Périphériques technologiques

Périphériques technologiques

IA

IA

Les dix meilleurs algorithmes que vous devez connaître et connaître sur le machine learning !

Les dix meilleurs algorithmes que vous devez connaître et connaître sur le machine learning !

Les dix meilleurs algorithmes que vous devez connaître et connaître sur le machine learning !

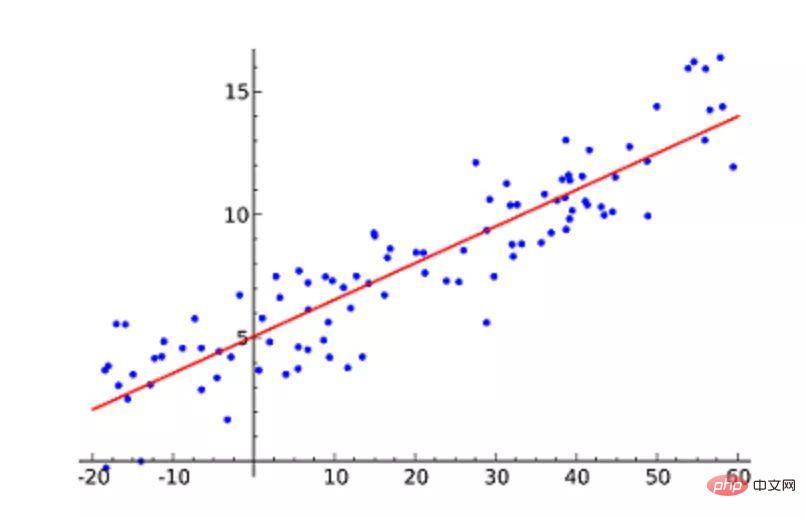

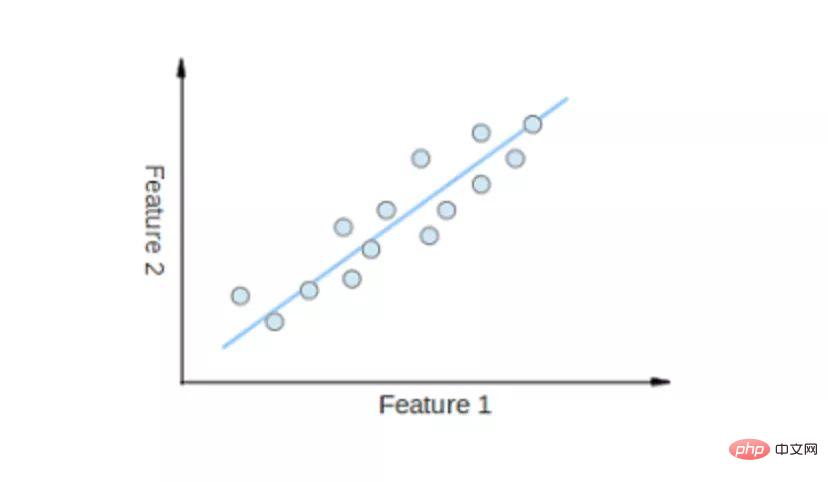

1. Régression linéaire

La régression linéaire est probablement l'algorithme d'apprentissage automatique le plus populaire. La régression linéaire consiste à trouver une ligne droite et à faire en sorte que cette ligne droite s'adapte le plus étroitement possible aux points de données du nuage de points. Il tente de représenter les variables indépendantes (valeurs x) et les résultats numériques (valeurs y) en ajustant une équation en ligne droite à ces données. Cette ligne peut ensuite être utilisée pour prédire les valeurs futures !

La technique la plus couramment utilisée pour cet algorithme est la méthode des moindres carrés. Cette méthode calcule une ligne de meilleur ajustement qui minimise la distance perpendiculaire à partir de chaque point de données sur la ligne. La distance totale est la somme des carrés des distances verticales (ligne verte) de tous les points de données. L'idée est d'ajuster le modèle en minimisant cette erreur quadratique ou cette distance.

Par exemple, une régression linéaire simple, qui a une variable indépendante (axe des x) et une variable dépendante (axe des y).

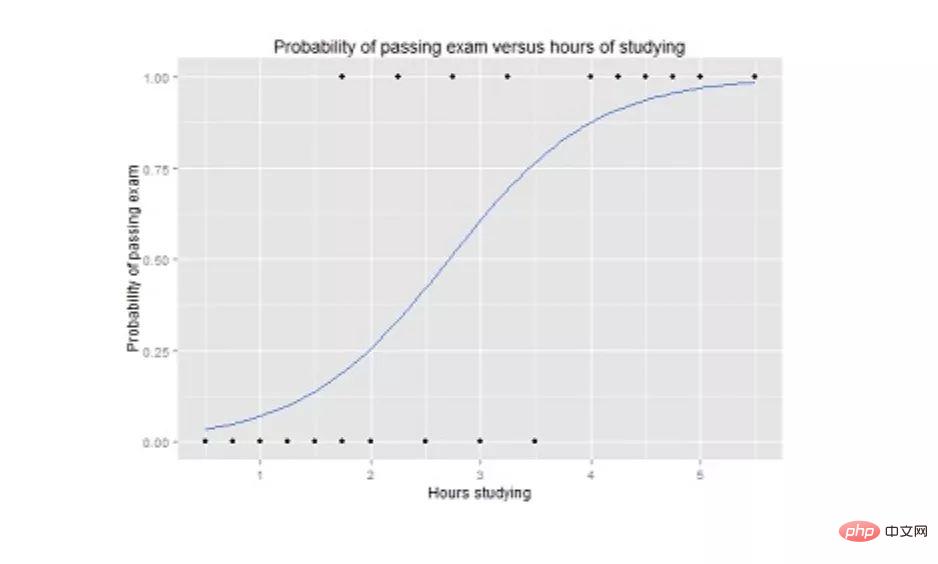

2. Régression logistique

La régression logistique est similaire à la régression linéaire, mais elle est utilisée lorsque la sortie est binaire (c'est-à-dire lorsque le résultat ne peut avoir que deux valeurs possibles). La prédiction du résultat final est une fonction sigmoïde non linéaire appelée fonction logistique, g().

Cette fonction logistique mappe la valeur du résultat intermédiaire à la variable de résultat Y, dont la valeur est comprise entre 0 et 1. Ces valeurs peuvent alors être interprétées comme la probabilité que Y se produise. Les propriétés de la fonction logistique sigmoïde rendent la régression logistique plus adaptée aux tâches de classification.

Graphique de régression logistique montrant la probabilité de réussite à l'examen en fonction du temps d'étude.

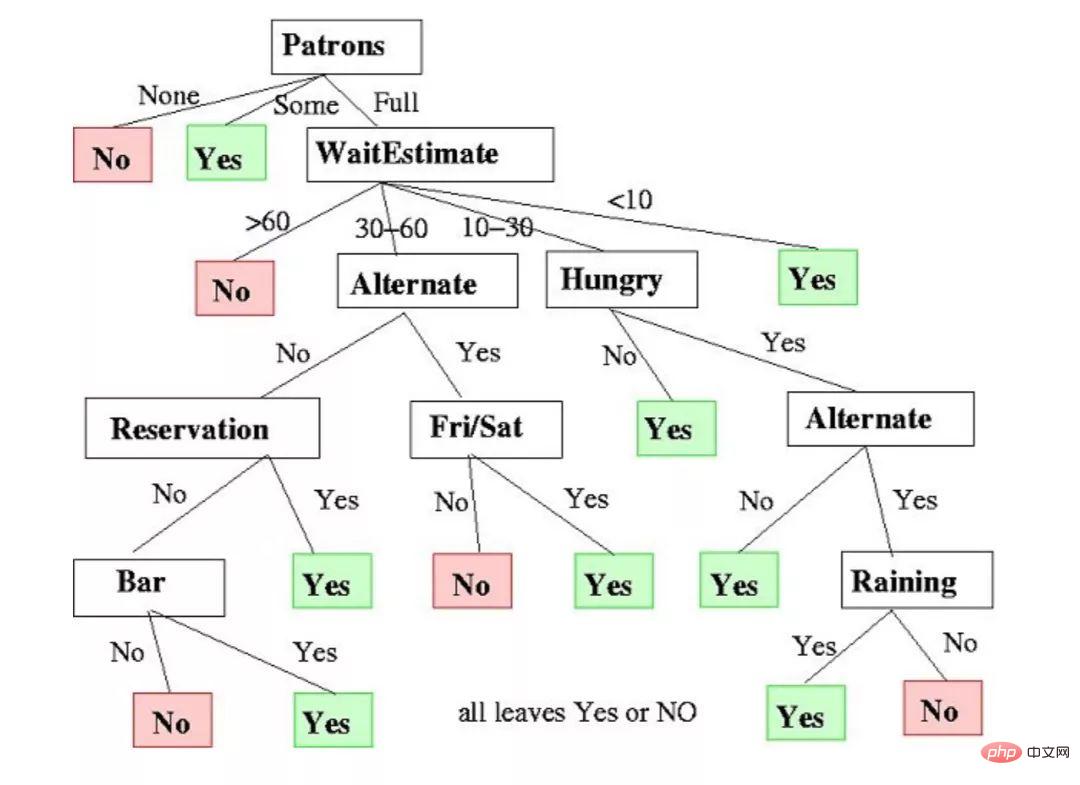

3. Arbres de décision

Les arbres de décision peuvent être utilisés pour des tâches de régression et de classification.

Dans cet algorithme, le modèle d'entraînement apprend à prédire la valeur de la variable cible en apprenant la règle de décision de la représentation arborescente. Un arbre est composé de nœuds avec des attributs correspondants.

À chaque nœud, nous posons des questions sur les données en fonction des fonctionnalités disponibles. Les branches gauche et droite représentent des réponses possibles. Le nœud final (c'est-à-dire le nœud feuille) correspond à une valeur prédite.

L'importance de chaque fonctionnalité est déterminée selon une approche descendante. Plus le nœud est haut, plus ses propriétés sont importantes.

Exemple d'arbre de décision pour décider d'attendre ou non dans un restaurant.

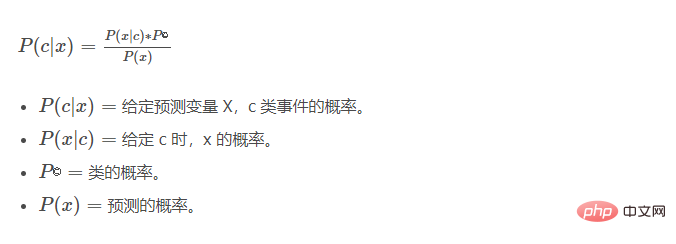

4. Naive Bayes

Naive Bayes (Naive Bayes) est basé sur le théorème de Bayes. Il mesure la probabilité de chaque classe, la probabilité conditionnelle de chaque classe étant donné la valeur de x. Cet algorithme est utilisé dans les problèmes de classification et donne un résultat binaire oui/non. Jetez un œil à l’équation ci-dessous.

Le classificateur Naive Bayes est une technique statistique populaire qui peut être utilisée pour filtrer le spam !

5. Support Vector Machine (SVM)

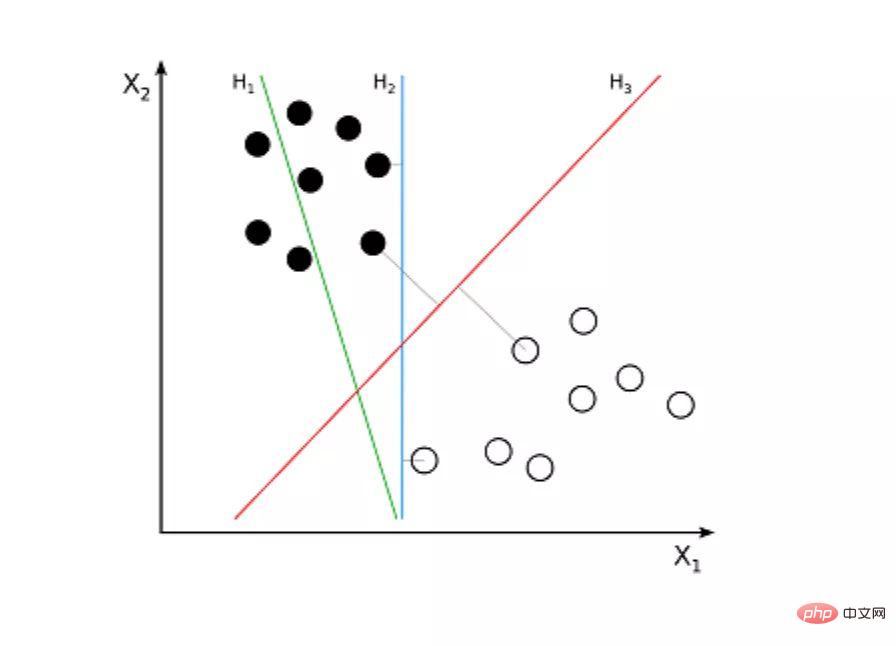

Support Vector Machine (SVM) est un algorithme supervisé pour les problèmes de classification. Une machine à vecteurs de support tente de tracer deux lignes entre les points de données avec la plus grande marge entre eux. Pour ce faire, nous traçons les éléments de données sous forme de points dans un espace à n dimensions, où n est le nombre d'entités en entrée. Sur cette base, la machine à vecteurs de support trouve une limite optimale, appelée hyperplan, qui sépare au mieux les sorties possibles par étiquettes de classe.

La distance entre l'hyperplan et le point de classe le plus proche est appelée la marge. L'hyperplan optimal possède la plus grande marge qui classe les points de telle sorte que la distance entre le point de données le plus proche et les deux classes soit maximisée.

Par exemple, H1 ne sépare pas ces deux classes. Mais H2 le fait, mais seulement avec des marges infimes. Et H3 les sépare avec la plus grande marge.

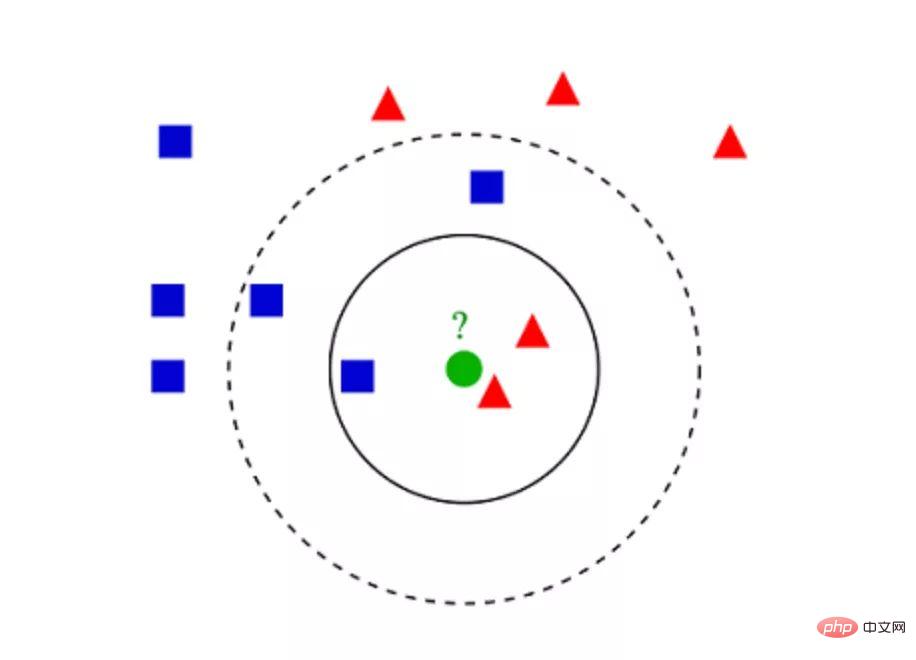

6.K-Algorithme des voisins les plus proches (KNN)

K-Algorithme des voisins les plus proches (KNN) est très simple. KNN classe les objets en recherchant dans l'ensemble de l'apprentissage les K instances les plus similaires, ou K voisins, et en attribuant une variable de sortie commune à toutes ces K instances. Le choix de

K est critique : des valeurs plus petites peuvent donner beaucoup de bruit et des résultats inexacts, tandis que des valeurs plus grandes sont irréalisables. Il est le plus souvent utilisé pour la classification, mais convient également aux problèmes de régression.

La distance utilisée pour évaluer la similarité entre les instances peut être la distance euclidienne, la distance de Manhattan ou la distance de Minkowski. La distance euclidienne est la distance ordinaire en ligne droite entre deux points. Il s'agit en fait de la racine carrée de la somme des carrés des différences entre les coordonnées des points.

▲Exemple de classification KNN

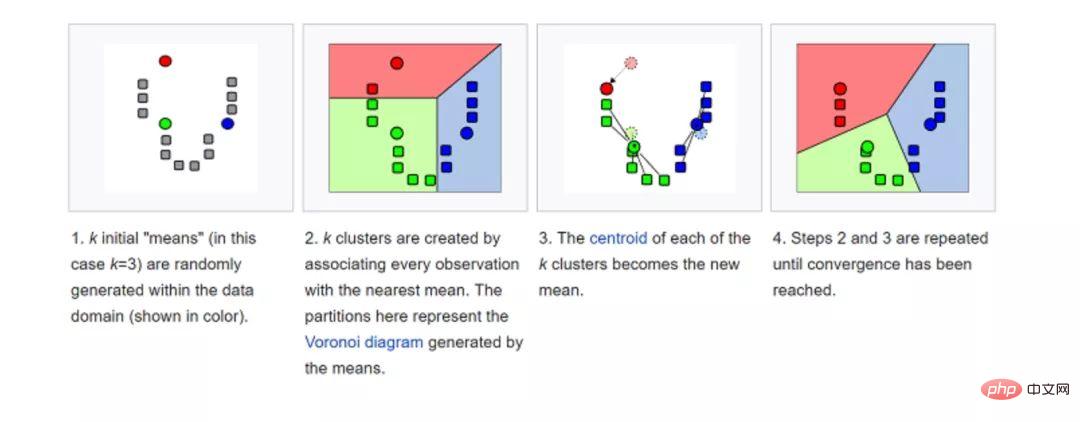

7.K-Means

K-means (K-means) est regroupé en classifiant l'ensemble de données. Par exemple, cet algorithme peut être utilisé pour regrouper les utilisateurs en fonction de l'historique des achats. Il trouve K clusters dans l'ensemble de données. K-means est utilisé pour l'apprentissage non supervisé, nous n'avons donc besoin d'utiliser que les données d'entraînement X et le nombre de clusters que nous voulons identifier K.

L'algorithme attribue de manière itérative chaque point de données à l'un des K groupes en fonction de ses caractéristiques. Il sélectionne K points pour chaque K-cluster (appelés centroïdes). En fonction de la similarité, de nouveaux points de données sont ajoutés au cluster ayant le centroïde le plus proche. Ce processus se poursuit jusqu'à ce que le centre de masse cesse de changer.

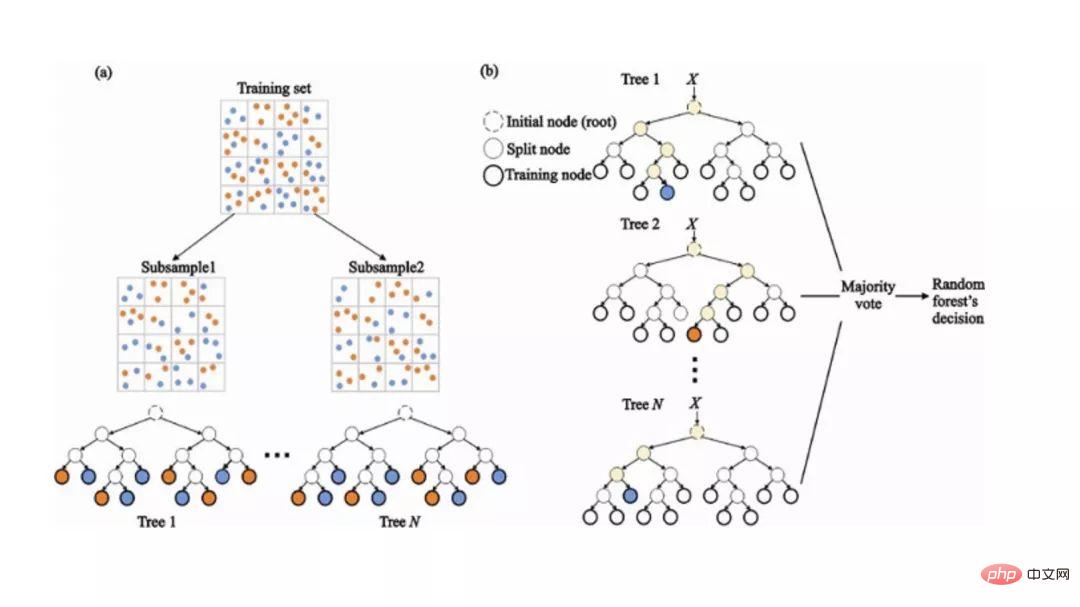

8. Random Forest

Random Forest (Random Forest) est un algorithme d'apprentissage automatique d'ensemble très populaire. L’idée de base de cet algorithme est que les opinions de nombreuses personnes sont plus précises que celles d’un seul individu. Dans une forêt aléatoire, nous utilisons un ensemble d'arbres de décision (voir Arbres de décision).

Pour classer les nouveaux objets, nous prenons un vote dans chaque arbre de décision et combinons les résultats avant de prendre la décision finale basée sur un vote majoritaire.

Pendant le processus de formation, chaque arbre de décision est construit sur la base des échantillons bootstrap de l'ensemble de formation.

Pendant le processus de classification, les décisions sur les instances d'entrée sont prises sur la base d'un vote majoritaire.

9. Réduction de la dimensionnalité

Les problèmes d'apprentissage automatique sont devenus plus complexes en raison du grand volume de données que nous sommes capables de capturer aujourd'hui. Cela signifie que la formation est extrêmement lente et qu’il est difficile de trouver une bonne solution. Ce problème est souvent appelé la « malédiction de la dimensionnalité ».

La réduction de dimensionnalité tente de résoudre ce problème en combinant des fonctionnalités spécifiques dans des fonctionnalités de niveau supérieur sans perdre les informations les plus importantes. L'analyse en composantes principales (ACP) est la technique de réduction de dimensionnalité la plus populaire.

L'analyse en composantes principales réduit la dimensionnalité d'un ensemble de données en le compressant en lignes de faible dimension ou en hyperplans/sous-espaces. Cela préserve autant que possible les caractéristiques principales des données originales.

Un exemple de réduction de dimensionnalité peut être obtenu en rapprochant tous les points de données d'une ligne droite.

10. Réseaux de neurones artificiels (ANN)

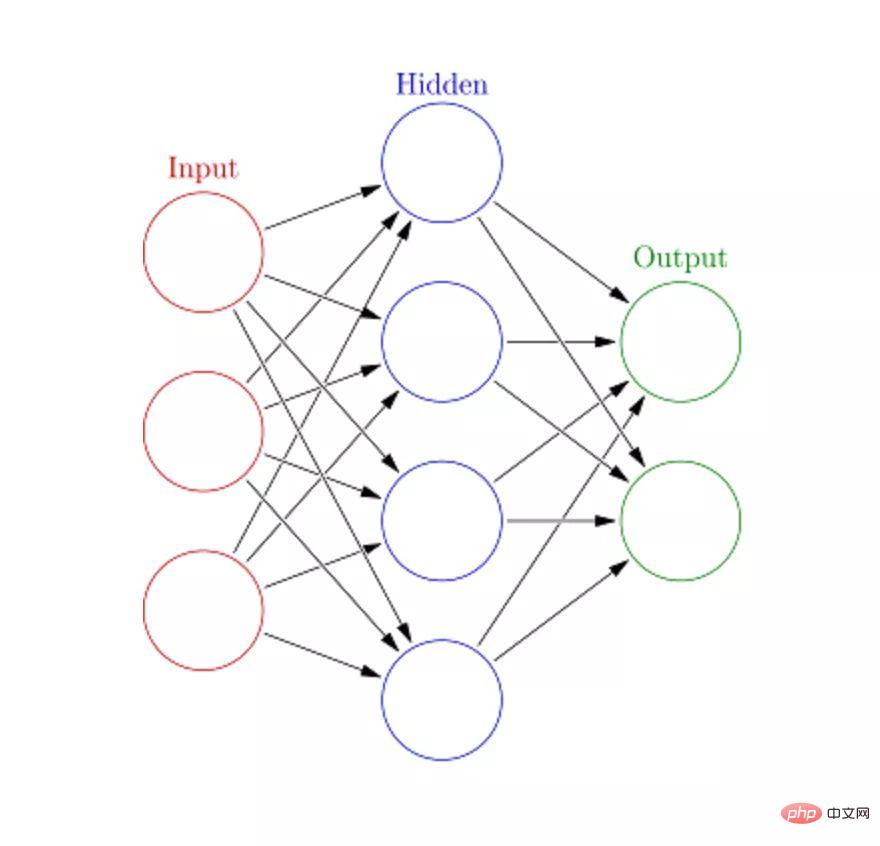

Les réseaux de neurones artificiels (ANN) peuvent gérer des tâches d'apprentissage automatique importantes et complexes. Un réseau neuronal est essentiellement un ensemble de couches interconnectées composées de bords et de nœuds pondérés, appelés neurones. Entre la couche d'entrée et la couche de sortie, nous pouvons insérer plusieurs couches cachées. Les réseaux de neurones artificiels utilisent deux couches cachées. Au-delà de cela, il faut s’attaquer au deep learning.

Le principe de fonctionnement du réseau neuronal artificiel est similaire à la structure du cerveau. Un groupe de neurones reçoit un poids aléatoire pour déterminer comment le neurone traite les données d'entrée. La relation entre l'entrée et la sortie est apprise en entraînant un réseau neuronal sur les données d'entrée. Pendant la phase de formation, le système a accès aux bonnes réponses.

Si le réseau ne peut pas reconnaître avec précision l'entrée, le système ajustera les poids. Après un entraînement suffisant, il reconnaîtra systématiquement les modèles corrects.

Chaque nœud circulaire représente un neurone artificiel, et les flèches représentent les connexions de la sortie d'un neurone artificiel à l'entrée d'un autre neurone artificiel.

Quelle est la prochaine étape ? Vous avez désormais appris les bases des algorithmes d’apprentissage automatique les plus populaires. Vous êtes prêt à apprendre des concepts plus complexes et même à les mettre en œuvre grâce à une pratique pratique approfondie. Si vous souhaitez apprendre à mettre en œuvre ces algorithmes, le cours Grokking Data Science d'Educative applique ces théories passionnantes à des applications claires et réelles.

Je vous souhaite de bonnes études !

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Cet article vous amènera à comprendre SHAP : explication du modèle pour l'apprentissage automatique

Jun 01, 2024 am 10:58 AM

Cet article vous amènera à comprendre SHAP : explication du modèle pour l'apprentissage automatique

Jun 01, 2024 am 10:58 AM

Dans les domaines de l’apprentissage automatique et de la science des données, l’interprétabilité des modèles a toujours été au centre des préoccupations des chercheurs et des praticiens. Avec l'application généralisée de modèles complexes tels que l'apprentissage profond et les méthodes d'ensemble, la compréhension du processus décisionnel du modèle est devenue particulièrement importante. Explainable AI|XAI contribue à renforcer la confiance dans les modèles d'apprentissage automatique en augmentant la transparence du modèle. L'amélioration de la transparence des modèles peut être obtenue grâce à des méthodes telles que l'utilisation généralisée de plusieurs modèles complexes, ainsi que les processus décisionnels utilisés pour expliquer les modèles. Ces méthodes incluent l'analyse de l'importance des caractéristiques, l'estimation de l'intervalle de prédiction du modèle, les algorithmes d'interprétabilité locale, etc. L'analyse de l'importance des fonctionnalités peut expliquer le processus de prise de décision du modèle en évaluant le degré d'influence du modèle sur les fonctionnalités d'entrée. Estimation de l’intervalle de prédiction du modèle

Implémentation d'algorithmes d'apprentissage automatique en C++ : défis et solutions courants

Jun 03, 2024 pm 01:25 PM

Implémentation d'algorithmes d'apprentissage automatique en C++ : défis et solutions courants

Jun 03, 2024 pm 01:25 PM

Les défis courants rencontrés par les algorithmes d'apprentissage automatique en C++ incluent la gestion de la mémoire, le multithread, l'optimisation des performances et la maintenabilité. Les solutions incluent l'utilisation de pointeurs intelligents, de bibliothèques de threads modernes, d'instructions SIMD et de bibliothèques tierces, ainsi que le respect des directives de style de codage et l'utilisation d'outils d'automatisation. Des cas pratiques montrent comment utiliser la bibliothèque Eigen pour implémenter des algorithmes de régression linéaire, gérer efficacement la mémoire et utiliser des opérations matricielles hautes performances.

IA explicable : Expliquer les modèles IA/ML complexes

Jun 03, 2024 pm 10:08 PM

IA explicable : Expliquer les modèles IA/ML complexes

Jun 03, 2024 pm 10:08 PM

Traducteur | Revu par Li Rui | Chonglou Les modèles d'intelligence artificielle (IA) et d'apprentissage automatique (ML) deviennent aujourd'hui de plus en plus complexes, et le résultat produit par ces modèles est une boîte noire – impossible à expliquer aux parties prenantes. L'IA explicable (XAI) vise à résoudre ce problème en permettant aux parties prenantes de comprendre comment fonctionnent ces modèles, en s'assurant qu'elles comprennent comment ces modèles prennent réellement des décisions et en garantissant la transparence des systèmes d'IA, la confiance et la responsabilité pour résoudre ce problème. Cet article explore diverses techniques d'intelligence artificielle explicable (XAI) pour illustrer leurs principes sous-jacents. Plusieurs raisons pour lesquelles l’IA explicable est cruciale Confiance et transparence : pour que les systèmes d’IA soient largement acceptés et fiables, les utilisateurs doivent comprendre comment les décisions sont prises

Cinq écoles d'apprentissage automatique que vous ne connaissez pas

Jun 05, 2024 pm 08:51 PM

Cinq écoles d'apprentissage automatique que vous ne connaissez pas

Jun 05, 2024 pm 08:51 PM

L'apprentissage automatique est une branche importante de l'intelligence artificielle qui donne aux ordinateurs la possibilité d'apprendre à partir de données et d'améliorer leurs capacités sans être explicitement programmés. L'apprentissage automatique a un large éventail d'applications dans divers domaines, de la reconnaissance d'images et du traitement du langage naturel aux systèmes de recommandation et à la détection des fraudes, et il change notre façon de vivre. Il existe de nombreuses méthodes et théories différentes dans le domaine de l'apprentissage automatique, parmi lesquelles les cinq méthodes les plus influentes sont appelées les « Cinq écoles d'apprentissage automatique ». Les cinq grandes écoles sont l’école symbolique, l’école connexionniste, l’école évolutionniste, l’école bayésienne et l’école analogique. 1. Le symbolisme, également connu sous le nom de symbolisme, met l'accent sur l'utilisation de symboles pour le raisonnement logique et l'expression des connaissances. Cette école de pensée estime que l'apprentissage est un processus de déduction inversée, à travers les connaissances existantes.

Algorithme de détection amélioré : pour la détection de cibles dans des images de télédétection optique haute résolution

Jun 06, 2024 pm 12:33 PM

Algorithme de détection amélioré : pour la détection de cibles dans des images de télédétection optique haute résolution

Jun 06, 2024 pm 12:33 PM

01Aperçu des perspectives Actuellement, il est difficile d'atteindre un équilibre approprié entre efficacité de détection et résultats de détection. Nous avons développé un algorithme YOLOv5 amélioré pour la détection de cibles dans des images de télédétection optique haute résolution, en utilisant des pyramides de caractéristiques multicouches, des stratégies de têtes de détection multiples et des modules d'attention hybrides pour améliorer l'effet du réseau de détection de cibles dans les images de télédétection optique. Selon l'ensemble de données SIMD, le mAP du nouvel algorithme est 2,2 % meilleur que YOLOv5 et 8,48 % meilleur que YOLOX, permettant ainsi d'obtenir un meilleur équilibre entre les résultats de détection et la vitesse. 02 Contexte et motivation Avec le développement rapide de la technologie de télédétection, les images de télédétection optique à haute résolution ont été utilisées pour décrire de nombreux objets à la surface de la Terre, notamment des avions, des voitures, des bâtiments, etc. Détection d'objets dans l'interprétation d'images de télédétection

Flash Attention est-il stable ? Meta et Harvard ont constaté que les écarts de poids de leur modèle fluctuaient de plusieurs ordres de grandeur.

May 30, 2024 pm 01:24 PM

Flash Attention est-il stable ? Meta et Harvard ont constaté que les écarts de poids de leur modèle fluctuaient de plusieurs ordres de grandeur.

May 30, 2024 pm 01:24 PM

MetaFAIR s'est associé à Harvard pour fournir un nouveau cadre de recherche permettant d'optimiser le biais de données généré lors de l'apprentissage automatique à grande échelle. On sait que la formation de grands modèles de langage prend souvent des mois et utilise des centaines, voire des milliers de GPU. En prenant comme exemple le modèle LLaMA270B, sa formation nécessite un total de 1 720 320 heures GPU. La formation de grands modèles présente des défis systémiques uniques en raison de l’ampleur et de la complexité de ces charges de travail. Récemment, de nombreuses institutions ont signalé une instabilité dans le processus de formation lors de la formation des modèles d'IA générative SOTA. Elles apparaissent généralement sous la forme de pics de pertes. Par exemple, le modèle PaLM de Google a connu jusqu'à 20 pics de pertes au cours du processus de formation. Le biais numérique est à l'origine de cette imprécision de la formation,

Apprentissage automatique en C++ : un guide pour la mise en œuvre d'algorithmes d'apprentissage automatique courants en C++

Jun 03, 2024 pm 07:33 PM

Apprentissage automatique en C++ : un guide pour la mise en œuvre d'algorithmes d'apprentissage automatique courants en C++

Jun 03, 2024 pm 07:33 PM

En C++, la mise en œuvre d'algorithmes d'apprentissage automatique comprend : Régression linéaire : utilisée pour prédire des variables continues. Les étapes comprennent le chargement des données, le calcul des poids et des biais, la mise à jour des paramètres et la prédiction. Régression logistique : utilisée pour prédire des variables discrètes. Le processus est similaire à la régression linéaire, mais utilise la fonction sigmoïde pour la prédiction. Machine à vecteurs de support : un puissant algorithme de classification et de régression qui implique le calcul de vecteurs de support et la prédiction d'étiquettes.

Perspectives sur les tendances futures de la technologie Golang dans l'apprentissage automatique

May 08, 2024 am 10:15 AM

Perspectives sur les tendances futures de la technologie Golang dans l'apprentissage automatique

May 08, 2024 am 10:15 AM

Le potentiel d'application du langage Go dans le domaine de l'apprentissage automatique est énorme. Ses avantages sont les suivants : Concurrence : il prend en charge la programmation parallèle et convient aux opérations intensives en calcul dans les tâches d'apprentissage automatique. Efficacité : les fonctionnalités du garbage collector et du langage garantissent l’efficacité du code, même lors du traitement de grands ensembles de données. Facilité d'utilisation : la syntaxe est concise, ce qui facilite l'apprentissage et l'écriture d'applications d'apprentissage automatique.