Périphériques technologiques

Périphériques technologiques

IA

IA

Technologie Edge Computing dans les systèmes de conduite autonome

Technologie Edge Computing dans les systèmes de conduite autonome

Technologie Edge Computing dans les systèmes de conduite autonome

Edge computing est un nouveau modèle informatique qui effectue des calculs à la périphérie du réseau. Son traitement des données comprend principalement deux parties, l'une est le service cloud de liaison descendante et l'autre est le service Internet of Everything de liaison montante. « Edge » est en fait un concept relatif, faisant référence à toutes les ressources informatiques, de stockage et liées au réseau sur le chemin allant des données au centre de cloud computing. D'une extrémité des données à l'autre extrémité du centre de services cloud, la périphérie peut être représentée comme un ou plusieurs nœuds de ressources sur ce chemin en fonction des besoins spécifiques de l'application et des scénarios d'application réels. L'essence commerciale de l'edge computing est l'extension et l'évolution des nœuds d'agrégation du cloud computing en dehors du centre de données. Elle est principalement composée de trois types de formes de mise en œuvre : le cloud périphérique, le réseau périphérique et la passerelle périphérique.

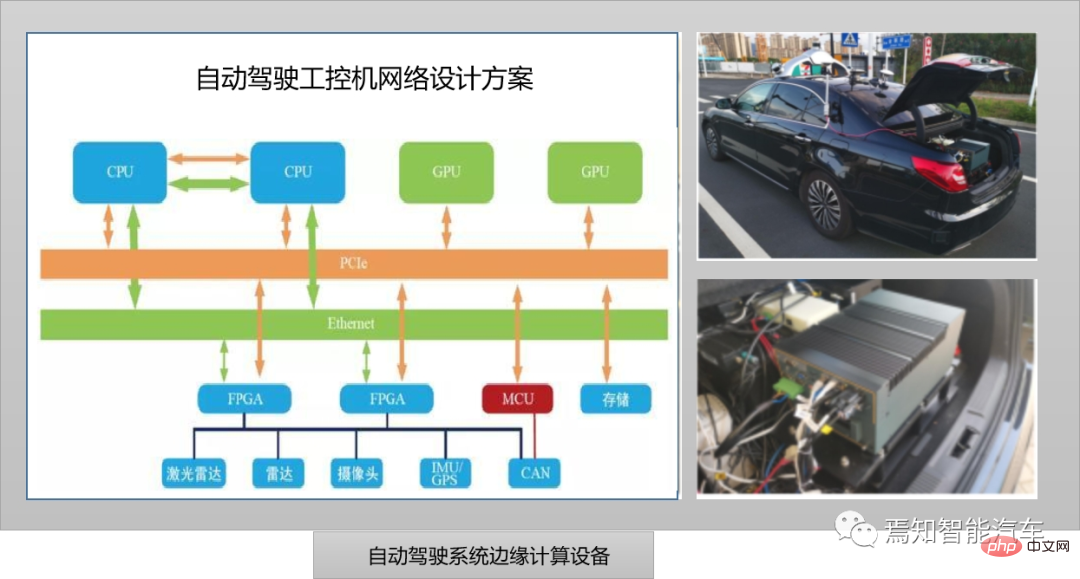

Comme le montre la photo ci-dessus, il représente un ordinateur industriel actuellement utilisé dans la conduite autonome. En fait, il s’agit d’un ordinateur personnel amélioré et renforcé. Il peut fonctionner de manière fiable dans un environnement industriel en tant que contrôleur industriel. Il utilise un châssis industriel entièrement en acier conforme aux normes EIA pour améliorer ses capacités d'interférence anti-électromagnétique, et utilise une structure de bus et une technologie de conception modulaire pour éviter les points de défaillance uniques. Le plan de conception de réseau informatique industriel de conduite autonome ci-dessus prend pleinement en compte les exigences de la norme ISO26262. Parmi eux, le CPU, le GPU, le FPGA et le bus sont tous conçus pour la redondance. Lorsque le système IPC global tombe en panne, le contrôle MCU redondant peut garantir la sécurité informatique et envoyer directement des instructions au bus CAN du véhicule pour contrôler le stationnement du véhicule. À l'heure actuelle, cette architecture centralisée convient à la prochaine génération de solutions de systèmes de conduite autonomes centralisés. L'ordinateur industriel est équivalent à la prochaine génération de contrôleurs de domaine centralisés, qui unifie tous les travaux informatiques en un seul. L'itération de l'algorithme ne nécessite pas de considération excessive du matériel. . Exigences globales de mise à niveau et de réglementation des véhicules.

Edge Computing et Edge Cloud

Dans la conduite autonome actuelle, des modèles d'algorithmes d'intelligence artificielle à grande échelle et une analyse centralisée des données à grande échelle sont effectués sur le cloud. Étant donné que le cloud dispose d'une grande quantité de ressources informatiques et peut effectuer le traitement des données en très peu de temps, il n'est pas possible dans de nombreux cas de s'appuyer uniquement sur le cloud pour fournir des services aux véhicules autonomes. Étant donné que les véhicules autonomes généreront une grande quantité de données qui devront être traitées en temps réel pendant la conduite, si ces données sont transmises au cloud distant pour être traitées via le réseau central, la transmission des données à elle seule entraînera un retard important et ne pourra pas être respectée. les exigences de traitement des données. La bande passante du réseau central est également difficile à prendre en charge pour un grand nombre de voitures autonomes qui envoient une grande quantité de données vers le cloud en même temps. De plus, une fois que le réseau central est encombré et que la transmission des données est instable, la conduite. la sécurité des voitures autonomes ne peut être garantie.

Edge computing se concentre sur les entreprises locales, a des exigences élevées en temps réel, une pression réseau élevée et la méthode informatique est orientée vers la localisation. L’Edge Computing est plus adapté à l’analyse intelligente locale à petite échelle et au prétraitement basé sur des modèles d’algorithmes intégrés. L'application de l'informatique de pointe au domaine de la conduite autonome contribuera à résoudre les problèmes rencontrés par les véhicules autonomes dans l'acquisition et le traitement des données environnementales.

En tant que deux méthodes informatiques importantes pour la transformation numérique de l'industrie, l'edge computing et le cloud computing coexistent fondamentalement en même temps, se complètent et se favorisent mutuellement pour résoudre conjointement les problèmes informatiques à l'ère du big data.

Edge computing fait référence à un modèle informatique qui effectue des calculs à la périphérie du réseau. Ses objets d'exploitation proviennent des données de liaison descendante des services cloud et des données de liaison montante des services Internet of Everything. Le « Edge » dans l'Edge Computing fait référence au processus de l'Internet of Everything. sources de données vers le cloud computing. Chemin central entre l’informatique arbitraire et les ressources réseau. En bref, l'informatique de pointe déploie des serveurs sur des nœuds périphériques à proximité des utilisateurs pour fournir des services aux utilisateurs situés à la périphérie du réseau (tels que des points d'accès sans fil), évitant ainsi la transmission de données sur de longues distances et offrant aux utilisateurs des réponses plus rapides. La technologie de déchargement de tâches décharge les tâches informatiques des véhicules autonomes vers d'autres nœuds périphériques pour exécution, résolvant ainsi le problème des ressources informatiques insuffisantes pour les véhicules autonomes.

Edge computing présente les caractéristiques de proximité, de faible latence, de localité et de connaissance de l'emplacement. Parmi eux, la proximité signifie que l'informatique de pointe est proche de la source d'informations. Elle est adaptée à la capture et à l'analyse d'informations clés dans le Big Data grâce à l'optimisation des données, elle peut accéder directement à l'appareil, servir plus efficacement l'intelligence de pointe et dériver facilement des scénarios d'application spécifiques. . Une faible latence signifie que les services informatiques de pointe sont proches des terminaux qui génèrent des données. Par rapport au cloud computing, la latence est considérablement réduite, en particulier dans les scénarios d'applications de conduite intelligente, ce qui accélère le processus de retour d'information. La localité signifie que l'informatique de pointe peut fonctionner indépendamment du reste du réseau pour obtenir une informatique localisée et relativement indépendante. D'une part, elle garantit la sécurité des données locales et, d'autre part, elle réduit la dépendance de l'informatique à l'égard de la qualité du réseau. La connaissance de l'emplacement signifie que lorsque le réseau périphérique fait partie d'un réseau sans fil, les services locaux de type informatique de pointe peuvent utiliser relativement peu d'informations pour déterminer l'emplacement de tous les appareils connectés. Ces services peuvent être appliqués à des scénarios d'application de services basés sur la localisation.

Dans le même temps, la tendance de développement de l'edge computing évoluera progressivement vers l'informatique hétérogène, l'intelligence de pointe, la collaboration edge-cloud et l'edge computing 5G+. L'informatique hétérogène nécessite l'utilisation d'unités informatiques de différents types de jeux d'instructions et d'architectures pour former un système informatique répondant aux besoins des services de pointe pour une informatique diversifiée. L'informatique hétérogène peut non seulement répondre aux besoins de la nouvelle génération de « connexion + informatique ». " construction d'infrastructures , il peut également répondre aux besoins d'industries fragmentées et d'applications différenciées, améliorer l'utilisation des ressources informatiques et prendre en charge un déploiement et une planification flexibles de la puissance de calcul.

Architecture de référence Edge Computing

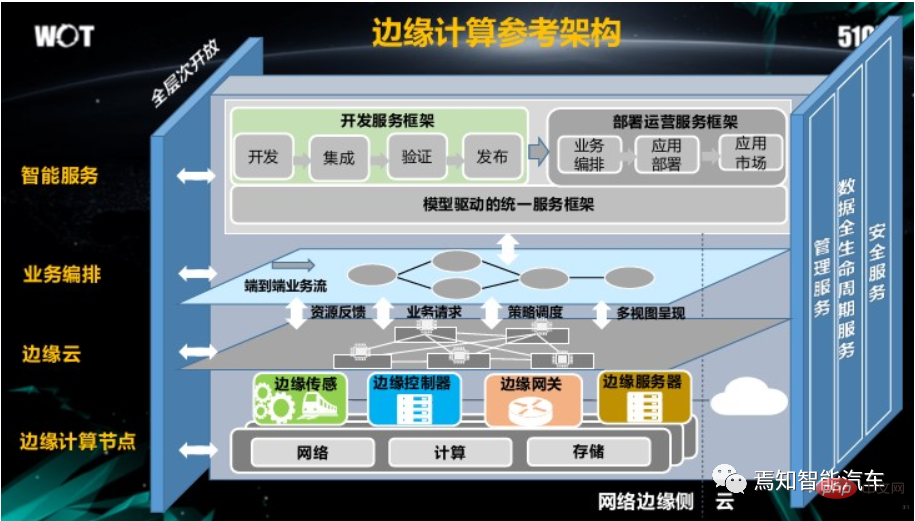

Chaque couche de l'architecture de référence Edge Computing fournit une interface ouverte modélisée, réalisant une ouverture complète de l'architecture et réalisant l'ensemble du processus métier via des services de gestion verticale, des services de cycle de vie complet des données et des services de sécurité. , services intelligents sur un cycle de vie complet.

Comme le montre la figure ci-dessus, l'architecture de référence de l'Edge Computing comprend principalement les contenus suivants :

L'ensemble du système est divisé en quatre couches : les services intelligents, l'orchestration métier, le Edge Cloud et les nœuds Edge Computing. situé entre le cloud et les appareils sur site. La couche périphérique prend en charge l'accès de divers appareils de terrain vers le bas et peut se connecter au cloud vers le haut. La couche Edge comprend deux parties principales : le nœud Edge et le gestionnaire Edge. Le nœud Edge est une entité matérielle et constitue le cœur des services Edge Computing. Le cœur du gestionnaire Edge est le logiciel et sa fonction principale est de gérer uniformément les nœuds Edge. Les nœuds Edge Computing disposent généralement de ressources informatiques, de ressources réseau et de ressources de stockage. Le système Edge Computing utilise les ressources de deux manières : premièrement, il encapsule directement les ressources informatiques, les ressources réseau et les ressources de stockage et fournit une interface d'appel. Le gestionnaire Edge utilise le nœud Edge. les ressources sont utilisées dans le téléchargement de code, la configuration de la politique réseau et les opérations de base de données ; deuxièmement, les ressources des nœuds périphériques sont encapsulées dans des modules fonctionnels en fonction des domaines fonctionnels, et le gestionnaire périphérique combine et appelle des modules fonctionnels via une orchestration commerciale basée sur un modèle pour réaliser un développement intégré. et déploiement agile de services informatiques de pointe.

Infrastructure matérielle pour l'informatique de pointe

1. Serveur Edge

Le serveur Edge est le principal support informatique pour l'informatique de pointe et les centres de données de pointe et peut être déployé dans une salle informatique d'un opérateur. Étant donné que les environnements informatiques de pointe varient considérablement et que les services de pointe ont des exigences personnalisées en termes de latence, de bande passante, de GPU et d'IA, les ingénieurs doivent minimiser les opérations sur site et disposer de solides capacités de gestion et d'exploitation, y compris la collecte d'état, le contrôle des opérations et l'interface de gestion pour réaliser une gestion à distance et automatisée.

Dans les systèmes de conduite autonome, les machines tout-en-un intelligentes sont généralement utilisées pour intégrer organiquement l'informatique, le stockage, le réseau, la virtualisation, la puissance environnementale et d'autres produits dans un ordinateur industriel afin de faciliter le fonctionnement normal de le système de conduite autonome.

2. Réseau d'accès Edge

Le réseau d'accès informatique Edge fait référence à une série d'infrastructures réseau qui passent du système utilisateur au système informatique Edge, y compris, mais sans s'y limiter, le réseau du campus, le réseau d'accès et la passerelle Edge. Il possède également des fonctionnalités telles que la convergence, une faible latence, une large bande passante, des connexions étendues et une sécurité élevée.

3. Réseau interne Edge

Le réseau interne Edge Computing fait référence à l'infrastructure réseau interne du système informatique Edge, telle que l'équipement réseau connecté au serveur, l'équipement réseau interconnecté avec le réseau externe et le réseau construit par celui-ci, etc. Le réseau interne de l'informatique de pointe présente les caractéristiques d'une architecture simplifiée, de fonctions complètes et d'une perte de performances considérablement réduite. En même temps, il peut réaliser une collaboration Edge-Cloud et une gestion et un contrôle centralisés.

En raison de la nature naturellement distribuée des systèmes informatiques de pointe, qui sont de petite taille mais nombreux en nombre, si un modèle de gestion à point unique est adopté, il sera difficile de répondre aux besoins opérationnels, et il occupera également des ressources informatiques industrielles et réduire l'efficacité ; d'un autre côté, le secteur de l'informatique de pointe met davantage l'accent sur la latence de bout en bout, la bande passante et la sécurité. La collaboration entre le cloud et la périphérie est donc également très importante. Généralement, il est nécessaire d'introduire un système intelligent de gestion et d'orchestration inter-domaines dans le système de cloud computing pour gérer et contrôler uniformément toute l'infrastructure réseau du système informatique de pointe dans une certaine plage, et assurer l'automatisation des ressources réseau et informatiques en prenant en charge un système centralisé. modèle de gestion basé sur la collaboration Edge-Cloud. Configuration efficace.

4. Réseau d'interconnexion Edge Computing

Le réseau d'interconnexion Edge Computing comprend des systèmes informatiques de pointe aux systèmes de cloud computing (tels que les nuages publics, les nuages privés, les nuages de communication, les nuages construits par l'utilisateur, etc.), d'autres systèmes informatiques de pointe et divers centres de données L'infrastructure réseau traversée. Le réseau d'interconnexion Edge Computing présente les caractéristiques de connexions diversifiées et d'une faible latence inter-domaines.

Comment combiner l'informatique de pointe avec les systèmes de conduite autonome

Dans l'étape suivante, afin d'accomplir des tâches de système de conduite autonome d'ordre supérieur, s'appuyer uniquement sur l'intelligence d'un seul véhicule est totalement insuffisant.

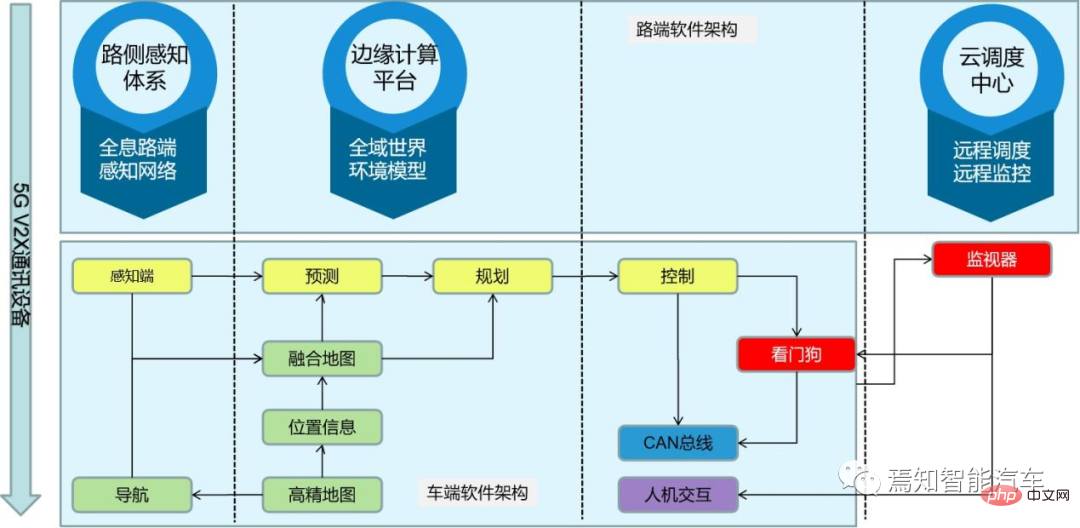

La détection collaborative et le déchargement de tâches sont les principales applications de l'edge computing dans le domaine de la conduite autonome. Ces deux technologies permettent d'atteindre une conduite autonome de haut niveau. La technologie de détection collaborative permet aux voitures d'obtenir des informations de capteurs provenant d'autres nœuds périphériques, élargissant ainsi la portée de détection des véhicules autonomes et augmentant l'intégrité des données environnementales. En prenant comme exemple la conduite autonome, les voitures intégreront des capteurs tels que le lidar et les caméras. Dans le même temps, elles devront obtenir une perception complète des véhicules, des routes et des données de trafic via le réseau de véhicules V2X, etc., pour obtenir plus d'informations que le réseau interne. et capteurs externes d'un seul véhicule, et pour améliorer la visibilité au-delà de la portée visuelle. Perception de l'environnement à portée et partage de la position de conduite autonome en temps réel grâce à des cartes dynamiques 3D haute définition. Les données collectées interagiront avec les nœuds de bord de route et les véhicules environnants pour étendre les capacités de perception et réaliser une collaboration de véhicule à véhicule et de véhicule à route. Le centre de cloud computing est chargé de collecter des données à partir de nœuds périphériques largement distribués, de détecter l'état de fonctionnement du système de transport et de fournir des instructions de répartition raisonnables aux nœuds périphériques, aux systèmes de feux de circulation et aux véhicules via des algorithmes de mégadonnées et d'intelligence artificielle, améliorant ainsi le fonctionnement du système. . efficacité. Par exemple, par mauvais temps comme la pluie, la neige, un épais brouillard ou dans des scènes telles que des intersections et des virages, les radars et les caméras ne peuvent pas identifier clairement les obstacles à venir. Utilisation de V2x pour obtenir des données en temps réel sur les routes, la conduite, etc., intelligentes. la prévision des conditions routières peut être obtenue.

Avec l’amélioration des niveaux de conduite autonome et l’augmentation du nombre de capteurs intelligents équipés, les véhicules autonomes génèrent chaque jour une grande quantité de données brutes. Ces données brutes nécessitent un traitement local en temps réel, une fusion et une extraction de fonctionnalités, y compris la détection et le suivi de cibles basés sur l'apprentissage en profondeur. Dans le même temps, V2X doit être utilisé pour améliorer la perception de l'environnement, des routes et des autres véhicules, et utiliser des cartes 3D haute définition pour la modélisation et le positionnement en temps réel, la planification et la sélection de chemins et l'ajustement de la stratégie de conduite pour contrôler en toute sécurité. le véhicule. Étant donné que ces tâches nécessitent un traitement et une réponse en temps réel dans le véhicule à tout moment, une plate-forme informatique de pointe puissante et fiable est nécessaire pour les exécuter. Compte tenu de la diversité des tâches informatiques, afin d’améliorer l’efficacité d’exécution et de réduire la consommation d’énergie et les coûts, il est généralement nécessaire de prendre en charge des plates-formes informatiques hétérogènes.

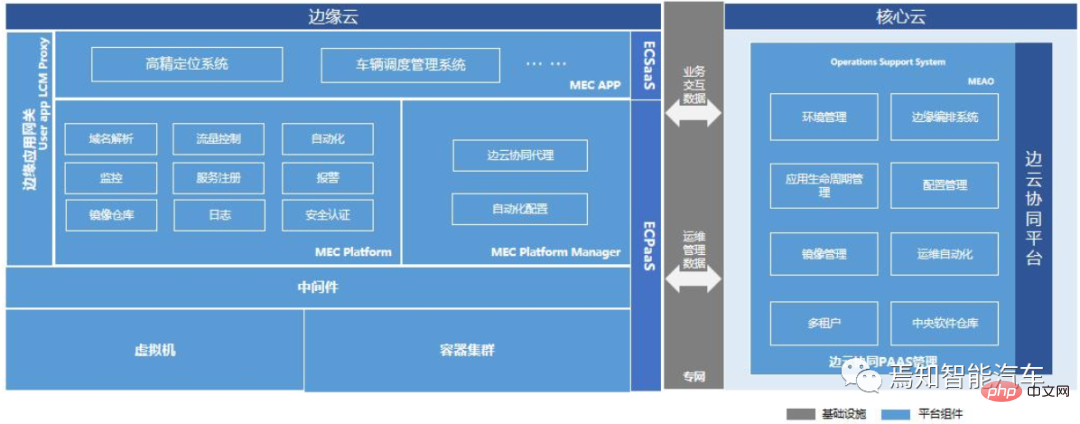

L'architecture informatique de pointe de la conduite autonome repose sur la collaboration Edge-Cloud et sur l'infrastructure et les services de communication fournis par LTE/5G. Le côté Edge fait principalement référence aux unités montées sur véhicule, aux unités routières (RSU) ou aux serveurs de Mobile Edge Computing (MEC). Parmi eux, l'unité montée sur véhicule est l'organe principal de la perception environnementale, de la planification décisionnelle et du contrôle du véhicule, mais elle repose sur la coopération du serveur RSU ou MEC. Par exemple, RSU fournit à l'unité montée sur véhicule plus d'informations sur. les routes et les piétons, mais certaines fonctions sont plus adaptées et encore mieux exécutées dans le cloud. Ne peuvent pas être remplacées. Par exemple, contrôle à distance du véhicule, simulation et vérification du véhicule, gestion des nœuds, persistance et gestion des données, etc.

Pour l'informatique de pointe des systèmes de conduite autonomes, il peut offrir des avantages tels que l'intégration de charge, le calcul hétérogène, le traitement en temps réel, la connexion et l'interopérabilité, ainsi que l'optimisation de la sécurité.

1. "Consolidation de charge"

Exécutez des charges avec différents attributs, tels que ADAS, IVI, instruments numériques, affichage tête haute et système de divertissement arrière, sur la même plate-forme matérielle grâce à l'informatique virtualisée. Dans le même temps, l'intégration de charge basée sur la virtualisation et la couche d'abstraction matérielle facilite la mise en œuvre de l'orchestration commerciale dans le cloud, des mises à jour du modèle d'apprentissage profond, des mises à niveau des logiciels et du micrologiciel pour l'ensemble du système de conduite du véhicule.

2. « Informatique hétérogène »

fait référence aux tâches informatiques avec différents attributs hérités par la plate-forme périphérique du système de conduite autonome et adopte différentes méthodes de calcul basées sur les différences de performances et de ratio de consommation d'énergie lors de l'exécution sur différentes plates-formes matérielles. Par exemple, la géolocalisation et la planification de trajectoires, la reconnaissance et la détection de cibles basées sur l'apprentissage profond, le prétraitement d'images et l'extraction de caractéristiques, la fusion de capteurs et le suivi de cibles, etc. Les GPU sont efficaces dans la gestion des calculs convolutifs pour la reconnaissance et le suivi des cibles. Le processeur produira de meilleures performances et une consommation d'énergie réduite pour les capacités de calcul logique. Le DSP de traitement du signal numérique produit davantage d'avantages dans les algorithmes d'extraction de caractéristiques tels que le positionnement. Cette méthode de calcul hétérogène améliore considérablement le rapport performances/consommation d'énergie de la plateforme informatique et réduit la latence de calcul. L'informatique hétérogène sélectionne les implémentations matérielles appropriées pour différentes tâches informatiques, exploite pleinement les avantages des différentes plates-formes matérielles et protège la diversité matérielle en unifiant les interfaces logicielles des couches supérieures.

3. "Traitement en temps réel"

Comme nous le savons tous, le système de conduite automatique a des exigences extrêmement élevées en matière de performances en temps réel, car dans des situations dangereuses, seules quelques secondes peuvent être disponibles pour que le système de conduite automatique freine. et éviter les collisions. De plus, le temps de réaction au freinage comprend le temps de réponse de l'ensemble du système de conduite, impliquant le traitement du cloud computing, le temps de traitement des négociations en atelier, le calcul du système du véhicule lui-même et le temps de traitement du freinage. Si la réponse de la conduite autonome est divisée en exigences en temps réel pour chaque module fonctionnel de sa plateforme informatique de pointe. Il doit être affiné en temps de détection de perception, temps d’analyse de fusion et temps de planification du cheminement comportemental. Dans le même temps, la latence globale du réseau doit également être prise en compte, car les scénarios d'application à faible latence et à haute fiabilité apportés par la 5G sont également très critiques. Il peut permettre aux voitures autonomes d'atteindre une latence de bout en bout inférieure à 1 ms et une fiabilité proche de 100 %. Dans le même temps, la 5G peut attribuer de manière flexible les capacités de traitement du réseau en fonction de la priorité, garantissant ainsi une vitesse de réponse plus rapide pour la transmission des signaux de commande du véhicule.

4. "Connectivité et interopérabilité"

L'informatique de pointe pour les véhicules autonomes est indissociable du support de la technologie de communication sans fil des véhicules (V2X, véhicule à tout), qui assure la connexion entre les véhicules autonomes et d'autres éléments du transport intelligent. Les moyens de communication du système constituent la base de la coopération entre les véhicules autonomes et les nœuds périphériques.

Actuellement, le V2X repose principalement sur des communications dédiées à courte portée (DSRC, dédiée short range communication) et des réseaux cellulaires [5]. DSRC est une norme de communication spécifiquement utilisée entre les véhicules (V2V, véhicule à véhicule) et les véhicules et les infrastructures routières (V2I, véhicule à infrastructure). Il a un taux de transmission de données élevé et une faible latence. ou communication point à multipoint et autres avantages. Les réseaux cellulaires représentés par la 5G présentent les avantages d'une grande capacité de réseau et d'une large couverture, et conviennent à la communication V2I et à la communication entre serveurs Edge.

5. "Optimisation de la sécurité"

La sécurité de l'Edge Computing est une garantie importante pour l'Edge Computing. Sa conception combine le système de protection de sécurité approfondi du Cloud Computing et de l'Edge Computing pour améliorer l'infrastructure, les réseaux, les applications, l'identification et la résistance des données. Capacité à faire face à diverses menaces de sécurité et à créer un environnement sûr et fiable pour le développement de l'informatique de pointe. Le plan de contrôle et le plan de données du réseau central 5G du système de conduite autonome de nouvelle génération sont séparés, ce qui rend le déploiement du réseau plus flexible, garantissant ainsi le succès du déploiement de l'informatique distribuée de pointe. L'Edge Computing répartit davantage le calcul et le stockage des données de l'unité centrale vers la périphérie. Sa puissance de calcul est déployée à proximité de la source de données. Certaines données n'ont plus besoin de passer par le réseau pour atteindre le cloud pour être traitées, réduisant ainsi la latence et la charge du réseau. et améliorer l’efficacité des données. Pour les futurs appareils de communication mobile proches des véhicules, tels que les stations de base, les unités routières, etc., l'informatique de pointe de l'Internet des véhicules pourrait être déployée, ce qui pourrait compléter le traitement, le cryptage et la prise de décision locaux des données, et fournir des informations en temps réel. , capacités de communication hautement fiables.

Résumé

Edge computing a des applications extrêmement importantes dans la perception environnementale et le traitement des données de la conduite autonome. Les voitures autonomes peuvent élargir leur champ de perception en obtenant des informations environnementales à partir des nœuds périphériques, et peuvent également confier des tâches informatiques aux nœuds périphériques pour résoudre le problème des ressources informatiques insuffisantes. Par rapport au cloud computing, l'edge computing évite les retards élevés causés par la transmission de données sur de longues distances, peut fournir des réponses plus rapides aux véhicules autonomes et réduit la charge sur le réseau fédérateur. Par conséquent, l’utilisation de l’informatique de pointe dans le processus de recherche et développement par étapes sur la conduite autonome constituera une option importante pour son optimisation et son développement continus.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment résoudre le problème de la longue traîne dans les scénarios de conduite autonome ?

Jun 02, 2024 pm 02:44 PM

Comment résoudre le problème de la longue traîne dans les scénarios de conduite autonome ?

Jun 02, 2024 pm 02:44 PM

Hier, lors de l'entretien, on m'a demandé si j'avais posé des questions à longue traîne, j'ai donc pensé faire un bref résumé. Le problème à longue traîne de la conduite autonome fait référence aux cas extrêmes dans les véhicules autonomes, c'est-à-dire à des scénarios possibles avec une faible probabilité d'occurrence. Le problème perçu de la longue traîne est l’une des principales raisons limitant actuellement le domaine de conception opérationnelle des véhicules autonomes intelligents à véhicule unique. L'architecture sous-jacente et la plupart des problèmes techniques de la conduite autonome ont été résolus, et les 5 % restants des problèmes à longue traîne sont progressivement devenus la clé pour restreindre le développement de la conduite autonome. Ces problèmes incluent une variété de scénarios fragmentés, de situations extrêmes et de comportements humains imprévisibles. La « longue traîne » des scénarios limites dans la conduite autonome fait référence aux cas limites dans les véhicules autonomes (VA). Les cas limites sont des scénarios possibles avec une faible probabilité d'occurrence. ces événements rares

Le papier Stable Diffusion 3 est enfin publié, et les détails architecturaux sont révélés. Cela aidera-t-il à reproduire Sora ?

Mar 06, 2024 pm 05:34 PM

Le papier Stable Diffusion 3 est enfin publié, et les détails architecturaux sont révélés. Cela aidera-t-il à reproduire Sora ?

Mar 06, 2024 pm 05:34 PM

L'article de StableDiffusion3 est enfin là ! Ce modèle est sorti il y a deux semaines et utilise la même architecture DiT (DiffusionTransformer) que Sora. Il a fait beaucoup de bruit dès sa sortie. Par rapport à la version précédente, la qualité des images générées par StableDiffusion3 a été considérablement améliorée. Il prend désormais en charge les invites multithèmes, et l'effet d'écriture de texte a également été amélioré et les caractères tronqués n'apparaissent plus. StabilityAI a souligné que StableDiffusion3 est une série de modèles avec des tailles de paramètres allant de 800M à 8B. Cette plage de paramètres signifie que le modèle peut être exécuté directement sur de nombreux appareils portables, réduisant ainsi considérablement l'utilisation de l'IA.

Cet article vous suffit pour en savoir plus sur la conduite autonome et la prédiction de trajectoire !

Feb 28, 2024 pm 07:20 PM

Cet article vous suffit pour en savoir plus sur la conduite autonome et la prédiction de trajectoire !

Feb 28, 2024 pm 07:20 PM

La prédiction de trajectoire joue un rôle important dans la conduite autonome. La prédiction de trajectoire de conduite autonome fait référence à la prédiction de la trajectoire de conduite future du véhicule en analysant diverses données pendant le processus de conduite du véhicule. En tant que module central de la conduite autonome, la qualité de la prédiction de trajectoire est cruciale pour le contrôle de la planification en aval. La tâche de prédiction de trajectoire dispose d'une riche pile technologique et nécessite une connaissance de la perception dynamique/statique de la conduite autonome, des cartes de haute précision, des lignes de voie, des compétences en architecture de réseau neuronal (CNN&GNN&Transformer), etc. Il est très difficile de démarrer ! De nombreux fans espèrent se lancer dans la prédiction de trajectoire le plus tôt possible et éviter les pièges. Aujourd'hui, je vais faire le point sur quelques problèmes courants et des méthodes d'apprentissage introductives pour la prédiction de trajectoire ! Connaissances introductives 1. Existe-t-il un ordre d'entrée pour les épreuves de prévisualisation ? R : Regardez d’abord l’enquête, p

SIMPL : un benchmark de prédiction de mouvement multi-agents simple et efficace pour la conduite autonome

Feb 20, 2024 am 11:48 AM

SIMPL : un benchmark de prédiction de mouvement multi-agents simple et efficace pour la conduite autonome

Feb 20, 2024 am 11:48 AM

Titre original : SIMPL : ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving Lien article : https://arxiv.org/pdf/2402.02519.pdf Lien code : https://github.com/HKUST-Aerial-Robotics/SIMPL Affiliation de l'auteur : Université des sciences de Hong Kong et technologie Idée DJI Paper : cet article propose une base de référence de prédiction de mouvement (SIMPL) simple et efficace pour les véhicules autonomes. Par rapport au cent agent traditionnel

Parlons des systèmes de conduite autonome de bout en bout et de nouvelle génération, ainsi que de quelques malentendus sur la conduite autonome de bout en bout ?

Apr 15, 2024 pm 04:13 PM

Parlons des systèmes de conduite autonome de bout en bout et de nouvelle génération, ainsi que de quelques malentendus sur la conduite autonome de bout en bout ?

Apr 15, 2024 pm 04:13 PM

Au cours du mois dernier, pour des raisons bien connues, j'ai eu des échanges très intensifs avec divers professeurs et camarades de classe du secteur. Un sujet inévitable dans l'échange est naturellement le populaire Tesla FSDV12 de bout en bout. Je voudrais profiter de cette occasion pour trier certaines de mes pensées et opinions en ce moment pour votre référence et votre discussion. Comment définir un système de conduite autonome de bout en bout et quels problèmes devraient être résolus de bout en bout ? Selon la définition la plus traditionnelle, un système de bout en bout fait référence à un système qui saisit les informations brutes des capteurs et génère directement les variables pertinentes pour la tâche. Par exemple, en reconnaissance d'images, CNN peut être appelé de bout en bout par rapport à la méthode traditionnelle d'extraction de caractéristiques + classificateur. Dans les tâches de conduite autonome, saisir les données de divers capteurs (caméra/LiDAR

NuScenes dernier SOTA SparseAD : les requêtes clairsemées contribuent à une conduite autonome efficace de bout en bout !

Apr 17, 2024 pm 06:22 PM

NuScenes dernier SOTA SparseAD : les requêtes clairsemées contribuent à une conduite autonome efficace de bout en bout !

Apr 17, 2024 pm 06:22 PM

Écrit à l'avant et point de départ Le paradigme de bout en bout utilise un cadre unifié pour réaliser plusieurs tâches dans les systèmes de conduite autonome. Malgré la simplicité et la clarté de ce paradigme, les performances des méthodes de conduite autonome de bout en bout sur les sous-tâches sont encore loin derrière les méthodes à tâche unique. Dans le même temps, les fonctionnalités de vue à vol d'oiseau (BEV) denses, largement utilisées dans les méthodes de bout en bout précédentes, rendent difficile l'adaptation à davantage de modalités ou de tâches. Un paradigme de conduite autonome de bout en bout (SparseAD) centré sur la recherche clairsemée est proposé ici, dans lequel la recherche clairsemée représente entièrement l'ensemble du scénario de conduite, y compris l'espace, le temps et les tâches, sans aucune représentation BEV dense. Plus précisément, une architecture clairsemée unifiée est conçue pour la connaissance des tâches, notamment la détection, le suivi et la cartographie en ligne. De plus, lourd

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

La détection de cibles est un problème relativement mature dans les systèmes de conduite autonome, parmi lesquels la détection des piétons est l'un des premiers algorithmes à être déployés. Des recherches très complètes ont été menées dans la plupart des articles. Cependant, la perception de la distance à l’aide de caméras fisheye pour une vue panoramique est relativement moins étudiée. En raison de la distorsion radiale importante, la représentation standard du cadre de délimitation est difficile à mettre en œuvre dans les caméras fisheye. Pour alléger la description ci-dessus, nous explorons les conceptions étendues de boîtes englobantes, d'ellipses et de polygones généraux dans des représentations polaires/angulaires et définissons une métrique de segmentation d'instance mIOU pour analyser ces représentations. Le modèle fisheyeDetNet proposé avec une forme polygonale surpasse les autres modèles et atteint simultanément 49,5 % de mAP sur l'ensemble de données de la caméra fisheye Valeo pour la conduite autonome.

DualBEV : dépassant largement BEVFormer et BEVDet4D, ouvrez le livre !

Mar 21, 2024 pm 05:21 PM

DualBEV : dépassant largement BEVFormer et BEVDet4D, ouvrez le livre !

Mar 21, 2024 pm 05:21 PM

Cet article explore le problème de la détection précise d'objets sous différents angles de vue (tels que la perspective et la vue à vol d'oiseau) dans la conduite autonome, en particulier comment transformer efficacement les caractéristiques de l'espace en perspective (PV) en vue à vol d'oiseau (BEV). implémenté via le module Visual Transformation (VT). Les méthodes existantes sont globalement divisées en deux stratégies : la conversion 2D en 3D et la conversion 3D en 2D. Les méthodes 2D vers 3D améliorent les caractéristiques 2D denses en prédisant les probabilités de profondeur, mais l'incertitude inhérente aux prévisions de profondeur, en particulier dans les régions éloignées, peut introduire des inexactitudes. Alors que les méthodes 3D vers 2D utilisent généralement des requêtes 3D pour échantillonner des fonctionnalités 2D et apprendre les poids d'attention de la correspondance entre les fonctionnalités 3D et 2D via un transformateur, ce qui augmente le temps de calcul et de déploiement.