ChatGPT peut devenir le modèle haut de gamme populaire partout dans le monde aujourd'hui, et il est indispensable en raison de la super puissance de calcul qui se cache derrière lui.

Les données montrent que la consommation totale d'énergie de calcul de ChatGPT est d'environ 3640PF-jours (c'est-à-dire que s'il calcule un quadrillion de fois par seconde, il faut 3640 jours pour calculer).

Alors, comment est né le supercalculateur construit par Microsoft spécifiquement pour OpenAI ?

Lundi, Microsoft a publié deux articles consécutifs sur son blog officiel, décryptant personnellement ce supercalculateur ultra-coûteux et la mise à niveau majeure d'Azure - ajoutant des milliers de cartes graphiques H100 les plus puissantes de NVIDIA et la technologie d'interconnexion réseau InfiniBand plus rapide.

Sur cette base, Microsoft a également annoncé officiellement la dernière machine virtuelle ND H100 v5. Les spécifications spécifiques sont les suivantes :

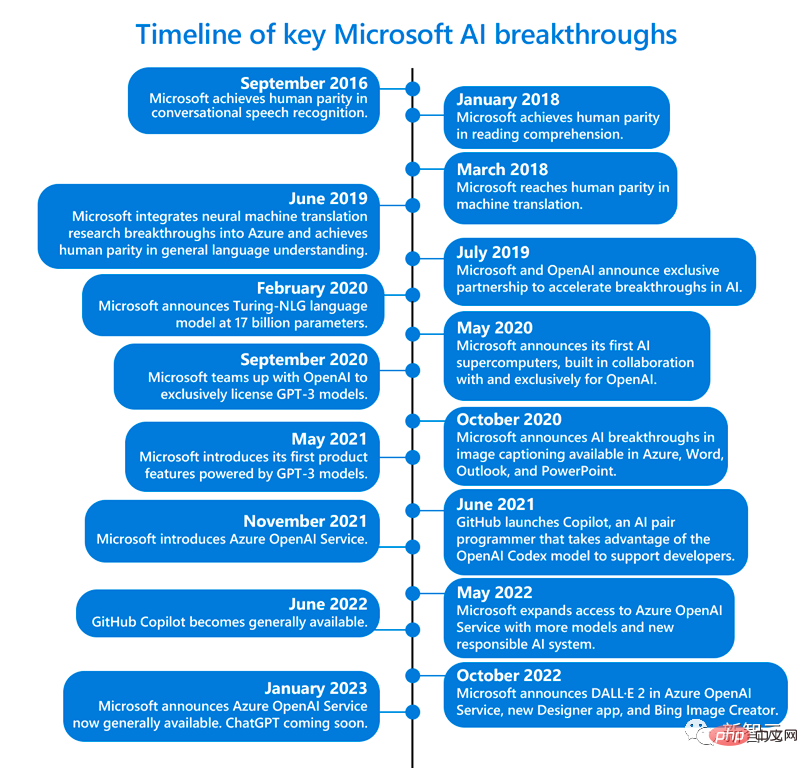

Par la suite, Microsoft a entamé une exploration difficile.

Nidhi Chappell (à gauche), chef de produit Azure High Performance Computing et Intelligence artificielle chez Microsoft, et Phil Waymouth (à droite), directeur principal des partenariats stratégiques chez Microsoft

Pour construire un supercalculateur pour soutenir le projet OpenAI, elle a dépensé des centaines de millions de dollars pour connecter des dizaines de milliers de puces Nvidia A100 ensemble sur la plate-forme de cloud computing Azure et réorganiser les racks de serveurs.

De plus, afin d'adapter cette plate-forme de calcul intensif à OpenAI, Microsoft est très dévoué et a accordé une attention particulière aux besoins d'OpenAI et s'est tenu au courant de ses besoins les plus critiques lors de la formation de l'IA.

Combien coûte un si gros projet ? Scott Guthrie, vice-président exécutif du cloud computing et de l'intelligence artificielle de Microsoft, n'a pas voulu divulguer le montant exact, mais a déclaré qu'il s'élevait « probablement à plus de » quelques centaines de millions de dollars.

Les problèmes d'OpenAIPhil Waymouth, responsable des partenariats stratégiques chez Microsoft, a souligné que l'ampleur de l'infrastructure de cloud computing requise pour les modèles de formation OpenAI est sans précédent dans l'industrie.

Croissance exponentielle de la taille des clusters de GPU réseau au-delà de ce que quiconque dans l'industrie a jamais essayé de construire.

La raison pour laquelle Microsoft est déterminé à coopérer avec OpenAI est qu'il croit fermement que cette infrastructure d'une ampleur sans précédent changera l'histoire, créera une nouvelle IA et une nouvelle plate-forme de programmation, et fournira aux clients des produits et services réellement disponibles. leurs intérêts.

Maintenant, il semble que ces centaines de millions de dollars n'ont manifestement pas été gaspillés - le pari était juste.

Sur ce superordinateur, les modèles qu'OpenAI peut former deviennent de plus en plus puissants, et il a débloqué les fonctions étonnantes des outils d'IA ChatGPT, qui a presque déclenché la quatrième révolution industrielle de l'humanité.

Très satisfait, Microsoft a investi 10 milliards de dollars supplémentaires dans OpenAI début janvier.

On peut dire que l’ambition de Microsoft de repousser les limites du supercalcul IA a porté ses fruits. Ce qui se reflète derrière cela est la transformation de la recherche en laboratoire vers l’industrialisation de l’IA.

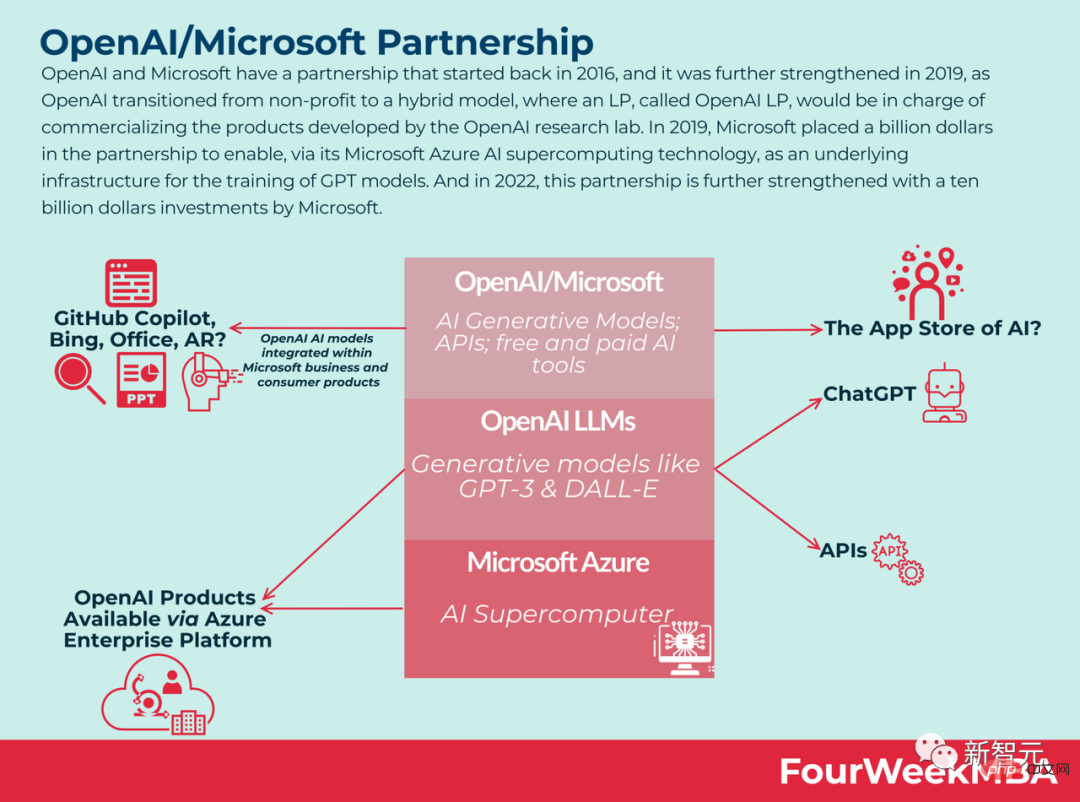

Actuellement, l’empire des logiciels bureautiques de Microsoft a commencé à prendre forme.

La version ChatGPT de Bing peut nous aider à rechercher des arrangements de vacances ; le chatbot de Viva Sales peut aider les spécialistes du marketing à rédiger des e-mails ; GitHub Copilot peut aider les développeurs à continuer à écrire du code ; le service Azure OpenAI nous permet d'accéder aux grands modèles de langage d'OpenAI et accédez aux fonctionnalités d'entreprise d'Azure.

En fait, en novembre de l'année dernière, Microsoft a officiellement annoncé qu'il s'associerait à Nvidia pour construire "l'un des superordinateurs d'IA les plus puissants au monde" pour répondre aux besoins de formation et expansion de l’IA.

Ce supercalculateur est basé sur l'infrastructure cloud Azure de Microsoft, utilisant des dizaines de milliers de GPU Nvidia H100 et A100 Tensor Core, et sa plateforme réseau Quantum-2 InfiniBand.

Nvidia a déclaré dans un communiqué que ce supercalculateur peut être utilisé pour étudier et accélérer des modèles d'IA génératifs tels que DALL-E et Stable Diffusion.

Alors que les chercheurs en IA commencent à utiliser des GPU plus puissants pour gérer des charges de travail d'IA plus complexes, ils voient un plus grand potentiel pour les modèles d'IA capables de comprendre suffisamment bien les nuances pour pouvoir gérer simultanément de nombreuses tâches linguistiques différentes.

En termes simples, plus le modèle est grand, plus vous disposez de données, plus vous pouvez l'entraîner longtemps, meilleure est la précision du modèle.

Mais ces modèles plus grands atteindront bientôt les limites des ressources informatiques existantes. Et Microsoft comprend à quoi ressemble le supercalculateur dont OpenAI a besoin et quelle doit être sa taille.

Cela ne signifie évidemment pas simplement acheter un tas de GPU et les connecter ensemble pour commencer à travailler ensemble.

Nidhi Chappell, responsable produit Azure High Performance Computing et Intelligence artificielle chez Microsoft, a déclaré : « Nous devons permettre aux modèles plus grands de s'entraîner plus longtemps, ce qui signifie non seulement que vous devez disposer de la plus grande infrastructure, mais que vous avez également pour qu'il fonctionne de manière fiable sur le long terme. »

Alistair Speirs, directeur d'Azure Global Infrastructure, a déclaré que Microsoft doit s'assurer qu'il peut refroidir toutes ces machines et puces. Les exemples incluent l’utilisation de l’air extérieur dans des climats plus froids et des refroidisseurs par évaporation de haute technologie dans des climats plus chauds.

De plus, puisque toutes les machines démarrent en même temps, Microsoft doit également considérer l'emplacement de celles-ci et l'alimentation électrique. C'est comme ce qui pourrait arriver si vous allumiez le micro-ondes, le grille-pain et l'aspirateur en même temps dans la cuisine, mais dans la version du centre de données.

Quelle est la clé pour réaliser ces avancées ?

Le défi consiste à savoir comment construire, exploiter et entretenir des dizaines de milliers de GPU colocalisés interconnectés sur un réseau InfiniBand à haut débit et à faible latence.

Cette échelle a largement dépassé la portée des tests effectués par les fournisseurs de GPU et d'équipements réseau, et constitue un territoire totalement inconnu. Personne ne sait si le matériel va tomber en panne à cette échelle.

Nidhi Chappell, responsable des produits de calcul haute performance et d'intelligence artificielle chez Microsoft Azure, a expliqué que lors du processus de formation du LLM, les calculs à grande échelle impliqués sont généralement divisés en milliers de GPU dans un cluster.

Dans une étape appelée allreduce, les GPU échangent des informations sur le travail qu'ils effectuent. À ce stade, l'accélération doit être effectuée via le réseau InfiniBand afin que le GPU puisse terminer le calcul avant le début du prochain bloc de calculs.

Nidhi Chappell a déclaré que, parce que ces efforts s'étendent sur des milliers de GPU, en plus d'assurer la fiabilité de l'infrastructure, de nombreuses optimisations au niveau du système sont nécessaires pour obtenir les meilleures performances, et cela sur plusieurs générations. par expérience.

L'optimisation dite au niveau du système comprend des logiciels capables d'utiliser efficacement le GPU et les équipements réseau.

Au cours des dernières années, Microsoft a développé cette technologie pour augmenter la capacité de former des modèles avec des dizaines de milliards de paramètres tout en réduisant le coût de formation et en servant ces modèles en production.

Waymouth a souligné que Microsoft et ses partenaires ont également progressivement augmenté la capacité des clusters GPU et développé des réseaux InfiniBand pour voir jusqu'où ils peuvent pousser l'infrastructure du centre de données requise pour maintenir le fonctionnement des clusters GPU, y compris les systèmes de refroidissement, l'alimentation électrique sans interruption. système et générateur de secours.

Eric Boyd, vice-président corporatif de Microsoft AI Platform, a déclaré que ce type de puissance de calcul optimisée pour la formation de modèles de langage à grande échelle et la prochaine vague d'innovation en IA est déjà disponible directement dans les services cloud Azure.

Et Microsoft a accumulé beaucoup d'expérience grâce à la coopération avec OpenAI. Lorsque d'autres partenaires viennent et souhaitent la même infrastructure, Microsoft peut également la fournir.

Maintenant, les centres de données Azure de Microsoft couvrent plus de 60 régions à travers le monde.

Nouvelle machine virtuelle : ND H100 v5

Sur l'infrastructure ci-dessus, Microsoft a continué de s'améliorer.

Aujourd'hui, Microsoft a officiellement annoncé de nouvelles machines virtuelles massivement évolutives qui intègrent le dernier GPU NVIDIA H100 Tensor Core et le réseau NVIDIA Quantum-2 InfiniBand.

Grâce aux machines virtuelles, Microsoft peut fournir à ses clients une infrastructure qui s'adapte à l'échelle de n'importe quelle tâche d'IA. Selon Microsoft, la nouvelle machine virtuelle ND H100 v5 d'Azure offre aux développeurs des performances supérieures tout en appelant des milliers de GPU.

Référence : https://www.php.cn/link/a7bf3f5462cc82062e41b3a2262e1a21

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

ébrécher

ébrécher

Inscription ChatGPT

Inscription ChatGPT

Encyclopédie ChatGPT nationale gratuite

Encyclopédie ChatGPT nationale gratuite

Comment installer chatgpt sur un téléphone mobile

Comment installer chatgpt sur un téléphone mobile

Chatgpt peut-il être utilisé en Chine ?

Chatgpt peut-il être utilisé en Chine ?

La différence et la connexion entre Java et Javascript

La différence et la connexion entre Java et Javascript

Quelle plateforme est lazada ?

Quelle plateforme est lazada ?

Comment résoudre les caractères chinois tronqués de Tomcat

Comment résoudre les caractères chinois tronqués de Tomcat

Refroidissement d'un ordinateur portable ASUS

Refroidissement d'un ordinateur portable ASUS