Périphériques technologiques

Périphériques technologiques

IA

IA

Parlons de la technologie de réduction du bruit de l'IA dans la communication en temps réel

Parlons de la technologie de réduction du bruit de l'IA dans la communication en temps réel

Parlons de la technologie de réduction du bruit de l'IA dans la communication en temps réel

Partie 01 Vue d'ensemble

Dans les scénarios de communication audio et vidéo en temps réel, lorsque le microphone collecte la voix de l'utilisateur, il collecte également une grande quantité de bruit ambiant uniquement grâce aux algorithmes traditionnels de réduction du bruit. gérer les bruits stables (tels que le vent du ventilateur, le fond blanc, etc.) Il a un certain effet sur le bruit transitoire non stationnaire (tel que le bruit du restaurant, le bruit ambiant du métro, le bruit de la cuisine à domicile, etc.), ce qui affecte sérieusement l'utilisateur expérience d'appel. En réponse à des centaines de problèmes de bruit non stationnaire dans des scénarios complexes tels que la maison et le bureau, l'équipe d'autonomisation écologique du Département des systèmes de communication intégrés a développé indépendamment une technologie de réduction du bruit audio IA basée sur le modèle GRU et grâce à l'optimisation d'algorithmes et d'ingénierie, réduit la taille du modèle de réduction du bruit. Comprimée de 2,4 Mo à 82 Ko, la mémoire en cours d'exécution est réduite d'environ 65 % ; la complexité de calcul est optimisée d'environ 186 Mflops à 42 Mflops et l'efficacité d'exécution est améliorée de 77 % dans l'existant ; Ensemble de données de test (dans l'environnement expérimental), la voix humaine et le bruit peuvent être efficacement séparés, améliorant ainsi le score Mos de la qualité de la voix de l'appel (valeur d'opinion moyenne) à 4,25.

Cet article présentera comment notre équipe effectue la suppression du bruit en temps réel basée sur l'apprentissage en profondeur et la met en œuvre sur les terminaux mobiles et l'application Jiaqin. Le texte complet sera organisé comme suit, présentant la classification du bruit et comment choisir des algorithmes pour résoudre ces problèmes de bruit ; comment concevoir des algorithmes et former des modèles d'IA grâce à l'apprentissage en profondeur ; enfin, il présentera les effets et les applications clés de l'IA actuelle ; scène de réduction du bruit.

Partie 02 Classification du bruit et sélection de l'algorithme de réduction du bruit

Dans les scénarios d'applications audio et vidéo en temps réel, l'appareil se trouve dans un environnement acoustique complexe. Lorsque le microphone collecte des signaux vocaux, il. collecte également une grande quantité de bruit. C'est un très gros défi pour la qualité audio et vidéo en temps réel. Il existe de nombreux types de bruit. Selon les caractéristiques statistiques mathématiques du bruit, le bruit peut être divisé en deux catégories :

Bruit stationnaire : Les caractéristiques statistiques du bruit ne changeront pas avec le temps pendant une période relativement longue, comme le bruit blanc et ventilateurs électriques, climatisation, bruit intérieur, etc. ; , bureaux, cuisines à domicile, etc.

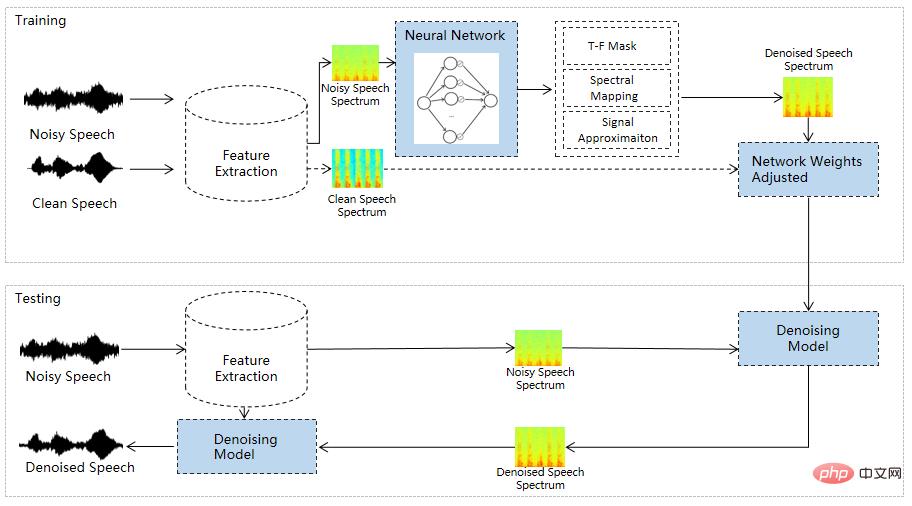

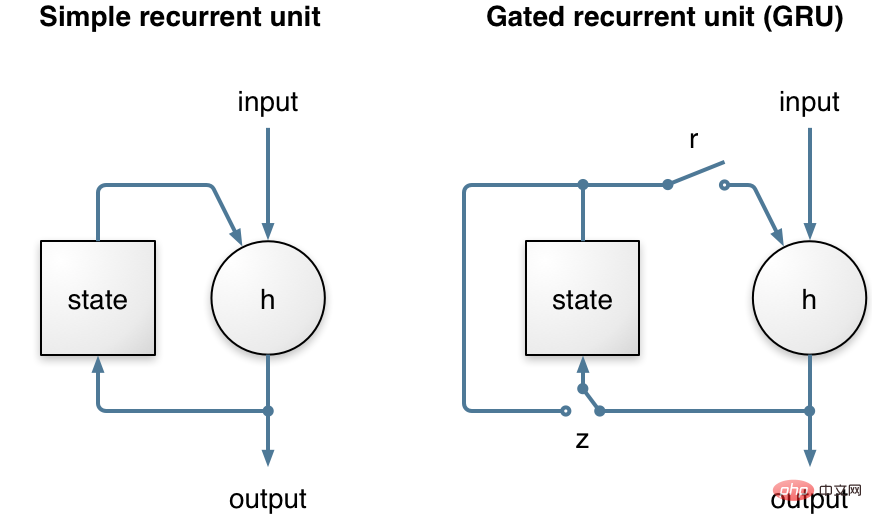

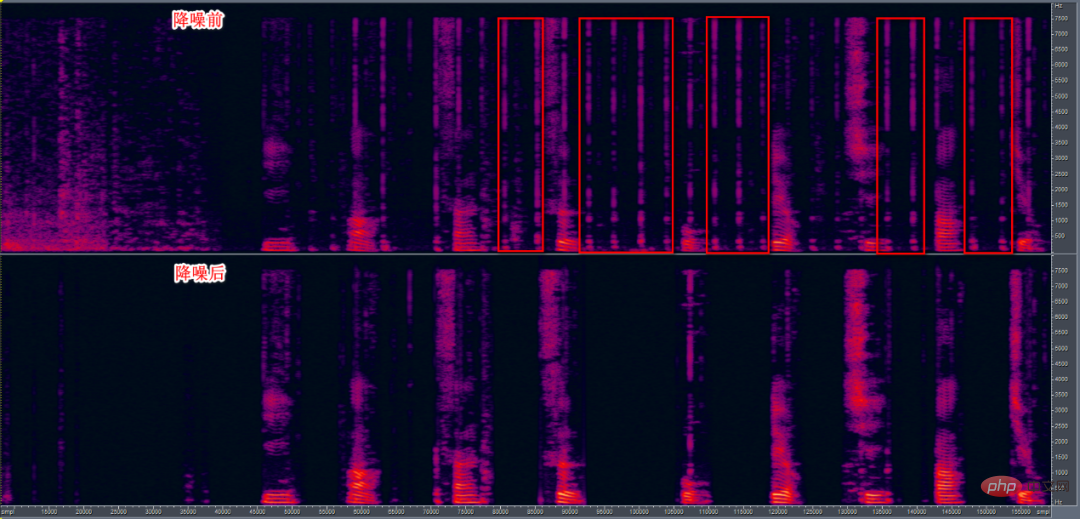

Dans les applications audio et vidéo en temps réel, les appels sont sensibles aux interférences de divers bruits, ce qui affecte l'expérience. Par conséquent, la réduction du bruit audio en temps réel est devenue une fonction importante dans la réalité. -temps audio et vidéo. Pour le bruit constant, tel que le vrombissement des climatiseurs ou le bruit de fond des équipements d'enregistrement, il ne changera pas de manière significative au fil du temps. Vous pouvez l'estimer, le prédire et le supprimer par une simple soustraction. Il existe des soustractions spectrales, des filtrages de Wiener et des ondelettes. transformer. Les bruits non stationnaires, tels que le bruit des voitures qui passent à toute allure sur la route, le claquement des assiettes dans les restaurants et le claquement des casseroles et des poêles dans les cuisines domestiques, apparaissent tous de manière aléatoire et inattendue, et il est impossible de les estimer et de les prévoir. .résolu. Les algorithmes traditionnels sont difficiles à estimer et à éliminer le bruit non stationnaire, c'est pourquoi nous utilisons des algorithmes d'apprentissage profond. Afin d'améliorer les capacités de réduction du bruit du SDK audio pour diverses scènes de bruit et de compenser les lacunes de la réduction de bruit traditionnelle algorithmes, nous avons développé un module de réduction du bruit AI basé sur RNN, combinant la technologie traditionnelle de réduction du bruit et la technologie d'apprentissage en profondeur. En se concentrant sur le traitement de la réduction du bruit pour les scénarios d'utilisation à la maison et au bureau, un grand nombre de types de bruit intérieur sont ajoutés à l'ensemble de données sur le bruit, tels que la frappe au clavier au bureau, les bruits de friction des bureaux et des fournitures de bureau traînés, le traînage des chaises et les cuisines. à la maison Bruits, claquements de sol, etc. Dans le même temps, afin de mettre en œuvre le traitement de la parole en temps réel sur le terminal mobile, cet algorithme de réduction du bruit audio IA contrôle la surcharge de calcul et la taille de la bibliothèque à un niveau très faible. En termes de surcharge de calcul, en prenant 48 KHz comme exemple, le traitement du réseau RNN de chaque trame vocale ne nécessite qu'environ 17,5 Mflops, FFT et IFFT nécessitent environ 7,5 Mflops de chaque trame vocale, et l'extraction de fonctionnalités nécessite environ 12 Mflops, pour un total d'environ 42 Mflops. La complexité de calcul est d'environ 48 kHz. Dans une certaine marque de modèles de téléphones mobiles de milieu de gamme, les statistiques indiquent que l'utilisation du processeur du module de réduction du bruit RNN est d'environ 4 %. En termes de taille de la bibliothèque audio, après avoir activé la compilation de réduction du bruit RNN, la taille de la bibliothèque du moteur audio n'augmente que d'environ 108 Ko. Ce module utilise le modèle RNN car RNN transporte des informations temporelles par rapport à d'autres modèles d'apprentissage (tels que CNN) et peut modéliser des signaux de synchronisation, plutôt que séparez simplement les images d’entrée et de sortie audio. Dans le même temps, le modèle utilise une unité récurrente fermée (GRU, comme le montre la figure 1). Les expériences montrent que GRU fonctionne légèrement mieux que LSTM sur les tâches de réduction du bruit vocal et que, comme GRU a moins de paramètres de poids, il peut économiser des ressources informatiques. . Par rapport à une simple unité de boucle, un GRU possède deux portes supplémentaires. L'état de contrôle de porte de réinitialisation est utilisé pour calculer le nouvel état, tandis que l'état de contrôle de porte de mise à jour indique dans quelle mesure il changera en fonction de la nouvelle entrée. Cette porte de mise à jour permet à GRU de mémoriser les informations de synchronisation pendant une longue période, c'est pourquoi GRU fonctionne mieux que de simples unités récurrentes. Figure 1 Le côté gauche est une unité cyclique simple et le côté droit est GRU La structure du modèle est présentée dans la figure 2. Le modèle formé sera intégré dans le SDK de communication audio et vidéo. En lisant le flux audio du périphérique matériel, le flux audio sera encadré et envoyé au module de prétraitement de réduction du bruit AI. Le module de prétraitement ajoutera les fonctionnalités correspondantes. (Fonctionnalité) est calculé et transmis au modèle entraîné. La valeur de gain correspondante (Gain) est calculée via le modèle, et la valeur de gain est utilisée pour ajuster le signal, atteignant finalement l'objectif de réduction du bruit (comme le montre la figure 3). . Figure 2. Modèle de réseau RNN basé sur GRU Processus de formation, vous trouverez ci-dessous le processus de réduction du bruit en temps réel La figure 4 montre la comparaison des spectrogrammes vocaux avant et après la réduction du bruit avec le bruit de frappe du clavier. , dans lequel la case rectangulaire rouge représente le bruit de frappe du clavier. La partie inférieure est le signal vocal après réduction du bruit. Grâce à l'observation, on peut constater que la plupart des sons de frappe du clavier peuvent être supprimés, tandis que les dommages vocaux sont contrôlés à un faible niveau. Figure 4. Discours bruyant (accompagné de sons de frappe du clavier pendant l'appel) avant et après comparaison Le modèle actuel de réduction du bruit de l'IA est déjà sur le téléphone mobile Hejiaqin est en ligne pour améliorer l'effet de réduction du bruit des appels sur les téléphones mobiles et l'application Jiaqin possède d'excellentes capacités de suppression dans plus de 100 scénarios de bruit, y compris les maisons et les bureaux, tout en conservant la distorsion de la voix. Dans la prochaine étape, nous continuerons à optimiser la complexité informatique du modèle de réduction du bruit de l'IA afin qu'il puisse être promu et utilisé sur les appareils IoT à faible consommation.

Partie 03 Conception d'algorithmes de réduction du bruit d'apprentissage profond

Partie 04 Modèle de réseau et flux de traitement

Partie 05 Effet et mise en œuvre du traitement de réduction du bruit de l'IA

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

La commande de fermeture CENTOS est arrêtée et la syntaxe est la fermeture de [options] le temps [informations]. Les options incluent: -H Arrêtez immédiatement le système; -P éteignez l'alimentation après l'arrêt; -r redémarrer; -t temps d'attente. Les temps peuvent être spécifiés comme immédiats (maintenant), minutes (minutes) ou une heure spécifique (HH: mm). Des informations supplémentaires peuvent être affichées dans les messages système.

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

La politique de sauvegarde et de récupération de GitLab dans le système CentOS afin d'assurer la sécurité et la récupérabilité des données, Gitlab on CentOS fournit une variété de méthodes de sauvegarde. Cet article introduira plusieurs méthodes de sauvegarde courantes, paramètres de configuration et processus de récupération en détail pour vous aider à établir une stratégie complète de sauvegarde et de récupération de GitLab. 1. MANUEL BACKUP Utilisez le Gitlab-RakegitLab: Backup: Créer la commande pour exécuter la sauvegarde manuelle. Cette commande sauvegarde des informations clés telles que le référentiel Gitlab, la base de données, les utilisateurs, les groupes d'utilisateurs, les clés et les autorisations. Le fichier de sauvegarde par défaut est stocké dans le répertoire / var / opt / gitlab / backups. Vous pouvez modifier / etc / gitlab

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Guide complet pour vérifier la configuration HDFS dans les systèmes CentOS Cet article vous guidera comment vérifier efficacement la configuration et l'état de l'exécution des HDF sur les systèmes CentOS. Les étapes suivantes vous aideront à bien comprendre la configuration et le fonctionnement des HDF. Vérifiez la variable d'environnement Hadoop: Tout d'abord, assurez-vous que la variable d'environnement Hadoop est correctement définie. Dans le terminal, exécutez la commande suivante pour vérifier que Hadoop est installé et configuré correctement: HadoopVersion Check HDFS Fichier de configuration: Le fichier de configuration de base de HDFS est situé dans le répertoire / etc / hadoop / conf / le répertoire, où Core-site.xml et hdfs-site.xml sont cruciaux. utiliser

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Activer l'accélération du GPU Pytorch sur le système CentOS nécessite l'installation de versions CUDA, CUDNN et GPU de Pytorch. Les étapes suivantes vous guideront tout au long du processus: CUDA et CUDNN Installation détermineront la compatibilité de la version CUDA: utilisez la commande NVIDIA-SMI pour afficher la version CUDA prise en charge par votre carte graphique NVIDIA. Par exemple, votre carte graphique MX450 peut prendre en charge CUDA11.1 ou plus. Téléchargez et installez Cudatoolkit: visitez le site officiel de Nvidiacudatoolkit et téléchargez et installez la version correspondante selon la version CUDA la plus élevée prise en charge par votre carte graphique. Installez la bibliothèque CUDNN:

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Docker utilise les fonctionnalités du noyau Linux pour fournir un environnement de fonctionnement d'application efficace et isolé. Son principe de travail est le suivant: 1. Le miroir est utilisé comme modèle en lecture seule, qui contient tout ce dont vous avez besoin pour exécuter l'application; 2. Le Système de fichiers Union (UnionFS) empile plusieurs systèmes de fichiers, ne stockant que les différences, l'économie d'espace et l'accélération; 3. Le démon gère les miroirs et les conteneurs, et le client les utilise pour l'interaction; 4. Les espaces de noms et les CGROUP implémentent l'isolement des conteneurs et les limitations de ressources; 5. Modes de réseau multiples prennent en charge l'interconnexion du conteneur. Ce n'est qu'en comprenant ces concepts principaux que vous pouvez mieux utiliser Docker.

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

L'installation de MySQL sur CENTOS implique les étapes suivantes: Ajout de la source MySQL YUM appropriée. Exécutez la commande YUM Install MySQL-Server pour installer le serveur MySQL. Utilisez la commande mysql_secure_installation pour créer des paramètres de sécurité, tels que la définition du mot de passe de l'utilisateur racine. Personnalisez le fichier de configuration MySQL selon les besoins. Écoutez les paramètres MySQL et optimisez les bases de données pour les performances.

CentOS8 redémarre SSH

Apr 14, 2025 pm 09:00 PM

CentOS8 redémarre SSH

Apr 14, 2025 pm 09:00 PM

La commande pour redémarrer le service SSH est: SystemCTL Redémarrer SSHD. Étapes détaillées: 1. Accédez au terminal et connectez-vous au serveur; 2. Entrez la commande: SystemCTL Restart SSHD; 3. Vérifiez l'état du service: SystemCTL Status Sshd.

Comment faire fonctionner la formation distribuée de Pytorch sur CentOS

Apr 14, 2025 pm 06:36 PM

Comment faire fonctionner la formation distribuée de Pytorch sur CentOS

Apr 14, 2025 pm 06:36 PM

La formation distribuée par Pytorch sur le système CentOS nécessite les étapes suivantes: Installation de Pytorch: La prémisse est que Python et PIP sont installés dans le système CentOS. Selon votre version CUDA, obtenez la commande d'installation appropriée sur le site officiel de Pytorch. Pour la formation du processeur uniquement, vous pouvez utiliser la commande suivante: pipinstalltorchtorchVisionTorChaudio Si vous avez besoin d'une prise en charge du GPU, assurez-vous que la version correspondante de CUDA et CUDNN est installée et utilise la version Pytorch correspondante pour l'installation. Configuration de l'environnement distribué: la formation distribuée nécessite généralement plusieurs machines ou des GPU multiples uniques. Lieu