Périphériques technologiques

Périphériques technologiques

IA

IA

Cet article vous donnera une compréhension facile à comprendre de la conduite autonome

Cet article vous donnera une compréhension facile à comprendre de la conduite autonome

Cet article vous donnera une compréhension facile à comprendre de la conduite autonome

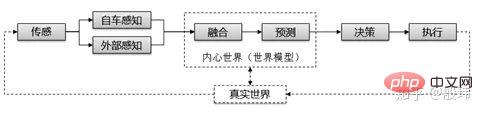

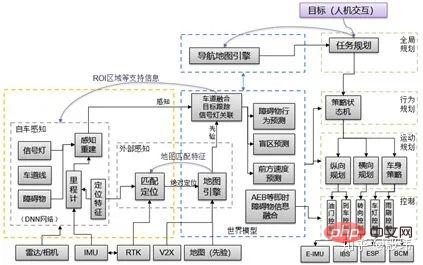

Les principes de la conduite autonome sont souvent mieux compris à partir de l'architecture de la conduite autonome. La compréhension la plus simple et la plus facile à comprendre de la conduite autonome par le public est la perception, la prise de décision et l'exécution. Tous les robots ont cette structure.

- La perception répond aux questions sur ce qui nous entoure, à l'instar des yeux et des oreilles humains. Obtenez des informations sur les obstacles et les routes environnantes grâce à des caméras, des radars, des cartes et d'autres moyens.

- La prise de décision répond à la question de savoir ce que je veux faire, à l'instar du cerveau. En analysant les informations détectées, la trajectoire et la vitesse du véhicule sont générées.

- L'exécution est similaire aux mains et aux pieds, convertissant les informations de prise de décision en signaux de freinage, d'accélérateur et de direction pour contrôler le véhicule pour qu'il conduise comme prévu.

Ensuite, nous approfondissons et le problème commence à devenir un peu plus compliqué.

Dans notre vie quotidienne, nous pouvons intuitivement penser que je prends ma prochaine décision en fonction des informations que je vois avec mes yeux à chaque instant, mais ce n'est souvent pas le cas. Il y a toujours un décalage entre les yeux, la tête, les mains et les pieds, et il en va de même pour la conduite autonome. Mais nous n’en ressentons pas l’impact, car notre cerveau gère automatiquement les prédictions. Même si cela ne dure que quelques millisecondes, nos décisions sont basées sur des prédictions de ce que nous voyons pour guider le fonctionnement de nos mains et de nos pieds. C'est la base pour que nous puissions maintenir des fonctions normales. Par conséquent, nous ajouterons un module de prédiction avant les décisions de conduite autonome.

Le processus de perception contient également l'univers, et après un examen attentif, il peut être divisé en deux étapes : « détection » et « perception ». La « détection » obtient des données brutes à partir de capteurs tels que des images, tandis que la « perception » traite des informations utiles à partir d'images (telles que le nombre de personnes sur la photo). Comme le dit le vieil adage : « Voir c'est croire, entendre c'est croire ». Les informations utiles de la « perception » peuvent être divisées en perception du véhicule autonome et perception externe. Les personnes ou les voitures autonomes ont souvent des stratégies différentes lors du traitement de ces deux types d'informations.

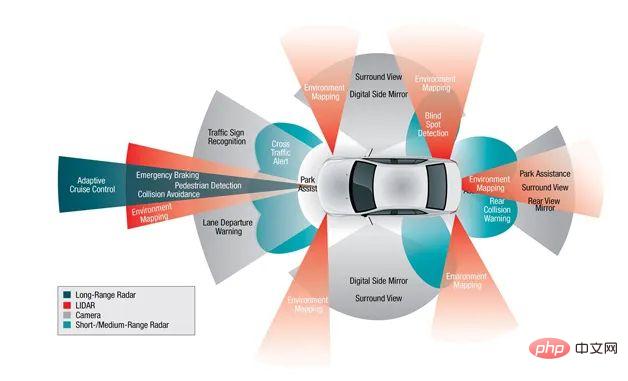

- Perception du véhicule autonome - informations obtenues par les récepteurs à tout moment (y compris caméras, radar, GPS, etc.)

- Perception externe - informations collectées et traitées par des agents externes ou des souvenirs passés (y compris le positionnement, les cartes , informations liées au véhicule, etc.), le principe nécessite l'entrée d'un capteur de positionnement autonome (GPS).

De plus, les informations sur les obstacles, les voies et autres informations traitées par divers capteurs via des algorithmes sont souvent contradictoires. Si le radar voit un obstacle devant vous mais que la caméra vous indique qu'il n'y en a pas, alors vous devez ajouter un module « fusion ». Établissez d’autres liens et jugements sur des informations incohérentes.

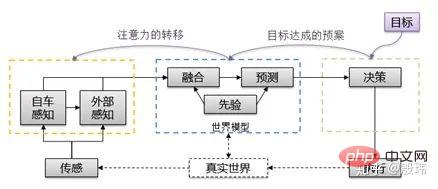

Ici, nous résumons souvent « fusion et prédiction » par « modèle mondial ». Ce mot est très vivant, que vous soyez matérialiste ou idéaliste. Il est impossible d'entasser tout le « monde » dans votre cerveau, mais ce qui guide notre travail et notre vie est le « modèle » du « monde », c'est-à-dire en traitant ce que nous voyons après notre naissance et en construisant progressivement un modèle. dans notre esprit, la compréhension taoïste du monde est appelée « vision intérieure ». La responsabilité principale du modèle mondial est de comprendre les attributs et les relations des éléments environnementaux actuels par la « fusion », et de faire des « prédictions » en conjonction avec des « lois a priori » pour fournir cette fois un jugement plus tranquille pour l'exécution des décisions. la durée peut aller de quelques millisecondes à quelques secondes.

Grâce à l'ajout du modèle mondial, l'architecture entière est devenue plus riche, mais il y a un autre détail qui est souvent négligé. C'est le flux d'informations. Une compréhension simple est que les gens perçoivent les choses à travers leurs yeux, les traitent dans le cerveau et les remettent finalement à leurs mains et à leurs pieds pour exécution. Cependant, la situation réelle est souvent plus compliquée. Il existe ici deux comportements typiques qui constituent un flux d'informations complètement opposé, à savoir le « plan pour atteindre l'objectif » et le « déplacement de l'attention ».

Comment comprenez-vous « planifier pour atteindre les objectifs » ? En fait, le début de la réflexion n'est pas une perception mais un « but ». Ce n'est que lorsque vous avez un objectif que vous pouvez déclencher un processus « perception-décision-exécution » significatif. Par exemple, si vous souhaitez vous rendre à une destination, vous connaissez peut-être plusieurs itinéraires, et vous choisirez finalement l'un des itinéraires en fonction de celui-ci. situation de congestion. La congestion appartient au modèle mondial, tandis que « y parvenir » appartient à la décision. C’est le processus par lequel les décisions sont transmises au modèle mondial.

Comment comprendre le « déplacement d'attention » ? Même s’il s’agit d’une image, ni les humains ni les machines ne peuvent obtenir toutes les informations qui s’y cachent. Partant d’un besoin et d’un contexte, nous avons tendance à nous concentrer sur une portée et des catégories limitées. Cette information ne peut pas être obtenue à partir de l'image elle-même, mais provient du « modèle du monde » et du « but ». Il s'agit d'un processus allant de la prise de décision au modèle du monde puis à la perception.

Nous ajoutons quelques informations nécessaires et réorganisons toute la structure Cela ressemble à ceci. Est-ce un peu plus compliqué ? Ce n’est pas encore fini, continuons à regarder.

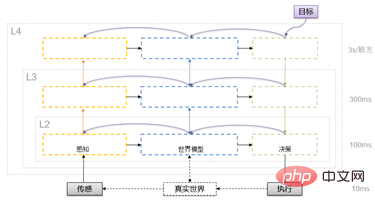

L'algorithme de conduite autonome, comme le cerveau, a une exigence en matière de temps de traitement. Le cycle général se situe entre 10 ms et 100 ms, ce qui peut répondre aux exigences de réponse aux changements environnementaux. Mais l’environnement est parfois simple et parfois très complexe. De nombreux modules d'algorithmes ne peuvent pas répondre à cette exigence de temps. Par exemple, réfléchir au sens de la vie n’est peut-être pas quelque chose qui peut être fait en 100 ms. Si vous devez penser à la vie à chaque étape, cela doit être une sorte de destruction du cerveau. Il en va de même pour les ordinateurs. Il existe des limites physiques à la puissance et à la vitesse de calcul. La solution consiste à introduire un cadre en couches.

Ce mécanisme en couches raccourcira généralement le cycle de traitement de 3 à 10 fois à mesure qu'il augmente. Bien sûr, il n'a pas nécessairement besoin d'apparaître complètement dans le cadre réel. Le projet peut être ajusté de manière flexible en fonction de l'intégration. utilisation des ressources et des algorithmes. Fondamentalement, la perception est un processus ascendant qui affine continuellement des éléments spécifiques en fonction de l'attention, fournissant des informations perceptuelles avec « de la profondeur et de la direction ». La prise de décision est un processus descendant, décomposant les actions depuis l'objectif vers chaque unité d'exécution couche par couche selon différents niveaux de modèles mondiaux. Les modèles mondiaux n’ont généralement pas de direction de flux spécifique et sont utilisés pour construire des informations environnementales à différentes échelles granulaires.

Selon la complexité des tâches de traitement, la division du travail et l'environnement de communication seront également castrés et fusionnés de manière appropriée. Par exemple, les fonctions ADAS de bas niveau (ACC) nécessitent moins de puissance de calcul et peuvent être conçues avec une seule couche. Les fonctions ADAS haut de gamme (AutoPilot) disposent généralement de deux niveaux de configuration. Quant à la fonction de conduite autonome, il existe de nombreux algorithmes complexes, et une conception à trois couches est parfois nécessaire. Dans la conception d'architecture logicielle, il existe également des situations dans lesquelles le modèle mondial et le module de perception ou de prise de décision d'une même couche sont fusionnés.

Diverses entreprises de conduite autonome ou normes industrielles publieront leurs propres conceptions d'architecture logicielle, mais elles sont souvent le résultat d'une castration basée sur la situation actuelle et ne sont pas universelles. Cependant, afin de faciliter la compréhension de tous, je. Disons-le toujours Les modules fonctionnels traditionnels actuels sont remplacés. Jetons un coup d'œil à la relation de comparaison, qui sera plus utile pour comprendre le principe.

Vous devez faire attention à l'avance ici. Bien que cela signifie déjà un peu d'architecture logicielle, il s'agit toujours d'une description du principe. La conception réelle de l'architecture logicielle est encore plus compliquée que cela, et il y en a. rien de tel ici. Développez tous les détails, mais concentrez-vous sur les parties qui se confondent facilement. Concentrons-nous dessus ci-dessous.

Perception de l'environnement - TOUT EN Deep Learning

Afin de garantir que les véhicules sans pilote comprennent et appréhendent l'environnement, la partie perception de l'environnement du système de conduite sans pilote doit généralement obtenir une grande quantité d'informations sur l'environnement environnant, y compris l'emplacement des obstacles, la vitesse, la forme précise de la voie devant vous et le type d'emplacement des panneaux d'attente. Ces informations sont généralement obtenues en fusionnant les données de plusieurs capteurs tels qu'un lidar, une caméra périphérique/surround et un radar à ondes millimétriques.

Le développement de l'apprentissage profond a fait un consensus à l'échelle de l'industrie pour achever la construction de la conduite autonome grâce à des algorithmes de réseaux neuronaux. L'algorithme du module de perception est le « pion » de l'ensemble du processus d'apprentissage profond et est le premier module logiciel à achever la transformation.

Relations et différences entre les cartes de positionnement et la détection des véhicules autonomes V2X et la perception externe

Au sens traditionnel, la perception externe est basée sur les signaux de positionnement GPS, combinant des cartes de haute précision et des messages Internet des véhicules (V2X) et d'autres systèmes de coordonnées absolues sont transformés en système de coordonnées du véhicule autonome en tant que source de détection pour le véhicule. Il est similaire au navigateur Amap utilisé par les gens. Combiné avec les informations de « perception du véhicule autonome » initialement présentes dans le système de coordonnées du véhicule autonome, il fournit des informations environnementales pour la conduite autonome.

Mais la conception réelle est souvent plus compliquée. En raison du manque de fiabilité du GPS, l'IMU doit être continuellement corrigée. Le positionnement de conduite autonome produit en série utilise souvent la correspondance des cartes de perception pour obtenir avec précision la position absolue. utilise les résultats de perception pour corriger l'IMU. Obtenez une position relative précise et formez une redondance avec le système INS composé de GPS-IMU. Par conséquent, les signaux de positionnement nécessaires à la « perception externe » reposent souvent sur des informations de « perception du véhicule propre ».

De plus, bien que la carte fasse strictement partie du « modèle mondial », en raison de la sensibilité du GPS, lors du processus de mise en œuvre du logiciel national, le module de positionnement et le module de carte seront intégrés et biaisés. garantit qu’aucune information de positionnement sensible n’est divulguée.

Module de prédiction de fusion - l'accent est mis sur la différence entre les deux

Le cœur de la fusion est de résoudre deux problèmes. L'un est le problème de synchronisation temporelle et spatiale, en utilisant l'algorithme de conversion du système de coordonnées. et l'algorithme de synchronisation temporelle de la collaboration logicielle et matérielle. Tout d'abord, alignez les résultats de mesure de détection tels que le lidar, la caméra et le radar à ondes millimétriques sur un point spatio-temporel pour garantir l'unité des données brutes pour l'ensemble de la perception de l'environnement. L'autre consiste à résoudre le problème d'association et d'élimination des anomalies, à gérer l'association de différents capteurs mappant au même élément de « modèle mondial » (une personne/une voie, etc.), et à éliminer les anomalies qui peuvent être causées par une mauvaise détection par un capteur unique. Cependant, la différence fondamentale entre la fusion et la prédiction est qu’elles traitent uniquement les informations du passé et du moment présent, et ne traitent pas les moments externes.

La prédiction portera un jugement sur l'heure future en fonction des résultats de la fusion. Cette heure future varie de 10 ms à 5 minutes. Cela inclut la prédiction des feux de circulation, la prédiction de la trajectoire des obstacles environnants ou la prédiction des positions éloignées dans les virages. Les prévisions de différentes périodes fourniront une planification pour les périodes correspondantes et des prévisions de différentes granularités, offrant ainsi un plus grand espace pour les ajustements de planification.

Contrôle de la planification - Décomposition de la stratégie hiérarchique

La planification est le processus par lequel les véhicules autonomes prennent des décisions ciblées pour un certain objectif. Pour les véhicules autonomes, cet objectif fait généralement référence à Aller du point de départ à la destination tout en. éviter les obstacles et optimiser en permanence les trajectoires et les comportements de conduite pour assurer la sécurité et le confort des passagers. Le résumé structurel de la planification consiste à intégrer des informations basées sur différentes granularités de l'environnement, à effectuer une évaluation et une décomposition couche par couche à partir d'objectifs externes, et enfin à les transmettre à l'exécuteur testamentaire pour prendre une décision complète.

Décomposé, le module de planification est généralement divisé en trois couches : Planification de mission, Planification comportementale et Planification de mouvement. Le cœur de la planification de mission est basé sur des réseaux routiers et des chemins discrets. L'algorithme de recherche obtient le chemin global et est donné. un type de tâche à grande échelle, qui a souvent un cycle long. La planification du comportement est basée sur une machine à états finis pour déterminer le comportement spécifique que le véhicule doit adopter dans un cycle moyen (changer de voie à gauche, éviter les détours, E-STOP) et définir certains paramètres de limite et la plage approximative du chemin. La couche de planification du mouvement s'appuie souvent sur des méthodes d'échantillonnage ou d'optimisation pour obtenir au final le seul chemin répondant aux exigences de confort et de sécurité. Enfin, il est confié au module de commande pour suivre le chemin unique à travers des algorithmes de prédiction anticipée et de contrôle de rétroaction, et manipuler les freins, la direction, l'accélérateur, la carrosserie et d'autres actionneurs pour finalement exécuter la commande.

Je ne sais pas quel niveau vous avez compris, mais ce qui précède n'est qu'une introduction aux principes de la conduite autonome. Les théories, algorithmes et architectures actuelles de la conduite autonome se développent très rapidement, bien que le contenu ci-dessus soit relativement basique. point de connaissance, il ne sera pas obsolète avant longtemps. Mais les nouvelles exigences ont apporté de nombreuses nouvelles compréhensions de l’architecture et des principes de la conduite autonome.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Pourquoi le Gaussian Splatting est-il si populaire dans la conduite autonome que le NeRF commence à être abandonné ?

Jan 17, 2024 pm 02:57 PM

Pourquoi le Gaussian Splatting est-il si populaire dans la conduite autonome que le NeRF commence à être abandonné ?

Jan 17, 2024 pm 02:57 PM

Écrit ci-dessus et compréhension personnelle de l'auteur Le Gaussiansplatting tridimensionnel (3DGS) est une technologie transformatrice qui a émergé dans les domaines des champs de rayonnement explicites et de l'infographie ces dernières années. Cette méthode innovante se caractérise par l’utilisation de millions de gaussiennes 3D, ce qui est très différent de la méthode du champ de rayonnement neuronal (NeRF), qui utilise principalement un modèle implicite basé sur les coordonnées pour mapper les coordonnées spatiales aux valeurs des pixels. Avec sa représentation explicite de scènes et ses algorithmes de rendu différenciables, 3DGS garantit non seulement des capacités de rendu en temps réel, mais introduit également un niveau de contrôle et d'édition de scène sans précédent. Cela positionne 3DGS comme un révolutionnaire potentiel pour la reconstruction et la représentation 3D de nouvelle génération. À cette fin, nous fournissons pour la première fois un aperçu systématique des derniers développements et préoccupations dans le domaine du 3DGS.

Comment résoudre le problème de la longue traîne dans les scénarios de conduite autonome ?

Jun 02, 2024 pm 02:44 PM

Comment résoudre le problème de la longue traîne dans les scénarios de conduite autonome ?

Jun 02, 2024 pm 02:44 PM

Hier, lors de l'entretien, on m'a demandé si j'avais posé des questions à longue traîne, j'ai donc pensé faire un bref résumé. Le problème à longue traîne de la conduite autonome fait référence aux cas extrêmes dans les véhicules autonomes, c'est-à-dire à des scénarios possibles avec une faible probabilité d'occurrence. Le problème perçu de la longue traîne est l’une des principales raisons limitant actuellement le domaine de conception opérationnelle des véhicules autonomes intelligents à véhicule unique. L'architecture sous-jacente et la plupart des problèmes techniques de la conduite autonome ont été résolus, et les 5 % restants des problèmes à longue traîne sont progressivement devenus la clé pour restreindre le développement de la conduite autonome. Ces problèmes incluent une variété de scénarios fragmentés, de situations extrêmes et de comportements humains imprévisibles. La « longue traîne » des scénarios limites dans la conduite autonome fait référence aux cas limites dans les véhicules autonomes (VA). Les cas limites sont des scénarios possibles avec une faible probabilité d'occurrence. ces événements rares

Choisir une caméra ou un lidar ? Une étude récente sur la détection robuste d'objets 3D

Jan 26, 2024 am 11:18 AM

Choisir une caméra ou un lidar ? Une étude récente sur la détection robuste d'objets 3D

Jan 26, 2024 am 11:18 AM

0. Écrit à l'avant&& Compréhension personnelle que les systèmes de conduite autonome s'appuient sur des technologies avancées de perception, de prise de décision et de contrôle, en utilisant divers capteurs (tels que caméras, lidar, radar, etc.) pour percevoir l'environnement et en utilisant des algorithmes et des modèles pour une analyse et une prise de décision en temps réel. Cela permet aux véhicules de reconnaître les panneaux de signalisation, de détecter et de suivre d'autres véhicules, de prédire le comportement des piétons, etc., permettant ainsi de fonctionner en toute sécurité et de s'adapter à des environnements de circulation complexes. Cette technologie attire actuellement une grande attention et est considérée comme un domaine de développement important pour l'avenir des transports. . un. Mais ce qui rend la conduite autonome difficile, c'est de trouver comment faire comprendre à la voiture ce qui se passe autour d'elle. Cela nécessite que l'algorithme de détection d'objets tridimensionnels du système de conduite autonome puisse percevoir et décrire avec précision les objets dans l'environnement, y compris leur emplacement,

Avez-vous vraiment maîtrisé la conversion des systèmes de coordonnées ? Des enjeux multi-capteurs indispensables à la conduite autonome

Oct 12, 2023 am 11:21 AM

Avez-vous vraiment maîtrisé la conversion des systèmes de coordonnées ? Des enjeux multi-capteurs indispensables à la conduite autonome

Oct 12, 2023 am 11:21 AM

Le premier article pilote et clé présente principalement plusieurs systèmes de coordonnées couramment utilisés dans la technologie de conduite autonome, et comment compléter la corrélation et la conversion entre eux, et enfin construire un modèle d'environnement unifié. L'objectif ici est de comprendre la conversion du véhicule en corps rigide de caméra (paramètres externes), la conversion de caméra en image (paramètres internes) et la conversion d'image en unité de pixel. La conversion de 3D en 2D aura une distorsion, une traduction, etc. Points clés : Le système de coordonnées du véhicule et le système de coordonnées du corps de la caméra doivent être réécrits : le système de coordonnées planes et le système de coordonnées des pixels Difficulté : la distorsion de l'image doit être prise en compte. La dé-distorsion et l'ajout de distorsion sont compensés sur le plan de l'image. 2. Introduction Il existe quatre systèmes de vision au total : système de coordonnées du plan de pixels (u, v), système de coordonnées d'image (x, y), système de coordonnées de caméra () et système de coordonnées mondiales (). Il existe une relation entre chaque système de coordonnées,

Cet article vous suffit pour en savoir plus sur la conduite autonome et la prédiction de trajectoire !

Feb 28, 2024 pm 07:20 PM

Cet article vous suffit pour en savoir plus sur la conduite autonome et la prédiction de trajectoire !

Feb 28, 2024 pm 07:20 PM

La prédiction de trajectoire joue un rôle important dans la conduite autonome. La prédiction de trajectoire de conduite autonome fait référence à la prédiction de la trajectoire de conduite future du véhicule en analysant diverses données pendant le processus de conduite du véhicule. En tant que module central de la conduite autonome, la qualité de la prédiction de trajectoire est cruciale pour le contrôle de la planification en aval. La tâche de prédiction de trajectoire dispose d'une riche pile technologique et nécessite une connaissance de la perception dynamique/statique de la conduite autonome, des cartes de haute précision, des lignes de voie, des compétences en architecture de réseau neuronal (CNN&GNN&Transformer), etc. Il est très difficile de démarrer ! De nombreux fans espèrent se lancer dans la prédiction de trajectoire le plus tôt possible et éviter les pièges. Aujourd'hui, je vais faire le point sur quelques problèmes courants et des méthodes d'apprentissage introductives pour la prédiction de trajectoire ! Connaissances introductives 1. Existe-t-il un ordre d'entrée pour les épreuves de prévisualisation ? R : Regardez d’abord l’enquête, p

SIMPL : un benchmark de prédiction de mouvement multi-agents simple et efficace pour la conduite autonome

Feb 20, 2024 am 11:48 AM

SIMPL : un benchmark de prédiction de mouvement multi-agents simple et efficace pour la conduite autonome

Feb 20, 2024 am 11:48 AM

Titre original : SIMPL : ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving Lien article : https://arxiv.org/pdf/2402.02519.pdf Lien code : https://github.com/HKUST-Aerial-Robotics/SIMPL Affiliation de l'auteur : Université des sciences de Hong Kong et technologie Idée DJI Paper : cet article propose une base de référence de prédiction de mouvement (SIMPL) simple et efficace pour les véhicules autonomes. Par rapport au cent agent traditionnel

Parlons des systèmes de conduite autonome de bout en bout et de nouvelle génération, ainsi que de quelques malentendus sur la conduite autonome de bout en bout ?

Apr 15, 2024 pm 04:13 PM

Parlons des systèmes de conduite autonome de bout en bout et de nouvelle génération, ainsi que de quelques malentendus sur la conduite autonome de bout en bout ?

Apr 15, 2024 pm 04:13 PM

Au cours du mois dernier, pour des raisons bien connues, j'ai eu des échanges très intensifs avec divers professeurs et camarades de classe du secteur. Un sujet inévitable dans l'échange est naturellement le populaire Tesla FSDV12 de bout en bout. Je voudrais profiter de cette occasion pour trier certaines de mes pensées et opinions en ce moment pour votre référence et votre discussion. Comment définir un système de conduite autonome de bout en bout et quels problèmes devraient être résolus de bout en bout ? Selon la définition la plus traditionnelle, un système de bout en bout fait référence à un système qui saisit les informations brutes des capteurs et génère directement les variables pertinentes pour la tâche. Par exemple, en reconnaissance d'images, CNN peut être appelé de bout en bout par rapport à la méthode traditionnelle d'extraction de caractéristiques + classificateur. Dans les tâches de conduite autonome, saisir les données de divers capteurs (caméra/LiDAR

NuScenes dernier SOTA SparseAD : les requêtes clairsemées contribuent à une conduite autonome efficace de bout en bout !

Apr 17, 2024 pm 06:22 PM

NuScenes dernier SOTA SparseAD : les requêtes clairsemées contribuent à une conduite autonome efficace de bout en bout !

Apr 17, 2024 pm 06:22 PM

Écrit à l'avant et point de départ Le paradigme de bout en bout utilise un cadre unifié pour réaliser plusieurs tâches dans les systèmes de conduite autonome. Malgré la simplicité et la clarté de ce paradigme, les performances des méthodes de conduite autonome de bout en bout sur les sous-tâches sont encore loin derrière les méthodes à tâche unique. Dans le même temps, les fonctionnalités de vue à vol d'oiseau (BEV) denses, largement utilisées dans les méthodes de bout en bout précédentes, rendent difficile l'adaptation à davantage de modalités ou de tâches. Un paradigme de conduite autonome de bout en bout (SparseAD) centré sur la recherche clairsemée est proposé ici, dans lequel la recherche clairsemée représente entièrement l'ensemble du scénario de conduite, y compris l'espace, le temps et les tâches, sans aucune représentation BEV dense. Plus précisément, une architecture clairsemée unifiée est conçue pour la connaissance des tâches, notamment la détection, le suivi et la cartographie en ligne. De plus, lourd