Périphériques technologiques

Périphériques technologiques

IA

IA

Regard sur le passé et l'avenir de l'apprentissage multimodal d'un point de vue visuel et audio

Regard sur le passé et l'avenir de l'apprentissage multimodal d'un point de vue visuel et audio

Regard sur le passé et l'avenir de l'apprentissage multimodal d'un point de vue visuel et audio

La vision et l'audition sont cruciales dans la communication humaine et la compréhension de la scène. Afin d'imiter les capacités perceptuelles humaines, l'apprentissage audiovisuel visant à explorer les modalités audiovisuelles est devenu un domaine en plein essor ces dernières années. Cet article est une revue du dernier apprentissage audiovisuel « Apprentissage dans un contexte audiovisuel : examen, analyse et interprétation d'une « nouvelle perspective ».

Cette revue analyse d'abord les bases scientifiques cognitives des modalités audiovisuelles, puis procède à une analyse systématique et à une synthèse des travaux récents d'apprentissage audiovisuel (près de trois cents documents associés). Enfin, afin de donner un aperçu du domaine actuel de l'apprentissage visuel-visuel, cette revue revisite les progrès de l'apprentissage visuel-visuel au cours des dernières années du point de vue de la compréhension des scènes visuo-visuelles et explore les orientations de développement potentielles dans ce domaine.

Lien arXiv : https://arxiv.org/abs/2208.09579

Page d'accueil du projet : https://gewu-lab.github.io/audio-visual-learning/

lien génial-list : https://gewu-lab.github.io/awesome-audiovisual-learning/

1 Introduction

Les informations visuelles et auditives sont les principaux moyens permettant aux humains de percevoir le monde extérieur Source d'information. Le cerveau humain obtient une cognition globale du milieu environnant en intégrant des informations multimodales hétérogènes. Par exemple, dans une scène de cocktail avec plusieurs locuteurs, nous pouvons utiliser des changements dans la forme des lèvres pour améliorer le discours reçu de l'orateur concerné. Par conséquent, l’apprentissage visuel et audio est indispensable à l’exploration des capacités de perception des machines de type humain. Par rapport à d'autres modalités, les caractéristiques de la modalité audiovisuelle la rendent unique :

1) Base cognitive. En tant que deux sens les plus étudiés, l'intégration de la vision et de l'ouïe se retrouve dans tout le système nerveux humain. D'une part, l'importance de ces deux sens dans la perception humaine fournit une base cognitive pour la recherche sur la perception automatique basée sur des données audiovisuelles. D'autre part, l'interaction et l'intégration de la vision et de l'audition dans le système nerveux peuvent servir de base. base pour promouvoir l’apprentissage visuel-visuel.

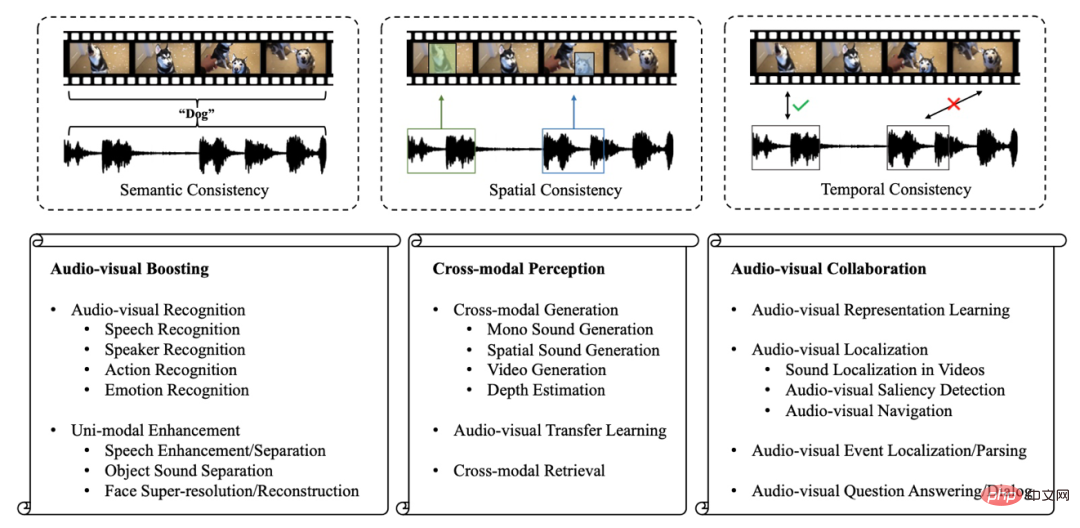

2) Consistance multiple. Dans notre vie quotidienne, la vision et l'audition sont étroitement liées. Comme le montre la figure 1, tant l'aboiement d'un chien que son apparence nous permettent de l'associer au concept de « chien » (Cohérence sémantique). Dans le même temps, nous pouvons déterminer la localisation spatiale exacte du chien à l’aide des sons entendus ou de la vision (Consistance spatiale). Et lorsque nous entendons un chien aboyer, nous pouvons généralement le voir visuellement en même temps (Cohérence temporelle). Les cohérences multiples entre vision et audition sont à la base des recherches sur l’apprentissage audiovisuel.

3) Prise en charge de données riches. Le développement rapide des terminaux mobiles et d'Internet a incité de plus en plus de personnes à partager des vidéos sur des plateformes publiques, ce qui a réduit le coût de collecte des vidéos. Ces riches vidéos publiques éliminent les obstacles à l'acquisition de données et fournissent un support de données pour l'apprentissage audiovisuel.

Ces caractéristiques de la modalité audiovisuelle ont naturellement conduit à la naissance du domaine de l'apprentissage audiovisuel. Ces dernières années, ce domaine a connu un développement vigoureux et les chercheurs ne se contentent plus de simplement introduire des modalités supplémentaires dans les tâches monomodales originales, mais ont commencé à explorer et à résoudre de nouveaux problèmes et défis.

Cependant, les emplois d'apprentissage audiovisuel existants sont souvent axés sur des tâches. Dans ces travaux, ils se concentrent sur des tâches audiovisuelles spécifiques. Il manque encore des travaux complets qui examinent et analysent systématiquement le développement du domaine de l’apprentissage audiovisuel. Par conséquent, cet article résume le domaine actuel de l’apprentissage audiovisuel et examine ensuite plus en détail ses orientations potentielles de développement.

En raison du lien étroit entre l'apprentissage visuel et audio et la capacité de perception humaine, cet article résume d'abord la base cognitive des modalités visuelles et auditives, puis sur cette base, les recherches existantes sur l'apprentissage visuel et audio sont divisées en trois catégories :

1) Boosting audiovisuel. Les données visuelles et audio ont chacune un long historique de recherche et une large application. Bien que ces méthodes monomodales aient obtenu des résultats assez efficaces, elles n'utilisent que des informations partielles sur les éléments d'intérêt, leurs performances sont limitées et elles sont sensibles au bruit monomodal. Par conséquent, les chercheurs introduisent des modalités supplémentaires dans ces tâches audio ou visuelles, ce qui non seulement améliore l’effet du modèle en intégrant des informations complémentaires, mais favorise également la robustesse du modèle.

2) Perception multimodale. Les êtres humains peuvent associer des images associées lorsqu'ils entendent des sons, et peuvent également penser à des sons correspondants lorsqu'ils voient des images. Cela est dû au fait que les informations visuelles et auditives sont cohérentes. Cette cohérence fournit une base permettant à la machine de transférer des connaissances intermodales ou de générer des données correspondantes d'une autre modalité sur la base des informations d'une modalité. Par conséquent, de nombreuses études ont été consacrées à l’exploration des capacités de perception intermodale et ont obtenu des résultats remarquables.

3) Collaboration Audio-visuelle. En plus de fusionner les signaux de différentes modalités, il existe des interactions de plus haut niveau entre les modalités dans les zones corticales du cerveau humain pour parvenir à une compréhension plus approfondie de la scène. Par conséquent, les capacités de perception de type humain nécessitent l’exploration de la collaboration entre les modalités audio et vidéo. Afin d’atteindre cet objectif, de nombreuses études ont proposé ces dernières années des problèmes de compréhension de scène plus difficiles, qui ont reçu une large attention.

Figure 1 : Aperçu du domaine de la cohérence visuelle et audio et de l'apprentissage visuel et audio

La cohérence entre les modalités visuelles et audio couvrant la sémantique, l'espace et le timing offre la faisabilité des éléments visuels et temporels ci-dessus. recherche audio. Ainsi, cet article, après avoir synthétisé les recherches récentes sur l’audiovisuel, analyse les multiples cohérences de l’audiovisuel. De plus, cet article passe une fois de plus en revue les progrès dans le domaine de l’apprentissage audiovisuel sous une nouvelle perspective de compréhension des scènes audiovisuelles.

2 Bases de la cognition visuelle et audio

La vision et l'ouïe sont les deux sens fondamentaux pour la compréhension de la scène humaine. Ce chapitre résume les voies neuronales des sens visuels et auditifs et l'intégration des modalités visuelles et audio dans les neurosciences cognitives, jetant les bases de la discussion ultérieure sur la recherche dans le domaine de l'apprentissage visuel et audio.

2.1 Voies neuronales de la vision et de l'audition

La vision est le sens le plus étudié, et certains pensent même qu'il domine la perception humaine. En conséquence, les voies neuronales de la vision sont également relativement complexes. La lumière réfléchie par les objets contient des informations visuelles qui activent de nombreux photorécepteurs (environ 260 millions) dans la rétine. La production des photorécepteurs est envoyée aux cellules ganglionnaires (environ 2 millions). Ce processus compresse les informations visuelles. Ensuite, après avoir été traitées par les cellules du noyau géniculé latéral, l’information visuelle atteint finalement les zones du cortex cérébral liées à la vision. Le cortex visuel est un ensemble fonctionnellement distinct de régions dont les neurones visuels ont des préférences. Par exemple, les neurones en V4 et V5 sont respectivement sensibles à la couleur et au mouvement.

En plus de la vision, l'ouïe est également un sens important pour l'observation du milieu environnant. Cela rappelle non seulement aux humains d'éviter les risques (par exemple, les humains prendront des mesures proactives lorsqu'ils entendront le cri des bêtes sauvages), mais constitue également la base sur laquelle les gens peuvent communiquer entre eux. Les ondes sonores sont converties en signaux neuronaux au niveau du tympan. L’information auditive est ensuite transmise au colliculus inférieur et aux noyaux cochléaires du tronc cérébral. Après traitement par le noyau géniculé médial du thalamus, les sons sont finalement codés dans le cortex auditif primaire. Le cerveau prend les informations auditives et utilise les signaux acoustiques qu'elles contiennent, tels que la fréquence et le timbre, pour déterminer l'identité de la source sonore. Dans le même temps, l’intensité entre les deux oreilles et la différence temporelle entre l’audition fournissent des indices sur la localisation du son, ce que l’on appelle l’effet binaural. En pratique, la perception humaine peut combiner plusieurs sens, notamment l’ouïe et la vision, ce qu’on appelle la perception multicanal.

2.2 Intégration audiovisuelle dans les neurosciences cognitives

Chaque sens fournit des informations uniques sur l'environnement qui l'entoure. Bien que les informations reçues par les multiples sens soient différentes, la représentation de l’environnement qui en résulte est une expérience unifiée plutôt que des sensations distinctes.

Un exemple représentatif est l'effet McGurk : les signaux visuels et les signaux auditifs avec des sémantiques différentes obtiennent une information sémantique unique. Ces phénomènes indiquent que dans la perception humaine, les signaux provenant de plusieurs sens sont souvent intégrés. Parmi eux, l'intersection des voies neuronales auditives et visuelles combine les informations provenant de deux sens humains importants, favorisant la sensibilité et la précision de la perception. Par exemple, les informations visuelles liées au son peuvent améliorer l'efficacité de la recherche de l'espace auditif.

Ces phénomènes perceptifs qui combinent de multiples informations sensorielles ont attiré l'attention des gens dans le domaine des neurosciences cognitives. Le colliculus supérieur est une région sensorielle multicanal bien étudiée du système nerveux humain. De nombreux neurones du colliculus supérieur ont des propriétés multisensorielles et peuvent être activés par des informations provenant de la vision, de l’audition et même du toucher. Cette réponse multisensorielle est souvent plus forte qu’une réponse unique. Le sillon temporal supérieur du cortex est une autre région représentative.

Basé sur des études menées sur des singes, il a été observé qu'il se connecte à plusieurs sens, notamment la vision, l'ouïe et le somatosensoriel. Des régions cérébrales supplémentaires, notamment les lobes pariétaux, les lobes frontaux et l'hippocampe, présentent des phénomènes de perception multicanaux similaires. Sur la base des recherches sur les phénomènes de perception multicanaux, nous pouvons observer plusieurs résultats clés :

1) Amélioration multimodale. Comme mentionné ci-dessus, de nombreux neurones peuvent répondre aux signaux fusionnés de plusieurs sens. Lorsque la stimulation d'un seul sens est faible, cette réponse améliorée est plus fiable qu'une réponse à modalité unique.

2) Plasticité cross-modale. Ce phénomène signifie que la privation d'un sens peut affecter le développement de l'aire corticale correspondante. Par exemple, il est possible que le cortex auditif des personnes sourdes soit activé par une stimulation visuelle.

3) Collaboration multimodale. Les signaux des différents sens sont intégrés de manière plus complexe dans les zones corticales. Les chercheurs ont découvert qu'il existe des modules dans le cortex cérébral qui ont la capacité d'intégrer des informations multisensorielles de manière collaborative pour renforcer la conscience et la cognition.

Inspirés par la cognition humaine, les chercheurs ont commencé à étudier comment atteindre des capacités de perception visuelle et audio semblables à celles des humains, et de plus en plus de recherches visuelles et audio ont progressivement émergé ces dernières années.

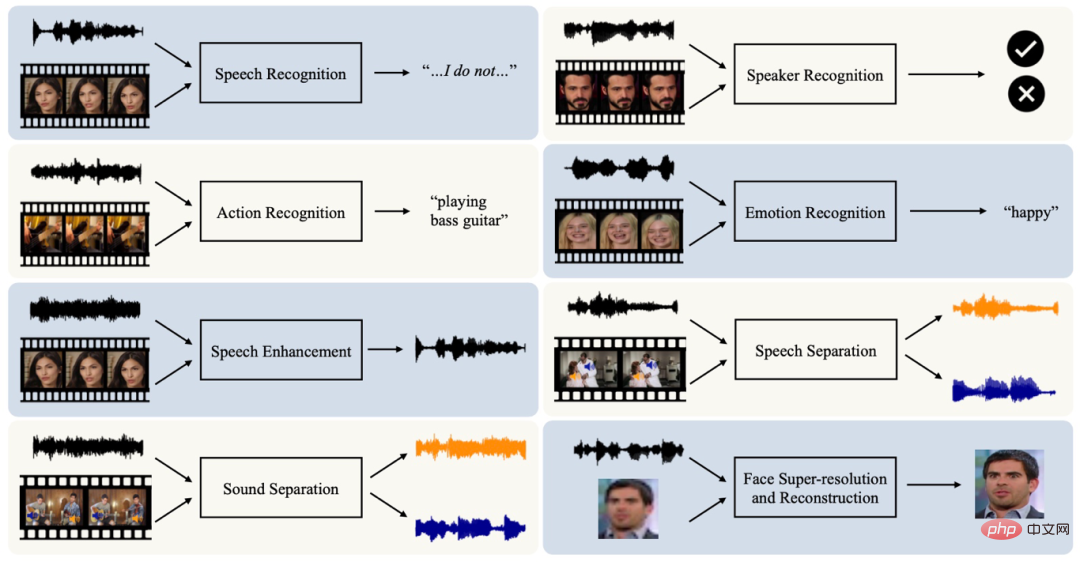

3 , et est plus sensible au bruit monomodal (par exemple, les informations visuelles sont affectées par des facteurs tels que l'éclairage, l'angle de vision, etc.). Par conséquent, inspirés par le phénomène d’amélioration multimodale de la cognition humaine, certains chercheurs introduisent des données visuelles (ou audio) supplémentaires dans la tâche monomodale originale pour améliorer la performance de la tâche. Nous divisons les tâches connexes en deux parties : l'identification et l'amélioration.

Les tâches de reconnaissance monomodale ont été largement étudiées dans le passé, telles que la reconnaissance vocale basée sur l'audio et la reconnaissance d'actions basée sur la vision. Cependant, les données monomodales n’observent qu’une partie des informations des objets et sont sensibles au bruit monomodal. Par conséquent, la tâche de reconnaissance audiovisuelle, qui intègre des données multimodales pour promouvoir les capacités et la robustesse des modèles, a attiré l'attention ces dernières années et couvre de nombreux aspects tels que la reconnaissance vocale, la reconnaissance du locuteur, la reconnaissance des actions et la reconnaissance des émotions.

La cohérence des modalités audio et vidéo fournit non seulement la base des tâches de reconnaissance multimodale, mais permet également d'utiliser une modalité pour améliorer le signal d'une autre modalité. Par exemple, plusieurs locuteurs sont visuellement séparés, de sorte que les informations visuelles sur les locuteurs peuvent être utilisées pour faciliter la séparation de la parole. De plus, les informations audio peuvent fournir des informations d'identité telles que le sexe et l'âge pour reconstruire les informations faciales masquées ou manquantes du locuteur. Ces phénomènes ont incité les chercheurs à utiliser les informations provenant d’autres modalités de débruitage ou d’amélioration, telles que l’amélioration de la parole, la séparation des sources sonores et la super-reconstruction faciale.

Figure 2 : Tâche d'amélioration visuo-visuelle

4 Perception intermodale

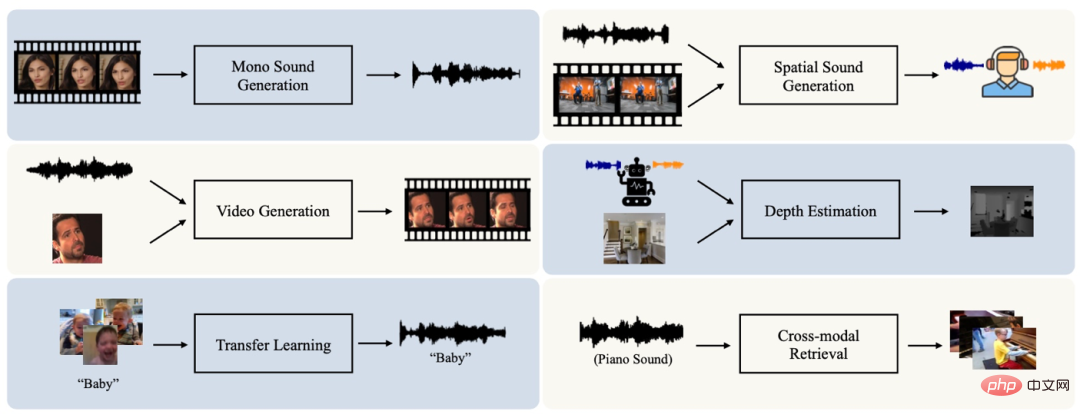

Phénomène de plasticité intermodale en neurosciences cognitives et cohérence entre les modalités visuelles et audio Promotion de la recherche sur les -la perception modale, qui vise à apprendre et à établir des associations entre les modalités audio et visuelles, en favorisant des tâches telles que la génération, le transfert et la récupération intermodaux.

Les êtres humains ont la capacité de prédire l'information correspondant à une autre modalité sous la direction d'une modalité connue. Par exemple, sans entendre le son, nous pouvons déduire grossièrement ce que dit la personne simplement en voyant les informations visuelles des mouvements des lèvres. La cohérence sémantique, spatiale et temporelle entre l'audio et la vision offre la possibilité aux machines de disposer de capacités de génération multimodale semblables à celles des humains. Les tâches de génération multimodale couvrent actuellement de nombreux aspects, notamment la génération audio monocanal, la génération stéréo, la génération vidéo/image et l'estimation de la profondeur.

En plus de la génération intermodale, la cohérence sémantique entre l'audio et la vidéo indique que l'apprentissage dans une modalité devrait être assisté par les informations sémantiques de l'autre modalité. C'est aussi l'objectif de la mission de transfert audiovisuel. De plus, la cohérence sémantique de l’audio et de la vidéo favorise également le développement de tâches de recherche d’informations crossmodales.

Figure 3 : Tâches liées à la perception multimodale

5 Collaboration visio-visuelle

Le cerveau humain va intégrer les informations audiovisuelles de la scène reçue pour les faire coopérer et interagir les uns avec les autres. Pour compléter, améliorant ainsi la compréhension de la scène. Par conséquent, il est nécessaire que les machines recherchent une perception semblable à celle de l’humain en explorant la collaboration audiovisuelle plutôt que de simplement fusionner ou prédire des informations multimodales. À cette fin, les chercheurs ont introduit une variété de nouveaux défis dans le domaine de l’apprentissage visuel et audio, notamment l’analyse des composants visuels et audio et le raisonnement visuel et audio.

Au début de la collaboration audiovisuelle, comment extraire efficacement des représentations de modalités audiovisuelles sans annotation humaine est un sujet important. En effet, des représentations de haute qualité peuvent contribuer à diverses tâches en aval. Pour les données audiovisuelles, la cohérence sémantique, spatiale et temporelle entre elles fournit un signal naturel pour l’apprentissage de la représentation audiovisuelle de manière auto-supervisée.

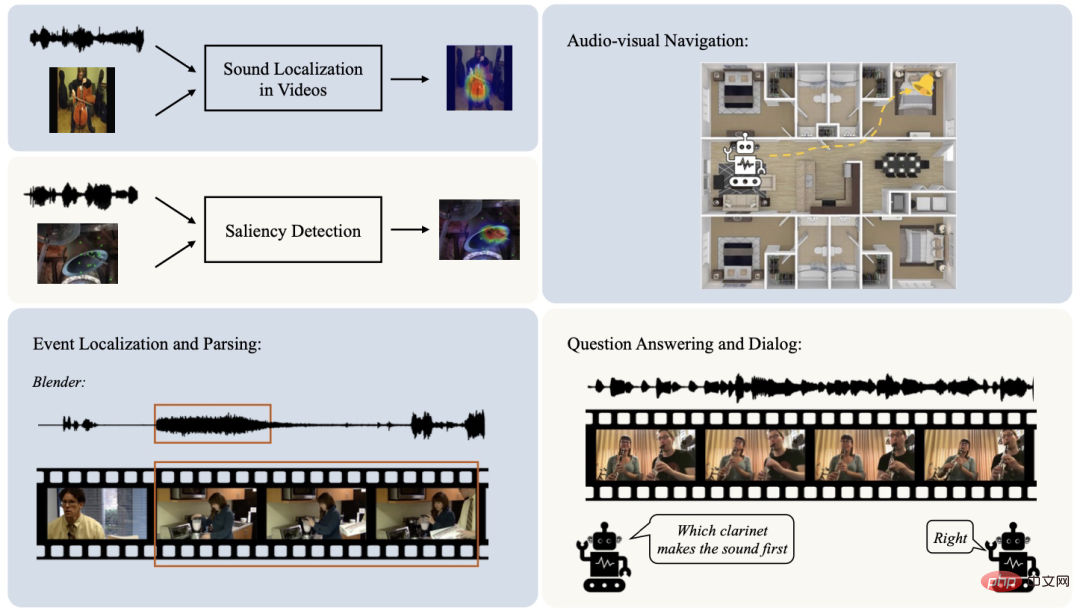

En plus de l'apprentissage des représentations, la collaboration entre les modalités audio et vidéo se concentre principalement sur la compréhension de la scène. Certains chercheurs se concentrent sur l'analyse et la localisation des composants visuels et audio de la scène, notamment la localisation des sources sonores, la détection de la saillance visuelle et audio, la navigation visuelle et audio, etc. De telles tâches établissent des connexions fines entre les modalités visuelles et audio.

De plus, dans de nombreuses tâches audiovisuelles, nous supposons souvent que le contenu audiovisuel de l'ensemble de la vidéo correspond toujours dans le temps, c'est-à-dire qu'à chaque instant de la vidéo, l'image et le son ont une cohérence. Mais en réalité, cette hypothèse ne peut pas toujours être établie. Par exemple, dans l'exemple « jouer au basket-ball », la caméra filme parfois des scènes telles que l'auditorium qui n'ont rien à voir avec l'étiquette « jouer au basket-ball ». Par conséquent, des tâches telles que la localisation et l’analyse d’événements visuels et audio sont proposées pour éliminer davantage les composants visuels et audio de la scène dans une séquence temporelle.

Les êtres humains sont capables de faire des déductions au-delà de la perception dans les scènes audiovisuelles. Bien que les tâches de collaboration audiovisuelle ci-dessus aient progressivement permis d'acquérir une compréhension fine de la scène audiovisuelle, elles n'ont pas effectué d'analyse inférentielle des composants audiovisuels. Récemment, avec le développement du domaine de l'apprentissage visuel-visuel, certains chercheurs ont commencé à s'intéresser davantage au raisonnement visuo-visuel, tel que la réponse aux questions visuo-visuelles et les tâches de dialogue. Ces tâches visent à effectuer un raisonnement spatio-temporel multimodal sur des scènes audiovisuelles, à répondre à des questions liées aux scènes ou à générer des dialogues sur des scènes audiovisuelles observées.

Figure 4 : Tâches liées à la collaboration audiovisuelle

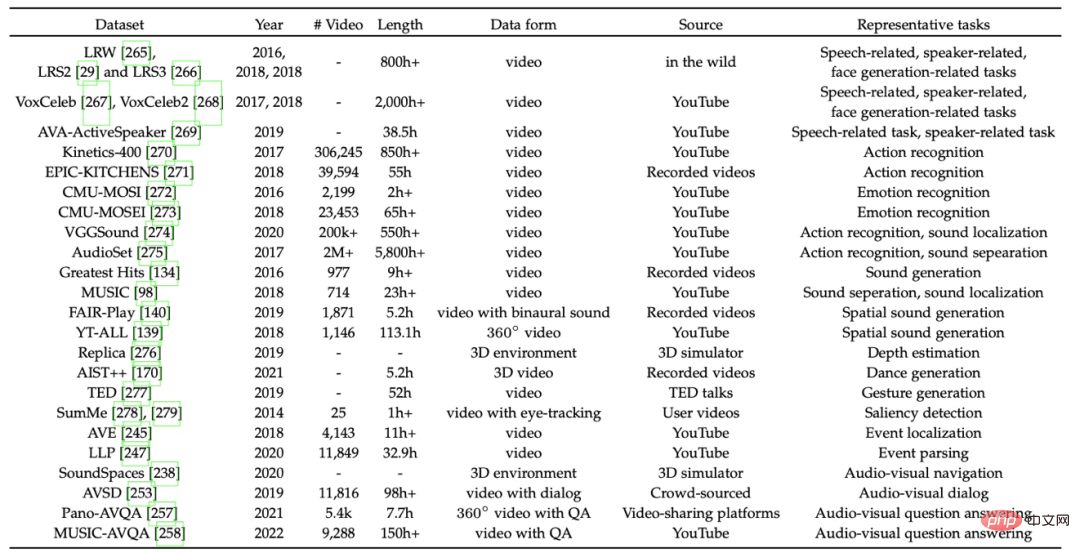

6 Ensembles de données représentatifs

Cette section passe au peigne fin et discute de certains ensembles de données représentatifs dans le domaine de l'apprentissage audiovisuel.

7 À bien des égards, il a jeté les bases de la recherche audiovisuelle.

Tout d’abord, les modalités visuelles et audio représentent l’objet d’intérêt sous différentes perspectives. Par conséquent, la sémantique des données audiovisuelles est considérée comme sémantiquement cohérente. Dans l’apprentissage visuel-visuel, la cohérence sémantique joue un rôle important dans la plupart des tâches. Cette cohérence permet par exemple de combiner des informations visuelles et audio pour une meilleure reconnaissance visuelle et audio et une valorisation monomodalité. De plus, la cohérence sémantique entre les modalités audiovisuelles joue également un rôle important dans la récupération intermodale et l’apprentissage par transfert.

Deuxièmement, le visuel et l'audio peuvent aider à déterminer l'emplacement spatial exact de l'objet sonore. Cette correspondance spatiale a également un large éventail d'applications. Par exemple, dans les tâches de localisation de sources sonores, cette cohérence est utilisée pour déterminer l'emplacement visuel d'un objet émettant du son guidé par l'audio d'entrée. Dans le cas stéréo, des informations de profondeur visuelle peuvent être estimées sur la base d'un son binaural ou un son stéréo peut être généré en utilisant des informations visuelles comme aide.

Enfin, le contenu visuel et les sons qu'il produit sont souvent cohérents dans le temps. Cette cohérence est également largement exploitée dans la plupart des recherches sur l’apprentissage audiovisuel, comme la fusion ou la prédiction d’informations multimodales dans des tâches de reconnaissance ou de génération audiovisuelles.

En pratique, ces différentes cohérences audiovisuelles ne sont pas isolées, mais apparaissent souvent ensemble dans des scènes audiovisuelles. C’est pourquoi ils sont souvent exploités conjointement dans des tâches connexes. Une combinaison de cohérence sémantique et temporelle est le cas le plus courant.

Dans des scénarios simples, les clips audio et vidéo avec le même horodatage sont considérés comme cohérents à la fois sémantiquement et temporellement. Cependant, cette hypothèse forte peut échouer, par exemple, l'image vidéo et le son de fond au même horodatage ne sont pas sémantiquement cohérents. Ces faux positifs interfèrent avec l’entraînement.

Récemment, les chercheurs ont commencé à se concentrer sur ces situations pour améliorer la qualité de la compréhension des scènes. De plus, la combinaison de cohérence sémantique et spatiale est également courante. Par exemple, une localisation réussie d’une source sonore dans une vidéo repose sur la cohérence sémantique pour explorer l’emplacement spatial visuel correspondant en fonction du son d’entrée. De plus, lors des premières étapes de la tâche de navigation audiovisuelle, la cible vocale produit un son constant et répétitif. Bien que la cohérence spatiale soit satisfaite, le contenu sémantique visuel et audio n’est pas corrélé. Par la suite, la cohérence sémantique des sons et des localisations des énoncés est introduite pour améliorer la qualité de la navigation audiovisuelle.

De manière générale, la cohérence sémantique, spatiale et temporelle des modalités visuelles et audio constitue un support solide pour la recherche sur l'apprentissage visuel et audio. L'analyse et l'exploitation de ces cohérences améliorent non seulement les performances des tâches audiovisuelles existantes mais contribuent également à une meilleure compréhension des scènes audiovisuelles.

7.2 Une nouvelle perspective sur la compréhension de la scène

Cet article résume les bases cognitives des modalités audiovisuelles et analyse le phénomène de perception multicanal humaine Sur cette base, la recherche actuelle sur l'apprentissage audiovisuel est divisée en trois. catégories : Boosting audiovisuel, Perception multimodale et Collaboration audiovisuelle. Afin de passer en revue le développement actuel dans le domaine de l'apprentissage audiovisuel dans une perspective plus macro, l'article propose en outre une nouvelle perspective sur la compréhension des scènes audiovisuelles :

1) Compréhension de base des scènes. Les tâches d'amélioration audiovisuelle et de perception intermodale se concentrent souvent sur la fusion ou la prédiction d'informations audiovisuelles cohérentes. Le cœur de ces tâches est la compréhension de base des scènes audiovisuelles (par exemple, la classification des actions des vidéos d'entrée) ou la prédiction d'informations intermodales (par exemple, la génération de l'audio correspondant basé sur des vidéos silencieuses). scènes Les vidéos contiennent souvent divers composants visuels et audio qui dépassent la portée de ces tâches de base de compréhension des scènes.

2) Compréhension fine de la scène. Comme mentionné ci-dessus, les scènes audiovisuelles comportent généralement de riches composants de différentes modalités. Par conséquent, les chercheurs ont proposé certaines tâches pour décoller les composants cibles. Par exemple, une tâche de localisation de source sonore vise à marquer la zone en vision où se trouve un objet cible produisant du son. La tâche de localisation et d'analyse d'événements audiovisuels détermine l'événement sonore ou l'événement visible cible dans une série chronologique. Ces tâches séparent les composants audiovisuels et découplent les scènes audiovisuelles, ce qui permet une compréhension plus fine des scènes par rapport à l'étape précédente.

3) Compréhension de la scène causale. Dans les scènes audiovisuelles, les humains peuvent non seulement percevoir les objets d'intérêt autour d'eux, mais également déduire les interactions entre eux. L’objectif de la compréhension de la scène à ce stade est plus proche de la recherche d’une perception humaine. Actuellement, seules quelques missions sont explorées à ce stade. Les réponses aux questions audiovisuelles et les tâches de dialogue sont des œuvres représentatives. Ces tâches tentent d'explorer l'association de composants visuels et audio dans des vidéos et d'effectuer un raisonnement spatio-temporel.

De manière générale, l'exploration de ces trois étapes est déséquilibrée. De la compréhension fondamentale des scènes à la compréhension des scènes d’interaction causale, la diversité et la richesse des recherches connexes diminuent progressivement. En particulier, la compréhension des scènes d’interaction causale en est encore à ses balbutiements. Cela fait allusion à quelques orientations de développement potentielles pour l'apprentissage audiovisuel :

1) Intégration des tâches. La plupart des recherches dans le domaine audiovisuel sont orientées tâches. Ces tâches individuelles simulent et apprennent uniquement des aspects spécifiques de la scène audiovisuelle. Cependant, la compréhension et la perception des scènes audiovisuelles ne se font pas de manière isolée. Par exemple, les tâches de localisation de sources sonores mettent l'accent sur les objets liés au son dans la vision, tandis que les tâches de localisation et d'analyse d'événements identifient temporellement les événements cibles. Les deux tâches devraient être intégrées pour faciliter une compréhension raffinée des scènes audiovisuelles. L’intégration de multiples tâches d’apprentissage audiovisuelle est une direction qui mérite d’être explorée à l’avenir.

2) Compréhension plus approfondie des scénarios d'interaction causale. Actuellement, la diversité des recherches sur la compréhension des scènes impliquant le raisonnement est encore limitée. Les tâches existantes, y compris la réponse aux questions et le dialogue audiovisuels, se concentrent principalement sur la conduite de dialogues basés sur des événements dans des vidéos. Des types d’inférence plus approfondis, tels que la prédiction d’événements audio ou visuels susceptibles de se produire ensuite sur la base d’une scène prévisualisée, méritent des recherches plus approfondies à l’avenir.

Afin de mieux présenter le contenu de l'article, cette revue est également équipée d'une page d'accueil du projet continuellement mise à jour, qui affiche les objectifs et le développement de différentes tâches visuelles et audio sous forme d'images, de vidéos et d'autres formes permettant aux lecteurs de comprendre rapidement le domaine de l’apprentissage visuel et audio.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Apprenez à désinstaller complètement pip et à utiliser Python plus efficacement

Jan 16, 2024 am 09:01 AM

Apprenez à désinstaller complètement pip et à utiliser Python plus efficacement

Jan 16, 2024 am 09:01 AM

Plus besoin de pip ? Venez apprendre à désinstaller pip efficacement ! Introduction : pip est l'un des outils de gestion de packages Python, qui peut facilement installer, mettre à niveau et désinstaller les packages Python. Cependant, nous devrons parfois désinstaller pip, peut-être parce que nous souhaitons utiliser un autre outil de gestion de packages, ou parce que nous devons vider complètement l'environnement Python. Cet article explique comment désinstaller pip efficacement et fournit des exemples de code spécifiques. 1. Méthodes de désinstallation de pip Ce qui suit présente deux méthodes courantes de désinstallation de pip.

Une plongée approfondie dans la palette de couleurs de matplotlib

Jan 09, 2024 pm 03:51 PM

Une plongée approfondie dans la palette de couleurs de matplotlib

Jan 09, 2024 pm 03:51 PM

Pour en savoir plus sur la table de couleurs matplotlib, vous avez besoin d'exemples de code spécifiques 1. Introduction matplotlib est une puissante bibliothèque de dessins Python. Elle fournit un riche ensemble de fonctions et d'outils de dessin qui peuvent être utilisés pour créer différents types de graphiques. La palette de couleurs (colormap) est un concept important dans matplotlib, qui détermine la palette de couleurs du graphique. Une étude approfondie de la table des couleurs matplotlib nous aidera à mieux maîtriser les fonctions de dessin de matplotlib et à rendre les dessins plus pratiques.

Révéler l'attrait du langage C : découvrir le potentiel des programmeurs

Feb 24, 2024 pm 11:21 PM

Révéler l'attrait du langage C : découvrir le potentiel des programmeurs

Feb 24, 2024 pm 11:21 PM

Le charme de l'apprentissage du langage C : libérer le potentiel des programmeurs Avec le développement continu de la technologie, la programmation informatique est devenue un domaine qui a beaucoup attiré l'attention. Parmi les nombreux langages de programmation, le langage C a toujours été apprécié des programmeurs. Sa simplicité, son efficacité et sa large application font de l’apprentissage du langage C la première étape pour de nombreuses personnes souhaitant entrer dans le domaine de la programmation. Cet article discutera du charme de l’apprentissage du langage C et de la manière de libérer le potentiel des programmeurs en apprenant le langage C. Tout d’abord, le charme de l’apprentissage du langage C réside dans sa simplicité. Comparé à d'autres langages de programmation, le langage C

Premiers pas avec Pygame : didacticiel complet d'installation et de configuration

Feb 19, 2024 pm 10:10 PM

Premiers pas avec Pygame : didacticiel complet d'installation et de configuration

Feb 19, 2024 pm 10:10 PM

Apprenez Pygame à partir de zéro : didacticiel complet d'installation et de configuration, exemples de code spécifiques requis Introduction : Pygame est une bibliothèque de développement de jeux open source développée à l'aide du langage de programmation Python. Elle fournit une multitude de fonctions et d'outils, permettant aux développeurs de créer facilement une variété de types. de jeu. Cet article vous aidera à apprendre Pygame à partir de zéro et fournira un didacticiel complet d'installation et de configuration, ainsi que des exemples de code spécifiques pour vous permettre de démarrer rapidement. Première partie : Installer Python et Pygame Tout d'abord, assurez-vous d'avoir

Apprenons ensemble à saisir le numéro racine dans Word

Mar 19, 2024 pm 08:52 PM

Apprenons ensemble à saisir le numéro racine dans Word

Mar 19, 2024 pm 08:52 PM

Lors de la modification du contenu du texte dans Word, vous devez parfois saisir des symboles de formule. Certains gars ne savent pas comment saisir le numéro racine dans Word, alors Xiaomian m'a demandé de partager avec mes amis un tutoriel sur la façon de saisir le numéro racine dans Word. J'espère que cela aidera mes amis. Tout d'abord, ouvrez le logiciel Word sur votre ordinateur, puis ouvrez le fichier que vous souhaitez modifier et déplacez le curseur vers l'emplacement où vous devez insérer le signe racine, reportez-vous à l'exemple d'image ci-dessous. 2. Sélectionnez [Insérer], puis sélectionnez [Formule] dans le symbole. Comme indiqué dans le cercle rouge dans l'image ci-dessous : 3. Sélectionnez ensuite [Insérer une nouvelle formule] ci-dessous. Comme indiqué dans le cercle rouge dans l'image ci-dessous : 4. Sélectionnez [Formule radicale], puis sélectionnez le signe racine approprié. Comme le montre le cercle rouge sur l'image ci-dessous :

Apprenez la fonction principale du langage Go à partir de zéro

Mar 27, 2024 pm 05:03 PM

Apprenez la fonction principale du langage Go à partir de zéro

Mar 27, 2024 pm 05:03 PM

Titre : Apprenez la fonction principale du langage Go à partir de zéro. En tant que langage de programmation simple et efficace, le langage Go est privilégié par les développeurs. Dans le langage Go, la fonction principale est une fonction d'entrée, et chaque programme Go doit contenir la fonction principale comme point d'entrée du programme. Cet article explique comment apprendre la fonction principale du langage Go à partir de zéro et fournit des exemples de code spécifiques. 1. Tout d’abord, nous devons installer l’environnement de développement du langage Go. Vous pouvez aller sur le site officiel (https://golang.org

Apprenez la fonction strconv.Atoi dans la documentation du langage Go pour convertir des chaînes en entiers

Nov 03, 2023 am 08:55 AM

Apprenez la fonction strconv.Atoi dans la documentation du langage Go pour convertir des chaînes en entiers

Nov 03, 2023 am 08:55 AM

Apprenez la fonction strconv.Atoi dans la documentation du langage Go pour convertir des chaînes en entiers. Le langage Go est un langage de programmation puissant et flexible dans sa bibliothèque standard qui fournit la fonction de conversion de chaînes. Dans cet article, nous apprendrons comment convertir une chaîne en entier à l'aide de la fonction strconv.Atoi. Tout d’abord, nous devons comprendre le but et la déclaration de la fonction strconv.Atoi. La description de la fonction dans le document est la suivante : funcAtoi(sstring)(i

Apprenez rapidement l'installation de pip et maîtrisez les compétences à partir de zéro

Jan 16, 2024 am 10:30 AM

Apprenez rapidement l'installation de pip et maîtrisez les compétences à partir de zéro

Jan 16, 2024 am 10:30 AM

Apprenez l'installation de pip à partir de zéro et maîtrisez rapidement les compétences. Des exemples de code spécifiques sont nécessaires. Présentation : pip est un outil de gestion de packages Python qui peut facilement installer, mettre à niveau et gérer les packages Python. Pour les développeurs Python, il est très important de maîtriser les compétences d'utilisation de pip. Cet article présentera la méthode d'installation de pip à partir de zéro et donnera quelques conseils pratiques et exemples de code spécifiques pour aider les lecteurs à maîtriser rapidement l'utilisation de pip. 1. Installer pip Avant d'utiliser pip, vous devez d'abord installer pip. pépin