Périphériques technologiques

Périphériques technologiques

IA

IA

Grâce à des matériaux 2D uniques et à l'apprentissage automatique, CV « voit » des millions de couleurs comme un humain

Grâce à des matériaux 2D uniques et à l'apprentissage automatique, CV « voit » des millions de couleurs comme un humain

Grâce à des matériaux 2D uniques et à l'apprentissage automatique, CV « voit » des millions de couleurs comme un humain

Les yeux humains peuvent voir des millions de couleurs, et désormais l’intelligence artificielle le peut aussi.

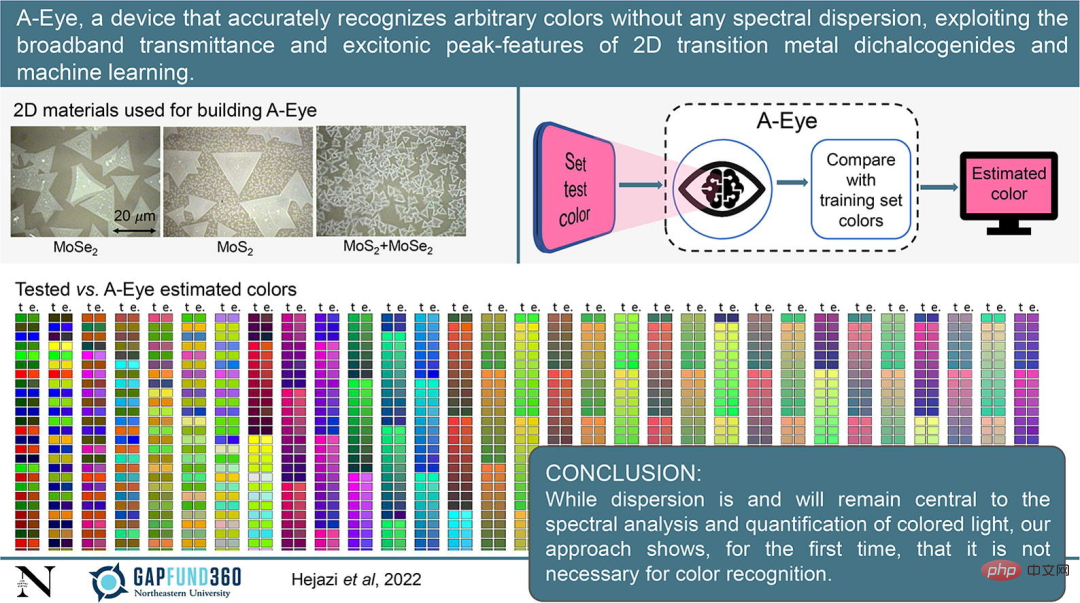

Récemment, une équipe de recherche interdisciplinaire de l'Université Northeastern aux États-Unis a utilisé une nouvelle technologie d'intelligence artificielle pour construire un nouvel appareil A-Eye capable de reconnaître des millions de couleurs, ce qui représente un grand pas en avant dans le domaine de la vision industrielle. Dans cette étape, il sera largement utilisé dans une série de technologies telles que les voitures autonomes, le tri agricole et l’imagerie satellite à distance.

Le document de recherche a été publié dans « Materials Today ».

Adresse papier : https://www.sciencedirect.com/science/article/abs/pii/S1369702122002255

Swastik Kar, auteur correspondant de l'étude et professeur agrégé de physique à la Northeastern University, a déclaré : "À mesure que l'automatisation se généralise, la capacité des machines à reconnaître la couleur et la forme des objets devient de plus en plus importante.

La recherche a conçu un matériau 2D doté de propriétés quantiques spéciales qui intègre la lumière dans un-." La fenêtre optique de la machine Eye peut gérer une riche variété de couleurs avec une « très haute précision » – ce qui est sans précédent.

De plus, A-Eye est capable d'identifier et de reproduire avec précision la couleur « vue » avec un écart nul par rapport au spectre d'origine. Ceci est possible grâce aux algorithmes d'apprentissage automatique développés par une équipe de recherche en IA dirigée par Sarah Ostadabbas, professeure adjointe de génie électrique et informatique à la Northeastern University.

La technologie principale de l'ensemble de la recherche se concentre sur les propriétés quantiques et optiques d'une classe de matériaux appelés dichalcogénures de métaux de transition. Ce matériau unique a toujours été considéré comme ayant un potentiel illimité, en particulier dans le domaine des applications de détection et de stockage d'énergie. .

Aperçu de la recherche

Lors de l'identification des couleurs, les machines utilisent généralement des filtres RVB traditionnels (rouge, vert et bleu) pour décomposer les couleurs en leurs composants, puis utilisent ces informations pour deviner et reproduire essentiellement les couleurs primaires. Lorsque vous pointez votre appareil photo numérique sur un objet coloré et prenez une photo, la lumière de l'objet passe à travers un ensemble de détecteurs dotés de filtres devant eux qui séparent la lumière en ces couleurs RVB brutes.

Kar a déclaré: "Vous pouvez considérer les filtres de couleur comme des entonnoirs qui fournissent des informations visuelles ou des données dans des cases séparées, puis ces entonnoirs attribuent des nombres artificiels aux couleurs naturelles. Mais si vous décomposez simplement les couleurs avec trois composants ( rouge, vert et bleu), il existe certaines restrictions.

Cependant, au lieu d'utiliser des filtres de couleur, Kar et son équipe ont utilisé des « fenêtres transmissives » constituées d'un matériau 2D unique.

Kar dit qu'ils utilisent la machine (c'est-à-dire A-Eye) pour reconnaître les couleurs d'une manière complètement différente. Lorsqu'une lumière colorée frappe un détecteur, les chercheurs ne la décomposent pas en ses principales composantes rouge, verte et bleue ou ne recherchent pas simplement ces composantes, mais utilisent plutôt l'ensemble du spectre d'informations.

En plus de cela, les chercheurs ont utilisé quelques techniques pour modifier et coder ces ingrédients et les stocker de différentes manières. Ils ont donc reçu un ensemble de chiffres et ont pu identifier les couleurs primaires d'une manière très différente de celle conventionnelle.

Le coin supérieur gauche de l'image ci-dessous montre les matériaux 2D utilisés pour construire A-Eye, le coin supérieur droit montre le flux de travail de A-Eye et le bas de l'image montre la comparaison des couleurs entre la couleur de test et A-Eye. Estimation de Eye.

Une autre auteure, Sarah Ostadabbas, a déclaré que lorsque la lumière traverse ces fenêtres de transmission, A-Eye transforme la couleur en données. Et les modèles d'apprentissage automatique intégrés recherchent des modèles pour mieux identifier les couleurs correspondantes analysées par A-Eye.

Dans le même temps, A-Eye peut également améliorer continuellement les résultats de l'estimation des couleurs en ajoutant toutes les suppositions correctes à son ensemble de données d'entraînement.

Introduction au premier auteur

Le premier auteur de cette recherche, Davoud Hejazi, est maintenant un data scientist senior chez Titan Advanced Energy Solutions, se concentrant sur la modélisation statistique, l'apprentissage automatique, le traitement du signal, le traitement d'images, le cloud computing et la visualisation de données.

En mai de cette année, il a obtenu un doctorat en physique de la Northeastern University, et sa thèse de fin d'études était « Estimation précise des couleurs sans dispersion à l'aide de matériaux 2D excitoniques en couches et d'apprentissage automatique ».

Adresse papier : https://repository.library.northeastern.edu/files/neu:4f171c96c

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Cet article vous amènera à comprendre SHAP : explication du modèle pour l'apprentissage automatique

Jun 01, 2024 am 10:58 AM

Cet article vous amènera à comprendre SHAP : explication du modèle pour l'apprentissage automatique

Jun 01, 2024 am 10:58 AM

Dans les domaines de l’apprentissage automatique et de la science des données, l’interprétabilité des modèles a toujours été au centre des préoccupations des chercheurs et des praticiens. Avec l'application généralisée de modèles complexes tels que l'apprentissage profond et les méthodes d'ensemble, la compréhension du processus décisionnel du modèle est devenue particulièrement importante. Explainable AI|XAI contribue à renforcer la confiance dans les modèles d'apprentissage automatique en augmentant la transparence du modèle. L'amélioration de la transparence des modèles peut être obtenue grâce à des méthodes telles que l'utilisation généralisée de plusieurs modèles complexes, ainsi que les processus décisionnels utilisés pour expliquer les modèles. Ces méthodes incluent l'analyse de l'importance des caractéristiques, l'estimation de l'intervalle de prédiction du modèle, les algorithmes d'interprétabilité locale, etc. L'analyse de l'importance des fonctionnalités peut expliquer le processus de prise de décision du modèle en évaluant le degré d'influence du modèle sur les fonctionnalités d'entrée. Estimation de l’intervalle de prédiction du modèle

Transparent! Une analyse approfondie des principes des principaux modèles de machine learning !

Apr 12, 2024 pm 05:55 PM

Transparent! Une analyse approfondie des principes des principaux modèles de machine learning !

Apr 12, 2024 pm 05:55 PM

En termes simples, un modèle d’apprentissage automatique est une fonction mathématique qui mappe les données d’entrée à une sortie prédite. Plus précisément, un modèle d'apprentissage automatique est une fonction mathématique qui ajuste les paramètres du modèle en apprenant à partir des données d'entraînement afin de minimiser l'erreur entre la sortie prédite et la véritable étiquette. Il existe de nombreux modèles dans l'apprentissage automatique, tels que les modèles de régression logistique, les modèles d'arbre de décision, les modèles de machines à vecteurs de support, etc. Chaque modèle a ses types de données et ses types de problèmes applicables. Dans le même temps, il existe de nombreux points communs entre les différents modèles, ou il existe une voie cachée pour l’évolution du modèle. En prenant comme exemple le perceptron connexionniste, en augmentant le nombre de couches cachées du perceptron, nous pouvons le transformer en un réseau neuronal profond. Si une fonction noyau est ajoutée au perceptron, elle peut être convertie en SVM. celui-ci

Au-delà d'ORB-SLAM3 ! SL-SLAM : les scènes de faible luminosité, de gigue importante et de texture faible sont toutes gérées

May 30, 2024 am 09:35 AM

Au-delà d'ORB-SLAM3 ! SL-SLAM : les scènes de faible luminosité, de gigue importante et de texture faible sont toutes gérées

May 30, 2024 am 09:35 AM

Écrit précédemment, nous discutons aujourd'hui de la manière dont la technologie d'apprentissage profond peut améliorer les performances du SLAM (localisation et cartographie simultanées) basé sur la vision dans des environnements complexes. En combinant des méthodes d'extraction de caractéristiques approfondies et de correspondance de profondeur, nous introduisons ici un système SLAM visuel hybride polyvalent conçu pour améliorer l'adaptation dans des scénarios difficiles tels que des conditions de faible luminosité, un éclairage dynamique, des zones faiblement texturées et une gigue importante. Notre système prend en charge plusieurs modes, notamment les configurations étendues monoculaire, stéréo, monoculaire-inertielle et stéréo-inertielle. En outre, il analyse également comment combiner le SLAM visuel avec des méthodes d’apprentissage profond pour inspirer d’autres recherches. Grâce à des expériences approfondies sur des ensembles de données publiques et des données auto-échantillonnées, nous démontrons la supériorité du SL-SLAM en termes de précision de positionnement et de robustesse du suivi.

Identifier le surapprentissage et le sous-apprentissage grâce à des courbes d'apprentissage

Apr 29, 2024 pm 06:50 PM

Identifier le surapprentissage et le sous-apprentissage grâce à des courbes d'apprentissage

Apr 29, 2024 pm 06:50 PM

Cet article présentera comment identifier efficacement le surajustement et le sous-apprentissage dans les modèles d'apprentissage automatique grâce à des courbes d'apprentissage. Sous-ajustement et surajustement 1. Surajustement Si un modèle est surentraîné sur les données de sorte qu'il en tire du bruit, alors on dit que le modèle est en surajustement. Un modèle surajusté apprend chaque exemple si parfaitement qu'il classera mal un exemple inédit/inédit. Pour un modèle surajusté, nous obtiendrons un score d'ensemble d'entraînement parfait/presque parfait et un score d'ensemble/test de validation épouvantable. Légèrement modifié : "Cause du surajustement : utilisez un modèle complexe pour résoudre un problème simple et extraire le bruit des données. Parce qu'un petit ensemble de données en tant qu'ensemble d'entraînement peut ne pas représenter la représentation correcte de toutes les données."

L'évolution de l'intelligence artificielle dans l'exploration spatiale et l'ingénierie des établissements humains

Apr 29, 2024 pm 03:25 PM

L'évolution de l'intelligence artificielle dans l'exploration spatiale et l'ingénierie des établissements humains

Apr 29, 2024 pm 03:25 PM

Dans les années 1950, l’intelligence artificielle (IA) est née. C’est à ce moment-là que les chercheurs ont découvert que les machines pouvaient effectuer des tâches similaires à celles des humains, comme penser. Plus tard, dans les années 1960, le Département américain de la Défense a financé l’intelligence artificielle et créé des laboratoires pour poursuivre son développement. Les chercheurs trouvent des applications à l’intelligence artificielle dans de nombreux domaines, comme l’exploration spatiale et la survie dans des environnements extrêmes. L'exploration spatiale est l'étude de l'univers, qui couvre l'ensemble de l'univers au-delà de la terre. L’espace est classé comme environnement extrême car ses conditions sont différentes de celles de la Terre. Pour survivre dans l’espace, de nombreux facteurs doivent être pris en compte et des précautions doivent être prises. Les scientifiques et les chercheurs pensent qu'explorer l'espace et comprendre l'état actuel de tout peut aider à comprendre le fonctionnement de l'univers et à se préparer à d'éventuelles crises environnementales.

Implémentation d'algorithmes d'apprentissage automatique en C++ : défis et solutions courants

Jun 03, 2024 pm 01:25 PM

Implémentation d'algorithmes d'apprentissage automatique en C++ : défis et solutions courants

Jun 03, 2024 pm 01:25 PM

Les défis courants rencontrés par les algorithmes d'apprentissage automatique en C++ incluent la gestion de la mémoire, le multithread, l'optimisation des performances et la maintenabilité. Les solutions incluent l'utilisation de pointeurs intelligents, de bibliothèques de threads modernes, d'instructions SIMD et de bibliothèques tierces, ainsi que le respect des directives de style de codage et l'utilisation d'outils d'automatisation. Des cas pratiques montrent comment utiliser la bibliothèque Eigen pour implémenter des algorithmes de régression linéaire, gérer efficacement la mémoire et utiliser des opérations matricielles hautes performances.

IA explicable : Expliquer les modèles IA/ML complexes

Jun 03, 2024 pm 10:08 PM

IA explicable : Expliquer les modèles IA/ML complexes

Jun 03, 2024 pm 10:08 PM

Traducteur | Revu par Li Rui | Chonglou Les modèles d'intelligence artificielle (IA) et d'apprentissage automatique (ML) deviennent aujourd'hui de plus en plus complexes, et le résultat produit par ces modèles est une boîte noire – impossible à expliquer aux parties prenantes. L'IA explicable (XAI) vise à résoudre ce problème en permettant aux parties prenantes de comprendre comment fonctionnent ces modèles, en s'assurant qu'elles comprennent comment ces modèles prennent réellement des décisions et en garantissant la transparence des systèmes d'IA, la confiance et la responsabilité pour résoudre ce problème. Cet article explore diverses techniques d'intelligence artificielle explicable (XAI) pour illustrer leurs principes sous-jacents. Plusieurs raisons pour lesquelles l’IA explicable est cruciale Confiance et transparence : pour que les systèmes d’IA soient largement acceptés et fiables, les utilisateurs doivent comprendre comment les décisions sont prises

La première reconstruction purement visuelle et statique de la conduite autonome

Jun 02, 2024 pm 03:24 PM

La première reconstruction purement visuelle et statique de la conduite autonome

Jun 02, 2024 pm 03:24 PM

Une solution d'annotation purement visuelle utilise principalement la vision ainsi que certaines données du GPS, de l'IMU et des capteurs de vitesse de roue pour l'annotation dynamique. Bien entendu, pour les scénarios de production de masse, il n’est pas nécessaire qu’il s’agisse d’une vision pure. Certains véhicules produits en série seront équipés de capteurs comme le radar à semi-conducteurs (AT128). Si nous créons une boucle fermée de données dans la perspective d'une production de masse et utilisons tous ces capteurs, nous pouvons résoudre efficacement le problème de l'étiquetage des objets dynamiques. Mais notre plan ne prévoit pas de radar à semi-conducteurs. Par conséquent, nous présenterons cette solution d’étiquetage de production de masse la plus courante. Le cœur d’une solution d’annotation purement visuelle réside dans la reconstruction de pose de haute précision. Nous utilisons le schéma de reconstruction de pose de Structure from Motion (SFM) pour garantir la précision de la reconstruction. Mais passe