Périphériques technologiques

Périphériques technologiques

IA

IA

GPT-3 et Stable Diffusion travaillent ensemble pour aider le modèle à comprendre les besoins de retouche d'image de la partie A.

GPT-3 et Stable Diffusion travaillent ensemble pour aider le modèle à comprendre les besoins de retouche d'image de la partie A.

GPT-3 et Stable Diffusion travaillent ensemble pour aider le modèle à comprendre les besoins de retouche d'image de la partie A.

Après la popularité du modèle de diffusion, de nombreuses personnes se sont concentrées sur la façon d'utiliser des invites plus efficaces pour générer les images qu'elles souhaitent. Dans les tentatives continues de certains modèles de peinture d'IA, les gens ont même résumé l'expérience par mot clé pour que l'IA puisse bien dessiner des images :

En d'autres termes, si vous maîtrisez les bonnes compétences d'IA, la qualité du dessin sera amélioré. L'effet sera très évident (voir : "Comment dessiner "Alpaga jouant au basket-ball" ? Quelqu'un a dépensé 13 dollars américains pour forcer DALL·E 2 à montrer ses véritables compétences").

De plus, certains chercheurs travaillent dans une autre direction : comment transformer un tableau à ce que l'on veut avec seulement quelques mots.

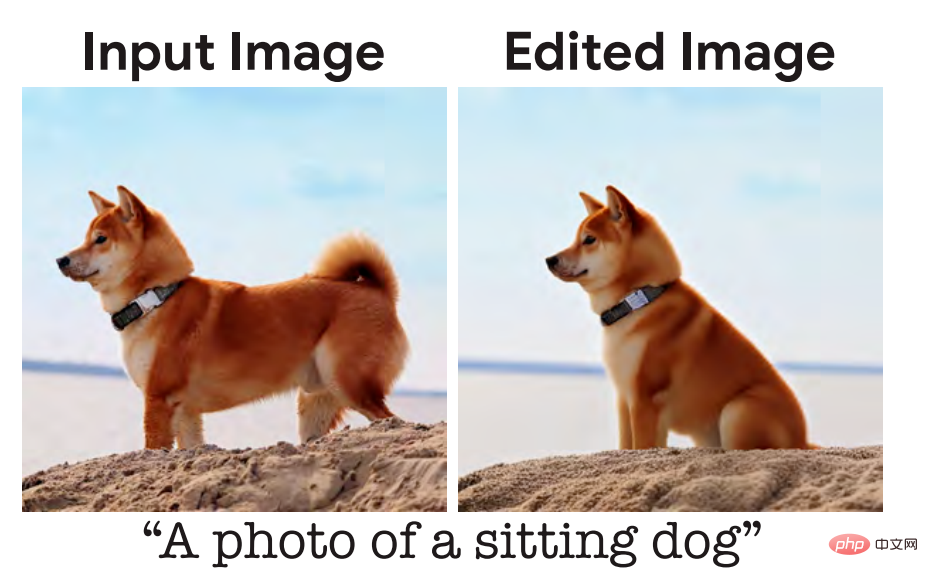

Il y a quelque temps, nous avons rendu compte d'une étudede Google Research et d'autres institutions. Dites simplement à quoi vous voulez qu'une image ressemble, et elle répondra essentiellement à vos exigences et générera des images photoréalistes, comme faire asseoir un chiot :

Voici les entrées du modèle La description est "un chien assis", mais selon les habitudes de communication quotidiennes des gens, la description la plus naturelle devrait être "laissez ce chien s'asseoir". Certains chercheurs estiment qu'il s'agit d'un problème qui devrait être optimisé et que le modèle devrait être davantage conforme aux habitudes de langage humain.

Récemment, une équipe de recherche de l'UC Berkeley a proposé une nouvelle méthode d'édition d'images basée sur des instructions humaines, InstructPix2Pix : étant donné une image d'entrée et une description textuelle qui indique au modèle quoi faire, le modèle peut suivre les instructions de description pour modifier l'image.

Adresse papier : https://arxiv.org/pdf/2211.09800.pdf

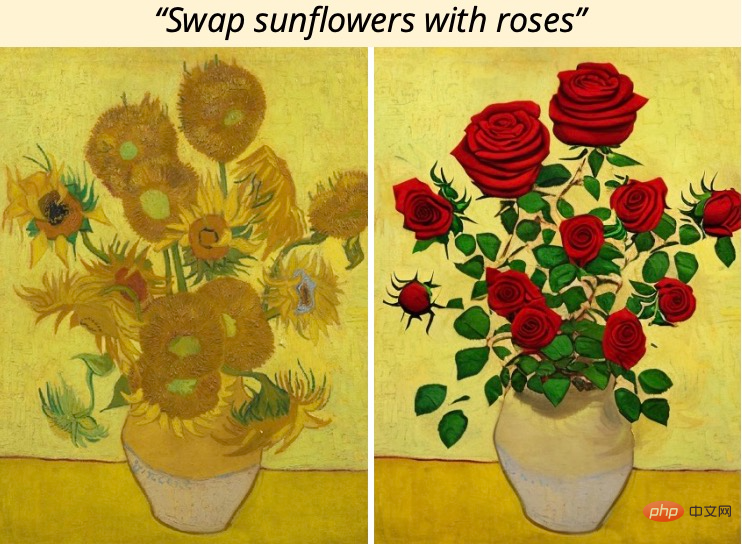

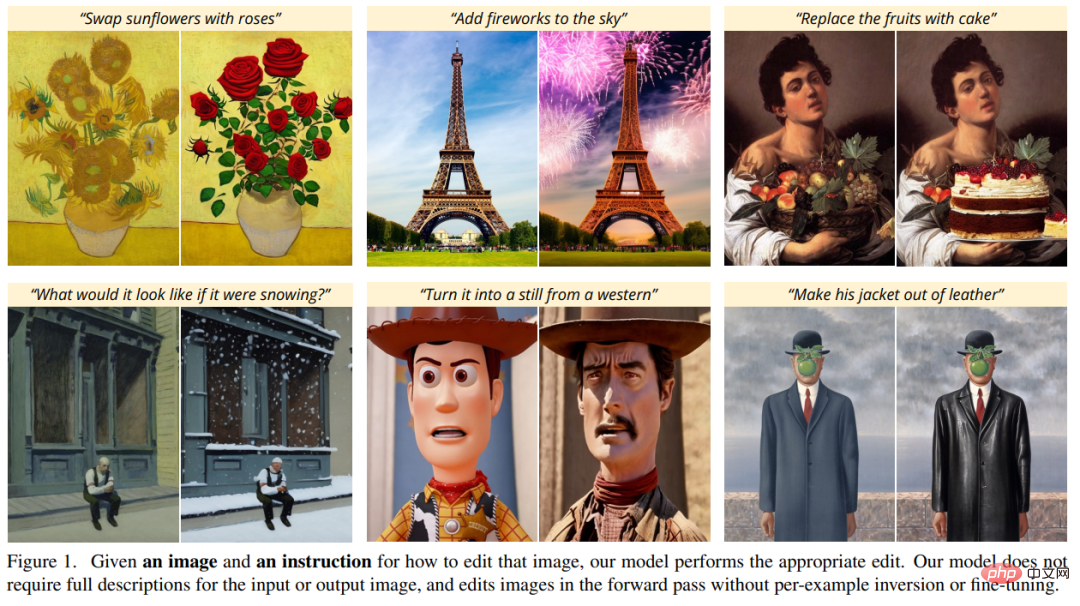

Par exemple, pour remplacer les tournesols du tableau par des roses, il suffit de dire directement "Mettez " au modèle Tournesols remplacés par des roses":

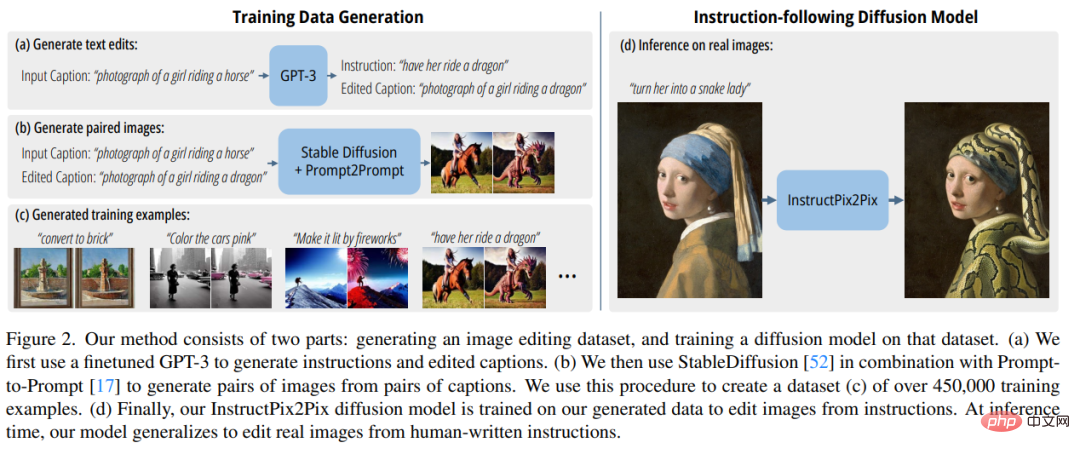

Afin d'obtenir des données de formation, l'étude a combiné deux modèles pré-entraînés à grande échelle - le modèle de langage (GPT-3) et la génération de texte en image modèle (Diffusion stable) pour générer un grand ensemble de données d'entraînement par paires d'exemples d'édition d'images. Les chercheurs ont formé un nouveau modèle, InstructPix2Pix, sur ce vaste ensemble de données et l'ont généralisé à des images réelles et à des instructions écrites par l'utilisateur au moment de l'inférence.

InstructPix2Pix est un modèle de diffusion conditionnelle qui génère une image modifiée à partir d'une image d'entrée et d'une instruction textuelle pour modifier l'image. Le modèle effectue l'édition d'images directement dans la passe avant et ne nécessite aucun exemple d'image supplémentaire, aucune description complète des images d'entrée/sortie ou un réglage fin de chaque exemple, de sorte que le modèle peut éditer rapidement des images en quelques secondes seulement.

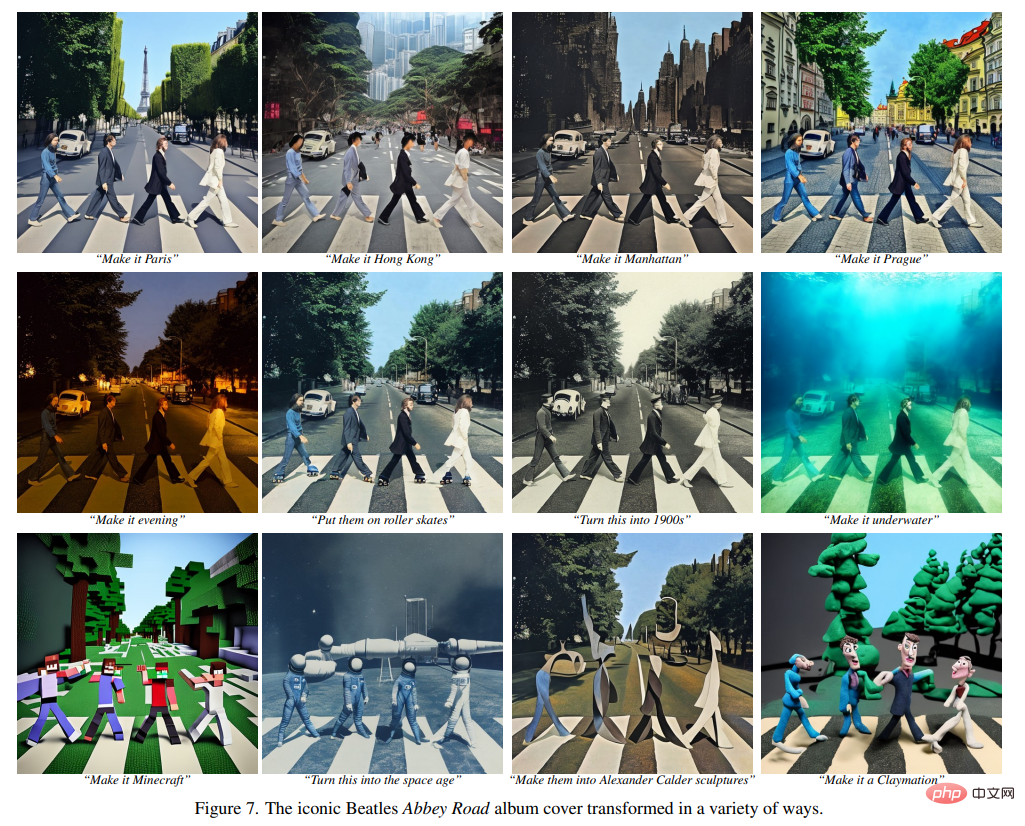

Bien qu'InstructPix2Pix soit entièrement formé sur des exemples synthétiques (c'est-à-dire des descriptions de texte générées par GPT-3 et des images générées par Stable Diffusion), le modèle réalise une généralisation sans plan à des images réelles arbitraires et à du texte écrit par l'homme. La maquette prend en charge l'édition d'images intuitive, notamment le remplacement d'objets, la modification des styles d'image, etc.

Aperçu de la méthode

Les chercheurs ont traité l'édition d'images basée sur des instructions comme un problème d'apprentissage supervisé : d'abord, ils ont généré un ensemble de données de formation appariées contenant des instructions d'édition de texte et des images avant et après l'édition (Figure 2a-c), puis une édition d'image. Le modèle de diffusion a été formé sur cet ensemble de données généré (Fig. 2d). Bien qu'entraîné à l'aide d'images générées et d'instructions d'édition, le modèle est toujours capable d'éditer des images réelles à l'aide d'instructions arbitraires écrites par des humains. La figure 2 ci-dessous est un aperçu de la méthode.

Générer un ensemble de données de formation multimodal

Au stade de la génération de l'ensemble de données, les chercheurs ont combiné un grand modèle de langage (GPT-3) et un modèle de texte en image ( Stable Diffusion), un ensemble de données de formation multimodales contenant des instructions d'édition de texte et des images correspondantes avant et après l'édition a été généré. Ce processus comprend les étapes suivantes :

- Affiner GPT-3 pour générer une collection de contenu d'édition de texte : étant donné une invite décrivant une image, générez une instruction textuelle décrivant la modification à apporter et une invite décrivant le image modifiée (Figure 2a) ;

- utilise un modèle texte-image pour convertir deux invites de texte (c'est-à-dire avant l'édition et après l'édition) en une paire d'images correspondantes (Figure 2b). Les chercheurs ont utilisé les données de formation générées pour former un modèle de diffusion conditionnelle basé sur le modèle de diffusion stable, qui peut éditer des images sur la base d'instructions écrites.

Le modèle de diffusion apprend à générer des échantillons de données grâce à une série d'auto-encodeurs de débruitage qui estiment la fraction de la distribution des données (pointant dans la direction des données haute densité). La diffusion latente améliore l'efficacité et la qualité des modèles de diffusion en opérant dans l'espace latent d'un auto-encodeur variationnel pré-entraîné avec un encodeur et un décodeur

.

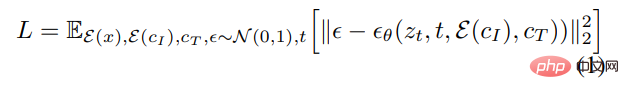

Pour une image x, le processus de diffusion ajoute du bruit au latent codé , ce qui produit un z_t latent bruyant où le niveau de bruit augmente avec le pas de temps t∈T. Nous apprenons un réseau qui prédit le bruit ajouté à un z_t latent bruyant étant donné une image conditionnant C_I et une instruction textuelle conditionnant C_T. Les chercheurs ont minimisé l'objectif de diffusion latent suivant :

Auparavant, des études (Wang et al.) ont montré que pour les tâches de traduction d'images, en particulier lorsque les données d'entraînement appariées sont limitées, le réglage fin des grands modèles de diffusion d'images surpasse l'entraînement. eux à partir de zéro. Par conséquent, dans de nouvelles recherches, les auteurs utilisent un point de contrôle de diffusion stable pré-entraîné pour initialiser les poids du modèle, en tirant parti de ses puissantes capacités de génération de texte en image. Pour prendre en charge le conditionnement d'image, les chercheurs ont ajouté un canal d'entrée supplémentaire à la première couche convolutive, connectant z_t et

. Tous les poids disponibles du modèle de diffusion sont initialisés à partir du point de contrôle pré-entraîné, tandis que les poids fonctionnant sur les canaux d'entrée nouvellement ajoutés sont initialisés à zéro. L'auteur réutilise ici le même mécanisme d'ajustement de texte utilisé à l'origine pour la légende sans prendre l'instruction d'édition de texte c_T en entrée.

Résultats expérimentaux

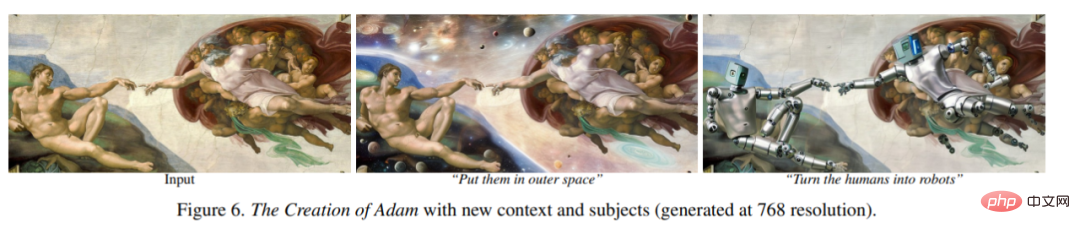

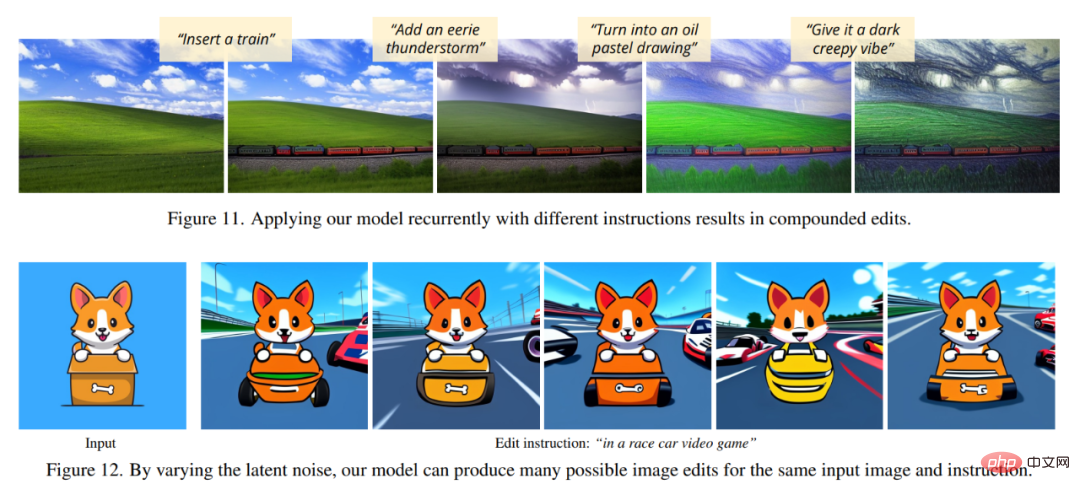

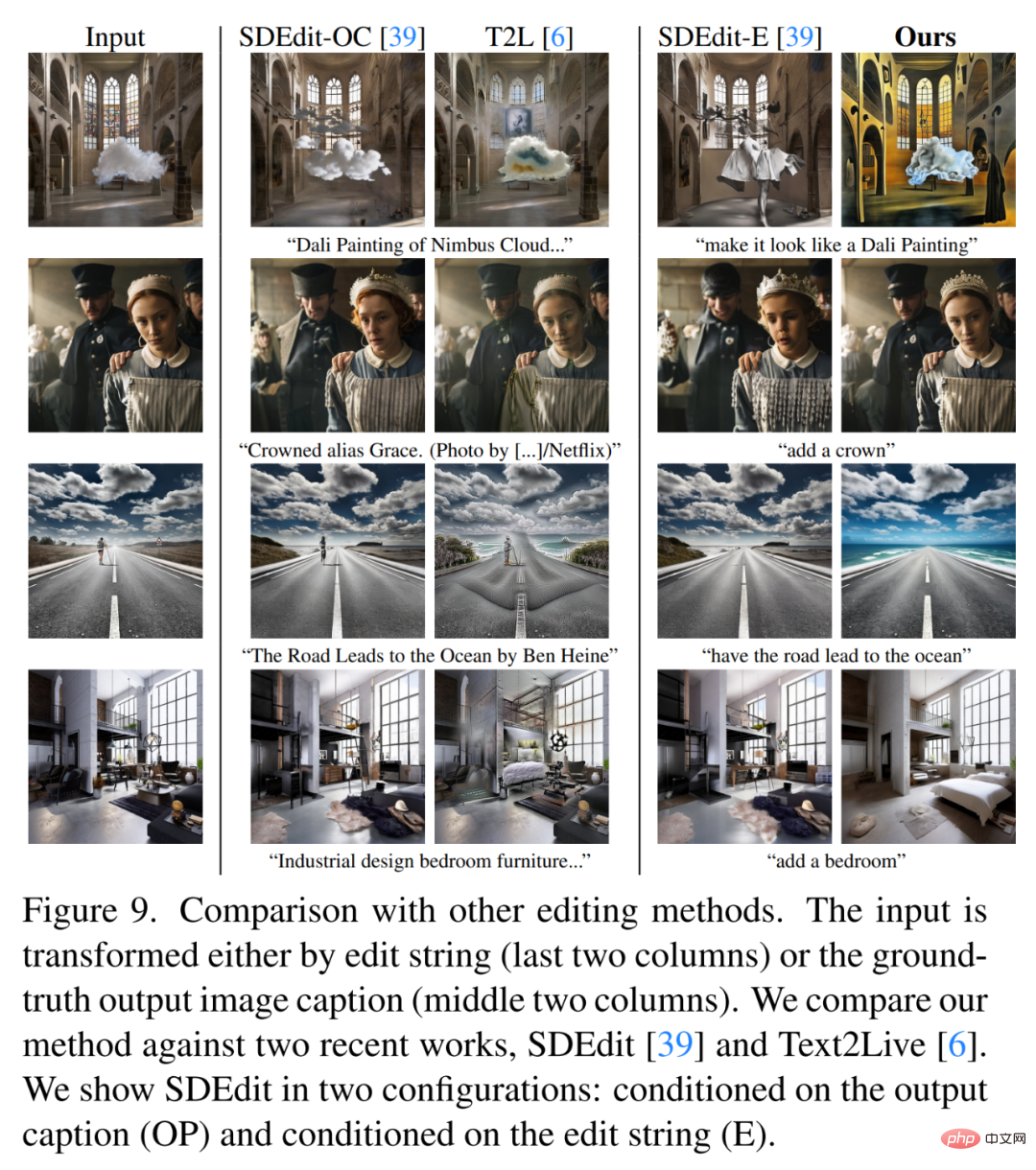

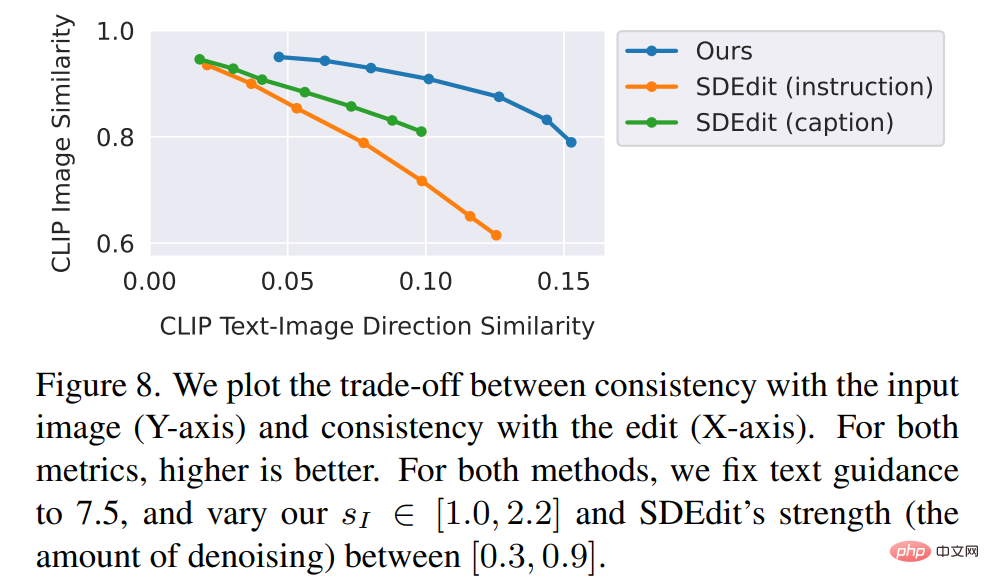

Dans les figures ci-dessous, les auteurs montrent les résultats d'édition d'image de leur nouveau modèle. Ces résultats concernent un ensemble différent de photos et d’œuvres d’art réelles. Le nouveau modèle effectue avec succès de nombreuses modifications difficiles, notamment le remplacement d'objets, la modification des saisons et de la météo, le remplacement d'arrière-plans, la modification des propriétés des matériaux, la conversion de supports artistiques, etc.Les chercheurs ont comparé la nouvelle méthode avec certaines technologies récentes telles que SDEdit, Text2Live, etc. Le nouveau modèle suit les instructions d'édition des images, tandis que d'autres méthodes, y compris les méthodes de base, nécessitent des descriptions d'images ou d'édition de calques. Par conséquent, lors de la comparaison, l'auteur fournit des annotations de texte « éditées » pour ces derniers au lieu d'instructions d'édition. Les auteurs comparent également quantitativement la nouvelle méthode avec SDEdit, en utilisant deux mesures qui mesurent la cohérence de l'image et la qualité d'édition. Enfin, les auteurs montrent comment la taille et la qualité des données d’entraînement générées affectent les résultats d’ablation sur les performances du modèle.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

La commande de fermeture CENTOS est arrêtée et la syntaxe est la fermeture de [options] le temps [informations]. Les options incluent: -H Arrêtez immédiatement le système; -P éteignez l'alimentation après l'arrêt; -r redémarrer; -t temps d'attente. Les temps peuvent être spécifiés comme immédiats (maintenant), minutes (minutes) ou une heure spécifique (HH: mm). Des informations supplémentaires peuvent être affichées dans les messages système.

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

La politique de sauvegarde et de récupération de GitLab dans le système CentOS afin d'assurer la sécurité et la récupérabilité des données, Gitlab on CentOS fournit une variété de méthodes de sauvegarde. Cet article introduira plusieurs méthodes de sauvegarde courantes, paramètres de configuration et processus de récupération en détail pour vous aider à établir une stratégie complète de sauvegarde et de récupération de GitLab. 1. MANUEL BACKUP Utilisez le Gitlab-RakegitLab: Backup: Créer la commande pour exécuter la sauvegarde manuelle. Cette commande sauvegarde des informations clés telles que le référentiel Gitlab, la base de données, les utilisateurs, les groupes d'utilisateurs, les clés et les autorisations. Le fichier de sauvegarde par défaut est stocké dans le répertoire / var / opt / gitlab / backups. Vous pouvez modifier / etc / gitlab

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Guide complet pour vérifier la configuration HDFS dans les systèmes CentOS Cet article vous guidera comment vérifier efficacement la configuration et l'état de l'exécution des HDF sur les systèmes CentOS. Les étapes suivantes vous aideront à bien comprendre la configuration et le fonctionnement des HDF. Vérifiez la variable d'environnement Hadoop: Tout d'abord, assurez-vous que la variable d'environnement Hadoop est correctement définie. Dans le terminal, exécutez la commande suivante pour vérifier que Hadoop est installé et configuré correctement: HadoopVersion Check HDFS Fichier de configuration: Le fichier de configuration de base de HDFS est situé dans le répertoire / etc / hadoop / conf / le répertoire, où Core-site.xml et hdfs-site.xml sont cruciaux. utiliser

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Activer l'accélération du GPU Pytorch sur le système CentOS nécessite l'installation de versions CUDA, CUDNN et GPU de Pytorch. Les étapes suivantes vous guideront tout au long du processus: CUDA et CUDNN Installation détermineront la compatibilité de la version CUDA: utilisez la commande NVIDIA-SMI pour afficher la version CUDA prise en charge par votre carte graphique NVIDIA. Par exemple, votre carte graphique MX450 peut prendre en charge CUDA11.1 ou plus. Téléchargez et installez Cudatoolkit: visitez le site officiel de Nvidiacudatoolkit et téléchargez et installez la version correspondante selon la version CUDA la plus élevée prise en charge par votre carte graphique. Installez la bibliothèque CUDNN:

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

L'installation de MySQL sur CENTOS implique les étapes suivantes: Ajout de la source MySQL YUM appropriée. Exécutez la commande YUM Install MySQL-Server pour installer le serveur MySQL. Utilisez la commande mysql_secure_installation pour créer des paramètres de sécurité, tels que la définition du mot de passe de l'utilisateur racine. Personnalisez le fichier de configuration MySQL selon les besoins. Écoutez les paramètres MySQL et optimisez les bases de données pour les performances.

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Docker utilise les fonctionnalités du noyau Linux pour fournir un environnement de fonctionnement d'application efficace et isolé. Son principe de travail est le suivant: 1. Le miroir est utilisé comme modèle en lecture seule, qui contient tout ce dont vous avez besoin pour exécuter l'application; 2. Le Système de fichiers Union (UnionFS) empile plusieurs systèmes de fichiers, ne stockant que les différences, l'économie d'espace et l'accélération; 3. Le démon gère les miroirs et les conteneurs, et le client les utilise pour l'interaction; 4. Les espaces de noms et les CGROUP implémentent l'isolement des conteneurs et les limitations de ressources; 5. Modes de réseau multiples prennent en charge l'interconnexion du conteneur. Ce n'est qu'en comprenant ces concepts principaux que vous pouvez mieux utiliser Docker.

CentOS8 redémarre SSH

Apr 14, 2025 pm 09:00 PM

CentOS8 redémarre SSH

Apr 14, 2025 pm 09:00 PM

La commande pour redémarrer le service SSH est: SystemCTL Redémarrer SSHD. Étapes détaillées: 1. Accédez au terminal et connectez-vous au serveur; 2. Entrez la commande: SystemCTL Restart SSHD; 3. Vérifiez l'état du service: SystemCTL Status Sshd.

Comment faire fonctionner la formation distribuée de Pytorch sur CentOS

Apr 14, 2025 pm 06:36 PM

Comment faire fonctionner la formation distribuée de Pytorch sur CentOS

Apr 14, 2025 pm 06:36 PM

La formation distribuée par Pytorch sur le système CentOS nécessite les étapes suivantes: Installation de Pytorch: La prémisse est que Python et PIP sont installés dans le système CentOS. Selon votre version CUDA, obtenez la commande d'installation appropriée sur le site officiel de Pytorch. Pour la formation du processeur uniquement, vous pouvez utiliser la commande suivante: pipinstalltorchtorchVisionTorChaudio Si vous avez besoin d'une prise en charge du GPU, assurez-vous que la version correspondante de CUDA et CUDNN est installée et utilise la version Pytorch correspondante pour l'installation. Configuration de l'environnement distribué: la formation distribuée nécessite généralement plusieurs machines ou des GPU multiples uniques. Lieu