Périphériques technologiques

Périphériques technologiques

IA

IA

Ray, le framework d'IA open source derrière ChatGPT, vaut désormais 1 milliard de dollars

Ray, le framework d'IA open source derrière ChatGPT, vaut désormais 1 milliard de dollars

Ray, le framework d'IA open source derrière ChatGPT, vaut désormais 1 milliard de dollars

L'intelligence artificielle génératrice de texte a récemment pris d'assaut Internet : ChatGPT est populaire pour sa capacité à fournir des réponses très détaillées et presque réalistes à presque toutes les questions auxquelles on peut penser. L’émergence d’applications à grande échelle a rendu les gens pleinement confiants dans les avancées technologiques de l’IA, mais peu de gens savent que derrière cela, un cadre d’apprentissage automatique distribué alimente cette révolution de l’IA générative.

Le framework informatique distribué Ray de la startup Anyscale soutenue par A16z est essentiel pour permettre à OpenAI de dynamiser sa formation de modèles comme ChatGPT. Ray est à l'origine de tous les récents modèles de langage à grande échelle d'OpenAI – et il pourrait également être le cadre derrière le très attendu GPT-4 d'OpenAI. Avec la mise en œuvre continue de technologies de modélisation à grande échelle, les initiés de l'industrie estiment qu'une industrie valant des milliards de dollars est en train de se former en générant un contenu proche des humains.

Dans ce domaine, Ray est le cadre le plus influent. Avant son avènement, OpenAI utilisait une collection personnalisée d’outils pour développer de grands modèles. Mais le président d'OpenAI, Greg Brockman, a déclaré lors du Ray Summit plus tôt cette année que l'entreprise s'était tournée vers Ray à mesure que les défis auxquels elle était confrontée augmentaient.

Lukas Biewald, PDG de la société de logiciels Weights & Biases, estime que Ray est déjà une étoile montante dans le monde de l'IA. "Grâce aux nouveaux outils, vous pouvez exécuter le même code sur un ordinateur portable et sur un grand serveur distribué. C'est un changement énorme, et cela va gagner en importance à mesure que les modèles grandissent", a déclaré Biewald.

Pari d'un milliard de dollars

À mesure que la technologie mûrit, Ray a attiré l'attention du marché des capitaux. Les actions d'Anyscale sont devenues une denrée rare, Business Insider rapportant que son dernier cycle de financement, une extension de sa série C, s'est clôturé en quelques jours pour une valorisation de plus d'un milliard de dollars, selon des sources proches du dossier.

Certains investisseurs ont décrit Anyscale comme le « prochain Databricks » plein d’espoir d’Horowitz – une description qui a du sens, étant donné que le co-fondateur de la startup, Ion Stoica, est un géant des données de 31 milliards de dollars.

« L'intelligence artificielle se développe à un rythme incroyable et les gens essaient constamment de nouvelles approches », a déclaré Robert Nishihara, PDG d'Anyscale. "ChatGPT combine de nombreux travaux antérieurs sur de grands modèles de langage. En plus de cela, vous devez disposer d'une infrastructure qui permet la flexibilité, l'innovation rapide et l'expansion de différents algorithmes et méthodes

En raison de la popularité de ChatGPT." Derrière les nouveaux outils se cachent des modèles de plus en plus grands, et les entreprises technologiques doivent repenser entièrement la manière dont elles développent l’IA. Ray est né pour faciliter la formation de ces modèles massifs et peut contenir des centaines de milliards de points de données, donnant à chaque réponse une sensation quasi réaliste.

Comment Ray est devenu l'outil de choix pour l'apprentissage automatique

Ray est un cadre informatique distribué basé sur le partage de mémoire, adapté au calcul parallèle à granularité fine et au calcul hétérogène, qui fournit une infrastructure sous-jacente pour gérer l'allocation. La tâche complexe de former des modèles d’apprentissage automatique.

En 2017, des chercheurs de l'UC Berkeley ont soumis pour la première fois l'article de Ray « Ray : A Distributed Framework for Emerging AI Applications » :

- Lien papier : https://arxiv.org/abs/1712.05889

- GitHub : https://github.com/ray-project/ray

Dans ce travail, des chercheurs prédisez à quoi ressemblera la prochaine génération d’applications d’IA : une application qui interagit en permanence avec l’environnement et apprend des actions interactives. Ces applications doivent de plus en plus effectuer des tâches dans des environnements dynamiques, réagir aux changements de l'environnement et effectuer une série d'actions pour atteindre des objectifs à long terme. Ces fonctionnalités ont mis en avant des exigences système nouvelles et exigeantes en termes de performances et de flexibilité de l'environnement d'exploitation, c'est pourquoi les chercheurs ont proposé un cadre Ray distribué.

Ray implémente une interface unifiée capable d'exprimer le parallélisme des tâches et le calcul basé sur les acteurs, pris en charge par un seul moteur d'exécution dynamique. Pour répondre aux exigences de performances, Ray utilise un planificateur distribué et un stockage distribué tolérant aux pannes pour gérer l'état de contrôle du système. Il s'agit du premier framework informatique distribué qui unifie la formation, la simulation et les services. Il unifie les calculs parallèles de rôles (acteurs) et de tâches (tâches) basés sur un moteur d'exécution de tâches dynamique, et garantit la haute évolutivité et les hautes performances du framework. tolérance.

L'architecture de Ray.

Sur la base de ce travail, en décembre 2019, Robert Nishihara, Philipp Moritz et Ion Stoica de l'UC Berkeley, ainsi que le professeur Michael I. Jordan de Berkeley, ont fondé Anyscale, qui a levé 260 millions de dollars à ce jour.

Les praticiens de l'apprentissage automatique peuvent souvent exécuter de petits modèles en utilisant des ensembles de données limités sur leurs ordinateurs portables, tels que des modèles simples qui prédisent les produits que les utilisateurs achèteront. Cependant, les ordinateurs portables ne sont pas réalisables pour les très gros modèles comme ChatGPT, qui nécessitent d’énormes serveurs pour s’entraîner.

La formation d'un modèle utilisant un grand nombre d'appareils est confrontée à un défi important : coordonner la formation sur différents matériels. Ray résout simplement ce problème. Il fournit aux praticiens un mécanisme permettant de gérer différents matériels en tant qu'unité afin de déterminer quelles données vont où, gérer les pannes, etc. Les types de matériel couvrent Google Cloud, AWS et d'autres. Un portefeuille de produits qui résolvent le même problème. . En outre, Ray a également étendu le terme « acteur », un concept de programmation clé dans d'autres langages, à Python, connu pour être le langage de choix pour les programmes d'apprentissage automatique.

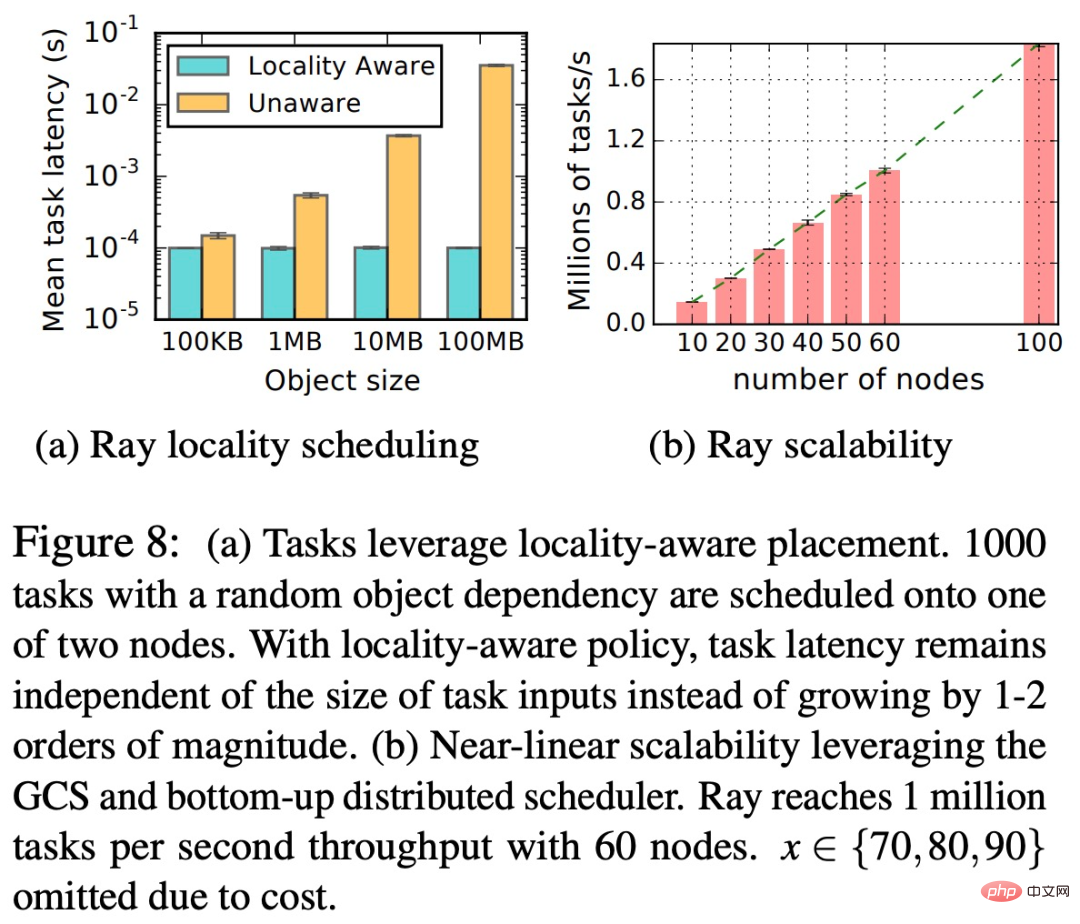

En tant que cadre informatique distribué, Ray présente deux avantages clés, à savoir la localisation (Locality-aware) et le placement de tâches (placement de tâches). Comme le montre la figure ci-dessous, Ray est capable de faire évoluer le système pour prendre en charge des tâches à haut débit et à granularité fine tout en conservant la tolérance aux pannes et la planification des tâches à faible latence.

Ray supprime une complexité significative liée à la formation de grands modèles pour OpenAI, permettant ainsi à l'entreprise de se concentrer sur les capacités critiques du modèle.

Une nouvelle génération d'IA nécessite de nouveaux outils de développement, et Ray n'est que l'un des nombreux outils d'apprentissage automatique de nouvelle génération qui émergent rapidement et qui bouleversent rapidement la façon dont l'IA est développée. Par exemple, le framework JAX de Google a également reçu une grande attention. JAX devrait devenir l'épine dorsale des principaux outils d'apprentissage automatique de Google et a été largement adopté dans DeepMind et Google Brain.

De même, Coiled, une startup soutenue par FirstMark Capital et Bessemer Venture Partners, a développé un framework informatique parallèle appelé Dask.

Les modèles linguistiques à grande échelle libèrent davantage de potentiel de nos jours, et ces nouveaux outils d'apprentissage automatique construiront des modèles linguistiques plus puissants pour les géants de la technologie et les startups du secteur.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

La commande de fermeture CENTOS est arrêtée et la syntaxe est la fermeture de [options] le temps [informations]. Les options incluent: -H Arrêtez immédiatement le système; -P éteignez l'alimentation après l'arrêt; -r redémarrer; -t temps d'attente. Les temps peuvent être spécifiés comme immédiats (maintenant), minutes (minutes) ou une heure spécifique (HH: mm). Des informations supplémentaires peuvent être affichées dans les messages système.

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

La politique de sauvegarde et de récupération de GitLab dans le système CentOS afin d'assurer la sécurité et la récupérabilité des données, Gitlab on CentOS fournit une variété de méthodes de sauvegarde. Cet article introduira plusieurs méthodes de sauvegarde courantes, paramètres de configuration et processus de récupération en détail pour vous aider à établir une stratégie complète de sauvegarde et de récupération de GitLab. 1. MANUEL BACKUP Utilisez le Gitlab-RakegitLab: Backup: Créer la commande pour exécuter la sauvegarde manuelle. Cette commande sauvegarde des informations clés telles que le référentiel Gitlab, la base de données, les utilisateurs, les groupes d'utilisateurs, les clés et les autorisations. Le fichier de sauvegarde par défaut est stocké dans le répertoire / var / opt / gitlab / backups. Vous pouvez modifier / etc / gitlab

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Guide complet pour vérifier la configuration HDFS dans les systèmes CentOS Cet article vous guidera comment vérifier efficacement la configuration et l'état de l'exécution des HDF sur les systèmes CentOS. Les étapes suivantes vous aideront à bien comprendre la configuration et le fonctionnement des HDF. Vérifiez la variable d'environnement Hadoop: Tout d'abord, assurez-vous que la variable d'environnement Hadoop est correctement définie. Dans le terminal, exécutez la commande suivante pour vérifier que Hadoop est installé et configuré correctement: HadoopVersion Check HDFS Fichier de configuration: Le fichier de configuration de base de HDFS est situé dans le répertoire / etc / hadoop / conf / le répertoire, où Core-site.xml et hdfs-site.xml sont cruciaux. utiliser

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Activer l'accélération du GPU Pytorch sur le système CentOS nécessite l'installation de versions CUDA, CUDNN et GPU de Pytorch. Les étapes suivantes vous guideront tout au long du processus: CUDA et CUDNN Installation détermineront la compatibilité de la version CUDA: utilisez la commande NVIDIA-SMI pour afficher la version CUDA prise en charge par votre carte graphique NVIDIA. Par exemple, votre carte graphique MX450 peut prendre en charge CUDA11.1 ou plus. Téléchargez et installez Cudatoolkit: visitez le site officiel de Nvidiacudatoolkit et téléchargez et installez la version correspondante selon la version CUDA la plus élevée prise en charge par votre carte graphique. Installez la bibliothèque CUDNN:

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

L'installation de MySQL sur CENTOS implique les étapes suivantes: Ajout de la source MySQL YUM appropriée. Exécutez la commande YUM Install MySQL-Server pour installer le serveur MySQL. Utilisez la commande mysql_secure_installation pour créer des paramètres de sécurité, tels que la définition du mot de passe de l'utilisateur racine. Personnalisez le fichier de configuration MySQL selon les besoins. Écoutez les paramètres MySQL et optimisez les bases de données pour les performances.

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Docker utilise les fonctionnalités du noyau Linux pour fournir un environnement de fonctionnement d'application efficace et isolé. Son principe de travail est le suivant: 1. Le miroir est utilisé comme modèle en lecture seule, qui contient tout ce dont vous avez besoin pour exécuter l'application; 2. Le Système de fichiers Union (UnionFS) empile plusieurs systèmes de fichiers, ne stockant que les différences, l'économie d'espace et l'accélération; 3. Le démon gère les miroirs et les conteneurs, et le client les utilise pour l'interaction; 4. Les espaces de noms et les CGROUP implémentent l'isolement des conteneurs et les limitations de ressources; 5. Modes de réseau multiples prennent en charge l'interconnexion du conteneur. Ce n'est qu'en comprenant ces concepts principaux que vous pouvez mieux utiliser Docker.

CentOS8 redémarre SSH

Apr 14, 2025 pm 09:00 PM

CentOS8 redémarre SSH

Apr 14, 2025 pm 09:00 PM

La commande pour redémarrer le service SSH est: SystemCTL Redémarrer SSHD. Étapes détaillées: 1. Accédez au terminal et connectez-vous au serveur; 2. Entrez la commande: SystemCTL Restart SSHD; 3. Vérifiez l'état du service: SystemCTL Status Sshd.

Comment faire fonctionner la formation distribuée de Pytorch sur CentOS

Apr 14, 2025 pm 06:36 PM

Comment faire fonctionner la formation distribuée de Pytorch sur CentOS

Apr 14, 2025 pm 06:36 PM

La formation distribuée par Pytorch sur le système CentOS nécessite les étapes suivantes: Installation de Pytorch: La prémisse est que Python et PIP sont installés dans le système CentOS. Selon votre version CUDA, obtenez la commande d'installation appropriée sur le site officiel de Pytorch. Pour la formation du processeur uniquement, vous pouvez utiliser la commande suivante: pipinstalltorchtorchVisionTorChaudio Si vous avez besoin d'une prise en charge du GPU, assurez-vous que la version correspondante de CUDA et CUDNN est installée et utilise la version Pytorch correspondante pour l'installation. Configuration de l'environnement distribué: la formation distribuée nécessite généralement plusieurs machines ou des GPU multiples uniques. Lieu