Périphériques technologiques

Périphériques technologiques

IA

IA

Une étude montre que les grands modèles de langage ont des problèmes de raisonnement logique

Une étude montre que les grands modèles de langage ont des problèmes de raisonnement logique

Une étude montre que les grands modèles de langage ont des problèmes de raisonnement logique

Traducteur | Li Rui

Réviseur | Sun Shujuan

Avant que les chatbots dotés de sensibilité ne deviennent un sujet brûlant, les grands modèles de langage (LLM) suscitaient déjà plus d'enthousiasme et d'inquiétude. Ces dernières années, les grands modèles linguistiques (LLM), des modèles d'apprentissage profond formés sur de grandes quantités de texte, ont obtenu de bons résultats sur plusieurs critères utilisés pour mesurer les capacités de compréhension du langage.

Les grands modèles linguistiques tels que GPT-3 et LaMDA parviennent à maintenir la cohérence sur des textes plus longs. Ils semblent bien informés sur différents sujets et restent cohérents tout au long des longues conversations. Les grands modèles de langage (LLM) sont devenus si convaincants que certaines personnes les associent à la personnalité et à des formes supérieures d'intelligence.

Mais les grands modèles linguistiques (LLM) peuvent-ils effectuer un raisonnement logique comme les humains ? Transformers, une architecture d'apprentissage profond utilisée dans les grands modèles de langage (LLM), n'apprend pas à simuler les capacités de raisonnement, selon un article de recherche publié par des scientifiques de l'UCLA. Au lieu de cela, les ordinateurs ont trouvé des moyens intelligents d’apprendre les propriétés statistiques inhérentes aux problèmes de raisonnement.

Les chercheurs ont testé l'architecture Transformer BERT actuellement populaire dans un espace problématique limité. Leurs résultats montrent que BERT peut répondre avec précision aux problèmes d'inférence sur des exemples au sein d'une distribution dans l'espace de formation, mais ne peut pas généraliser à des exemples dans d'autres distributions basées sur le même espace de problèmes.

Et ces tests mettent en évidence certaines des lacunes des réseaux de neurones profonds et les benchmarks utilisés pour les évaluer.

1. Comment mesurer le raisonnement logique en intelligence artificielle ?

Il existe plusieurs benchmarks pour les systèmes d'intelligence artificielle ciblant les problèmes de traitement et de compréhension du langage naturel, tels que GLUE, SuperGLUE, SNLI et SqUAD. Au fur et à mesure que Transformer s'est développé et a été formé sur des ensembles de données plus volumineux, Transformer a pu améliorer progressivement ces références.

Il convient de noter que les performances des systèmes d’IA sur ces benchmarks sont souvent comparées à l’intelligence humaine. La performance humaine par rapport à ces critères est étroitement liée au bon sens et aux capacités de raisonnement logique. Mais il n’est pas clair si les grands modèles de langage s’améliorent parce qu’ils acquièrent des capacités de raisonnement logique ou parce qu’ils sont exposés à de grandes quantités de texte.

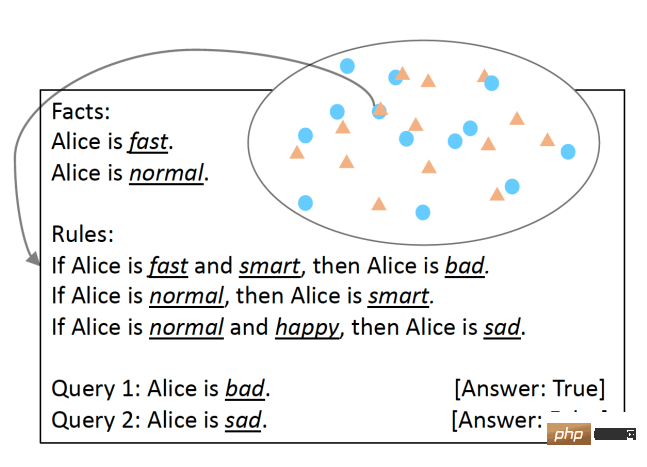

Pour tester cela, les chercheurs de l'UCLA ont développé SimpleLogic, une classe de questions de raisonnement logique basées sur la logique propositionnelle. Pour garantir que les capacités de raisonnement du modèle linguistique ont été rigoureusement testées, les chercheurs ont éliminé les différences linguistiques en utilisant des structures linguistiques modèles. Les problèmes SimpleLogic consistent en un ensemble de faits, de règles, de requêtes et d'étiquettes. Les faits sont des prédicats connus pour être « vrais ». Les règles sont des conditions, définies comme des termes. Une requête est une question à laquelle un modèle de machine learning doit répondre. L'étiquette est la réponse à la requête, c'est-à-dire « vrai » ou « faux ». Les questions SimpleLogic sont compilées en chaînes de texte continues contenant les signaux et délimiteurs attendus par le modèle de langage lors de la formation et de l'inférence.

Questions au format SimpleLogic L'une des caractéristiques de SimpleLogic est que ses questions sont autonomes et ne nécessitent aucune connaissance préalable. Ceci est particulièrement important car, comme le disent de nombreux scientifiques, lorsque les humains parlent, ils ignorent les connaissances partagées. C’est pourquoi les modèles linguistiques tombent souvent dans un piège lorsqu’on leur pose des questions sur les connaissances fondamentales du monde que tout le monde connaît. En revanche, SimpleLogic fournit aux développeurs tout ce dont ils ont besoin pour résoudre leurs problèmes. Par conséquent, tout développeur examinant un problème posé par le format SimpleLogic devrait être capable de déduire ses règles et de gérer de nouveaux exemples, quelles que soient ses connaissances de base.

2. Caractérisation statistique et inférence logique

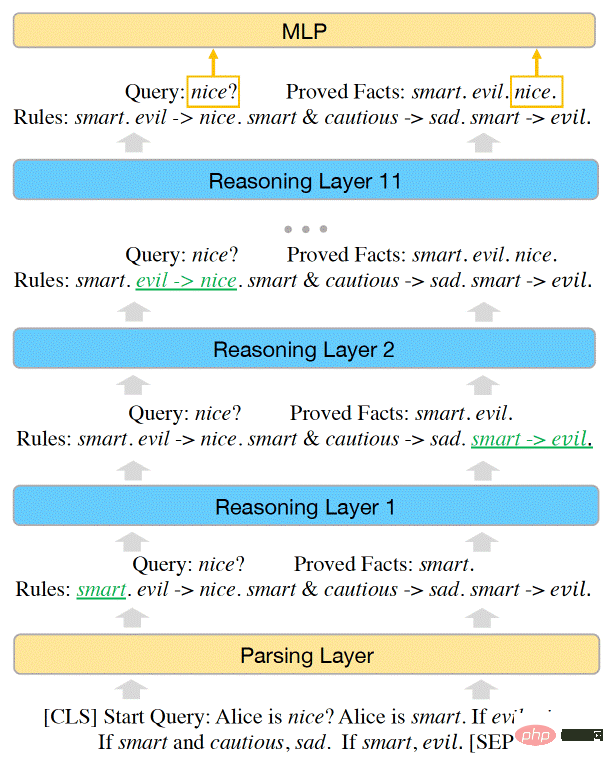

Les chercheurs ont démontré que l'espace du problème dans SimpleLogic peut être représenté par une fonction d'inférence. Les chercheurs ont en outre montré que BERT est suffisamment puissant pour résoudre tous les problèmes de SimpleLogic et qu'ils peuvent ajuster manuellement les paramètres du modèle d'apprentissage automatique pour représenter la fonction d'inférence.

Cependant, lorsqu'ils ont formé BERT sur l'exemple d'ensemble de données SimpleLogic, le modèle n'a pas pu apprendre la fonction d'inférence par lui-même. Les modèles d'apprentissage automatique parviennent à atteindre une précision presque parfaite sur une distribution de données. Mais cela ne se généralise pas à d’autres distributions au sein du même espace problématique. C'est le cas même si l'ensemble de données de formation couvre tout l'espace du problème et que toutes les distributions proviennent de la même fonction d'inférence.

La capacité du modèle BERT Transformer est suffisante pour représenter les capacités d'inférence de SimpleLogic

(Remarque : ceci est différent du défi de généralisation hors distribution, qui s'applique aux problèmes d'espace ouvert. Lorsque le modèle ne peut pas généraliser aux données OOD, lors du traitement. Lorsque les données sont en dehors de la plage de distribution de leur ensemble d'apprentissage, leurs performances chuteront considérablement)

Les chercheurs ont écrit : « Après une enquête plus approfondie, nous fournissons une explication à ce paradoxe : un modèle qui atteint une grande précision uniquement sur des exemples de tests de distribution n'a pas appris à raisonner. En fait, le modèle a appris à utiliser les caractéristiques statistiques des problèmes d'inférence logique. faire des prédictions, plutôt que de modéliser des fonctions d'inférence correctes. »

Cette découverte met en évidence un défi important dans l'utilisation de l'apprentissage en profondeur pour les tâches linguistiques. Les réseaux de neurones sont très efficaces pour découvrir et ajuster les caractéristiques statistiques. Dans certaines applications, cela peut être très utile. Par exemple, dans l’analyse des sentiments, il existe de fortes corrélations entre certains mots et catégories de sentiments.

Cependant, pour les tâches de raisonnement logique, même si des caractéristiques statistiques existent, le modèle doit essayer de trouver et d'apprendre les caractéristiques de raisonnement sous-jacentes.

"Il faut faire preuve de prudence lorsque nous tentons de former des modèles neuronaux de bout en bout pour résoudre des tâches de traitement du langage naturel (NLP) qui impliquent à la fois un raisonnement logique et des connaissances préalables et présentent des différences linguistiques", ont écrit les chercheurs. Les défis posés par SimpleLogic deviennent encore plus graves dans le monde réel, où les grandes quantités d'informations requises pour les grands modèles de langage (LLM) ne sont tout simplement pas contenues dans les données.

Les chercheurs ont observé que lorsqu'ils supprimaient une fonctionnalité statistique de l'ensemble de données de formation, les performances du modèle de langage s'amélioraient sur d'autres distributions du même espace problématique. Le problème, cependant, est qu’il est plus facile à dire qu’à faire de découvrir et de supprimer plusieurs fonctionnalités statistiques. Comme le soulignent les chercheurs dans leur article, « de telles caractéristiques statistiques peuvent être nombreuses et extrêmement complexes, ce qui les rend difficiles à supprimer des données de formation

3. L'inférence dans le Deep Learning

Malheureusement, en raison de la taille du langage. Le modèle augmente, le problème du raisonnement logique ne disparaît pas. C'est juste caché dans d'immenses architectures et de très grands corpus de formation. Les grands modèles de langage (LLM) peuvent très bien décrire des faits et assembler des phrases, mais en termes de raisonnement logique, ils utilisent toujours des fonctionnalités statistiques pour le raisonnement, ce qui ne constitue pas une base solide. De plus, rien n’indique qu’en ajoutant des couches, des paramètres et des attentions aux Transformers, le fossé du raisonnement logique sera comblé.

Cet article est cohérent avec d'autres travaux montrant les limites des réseaux de neurones dans l'apprentissage de règles logiques, comme le jeu de la vie ou le raisonnement abstrait à partir de données visuelles. L'article met en évidence l'un des principaux défis auxquels sont confrontés les modèles linguistiques actuels. Comme le soulignent les chercheurs de l'UCLA : « D'une part, lorsqu'un modèle est formé pour apprendre une tâche à partir de données, il a toujours tendance à apprendre des modèles statistiques qui sont intrinsèquement présents dans les exemples d'inférence. s'appuyer sur des modèles statistiques pour faire des inférences Comme il est difficile de construire un ensemble de données d'inférence logique qui ne contient pas de caractéristiques statistiques, il est difficile d'apprendre des inférences à partir des données ://bdtechtalks.com/2022/06/27/large-. modèles-de-langage-raisonnement-logique/

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Bytedance Cutting lance le super abonnement SVIP : 499 yuans pour un abonnement annuel continu, offrant une variété de fonctions d'IA

Jun 28, 2024 am 03:51 AM

Bytedance Cutting lance le super abonnement SVIP : 499 yuans pour un abonnement annuel continu, offrant une variété de fonctions d'IA

Jun 28, 2024 am 03:51 AM

Ce site a rapporté le 27 juin que Jianying est un logiciel de montage vidéo développé par FaceMeng Technology, une filiale de ByteDance. Il s'appuie sur la plateforme Douyin et produit essentiellement du contenu vidéo court pour les utilisateurs de la plateforme. Il est compatible avec iOS, Android et. Windows, MacOS et autres systèmes d'exploitation. Jianying a officiellement annoncé la mise à niveau de son système d'adhésion et a lancé un nouveau SVIP, qui comprend une variété de technologies noires d'IA, telles que la traduction intelligente, la mise en évidence intelligente, l'emballage intelligent, la synthèse humaine numérique, etc. En termes de prix, les frais mensuels pour le clipping SVIP sont de 79 yuans, les frais annuels sont de 599 yuans (attention sur ce site : équivalent à 49,9 yuans par mois), l'abonnement mensuel continu est de 59 yuans par mois et l'abonnement annuel continu est de 59 yuans par mois. est de 499 yuans par an (équivalent à 41,6 yuans par mois) . En outre, le responsable de Cut a également déclaré que afin d'améliorer l'expérience utilisateur, ceux qui se sont abonnés au VIP d'origine

Le système de conduite intelligent Qiankun ADS3.0 de Huawei sera lancé en août et sera lancé pour la première fois sur Xiangjie S9

Jul 30, 2024 pm 02:17 PM

Le système de conduite intelligent Qiankun ADS3.0 de Huawei sera lancé en août et sera lancé pour la première fois sur Xiangjie S9

Jul 30, 2024 pm 02:17 PM

Le 29 juillet, lors de la cérémonie de lancement de la 400 000e nouvelle voiture d'AITO Wenjie, Yu Chengdong, directeur général de Huawei, président de Terminal BG et président de la BU Smart Car Solutions, a assisté et prononcé un discours et a annoncé que les modèles de la série Wenjie seraient sera lancé cette année En août, la version Huawei Qiankun ADS 3.0 a été lancée et il est prévu de pousser successivement les mises à niveau d'août à septembre. Le Xiangjie S9, qui sortira le 6 août, lancera le système de conduite intelligent ADS3.0 de Huawei. Avec l'aide du lidar, la version Huawei Qiankun ADS3.0 améliorera considérablement ses capacités de conduite intelligente, disposera de capacités intégrées de bout en bout et adoptera une nouvelle architecture de bout en bout de GOD (identification générale des obstacles)/PDP (prédictive prise de décision et contrôle), fournissant la fonction NCA de conduite intelligente d'une place de stationnement à l'autre et mettant à niveau CAS3.0

Assistant de codage d'IA augmenté par le contexte utilisant Rag et Sem-Rag

Jun 10, 2024 am 11:08 AM

Assistant de codage d'IA augmenté par le contexte utilisant Rag et Sem-Rag

Jun 10, 2024 am 11:08 AM

Améliorez la productivité, l’efficacité et la précision des développeurs en intégrant une génération et une mémoire sémantique améliorées par la récupération dans les assistants de codage IA. Traduit de EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, auteur JanakiramMSV. Bien que les assistants de programmation d'IA de base soient naturellement utiles, ils ne parviennent souvent pas à fournir les suggestions de code les plus pertinentes et les plus correctes, car ils s'appuient sur une compréhension générale du langage logiciel et des modèles d'écriture de logiciels les plus courants. Le code généré par ces assistants de codage est adapté à la résolution des problèmes qu’ils sont chargés de résoudre, mais n’est souvent pas conforme aux normes, conventions et styles de codage des équipes individuelles. Cela aboutit souvent à des suggestions qui doivent être modifiées ou affinées pour que le code soit accepté dans l'application.

Le réglage fin peut-il vraiment permettre au LLM d'apprendre de nouvelles choses : l'introduction de nouvelles connaissances peut amener le modèle à produire davantage d'hallucinations

Jun 11, 2024 pm 03:57 PM

Le réglage fin peut-il vraiment permettre au LLM d'apprendre de nouvelles choses : l'introduction de nouvelles connaissances peut amener le modèle à produire davantage d'hallucinations

Jun 11, 2024 pm 03:57 PM

Les grands modèles linguistiques (LLM) sont formés sur d'énormes bases de données textuelles, où ils acquièrent de grandes quantités de connaissances du monde réel. Ces connaissances sont intégrées à leurs paramètres et peuvent ensuite être utilisées en cas de besoin. La connaissance de ces modèles est « réifiée » en fin de formation. À la fin de la pré-formation, le modèle arrête effectivement d’apprendre. Alignez ou affinez le modèle pour apprendre à exploiter ces connaissances et répondre plus naturellement aux questions des utilisateurs. Mais parfois, la connaissance du modèle ne suffit pas, et bien que le modèle puisse accéder à du contenu externe via RAG, il est considéré comme bénéfique de l'adapter à de nouveaux domaines grâce à un réglage fin. Ce réglage fin est effectué à l'aide de la contribution d'annotateurs humains ou d'autres créations LLM, où le modèle rencontre des connaissances supplémentaires du monde réel et les intègre.

Sept questions d'entretien technique Cool GenAI et LLM

Jun 07, 2024 am 10:06 AM

Sept questions d'entretien technique Cool GenAI et LLM

Jun 07, 2024 am 10:06 AM

Pour en savoir plus sur l'AIGC, veuillez visiter : 51CTOAI.x Community https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou est différent de la banque de questions traditionnelle que l'on peut voir partout sur Internet. nécessite de sortir des sentiers battus. Les grands modèles linguistiques (LLM) sont de plus en plus importants dans les domaines de la science des données, de l'intelligence artificielle générative (GenAI) et de l'intelligence artificielle. Ces algorithmes complexes améliorent les compétences humaines et stimulent l’efficacité et l’innovation dans de nombreux secteurs, devenant ainsi la clé permettant aux entreprises de rester compétitives. LLM a un large éventail d'applications. Il peut être utilisé dans des domaines tels que le traitement du langage naturel, la génération de texte, la reconnaissance vocale et les systèmes de recommandation. En apprenant de grandes quantités de données, LLM est capable de générer du texte

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

L'ensemble de données ScienceAI Question Answering (QA) joue un rôle essentiel dans la promotion de la recherche sur le traitement du langage naturel (NLP). Des ensembles de données d'assurance qualité de haute qualité peuvent non seulement être utilisés pour affiner les modèles, mais également évaluer efficacement les capacités des grands modèles linguistiques (LLM), en particulier la capacité à comprendre et à raisonner sur les connaissances scientifiques. Bien qu’il existe actuellement de nombreux ensembles de données scientifiques d’assurance qualité couvrant la médecine, la chimie, la biologie et d’autres domaines, ces ensembles de données présentent encore certaines lacunes. Premièrement, le formulaire de données est relativement simple, et la plupart sont des questions à choix multiples. Elles sont faciles à évaluer, mais limitent la plage de sélection des réponses du modèle et ne peuvent pas tester pleinement la capacité du modèle à répondre aux questions scientifiques. En revanche, les questions et réponses ouvertes

Cinq écoles d'apprentissage automatique que vous ne connaissez pas

Jun 05, 2024 pm 08:51 PM

Cinq écoles d'apprentissage automatique que vous ne connaissez pas

Jun 05, 2024 pm 08:51 PM

L'apprentissage automatique est une branche importante de l'intelligence artificielle qui donne aux ordinateurs la possibilité d'apprendre à partir de données et d'améliorer leurs capacités sans être explicitement programmés. L'apprentissage automatique a un large éventail d'applications dans divers domaines, de la reconnaissance d'images et du traitement du langage naturel aux systèmes de recommandation et à la détection des fraudes, et il change notre façon de vivre. Il existe de nombreuses méthodes et théories différentes dans le domaine de l'apprentissage automatique, parmi lesquelles les cinq méthodes les plus influentes sont appelées les « Cinq écoles d'apprentissage automatique ». Les cinq grandes écoles sont l’école symbolique, l’école connexionniste, l’école évolutionniste, l’école bayésienne et l’école analogique. 1. Le symbolisme, également connu sous le nom de symbolisme, met l'accent sur l'utilisation de symboles pour le raisonnement logique et l'expression des connaissances. Cette école de pensée estime que l'apprentissage est un processus de déduction inversée, à travers les connaissances existantes.

Les performances de SOTA, la méthode d'IA de prédiction d'affinité protéine-ligand multimodale de Xiamen, combinent pour la première fois des informations sur la surface moléculaire

Jul 17, 2024 pm 06:37 PM

Les performances de SOTA, la méthode d'IA de prédiction d'affinité protéine-ligand multimodale de Xiamen, combinent pour la première fois des informations sur la surface moléculaire

Jul 17, 2024 pm 06:37 PM

Editeur | KX Dans le domaine de la recherche et du développement de médicaments, il est crucial de prédire avec précision et efficacité l'affinité de liaison des protéines et des ligands pour le criblage et l'optimisation des médicaments. Cependant, les études actuelles ne prennent pas en compte le rôle important des informations sur la surface moléculaire dans les interactions protéine-ligand. Sur cette base, des chercheurs de l'Université de Xiamen ont proposé un nouveau cadre d'extraction de caractéristiques multimodales (MFE), qui combine pour la première fois des informations sur la surface des protéines, la structure et la séquence 3D, et utilise un mécanisme d'attention croisée pour comparer différentes modalités. alignement. Les résultats expérimentaux démontrent que cette méthode atteint des performances de pointe dans la prédiction des affinités de liaison protéine-ligand. De plus, les études d’ablation démontrent l’efficacité et la nécessité des informations sur la surface des protéines et de l’alignement des caractéristiques multimodales dans ce cadre. Les recherches connexes commencent par "S