Périphériques technologiques

Périphériques technologiques

IA

IA

VideoMAE : un nouveau paradigme de pré-formation vidéo auto-supervisée simple et efficace

VideoMAE : un nouveau paradigme de pré-formation vidéo auto-supervisée simple et efficace

VideoMAE : un nouveau paradigme de pré-formation vidéo auto-supervisée simple et efficace

Lien papier : https://arxiv.org/abs/2203.12602

Le code et les poids de pré-entraînement ont été open source sur Github : https://github.com/MCG- NJU/VideoMAE

Contenu1. Introduction au contexte

2. Motivation de la recherche

3. Détails de la mise en œuvre de VideoMAE

5. Caractéristiques importantes de VideoMAE

7. . À la communauté Impact

9. Résumé

Introduction générale

Apprentissage auto-supervisé vidéo : sans utiliser les informations d'étiquette, apprenez les informations de représentation spatio-temporelle à partir de données vidéo en concevant des tâches d'agent auto-supervisées. Les algorithmes de pré-entraînement vidéo auto-supervisés existants sont principalement divisés en deux catégories : (1) Les méthodes auto-supervisées basées sur l'apprentissage contrastif, telles que CoCLR, CVRL, etc. (2) Méthodes auto-supervisées basées sur des tâches d'agent liées à des séries chronologiques, telles que DPC, SpeedNet, Pace, etc.

Reconnaissance d'action : classez la vidéo découpée donnée (Vidéo découpée) et identifiez les actions des personnages dans cette vidéo. Les méthodes courantes actuelles sont basées sur la 2D (TSN, TSM, TDN, etc.), la 3D (I3D, SlowFast, etc.) et la technologie Transformer (TimeSformer, ViViT, MViT, VideoSwin, etc.). En tant que tâche de base dans le domaine vidéo, la reconnaissance d'action est souvent utilisée comme réseau fédérateur (Backbone) pour diverses tâches en aval dans le domaine vidéo (telles que la détection de comportement temporel, la détection d'action spatio-temporelle) pour extraire des caractéristiques spatio-temporelles à l'ensemble du niveau vidéo ou au niveau du clip vidéo.

Détection d'action : cette tâche nécessite non seulement une classification des actions de la vidéo, en identifiant les actions des personnages dans la vidéo, mais également en marquant la position spatiale des personnages avec un cadre de délimitation dans la plage spatiale. La détection d'action a un large éventail de scénarios d'application dans l'analyse de vidéos de films, d'analyses de vidéos sportives et d'autres scénarios.

Motivation de la recherche

Depuis que le modèle d'auto-attention visuelle (Vision Transformer) a été proposé fin 2020, Transformer a été largement utilisé dans le domaine de la vision par ordinateur et a contribué à améliorer les performances d'une série de vision par ordinateur tâches.

Cependant, Vision Transformer doit utiliser des ensembles de données étiquetées à grande échelle pour la formation. Initialement, le ViT (Vanilla Vision Transformer) original a obtenu de bonnes performances grâce à un pré-entraînement supervisé utilisant des centaines de millions d'images étiquetées. Les transformateurs vidéo actuels sont généralement basés sur des modèles Vision Transformer formés sur des données d'image (tels que TimeSformer, ViViT, etc.) et s'appuient sur des modèles pré-entraînés de données d'image à grande échelle (tels que ImageNet-1K, ImageNet-21K, JFT- 300M, etc.). TimeSformer et ViViT ont tous deux essayé d'entraîner le modèle Video Transformer à partir de zéro dans l'ensemble de données vidéo, mais ils n'ont pas réussi à obtenir des résultats satisfaisants. Par conséquent, comment entraîner efficacement Video Transformer, en particulier le ViT original (Vanilla Vision Transformer), directement sur des ensembles de données vidéo sans utiliser d'autres modèles pré-entraînés ni de données d'image supplémentaires, reste un problème urgent à résoudre. Il convient de noter que les ensembles de données vidéo existants sont relativement petits par rapport aux ensembles de données d'images. Par exemple, l'ensemble de données Kinectics-400, largement utilisé, ne contient que plus de 200 000 échantillons d'apprentissage. Le nombre d'échantillons est d'environ 1/50 de l'ensemble de données ImageNet-21K et 1/1 500 de l'ensemble de données JFT-300M. écart de plusieurs ordres de grandeur. Dans le même temps, par rapport à la formation d’un modèle d’image, la charge de calcul liée à la formation d’un modèle vidéo est également beaucoup plus élevée. Cela augmente encore la difficulté de former Video Transformer sur des ensembles de données vidéo.

Récemment, le paradigme de formation auto-supervisée de « masquage et reconstruction » a connu du succès dans le traitement du langage naturel (BERT) et la compréhension d'images (BEiT, MAE). Par conséquent, nous essayons d'utiliser ce paradigme auto-supervisé pour entraîner Video Transformer sur des ensembles de données vidéo, et proposons un algorithme de pré-entraînement vidéo auto-supervisé VideoMAE (Video Masked Autoencoder). Le modèle ViT pré-entraîné par VideoMAE peut obtenir des résultats nettement meilleurs que d'autres méthodes sur des ensembles de données vidéo plus volumineux tels que Kinetics-400 et Something-Something V2, ainsi que sur des ensembles de données vidéo relativement petits tels que UCF101 et HMDB51.

Introduction à la méthode

Aperçu de MAE

MAE adopte une architecture codeur-décodeur asymétrique pour effectuer des tâches de pré-formation auto-supervisées de masquage et de reconstruction. Une image d'entrée de résolution 224 x 224 est d'abord divisée en blocs de pixels visuels (jetons) ne se chevauchant pas de taille 16 × 16. Chaque bloc de pixels (jeton) est converti en une caractéristique de haute dimension via une opération d'intégration de bloc (intégration de jeton). MAE utilise un rapport de masque plus élevé (75 %) pour masquer de manière aléatoire certains blocs de pixels (jetons). Après l'opération de masquage, les blocs de pixels restants sont envoyés à l'encodeur pour l'extraction des caractéristiques. Immédiatement après, les blocs de fonctionnalités extraits par l'encodeur sont assemblés avec une autre partie de blocs de pixels apprenables prédéfinis (jetons apprenables) pour former des fonctionnalités aussi grandes que la taille de l'image d'entrée d'origine. Enfin, un décodeur léger est utilisé pour reconstruire l'image originale sur la base de ces caractéristiques (dans le processus expérimental réel, la cible de reconstruction est le bloc de pixels normalisé (jeton normalisé).

Données vidéo Caractéristiques

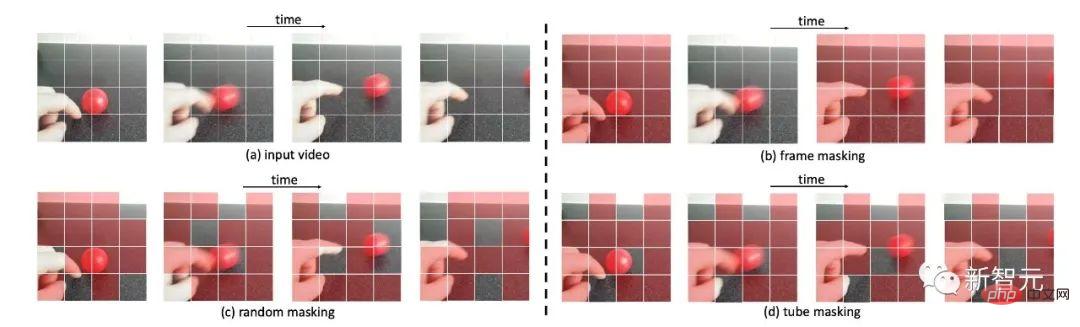

Par rapport à l'image données, les données vidéo contiennent plus d'images et contiennent des informations de mouvement plus riches. Cette section analysera d'abord les caractéristiques des données vidéo. Exemples de différentes stratégies de masquage pour les données

Redondance temporelle

Redondance temporelle

Les données vidéo contiennent des images d'image denses et la sémantique. les informations contenues dans ces images changent très lentement au fil du temps. On peut voir que la continuité dense dans la vidéo est hautement redondante, comme le montre la figure. Cette redondance peut poser deux problèmes dans le processus de mise en œuvre du MAE. Premièrement, si la fréquence d'images dense de la vidéo originale (telle que 30 FPS) est utilisée pour la pré-formation, l'efficacité de la formation sera très faible, car ce paramètre incitera le réseau à accorder plus d'attention aux fonctionnalités d'apparence statique. les données ou certaines caractéristiques de mouvement locales qui changent lentement. Deuxièmement, la redondance temporelle dans la vidéo diluera considérablement les caractéristiques de mouvement de la vidéo. Par conséquent, cette situation rend la tâche de reconstruction des blocs de pixels masqués relativement simple à des taux de masquage normaux (par exemple 50). % à 75 %). Ces problèmes affectent Backbone en tant qu'encodeur. Les fonctionnalités de mouvement sont extraites lors du processus de pré-entraînement

Corrélation temporelleLa vidéo peut être considérée comme générée par l'évolution des images statiques au fil du temps. il existe donc également une correspondance sémantique entre les images vidéo. Sans stratégie de masquage ciblée, cette corrélation temporelle peut augmenter le risque de « fuite d'informations » lors du processus de reconstruction. Concrètement, comme le montre la figure, s'il s'agit d'un masque aléatoire global ou aléatoire. Une trame d'image de masque est utilisée. Le réseau peut utiliser la corrélation temporelle dans la vidéo pour effectuer une reconstruction de blocs de pixels en « copiant et collant » les blocs de pixels non occultés aux positions temporelles correspondantes dans des images adjacentes. Dans ce cas, la tâche proxy peut également être effectuée. terminé dans une certaine mesure, mais cela est possible. Cela amènera VideoMAE à apprendre uniquement les caractéristiques de correspondance temporelle sémantique inférieure, plutôt que les informations sémantiques abstraites de haut niveau, telles que les capacités de raisonnement spatio-temporel pour le contenu vidéo. une nouvelle stratégie de masquage doit être conçue. La tâche de reconstruction est plus difficile, afin que le réseau puisse mieux apprendre la représentation des caractéristiques spatio-temporelles dans la vidéo

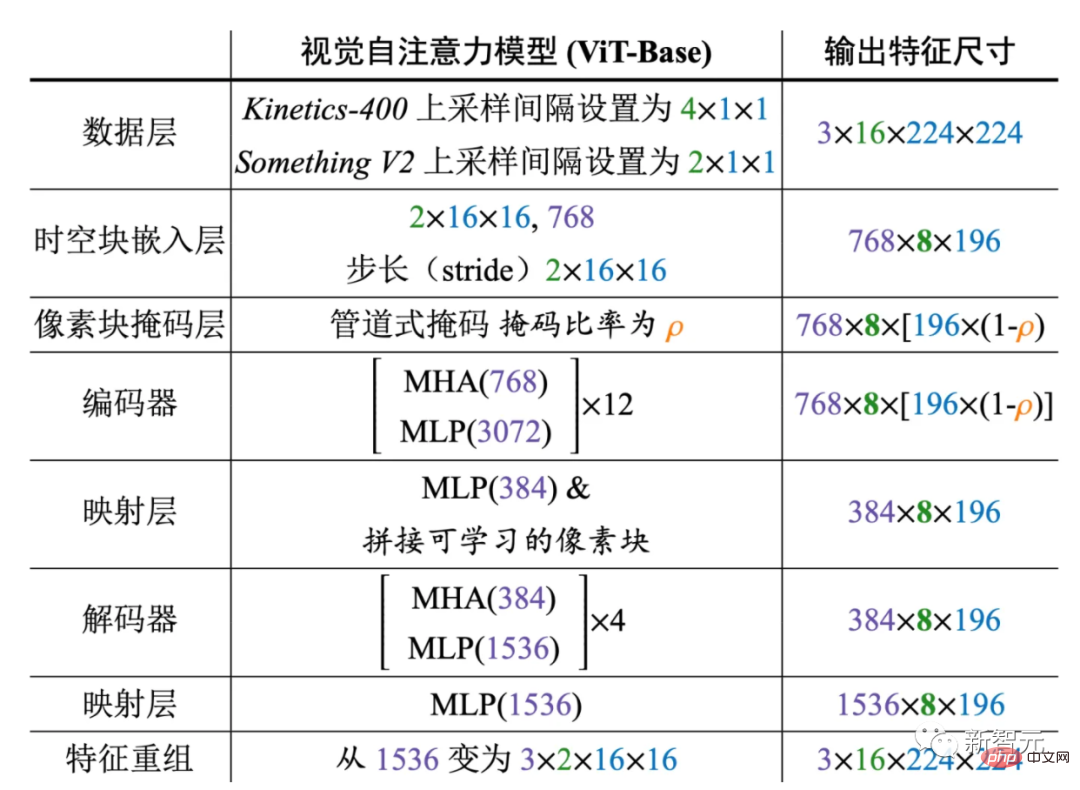

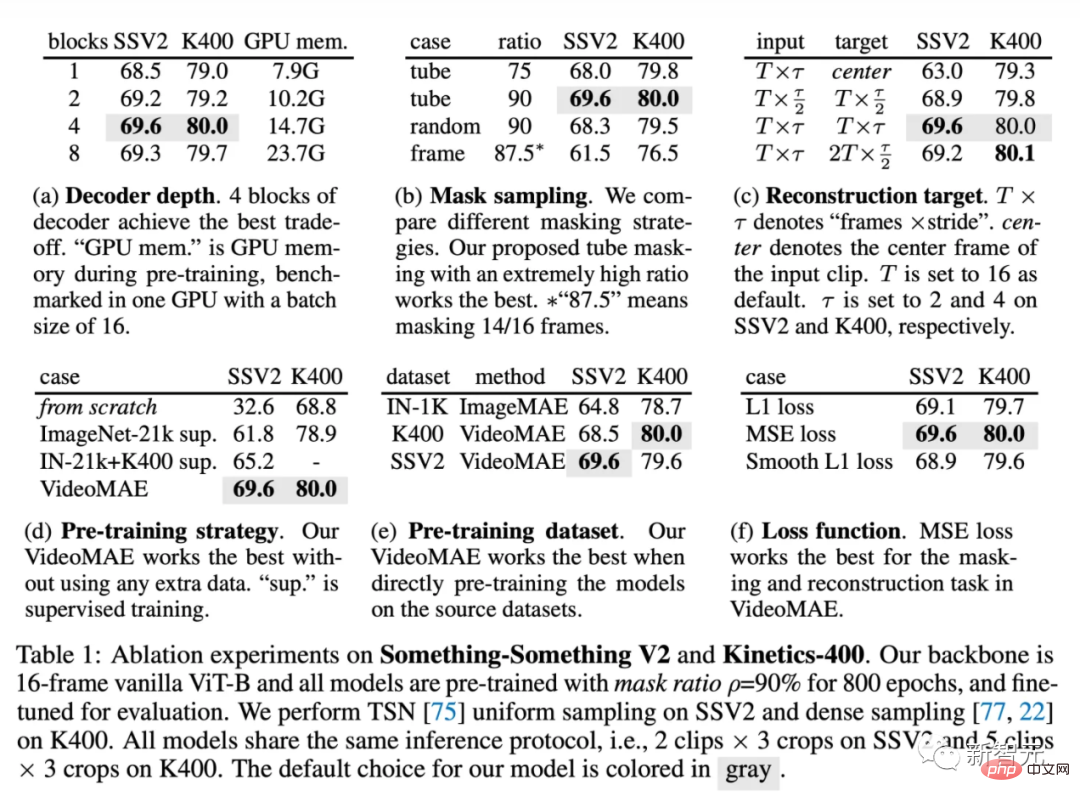

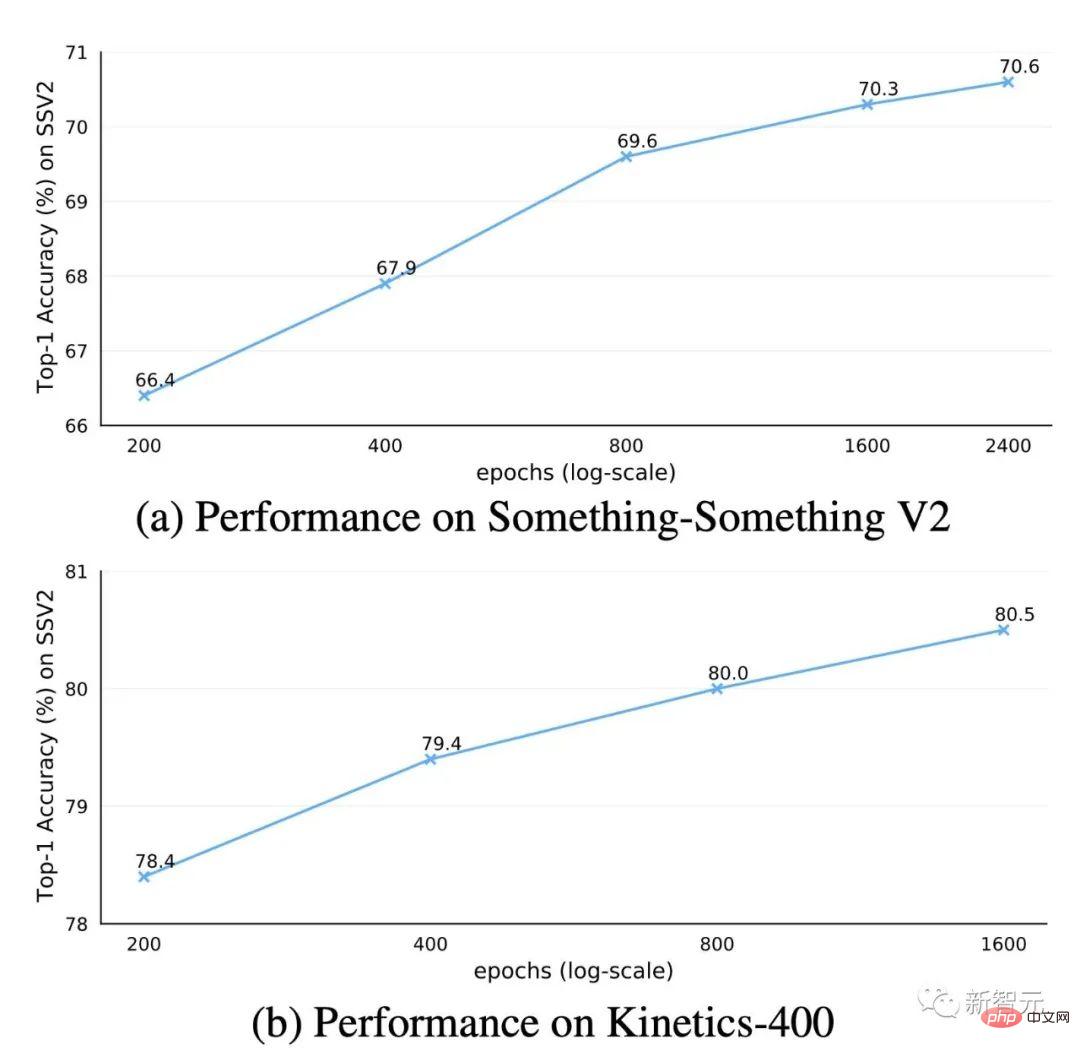

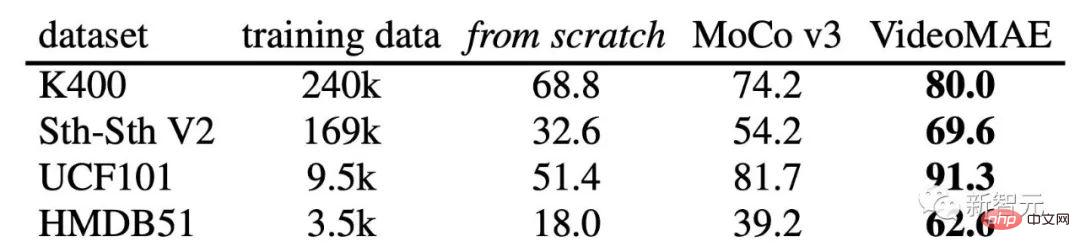

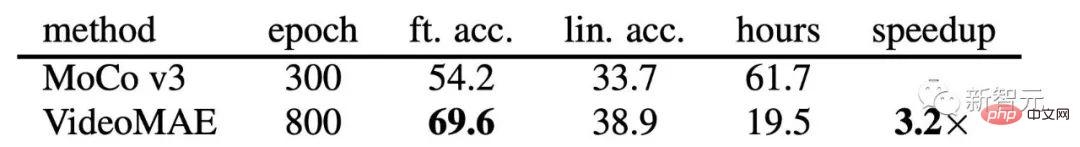

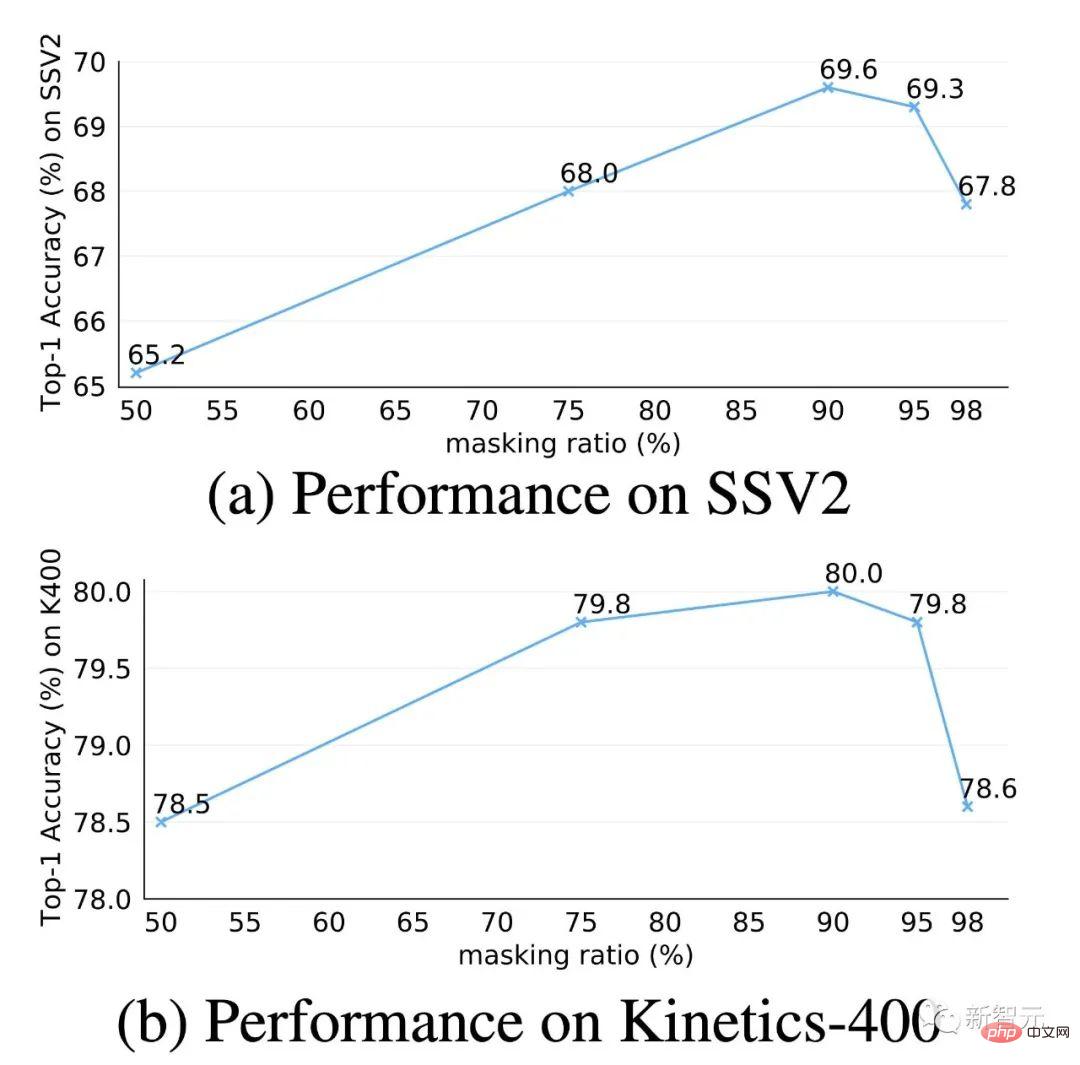

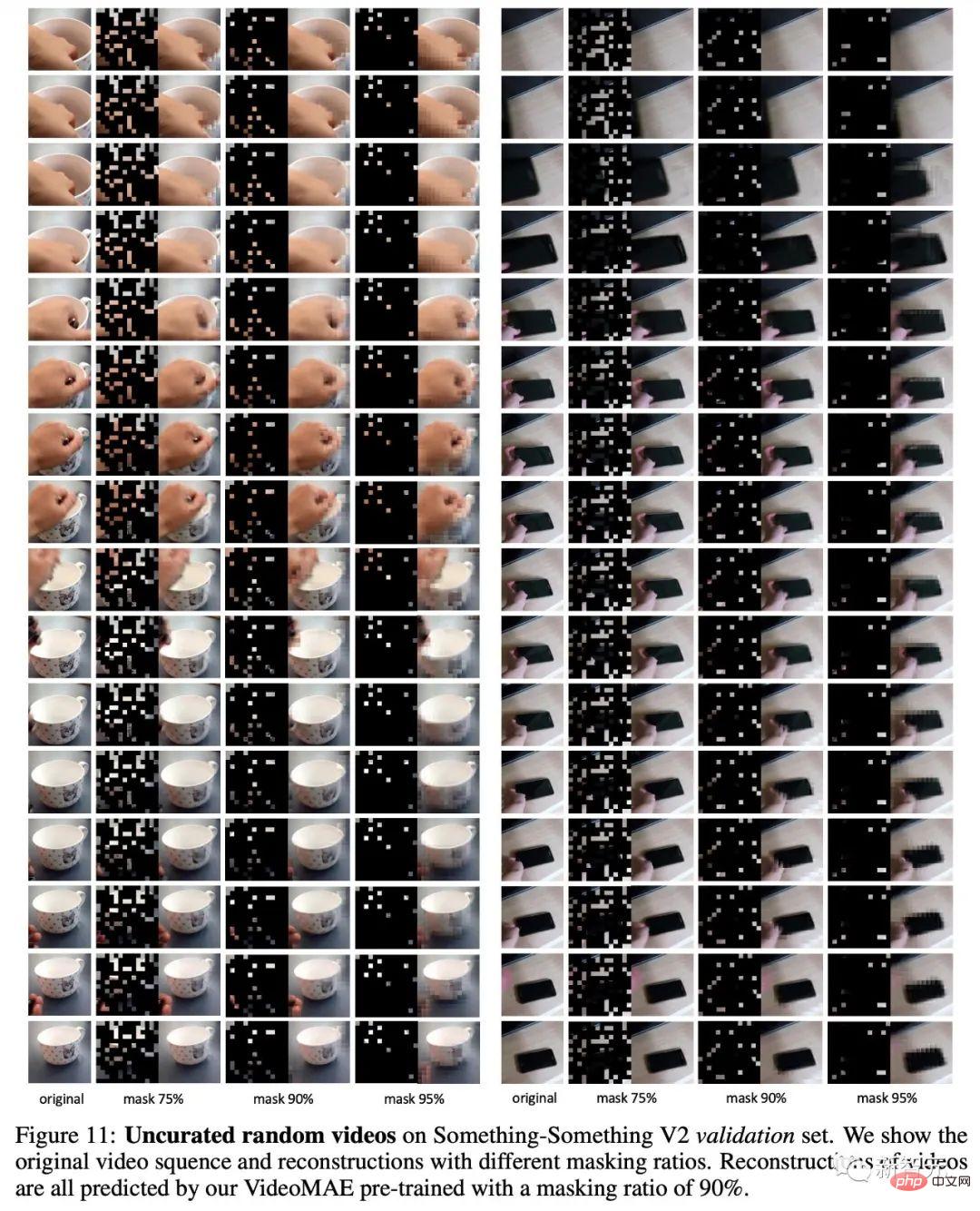

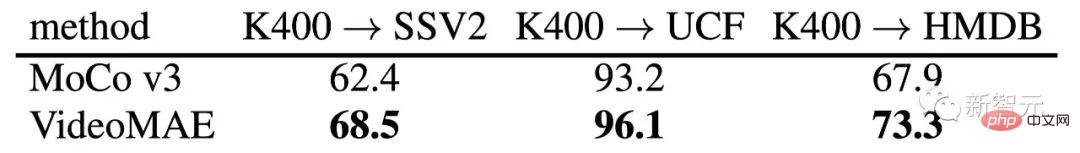

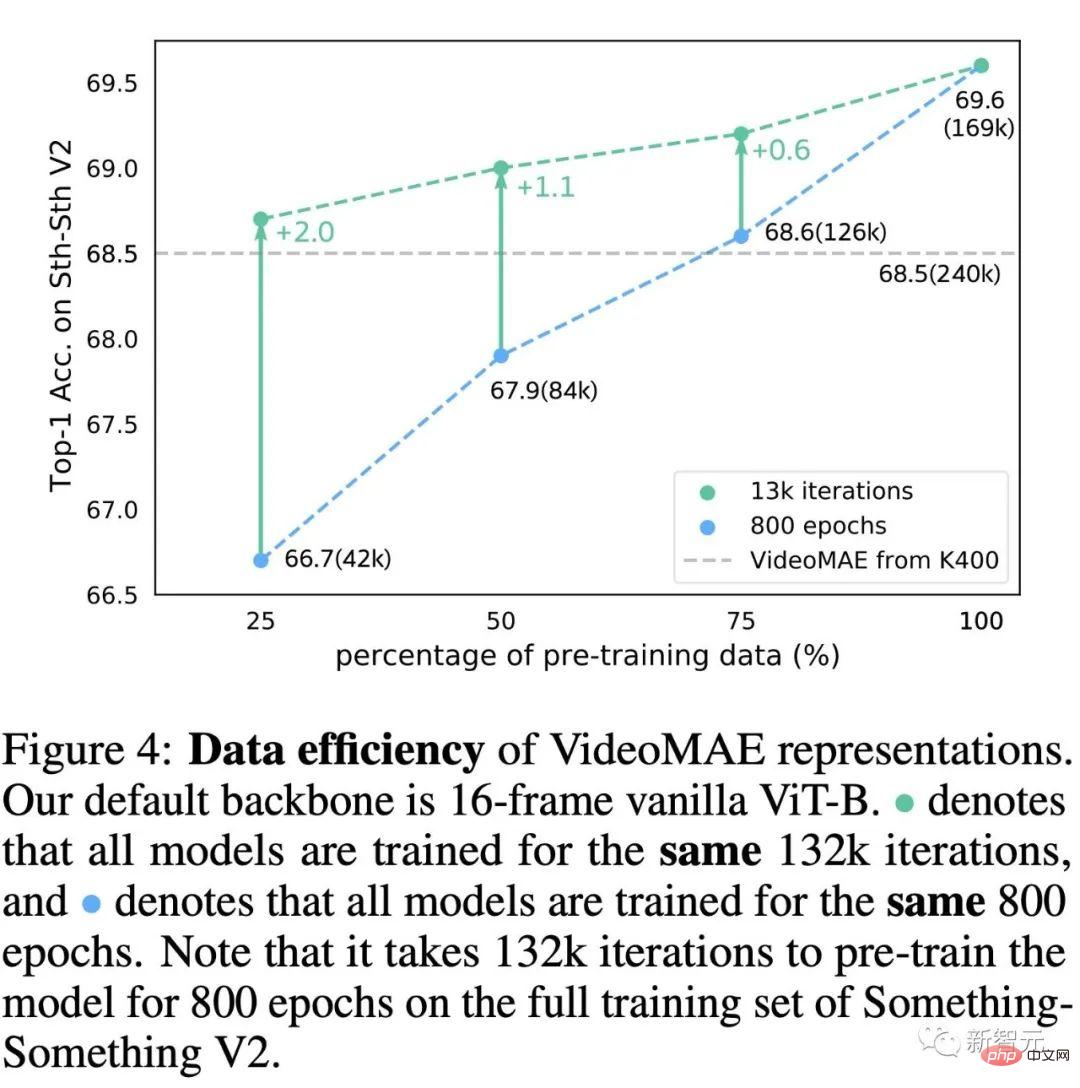

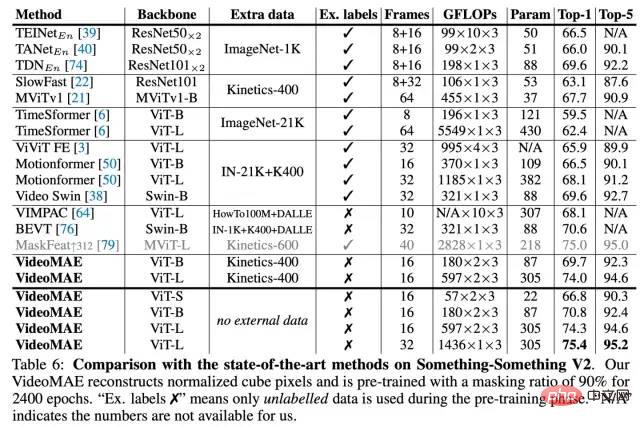

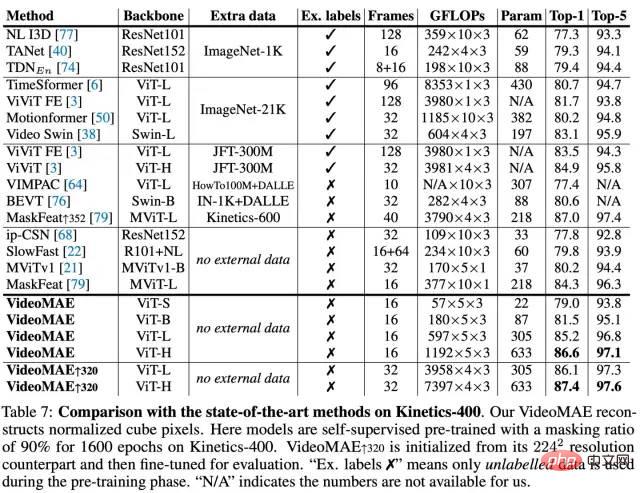

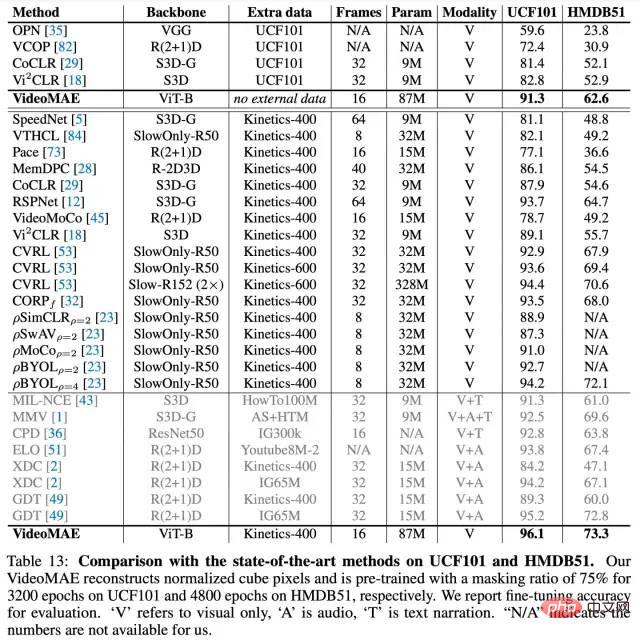

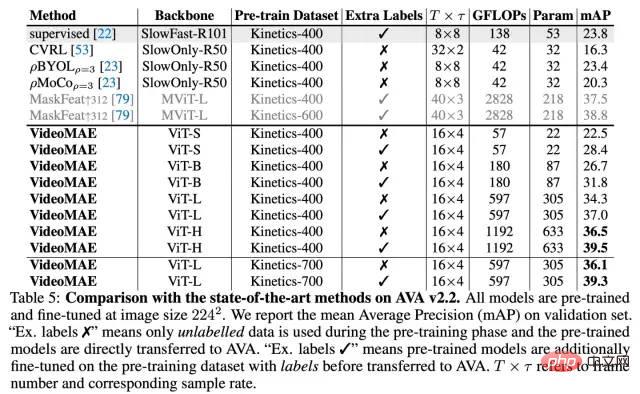

Introduction à la méthode VideoMAE

Le cadre général. de VideoMAE

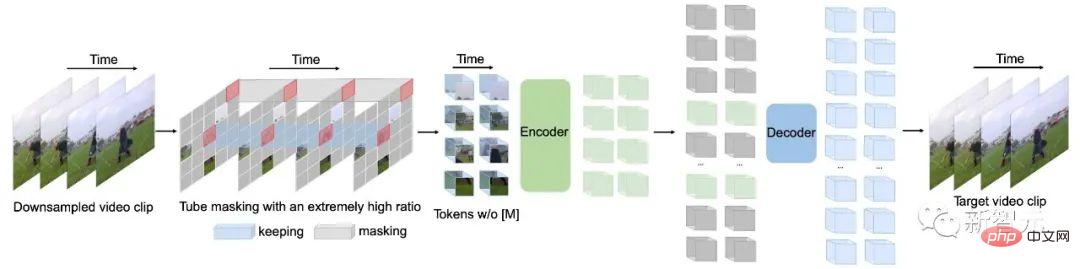

. Selon l'analyse précédente de la redondance temporelle existant dans les images continues denses dans les vidéos, nous avons choisi d'adopter une stratégie d'échantillonnage avec des intervalles temporels dans VideoMAE pour un train de prédiction vidéo auto-supervisé plus efficace. Plus précisément, un segment vidéo constitué de $t$ images consécutives est d'abord échantillonné de manière aléatoire à partir de la vidéo originale. Les clips vidéo sont ensuite compressés en images à l'aide d'un échantillonnage espacé temporellement, chacune contenant Avant d'être entrées dans l'encodeur, les clips vidéo échantillonnés sont des blocs de pixels intégrés sous la forme d'une articulation spatio-temporelle. Plus précisément, les pixels visuels de taille Afin de résoudre le problème de « fuite d'informations » causé par la redondance temporelle et la corrélation temporelle dans les données vidéo, cette méthode choisit d'utiliser une stratégie de masquage de pipeline dans le cadre supervisé. processus de pré-formation. La stratégie de masquage de pipeline peut naturellement étendre la méthode de masquage d'une image couleur à image unique à l'ensemble de la séquence vidéo, c'est-à-dire que les blocs de pixels visuels situés au même emplacement spatial dans différentes images seront masqués. Plus précisément, la stratégie de masquage du pipeline peut être exprimée par . Des moments différents partagent la même valeur. En utilisant cette stratégie de masquage, les jetons situés au même emplacement spatial seront toujours masqués. Ainsi, pour certains patchs de pixels visuels (par exemple, le patch de pixels contenant le doigt dans la ligne 4 de l'exemple d'image de différentes stratégies de masquage), le réseau ne pourra pas trouver sa partie correspondante dans d'autres trames. Cette conception permet d'atténuer le risque de « fuite d'informations » pendant le processus de reconstruction, permettant à VideoMAE de reconstruire le jeton masqué en extrayant des informations sémantiques de haut niveau du clip vidéo original. Par rapport aux données d'image, les données vidéo ont une redondance plus forte et la densité d'informations des données vidéo est bien inférieure à celle des images. Cette fonctionnalité permet à VideoMAE d'utiliser des taux de masque extrêmement élevés (par exemple 90 % à 95 %) pour la pré-entraînement. Il est à noter que le taux de masque par défaut du MAE est de 75 %. Les résultats expérimentaux montrent que l'utilisation d'un taux de masque extrêmement élevé peut non seulement accélérer le pré-entraînement (seulement 5 à 10 % des blocs de pixels visuels sont entrés dans l'encodeur), mais également améliorer la capacité de représentation du modèle et l'effet en aval. tâches . Comme mentionné dans l'article précédent, VideoMAE utilise un taux de masquage extrêmement élevé et ne conserve qu'un très petit nombre de jetons en entrée de l'encodeur. Afin de mieux extraire les caractéristiques spatio-temporelles de cette partie du jeton non occulté, VideoMAE a choisi d'utiliser le ViT d'origine comme épine dorsale, et en même temps d'utiliser l'auto-attention conjointe spatio-temporelle dans la couche d'attention (c'est-à-dire la structure du modèle de le ViT d'origine n'a pas été modifié). Par conséquent, tous les jetons non occultés peuvent interagir les uns avec les autres dans la couche d’auto-attention. La complexité informatique au niveau Détails de conception spécifiques du framework VideoMAE La figure ci-dessus montre la conception architecturale spécifique de l'encodeur et du décodeur utilisés par VideoMAE (en prenant ViT-B comme exemple) . Nous évaluons VideoMAE sur quatre ensembles de données de reconnaissance d'actions vidéo en aval et un ensemble de données de détection d'actions. Ces ensembles de données se concentrent sur différents aspects des informations de mouvement dans les vidéos. Kinetics-400 est un ensemble de données vidéo YouTube à grande échelle contenant environ 300 000 clips vidéo recadrés couvrant 400 catégories d'actions différentes. L'ensemble de données Kinetics-400 contient principalement des activités de la vie quotidienne et certaines catégories sont fortement corrélées à des objets interactifs ou à des informations sur la scène. Les vidéos de l'ensemble de données Something-Something V2 contiennent principalement différents objets effectuant les mêmes actions, de sorte que la reconnaissance des actions dans cet ensemble de données se concentre davantage sur les attributs de mouvement plutôt que sur les informations sur les objets ou les scènes. L'ensemble de formation contient environ 170 000 clips vidéo et l'ensemble de validation contient environ 25 000 clips vidéo. UCF101 et HMDB51 sont deux ensembles de données de reconnaissance d'actions vidéo relativement petits. L’ensemble de formation de l’UCF101 contient environ 9 500 vidéos et l’ensemble de formation de HMDB51 contient environ 3 500 vidéos. Au cours de l'expérience, nous avons d'abord utilisé VideoMAE pour effectuer un pré-entraînement auto-supervisé sur le réseau sur l'ensemble de formation, puis effectué un réglage fin supervisé de l'encodeur (ViT) sur l'ensemble de formation, et enfin évalué les performances du modèle sur l'ensemble de validation. Pour l'ensemble de données de détection d'action AVA, nous allons d'abord charger le modèle formé sur l'ensemble de données Kinetics-400 et effectuer un réglage fin supervisé de l'encodeur (ViT). Cette section mène des expériences d'ablation sur VideoMAE sur les ensembles de données Something-Something V2 et Kinetics-400. L'expérience d'ablation utilise le modèle ViT original avec 16 images d'entrée par défaut. Dans le même temps, lors de l'évaluation après réglage fin, 2 clips vidéo et 3 cultures ont été sélectionnés pour être testés sur Something-Something V2, et 5 clips vidéo et 3 cultures ont été sélectionnés pour être testés sur Kinetics-400. Le décodeur léger est un élément clé de VideoMAE. Les résultats expérimentaux utilisant des décodeurs de différentes profondeurs sont présentés dans le tableau (a). Contrairement à MAE, les décodeurs plus profonds de VideoMAE peuvent obtenir de meilleures performances, tandis que les décodeurs moins profonds peuvent réduire efficacement l'utilisation de la mémoire GPU. Le nombre de couches de décodeur est fixé à 4 par défaut. Suivant la conception empirique de MAE, la largeur de canal du décodeur dans VideoMAE est définie sur la moitié de la largeur de canal de l'encodeur (par exemple, lorsque ViT-B est utilisé comme encodeur, la largeur de canal du décodeur est définie sur 384). ). Comparez différentes stratégies de masquage avec la stratégie de masquage en pipeline en utilisant un taux de masquage de 75 %. Comme le montre le tableau (b), les performances du masquage aléatoire global et des trames d'image de masquage aléatoire sont pires que celles de la stratégie de masquage pipeline. Cela peut être dû au fait que la stratégie de masquage de pipeline peut atténuer dans une certaine mesure la redondance temporelle et la corrélation temporelle dans les données vidéo. Si le rapport de masque est augmenté à 90 %, les performances de VideoMAE sur Something-Something peuvent être encore améliorées de 68,0 % à 69,6 %. La conception de la stratégie de masque et du rapport de masque dans VideoMAE peut faire du masquage et de la reconstruction une tâche proxy plus difficile, obligeant le modèle à apprendre des caractéristiques spatio-temporelles de niveau supérieur. La cible de reconstruction dans VideoMAE est comparée ici et les résultats sont dans le tableau (c). Premièrement, les performances de VideoMAE dans les tâches en aval seront considérablement réduites si seule l'image centrale du clip vidéo est utilisée comme cible de reconstruction. Dans le même temps, VideoMAE est également très sensible à l'intervalle d'échantillonnage. Si vous choisissez de reconstruire un clip vidéo plus dense, les résultats seront nettement inférieurs à ceux du clip vidéo sous-échantillonné temporellement par défaut. Enfin, nous avons également essayé de reconstruire les images les plus denses du clip vidéo à partir du clip vidéo temporellement sous-échantillonné, mais ce paramètre nécessitera de décoder plus d'images, ce qui rendra l'entraînement plus lent et peu efficace. Les stratégies de pré-entraînement dans VideoMAE sont comparées ici et les résultats sont présentés dans le tableau (d). Semblable aux conclusions expérimentales des méthodes précédentes (TimeSformer, ViViT), la formation de ViT à partir de zéro sur Something-Something V2, un ensemble de données plus sensible aux informations de mouvement, ne permet pas d'obtenir des résultats satisfaisants. Si le modèle ViT pré-entraîné sur l'ensemble de données d'images à grande échelle (ImageNet-21K) est utilisé comme initialisation, une meilleure précision peut être obtenue, qui peut être améliorée de 32,6 % à 61,8 %. L'utilisation de modèles pré-entraînés sur ImageNet-21K et Kinetics-400 a encore amélioré la précision à 65,2 %. ViT, qui est pré-entraîné à partir de l'ensemble de données vidéo lui-même à l'aide de VideoMAE, peut finalement atteindre les meilleures performances de 69,6 % sans utiliser de données supplémentaires. Des conclusions similaires ont été tirées sur Kinetics-400. L'ensemble de données de pré-entraînement dans VideoMAE est comparé ici et les résultats sont présentés dans le tableau (e). Premièrement, selon les paramètres de MAE, ViT est pré-entraîné auto-supervisé sur ImageNet-1K pendant 1600 époques. La couche d'intégration de blocs 2D est ensuite gonflée en une couche d'intégration de blocs spatio-temporels 3D à l'aide de stratégies dans I3D, et le modèle est affiné sur l'ensemble de données vidéo. Ce paradigme de formation peut surpasser les modèles formés supervisés à partir de zéro. Ensuite, les performances du modèle pré-entraîné MAE ont été comparées à celles du modèle ViT pré-entraîné par VideoMAE sur Kinetics-400. On peut constater que VideoMAE peut atteindre de meilleures performances que MAE. Cependant, les deux modèles pré-entraînés n'ont pas réussi à obtenir de meilleures performances que VideoMAE, qui n'était qu'un pré-entraînement auto-supervisé sur l'ensemble de données Something-Something V2. On peut analyser que la différence de domaine entre l'ensemble de données de pré-formation et l'ensemble de données cible peut être un problème important. L'impact du total des tours de pré-entraînement dans VideoMAE Dans les expériences d'ablation, le nombre total de tours de pré-entraînement VideoMAE est défini sur 800 par défaut . Nous tentons de mener une exploration approfondie des époques de pré-formation sur les ensembles de données Kinetics-400 et Something-Something V2. Selon les résultats de la figure, l'utilisation de périodes de pré-entraînement plus longues conduit à des gains cohérents sur les deux ensembles de données. Comparaison des performances de VideoMAE et MoCov3 sur différents ensembles de données de reconnaissance d'action vidéo en aval De nombreux travaux antérieurs ont mené des recherches approfondies sur la pré-formation vidéo auto-supervisée, mais ces méthodes utilisent principalement des réseaux de neurones convolutifs comme Backbone, et il existe peu de méthodes pour étudier le mécanisme de formation basé sur ViT. Par conséquent, pour vérifier l'efficacité de VideoMAE basé sur ViT pour la pré-formation vidéo auto-supervisée, nous avons comparé deux méthodes de formation basées sur ViT : (1) formation supervisée du modèle à partir de zéro, (2) en utilisant une méthode d'apprentissage contrastive (MoCo v3) Effectuer une pré-formation auto-supervisée. D'après les résultats expérimentaux, on peut constater que VideoMAE est nettement meilleure que les deux autres méthodes de formation. Par exemple, sur l'ensemble de données Kinetics-400, qui possède la plus grande taille de données, VideoMAE est environ 10 % plus précis que l'entraînement à partir de zéro et environ 6 % plus élevé que les résultats de la pré-entraînement MoCo v3. Les excellentes performances de VideoMAE montrent que le paradigme auto-supervisé de masquage et de reconstruction fournit un mécanisme de pré-entraînement efficace pour ViT. Dans le même temps, il convient de noter qu'à mesure que l'ensemble de formation devient plus petit, l'écart de performances entre VideoMAE et les deux autres méthodes de formation devient de plus en plus grand. Il convient de noter que même si l'ensemble de données HMDB51 ne contient qu'environ 3 500 clips vidéo, le modèle pré-entraîné basé sur VideoMAE peut toujours atteindre une précision très satisfaisante. Ce nouveau résultat démontre que VideoMAE est un apprenant efficace en matière de données. Ceci est différent de l’apprentissage contrastif, qui nécessite une grande quantité de données pour la pré-formation. Les fonctionnalités efficaces en matière de données de VideoMAE sont particulièrement importantes dans les scénarios où les données vidéo sont limitées. Analyse de l'efficacité de VideoMAE et MoCov3 sur l'ensemble de données Something-SomethingV2 Nous avons également comparé l'efficacité informatique de l'utilisation de VideoMAE pour la pré-formation et de l'utilisation de MoCo v3 pour la pré-formation. En raison de la tâche proxy extrêmement difficile de masquage et de reconstruction, le réseau ne peut observer que 10 % des données d'entrée (90 % des jetons sont masqués) à chaque itération, donc VideoMAE nécessite davantage de cycles de formation. Une très forte proportion de jetons est masquée. Cette conception permet d'économiser considérablement la consommation de calcul et le temps de pré-formation. La pré-formation VideoMAE pour 800 tours ne prend que 19,5 heures, tandis que la pré-formation MoCo v3 pour 300 tours prend 61,7 heures. L'impact du taux de masquage dans VideoMAE Le taux de masquage extrêmement élevé est l'une des conceptions principales de VideoMAE. Nous effectuons une exploration approfondie de cette conception sur les ensembles de données Kinetics-400 et Something-Something V2. Selon les résultats de la figure, lorsque le taux de masque est très élevé, même 95 %, le réseau affiche toujours d'excellentes performances sur ces deux ensembles de données importants pour les tâches de reconnaissance d'actions vidéo en aval. Ce phénomène est extrêmement différent du BERT pour le traitement du langage naturel et du MAE pour les images. L'existence d'une redondance temporelle et d'une corrélation temporelle dans les données vidéo permet à VideoMAE de fonctionner avec des taux de masque extrêmement élevés par rapport aux données d'image et au langage naturel. Nous visualisons également l'exemple de reconstruction du VideoMAE pré-entraîné. La figure montre que VideoMAE peut produire des résultats de reconstruction satisfaisants même à des taux de masquage extrêmement élevés. Cela signifie que VideoMAE peut apprendre et extraire des caractéristiques spatio-temporelles dans les vidéos. Comparaison des performances des capacités de transfert de fonctionnalités entre VideoMAE et MoCov3 sur des ensembles de données plus petits Afin d'étudier plus en profondeur les fonctionnalités apprises par VideoMAE, cette section évalue les capacités de généralisation et de transfert de VideoMAE pré-entraîné. Le tableau ci-dessus montre l'effet de transfert de VideoMAE pré-entraîné sur l'ensemble de données Kinetics-400 vers les ensembles de données Something-Something V2, UCF101 et HMDB51. Dans le même temps, le tableau montre également la capacité de migration du modèle pré-entraîné à l'aide de MoCo v3. D'après les résultats du tableau, les capacités de transfert et de généralisation du modèle pré-entraîné à l'aide de VideoMAE sont meilleures que celles du modèle pré-entraîné basé sur MoCo v3. Cela montre que VideoMAE peut apprendre des représentations de fonctionnalités plus transférables. VideoMAE pré-entraîné sur l'ensemble de données Kinetics-400 fonctionne mieux que VideoMAE pré-entraîné directement sur les ensembles de données UCF101 et HMDB51. Mais le modèle pré-entraîné sur l'ensemble de données Kinetics-400 se transfère mal sur l'ensemble de données Something-Something V2. Pour explorer davantage les raisons de cette incohérence, nous avons mené des expériences sur la réduction du nombre de vidéos de pré-formation sur l'ensemble de données Something-Something V2. Le processus d'exploration comprend deux expériences : (1) utiliser le même nombre de cycles d'entraînement (époque) pour le pré-entraînement, (2) utiliser le même nombre d'itérations (itération) pour le pré-entraînement. D'après les résultats de la figure, nous pouvons constater qu'en réduisant le nombre d'échantillons de pré-entraînement, l'utilisation de davantage d'itérations d'entraînement peut également améliorer les performances du modèle. Même si seulement 42 000 vidéos pré-entraînées sont utilisées, VideoMAE entraîné directement sur l'ensemble de données Something-Something V2 peut toujours atteindre une meilleure précision (68,7) que l'ensemble de données pré-entraîné Kinetics-400 utilisant 240 000 % de données vidéo contre 68,5 %). Cette découverte signifie que les différences de domaine sont un autre facteur important auquel il faut prêter attention lors de la pré-formation vidéo auto-supervisée. Lorsqu'il existe des différences de domaine entre l'ensemble de données de pré-formation et l'ensemble de données cible, la qualité des données de pré-formation est plus importante. que la quantité de données. Dans le même temps, cette découverte vérifie également indirectement que VideoMAE est un apprenant économe en données pour la pré-formation vidéo auto-supervisée. Résultats expérimentaux de l'ensemble de données Something-Something V2 Résultats expérimentaux de l'ensemble de données Kinetics-400 Ensembles de données UCF101 et HMDB51 Résultats expérimentaux Sans utiliser de données supplémentaires, la précision Top-1 de VideoMAE sur Something-Something V2 et Kinetics-400 a atteint respectivement 75,4 % et 87,4 %. Il convient de noter que les méthodes de pointe actuelles sur l'ensemble de données Something-Something V2 s'appuient fortement sur des modèles pré-entraînés sur des ensembles de données externes pour l'initialisation. En revanche, VideoMAE est capable de surpasser considérablement la meilleure méthode précédente d'environ 5 % en termes de précision sans utiliser de données externes. VideoMAE peut également atteindre d'excellentes performances sur l'ensemble de données Kinetics-400. Dans le cas de données vidéo limitées (par exemple, l'ensemble de données UCF101 ne contient que moins de 10 000 vidéos de formation et HMDB51 ne contient qu'environ 3 500 vidéos de formation), VideoMAE n'a pas besoin d'utiliser de données d'image et vidéo supplémentaires et peut également être utilisé dans ces méthodes surpassent de loin les meilleures méthodes précédentes sur les ensembles de données vidéo à petite échelle. Résultats expérimentaux de l'ensemble de données AVA v2.2 En plus de la tâche traditionnelle de classification des actions, nous avons en outre vérifié la capacité de représentation du modèle VideoMAE sur la tâche de compréhension plus sophistiquée de la détection d'actions vidéo. Nous avons sélectionné l'ensemble de données AVA v2.2 pour les expériences. Dans l'expérience, le modèle pré-entraîné sur l'ensemble de données Kinetics-400 sera d'abord chargé, puis ViT sera affiné de manière supervisée. Le tableau montre que le modèle ViT pré-entraîné par VideoMAE peut obtenir de très bons résultats sur l'ensemble de données AVA v2.2. Si le modèle ViT pré-entraîné auto-supervisé est ensuite affiné sur Kinetics-400, il peut mieux fonctionner sur la tâche de détection d'action (amélioration de 3 mAP-6mAP). Cela montre également que les performances du modèle pré-entraîné auto-supervisé VideoMAE peuvent être encore améliorées en effectuant un réglage fin supervisé sur l'ensemble de données en amont, puis en migrant vers des tâches en aval. Nous avons open source le modèle et le code de VideoMAE en avril de cette année et avons reçu une attention et une reconnaissance continues de la part de la communauté. Selon la liste Paper with Code, VideoMAE occupe la première place des listes Something-Something V2[1] et AVA 2.2[2] depuis six mois (de fin mars 2022 au présent). Sans utiliser de données externes, les résultats de VideoMAE sur les ensembles de données Kinetics-400[3], UCF101[4] et HMDB51[5] sont également les meilleurs à ce jour. https://huggingface.co/docs/transformers/main/en/model_doc/videomae Il y a quelques mois, le modèle de VideoMAE a été inclus dans l'entrepôt officiel des Transformers de Hugging Face. C'est le premier modèle de compréhension vidéo inclus dans ce référentiel ! Dans une certaine mesure, cela reflète aussi la reconnaissance de la communauté envers notre travail ! Nous espérons que notre travail pourra fournir une méthode de base simple et efficace pour la pré-formation vidéo basée sur Transformer, et également inspirer les méthodes ultérieures de compréhension vidéo basées sur Transformer. https://github.com/open-mmlab/mmaction2/tree/dev-1.x/configs/recognition/videomae L'entrepôt de compréhension vidéo actuel MMAction2 prend également en charge l'inférence du modèle VideoMAE . Lors du 2ème atelier international ECCV 2022 qui vient de se terminer, VideoMAE est rapidement devenu un outil pour aider tout le monde à jouer au jeu. Le laboratoire d'intelligence artificielle de Shanghai a remporté des championnats dans plusieurs sous-pistes de ce défi Ego4D. Parmi eux, VideoMAE constitue une épine dorsale importante, fournissant de puissantes fonctionnalités vidéo pour leur solution. Il convient de noter que d'après la première image ci-dessus, on peut constater que l'effet de VideoMAE (ViT-L) pré-entraîné uniquement sur Kinetics-400 peut déjà surpasser celui de l'ensemble de données vidéo IG-65M (environ Kinetics-400 échantillonner des données 300 fois) sur un ir-CSN-152 pré-entraîné. Cela vérifie également la puissante capacité de représentation du modèle pré-entraîné VideoMAE. Les principales contributions de notre travail incluent les trois aspects suivants : • Nous sommes les premiers à proposer VideoMAE, un cadre de pré-formation vidéo auto-supervisé basé sur le masquage et la reconstruction ViT. Même avec un pré-entraînement auto-supervisé sur des ensembles de données vidéo à plus petite échelle, VideoMAE peut toujours atteindre de très bonnes performances. Afin de résoudre le problème de « fuite d'informations » causé par la redondance temporelle et la corrélation temporelle, nous proposons un masquage de tube avec un taux de masquage extrêmement élevé. Les expériences montrent que cette conception est la clé de la capacité ultime de VideoMAE à réaliser des effets SOTA. Dans le même temps, grâce à l'architecture d'encodeur-décodeur asymétrique de VideoMAE, la consommation de calcul du processus de pré-formation est considérablement réduite, ce qui permet de gagner considérablement du temps dans le processus de pré-formation. • VideoMAE a étendu avec succès son expérience en PNL et dans les domaines de l'image au domaine de la compréhension vidéo d'une manière naturelle mais précieuse, en vérifiant que de simples tâches proxy basées sur le masquage et la reconstruction peuvent fournir une méthode simple mais précieuse pour la pré-supervision vidéo auto-supervisée. -formation.Solution très efficace. Les performances du modèle ViT après une pré-formation auto-supervisée à l'aide de VideoMAE sont nettement meilleures que l'entraînement à partir de zéro ou les méthodes d'apprentissage contrastées sur des tâches en aval dans le domaine de la compréhension vidéo (telles que la reconnaissance d'action, la détection d'action). • Il y a deux découvertes intéressantes au cours de l'expérience, qui ont peut-être été négligées par des travaux de recherche antérieurs en PNL et en compréhension d'images : (1) VideoMAE est un apprenant efficace en matière de données. Même sur l'ensemble de données vidéo HMDB51 d'environ 3 000 vidéos seulement, VideoMAE est capable d'effectuer une pré-formation auto-supervisée et d'obtenir des résultats dépassant de loin les autres méthodes sur les tâches de classification en aval. (2) Pour la pré-formation vidéo auto-supervisée, lorsqu'il existe un écart de domaine évident entre l'ensemble de données de pré-formation et l'ensemble de données de tâche en aval, la qualité des données vidéo peut être plus importante que la quantité. Sous-échantillonnage temporel

pixels. Dans les paramètres expérimentaux spécifiques, les intervalles d'échantillonnage sur les ensembles de données Kinetics-400 et Something-Something V2 sont définis sur 4 et 2 respectivement.

pixels. Dans les paramètres expérimentaux spécifiques, les intervalles d'échantillonnage sur les ensembles de données Kinetics-400 et Something-Something V2 sont définis sur 4 et 2 respectivement. Incorporation de blocs spatio-temporels

dans un clip vidéo de taille

dans un clip vidéo de taille  sont considérés comme un seul bloc de pixels visuels. Par conséquent, une fois que le clip vidéo échantillonné est passé à travers la couche d'intégration de blocs spatio-temporels (intégration de cubes),

sont considérés comme un seul bloc de pixels visuels. Par conséquent, une fois que le clip vidéo échantillonné est passé à travers la couche d'intégration de blocs spatio-temporels (intégration de cubes),  blocs de pixels visuels peuvent être obtenus. Dans ce processus, les dimensions du canal du bloc de pixels visuels seront également mappées. Cette conception peut réduire la taille des dimensions spatio-temporelles des données d'entrée et contribue également à atténuer dans une certaine mesure la redondance spatio-temporelle des données vidéo.

blocs de pixels visuels peuvent être obtenus. Dans ce processus, les dimensions du canal du bloc de pixels visuels seront également mappées. Cette conception peut réduire la taille des dimensions spatio-temporelles des données d'entrée et contribue également à atténuer dans une certaine mesure la redondance spatio-temporelle des données vidéo. Stratégie de masquage de pipeline avec un taux de masquage extrêmement élevé

Mécanisme d'auto-attention conjoint espace-temps

du mécanisme d'auto-attention conjointe spatio-temporelle est le goulot d'étranglement informatique du réseau. Dans l'article précédent, une stratégie de rapport de masque extrêmement élevé a été utilisée pour VideoMAE, et uniquement des jetons non masqués (par exemple, 10 %) ont été introduits dans le codage dans le navire. Cette conception peut atténuer efficacement dans une certaine mesure le problème de complexité informatique du niveau

du mécanisme d'auto-attention conjointe spatio-temporelle est le goulot d'étranglement informatique du réseau. Dans l'article précédent, une stratégie de rapport de masque extrêmement élevé a été utilisée pour VideoMAE, et uniquement des jetons non masqués (par exemple, 10 %) ont été introduits dans le codage dans le navire. Cette conception peut atténuer efficacement dans une certaine mesure le problème de complexité informatique du niveau  .

. Détails d'implémentation de VideoMAE

Ablation Experiment

Conception du décodeur

Stratégies de masquage

Cible de reconstruction

Stratégie de pré-entraînement

Ensemble de données de pré-entraînement

Tours de pré-entraînement

Fonctionnalités importantes de VideoMAE

VideoMAE est un apprenant économe en données

Taux de masquage extrêmement élevé

Capacités de généralisation et de transfert : qualité et quantité de données

Résultats principaux

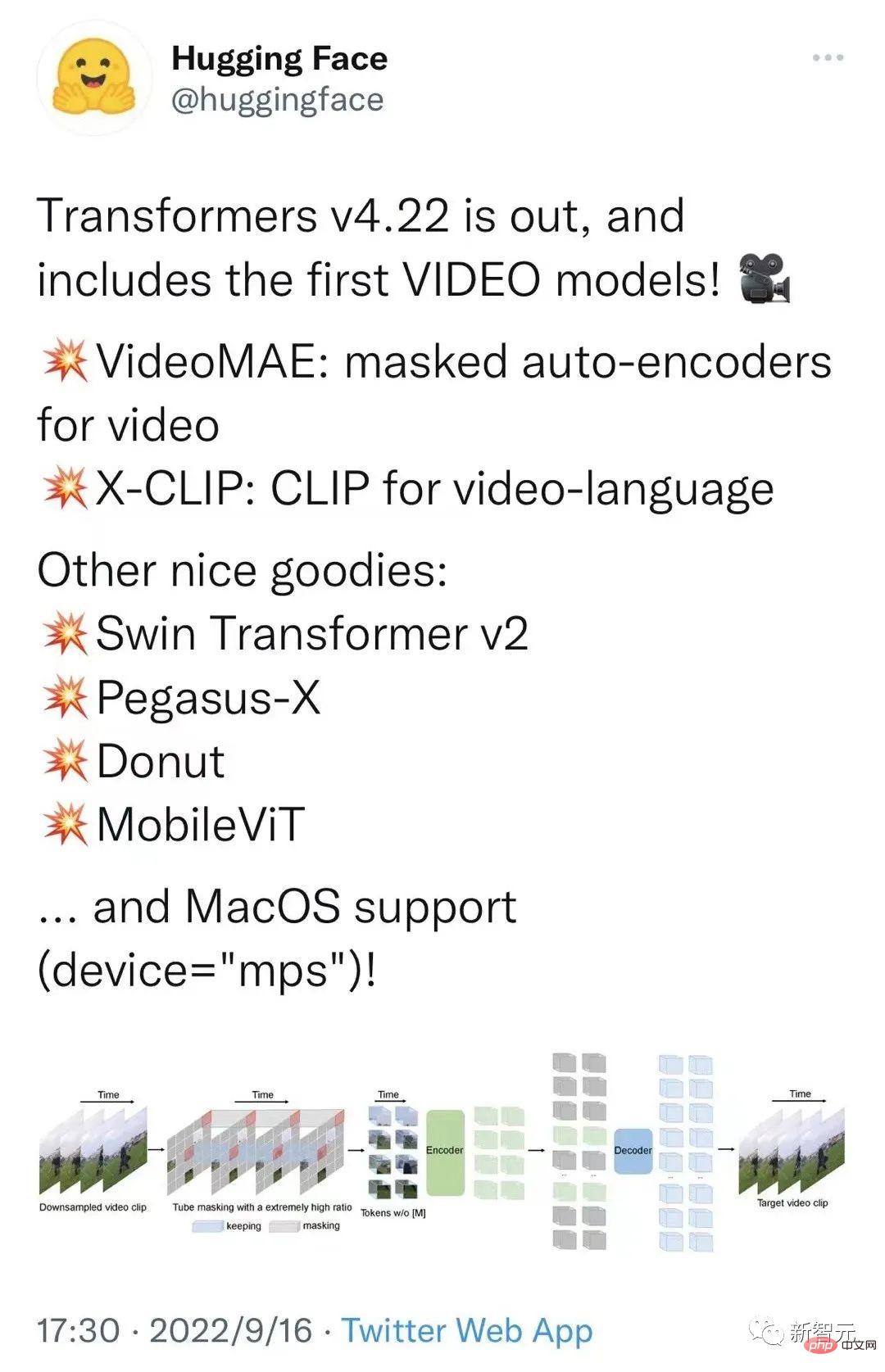

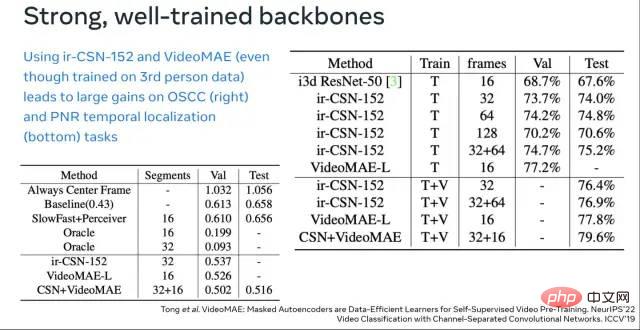

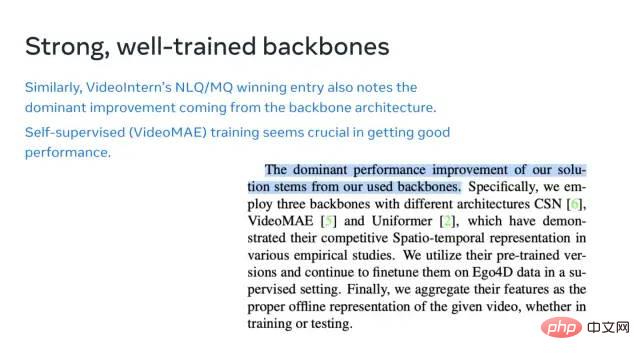

Impact sur la communauté

Résumé

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Bytedance Cutting lance le super abonnement SVIP : 499 yuans pour un abonnement annuel continu, offrant une variété de fonctions d'IA

Jun 28, 2024 am 03:51 AM

Bytedance Cutting lance le super abonnement SVIP : 499 yuans pour un abonnement annuel continu, offrant une variété de fonctions d'IA

Jun 28, 2024 am 03:51 AM

Ce site a rapporté le 27 juin que Jianying est un logiciel de montage vidéo développé par FaceMeng Technology, une filiale de ByteDance. Il s'appuie sur la plateforme Douyin et produit essentiellement du contenu vidéo court pour les utilisateurs de la plateforme. Il est compatible avec iOS, Android et. Windows, MacOS et autres systèmes d'exploitation. Jianying a officiellement annoncé la mise à niveau de son système d'adhésion et a lancé un nouveau SVIP, qui comprend une variété de technologies noires d'IA, telles que la traduction intelligente, la mise en évidence intelligente, l'emballage intelligent, la synthèse humaine numérique, etc. En termes de prix, les frais mensuels pour le clipping SVIP sont de 79 yuans, les frais annuels sont de 599 yuans (attention sur ce site : équivalent à 49,9 yuans par mois), l'abonnement mensuel continu est de 59 yuans par mois et l'abonnement annuel continu est de 59 yuans par mois. est de 499 yuans par an (équivalent à 41,6 yuans par mois) . En outre, le responsable de Cut a également déclaré que afin d'améliorer l'expérience utilisateur, ceux qui se sont abonnés au VIP d'origine

Assistant de codage d'IA augmenté par le contexte utilisant Rag et Sem-Rag

Jun 10, 2024 am 11:08 AM

Assistant de codage d'IA augmenté par le contexte utilisant Rag et Sem-Rag

Jun 10, 2024 am 11:08 AM

Améliorez la productivité, l’efficacité et la précision des développeurs en intégrant une génération et une mémoire sémantique améliorées par la récupération dans les assistants de codage IA. Traduit de EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, auteur JanakiramMSV. Bien que les assistants de programmation d'IA de base soient naturellement utiles, ils ne parviennent souvent pas à fournir les suggestions de code les plus pertinentes et les plus correctes, car ils s'appuient sur une compréhension générale du langage logiciel et des modèles d'écriture de logiciels les plus courants. Le code généré par ces assistants de codage est adapté à la résolution des problèmes qu’ils sont chargés de résoudre, mais n’est souvent pas conforme aux normes, conventions et styles de codage des équipes individuelles. Cela aboutit souvent à des suggestions qui doivent être modifiées ou affinées pour que le code soit accepté dans l'application.

Sept questions d'entretien technique Cool GenAI et LLM

Jun 07, 2024 am 10:06 AM

Sept questions d'entretien technique Cool GenAI et LLM

Jun 07, 2024 am 10:06 AM

Pour en savoir plus sur l'AIGC, veuillez visiter : 51CTOAI.x Community https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou est différent de la banque de questions traditionnelle que l'on peut voir partout sur Internet. nécessite de sortir des sentiers battus. Les grands modèles linguistiques (LLM) sont de plus en plus importants dans les domaines de la science des données, de l'intelligence artificielle générative (GenAI) et de l'intelligence artificielle. Ces algorithmes complexes améliorent les compétences humaines et stimulent l’efficacité et l’innovation dans de nombreux secteurs, devenant ainsi la clé permettant aux entreprises de rester compétitives. LLM a un large éventail d'applications. Il peut être utilisé dans des domaines tels que le traitement du langage naturel, la génération de texte, la reconnaissance vocale et les systèmes de recommandation. En apprenant de grandes quantités de données, LLM est capable de générer du texte

Le réglage fin peut-il vraiment permettre au LLM d'apprendre de nouvelles choses : l'introduction de nouvelles connaissances peut amener le modèle à produire davantage d'hallucinations

Jun 11, 2024 pm 03:57 PM

Le réglage fin peut-il vraiment permettre au LLM d'apprendre de nouvelles choses : l'introduction de nouvelles connaissances peut amener le modèle à produire davantage d'hallucinations

Jun 11, 2024 pm 03:57 PM

Les grands modèles linguistiques (LLM) sont formés sur d'énormes bases de données textuelles, où ils acquièrent de grandes quantités de connaissances du monde réel. Ces connaissances sont intégrées à leurs paramètres et peuvent ensuite être utilisées en cas de besoin. La connaissance de ces modèles est « réifiée » en fin de formation. À la fin de la pré-formation, le modèle arrête effectivement d’apprendre. Alignez ou affinez le modèle pour apprendre à exploiter ces connaissances et répondre plus naturellement aux questions des utilisateurs. Mais parfois, la connaissance du modèle ne suffit pas, et bien que le modèle puisse accéder à du contenu externe via RAG, il est considéré comme bénéfique de l'adapter à de nouveaux domaines grâce à un réglage fin. Ce réglage fin est effectué à l'aide de la contribution d'annotateurs humains ou d'autres créations LLM, où le modèle rencontre des connaissances supplémentaires du monde réel et les intègre.

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

L'ensemble de données ScienceAI Question Answering (QA) joue un rôle essentiel dans la promotion de la recherche sur le traitement du langage naturel (NLP). Des ensembles de données d'assurance qualité de haute qualité peuvent non seulement être utilisés pour affiner les modèles, mais également évaluer efficacement les capacités des grands modèles linguistiques (LLM), en particulier la capacité à comprendre et à raisonner sur les connaissances scientifiques. Bien qu’il existe actuellement de nombreux ensembles de données scientifiques d’assurance qualité couvrant la médecine, la chimie, la biologie et d’autres domaines, ces ensembles de données présentent encore certaines lacunes. Premièrement, le formulaire de données est relativement simple, et la plupart sont des questions à choix multiples. Elles sont faciles à évaluer, mais limitent la plage de sélection des réponses du modèle et ne peuvent pas tester pleinement la capacité du modèle à répondre aux questions scientifiques. En revanche, les questions et réponses ouvertes

Cinq écoles d'apprentissage automatique que vous ne connaissez pas

Jun 05, 2024 pm 08:51 PM

Cinq écoles d'apprentissage automatique que vous ne connaissez pas

Jun 05, 2024 pm 08:51 PM

L'apprentissage automatique est une branche importante de l'intelligence artificielle qui donne aux ordinateurs la possibilité d'apprendre à partir de données et d'améliorer leurs capacités sans être explicitement programmés. L'apprentissage automatique a un large éventail d'applications dans divers domaines, de la reconnaissance d'images et du traitement du langage naturel aux systèmes de recommandation et à la détection des fraudes, et il change notre façon de vivre. Il existe de nombreuses méthodes et théories différentes dans le domaine de l'apprentissage automatique, parmi lesquelles les cinq méthodes les plus influentes sont appelées les « Cinq écoles d'apprentissage automatique ». Les cinq grandes écoles sont l’école symbolique, l’école connexionniste, l’école évolutionniste, l’école bayésienne et l’école analogique. 1. Le symbolisme, également connu sous le nom de symbolisme, met l'accent sur l'utilisation de symboles pour le raisonnement logique et l'expression des connaissances. Cette école de pensée estime que l'apprentissage est un processus de déduction inversée, à travers les connaissances existantes.

Les performances de SOTA, la méthode d'IA de prédiction d'affinité protéine-ligand multimodale de Xiamen, combinent pour la première fois des informations sur la surface moléculaire

Jul 17, 2024 pm 06:37 PM

Les performances de SOTA, la méthode d'IA de prédiction d'affinité protéine-ligand multimodale de Xiamen, combinent pour la première fois des informations sur la surface moléculaire

Jul 17, 2024 pm 06:37 PM

Editeur | KX Dans le domaine de la recherche et du développement de médicaments, il est crucial de prédire avec précision et efficacité l'affinité de liaison des protéines et des ligands pour le criblage et l'optimisation des médicaments. Cependant, les études actuelles ne prennent pas en compte le rôle important des informations sur la surface moléculaire dans les interactions protéine-ligand. Sur cette base, des chercheurs de l'Université de Xiamen ont proposé un nouveau cadre d'extraction de caractéristiques multimodales (MFE), qui combine pour la première fois des informations sur la surface des protéines, la structure et la séquence 3D, et utilise un mécanisme d'attention croisée pour comparer différentes modalités. alignement. Les résultats expérimentaux démontrent que cette méthode atteint des performances de pointe dans la prédiction des affinités de liaison protéine-ligand. De plus, les études d’ablation démontrent l’efficacité et la nécessité des informations sur la surface des protéines et de l’alignement des caractéristiques multimodales dans ce cadre. Les recherches connexes commencent par "S

Préparant des marchés tels que l'IA, GlobalFoundries acquiert la technologie du nitrure de gallium de Tagore Technology et les équipes associées

Jul 15, 2024 pm 12:21 PM

Préparant des marchés tels que l'IA, GlobalFoundries acquiert la technologie du nitrure de gallium de Tagore Technology et les équipes associées

Jul 15, 2024 pm 12:21 PM

Selon les informations de ce site Web du 5 juillet, GlobalFoundries a publié un communiqué de presse le 1er juillet de cette année, annonçant l'acquisition de la technologie de nitrure de gallium (GaN) et du portefeuille de propriété intellectuelle de Tagore Technology, dans l'espoir d'élargir sa part de marché dans l'automobile et Internet. des objets et des domaines d'application des centres de données d'intelligence artificielle pour explorer une efficacité plus élevée et de meilleures performances. Alors que des technologies telles que l’intelligence artificielle générative (GenerativeAI) continuent de se développer dans le monde numérique, le nitrure de gallium (GaN) est devenu une solution clé pour une gestion durable et efficace de l’énergie, notamment dans les centres de données. Ce site Web citait l'annonce officielle selon laquelle, lors de cette acquisition, l'équipe d'ingénierie de Tagore Technology rejoindrait GF pour développer davantage la technologie du nitrure de gallium. g