Périphériques technologiques

Périphériques technologiques

IA

IA

La réduction de dimensionnalité de l'IA attaque les peintres humains, les graphiques vincentiens sont introduits dans ControlNet et les informations de profondeur et de contour sont entièrement réutilisables.

La réduction de dimensionnalité de l'IA attaque les peintres humains, les graphiques vincentiens sont introduits dans ControlNet et les informations de profondeur et de contour sont entièrement réutilisables.

La réduction de dimensionnalité de l'IA attaque les peintres humains, les graphiques vincentiens sont introduits dans ControlNet et les informations de profondeur et de contour sont entièrement réutilisables.

Avec l'émergence de modèles texte-image à grande échelle, générer une image attrayante est devenu très simple. Tout ce que l'utilisateur doit faire est de saisir une simple invite avec le mouvement de ses doigts. Après avoir obtenu l'image grâce à une série d'opérations, nous nous poserons inévitablement plusieurs questions : l'image générée sur la base de l'invite peut-elle répondre à nos exigences ? Quel type d’architecture devrions-nous construire pour répondre aux différentes exigences soulevées par les utilisateurs ? Les grands modèles peuvent-ils encore conserver les avantages et les capacités acquis grâce à des milliards d’images dans des tâches spécifiques ?

Pour répondre à ces questions, des chercheurs de Stanford ont mené une enquête approfondie sur diverses applications de traitement d'images et sont parvenus aux trois conclusions suivantes :

Premièrement, les données disponibles dans un domaine spécifique sont en réalité meilleures que la formation d'un modèle général. Il y a moins de données, ce qui se reflète principalement dans le fait que, par exemple, le plus grand ensemble de données sur un problème spécifique (comme la compréhension des gestes, etc.) est généralement inférieur à 100 000, soit 5 × 10 ^ 4 de moins que le plus grand. Ensemble de données d'images texte multimodales à grande échelle, ordre de grandeur LAION 5B. Cela nécessite que le réseau neuronal soit robuste pour éviter le surajustement du modèle et qu'il ait une bonne généralisation lorsqu'il cible des problèmes spécifiques.

Deuxièmement, lors de l'utilisation du traitement des tâches d'image basé sur les données, les grands clusters informatiques ne sont pas toujours disponibles. C'est là que les méthodes de formation rapides deviennent importantes, des méthodes capables d'optimiser de grands modèles pour des tâches spécifiques dans un temps et un espace mémoire acceptables. En outre, un réglage fin, un apprentissage par transfert et d'autres opérations peuvent être nécessaires lors du traitement ultérieur.

Enfin, divers problèmes rencontrés lors du traitement d'images seront définis de différentes manières. Lors de la résolution de ces problèmes, bien que l'algorithme de diffusion d'image puisse être ajusté de manière « procédurale », par exemple en limitant le processus de débruitage, en éditant l'activation de l'attention multi-têtes, etc., ces règles artisanales sont essentiellement dictées par des instructions humaines. Compte tenu de certaines tâches spécifiques telles que l'image en profondeur, la pose de la personne, etc., ces problèmes nécessitent essentiellement l'interprétation d'entrées brutes dans la compréhension au niveau de l'objet ou de la scène, ce qui rend les approches procédurales artisanales moins réalisables. Par conséquent, pour fournir des solutions à plusieurs tâches, un apprentissage de bout en bout est essentiel.

Sur la base des résultats ci-dessus, cet article propose une architecture de réseau neuronal de bout en bout ControlNet, qui peut contrôler le modèle de diffusion (tel que la diffusion stable) en ajoutant des conditions supplémentaires, améliorant ainsi l'effet de dessin et réalisant un dessin au trait. Générez des images en couleur, générez des images avec la même structure de profondeur et optimisez la génération manuelle grâce aux points clés de la main.

Adresse papier : https://arxiv.org/pdf/2302.05543.pdf

Adresse du projet : https://github.com/lllyasviel/ControlNet

Affichage des effets

Alors, quel est l’effet de ControlNet ?

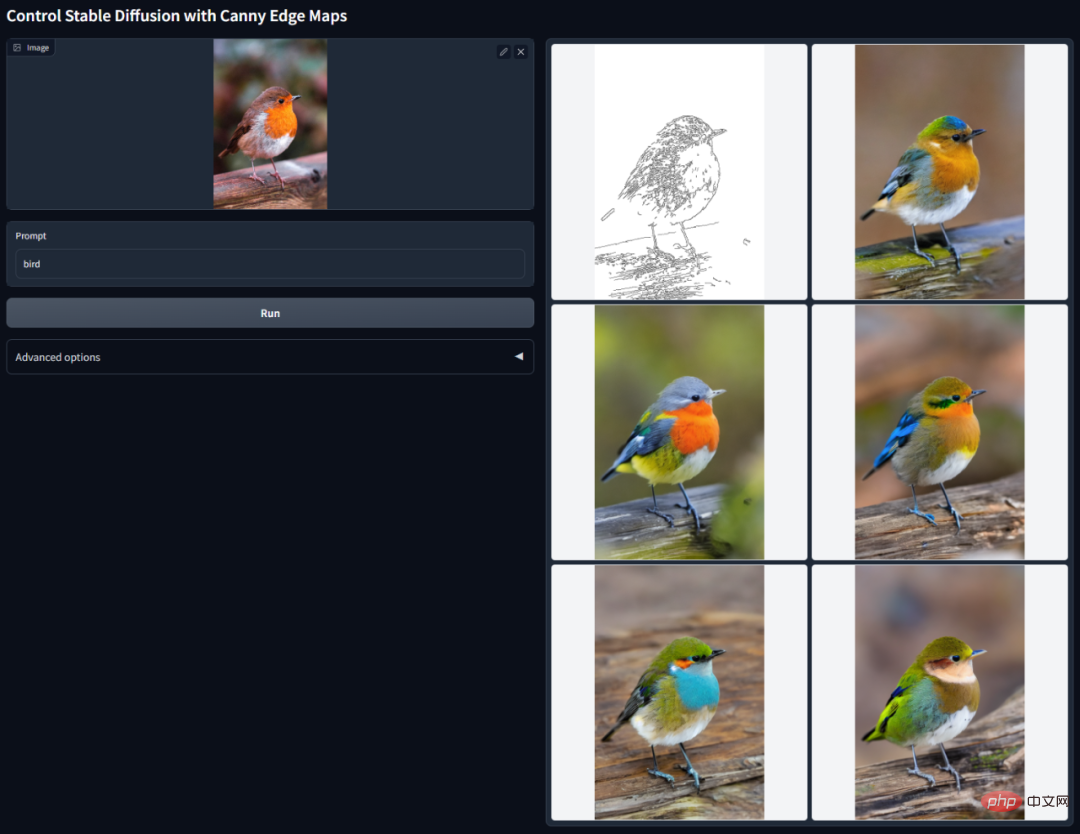

Détection Canny Edge : en extrayant des dessins au trait de l'image originale, des images avec la même composition peuvent être générées.

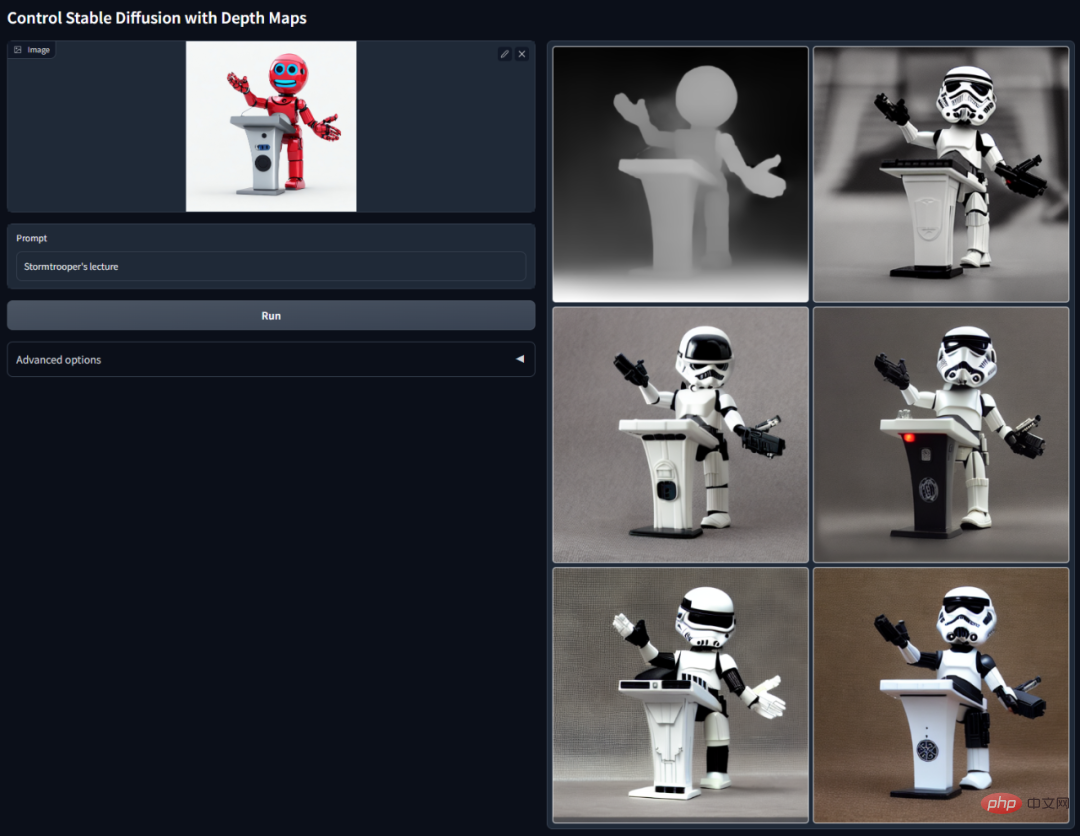

Détection de profondeur : en extrayant les informations de profondeur dans l'image originale, une carte avec la même structure de profondeur peut être générée.

ControlNet avec segmentation sémantique :

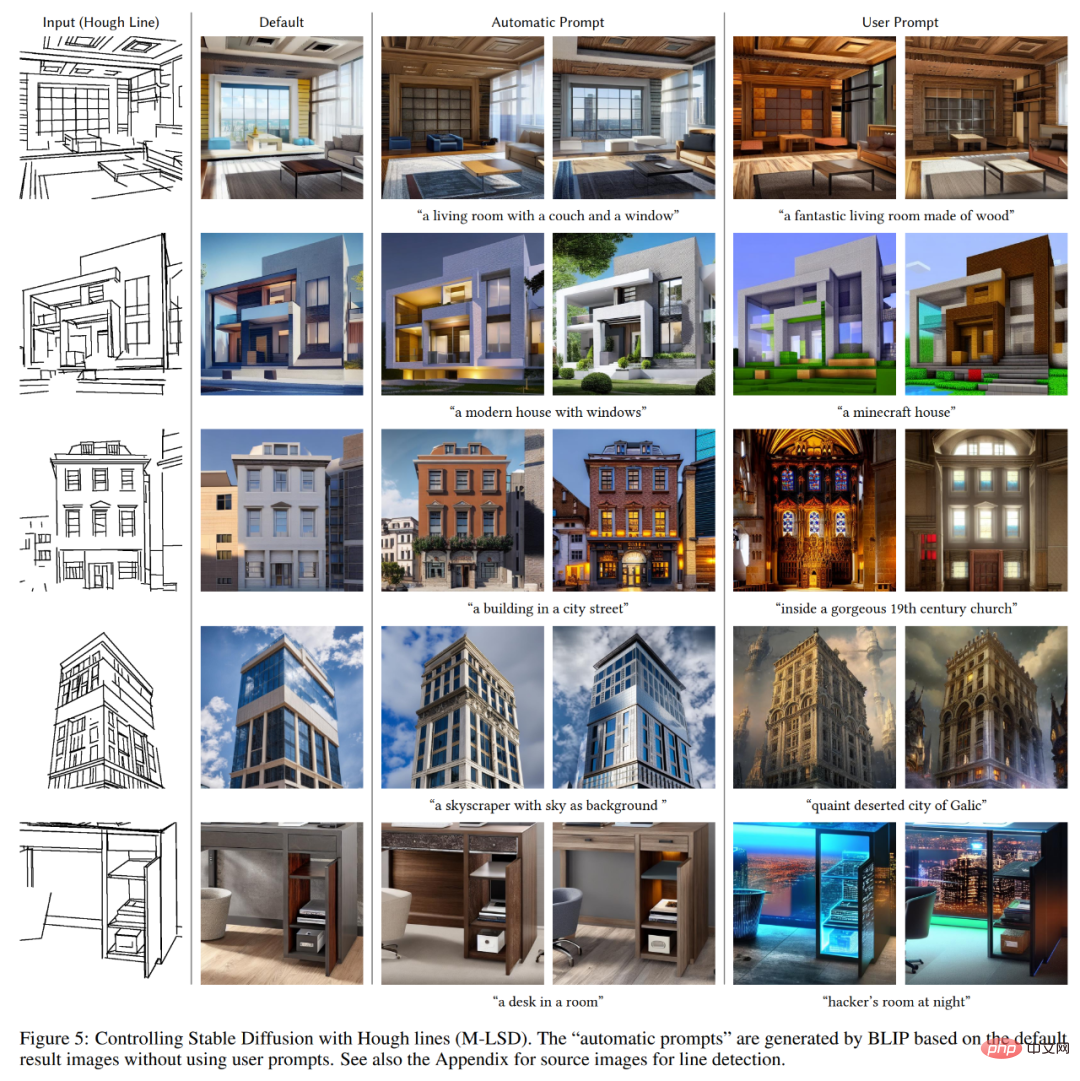

Détectez les lignes droites de Places2 à l'aide de la transformation profonde de Hough basée sur l'apprentissage, puis générez des sous-titres à l'aide de BLIP.

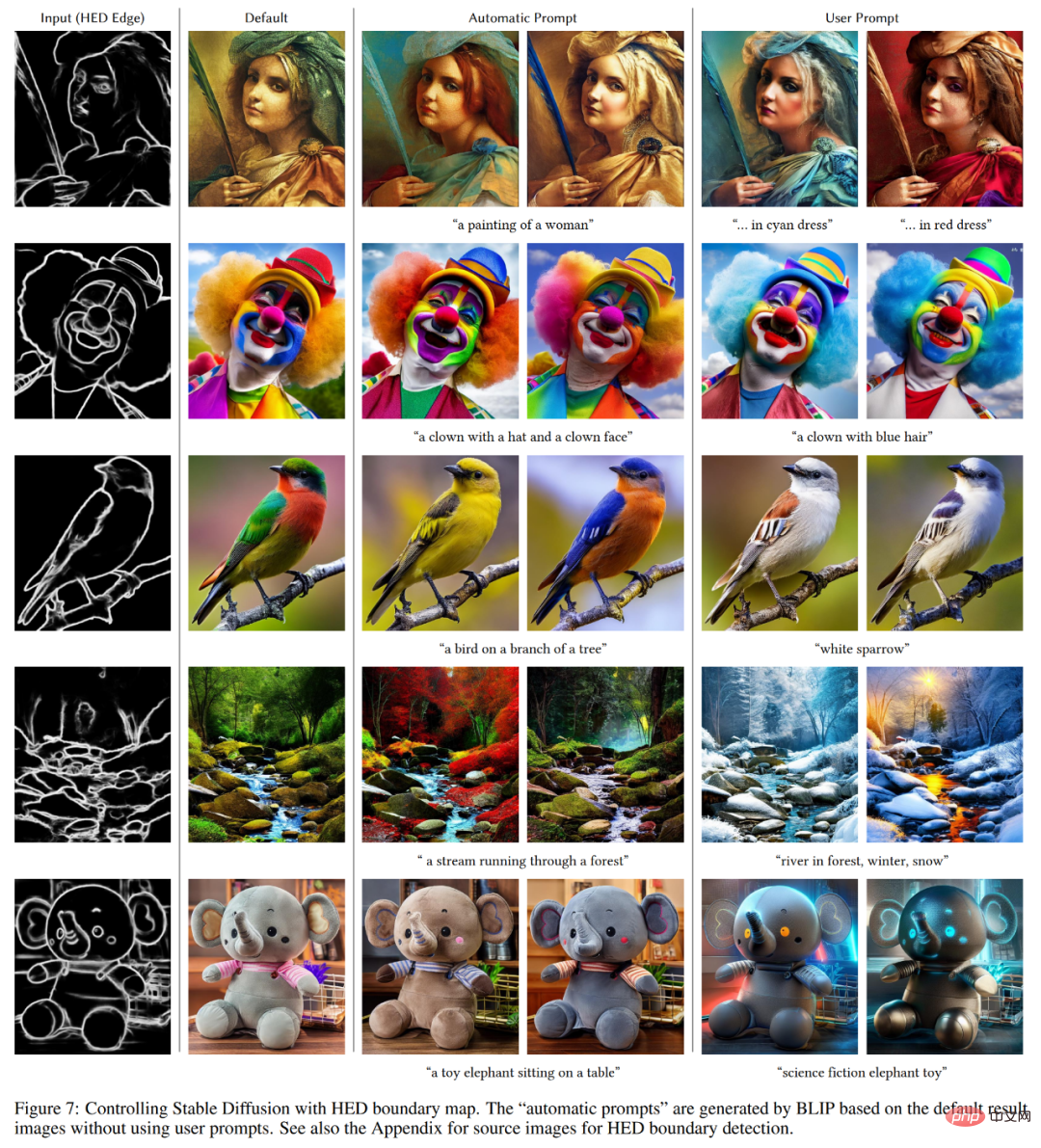

Icône de détection de bord HED.

Icône de reconnaissance de posture humaine.

Introduction à la méthode

ControlNet est une architecture de réseau neuronal qui améliore les modèles de diffusion d'images pré-entraînés avec des conditions spécifiques à la tâche. Examinons d'abord la structure de base de ControlNet.

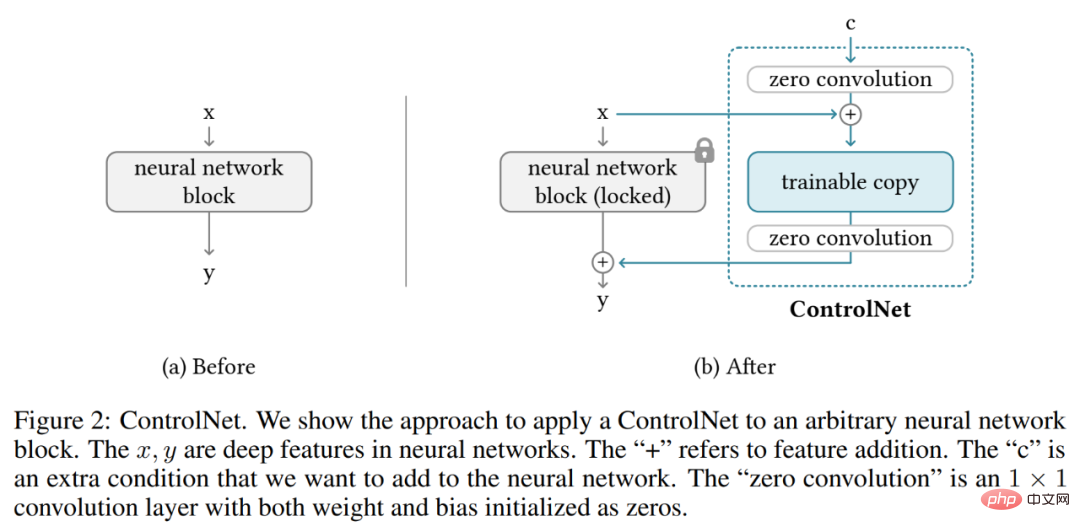

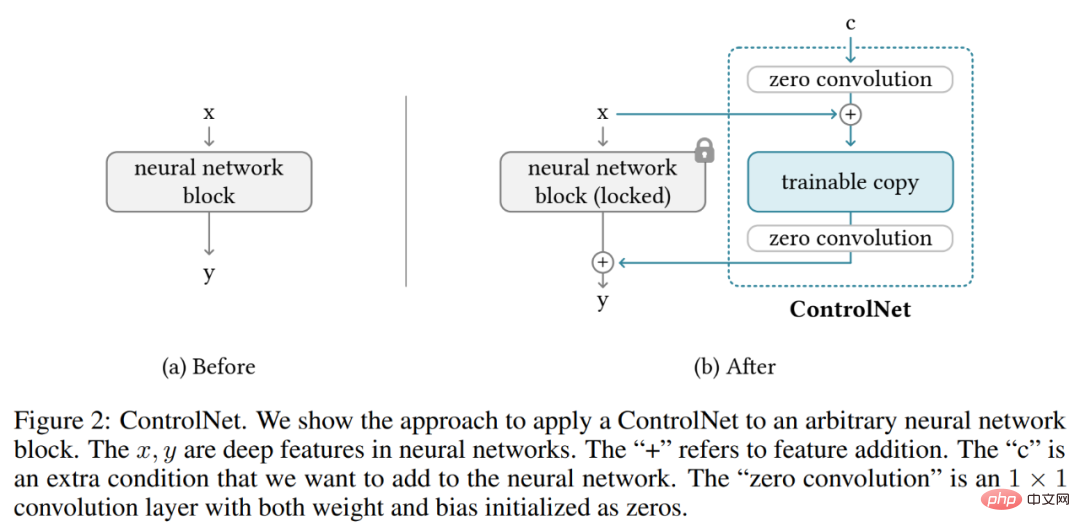

ControlNet manipule les conditions d'entrée des blocs de réseau neuronal pour contrôler davantage le comportement global de l'ensemble du réseau neuronal. Ici, le « bloc réseau » fait référence à un groupe de couches neuronales rassemblées comme une unité commune pour la construction de réseaux neuronaux, tels que le bloc Resnet, le bloc d'attention multi-têtes et le bloc Transformer.

Prenons l'exemple des entités 2D, étant donné une carte de caractéristiques x ϵ R^h×w×c, où {h, w, c} sont respectivement la hauteur, la largeur et le nombre de canaux. Un bloc de réseau neuronal F (・ ; Θ) avec un ensemble de paramètres Θ transforme x en une autre carte de caractéristiques y comme le montre l'équation (1) ci-dessous.

Ce processus est illustré dans la figure 2-(a) ci-dessous.

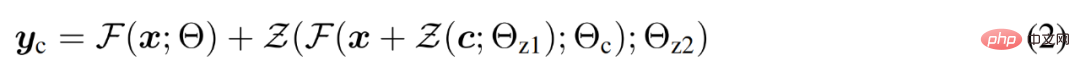

Les blocs du réseau neuronal sont connectés par une couche de convolution unique appelée « convolution zéro », qui est une couche de convolution 1×1 avec zéro initialisation des poids et des biais. Le chercheur représente l'opération de convolution nulle comme Z (・;・) et utilise deux instances de paramètres {Θ_z1, Θ_z2} pour former la structure ControlNet, comme le montre la formule suivante (2).

où y_c devient la sortie de ce bloc de réseau neuronal, comme le montre la figure 2-(b) ci-dessous.

ControlNet dans le modèle de diffusion d'images

Prenant la diffusion stable comme exemple, les chercheurs ont présenté comment utiliser ControlNet pour contrôler des modèles de diffusion à grande échelle avec des conditions spécifiques à une tâche. Stable Diffusion est un modèle de diffusion texte-image à grande échelle entraîné sur des milliards d'images, essentiellement un U-net composé d'un encodeur, de blocs intermédiaires et d'un décodeur connecté aux résidus.

Comme le montre la figure 3 ci-dessous, les chercheurs utilisent ControlNet pour contrôler chaque couche d'U-net. Notez que la façon dont ControlNet est connecté ici est efficace sur le plan informatique : puisque les poids d'origine sont verrouillés, le calcul du gradient sur l'encodeur d'origine ne nécessite aucune formation. Et comme la moitié des calculs de gradient sur le modèle d'origine sont réduits, la formation peut être accélérée et la mémoire GPU peut être économisée. La formation d'un modèle de diffusion stable à l'aide de ControlNet ne nécessite qu'environ 23 % de mémoire GPU en plus et 34 % de temps en plus par itération de formation (testé sur un seul Nvidia A100 PCIE 40G).

Plus précisément, les chercheurs ont utilisé ControlNet pour créer des copies entraînables de 12 blocs d'encodage et d'un bloc intermédiaire de diffusion stable. Les 12 blocs de codage sont disponibles en 4 résolutions, 64×64, 32×32, 16×16 et 8×8, avec 3 blocs dans chaque résolution. La sortie est ajoutée au U-net avec 12 connexions résiduelles et 1 bloc intermédiaire. Étant donné que Stable Diffusion est une structure U-net typique, il est probable que cette architecture ControlNet puisse être utilisée dans d'autres modèles de diffusion.

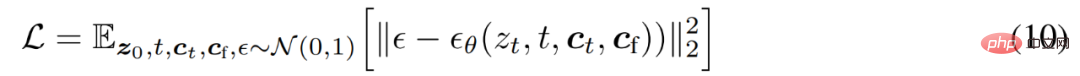

Entraînement et Boosting Training

Étant donné une image z_0, l'algorithme de diffusion ajoute progressivement du bruit à l'image et produit une image bruyante z_t, où t est le nombre de fois où du bruit est ajouté. Lorsque t est suffisamment grand, l’image se rapproche du bruit pur. Étant donné un ensemble de conditions comprenant le pas de temps t, les invites textuelles c_t et les conditions spécifiques à la tâche c_f, l'algorithme de diffusion d'image apprend un réseau ϵ_θ pour prédire le bruit ajouté à une image bruyante z_t, comme le montre l'équation (10) ci-dessous.

Pendant le processus de formation, les chercheurs ont remplacé de manière aléatoire 50 % des invites de texte c_t par des chaînes vides, ce qui est bénéfique pour la capacité de ControlNet à identifier le contenu sémantique à partir de la carte des conditions d'entrée.

De plus, les chercheurs discutent également de plusieurs stratégies pour améliorer la formation des ControlNets, notamment dans les cas extrêmes où les appareils informatiques sont très limités (comme les ordinateurs portables) ou très puissants (comme les clusters informatiques avec des GPU à grande échelle disponibles) .

Veuillez vous référer au document original pour plus de détails techniques.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L’IA change effectivement les mathématiques. Récemment, Tao Zhexuan, qui a prêté une attention particulière à cette question, a transmis le dernier numéro du « Bulletin de l'American Mathematical Society » (Bulletin de l'American Mathematical Society). En se concentrant sur le thème « Les machines changeront-elles les mathématiques ? », de nombreux mathématiciens ont exprimé leurs opinions. L'ensemble du processus a été plein d'étincelles, intense et passionnant. L'auteur dispose d'une équipe solide, comprenant Akshay Venkatesh, lauréat de la médaille Fields, le mathématicien chinois Zheng Lejun, l'informaticien de l'Université de New York Ernest Davis et de nombreux autres universitaires bien connus du secteur. Le monde de l’IA a radicalement changé. Vous savez, bon nombre de ces articles ont été soumis il y a un an.

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Les performances de JAX, promu par Google, ont dépassé celles de Pytorch et TensorFlow lors de récents tests de référence, se classant au premier rang sur 7 indicateurs. Et le test n’a pas été fait sur le TPU présentant les meilleures performances JAX. Bien que parmi les développeurs, Pytorch soit toujours plus populaire que Tensorflow. Mais à l’avenir, des modèles plus volumineux seront peut-être formés et exécutés sur la base de la plate-forme JAX. Modèles Récemment, l'équipe Keras a comparé trois backends (TensorFlow, JAX, PyTorch) avec l'implémentation native de PyTorch et Keras2 avec TensorFlow. Premièrement, ils sélectionnent un ensemble de

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

La détection de cibles est un problème relativement mature dans les systèmes de conduite autonome, parmi lesquels la détection des piétons est l'un des premiers algorithmes à être déployés. Des recherches très complètes ont été menées dans la plupart des articles. Cependant, la perception de la distance à l’aide de caméras fisheye pour une vue panoramique est relativement moins étudiée. En raison de la distorsion radiale importante, la représentation standard du cadre de délimitation est difficile à mettre en œuvre dans les caméras fisheye. Pour alléger la description ci-dessus, nous explorons les conceptions étendues de boîtes englobantes, d'ellipses et de polygones généraux dans des représentations polaires/angulaires et définissons une métrique de segmentation d'instance mIOU pour analyser ces représentations. Le modèle fisheyeDetNet proposé avec une forme polygonale surpasse les autres modèles et atteint simultanément 49,5 % de mAP sur l'ensemble de données de la caméra fisheye Valeo pour la conduite autonome.

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles

DualBEV : dépassant largement BEVFormer et BEVDet4D, ouvrez le livre !

Mar 21, 2024 pm 05:21 PM

DualBEV : dépassant largement BEVFormer et BEVDet4D, ouvrez le livre !

Mar 21, 2024 pm 05:21 PM

Cet article explore le problème de la détection précise d'objets sous différents angles de vue (tels que la perspective et la vue à vol d'oiseau) dans la conduite autonome, en particulier comment transformer efficacement les caractéristiques de l'espace en perspective (PV) en vue à vol d'oiseau (BEV). implémenté via le module Visual Transformation (VT). Les méthodes existantes sont globalement divisées en deux stratégies : la conversion 2D en 3D et la conversion 3D en 2D. Les méthodes 2D vers 3D améliorent les caractéristiques 2D denses en prédisant les probabilités de profondeur, mais l'incertitude inhérente aux prévisions de profondeur, en particulier dans les régions éloignées, peut introduire des inexactitudes. Alors que les méthodes 3D vers 2D utilisent généralement des requêtes 3D pour échantillonner des fonctionnalités 2D et apprendre les poids d'attention de la correspondance entre les fonctionnalités 3D et 2D via un transformateur, ce qui augmente le temps de calcul et de déploiement.