Périphériques technologiques

Périphériques technologiques

IA

IA

Avec seulement 3 échantillons et une phrase, l'IA peut personnaliser des images photoréalistes. Google joue avec un tout nouveau modèle de diffusion.

Avec seulement 3 échantillons et une phrase, l'IA peut personnaliser des images photoréalistes. Google joue avec un tout nouveau modèle de diffusion.

Avec seulement 3 échantillons et une phrase, l'IA peut personnaliser des images photoréalistes. Google joue avec un tout nouveau modèle de diffusion.

Récemment, les modèles texte-image sont devenus un domaine de recherche populaire. Qu'il s'agisse de grands paysages naturels ou d'images de scènes inédites, ils peuvent être générés automatiquement à l'aide de simples descriptions textuelles.

Parmi eux, le rendu de scènes sauvages et imaginaires est une tâche difficile qui nécessite de composer des instances de thèmes spécifiques (objets, animaux, etc.) dans de nouvelles scènes afin qu'elles se fondent naturellement et harmonieusement dans la scène.

Certains modèles texte-image à grande échelle permettent d'obtenir une synthèse d'images diversifiée et de haute qualité basée sur des invites de texte écrites en langage naturel. Le principal avantage de ces modèles réside dans les a priori sémantiques forts tirés d'un grand nombre de paires de descriptions image-texte, comme l'association du mot « chien » à diverses instances de chiens qui peuvent apparaître dans différentes poses dans l'image.

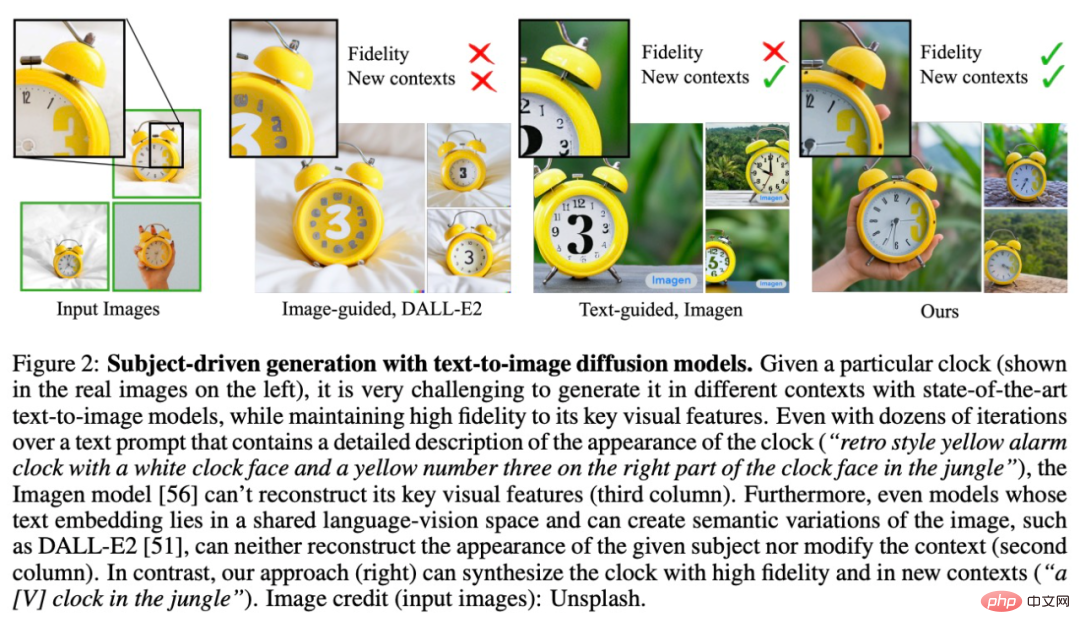

Bien que les capacités de synthèse de ces modèles soient sans précédent, il leur manque la capacité d'imiter un sujet de référence donné et de synthétiser de nouvelles images avec le même sujet mais des instances différentes dans différentes scènes. On constate que la capacité d’expression du domaine de sortie des modèles existants est limitée.

Afin de résoudre ce problème, des chercheurs de Google et de l'Université de Boston ont proposé un modèle de diffusion texte-image « personnalisé » DreamBooth qui peut s'adapter aux besoins spécifiques de génération d'images des utilisateurs.

Adresse papier : https://arxiv.org/pdf/2208.12242.pdf

Adresse du projet : https://github.com/XavierXiao/Dreambooth-Stable-Diffusion

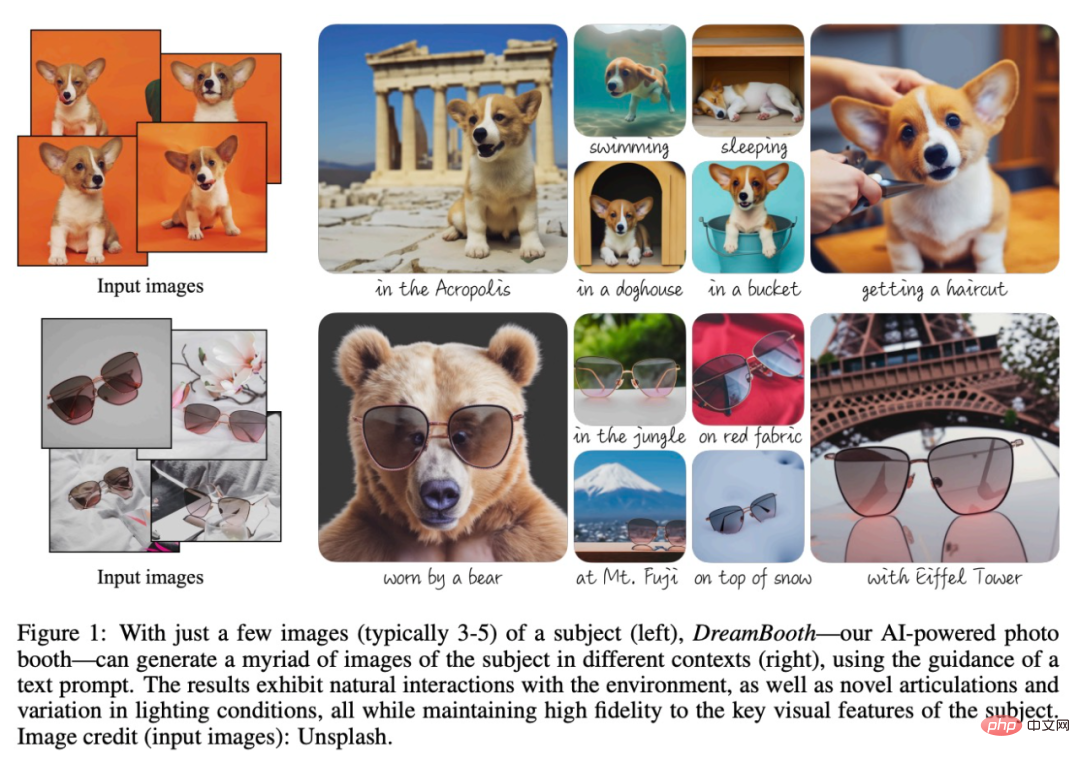

Le but de la recherche est d'étendre le dictionnaire langage-visuel du modèle afin qu'il lie le nouveau vocabulaire aux sujets spécifiques que l'utilisateur souhaite générer. Une fois le nouveau dictionnaire intégré au modèle, il peut utiliser ces mots pour synthétiser des images nouvelles et réalistes de sujets spécifiques tout en les contextualisant dans différentes scènes, en préservant les principales caractéristiques d'identification, comme le montre la figure 1 ci-dessous.

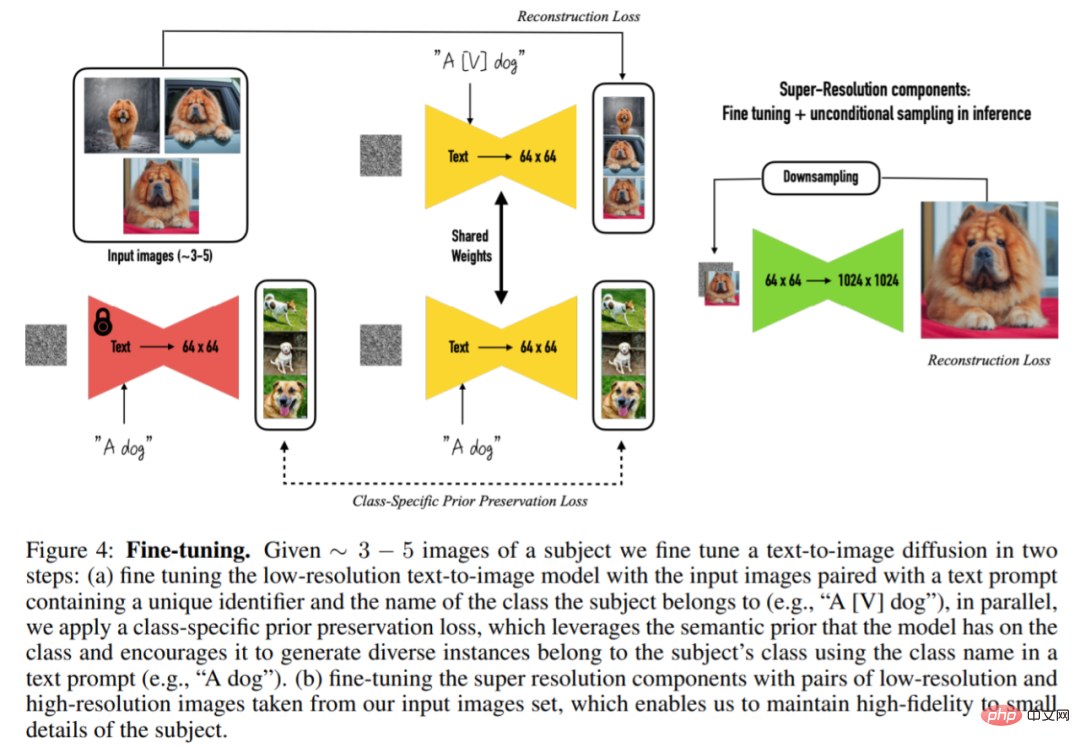

Plus précisément, l'étude a implanté des images d'un sujet donné dans le domaine de sortie du modèle afin qu'elles puissent être synthétisées à l'aide d'un identifiant unique. À cette fin, l'étude propose une méthode pour représenter un sujet donné avec un identifiant de jeton rare et affine un cadre texte-image pré-entraîné et basé sur la diffusion qui fonctionne en deux étapes : générer une basse résolution à partir d'images texte ; , puis appliquez un modèle de diffusion super-résolution (SR).

Tout d'abord, l'étude a affiné un modèle texte-image basse résolution à l'aide d'images d'entrée et d'indices de texte contenant des identifiants uniques (avec des noms de classe de sujets, tels que "Un chien [V]"). Pour empêcher le modèle de surajuster les noms de classe à des instances spécifiques et de dérive sémantique, cette étude propose une perte de préservation préalable auto-générée et spécifique à la classe, qui exploite la sémantique antérieure des classes intégrées dans le modèle pour encourager le modèle à générer différentes instances du même classe sous un sujet donné.

Dans la deuxième étape, l'étude utilise des versions basse et haute résolution de l'image d'entrée pour affiner la composante super-résolution. Cela permet au modèle de conserver une haute fidélité aux détails petits mais importants du sujet de la scène.

Jetons un coup d'œil aux méthodes spécifiques proposées dans cette étude.

Introduction à la méthode

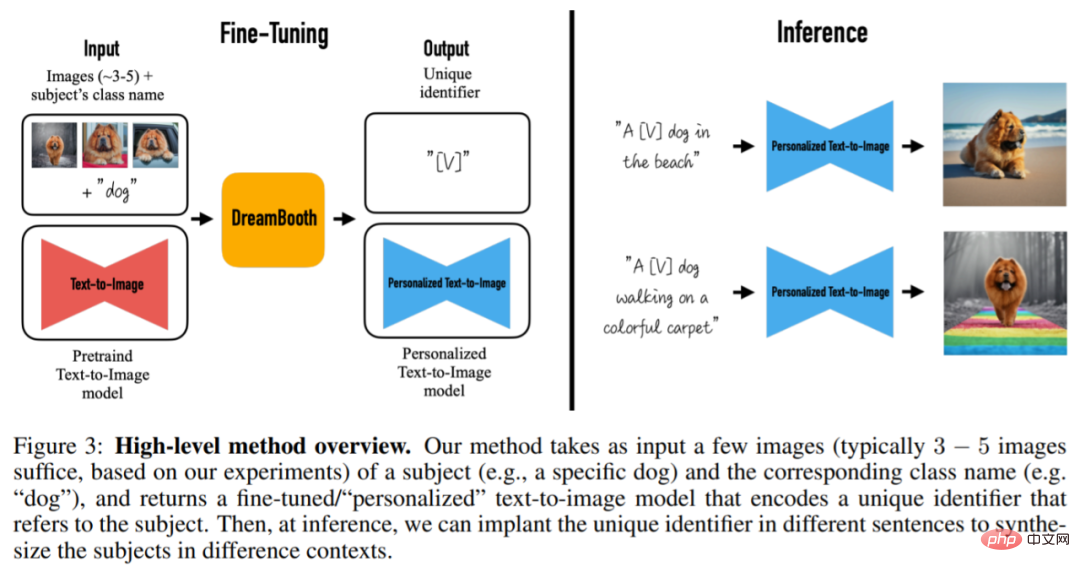

À partir de 3 à 5 images capturées sans descriptions textuelles, cet article vise à générer de nouvelles images avec une grande fidélité de détail et des changements guidés par des indices textuels. L'étude n'impose aucune restriction sur les images d'entrée, et les images sujet peuvent avoir des contextes différents. La méthode est illustrée à la figure 3. L'image de sortie peut modifier l'image originale, telle que la position du sujet, changer les propriétés du sujet telles que la couleur et la forme, et modifier la posture, l'expression, le matériau et d'autres modifications sémantiques du sujet.

Plus précisément, cette méthode prend en entrée quelques images (généralement 3 à 5 images) d'un sujet (par exemple, un chien spécifique) et le nom de classe correspondant (par exemple, la catégorie de chien), et renvoie un résultat affiné. / Modèle texte-image personnalisé qui code un identifiant unique faisant référence à un sujet. Ensuite, lors du raisonnement, des identifiants uniques peuvent être intégrés dans différentes phrases pour synthétiser des sujets dans différents contextes.

La première tâche de la recherche est d'implanter des instances de sujet dans le domaine de sortie du modèle et de lier les sujets avec des identifiants uniques. Cette étude propose une méthode de conception d'identifiants, en plus de concevoir une nouvelle méthode de supervision du processus de réglage fin du modèle.

Afin de résoudre le problème du surajustement de l'image et de la dérive du langage, cette étude propose également une perte (Perte de Préservation) pour atténuer le surajustement du modèle en encourageant le modèle de diffusion à générer en continu différentes instances de la même classe que le sujet. problèmes tels que l’intégration et la dérive linguistique.

Afin de préserver les détails de l'image, l'étude a révélé que le composant super-résolution (SR) du modèle doit être affiné. Cet article est complété sur la base du modèle Imagen pré-entraîné. Le processus spécifique est illustré à la figure 4. Étant donné 3 à 5 images du même sujet, le modèle de diffusion texte-image est ensuite affiné en deux étapes :

L'identifiant de jeton rare représente le topic

L'étude étiquete toutes les images d'entrée d'un sujet comme "un [identifiant] [nom de classe]", où [identifiant] est un identifiant unique lié au sujet et [nom de classe] est un descripteur de classe approximatif de le sujet (par exemple chat, chiens, montres, etc.). Cette étude utilise spécifiquement des descripteurs de classe dans des phrases afin d'associer les priorités de classe à des sujets.

Affichage des effets

Ce qui suit est une implémentation de diffusion stable de Dreambooth (voir le lien du projet). Résultats qualitatifs : Les images de formation proviennent de la bibliothèque « Textual Inversion » :

Une fois la formation terminée, sous l'invite « photo d'un conteneur sks », les photos de conteneurs générées par le modèle sont les suivantes :

à l'invite Ajoutez une position "photo d'un conteneur sks sur la plage", et le conteneur apparaît sur la plage

Le conteneur vert est de couleur trop simple ; Si vous voulez ajouter du rouge, entrez l'invite "photo d'un conteneur sks rouge". Vous pouvez l'obtenir :

Entrez l'invite "un chien au-dessus du conteneur sks" pour que le chiot s'assoie dans la boîte :

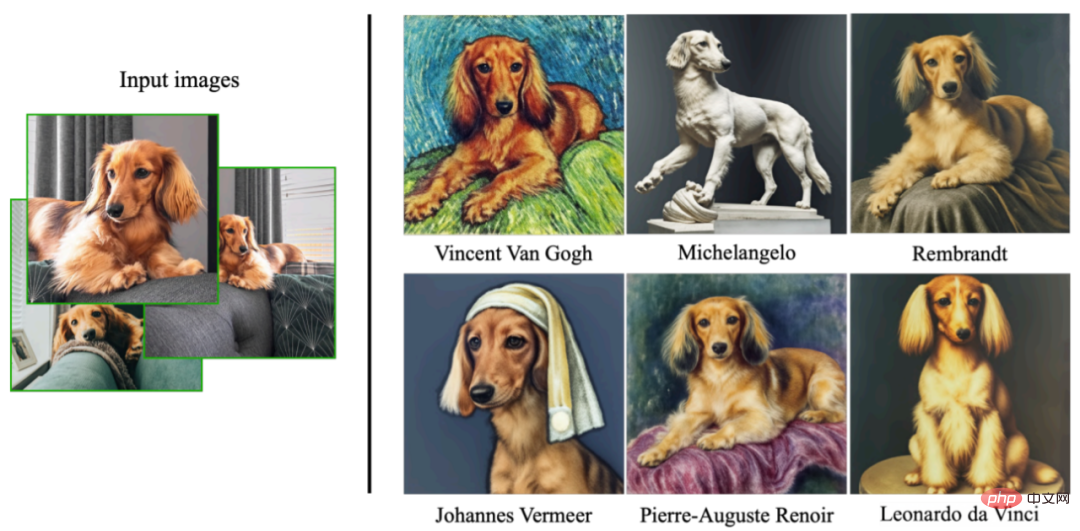

Voici quelques résultats présentés dans le document. Générez des images artistiques sur des chiens dans différents styles d'artistes :

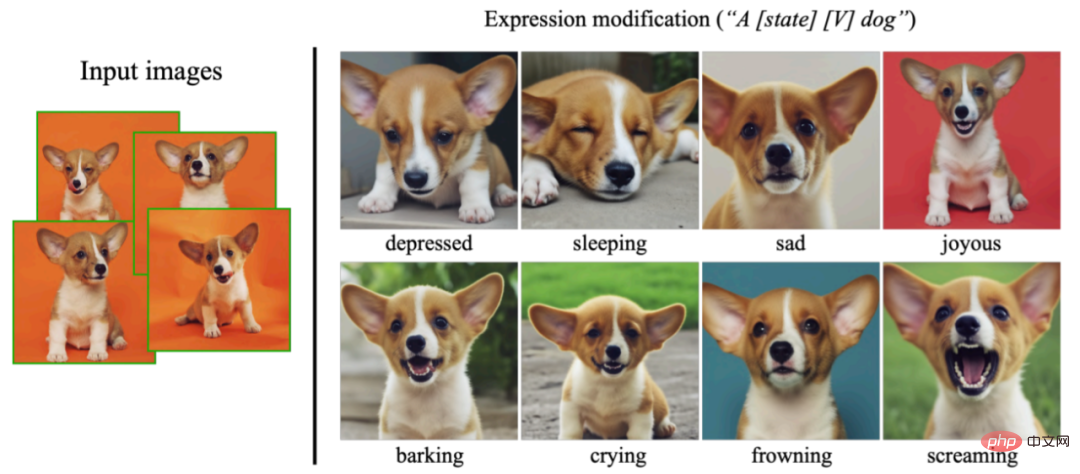

Cette recherche peut également synthétiser diverses expressions qui n'apparaissent pas dans l'image d'entrée, démontrant la capacité d'extrapolation du modèle :

Pour plus de détails, veuillez vous référer à l'article original.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

La commande de fermeture CENTOS est arrêtée et la syntaxe est la fermeture de [options] le temps [informations]. Les options incluent: -H Arrêtez immédiatement le système; -P éteignez l'alimentation après l'arrêt; -r redémarrer; -t temps d'attente. Les temps peuvent être spécifiés comme immédiats (maintenant), minutes (minutes) ou une heure spécifique (HH: mm). Des informations supplémentaires peuvent être affichées dans les messages système.

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

La politique de sauvegarde et de récupération de GitLab dans le système CentOS afin d'assurer la sécurité et la récupérabilité des données, Gitlab on CentOS fournit une variété de méthodes de sauvegarde. Cet article introduira plusieurs méthodes de sauvegarde courantes, paramètres de configuration et processus de récupération en détail pour vous aider à établir une stratégie complète de sauvegarde et de récupération de GitLab. 1. MANUEL BACKUP Utilisez le Gitlab-RakegitLab: Backup: Créer la commande pour exécuter la sauvegarde manuelle. Cette commande sauvegarde des informations clés telles que le référentiel Gitlab, la base de données, les utilisateurs, les groupes d'utilisateurs, les clés et les autorisations. Le fichier de sauvegarde par défaut est stocké dans le répertoire / var / opt / gitlab / backups. Vous pouvez modifier / etc / gitlab

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Guide complet pour vérifier la configuration HDFS dans les systèmes CentOS Cet article vous guidera comment vérifier efficacement la configuration et l'état de l'exécution des HDF sur les systèmes CentOS. Les étapes suivantes vous aideront à bien comprendre la configuration et le fonctionnement des HDF. Vérifiez la variable d'environnement Hadoop: Tout d'abord, assurez-vous que la variable d'environnement Hadoop est correctement définie. Dans le terminal, exécutez la commande suivante pour vérifier que Hadoop est installé et configuré correctement: HadoopVersion Check HDFS Fichier de configuration: Le fichier de configuration de base de HDFS est situé dans le répertoire / etc / hadoop / conf / le répertoire, où Core-site.xml et hdfs-site.xml sont cruciaux. utiliser

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Activer l'accélération du GPU Pytorch sur le système CentOS nécessite l'installation de versions CUDA, CUDNN et GPU de Pytorch. Les étapes suivantes vous guideront tout au long du processus: CUDA et CUDNN Installation détermineront la compatibilité de la version CUDA: utilisez la commande NVIDIA-SMI pour afficher la version CUDA prise en charge par votre carte graphique NVIDIA. Par exemple, votre carte graphique MX450 peut prendre en charge CUDA11.1 ou plus. Téléchargez et installez Cudatoolkit: visitez le site officiel de Nvidiacudatoolkit et téléchargez et installez la version correspondante selon la version CUDA la plus élevée prise en charge par votre carte graphique. Installez la bibliothèque CUDNN:

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

L'installation de MySQL sur CENTOS implique les étapes suivantes: Ajout de la source MySQL YUM appropriée. Exécutez la commande YUM Install MySQL-Server pour installer le serveur MySQL. Utilisez la commande mysql_secure_installation pour créer des paramètres de sécurité, tels que la définition du mot de passe de l'utilisateur racine. Personnalisez le fichier de configuration MySQL selon les besoins. Écoutez les paramètres MySQL et optimisez les bases de données pour les performances.

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Docker utilise les fonctionnalités du noyau Linux pour fournir un environnement de fonctionnement d'application efficace et isolé. Son principe de travail est le suivant: 1. Le miroir est utilisé comme modèle en lecture seule, qui contient tout ce dont vous avez besoin pour exécuter l'application; 2. Le Système de fichiers Union (UnionFS) empile plusieurs systèmes de fichiers, ne stockant que les différences, l'économie d'espace et l'accélération; 3. Le démon gère les miroirs et les conteneurs, et le client les utilise pour l'interaction; 4. Les espaces de noms et les CGROUP implémentent l'isolement des conteneurs et les limitations de ressources; 5. Modes de réseau multiples prennent en charge l'interconnexion du conteneur. Ce n'est qu'en comprenant ces concepts principaux que vous pouvez mieux utiliser Docker.

CentOS8 redémarre SSH

Apr 14, 2025 pm 09:00 PM

CentOS8 redémarre SSH

Apr 14, 2025 pm 09:00 PM

La commande pour redémarrer le service SSH est: SystemCTL Redémarrer SSHD. Étapes détaillées: 1. Accédez au terminal et connectez-vous au serveur; 2. Entrez la commande: SystemCTL Restart SSHD; 3. Vérifiez l'état du service: SystemCTL Status Sshd.

Comment faire fonctionner la formation distribuée de Pytorch sur CentOS

Apr 14, 2025 pm 06:36 PM

Comment faire fonctionner la formation distribuée de Pytorch sur CentOS

Apr 14, 2025 pm 06:36 PM

La formation distribuée par Pytorch sur le système CentOS nécessite les étapes suivantes: Installation de Pytorch: La prémisse est que Python et PIP sont installés dans le système CentOS. Selon votre version CUDA, obtenez la commande d'installation appropriée sur le site officiel de Pytorch. Pour la formation du processeur uniquement, vous pouvez utiliser la commande suivante: pipinstalltorchtorchVisionTorChaudio Si vous avez besoin d'une prise en charge du GPU, assurez-vous que la version correspondante de CUDA et CUDNN est installée et utilise la version Pytorch correspondante pour l'installation. Configuration de l'environnement distribué: la formation distribuée nécessite généralement plusieurs machines ou des GPU multiples uniques. Lieu