Périphériques technologiques

Périphériques technologiques

IA

IA

Le MIT publie une version améliorée du solveur « Advanced Mathematics » : le taux de précision atteint 81 % dans 7 cours

Le MIT publie une version améliorée du solveur « Advanced Mathematics » : le taux de précision atteint 81 % dans 7 cours

Le MIT publie une version améliorée du solveur « Advanced Mathematics » : le taux de précision atteint 81 % dans 7 cours

Non seulement elle résout les problèmes de mots mathématiques à l'école primaire, mais l'IA a également commencé à conquérir les mathématiques avancées !

Récemment, des chercheurs du MIT ont annoncé que, sur la base du modèle de pré-formation OpenAI Codex, ils ont réussi à atteindre un taux de précision de 81 % sur des problèmes de mathématiques de premier cycle grâce à un apprentissage en quelques étapes !

- Lien papier : https://arxiv.org/abs/2112.15594

- Lien code : https://github.com/idrori/mathq

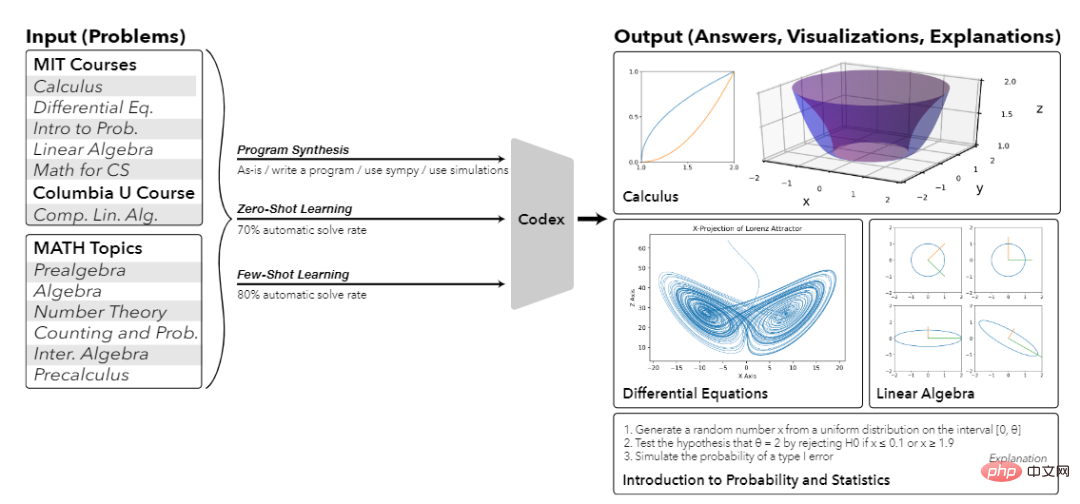

Jetons un coup d'œil aux réponses à quelques petites questions d'abord, telles que Calculer le volume généré en faisant tourner le graphique d'une fonction variable unique autour d'un axe, calculer l'attracteur et la projection de Lorenz, calculer et représenter la forme géométrique de la décomposition en valeurs singulières (SVD), non seulement vous pouvez y répondre correctement , mais vous pouvez aussi donner l'explication correspondante !

C'est vraiment incroyable. En regardant le passé, les scores élevés ont tous été dépassés. Maintenant, l'IA peut marquer 81 points d'un seul coup.

Ce qui est encore plus impressionnant, c'est qu'en plus de résoudre des problèmes difficiles à résoudre avec des modèles d'apprentissage automatique ordinaires, cette recherche montre également que cette technologie peut être promue à grande échelle et peut résoudre des problèmes dans ses cours et cours similaires.

C'est également la première fois dans l'histoire qu'un seul modèle d'apprentissage automatique peut résoudre un problème mathématique d'une telle envergure, et peut également expliquer, dessiner et même générer de nouvelles questions !

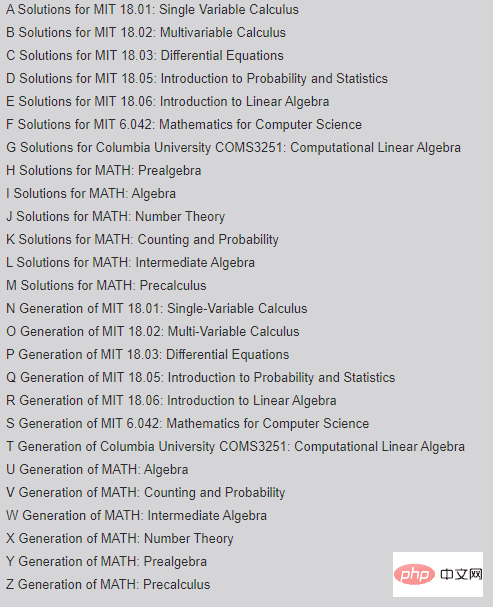

En fait, cet article a été publié dès le début de l'année. Après six mois de révision, la longueur est passée de 114 pages à 181 pages. Plus de problèmes mathématiques peuvent être résolus. Z.

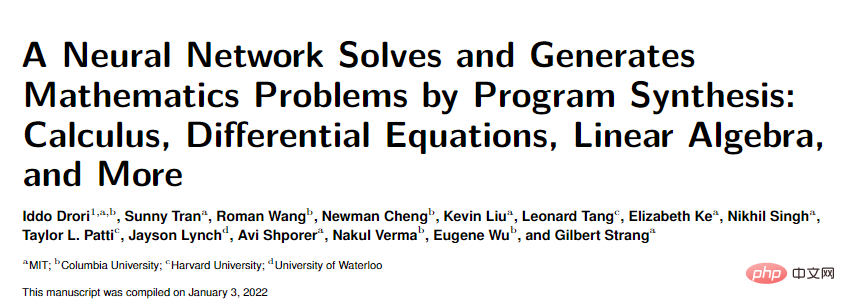

Il y a quatre unités d'auteurs principales de l'article, à savoir le MIT, l'Université Columbia, l'Université Harvard et l'Université de Waterloo.

Le premier auteur, Iddo Drori, est maître de conférences au département d'IA du département de génie électrique et d'informatique du MIT et professeur associé adjoint à la School of Engineering and Applied Sciences de l'Université de Columbia. A remporté le prix du meilleur article CCAI NeurIPS 2021.

Ses principaux axes de recherche sont l'apprentissage automatique pour l'éducation, qui tente d'amener les machines à résoudre, expliquer et générer des cours de mathématiques de niveau universitaire et l'apprentissage automatique pour la science du climat, qui prédit et surveille les changements climatiques extrêmes ; sur des milliers d'années de données Climat, intégrant des travaux multidisciplinaires pour prédire les changements pluriannuels de la biogéochimie des océans dans l'océan Atlantique, des algorithmes d'apprentissage automatique pour la conduite autonome, etc.

Il est également l'auteur de The Science of Deep Learning publié par Cambridge University Press.

Jalons de l'enseignement supérieur

Avant cet article, la plupart des chercheurs pensaient que les réseaux de neurones ne pouvaient pas gérer des problèmes à nombre élevé et ne pouvaient résoudre que quelques problèmes mathématiques simples.

Même si le modèle Transformer surpasse les performances humaines dans diverses tâches de PNL, il n'est toujours pas mauvais pour résoudre des problèmes mathématiques. La raison principale est que divers grands modèles tels que GPT-3 ne sont pré-entraînés que sur des données textuelles.

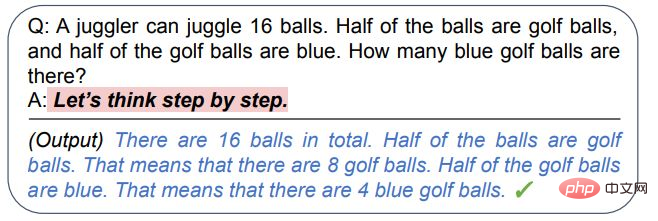

Plus tard, certains chercheurs ont découvert que le modèle de langage peut toujours être guidé pour raisonner et répondre à quelques questions mathématiques simples grâce à une analyse étape par étape (chaîne de pensées), mais les problèmes mathématiques avancés ne sont pas si faciles à résoudre.

Lorsque la cible est un problème à nombre élevé, vous devez d'abord collecter une vague de données d'entraînement.

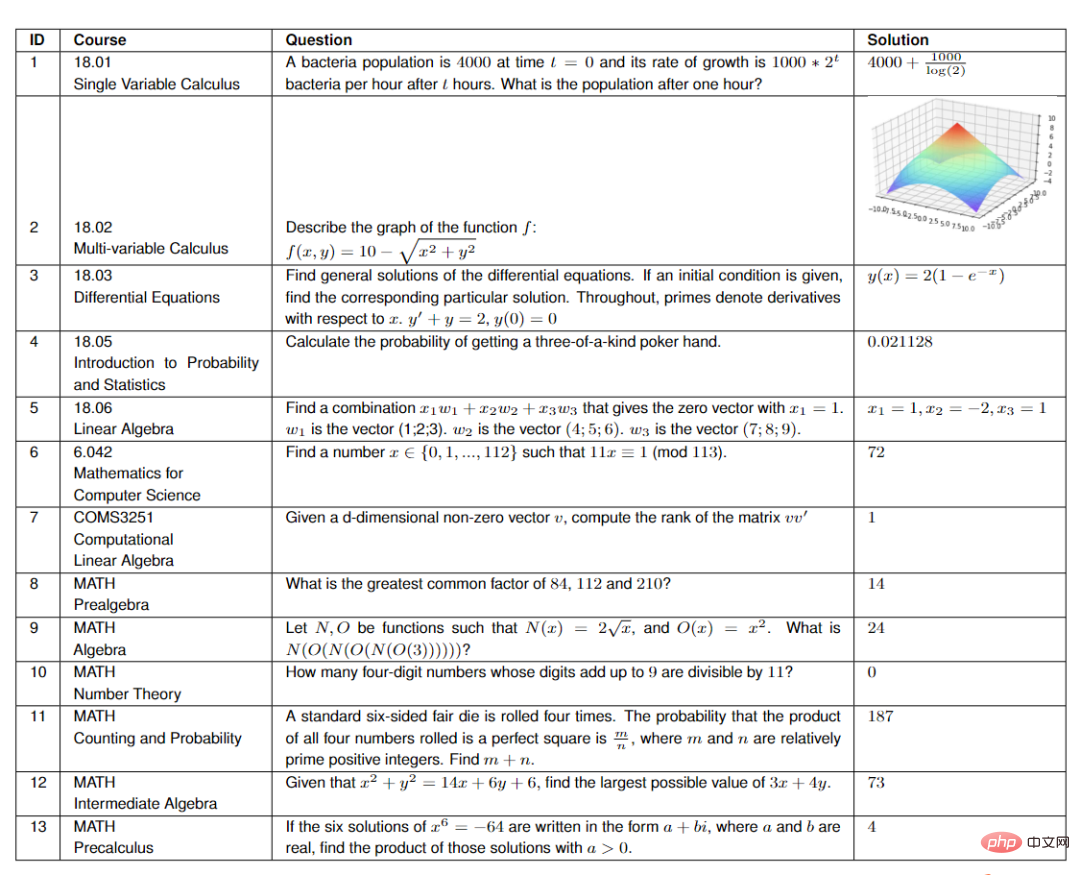

L'auteur a sélectionné au hasard 25 questions dans chacun des sept cours du MIT, dont :

- 18.01 Calcul à variable unique

- 18.02 Calcul à plusieurs variables

- 18.03 Équations différentielles

- 18.05 Introduction aux probabilités et aux statistiques

- 18.06 Al linéaire gebra

- 6.042 Mathématiques informatiques

- COMS3251 Algèbre linéaire computationnelle de l'Université de Columbia

Pour l'ensemble de données MATH, les chercheurs ont étudié les données des six sujets de l'ensemble de données (Algèbre, Comptage et Probabilités, Algèbre Intermédiaire, Théorie des Nombres, Algèbre Préliminaire ) 15 questions sélectionnées au hasard en algèbre et pré-universitaire).

Afin de vérifier que les résultats générés par le modèle ne sont pas surajustés aux données d'entraînement, les chercheurs ont choisi le cours COMS3251 qui n'a pas été publié sur Internet pour vérifier les résultats générés.

Workflow

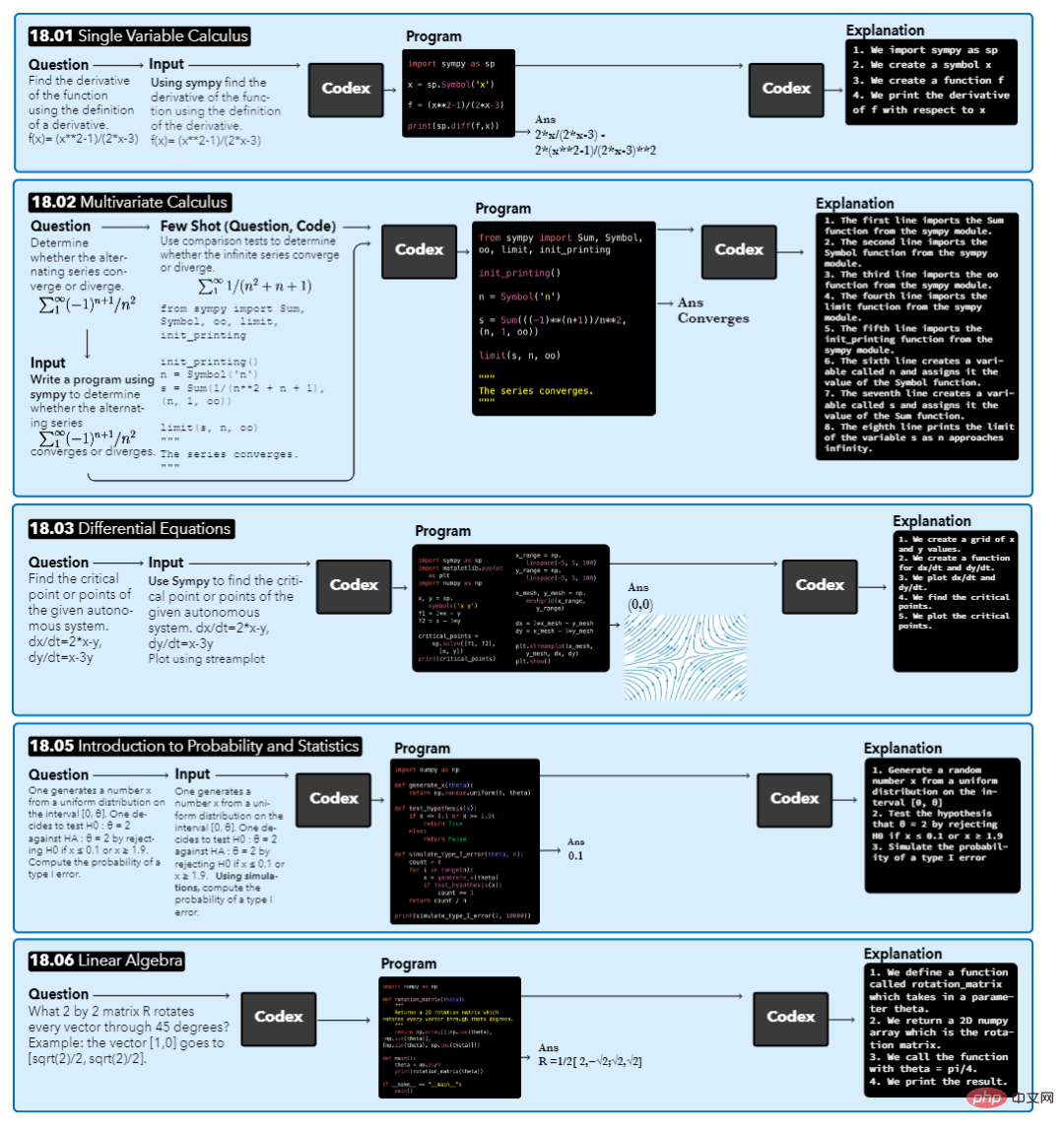

Le modèle prend une question de cours en entrée, puis effectue une augmentation automatique avec le contexte, aboutit à un programme synthétisé et génère enfin la réponse et l'explication générée.

Pour différentes questions, les résultats de sortie peuvent être différents. Par exemple, la réponse à 18.01 est une équation, la réponse à 18.02 est une valeur booléenne, les réponses à 18.03 et 18.06 sont un graphique ou un vecteur et la réponse à 18.05. est une valeur numérique.

Lorsque vous recevez une question, la première étape consiste à laisser le modèle trouver le contexte pertinent de la question. Les chercheurs se sont principalement concentrés sur le programme Python généré par Codex, ils ont donc ajouté le texte « écrire un programme » avant la question et ont placé le texte entre trois guillemets du programme Python, faisant semblant d'être une docstring dans le programme.

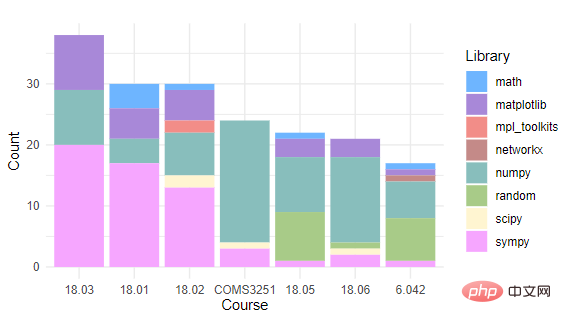

Après avoir généré le programme, une invite Codex est nécessaire pour spécifier les bibliothèques à importer. L'auteur a choisi d'ajouter la chaîne "use sympy" avant la question comme contexte, spécifiant que le programme synthétisé pour résoudre le problème doit utiliser ce package.

En comptant les packages de programmation Python utilisés par chaque cours, vous pouvez constater que tous les cours utilisent NumPy et Sympy. Matplotlib n'est utilisé que dans les cours comportant des problèmes nécessitant un traçage. Environ la moitié des cours utilisent les mathématiques, le hasard et SciPy. Pendant le fonctionnement réel, les chercheurs ont uniquement spécifié les packages SymPy ou liés aux dessins à importer, et les autres packages importés ont été automatiquement synthétisés.

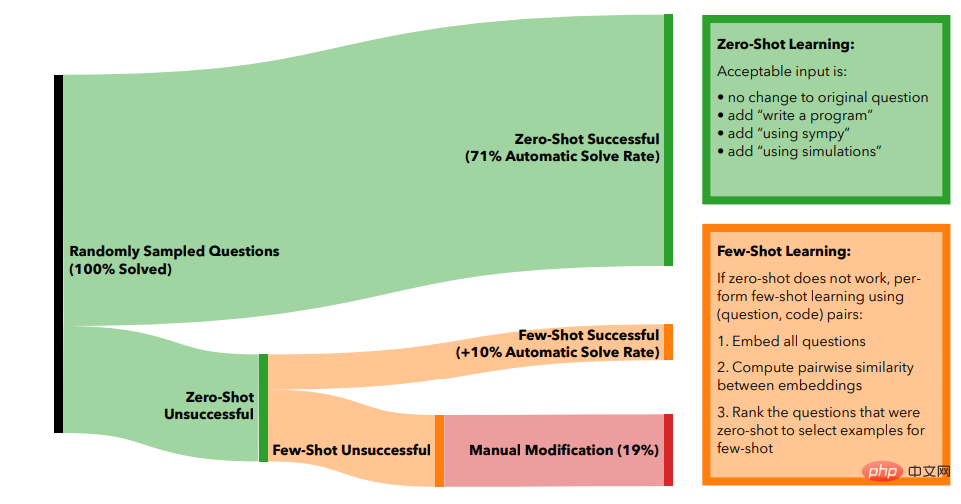

Grâce à l'apprentissage Zero-shot, c'est-à-dire que 71 % des problèmes peuvent être automatiquement résolus en utilisant uniquement l'amélioration automatique du problème d'origine.

Si un problème ne peut pas être résolu, les chercheurs essaient d'utiliser l'apprentissage en quelques étapes pour résoudre ces problèmes.

Utilisez d'abord le moteur d'intégration text-similarity-babbag-001 d'OpenAI pour obtenir l'intégration à 2048 dimensions de tous les problèmes, puis utilisez les calculs de similarité cosinus sur tous les vecteurs pour trouver les problèmes non résolus qui sont les plus similaires aux problèmes résolus. Enfin, le problème le plus similaire et son code correspondant sont utilisés comme exemples succincts du nouveau problème.

Si le code généré ne donne pas la bonne réponse, ajoutez une autre paire question-code résolue, en utilisant à chaque fois la prochaine question résolue similaire.

En pratique, on peut constater que l'utilisation de jusqu'à 5 exemples pour un apprentissage en quelques coups a le meilleur effet, et le nombre total de problèmes qui peuvent être automatiquement résolus passe de 71 % d'un apprentissage en plusieurs coups à 81 % de quelques-uns. -apprentissage par tir.

Pour résoudre les 19 % de problèmes restants, des éditeurs humains doivent intervenir.

Les chercheurs ont d'abord collecté toutes les questions et ont constaté que la plupart de ces questions étaient vagues ou contenaient des informations redondantes, telles que des références à des personnages de films ou à des événements actuels, etc. Les questions devaient être triées pour en extraire l'essence.

Le tri des questions consiste principalement à supprimer les informations redondantes, à décomposer les structures de phrases longues en composants plus petits et à convertir les invites au format de programmation.

Une autre situation qui nécessite une intervention manuelle est que la réponse à une question nécessite plusieurs étapes de dessin pour être expliquée, c'est-à-dire que le Codex doit être invité de manière interactive jusqu'à ce que l'effet de visualisation souhaité soit obtenu.

En plus de générer des réponses, le modèle devrait également être capable d'expliquer les raisons des réponses. Les chercheurs ont utilisé le mot d'invite "Voici ce que fait le code ci-dessus : 1" pour guider le modèle à générer. résultats d'explication étape par étape.

Une fois que vous avez répondu aux questions, l'étape suivante consiste à utiliser le Codex pour générer de nouvelles questions pour chaque cours.

Les chercheurs ont créé une liste numérotée de questions rédigées par les élèves de chaque classe. Cette liste a été coupée après un nombre aléatoire de questions, et les résultats ont été utilisés pour inciter le Codex à générer la question suivante.

Ce processus est répété jusqu'à ce que suffisamment de nouvelles questions aient été créées pour chaque cours.

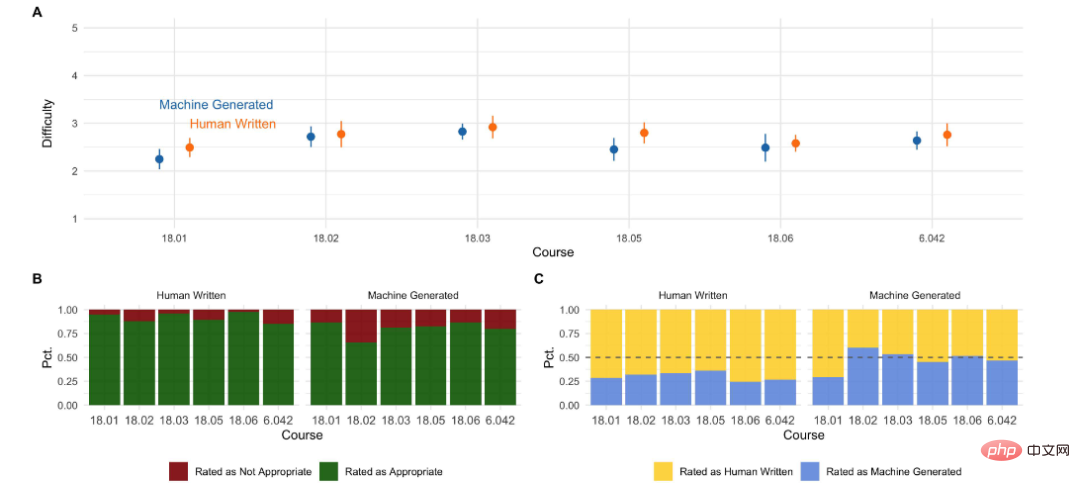

Pour évaluer les questions générées, les chercheurs ont interrogé des étudiants du MIT qui avaient suivi ces cours ou leurs équivalents pour comparer la qualité et la difficulté des questions générées automatiquement aux cours originaux.

D'après les résultats de l'enquête auprès des étudiants, nous pouvons voir :

- La qualité de la notation automatique est déjà comparable à celle des questions humaines.

- En termes de difficulté, les questions humaines sont plus adaptées aux questions de cours, tandis que les résultats générés par la machine sont légèrement plus difficiles ;

- Plus de la moitié des cours ; Les étudiants peuvent voir que les questions sont générées par le modèle. Le plus proche des humains est le cours 18.01

Référence :

https://www.reddit.com/r/artificial/comments/v8liqh/researchers_built_a_neural_network_that_not_only. /

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

Un nouveau paradigme de programmation, quand Spring Boot rencontre OpenAI

Feb 01, 2024 pm 09:18 PM

Un nouveau paradigme de programmation, quand Spring Boot rencontre OpenAI

Feb 01, 2024 pm 09:18 PM

En 2023, la technologie de l’IA est devenue un sujet brûlant et a un impact énorme sur diverses industries, notamment dans le domaine de la programmation. Les gens sont de plus en plus conscients de l’importance de la technologie de l’IA, et la communauté Spring ne fait pas exception. Avec l’évolution continue de la technologie GenAI (Intelligence Artificielle Générale), il est devenu crucial et urgent de simplifier la création d’applications dotées de fonctions d’IA. Dans ce contexte, « SpringAI » a émergé, visant à simplifier le processus de développement d'applications fonctionnelles d'IA, en le rendant simple et intuitif et en évitant une complexité inutile. Grâce à « SpringAI », les développeurs peuvent plus facilement créer des applications dotées de fonctions d'IA, ce qui les rend plus faciles à utiliser et à exploiter.

Choisir le modèle d'intégration qui correspond le mieux à vos données : un test comparatif des intégrations multilingues OpenAI et open source

Feb 26, 2024 pm 06:10 PM

Choisir le modèle d'intégration qui correspond le mieux à vos données : un test comparatif des intégrations multilingues OpenAI et open source

Feb 26, 2024 pm 06:10 PM

OpenAI a récemment annoncé le lancement de son modèle d'intégration de dernière génération, embeddingv3, qui, selon eux, est le modèle d'intégration le plus performant avec des performances multilingues plus élevées. Ce lot de modèles est divisé en deux types : les plus petits text-embeddings-3-small et les plus puissants et plus grands text-embeddings-3-large. Peu d'informations sont divulguées sur la façon dont ces modèles sont conçus et formés, et les modèles ne sont accessibles que via des API payantes. Il existe donc de nombreux modèles d'intégration open source. Mais comment ces modèles open source se comparent-ils au modèle open source open source ? Cet article comparera empiriquement les performances de ces nouveaux modèles avec des modèles open source. Nous prévoyons de créer une donnée

Travail posthume de l'équipe OpenAI Super Alignment : deux grands modèles jouent à un jeu et le résultat devient plus compréhensible

Jul 19, 2024 am 01:29 AM

Travail posthume de l'équipe OpenAI Super Alignment : deux grands modèles jouent à un jeu et le résultat devient plus compréhensible

Jul 19, 2024 am 01:29 AM

Si la réponse donnée par le modèle d’IA est incompréhensible du tout, oseriez-vous l’utiliser ? À mesure que les systèmes d’apprentissage automatique sont utilisés dans des domaines de plus en plus importants, il devient de plus en plus important de démontrer pourquoi nous pouvons faire confiance à leurs résultats, et quand ne pas leur faire confiance. Une façon possible de gagner confiance dans le résultat d'un système complexe est d'exiger que le système produise une interprétation de son résultat qui soit lisible par un humain ou un autre système de confiance, c'est-à-dire entièrement compréhensible au point que toute erreur possible puisse être trouvé. Par exemple, pour renforcer la confiance dans le système judiciaire, nous exigeons que les tribunaux fournissent des avis écrits clairs et lisibles qui expliquent et soutiennent leurs décisions. Pour les grands modèles de langage, nous pouvons également adopter une approche similaire. Cependant, lorsque vous adoptez cette approche, assurez-vous que le modèle de langage génère

L'éditeur Zed basé sur Rust est open source, avec prise en charge intégrée d'OpenAI et GitHub Copilot

Feb 01, 2024 pm 02:51 PM

L'éditeur Zed basé sur Rust est open source, avec prise en charge intégrée d'OpenAI et GitHub Copilot

Feb 01, 2024 pm 02:51 PM

Auteur丨Compilé par TimAnderson丨Produit par Noah|51CTO Technology Stack (WeChat ID : blog51cto) Le projet d'éditeur Zed est encore en phase de pré-version et a été open source sous licences AGPL, GPL et Apache. L'éditeur offre des performances élevées et plusieurs options assistées par l'IA, mais n'est actuellement disponible que sur la plate-forme Mac. Nathan Sobo a expliqué dans un article que dans la base de code du projet Zed sur GitHub, la partie éditeur est sous licence GPL, les composants côté serveur sont sous licence AGPL et la partie GPUI (GPU Accelerated User) l'interface) adopte la Licence Apache2.0. GPUI est un produit développé par l'équipe Zed

N'attendez pas OpenAI, attendez qu'Open-Sora soit entièrement open source

Mar 18, 2024 pm 08:40 PM

N'attendez pas OpenAI, attendez qu'Open-Sora soit entièrement open source

Mar 18, 2024 pm 08:40 PM

Il n'y a pas si longtemps, OpenAISora est rapidement devenu populaire grâce à ses étonnants effets de génération vidéo. Il s'est démarqué parmi la foule de modèles vidéo littéraires et est devenu le centre d'attention mondiale. Suite au lancement du processus de reproduction d'inférence de formation Sora avec une réduction des coûts de 46 % il y a 2 semaines, l'équipe Colossal-AI a entièrement open source le premier modèle de génération vidéo d'architecture de type Sora au monde "Open-Sora1.0", couvrant l'ensemble processus de formation, y compris le traitement des données, tous les détails de la formation et les poids des modèles, et joignez-vous aux passionnés mondiaux de l'IA pour promouvoir une nouvelle ère de création vidéo. Pour un aperçu, jetons un œil à une vidéo d'une ville animée générée par le modèle « Open-Sora1.0 » publié par l'équipe Colossal-AI. Ouvrir-Sora1.0

Microsoft et OpenAI prévoient d'investir 100 millions de dollars dans des robots humanoïdes ! Les internautes appellent Musk

Feb 01, 2024 am 11:18 AM

Microsoft et OpenAI prévoient d'investir 100 millions de dollars dans des robots humanoïdes ! Les internautes appellent Musk

Feb 01, 2024 am 11:18 AM

Il a été révélé que Microsoft et OpenAI investissaient de grosses sommes d’argent dans une start-up de robots humanoïdes au début de l’année. Parmi eux, Microsoft prévoit d'investir 95 millions de dollars et OpenAI investira 5 millions de dollars. Selon Bloomberg, la société devrait lever un total de 500 millions de dollars au cours de ce cycle, et sa valorisation pré-monétaire pourrait atteindre 1,9 milliard de dollars. Qu'est-ce qui les attire ? Jetons d’abord un coup d’œil aux réalisations de cette entreprise en matière de robotique. Ce robot est tout argenté et noir, et son apparence ressemble à l'image d'un robot dans un blockbuster de science-fiction hollywoodien : maintenant, il met une capsule de café dans la machine à café : si elle n'est pas placée correctement, elle s'ajustera sans aucun problème. télécommande humaine : Cependant, après un certain temps, une tasse de café peut être emportée et dégustée : Avez-vous des membres de votre famille qui l'ont reconnu ? Oui, ce robot a été créé il y a quelque temps.

Les performances d'exécution locale du service Embedding dépassent celles d'OpenAI Text-Embedding-Ada-002, ce qui est très pratique !

Apr 15, 2024 am 09:01 AM

Les performances d'exécution locale du service Embedding dépassent celles d'OpenAI Text-Embedding-Ada-002, ce qui est très pratique !

Apr 15, 2024 am 09:01 AM

Ollama est un outil super pratique qui vous permet d'exécuter facilement des modèles open source tels que Llama2, Mistral et Gemma localement. Dans cet article, je vais vous présenter comment utiliser Ollama pour vectoriser du texte. Si vous n'avez pas installé Ollama localement, vous pouvez lire cet article. Dans cet article, nous utiliserons le modèle nomic-embed-text[2]. Il s'agit d'un encodeur de texte qui surpasse OpenAI text-embedding-ada-002 et text-embedding-3-small sur les tâches à contexte court et à contexte long. Démarrez le service nomic-embed-text lorsque vous avez installé avec succès o

Soudain! OpenAI licencie un allié d'Ilya pour fuite d'informations présumée

Apr 15, 2024 am 09:01 AM

Soudain! OpenAI licencie un allié d'Ilya pour fuite d'informations présumée

Apr 15, 2024 am 09:01 AM

Soudain! OpenAI a licencié des gens, la raison : une fuite d'informations suspectée. L’un d’eux est Léopold Aschenbrenner, un allié du scientifique en chef disparu Ilya et un membre principal de l’équipe Superalignment. L'autre personne n'est pas simple non plus : il s'agit de Pavel Izmailov, chercheur au sein de l'équipe d'inférence du LLM, qui a également travaillé dans l'équipe de super alignement. On ne sait pas exactement quelles informations les deux hommes ont divulguées. Après que la nouvelle ait été révélée, de nombreux internautes se sont dits « assez choqués » : j'ai vu le message d'Aschenbrenner il n'y a pas longtemps et j'ai senti qu'il était en pleine ascension dans sa carrière. Certains internautes sur la photo pensent : OpenAI a perdu Aschenbrenner, je