Périphériques technologiques

Périphériques technologiques

IA

IA

Quatre techniques de validation croisée que vous devez apprendre en apprentissage automatique

Quatre techniques de validation croisée que vous devez apprendre en apprentissage automatique

Quatre techniques de validation croisée que vous devez apprendre en apprentissage automatique

Introduction

Envisagez de créer un modèle sur un ensemble de données, mais il échoue sur des données invisibles.

Nous ne pouvons pas simplement adapter un modèle à nos données d’entraînement et attendre qu’il fonctionne parfaitement sur des données réelles et invisibles.

Ceci est un exemple de surapprentissage, notre modèle a extrait tous les modèles et bruits dans les données d'entraînement. Pour éviter que cela ne se produise, nous avons besoin d'un moyen de garantir que notre modèle a capturé la majorité des modèles et ne capte pas chaque élément de bruit dans les données (faible biais et faible variance). L'une des nombreuses techniques permettant de résoudre ce problème est la validation croisée.

Comprendre la validation croisée

Supposons que dans un ensemble de données spécifique, nous ayons 1000 enregistrements et que train_test_split() soit exécuté dessus. En supposant que nous disposions de 70 % de données d'entraînement et de 30 % de données de test random_state = 0, ces paramètres donnent une précision de 85 %. Maintenant, si nous définissons random_state = 50, disons que la précision s'améliore à 87 %.

Cela signifie que si nous continuons à choisir des valeurs de précision pour différents random_state, des fluctuations se produiront. Pour éviter cela, une technique appelée validation croisée entre en jeu.

Types de validation croisée

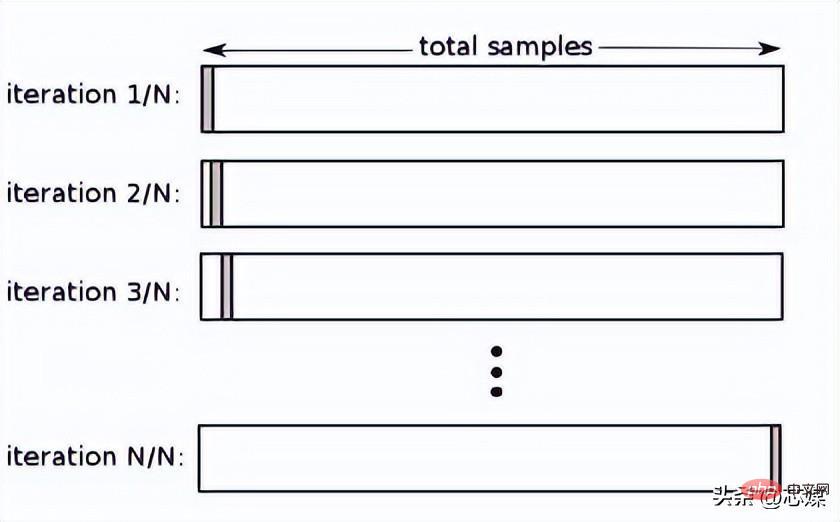

Leave One Out Cross Validation (LOOCV)

Dans LOOCV, nous sélectionnons 1 point de données comme test et toutes les données restantes seront les données d'entraînement lors de la première itération. Dans la prochaine itération, nous sélectionnerons le point de données suivant comme test et le reste comme données d'entraînement. Nous répéterons cela pour l'ensemble de l'ensemble de données afin que le dernier point de données soit sélectionné comme test lors de l'itération finale.

Normalement, pour calculer le R² de validation croisée pour une procédure itérative de validation croisée, vous calculez les scores R² pour chaque itération et prenez leur moyenne.

Bien que cela conduise à des estimations fiables et impartiales des performances du modèle, sa réalisation est coûteuse en termes de calcul.

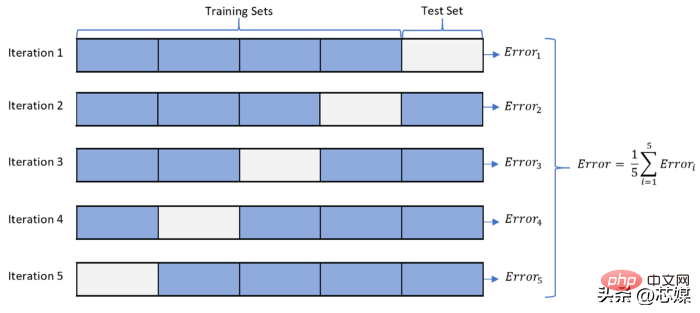

2. Validation croisée K-fold

Dans K-fold CV, nous divisons l'ensemble de données en k sous-ensembles (appelés plis), puis nous préparons la formation, mais partons un sous-ensemble (k-1) pour l'évaluation du modèle entraîné.

Supposons que nous ayons 1000 enregistrements et que notre K=5. Cette valeur K signifie que nous avons 5 itérations. Le nombre de points de données pour la première itération à prendre en compte pour les données de test est de 1 000/5 = 200 dès le début. Ensuite, pour la prochaine itération, les 200 points de données suivants seront considérés comme des tests, et ainsi de suite.

Pour calculer la précision globale, nous calculons la précision pour chaque itération puis prenons la moyenne.

La précision minimale que nous pouvons obtenir à partir de ce processus sera la précision la plus faible produite sur toutes les itérations, et de même, la précision maximale sera la précision la plus élevée produite sur toutes les itérations.

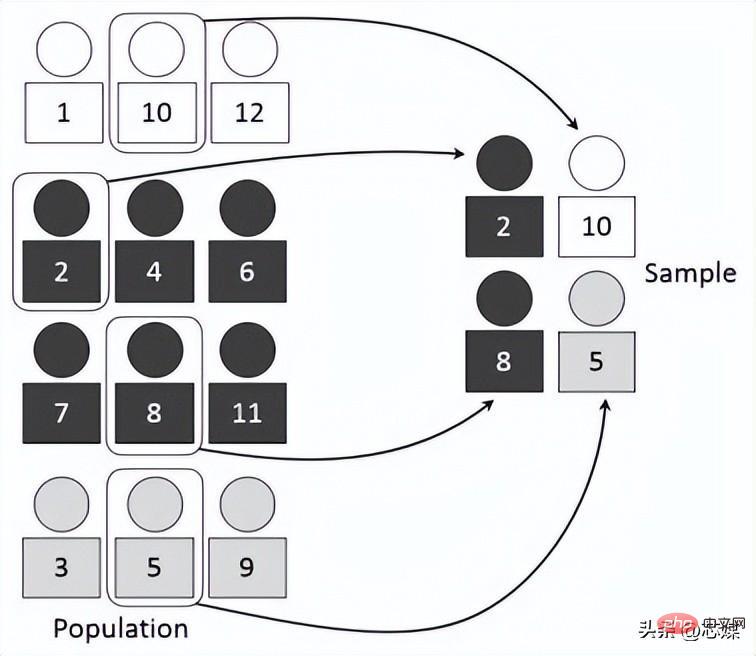

3 Le rapport entre est le même à chaque pli que dans l'ensemble de données complet. Supposons que nous ayons 1 000 enregistrements, qui contiennent 600 oui et 400 non. Par conséquent, dans chaque expérience, cela garantit que les échantillons aléatoires intégrés à la formation et aux tests sont remplis de telle manière qu'au moins certaines instances de chaque classe seront présentes dans les divisions de formation et de test.

4.

Validation croisée des séries chronologiques

Dans le CV des séries chronologiques, il existe une série d'ensembles de tests, chaque ensemble de tests contient une observation. L'ensemble d'entraînement correspondant contient uniquement les observations survenues avant l'observation qui a formé l'ensemble de test. Par conséquent, les observations futures ne peuvent pas être utilisées pour construire des prédictions. La précision de la prédiction est calculée en faisant la moyenne de l'ensemble de test. Ce processus est parfois appelé « évaluation de l'origine de la prévision glissante », car « l'origine » sur laquelle la prévision est basée est reportée dans le temps.

Conclusion

Dans l'apprentissage automatique, nous ne voulons généralement pas de l'algorithme ou du modèle qui fonctionne le mieux sur l'ensemble d'entraînement. Au lieu de cela, nous voulons un modèle qui fonctionne bien sur l'ensemble de test et un modèle qui fonctionne systématiquement bien compte tenu des nouvelles données d'entrée. La validation croisée est une étape critique pour garantir que nous pouvons identifier de tels algorithmes ou modèles.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Cet article vous amènera à comprendre SHAP : explication du modèle pour l'apprentissage automatique

Jun 01, 2024 am 10:58 AM

Cet article vous amènera à comprendre SHAP : explication du modèle pour l'apprentissage automatique

Jun 01, 2024 am 10:58 AM

Dans les domaines de l’apprentissage automatique et de la science des données, l’interprétabilité des modèles a toujours été au centre des préoccupations des chercheurs et des praticiens. Avec l'application généralisée de modèles complexes tels que l'apprentissage profond et les méthodes d'ensemble, la compréhension du processus décisionnel du modèle est devenue particulièrement importante. Explainable AI|XAI contribue à renforcer la confiance dans les modèles d'apprentissage automatique en augmentant la transparence du modèle. L'amélioration de la transparence des modèles peut être obtenue grâce à des méthodes telles que l'utilisation généralisée de plusieurs modèles complexes, ainsi que les processus décisionnels utilisés pour expliquer les modèles. Ces méthodes incluent l'analyse de l'importance des caractéristiques, l'estimation de l'intervalle de prédiction du modèle, les algorithmes d'interprétabilité locale, etc. L'analyse de l'importance des fonctionnalités peut expliquer le processus de prise de décision du modèle en évaluant le degré d'influence du modèle sur les fonctionnalités d'entrée. Estimation de l’intervalle de prédiction du modèle

Implémentation d'algorithmes d'apprentissage automatique en C++ : défis et solutions courants

Jun 03, 2024 pm 01:25 PM

Implémentation d'algorithmes d'apprentissage automatique en C++ : défis et solutions courants

Jun 03, 2024 pm 01:25 PM

Les défis courants rencontrés par les algorithmes d'apprentissage automatique en C++ incluent la gestion de la mémoire, le multithread, l'optimisation des performances et la maintenabilité. Les solutions incluent l'utilisation de pointeurs intelligents, de bibliothèques de threads modernes, d'instructions SIMD et de bibliothèques tierces, ainsi que le respect des directives de style de codage et l'utilisation d'outils d'automatisation. Des cas pratiques montrent comment utiliser la bibliothèque Eigen pour implémenter des algorithmes de régression linéaire, gérer efficacement la mémoire et utiliser des opérations matricielles hautes performances.

Cinq écoles d'apprentissage automatique que vous ne connaissez pas

Jun 05, 2024 pm 08:51 PM

Cinq écoles d'apprentissage automatique que vous ne connaissez pas

Jun 05, 2024 pm 08:51 PM

L'apprentissage automatique est une branche importante de l'intelligence artificielle qui donne aux ordinateurs la possibilité d'apprendre à partir de données et d'améliorer leurs capacités sans être explicitement programmés. L'apprentissage automatique a un large éventail d'applications dans divers domaines, de la reconnaissance d'images et du traitement du langage naturel aux systèmes de recommandation et à la détection des fraudes, et il change notre façon de vivre. Il existe de nombreuses méthodes et théories différentes dans le domaine de l'apprentissage automatique, parmi lesquelles les cinq méthodes les plus influentes sont appelées les « Cinq écoles d'apprentissage automatique ». Les cinq grandes écoles sont l’école symbolique, l’école connexionniste, l’école évolutionniste, l’école bayésienne et l’école analogique. 1. Le symbolisme, également connu sous le nom de symbolisme, met l'accent sur l'utilisation de symboles pour le raisonnement logique et l'expression des connaissances. Cette école de pensée estime que l'apprentissage est un processus de déduction inversée, à travers les connaissances existantes.

IA explicable : Expliquer les modèles IA/ML complexes

Jun 03, 2024 pm 10:08 PM

IA explicable : Expliquer les modèles IA/ML complexes

Jun 03, 2024 pm 10:08 PM

Traducteur | Revu par Li Rui | Chonglou Les modèles d'intelligence artificielle (IA) et d'apprentissage automatique (ML) deviennent aujourd'hui de plus en plus complexes, et le résultat produit par ces modèles est une boîte noire – impossible à expliquer aux parties prenantes. L'IA explicable (XAI) vise à résoudre ce problème en permettant aux parties prenantes de comprendre comment fonctionnent ces modèles, en s'assurant qu'elles comprennent comment ces modèles prennent réellement des décisions et en garantissant la transparence des systèmes d'IA, la confiance et la responsabilité pour résoudre ce problème. Cet article explore diverses techniques d'intelligence artificielle explicable (XAI) pour illustrer leurs principes sous-jacents. Plusieurs raisons pour lesquelles l’IA explicable est cruciale Confiance et transparence : pour que les systèmes d’IA soient largement acceptés et fiables, les utilisateurs doivent comprendre comment les décisions sont prises

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

L'ensemble de données ScienceAI Question Answering (QA) joue un rôle essentiel dans la promotion de la recherche sur le traitement du langage naturel (NLP). Des ensembles de données d'assurance qualité de haute qualité peuvent non seulement être utilisés pour affiner les modèles, mais également évaluer efficacement les capacités des grands modèles linguistiques (LLM), en particulier la capacité à comprendre et à raisonner sur les connaissances scientifiques. Bien qu’il existe actuellement de nombreux ensembles de données scientifiques d’assurance qualité couvrant la médecine, la chimie, la biologie et d’autres domaines, ces ensembles de données présentent encore certaines lacunes. Premièrement, le formulaire de données est relativement simple, et la plupart sont des questions à choix multiples. Elles sont faciles à évaluer, mais limitent la plage de sélection des réponses du modèle et ne peuvent pas tester pleinement la capacité du modèle à répondre aux questions scientifiques. En revanche, les questions et réponses ouvertes

Flash Attention est-il stable ? Meta et Harvard ont constaté que les écarts de poids de leur modèle fluctuaient de plusieurs ordres de grandeur.

May 30, 2024 pm 01:24 PM

Flash Attention est-il stable ? Meta et Harvard ont constaté que les écarts de poids de leur modèle fluctuaient de plusieurs ordres de grandeur.

May 30, 2024 pm 01:24 PM

MetaFAIR s'est associé à Harvard pour fournir un nouveau cadre de recherche permettant d'optimiser le biais de données généré lors de l'apprentissage automatique à grande échelle. On sait que la formation de grands modèles de langage prend souvent des mois et utilise des centaines, voire des milliers de GPU. En prenant comme exemple le modèle LLaMA270B, sa formation nécessite un total de 1 720 320 heures GPU. La formation de grands modèles présente des défis systémiques uniques en raison de l’ampleur et de la complexité de ces charges de travail. Récemment, de nombreuses institutions ont signalé une instabilité dans le processus de formation lors de la formation des modèles d'IA générative SOTA. Elles apparaissent généralement sous la forme de pics de pertes. Par exemple, le modèle PaLM de Google a connu jusqu'à 20 pics de pertes au cours du processus de formation. Le biais numérique est à l'origine de cette imprécision de la formation,

Algorithme de détection amélioré : pour la détection de cibles dans des images de télédétection optique haute résolution

Jun 06, 2024 pm 12:33 PM

Algorithme de détection amélioré : pour la détection de cibles dans des images de télédétection optique haute résolution

Jun 06, 2024 pm 12:33 PM

01Aperçu des perspectives Actuellement, il est difficile d'atteindre un équilibre approprié entre efficacité de détection et résultats de détection. Nous avons développé un algorithme YOLOv5 amélioré pour la détection de cibles dans des images de télédétection optique haute résolution, en utilisant des pyramides de caractéristiques multicouches, des stratégies de têtes de détection multiples et des modules d'attention hybrides pour améliorer l'effet du réseau de détection de cibles dans les images de télédétection optique. Selon l'ensemble de données SIMD, le mAP du nouvel algorithme est 2,2 % meilleur que YOLOv5 et 8,48 % meilleur que YOLOX, permettant ainsi d'obtenir un meilleur équilibre entre les résultats de détection et la vitesse. 02 Contexte et motivation Avec le développement rapide de la technologie de télédétection, les images de télédétection optique à haute résolution ont été utilisées pour décrire de nombreux objets à la surface de la Terre, notamment des avions, des voitures, des bâtiments, etc. Détection d'objets dans l'interprétation d'images de télédétection

Apprentissage automatique en C++ : un guide pour la mise en œuvre d'algorithmes d'apprentissage automatique courants en C++

Jun 03, 2024 pm 07:33 PM

Apprentissage automatique en C++ : un guide pour la mise en œuvre d'algorithmes d'apprentissage automatique courants en C++

Jun 03, 2024 pm 07:33 PM

En C++, la mise en œuvre d'algorithmes d'apprentissage automatique comprend : Régression linéaire : utilisée pour prédire des variables continues. Les étapes comprennent le chargement des données, le calcul des poids et des biais, la mise à jour des paramètres et la prédiction. Régression logistique : utilisée pour prédire des variables discrètes. Le processus est similaire à la régression linéaire, mais utilise la fonction sigmoïde pour la prédiction. Machine à vecteurs de support : un puissant algorithme de classification et de régression qui implique le calcul de vecteurs de support et la prédiction d'étiquettes.