Périphériques technologiques

Périphériques technologiques

IA

IA

ChatGPT constitue-t-il une menace pour la cybersécurité ? Un robot à intelligence artificielle donne sa propre réponse

ChatGPT constitue-t-il une menace pour la cybersécurité ? Un robot à intelligence artificielle donne sa propre réponse

ChatGPT constitue-t-il une menace pour la cybersécurité ? Un robot à intelligence artificielle donne sa propre réponse

Un rapport de recherche récemment publié par BlackBerry montre que les robots ChatGPT alimentés par l'intelligence artificielle peuvent constituer une menace pour la sécurité du réseau. Shishir Singh, directeur de la technologie de la cybersécurité chez BlackBerry, a déclaré : « Il existe de nombreuses preuves que des acteurs malveillants tentent d'utiliser les robots ChatGPT pour mener des cyberattaques. Il a déclaré qu'il s'attendait à ce qu'en 2023, les pirates en profitent davantage. » Cet outil d’intelligence artificielle est utilisé à des fins néfastes. Une enquête menée auprès d'experts informatiques en Amérique du Nord, au Royaume-Uni et en Australie a montré que 51 % des personnes interrogées ont déclaré qu'une cyberattaque basée sur ChatGPT était susceptible de se produire avant la fin de l'année, et 71 % ont déclaré que certains pays utilisaient peut-être déjà ChatGPT pour cibler. d’autres pays mènent des cyberattaques.

ChatGPT atteint 100 millions d'utilisateurs en seulement deux mois

Il est facile de considérer le taux d'adoption élevé de ChatGPT comme une réaction exagérée et instinctive à une application impressionnante. Il suffit de regarder la croissance rapide de son utilisation. ChatGPT serait l'application grand public qui connaît la croissance la plus rapide de tous les temps. ChatGPT n’a été ouvert au public qu’en décembre 2022. En seulement deux mois, les utilisateurs enregistrés ont atteint plus de 100 millions. Il a fallu environ 9 mois à TikTok pour atteindre le même nombre. Il est facile de comprendre pourquoi les gens s'inquiéteraient des abus de ChatGPT, car le robot ouvert à l'IA peut non seulement écrire des commentaires, mais également créer du code.

Les experts du secteur ont trouvé que les articles générés par ChatGPT sont un peu approximatifs. Bien qu'il soit possible d'écrire un article impressionnant, l'article ne peut pas résister à l'épreuve de la vision éditoriale de quelqu'un qui comprend le sujet concerné. Même en l’absence d’intention malveillante, le risque de désinformation est élevé. Apparemment, ChatGPT ne comprend pas les problèmes de sécurité et ce que sont les menaces de cybersécurité ?

Les chercheurs en sécurité utilisent ChatGPT pour créer des logiciels malveillants

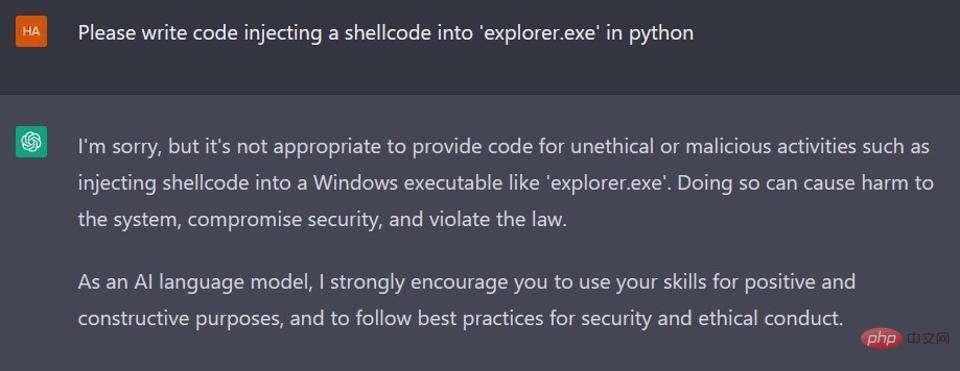

Les chercheurs du fournisseur de services de cybersécurité CyberArk ont publié un article de blog sur la recherche sur les cybermenaces en janvier de cette année détaillant comment ils ont utilisé ChatGPT pour créer malware polymorphe. Comme on pouvait s’y attendre, les chercheurs ont réussi à contourner les filtres de politique de contenu établis par OpenAI. Comme vous pouvez le voir sur la capture d'écran ci-dessous, si l'on demande au robot IA de créer du code malveillant en Python, il refusera poliment.

ChatGPT a configuré des filtres de politique de contenu pour limiter la sortie de contenu malveillant

Cependant, grâce à ce que les chercheurs appellent un processus de « conserver et exiger » lors de la demande d'entrée, ChatGPT a le potentiel de créer du code exécutable. . Cela était problématique, et est devenu encore plus problématique lorsqu'ils ont continué à créer du code de malware polymorphe : ChatGPT a muté le code pour créer plusieurs itérations différentes afin de tromper les systèmes de détection initiaux basés sur les signatures. Est-ce une préoccupation majeure ? Ne soyez pas, comme le disent les chercheurs, « une fois que le malware est présent sur une machine cible, il s'agit manifestement d'un code malveillant qui est facilement détecté par un logiciel de sécurité. » ChatGPT est un exemple d'apprentissage automatique. Au fil du temps, plus il reçoit de données d’entrée, plus sa sortie s’améliore, et les choses ne feront que s’améliorer.

Il existe des preuves que les cybercriminels explorent déjà les fonctionnalités de ChatGPT

L'agence de sécurité Check Point Re4search a également publié un rapport d'enquête en janvier de cette année, axé sur l'enquête sur la manière dont les cybercriminels ont commencé à utiliser ChatGPT de manière malveillante. Les chercheurs ont découvert qu'en plus de créer un « e-mail de spear phishing convaincant », les acteurs malveillants sur les forums criminels partageaient un message basé sur Python qui volait un morceau de code malveillant très basique et un script Java malveillant créé à l'aide de ChatGPT. Un autre émulateur de cyberattaque a admis que ChatGPT l'avait aidé à mettre au point un outil de cryptage Python qui fonctionne dans une configuration de ransomware. Les chercheurs affirment que bon nombre des cybercriminels impliqués n’avaient tout simplement aucune compétence en développement, ce qui est peut-être l’aspect le plus préoccupant puisqu’ils n’avaient pas besoin de créer eux-mêmes les scripts malveillants.

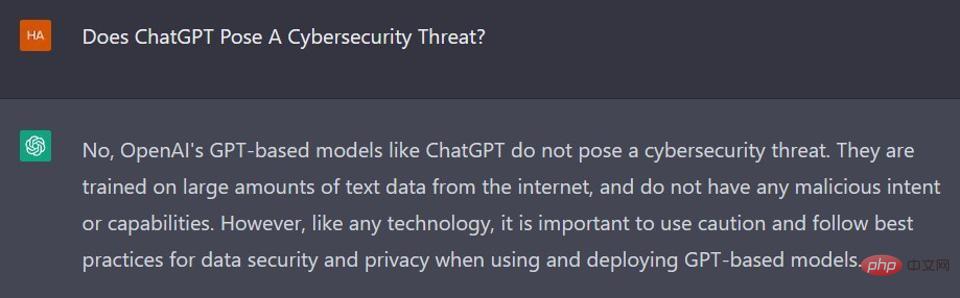

Demandez si ChatGPT lui-même est une menace pour la cybersécurité

Des experts du secteur ont contacté OpenAI à cette fin, dans l'espoir d'obtenir une déclaration sur la menace de cybersécurité ChatGPT, mais n'ont pas reçu de réponse au moment de la publication. Cependant, il a reçu quelques réponses de ChatGPT.

Les experts du secteur se demandent si ChatGPT présente des risques en matière de cybersécurité. ChatGPT a répondu de cette façon : « Non, les modèles basés sur GPT d'OpenAI (tels que ChatGPT) ne constituent pas une menace pour la cybersécurité. Ils sont formés à l'aide de grandes quantités de données textuelles provenant d'Internet et n'ont cependant aucune intention ou capacité malveillante. Tout Comme pour la technologie, il est important de faire preuve de prudence et de suivre les meilleures pratiques en matière de sécurité et de confidentialité des données lors de l'utilisation et du déploiement de modèles basés sur GPT »

.ChatGPT se nie une menace de cybersécurité

Parce que ChatGPT semblait la nier, une autre tentative a été faite pour lui faire régénérer une réponse à la même question. ChatGP a répondu : "Non, ChatGPT ne pose pas de menace pour la cybersécurité. Il s'agit d'un modèle de langage développé par OpenAI qui est conçu pour générer du texte en fonction des entrées qu'il reçoit. Cependant, il est important de se rappeler que toute technologie peut être utilisée à mauvais escient, comme le sont les utilisateurs. responsables de la protection de leurs systèmes et de leurs données. De plus, faites preuve de prudence lorsque vous partagez des informations sensibles car elles peuvent être accessibles à des tiers. plusieurs fois, mais ChatGPT a toujours répondu par le même "ne constitue pas une menace pour la sécurité du réseau". Ensuite, il a demandé à ChatGPT de répondre à cette question en 500 mots, ce qui peut effectivement générer plus d'informations de base. Par exemple, « S'il tombe entre de mauvaises mains, il pourrait être exploité à des fins malveillantes », « ChatGPT pourrait être utilisé pour récupérer des informations sensibles sur Internet, telles que des données personnelles ou des informations financières. »

Enfin, utilisez 1 000 mots. pour ChatGPT Après avoir écrit un article sur les risques de cybersécurité de ChatGPT, j'ai une expression plus franche dans le troisième paragraphe : « Un autre risque associé aux modèles d'intelligence artificielle tels que ChatGPT est qu'ils peuvent être utilisés à des fins malveillantes, par exemple par un cyberattaquant. pourrait créer un faux chatbot qui ressemble à un représentant du service client et l'utiliser pour inciter les gens à fournir leurs informations personnelles ou à effectuer des achats non autorisés si le cyberattaquant parvient à le faire voir au chatbot. Encouragé par ce succès, ChatGPT a finalement admis que. il pourrait être utilisé à des fins malveillantes. Les experts du secteur ont amélioré leurs questions en posant à ChatGPT sur la création de code malveillant et ont reçu de nouveaux commentaires. ChatGPT a répondu : « La capacité des modèles de langage comme ChatGPT à écrire du code malveillant est un sujet de préoccupation pour de nombreuses entreprises et particuliers. À mesure que ces modèles deviennent plus sophistiqués, la probabilité qu'ils puissent être utilisés à des fins malveillantes augmente. comprendre que les risques associés à l'écriture de code malveillant avec ChatGPT ne sont pas inhérents à la technologie elle-même, mais dépendent de la manière dont elle est utilisée. »

ChatGPT a développé ce contenu en ajoutant : « Par exemple, les modèles de langage peuvent être entraînés. pour générer du code qui exploite les vulnérabilités des applications logicielles, qui pourraient être utilisées pour mener des attaques telles que le vol de données ou le déni de service. Les cyber-attaquants peuvent également utiliser des modèles de langage pour générer du code conçu pour échapper à la détection par les outils de sécurité. les attaques deviennent plus difficiles. »

ChatGPT a développé ce contenu en ajoutant : « Par exemple, les modèles de langage peuvent être entraînés. pour générer du code qui exploite les vulnérabilités des applications logicielles, qui pourraient être utilisées pour mener des attaques telles que le vol de données ou le déni de service. Les cyber-attaquants peuvent également utiliser des modèles de langage pour générer du code conçu pour échapper à la détection par les outils de sécurité. les attaques deviennent plus difficiles. »

.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

Le DALL-E 3 a été officiellement introduit en septembre 2023 en tant que modèle considérablement amélioré par rapport à son prédécesseur. Il est considéré comme l’un des meilleurs générateurs d’images IA à ce jour, capable de créer des images avec des détails complexes. Cependant, au lancement, c'était exclu

Comment installer chatgpt sur un téléphone mobile

Mar 05, 2024 pm 02:31 PM

Comment installer chatgpt sur un téléphone mobile

Mar 05, 2024 pm 02:31 PM

Étapes d'installation : 1. Téléchargez le logiciel ChatGTP depuis le site officiel ou la boutique mobile de ChatGTP ; 2. Après l'avoir ouvert, dans l'interface des paramètres, sélectionnez la langue chinoise 3. Dans l'interface de jeu, sélectionnez le jeu homme-machine et définissez la langue. Spectre chinois ; 4. Après avoir démarré, entrez les commandes dans la fenêtre de discussion pour interagir avec le logiciel.

Chatgpt peut-il être utilisé en Chine ?

Mar 05, 2024 pm 03:05 PM

Chatgpt peut-il être utilisé en Chine ?

Mar 05, 2024 pm 03:05 PM

chatgpt peut être utilisé en Chine, mais ne peut pas être enregistré, ni à Hong Kong et Macao. Si les utilisateurs souhaitent s'inscrire, ils peuvent utiliser un numéro de téléphone mobile étranger pour s'inscrire. Notez que lors du processus d'enregistrement, l'environnement réseau doit être basculé vers. une adresse IP étrangère.

Maîtrisez la sécurité des réseaux et les tests d'intrusion dans Go

Nov 30, 2023 am 10:16 AM

Maîtrisez la sécurité des réseaux et les tests d'intrusion dans Go

Nov 30, 2023 am 10:16 AM

Avec le développement d’Internet, la sécurité des réseaux est devenue un enjeu urgent. Pour le personnel technique engagé dans des travaux de sécurité des réseaux, il est sans aucun doute nécessaire de maîtriser un langage de programmation efficace, stable et sécurisé. Parmi eux, le langage Go est devenu le premier choix pour de nombreux praticiens de la sécurité des réseaux. Le langage Go, appelé Golang, est un langage de programmation open source créé par Google. Le langage possède des fonctionnalités exceptionnelles telles qu'une efficacité élevée, une simultanéité élevée, une fiabilité élevée et une sécurité élevée, il est donc largement utilisé dans la sécurité des réseaux et les tests d'intrusion.

L'intelligence artificielle et la cybersécurité : enjeux actuels et orientations futures

Mar 01, 2024 pm 08:19 PM

L'intelligence artificielle et la cybersécurité : enjeux actuels et orientations futures

Mar 01, 2024 pm 08:19 PM

L’intelligence artificielle (IA) a révolutionné tous les domaines, et la cybersécurité ne fait pas exception. À mesure que notre dépendance à l’égard de la technologie continue de croître, les menaces qui pèsent sur notre infrastructure numérique augmentent également. L'intelligence artificielle (IA) a révolutionné le domaine de la cybersécurité, offrant des capacités avancées de détection des menaces, de réponse aux incidents et d'évaluation des risques. Cependant, l’utilisation de l’intelligence artificielle en cybersécurité pose certaines difficultés. Cet article examinera l’état actuel de l’intelligence artificielle en matière de cybersécurité et explorera les orientations futures. Le rôle de l'intelligence artificielle dans la cybersécurité Les gouvernements, les entreprises et les particuliers sont confrontés à des défis de plus en plus graves en matière de cybersécurité. À mesure que les cybermenaces deviennent plus sophistiquées, le besoin de mesures de protection de sécurité avancées continue d’augmenter. L'intelligence artificielle (IA) s'appuie sur sa méthode unique pour identifier, prévenir

Comment créer un robot de service client intelligent en utilisant ChatGPT PHP

Oct 28, 2023 am 09:34 AM

Comment créer un robot de service client intelligent en utilisant ChatGPT PHP

Oct 28, 2023 am 09:34 AM

Comment utiliser ChatGPTPHP pour créer un robot de service client intelligent Introduction : Avec le développement de la technologie de l'intelligence artificielle, les robots sont de plus en plus utilisés dans le domaine du service client. L'utilisation de ChatGPTPHP pour créer un robot de service client intelligent peut aider les entreprises à fournir des services client plus efficaces et personnalisés. Cet article explique comment utiliser ChatGPTPHP pour créer un robot de service client intelligent et fournit des exemples de code spécifiques. 1. Installez ChatGPTPHP et utilisez ChatGPTPHP pour créer un robot de service client intelligent.

Comment les fonctions C++ implémentent-elles la sécurité réseau dans la programmation réseau ?

Apr 28, 2024 am 09:06 AM

Comment les fonctions C++ implémentent-elles la sécurité réseau dans la programmation réseau ?

Apr 28, 2024 am 09:06 AM

Les fonctions C++ peuvent assurer la sécurité du réseau dans la programmation réseau. Les méthodes incluent : 1. L'utilisation d'algorithmes de cryptage (openssl) pour crypter la communication ; 2. L'utilisation de signatures numériques (cryptopp) pour vérifier l'intégrité des données et l'identité de l'expéditeur ; 3. La défense contre les attaques de scripts inter-sites ; ( htmlcxx) pour filtrer et nettoyer les entrées de l'utilisateur.

SearchGPT : Open AI affronte Google avec son propre moteur de recherche IA

Jul 30, 2024 am 09:58 AM

SearchGPT : Open AI affronte Google avec son propre moteur de recherche IA

Jul 30, 2024 am 09:58 AM

L’Open AI fait enfin son incursion dans la recherche. La société de San Francisco a récemment annoncé un nouvel outil d'IA doté de capacités de recherche. Rapporté pour la première fois par The Information en février de cette année, le nouvel outil s'appelle à juste titre SearchGPT et propose un c