Périphériques technologiques

Périphériques technologiques

IA

IA

Le nombre de paramètres est de 1/50, Meta publie un modèle de 11 milliards de paramètres, battant Google PaLM

Le nombre de paramètres est de 1/50, Meta publie un modèle de 11 milliards de paramètres, battant Google PaLM

Le nombre de paramètres est de 1/50, Meta publie un modèle de 11 milliards de paramètres, battant Google PaLM

Nous pouvons comprendre les grands modèles de langage (LLM) comme de petits échantillons d'apprenants, qui peuvent apprendre de nouvelles tâches avec peu d'exemples, ou même apprendre avec seulement des instructions simples, où la quantité de paramètres de modèle et de données de formation est limitée. L'augmentation de la taille est la clé à la capacité de généralisation du modèle. Cette amélioration des LLM est due à une plus grande puissance de calcul et des capacités de stockage. Intuitivement, des capacités d'inférence améliorées conduiront à une meilleure généralisation et donc à moins d'apprentissage d'échantillons. Cependant, il n'est pas clair dans quelle mesure un apprentissage efficace sur petits échantillons nécessite une connaissance approfondie des paramètres du modèle.

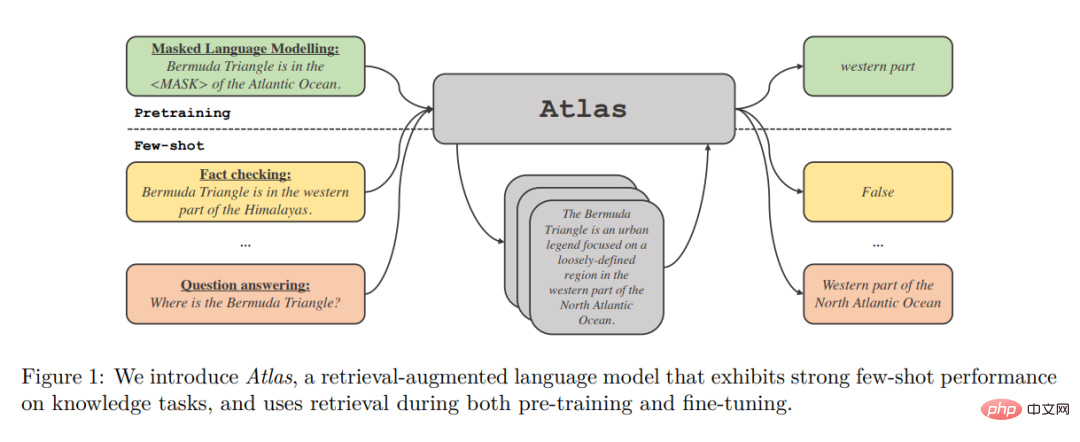

Jusqu’à présent, les modèles d’amélioration de la récupération n’ont pas démontré de capacités convaincantes d’apprentissage sur de petits échantillons. Dans cet article, des chercheurs de Meta AI Research et d'autres institutions se demandent si l'apprentissage sur petits échantillons nécessite que le modèle stocke une grande quantité d'informations dans ses paramètres, et si le stockage peut être dissocié de la généralisation. Ils ont proposé Atlas, qui est un type de modèle de langage amélioré par la récupération et doté de fortes capacités d'apprentissage sur petits échantillons, même si le nombre de paramètres est inférieur à celui des autres modèles d'apprentissage puissants actuels sur petits échantillons.

Le modèle utilise le stockage non paramétrique, c'est-à-dire l'utilisation d'un récupérateur neuronal basé sur de grandes sources de connaissances externes non statiques pour améliorer le modèle de langage paramétrique. Outre leurs capacités de stockage, ces architectures sont attrayantes en raison de leurs avantages en termes d’adaptabilité, d’interprétabilité et d’efficacité.

La récupération par Atlas des documents pertinents est un outil de récupération de densité générale basé sur le double encodeur Contriever architecture. Récupérez les fichiers associés en fonction du contexte actuel lors de la récupération des fichiers. Les documents récupérés ainsi que le contexte actuel sont traités par un modèle séquence à séquence qui utilise l'architecture Fusion-in-Decoder pour générer la sortie correspondante.

Les auteurs étudient l'impact de différentes techniques sur les performances de la formation Atlas sur des ensembles de données sur petits échantillons sur une gamme de tâches en aval, y compris la réponse aux questions et la vérification des faits. L'étude a révélé que la composante conjointe de pré-formation est cruciale pour les performances d'un petit échantillon, et les auteurs ont évalué de nombreuses tâches et programmes de pré-formation existants et nouveaux. Atlas présente de solides performances en aval dans des environnements de petit échantillon et riches en ressources.

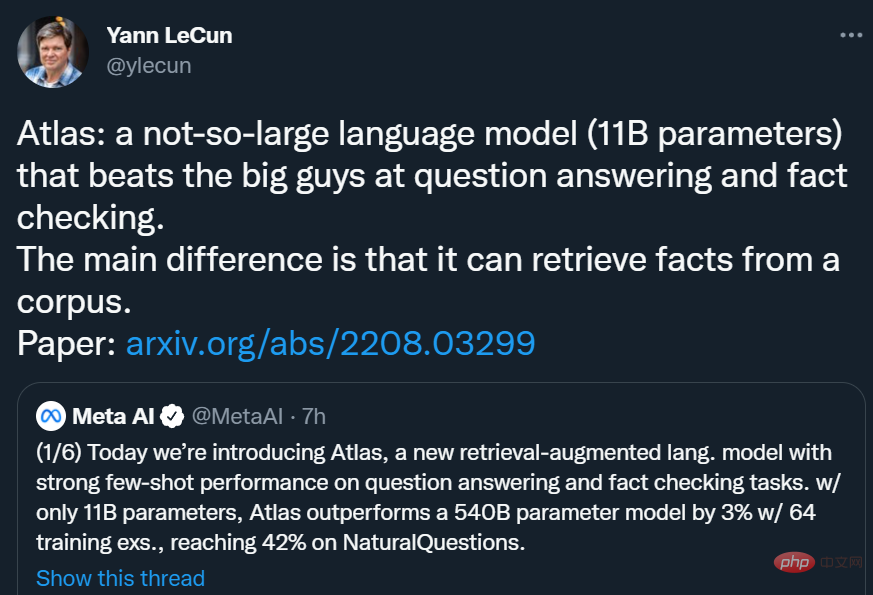

Avec seulement 11B de paramètres, Atlas utilise 64 exemples d'entraînement pour atteindre une précision de 42,4 % sur NaturalQuestions (NQ), soit près de 3 points de pourcentage de plus que le modèle de paramètres 540B PaLM (39,6 %) et est le meilleur au monde. . Dans le paramètre Ensemble de données (Complet), le taux de précision est de 64,0 %.

Yann LeCun a déclaré : Atlas est un modèle de langage pas trop gros (paramètres 11B) qui bat les « grands » en matière de questions/réponses et de vérification des faits. La principale différence d’Atlas est qu’il peut récupérer des faits à partir d’un corpus.

Yann LeCun a déclaré : Atlas est un modèle de langage pas trop gros (paramètres 11B) qui bat les « grands » en matière de questions/réponses et de vérification des faits. La principale différence d’Atlas est qu’il peut récupérer des faits à partir d’un corpus.

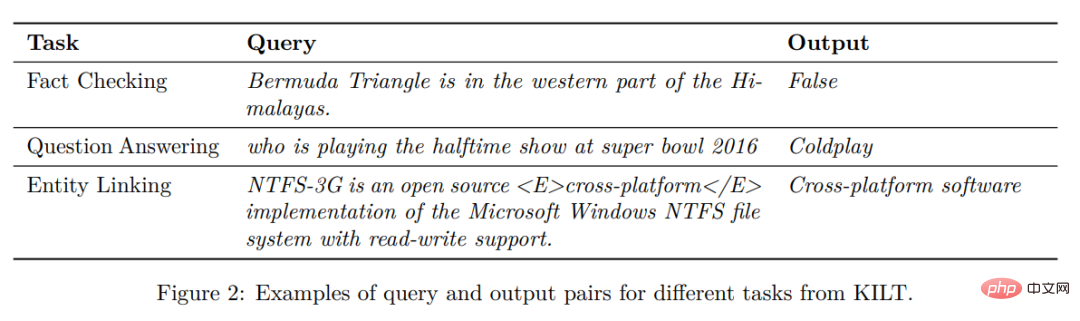

Présentation de la méthode Atlas suit un cadre texte-texte. Cela signifie que le cadre général de toutes les tâches est le suivant : le système prend une requête de texte en entrée et génère une sortie de texte. Par exemple, dans le cas de tâches de questions et réponses, la requête correspond à une question et le modèle doit générer une réponse. Dans le cas de tâches de classification, la requête correspond à la saisie de texte et le modèle génère des étiquettes de classe, c'est-à-dire les mots correspondant aux étiquettes. Le benchmark KILT de la figure 2 donne plus d'exemples de tâches en aval. De nombreuses tâches de traitement du langage naturel nécessitent des connaissances, et Atlas vise à améliorer les modèles texte-texte standard grâce à la récupération, car la récupération peut être essentielle à la capacité du modèle à apprendre dans des scénarios sur petits échantillons.

Atlas suit un cadre texte-texte. Cela signifie que le cadre général de toutes les tâches est le suivant : le système prend une requête de texte en entrée et génère une sortie de texte. Par exemple, dans le cas de tâches de questions et réponses, la requête correspond à une question et le modèle doit générer une réponse. Dans le cas de tâches de classification, la requête correspond à la saisie de texte et le modèle génère des étiquettes de classe, c'est-à-dire les mots correspondant aux étiquettes. Le benchmark KILT de la figure 2 donne plus d'exemples de tâches en aval. De nombreuses tâches de traitement du langage naturel nécessitent des connaissances, et Atlas vise à améliorer les modèles texte-texte standard grâce à la récupération, car la récupération peut être essentielle à la capacité du modèle à apprendre dans des scénarios sur petits échantillons.

Architecture Le modèle Atlas est basé sur deux sous-modèles : le retriever et le modèle de langage. Lors de l'exécution d'une tâche, de la réponse aux questions à la génération d'articles Wikipédia, le modèle récupère d'abord les k principaux documents pertinents d'un grand corpus de texte via un outil d'extraction. Ces documents, ainsi que la requête, sont ensuite transmis en entrée au modèle de langage, qui génère une sortie. Le récupérateur et le modèle de langage sont tous deux basés sur des réseaux de transformateurs pré-entraînés, qui sont décrits en détail ci-dessous.

Le modèle Atlas est basé sur deux sous-modèles : le retriever et le modèle de langage. Lors de l'exécution d'une tâche, de la réponse aux questions à la génération d'articles Wikipédia, le modèle récupère d'abord les k principaux documents pertinents d'un grand corpus de texte via un outil d'extraction. Ces documents, ainsi que la requête, sont ensuite transmis en entrée au modèle de langage, qui génère une sortie. Le récupérateur et le modèle de langage sont tous deux basés sur des réseaux de transformateurs pré-entraînés, qui sont décrits en détail ci-dessous.

Récupération : le module de récupération d'Atlas est basé sur Contriever, une technologie de récupération d'informations basée sur l'intégration de densité continue. Contriever utilise une architecture à double encodeur dans laquelle les requêtes et les documents sont intégrés indépendamment par des encodeurs de transformateur. Une mutualisation moyenne est appliquée à la sortie de la dernière couche pour obtenir une représentation vectorielle de chaque requête ou document. Ensuite, en calculant le produit scalaire des intégrations mutuelles entre la requête et chaque document, leurs scores de similarité sont obtenus. Le modèle Contriever est pré-entraîné à l'aide de la perte contrastive MoCo et utilise uniquement des données non supervisées. L'un des avantages des récupérateurs de densité est que les encodeurs de requêtes et de documents peuvent être formés sans annotations de documents à l'aide de techniques standard telles que la descente de gradient et la distillation.

Modèle de langage : pour le modèle de langage, Atlas s'appuie sur l'architecture séquence à séquence T5. Le modèle s'appuie également sur les modifications Fusion-in-Decoder du modèle séquence à séquence et traite chaque document indépendamment dans l'encodeur. Le modèle concatène ensuite les sorties des encodeurs correspondant à différents documents et effectue une attention croisée sur une seule séquence dans le décodeur. Le modèle connecte la requête à chaque document dans l'encodeur. Une autre façon de traiter les documents récupérés dans un modèle de langage consiste à concaténer la requête et tous les documents et à utiliser cette longue séquence comme entrée dans le modèle. Mais cette méthode est moins évolutive, c'est-à-dire qu'elle ne s'adaptera pas à mesure que le nombre de documents augmente, car le mécanisme d'auto-attention de l'encodeur conduira à une complexité temporelle de O(n^2) (où n est le nombre de documents). documents ).

Résultats expérimentaux

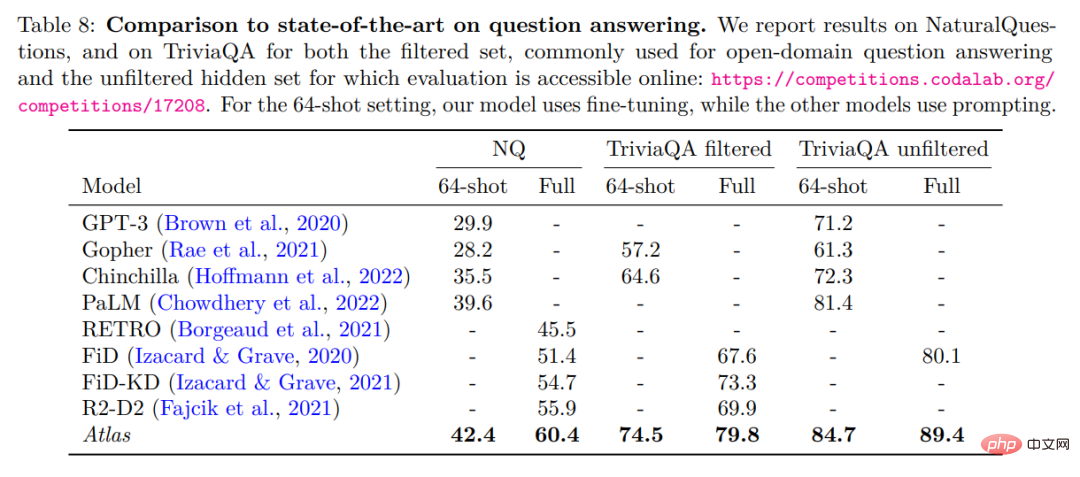

Les auteurs évaluent Atlas sur deux critères de réponse aux questions en domaine ouvert, NaturalQuestions et TriviaQA. Et un petit ensemble de données de 64 échantillons et un ensemble de formation complet ont été utilisés pour comparer avec les travaux antérieurs. La comparaison détaillée est présentée dans le tableau ci-dessous.

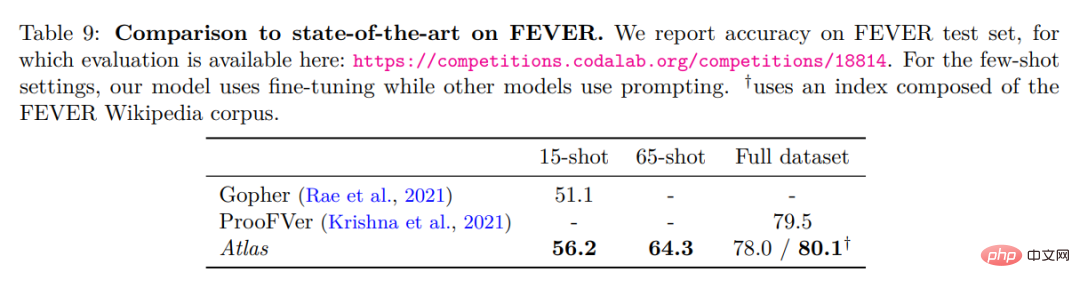

Meilleure performance en 64 questions et réponses de NaturalQuestions et TriviaQA. Il surpasse notamment les modèles plus grands (PaLM) ou les modèles nécessitant plus de calculs d’entraînement (Chinchilla). Atlas peut également obtenir des résultats optimaux en utilisant l'ensemble complet d'entraînement, par exemple en augmentant la précision des NaturalQuestions de 55,9 % à 60,4 %. Ce résultat a été obtenu avec les paramètres par défaut d'Atlas, en utilisant un index composé de CCNet et du corpus Wikipédia de décembre 2021. Le tableau ci-dessous présente les résultats des tests sur l'ensemble de données de vérification des faits FEVER.

Atlas Dans le cas de 64 coups, les échantillons d'entraînement sont échantillonnés à partir de l'ensemble d'entraînement complet. Atlas a atteint une précision de 64,3 %. Dans le cas de 15 tirs, 5 échantillons sont uniformément échantillonnés dans chaque classe. Par rapport aux résultats de Gopher, la précision d'Atlas est de 56,2 %, soit 5,1 points de pourcentage de plus que celle de Gopher. Le modèle Atlas a été affiné sur l'ensemble complet de la formation et a atteint une précision de 78 %, soit 1,5 % de moins que ProoFVer. ProoFVer utilise une architecture spécialisée pour former les récupérateurs avec des annotations au niveau des phrases et est fourni par le corpus Wikipédia publié avec FEVER, tandis qu'Atlas récupère à partir de CCNet et du dump Wikipédia de décembre 2021. Lorsqu'on lui a donné un indice constitué du corpus Wikipédia FEVER, Atlas a atteint un niveau optimal de 80,1 %.

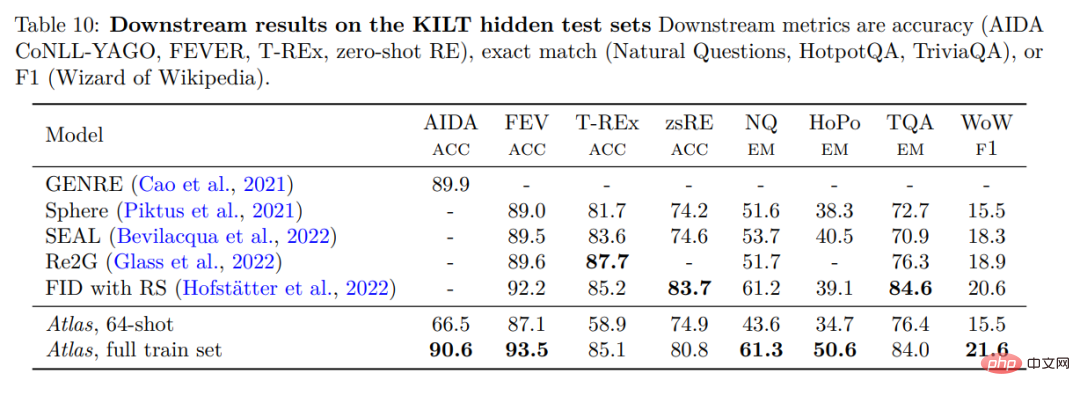

Pour vérifier les performances d'Atlas, Atlas a été évalué sur KILT, un benchmark composé de plusieurs tâches différentes à forte intensité de connaissances. Le tableau ci-dessous montre les résultats sur l'ensemble de test.

Atlas 64-shot surpasse de loin les algorithmes aléatoires dans les expériences et est même à égalité avec certains modèles affinés du classement. Par exemple, sur FEVER, Atlas 64-shot n'a que 2 à 2,5 points de retard sur Sphere, SEAL et Re2G, tandis que sur Zero-shot RE, il surpasse Sphere et SEAL. Sur l’ensemble de données complet, les performances d’Atlas se situent à 3 % près du meilleur modèle dans 3 ensembles de données, mais elles sont les meilleures dans les 5 ensembles de données restants.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L’IA change effectivement les mathématiques. Récemment, Tao Zhexuan, qui a prêté une attention particulière à cette question, a transmis le dernier numéro du « Bulletin de l'American Mathematical Society » (Bulletin de l'American Mathematical Society). En se concentrant sur le thème « Les machines changeront-elles les mathématiques ? », de nombreux mathématiciens ont exprimé leurs opinions. L'ensemble du processus a été plein d'étincelles, intense et passionnant. L'auteur dispose d'une équipe solide, comprenant Akshay Venkatesh, lauréat de la médaille Fields, le mathématicien chinois Zheng Lejun, l'informaticien de l'Université de New York Ernest Davis et de nombreux autres universitaires bien connus du secteur. Le monde de l’IA a radicalement changé. Vous savez, bon nombre de ces articles ont été soumis il y a un an.

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Les performances de JAX, promu par Google, ont dépassé celles de Pytorch et TensorFlow lors de récents tests de référence, se classant au premier rang sur 7 indicateurs. Et le test n’a pas été fait sur le TPU présentant les meilleures performances JAX. Bien que parmi les développeurs, Pytorch soit toujours plus populaire que Tensorflow. Mais à l’avenir, des modèles plus volumineux seront peut-être formés et exécutés sur la base de la plate-forme JAX. Modèles Récemment, l'équipe Keras a comparé trois backends (TensorFlow, JAX, PyTorch) avec l'implémentation native de PyTorch et Keras2 avec TensorFlow. Premièrement, ils sélectionnent un ensemble de

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

La détection de cibles est un problème relativement mature dans les systèmes de conduite autonome, parmi lesquels la détection des piétons est l'un des premiers algorithmes à être déployés. Des recherches très complètes ont été menées dans la plupart des articles. Cependant, la perception de la distance à l’aide de caméras fisheye pour une vue panoramique est relativement moins étudiée. En raison de la distorsion radiale importante, la représentation standard du cadre de délimitation est difficile à mettre en œuvre dans les caméras fisheye. Pour alléger la description ci-dessus, nous explorons les conceptions étendues de boîtes englobantes, d'ellipses et de polygones généraux dans des représentations polaires/angulaires et définissons une métrique de segmentation d'instance mIOU pour analyser ces représentations. Le modèle fisheyeDetNet proposé avec une forme polygonale surpasse les autres modèles et atteint simultanément 49,5 % de mAP sur l'ensemble de données de la caméra fisheye Valeo pour la conduite autonome.

Les dernières nouvelles de l'Université d'Oxford ! Mickey : correspondance d'images 2D en 3D SOTA ! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Les dernières nouvelles de l'Université d'Oxford ! Mickey : correspondance d'images 2D en 3D SOTA ! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Lien du projet écrit devant : https://nianticlabs.github.io/mickey/ Étant donné deux images, la pose de la caméra entre elles peut être estimée en établissant la correspondance entre les images. En règle générale, ces correspondances sont 2D à 2D et nos poses estimées sont à échelle indéterminée. Certaines applications, telles que la réalité augmentée instantanée, à tout moment et en tout lieu, nécessitent une estimation de pose des métriques d'échelle, elles s'appuient donc sur des estimateurs de profondeur externes pour récupérer l'échelle. Cet article propose MicKey, un processus de correspondance de points clés capable de prédire les correspondances métriques dans l'espace d'une caméra 3D. En apprenant la correspondance des coordonnées 3D entre les images, nous sommes en mesure de déduire des métriques relatives.