Périphériques technologiques

Périphériques technologiques

IA

IA

Le premier jour de 2023, veuillez consulter le résumé de fin d'année de ChatGPT !

Le premier jour de 2023, veuillez consulter le résumé de fin d'année de ChatGPT !

Le premier jour de 2023, veuillez consulter le résumé de fin d'année de ChatGPT !

L’émergence de ChatGPT pourrait bien être l’avancée la plus marquante de l’IA au cours du second semestre 2022, même si elle n’est peut-être pas la plus technique.

Il n'y a pas si longtemps, lors du NeurIPS 2022 qui s'est tenu à la Nouvelle-Orléans, les rumeurs sur GPT-4 étaient interminables. Dans le même temps, OpenAI est également devenu le centre d'intérêt des médias.

OpenAI a annoncé un nouveau modèle dans la série GPT-3 de modèles de langage d'IA à grande échelle : text-davinci-003, qui fait partie de sa "série GPT-3.5", qui peut traiter des instructions plus complexes et générer du contenu de meilleure qualité et plus long pour améliorer les performances.

Le nouveau modèle est construit sur InstructGPT, utilisant l'apprentissage par renforcement avec retour humain pour mieux aligner le modèle de langage avec les instructions humaines.

DaVinci-003 est un véritable modèle d'apprentissage par renforcement avec rétroaction humaine (RLHF) qui utilise un réglage fin supervisé sur des démonstrations humaines et des échantillons de modèles à score élevé pour améliorer la qualité de la génération. "

En tant qu'autre partie de la "série GPT-3.5", OpenAI a publié une première démonstration de ChatGPT. La société a affirmé que ce modèle de conversation interactive peut non seulement répondre à un grand nombre de questions de suivi, mais également Admettez vos erreurs, remettez en question les prémisses de questions incorrectes et rejetez les demandes de questions inappropriées.

OpenAI a déclaré dans un article de blog que la publication de recherche de ChatGPT est "la dernière étape dans le déploiement itératif d'OpenAI de systèmes d'IA de plus en plus sûrs et utiles. Elle s'inspire de déploiements de modèles antérieurs tels que GPT-3 et Codex" De nombreuses leçons apprises, les résultats de sortie nuisibles et irréalistes sont considérablement réduits en tirant parti de l'apprentissage par renforcement avec feedback humain (RLHF)

De plus, ChatGPT souligne dans la formation qu'il s'agit d'un modèle d'apprentissage automatique, qu'il peut s'agir de éviter la controverse sur "la question de savoir si l'IA est consciente" provoquée il n'y a pas si longtemps par le chatbot LaMDA de Google.

Bien sûr, ChatGPT a aussi des limites.

Dans un article de blog, OpenAI détaille ses limites, notamment le fait que parfois les réponses peuvent sembler raisonnables mais sont en réalité incorrectes ou absurdes.

"Résoudre ce problème est très difficile car (1) il n'y a actuellement aucune garantie de sources fiables pendant la formation d'apprentissage par renforcement ; (2) le modèle de formation est plus prudent et rejettera les réponses qui pourraient être correctes. Problème ; ( 3) La formation supervisée peut induire le modèle en erreur car la réponse idéale dépend de ce que le modèle sait, et non de ce que le démonstrateur humain sait. "

Open AI a déclaré que ChatGPT " donne parfois des instructions nuisibles. Nous utilisons l'API pour avertir ou bloquer certains types de contenu dangereux, mais nous nous attendons à ce qu'il y ait des faux négatifs et positifs pour le moment et nous sommes très intéressés à recueillir les commentaires des utilisateurs pour nous aider dans notre travail en cours pour améliorer ce modèle. ".

Bien que ChatGPT puisse encore avoir de nombreux problèmes à améliorer, nous ne pouvons nier qu'avant les débuts de GPT-4, ChatGPT est toujours le modèle de langage à grande échelle de premier ordre.

Cependant, dans la communauté récente, il existe un nouveau modèle qui a suscité l'enthousiasme de chacun pour la discussion. Le plus important c'est qu'il soit open source.

Cette semaine, Philip Wang, développeur responsable de l'ingénierie inverse des systèmes d'IA à source fermée, notamment Make-A-Video de Meta, a publié PaLM+RLHF, un modèle de génération de texte qui se comporte de la même manière sur ChatGPT.

Adresse du code : https://github.com/lucidrains/PaLM-rlhf-pytorch

Ce système combine le grand modèle de langage PaLM de Google et l'apprentissage par renforcement avec la technologie de feedback humain (RLHF), créé un système qui peut accomplir presque toutes les tâches chez ChatGPT, y compris la rédaction d'e-mails et la suggestion de code informatique.

La puissance de PaLm + RLHF

Depuis sa sortie, ChatGPT a fait des vagues dans le monde de la technologie pour sa capacité à générer du texte haute définition de type humain et à répondre aux questions des utilisateurs de manière conversationnelle. Une tempête.

Bien qu'il s'agisse d'une avancée majeure dans les premières étapes du développement des chatbots, de nombreux fans dans le domaine de l'intelligence artificielle ont exprimé leurs inquiétudes quant à la nature fermée de ChatGPT.

À ce jour, le modèle ChatGPT reste propriétaire, ce qui signifie que son code sous-jacent ne peut pas être consulté par le public. Seul OpenAI sait vraiment comment il fonctionne et quelles données il traite. Ce manque de transparence peut avoir des conséquences considérables et affecter la confiance des utilisateurs à long terme.

De nombreux développeurs étaient impatients de créer une alternative open source, et maintenant, elle est enfin là. PaLM+RLHF est conçu spécifiquement pour le langage Python et peut être implémenté pour PyTorch.

Les développeurs peuvent entraîner PaLM aussi facilement qu'un transformateur autorégressif, puis utiliser les commentaires humains pour entraîner le modèle de récompense.

Comme ChatGPT, PaLM + RLHF est essentiellement un outil statistique de prédiction de mots. Lorsqu'il est alimenté par un grand nombre d'exemples issus des données de formation, tels que des publications de Reddit, des articles de presse et des livres électroniques, PaLM+RLHF apprend la probabilité qu'un mot apparaisse en fonction de modèles tels que le contexte sémantique du texte environnant.

Est-ce vraiment si parfait ?

Bien sûr, il existe encore un grand écart entre l'idéal et la réalité. PaLM + RLHF semble parfait, mais il existe également divers problèmes. Le plus gros problème est que les gens ne peuvent pas encore l'utiliser.

Pour lancer PaLM + RLHF, les utilisateurs doivent compiler des gigaoctets de texte obtenu à partir de diverses sources telles que des blogs, des réseaux sociaux, des articles de presse, des livres électroniques, etc.

Ces données sont introduites dans un modèle PaLm affiné qui générera plusieurs réponses. Par exemple, si vous demandez au modèle "Quelles sont les connaissances de base en économie ?", PaLm vous donnera des réponses telles que "L'économie est la science sociale qui étudie...".

Ensuite, le développeur demandera aux gens de classer les réponses générées par le modèle du meilleur au pire et de créer un modèle de récompense. Enfin, les classements sont utilisés pour former un « modèle de récompense », qui prend les réponses du modèle d’origine et les trie par ordre de préférence, filtrant la meilleure réponse pour une invite donnée.

Cependant, c'est un processus coûteux. La collecte de données de formation et la formation du modèle lui-même ne sont pas bon marché. PaLM possède 540 milliards de paramètres, qui constituent les parties du modèle de langage apprises à partir des données de formation. Une étude de 2020 a montré que le développement d’un modèle de génération de texte avec seulement 1,5 milliard de paramètres coûterait jusqu’à 1,6 million de dollars.

En juillet de cette année, afin de former le modèle open source Bloom avec 176 milliards de paramètres, les chercheurs de Hugging Face ont passé trois mois et utilisé 384 GPU NVIDIA A100. Chaque A100 coûte des milliers de dollars, ce qui n'est pas un coût qu'un utilisateur moyen peut se permettre.

De plus, même après avoir entraîné le modèle, exécuter un modèle de la taille de PaLM + RLHF n'est pas anodin. Bloom dispose d'un PC dédié avec huit GPU A100, et le GPT-3 de génération de texte d'OpenAI (avec environ 175 milliards de paramètres) coûte environ 87 000 $ par an.

Le chercheur en IA Sebastian Raschka souligne dans un article sur PaLM + RLHF que la mise à l'échelle des flux de développement nécessaires peut également être un défi.

"Même si quelqu'un vous donne 500 GPU pour entraîner ce modèle, vous devez toujours vous occuper de l'infrastructure et disposer d'un cadre logiciel capable de la gérer", a-t-il déclaré. "Bien que cela soit réalisable, cela nécessite actuellement beaucoup d'efforts." , Prenant la peine de former le modèle, PaLM + RLHF n'a pas actuellement la possibilité de remplacer ChatGPT.

Jusqu'à présent, il n'y a pas de date de sortie exacte pour PaLM + RLHF. Pour référence, il a fallu trois mois à Hugging Face pour former Bloom. En revanche, PaLM + RLHF, avec 540 milliards de paramètres, devra peut-être attendre 6 à 8 mois pour produire une version significative.

La bonne nouvelle est que jusqu'à présent, nous avons trois acteurs connus qui travaillent sur cette alternative open source à ChatGPT :

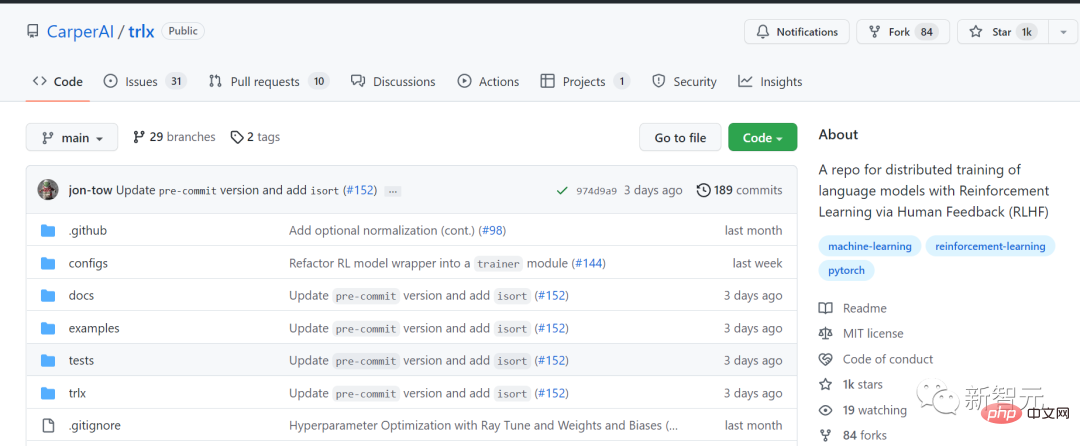

CarperAI

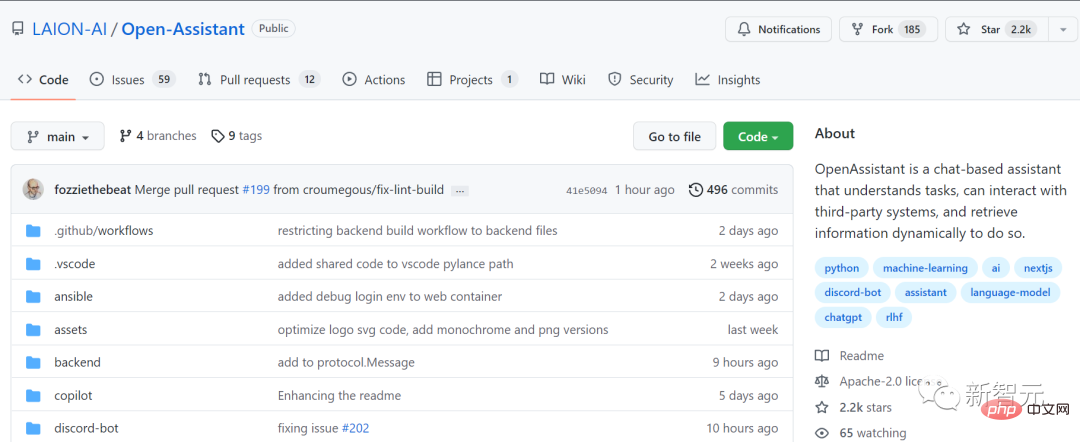

LAION

- Yannic Kilcher See More

- CarperAI prévoit de s'associer à EleutherAI et aux startups Scale AI et Hugging Face pour lancer le premier modèle d'IA prêt à l'emploi de type ChatGPT, entraîné avec des commentaires humains.

Adresse du code : https://github.com/CarperAI/trlx

LAION est l'organisation à but non lucratif qui a fourni l'ensemble de données initial pour Stable Diffusion. Elle a également été la pionnière d'un système à but non lucratif. utilisez Project pour répliquer ChatGPT avec la dernière technologie d'apprentissage automatique.

LAION est l'organisation à but non lucratif qui a fourni l'ensemble de données initial pour Stable Diffusion. Elle a également été la pionnière d'un système à but non lucratif. utilisez Project pour répliquer ChatGPT avec la dernière technologie d'apprentissage automatique.

Adresse du code : https://github.com/LAION-AI/Open-Assistant

LAION vise à créer un "futur assistant" qui peut non seulement rédiger des e-mails et postuler pour les emplois Vous pouvez également « effectuer un travail significatif, utiliser des API, rechercher des informations de manière dynamique, etc. » Il n'en est qu'à ses débuts, mais un projet avec des ressources associées a été mis en ligne sur GitHub il y a quelques semaines.

LAION vise à créer un "futur assistant" qui peut non seulement rédiger des e-mails et postuler pour les emplois Vous pouvez également « effectuer un travail significatif, utiliser des API, rechercher des informations de manière dynamique, etc. » Il n'en est qu'à ses débuts, mais un projet avec des ressources associées a été mis en ligne sur GitHub il y a quelques semaines.

Et GPT-4chan, créé par la célébrité YouTube et chercheur en IA Yannic Kilcher, ressemble plus à un expert en mauvaise bouche qui "sort de la boue et se tache".

Le "4chan" dans ce modèle est un forum anonyme en ligne américain. Parce que l'identité des internautes est anonyme, de nombreuses personnes n'ont pas peur et font toutes sortes de remarques politiquement incorrectes. Kilcher a officiellement utilisé les publications sur 4chan pour entraîner le modèle, et les résultats sont prévisibles.

Semblable au ton général du forum, les réponses de GPT-4chan étaient remplies de racisme, de sexisme et d'antisémitisme. De plus, Kilcher a également publié son modèle sous-jacent sur Hugging Face pour que d'autres puissent le télécharger. Cependant, sous la condamnation de nombreux chercheurs en IA, les autorités ont rapidement restreint l’accès des internautes au modèle.

Alors que nous attendons avec impatience l'émergence de modèles de langage plus open source, tout ce que nous pouvons faire maintenant, c'est attendre. Bien sûr, c'est aussi une bonne idée de continuer à utiliser ChatGPT gratuitement.

Il convient de noter qu'OpenAI est encore très en avance dans le développement avant qu'une version open source ne soit officiellement lancée. En 2023, GPT-4 est sans aucun doute ce qu’attendent avec impatience les passionnés d’IA du monde entier.

D'innombrables géants de l'IA ont fait leurs propres prédictions à ce sujet. Ces prédictions peuvent être bonnes ou mauvaises, mais comme l'a dit Sam Altman, COO d'OpenAI : "La réalisation de l'intelligence artificielle générale sera plus difficile que la plupart des gens ne l'imaginent." va changer tout ce que la plupart des gens imaginent."

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Quelle méthode est utilisée pour convertir les chaînes en objets dans vue.js?

Apr 07, 2025 pm 09:39 PM

Quelle méthode est utilisée pour convertir les chaînes en objets dans vue.js?

Apr 07, 2025 pm 09:39 PM

Lors de la conversion des chaînes en objets dans vue.js, JSON.Parse () est préféré pour les chaînes JSON standard. Pour les chaînes JSON non standard, la chaîne peut être traitée en utilisant des expressions régulières et réduisez les méthodes en fonction du format ou du codé décodé par URL. Sélectionnez la méthode appropriée en fonction du format de chaîne et faites attention aux problèmes de sécurité et d'encodage pour éviter les bogues.

Vue.js Comment convertir un tableau de type de chaîne en un tableau d'objets?

Apr 07, 2025 pm 09:36 PM

Vue.js Comment convertir un tableau de type de chaîne en un tableau d'objets?

Apr 07, 2025 pm 09:36 PM

Résumé: Il existe les méthodes suivantes pour convertir les tableaux de chaîne Vue.js en tableaux d'objets: Méthode de base: utilisez la fonction de carte pour convenir à des données formatées régulières. Gameplay avancé: l'utilisation d'expressions régulières peut gérer des formats complexes, mais ils doivent être soigneusement écrits et considérés. Optimisation des performances: Considérant la grande quantité de données, des opérations asynchrones ou des bibliothèques efficaces de traitement des données peuvent être utilisées. MEILLEUR PRATIQUE: Effacer le style de code, utilisez des noms de variables significatifs et des commentaires pour garder le code concis.

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

L'article présente le fonctionnement de la base de données MySQL. Tout d'abord, vous devez installer un client MySQL, tel que MySQLWorkBench ou le client de ligne de commande. 1. Utilisez la commande MySQL-UROot-P pour vous connecter au serveur et connecter avec le mot de passe du compte racine; 2. Utilisez Createdatabase pour créer une base de données et utilisez Sélectionner une base de données; 3. Utilisez CreateTable pour créer une table, définissez des champs et des types de données; 4. Utilisez InsertInto pour insérer des données, remettre en question les données, mettre à jour les données par mise à jour et supprimer les données par Supprimer. Ce n'est qu'en maîtrisant ces étapes, en apprenant à faire face à des problèmes courants et à l'optimisation des performances de la base de données que vous pouvez utiliser efficacement MySQL.

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Il existe de nombreuses raisons pour lesquelles la startup MySQL échoue, et elle peut être diagnostiquée en vérifiant le journal des erreurs. Les causes courantes incluent les conflits de port (vérifier l'occupation du port et la configuration de modification), les problèmes d'autorisation (vérifier le service exécutant les autorisations des utilisateurs), les erreurs de fichier de configuration (vérifier les paramètres des paramètres), la corruption du répertoire de données (restaurer les données ou reconstruire l'espace de la table), les problèmes d'espace de la table InNODB (vérifier les fichiers IBDATA1), la défaillance du chargement du plug-in (vérification du journal des erreurs). Lors de la résolution de problèmes, vous devez les analyser en fonction du journal d'erreur, trouver la cause profonde du problème et développer l'habitude de sauvegarder régulièrement les données pour prévenir et résoudre des problèmes.

Comment définir le délai de Vue Axios

Apr 07, 2025 pm 10:03 PM

Comment définir le délai de Vue Axios

Apr 07, 2025 pm 10:03 PM

Afin de définir le délai d'expiration de Vue Axios, nous pouvons créer une instance AxiOS et spécifier l'option Timeout: dans les paramètres globaux: vue.prototype. $ Axios = axios.create ({timeout: 5000}); Dans une seule demande: ce. $ axios.get ('/ api / utilisateurs', {timeout: 10000}).

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Traiter efficacement 7 millions d'enregistrements et créer des cartes interactives avec la technologie géospatiale. Cet article explore comment traiter efficacement plus de 7 millions d'enregistrements en utilisant Laravel et MySQL et les convertir en visualisations de cartes interactives. Exigences initiales du projet de défi: extraire des informations précieuses en utilisant 7 millions d'enregistrements dans la base de données MySQL. Beaucoup de gens considèrent d'abord les langages de programmation, mais ignorent la base de données elle-même: peut-il répondre aux besoins? La migration des données ou l'ajustement structurel est-il requis? MySQL peut-il résister à une charge de données aussi importante? Analyse préliminaire: les filtres et les propriétés clés doivent être identifiés. Après analyse, il a été constaté que seuls quelques attributs étaient liés à la solution. Nous avons vérifié la faisabilité du filtre et établi certaines restrictions pour optimiser la recherche. Recherche de cartes basée sur la ville

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Ingénieur backend à distance Emploi Vacant Société: Emplacement du cercle: Bureau à distance Type d'emploi: Salaire à temps plein: 130 000 $ - 140 000 $ Description du poste Participez à la recherche et au développement des applications mobiles Circle et des fonctionnalités publiques liées à l'API couvrant l'intégralité du cycle de vie de développement logiciel. Les principales responsabilités complètent indépendamment les travaux de développement basés sur RubyOnRails et collaborent avec l'équipe frontale React / Redux / Relay. Créez les fonctionnalités de base et les améliorations des applications Web et travaillez en étroite collaboration avec les concepteurs et le leadership tout au long du processus de conception fonctionnelle. Promouvoir les processus de développement positifs et hiérarchiser la vitesse d'itération. Nécessite plus de 6 ans de backend d'applications Web complexe

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

L'optimisation des performances MySQL doit commencer à partir de trois aspects: configuration d'installation, indexation et optimisation des requêtes, surveillance et réglage. 1. Après l'installation, vous devez ajuster le fichier my.cnf en fonction de la configuration du serveur, tel que le paramètre innodb_buffer_pool_size, et fermer query_cache_size; 2. Créez un index approprié pour éviter les index excessifs et optimiser les instructions de requête, telles que l'utilisation de la commande Explication pour analyser le plan d'exécution; 3. Utilisez le propre outil de surveillance de MySQL (ShowProcessList, Showstatus) pour surveiller la santé de la base de données, et sauvegarde régulièrement et organisez la base de données. Ce n'est qu'en optimisant en continu ces étapes que les performances de la base de données MySQL peuvent être améliorées.