Périphériques technologiques

Périphériques technologiques

IA

IA

Yann LeCun s'exprime sur Google Research : La communication ciblée existe depuis longtemps, où est votre innovation ?

Yann LeCun s'exprime sur Google Research : La communication ciblée existe depuis longtemps, où est votre innovation ?

Yann LeCun s'exprime sur Google Research : La communication ciblée existe depuis longtemps, où est votre innovation ?

Il y a quelques jours, Yann LeCun, lauréat du prix universitaire Turing, a remis en question une étude de Google.

Il y a quelque temps, Google AI a proposé un cadre général de construction de pertes hiérarchiques LocoProp pour les réseaux de neurones multicouches dans sa nouvelle recherche "LocoProp : Enhancing BackProp via Local Loss Optimization", qui utilise uniquement un optimiseur de premier ordre tout en atteignant des performances. proche de celle des méthodes du second ordre.

Plus précisément, le cadre réinvente un réseau neuronal comme une composition modulaire de plusieurs couches, où chaque couche utilise son propre régulateur de poids, sa propre sortie cible et sa fonction de perte, atteignant finalement à la fois performances et efficacité.

Google a vérifié expérimentalement l'efficacité de sa méthode sur des modèles et des ensembles de données de référence, réduisant ainsi l'écart entre les optimiseurs de premier ordre et de second ordre. De plus, les chercheurs de Google ont déclaré que leur méthode de construction des pertes locales était la première fois que la perte carrée était utilisée comme perte locale.

Source de l'image : @Google AI

Pour cette recherche de Google, certaines personnes ont commenté qu'elle était géniale et intéressante. Cependant, certaines personnes ont exprimé des points de vue différents, notamment Yann LeCun, lauréat du prix Turing.

Il pense qu'il existe de nombreuses versions de ce que nous appelons aujourd'hui des accessoires cibles, certaines remontant à 1986. Alors, quelle est la différence entre LocoProp de Google et eux ?

Source photo : @Yann LeCun

Concernant la question de LeCun, Haohan Wang, qui est sur le point de devenir professeur adjoint à l'UIUC, a accepté. Il a dit qu'il était parfois surprenant que certains auteurs pensent qu'une idée aussi simple était la première du genre dans l'histoire. Peut-être qu'ils ont fait quelque chose de différent, mais l'équipe de publicité avait hâte de tout revendiquer...

Source photo : @HaohanWang

Cependant, certaines personnes ne sont "pas froides" envers LeCun, pensant qu'il Les considérations concurrentielles soulèvent des questions, voire « provoquent la guerre ». LeCun a répondu en affirmant que sa question n'avait rien à voir avec la compétition et a donné l'exemple d'anciens membres de son laboratoire comme Marc'Aurelio Ranzato, Karol Gregor, Koray Kavukcuoglu, etc., qui ont tous utilisé certaines versions de propagation de cibles, et maintenant ils travaillent tous chez Google DeepMind.

Source photo : @Gabriel Jimenez @Yann LeCun

Certaines personnes ont même taquiné Yann LeCun : "Quand tu ne peux pas battre Jürgen Schmidhuber, deviens-le."

Yann LeCun a-t-il raison ? Voyons d’abord en quoi consiste cette étude de Google. Y a-t-il une innovation remarquable ?

Google LocoProp : rétropropagation améliorée avec optimisation des pertes locales

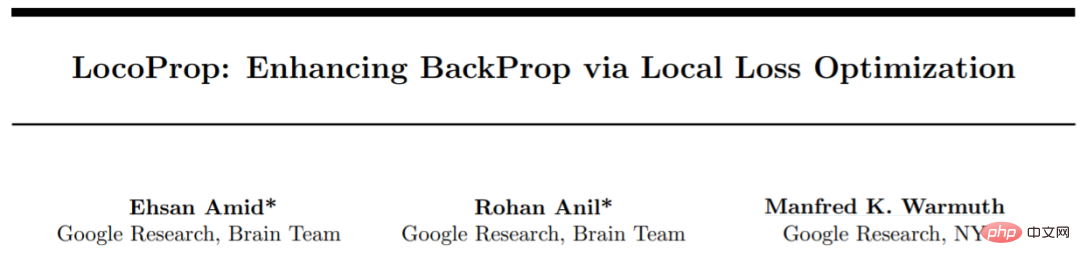

Cette recherche a été réalisée par trois chercheurs de Google : Ehsan Amid, Rohan Anil et Manfred K. Warmuth.

Adresse papier : https://proceedings.mlr.press/v151/amid22a/amid22a.pdf

Cet article estime qu'il existe deux facteurs clés pour le succès des réseaux de neurones profonds (DNN) : la conception du modèle et données de formation, cependant, peu de chercheurs discutent des méthodes d'optimisation pour mettre à jour les paramètres du modèle. Notre formation du DNN implique de minimiser la fonction de perte, qui est utilisée pour prédire la différence entre la valeur réelle et la valeur prédite du modèle, et d'utiliser la rétropropagation pour mettre à jour les paramètres.

La méthode de mise à jour du poids la plus simple est la descente de gradient stochastique, c'est-à-dire qu'à chaque étape, le poids se déplace par rapport à la direction négative du gradient. De plus, il existe des méthodes d'optimisation avancées, telles que l'optimiseur de momentum, AdaGrad, etc. Ces optimiseurs sont souvent appelés méthodes du premier ordre car ils utilisent généralement uniquement les informations des dérivées du premier ordre pour modifier la direction de la mise à jour.

Il existe également des méthodes d'optimisation plus avancées telles que Shampoo, K-FAC, etc., qui ont fait leurs preuves pour améliorer la convergence et réduire le nombre d'itérations. Ces méthodes peuvent capturer les changements de gradients. Grâce à ces informations supplémentaires, les optimiseurs d'ordre supérieur peuvent découvrir des directions de mise à jour plus efficaces pour le modèle entraîné en prenant en compte les corrélations entre différents groupes de paramètres. L’inconvénient est que le calcul des directions de mise à jour d’ordre supérieur est plus coûteux en termes de calcul que les mises à jour de premier ordre.

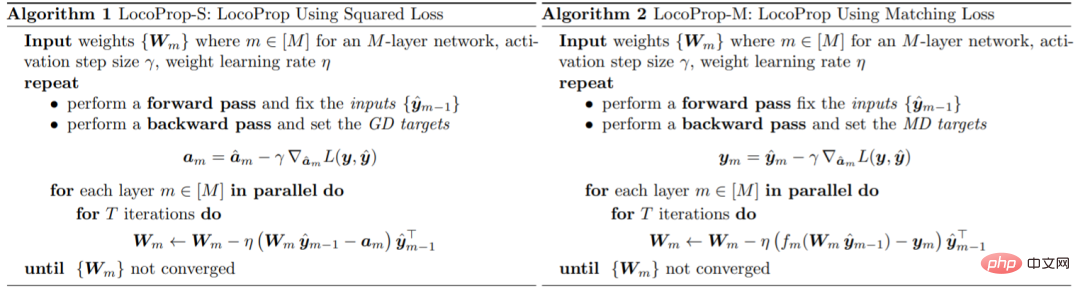

Google a présenté un cadre pour la formation des modèles DNN dans l'article : LocoProp, qui conçoit les réseaux de neurones comme des combinaisons modulaires de couches. De manière générale, chaque couche d'un réseau neuronal effectue une transformation linéaire sur l'entrée, suivie d'une fonction d'activation non linéaire. Dans cette étude, chaque couche du réseau s’est vu attribuer son propre régulateur de poids, son propre objectif de production et sa propre fonction de perte. La fonction de perte de chaque couche est conçue pour correspondre à la fonction d'activation de cette couche. En utilisant cette forme, la formation d'un petit lot donné de pertes locales peut être minimisée, en itérant entre les couches en parallèle.

Google utilise cet optimiseur de premier ordre pour les mises à jour des paramètres, évitant ainsi le coût de calcul requis par les optimiseurs d'ordre supérieur.

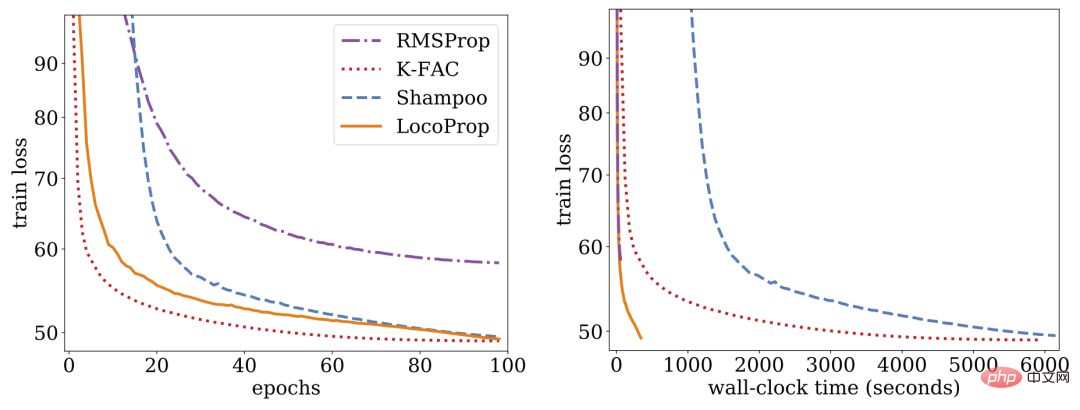

La recherche montre que LocoProp surpasse les méthodes de premier ordre sur les références approfondies des auto-encodeurs et fonctionne de manière comparable aux optimiseurs d'ordre supérieur tels que Shampoo et K-FAC sans exigences de mémoire et de calcul élevées.

LocoProp : rétropropagation améliorée avec optimisation des pertes locales

Généralement, les réseaux de neurones sont considérés comme des fonctions composites qui transforment l'entrée de chaque couche en une représentation de sortie. LocoProp adopte cette perspective lors de la décomposition du réseau en couches. En particulier, au lieu de mettre à jour les poids d'une couche pour minimiser une fonction de perte en sortie, LocoProp applique une fonction de perte locale prédéfinie spécifique à chaque couche. Pour une couche donnée, la fonction de perte est choisie pour correspondre à la fonction d'activation, par exemple, une perte tanh serait choisie pour une couche avec activation tanh. De plus, le terme de régularisation garantit que les poids mis à jour ne s'écartent pas trop de leurs valeurs actuelles.

Semblable à la rétropropagation, LocoProp applique une passe avant pour calculer les activations. Lors du passage arrière, LocoProp définit des cibles pour les neurones de chaque couche. Enfin, LocoProp décompose la formation du modèle en problèmes indépendants sur plusieurs couches, où plusieurs mises à jour locales peuvent être appliquées en parallèle aux poids de chaque couche.

Google a mené des expériences sur des modèles d'encodeurs automatiques profonds, une référence courante pour évaluer les performances des algorithmes d'optimisation. Ils ont effectué une optimisation approfondie sur plusieurs optimiseurs de premier ordre couramment utilisés, notamment SGD, SGD with momentum, AdaGrad, RMSProp, Adam et des optimiseurs d'ordre supérieur, notamment Shampoo, K-FAC, et ont comparé les résultats avec LocoProp. Les résultats montrent que la méthode LocoProp est nettement plus performante que les optimiseurs de premier ordre et est comparable aux optimiseurs d'ordre élevé, tout en étant nettement plus rapide lorsqu'elle est exécutée sur un seul GPU.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Il existe de nombreuses raisons pour lesquelles la startup MySQL échoue, et elle peut être diagnostiquée en vérifiant le journal des erreurs. Les causes courantes incluent les conflits de port (vérifier l'occupation du port et la configuration de modification), les problèmes d'autorisation (vérifier le service exécutant les autorisations des utilisateurs), les erreurs de fichier de configuration (vérifier les paramètres des paramètres), la corruption du répertoire de données (restaurer les données ou reconstruire l'espace de la table), les problèmes d'espace de la table InNODB (vérifier les fichiers IBDATA1), la défaillance du chargement du plug-in (vérification du journal des erreurs). Lors de la résolution de problèmes, vous devez les analyser en fonction du journal d'erreur, trouver la cause profonde du problème et développer l'habitude de sauvegarder régulièrement les données pour prévenir et résoudre des problèmes.

Mysql peut-il renvoyer JSON

Apr 08, 2025 pm 03:09 PM

Mysql peut-il renvoyer JSON

Apr 08, 2025 pm 03:09 PM

MySQL peut renvoyer les données JSON. La fonction JSON_Extract extrait les valeurs de champ. Pour les requêtes complexes, envisagez d'utiliser la clause pour filtrer les données JSON, mais faites attention à son impact sur les performances. Le support de MySQL pour JSON augmente constamment, et il est recommandé de faire attention aux dernières versions et fonctionnalités.

Comprendre les propriétés acides: les piliers d'une base de données fiable

Apr 08, 2025 pm 06:33 PM

Comprendre les propriétés acides: les piliers d'une base de données fiable

Apr 08, 2025 pm 06:33 PM

Une explication détaillée des attributs d'acide de base de données Les attributs acides sont un ensemble de règles pour garantir la fiabilité et la cohérence des transactions de base de données. Ils définissent comment les systèmes de bases de données gérent les transactions et garantissent l'intégrité et la précision des données même en cas de plantages système, d'interruptions d'alimentation ou de plusieurs utilisateurs d'accès simultanément. Présentation de l'attribut acide Atomicité: une transaction est considérée comme une unité indivisible. Toute pièce échoue, la transaction entière est reculée et la base de données ne conserve aucune modification. Par exemple, si un transfert bancaire est déduit d'un compte mais pas augmenté à un autre, toute l'opération est révoquée. BeginTransaction; UpdateAccountSsetBalance = Balance-100Wh

Master SQL Limit Clause: Contrôlez le nombre de lignes dans une requête

Apr 08, 2025 pm 07:00 PM

Master SQL Limit Clause: Contrôlez le nombre de lignes dans une requête

Apr 08, 2025 pm 07:00 PM

Clause SQLLIMIT: Contrôlez le nombre de lignes dans les résultats de la requête. La clause limite dans SQL est utilisée pour limiter le nombre de lignes renvoyées par la requête. Ceci est très utile lors du traitement de grands ensembles de données, des affichages paginés et des données de test, et peut améliorer efficacement l'efficacité de la requête. Syntaxe de base de la syntaxe: selectColumn1, Column2, ... FromTable_NamelimitNumber_Of_Rows; Number_OF_ROWS: Spécifiez le nombre de lignes renvoyées. Syntaxe avec décalage: selectColumn1, Column2, ... FromTable_Namelimitoffset, numéro_of_rows; décalage: sauter

Comment optimiser les performances MySQL pour les applications de haute charge?

Apr 08, 2025 pm 06:03 PM

Comment optimiser les performances MySQL pour les applications de haute charge?

Apr 08, 2025 pm 06:03 PM

Guide d'optimisation des performances de la base de données MySQL dans les applications à forte intensité de ressources, la base de données MySQL joue un rôle crucial et est responsable de la gestion des transactions massives. Cependant, à mesure que l'échelle de l'application se développe, les goulots d'étranglement des performances de la base de données deviennent souvent une contrainte. Cet article explorera une série de stratégies efficaces d'optimisation des performances MySQL pour garantir que votre application reste efficace et réactive dans des charges élevées. Nous combinerons des cas réels pour expliquer les technologies clés approfondies telles que l'indexation, l'optimisation des requêtes, la conception de la base de données et la mise en cache. 1. La conception de l'architecture de la base de données et l'architecture optimisée de la base de données sont la pierre angulaire de l'optimisation des performances MySQL. Voici quelques principes de base: sélectionner le bon type de données et sélectionner le plus petit type de données qui répond aux besoins peut non seulement économiser un espace de stockage, mais également améliorer la vitesse de traitement des données.

La clé principale de MySQL peut être nul

Apr 08, 2025 pm 03:03 PM

La clé principale de MySQL peut être nul

Apr 08, 2025 pm 03:03 PM

La clé primaire MySQL ne peut pas être vide car la clé principale est un attribut de clé qui identifie de manière unique chaque ligne dans la base de données. Si la clé primaire peut être vide, l'enregistrement ne peut pas être identifié de manière unique, ce qui entraînera une confusion des données. Lorsque vous utilisez des colonnes entières ou des UUIdes auto-incrémentales comme clés principales, vous devez considérer des facteurs tels que l'efficacité et l'occupation de l'espace et choisir une solution appropriée.

Méthode de Navicat pour afficher le mot de passe de la base de données MongoDB

Apr 08, 2025 pm 09:39 PM

Méthode de Navicat pour afficher le mot de passe de la base de données MongoDB

Apr 08, 2025 pm 09:39 PM

Il est impossible de visualiser le mot de passe MongoDB directement via NAVICAT car il est stocké sous forme de valeurs de hachage. Comment récupérer les mots de passe perdus: 1. Réinitialiser les mots de passe; 2. Vérifiez les fichiers de configuration (peut contenir des valeurs de hachage); 3. Vérifiez les codes (May Code Hardcode).

Surveillez les gouttelettes MySQL et MariaDB avec Exportateur de Prometheus Mysql

Apr 08, 2025 pm 02:42 PM

Surveillez les gouttelettes MySQL et MariaDB avec Exportateur de Prometheus Mysql

Apr 08, 2025 pm 02:42 PM

Une surveillance efficace des bases de données MySQL et MARIADB est essentielle pour maintenir des performances optimales, identifier les goulots d'étranglement potentiels et assurer la fiabilité globale du système. Prometheus Mysql Exportateur est un outil puissant qui fournit des informations détaillées sur les mesures de base de données qui sont essentielles pour la gestion et le dépannage proactifs.