Périphériques technologiques

Périphériques technologiques

IA

IA

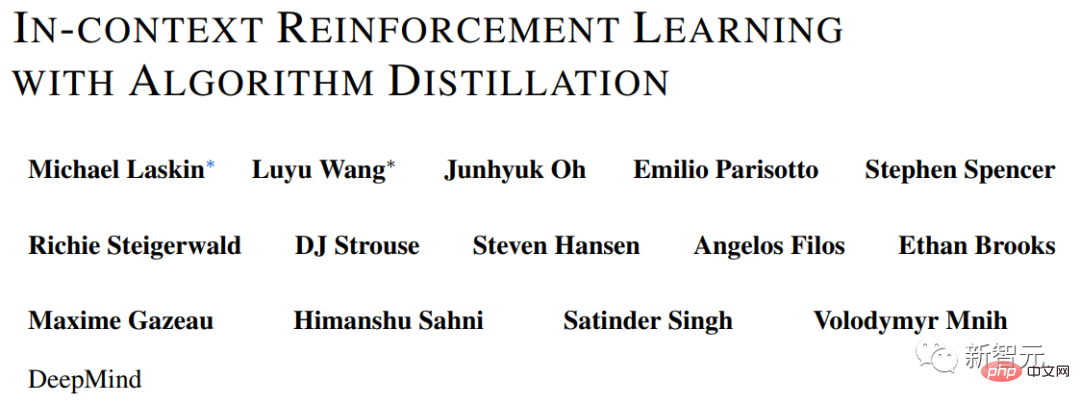

Une autre révolution dans l'apprentissage par renforcement ! DeepMind propose une « distillation d'algorithmes » : un transformateur d'apprentissage par renforcement pré-entraîné explorable

Une autre révolution dans l'apprentissage par renforcement ! DeepMind propose une « distillation d'algorithmes » : un transformateur d'apprentissage par renforcement pré-entraîné explorable

Une autre révolution dans l'apprentissage par renforcement ! DeepMind propose une « distillation d'algorithmes » : un transformateur d'apprentissage par renforcement pré-entraîné explorable

Dans les tâches actuelles de modélisation de séquences, Transformer peut être considéré comme l'architecture de réseau neuronal la plus puissante, et le modèle Transformer pré-entraîné peut utiliser des invites comme conditions ou un apprentissage en contexte pour s'adapter à différentes tâches en aval.

La capacité de généralisation du modèle Transformer pré-entraîné à grande échelle a été vérifiée dans plusieurs domaines, tels que la complétion de texte, la compréhension du langage, la génération d'images, etc.

Depuis l'année dernière, des travaux pertinents ont été réalisés prouvant qu'en traitant l'apprentissage par renforcement hors ligne (RL hors ligne) comme un problème de prédiction de séquence, le modèle peut apprendre des politiques à partir de données hors ligne.

Mais les méthodes actuelles soit apprennent la politique à partir de données qui ne contiennent pas d'apprentissage (comme une politique experte fixée par distillation), soit apprennent à partir de données qui contiennent de l'apprentissage (comme le tampon de relecture de l'agent), mais parce que son contexte est trop petit, il ne peut pas prendre en compte les améliorations politiques.

Les chercheurs de DeepMind ont découvert par observation qu'en principela nature séquentielle de l'apprentissage dans la formation des algorithmes d'apprentissage par renforcement peut modéliser le processus d'apprentissage par renforcement lui-même comme un « problème de prédiction de séquence causale ».

Plus précisément, si le contexte d'un Transformer est suffisamment long pour inclure des améliorations de politique dues aux mises à jour d'apprentissage, alors il devrait être capable de représenter non seulement une politique fixe, mais également l'état, les actions et les récompenses des épisodes précédents en se concentrer sur lui Représenté comme un opérateur d’amélioration des politiques.

Cela fournit également une faisabilité technique selon laquelle tout algorithme RL peut être distillé en un modèle de séquence suffisamment puissant grâce à l'apprentissage par imitation et transformé en un algorithme RL en contexte.

Sur cette base, DeepMind a proposé l'algorithme de distillation (AD), qui extrait les algorithmes d'apprentissage par renforcement dans les réseaux neuronaux en établissant un modèle de séquence causale.

Lien papier :https://arxiv.org/pdf/2210.14215.pdf

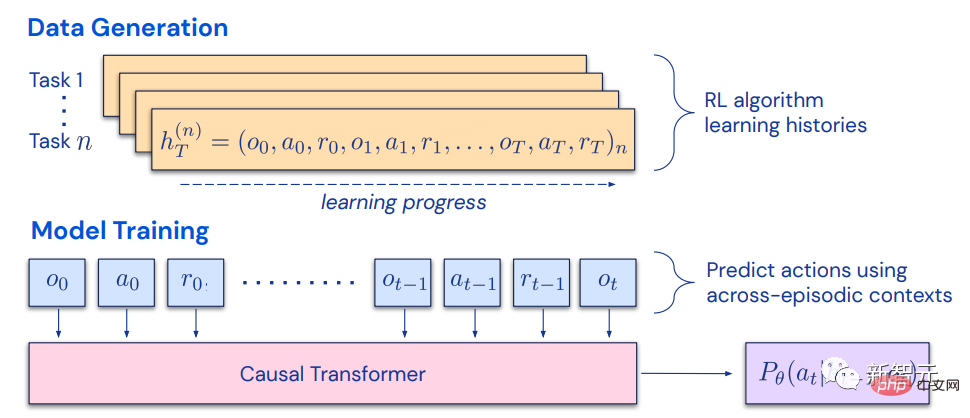

La distillation algorithmique traite l'apprentissage par renforcement comme un problème de prédiction de séquence entre épisodes, via la source RL L'algorithme génère un ensemble de données d'historique d'apprentissage, puis entraîne le transformateur causal en prédisant le comportement par autorégression basée sur l'historique d'apprentissage comme contexte.

Contrairement aux structures de post-apprentissage ou de prédiction de politique de séquence de séquences expertes, AD est capable d'améliorer sa politique entièrement en contexte sans mettre à jour ses paramètres réseau.

- Transfomer collecte ses propres données et maximise les récompenses sur les nouvelles tâches ;

- Aucune invite ou réglage précis n'est requis

- Avec les poids gelés, Transformer explore, exploite et maximise le retour du contexte ! Les méthodes de distillation expertes telles que Gato ne peuvent pas explorer et ne peuvent pas maximiser les rendements.

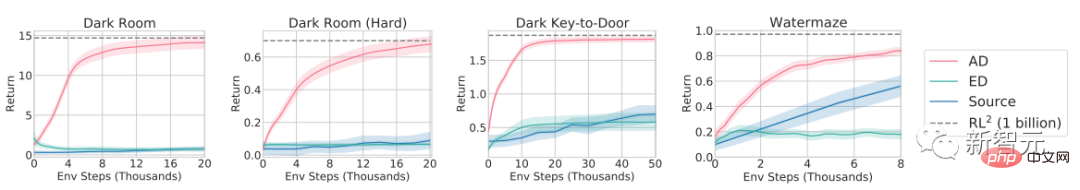

Les résultats expérimentaux prouvent qu'AD peut effectuer un apprentissage par renforcement dans divers environnements avec des récompenses clairsemées, des structures de tâches combinées et des observations basées sur les pixels, et que l'apprentissage AD est plus efficace en matière de données que l'algorithme RL qui génère des données sources élevées. .

AD est également le premier à démontrer des méthodes d'apprentissage par renforcement en contexte par modélisation séquentielle de données hors ligne avec perte d'imitation.

Distillation d'algorithmes

En 2021, certains chercheurs ont découvert pour la première fois que Transformer pouvait apprendre des politiques à tâche unique à partir de données RL hors ligne grâce à l'apprentissage par imitation, et a ensuite été étendu pour extraire des politiques multitâches à la fois dans le même domaine et dans plusieurs domaines. paramètres.

Ces travaux proposent un paradigme prometteur pour extraire des politiques générales multitâches : collecter d'abord un ensemble de données vaste et diversifié sur les interactions environnementales, puis extraire une politique à partir des données via une modélisation séquentielle.

La méthode d'apprentissage des politiques à partir de données RL hors ligne via l'apprentissage par imitation est également appelée distillation des politiques hors ligne, ou simplement Policy Distillation (PD).

Bien que l'idée du PD soit très simple et facile à étendre, le PD présente un défaut majeur : la stratégie générée ne s'améliore pas grâce aux interactions supplémentaires avec l'environnement.

Par exemple, MultiGame Decision Transformer (MGDT) a appris une politique de retour conditionnelle qui peut jouer à un grand nombre de jeux Atari, tandis que Gato a appris une politique pour résoudre des tâches dans différents environnements via des tâches d'inférence contextuelle, mais aucune des deux méthodes améliore sa stratégie par essais et erreurs.

MGDT adapte le transformateur aux nouvelles tâches en ajustant les poids du modèle, tandis que Gato nécessite des conseils de démonstration d'experts pour s'adapter aux nouvelles tâches.

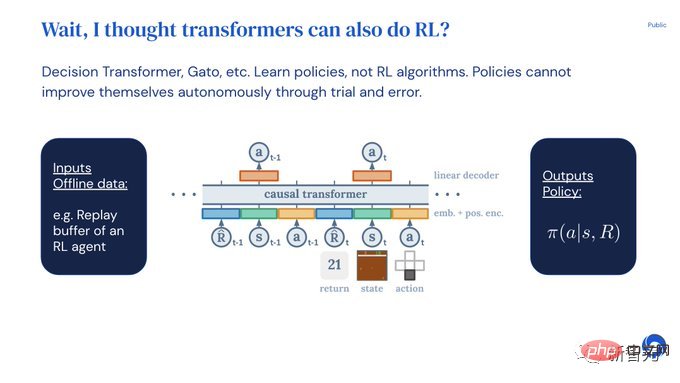

En bref, la méthode Policy Distillation apprend les politiques plutôt que les algorithmes d'apprentissage par renforcement.

La raison pour laquelle les chercheurs ont émis l'hypothèse que la distillation politique ne peut pas s'améliorer par essais et erreurs est qu'elle est formée sur des données qui ne montrent pas de progrès d'apprentissage.

La distillation algorithmique (AD) est une méthode d'apprentissage des opérateurs intrinsèques d'amélioration des politiques en optimisant la perte de prédiction de la séquence causale dans l'historique d'apprentissage d'un algorithme RL.

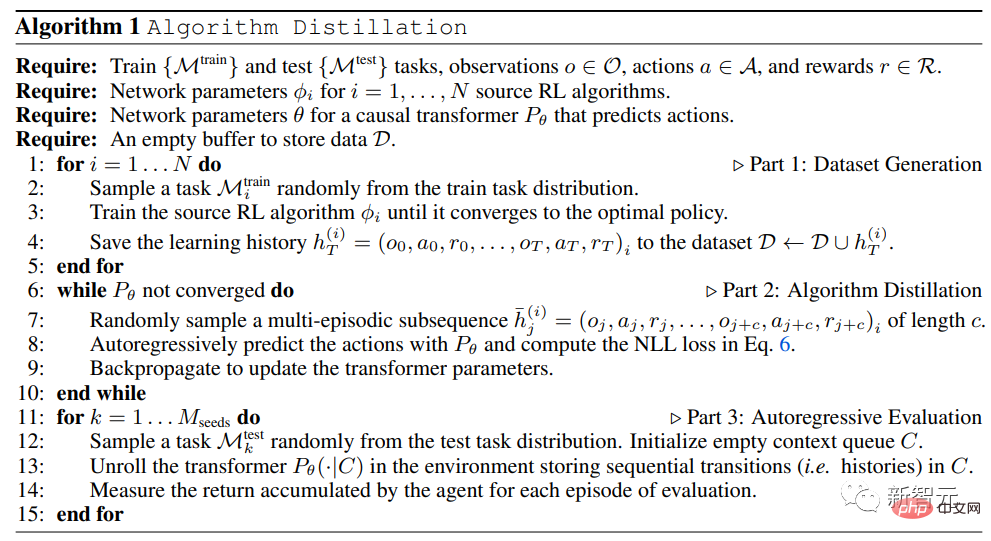

AD comprend deux composants :

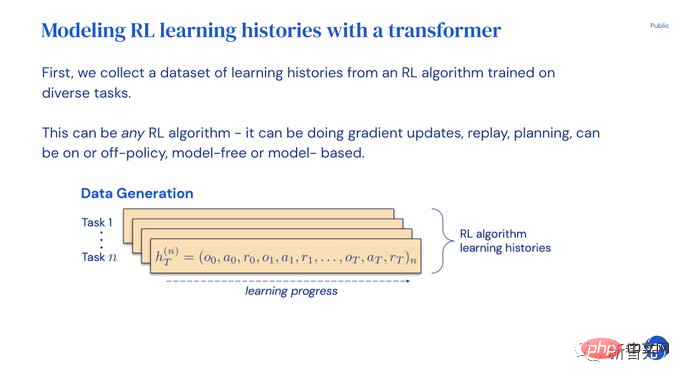

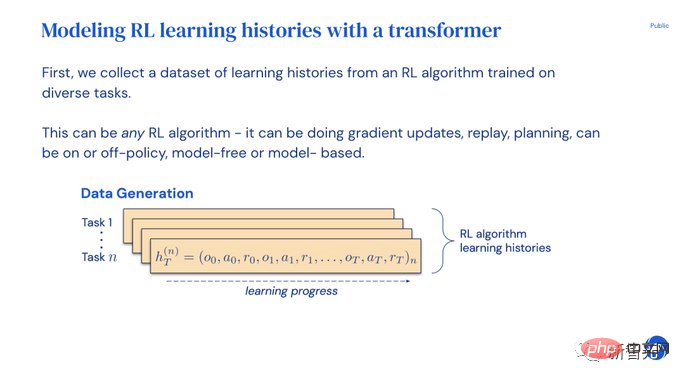

1 : Générer un grand ensemble de données multitâches en enregistrant l'historique d'entraînement d'un algorithme RL sur de nombreuses tâches individuelles

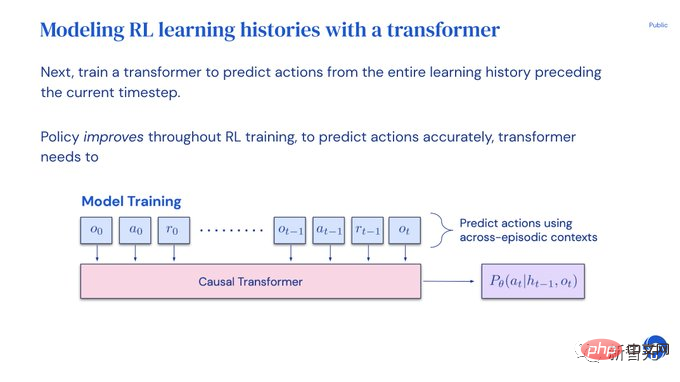

2. utilise l’historique d’apprentissage précédent comme arrière-plan pour modéliser causalement les actions.

Étant donné que la politique continue de s'améliorer tout au long du processus de formation de l'algorithme source RL, AD doit apprendre à améliorer l'opérateur afin de simuler avec précision les actions à tout moment donné de l'historique de formation.

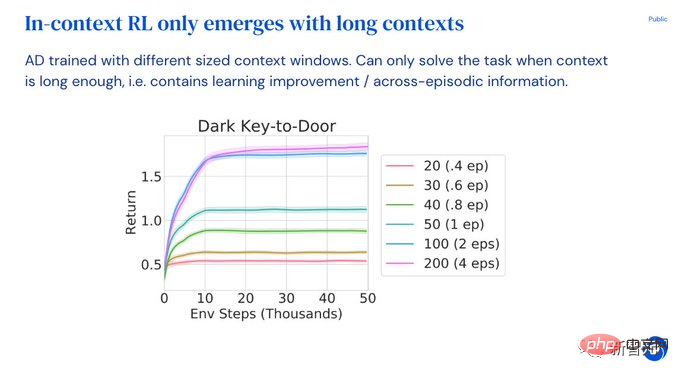

Plus important encore, la taille du contexte du Transformer doit être suffisamment grande (c'est-à-dire à travers les époques) pour capturer les améliorations des données d'entraînement.

Dans la partie expérimentale, afin d'explorer les avantages de l'AD dans les capacités RL en contexte, les chercheurs se sont concentrés sur les environnements qui ne peuvent pas être résolus par la généralisation sans tir après la pré-entraînement, c'est-à-dire chaque environnement est requis. Une variété de tâches sont prises en charge et la solution à la tâche ne peut pas être facilement déduite par le modèle à partir des observations. Dans le même temps, les épisodes doivent être suffisamment courts pour que les transformateurs causals puissent être formés à travers les épisodes.

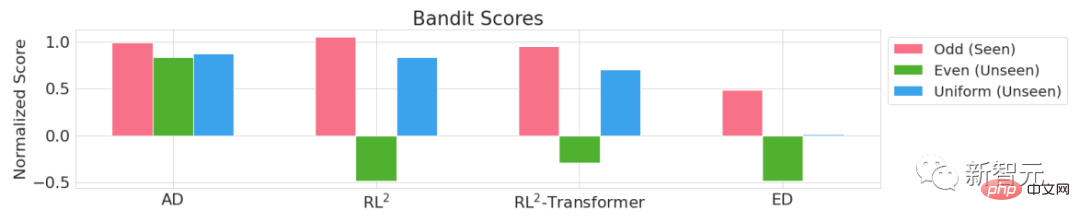

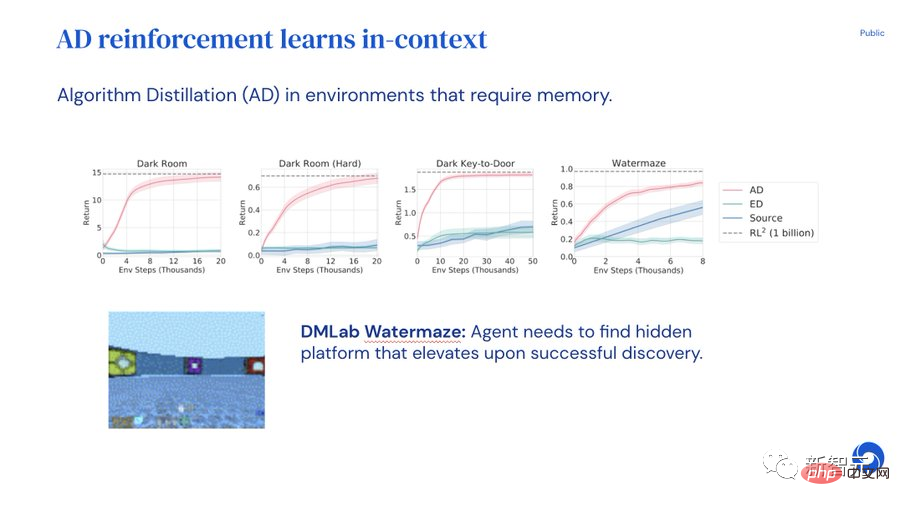

Comme le montrent les résultats expérimentaux de quatre environnements Adversarial Bandit, Dark Room, Dark Key-to-Door, DMLab Watermaze, en imitant l'algorithme RL basé sur le gradient, en utilisant un transformateur causal avec un grand suffisamment de contexte, AD peut renforcer pleinement l'apprentissage de nouvelles tâches en contexte.

AD est capable d'effectuer une exploration en contexte, une allocation temporelle de crédits et une généralisation. L'algorithme appris par AD est plus efficace en matière de données que l'algorithme qui génère les données sources pour la formation Transformer.

Explication PPT

Afin de faciliter la compréhension de l'article, Michael Laskin, l'un des auteurs de l'article, a publié une explication ppt sur Twitter.

Les expériences sur la distillation d'algorithmes montrent que Transformer peut améliorer le modèle de manière autonome par essais et erreurs sans mettre à jour les poids, les invites ou les réglages fins. Un seul Transformer peut collecter ses propres données et maximiser les récompenses sur les nouvelles tâches.

Bien qu'il existe de nombreux modèles réussis montrant comment Transformer apprend en contexte, il n'a pas été prouvé que Transformer renforce l'apprentissage en contexte.

Pour s'adapter aux nouvelles tâches, les développeurs doivent soit spécifier manuellement une invite, soit ajuster le modèle.

Ne serait-il pas bien si Transformer pouvait s'adapter à l'apprentissage par renforcement et être utilisable dès le départ ?

Mais Decision Transformers ou Gato ne peuvent apprendre des stratégies qu'à partir de données hors ligne et ne peuvent pas s'améliorer automatiquement grâce à des expériences répétées.

Le Transformateur généré à l'aide de la méthode de pré-entraînement de distillation algorithmique (AD) peut effectuer un apprentissage par renforcement en contexte.

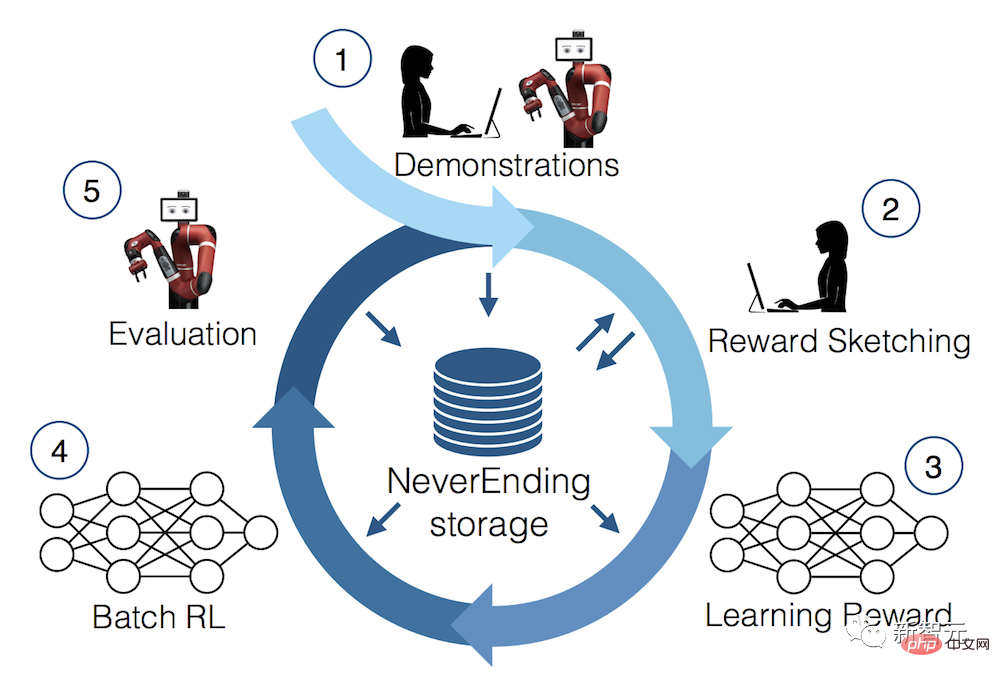

Entraînez d'abord plusieurs copies d'un algorithme d'apprentissage par renforcement pour résoudre différentes tâches et enregistrer l'historique d'apprentissage.

Une fois l'ensemble de données de l'historique d'apprentissage collecté, un transformateur peut être entraîné pour prédire les actions de l'historique d'apprentissage précédent.

Étant donné que les politiques se sont améliorées au fil du temps, prédire avec précision les actions obligera le Transformateur à modéliser les améliorations politiques.

L'ensemble du processus est si simple. Transformer est formé uniquement en imitant des actions. Il n'y a pas de valeur Q comme les modèles d'apprentissage par renforcement courants, pas de longue séquence opération-action-récompense et pas de retour comme les conditions DT.

Dans le contexte, l'apprentissage par renforcement n'entraîne aucune surcharge supplémentaire, et le modèle est ensuite évalué en observant si AD peut maximiser la récompense pour la nouvelle tâche.

Transformer explore, exploite et maximise les rendements alors que dans le contexte, ses poids sont figés !

D'un autre côté, Expert Distillation (le plus similaire à Gato) ne peut pas explorer ni maximiser les rendements.

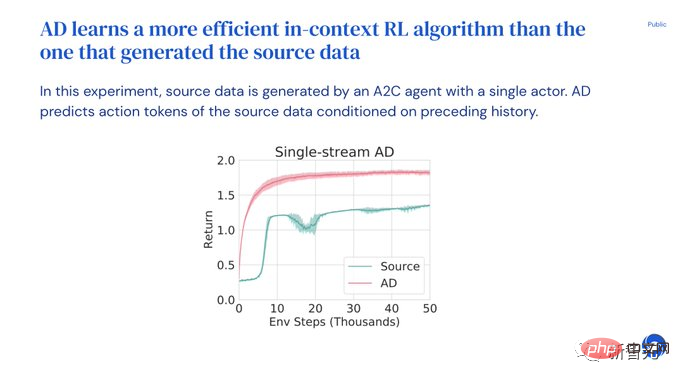

AD peut extraire n'importe quel algorithme RL. Les chercheurs ont essayé UCB et DQNA2C. Une découverte intéressante est qu'AD est plus efficace en matière de données dans l'apprentissage contextuel des algorithmes RL.

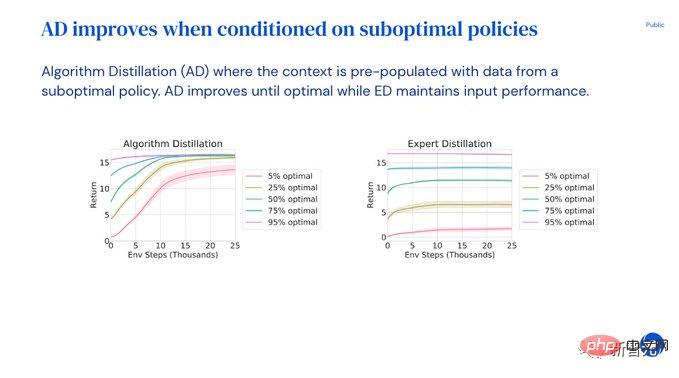

Les utilisateurs peuvent également saisir des invites et des démos sous-optimales, et le modèle améliorera automatiquement la stratégie jusqu'à ce que la solution optimale soit obtenue !

Et l'ED distillé par un expert ne peut maintenir que des performances de démonstration sous-optimales.

Context RL n'apparaîtra que lorsque le contexte du Transformer est suffisamment long et s'étend sur plusieurs épisodes.

AD nécessite un historique suffisamment long pour des tâches efficaces d'amélioration et d'identification du modèle.

Grâce à des expériences, les chercheurs sont arrivés aux conclusions suivantes :

- Le transformateur peut effectuer une RL en contexte

- L'algorithme RL contextuel avec AD est plus efficace que l'algorithme RL source basé sur un gradient

- AD améliore les stratégies sous-optimales

- l'apprentissage par renforcement en contexte découle de l'apprentissage par imitation en contexte long

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

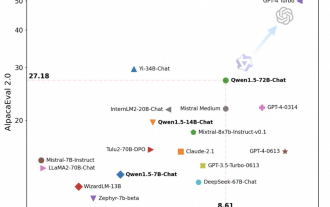

Tongyi Qianwen est à nouveau open source, Qwen1.5 propose six modèles de volume et ses performances dépassent GPT3.5

Feb 07, 2024 pm 10:15 PM

Tongyi Qianwen est à nouveau open source, Qwen1.5 propose six modèles de volume et ses performances dépassent GPT3.5

Feb 07, 2024 pm 10:15 PM

À temps pour la Fête du Printemps, la version 1.5 du modèle Tongyi Qianwen (Qwen) est en ligne. Ce matin, la nouvelle de la nouvelle version a attiré l'attention de la communauté IA. La nouvelle version du grand modèle comprend six tailles de modèle : 0,5B, 1,8B, 4B, 7B, 14B et 72B. Parmi eux, les performances de la version la plus puissante surpassent GPT3.5 et Mistral-Medium. Cette version inclut le modèle de base et le modèle Chat et fournit une prise en charge multilingue. L'équipe Tongyi Qianwen d'Alibaba a déclaré que la technologie pertinente avait également été lancée sur le site officiel de Tongyi Qianwen et sur l'application Tongyi Qianwen. De plus, la version actuelle de Qwen 1.5 présente également les points forts suivants : prend en charge une longueur de contexte de 32 Ko ; ouvre le point de contrôle du modèle Base+Chat ;

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

0. À quoi sert cet article ? Nous proposons DepthFM : un modèle d'estimation de profondeur monoculaire génératif de pointe, polyvalent et rapide. En plus des tâches traditionnelles d'estimation de la profondeur, DepthFM démontre également des capacités de pointe dans les tâches en aval telles que l'inpainting en profondeur. DepthFM est efficace et peut synthétiser des cartes de profondeur en quelques étapes d'inférence. Lisons ce travail ensemble ~ 1. Titre des informations sur l'article : DepthFM : FastMonocularDepthEstimationwithFlowMatching Auteur : MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Abandonnez l'architecture codeur-décodeur et utilisez le modèle de diffusion pour la détection des contours avec de meilleurs résultats. L'Université nationale de technologie de la défense a proposé DiffusionEdge.

Feb 07, 2024 pm 10:12 PM

Abandonnez l'architecture codeur-décodeur et utilisez le modèle de diffusion pour la détection des contours avec de meilleurs résultats. L'Université nationale de technologie de la défense a proposé DiffusionEdge.

Feb 07, 2024 pm 10:12 PM

Les réseaux actuels de détection des contours profonds adoptent généralement une architecture d'encodeur-décodeur, qui contient des modules d'échantillonnage ascendant et descendant pour mieux extraire les fonctionnalités à plusieurs niveaux. Cependant, cette structure limite le réseau à produire des résultats de détection de contour précis et détaillés. En réponse à ce problème, un article sur AAAI2024 propose une nouvelle solution. Titre de la thèse : DiffusionEdge : DiffusionProbabilisticModelforCrispEdgeDetection Auteurs : Ye Yunfan (Université nationale de technologie de la défense), Xu Kai (Université nationale de technologie de la défense), Huang Yuxing (Université nationale de technologie de la défense), Yi Renjiao (Université nationale de technologie de la défense), Cai Zhiping (Université nationale de technologie de la défense) Lien vers l'article : https ://ar

Les grands modèles peuvent également être découpés, et Microsoft SliceGPT augmente considérablement l'efficacité de calcul de LAMA-2.

Jan 31, 2024 am 11:39 AM

Les grands modèles peuvent également être découpés, et Microsoft SliceGPT augmente considérablement l'efficacité de calcul de LAMA-2.

Jan 31, 2024 am 11:39 AM

Les grands modèles de langage (LLM) comportent généralement des milliards de paramètres et sont formés sur des milliards de jetons. Cependant, ces modèles sont très coûteux à former et à déployer. Afin de réduire les besoins de calcul, diverses techniques de compression de modèles sont souvent utilisées. Ces techniques de compression de modèles peuvent généralement être divisées en quatre catégories : distillation, décomposition tensorielle (y compris la factorisation de bas rang), élagage et quantification. Les méthodes d'élagage existent depuis un certain temps, mais beaucoup nécessitent un réglage fin de la récupération (RFT) après l'élagage pour maintenir les performances, ce qui rend l'ensemble du processus coûteux et difficile à faire évoluer. Des chercheurs de l'ETH Zurich et de Microsoft ont proposé une solution à ce problème appelée SliceGPT. L'idée principale de cette méthode est de réduire l'intégration du réseau en supprimant des lignes et des colonnes dans la matrice de pondération.

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

Je pleure à mort. Le monde construit à la folie de grands modèles. Les données sur Internet ne suffisent pas du tout. Le modèle de formation ressemble à « The Hunger Games », et les chercheurs en IA du monde entier se demandent comment nourrir ces personnes avides de données. Ce problème est particulièrement important dans les tâches multimodales. À une époque où rien ne pouvait être fait, une équipe de start-up du département de l'Université Renmin de Chine a utilisé son propre nouveau modèle pour devenir la première en Chine à faire de « l'auto-alimentation des données générées par le modèle » une réalité. De plus, il s’agit d’une approche à deux volets, du côté compréhension et du côté génération, les deux côtés peuvent générer de nouvelles données multimodales de haute qualité et fournir un retour de données au modèle lui-même. Qu'est-ce qu'un modèle ? Awaker 1.0, un grand modèle multimodal qui vient d'apparaître sur le Forum Zhongguancun. Qui est l'équipe ? Moteur Sophon. Fondé par Gao Yizhao, doctorant à la Hillhouse School of Artificial Intelligence de l’Université Renmin.

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

La version Kuaishou de Sora 'Ke Ling' est ouverte aux tests : génère plus de 120 s de vidéo, comprend mieux la physique et peut modéliser avec précision des mouvements complexes

Jun 11, 2024 am 09:51 AM

La version Kuaishou de Sora 'Ke Ling' est ouverte aux tests : génère plus de 120 s de vidéo, comprend mieux la physique et peut modéliser avec précision des mouvements complexes

Jun 11, 2024 am 09:51 AM

Quoi? Zootopie est-elle concrétisée par l’IA domestique ? Avec la vidéo est exposé un nouveau modèle de génération vidéo domestique à grande échelle appelé « Keling ». Sora utilise une voie technique similaire et combine un certain nombre d'innovations technologiques auto-développées pour produire des vidéos qui comportent non seulement des mouvements larges et raisonnables, mais qui simulent également les caractéristiques du monde physique et possèdent de fortes capacités de combinaison conceptuelle et d'imagination. Selon les données, Keling prend en charge la génération de vidéos ultra-longues allant jusqu'à 2 minutes à 30 ips, avec des résolutions allant jusqu'à 1080p, et prend en charge plusieurs formats d'image. Un autre point important est que Keling n'est pas une démo ou une démonstration de résultats vidéo publiée par le laboratoire, mais une application au niveau produit lancée par Kuaishou, un acteur leader dans le domaine de la vidéo courte. De plus, l'objectif principal est d'être pragmatique, de ne pas faire de chèques en blanc et de se mettre en ligne dès sa sortie. Le grand modèle de Ke Ling est déjà sorti à Kuaiying.

L'US Air Force présente son premier avion de combat IA de grande envergure ! Le ministre a personnellement effectué l'essai routier sans intervenir pendant tout le processus, et 100 000 lignes de code ont été testées 21 fois.

May 07, 2024 pm 05:00 PM

L'US Air Force présente son premier avion de combat IA de grande envergure ! Le ministre a personnellement effectué l'essai routier sans intervenir pendant tout le processus, et 100 000 lignes de code ont été testées 21 fois.

May 07, 2024 pm 05:00 PM

Récemment, le milieu militaire a été submergé par la nouvelle : les avions de combat militaires américains peuvent désormais mener des combats aériens entièrement automatiques grâce à l'IA. Oui, tout récemment, l’avion de combat IA de l’armée américaine a été rendu public pour la première fois, dévoilant ainsi son mystère. Le nom complet de ce chasseur est Variable Stability Simulator Test Aircraft (VISTA). Il a été personnellement piloté par le secrétaire de l'US Air Force pour simuler une bataille aérienne en tête-à-tête. Le 2 mai, le secrétaire de l'US Air Force, Frank Kendall, a décollé à bord d'un X-62AVISTA à la base aérienne d'Edwards. Notez que pendant le vol d'une heure, toutes les actions de vol ont été effectuées de manière autonome par l'IA ! Kendall a déclaré : "Au cours des dernières décennies, nous avons réfléchi au potentiel illimité du combat air-air autonome, mais cela a toujours semblé hors de portée." Mais maintenant,