Périphériques technologiques

Périphériques technologiques

IA

IA

Par rapport aux modèles génératifs, pourquoi la recherche en robotique utilise-t-elle toujours les mêmes méthodes d'il y a quelques années ?

Par rapport aux modèles génératifs, pourquoi la recherche en robotique utilise-t-elle toujours les mêmes méthodes d'il y a quelques années ?

Par rapport aux modèles génératifs, pourquoi la recherche en robotique utilise-t-elle toujours les mêmes méthodes d'il y a quelques années ?

Des progrès remarquables ont été réalisés dans le domaine de la robotique, et ces progrès indiquent que les robots pourront faire plus de choses à l'avenir. Mais il y a aussi des choses troublantes, car par rapport aux modèles génératifs, les progrès des robots sont encore un peu en retard, surtout avec l'émergence de modèles comme le GPT-3, cet écart est encore plus marqué.

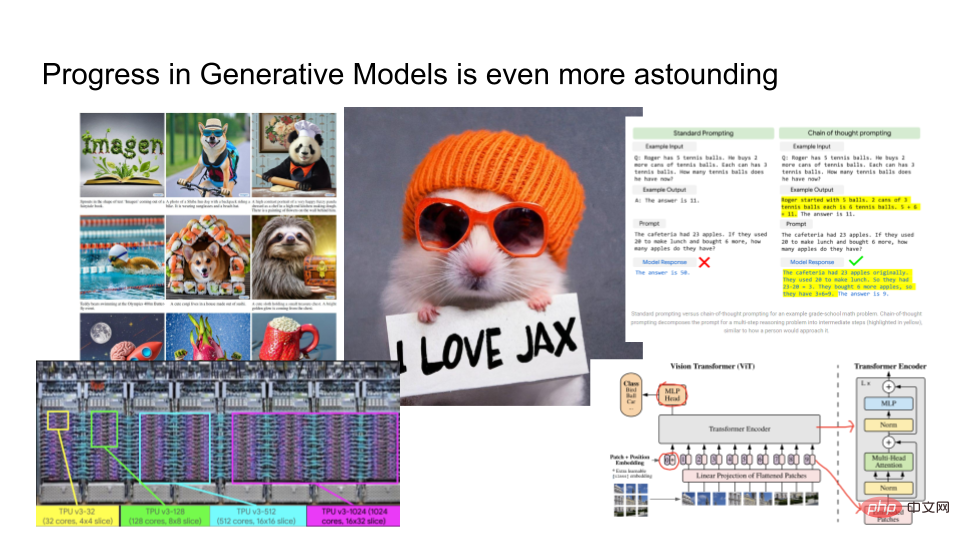

Les résultats produits par le modèle génératif sont incroyablement bons. Le côté gauche de l'image ci-dessus est le résultat de sortie d'Imagen lancé par Google. Vous pouvez lui fournir un morceau de texte, tel que "Un hamster portant un chapeau orange et tenant un morceau de papier disant J'aime JAX". Sur la base du texte donné, Imagen restituera une image raisonnable. En outre, Google a également formé un grand modèle de langage PaLM, qui peut être utilisé pour expliquer pourquoi les blagues sont drôles, etc. Ils entraînent des modèles avec du matériel avancé tel que TPUv4, et dans le domaine de la vision par ordinateur, les chercheurs développent des architectures très complexes telles que Vision Transformers.

Les modèles génératifs se développent si rapidement Par rapport à la robotique, quel est le lien entre les deux ?

Dans cet article, Eric Jang, vice-président de l'IA de la société norvégienne de robotique "Halodi Robotics", présente "Comment faire en sorte que les robots ressemblent davantage à des modèles génératifs ?" 》. Ce qui suit est le contenu principal de l’article.

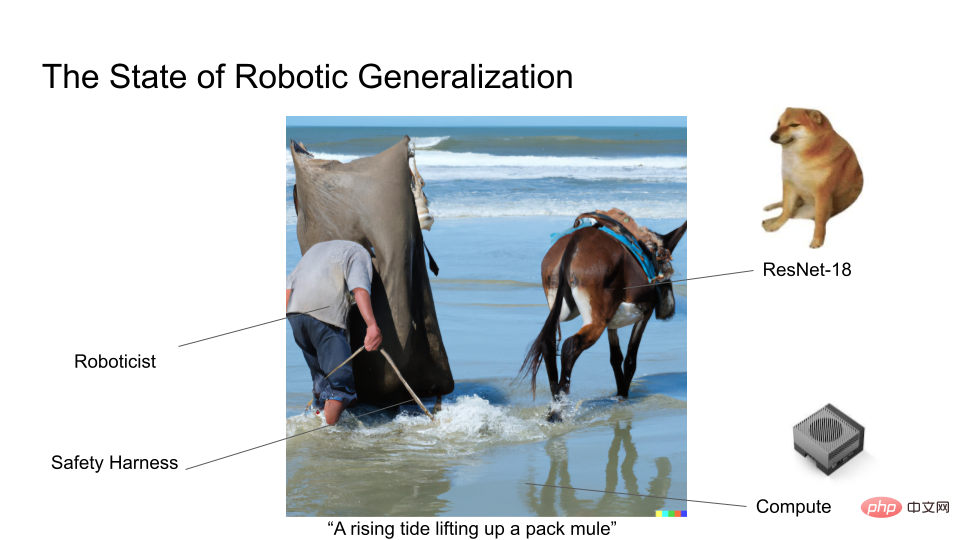

En tant qu'expert dans le domaine de la robotique, les progrès dans le domaine des modèles génératifs sont un peu enviables. Car dans le domaine de la robotique, la plupart des chercheurs utilisent probablement encore ResNet18, une architecture de deep learning vieille de 7 ans. Nous n’entraînons certainement pas de modèles sur d’énormes ensembles de données comme le font les modèles génératifs, donc très peu d’efforts de recherche en robotique font la une des journaux.

Nous connaissons le paradoxe de Moravec : par rapport aux tâches cognitives, il est difficile de manipuler les robots de manière intuitive, laisser le robot ramasser et transporter des objets ne semble pas transformer les mots en images ou expliquer une blague de manière aussi impressionnante.

Nous définissons d’abord le modèle génératif. Les modèles génératifs ne se limitent pas au rendu d’images ou à la génération de tonnes de texte. C'est également un cadre que nous pouvons utiliser pour comprendre tout apprentissage automatique probabiliste. Il y a deux questions principales dans les modèles génératifs :

1. Combien de bits y a-t-il dans la catégorie de données que vous souhaitez modéliser ?

2. Dans quelle mesure pouvez-vous construire le modèle ?

AlexNet a réalisé une percée en 2012. Il peut prédire 1 000 catégories, et Log2 (1 000 classes) représente environ 10 bits de classe. Vous pouvez considérer AlexNet comme un modèle génératif basé sur des images contenant 10 bits d'informations. Si vous améliorez la difficulté de la tâche de modélisation vers la tâche de sous-titres MS-CoCo, le modèle contient environ 100 bits d'informations. Si vous effectuez une génération d'images, par exemple du texte à l'image à l'aide de DALLE ou Imagen, celle-ci contient environ 1 000 bits d'informations.

Habituellement, plus les catégories sont modélisées, plus la puissance de calcul est nécessaire pour calculer les probabilités conditionnelles qu'elles contiennent. C'est pourquoi le modèle deviendra énorme à mesure que le nombre de catégories augmente. À mesure que nous formons des modèles de plus en plus grands, il devient possible d’exploiter les caractéristiques des données afin que des structures plus riches puissent être apprises. C’est pourquoi les modèles génératifs et l’apprentissage auto-supervisé sont devenus des méthodes populaires pour effectuer un apprentissage en profondeur sur de grandes quantités d’entrées sans nécessiter un étiquetage humain approfondi.

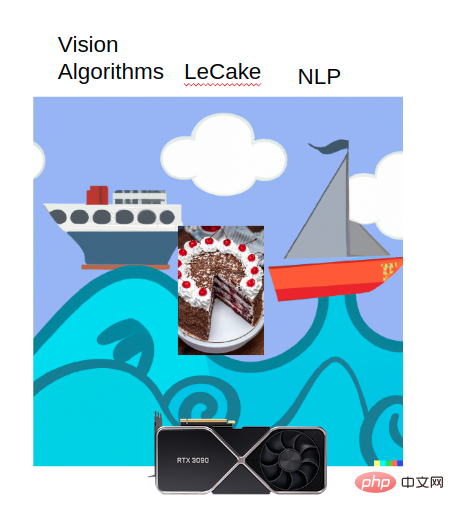

Rich Sutton a souligné dans son article "The Bitter Lesson" : La plupart des progrès en matière d'intelligence artificielle semblent avoir été réalisés dans ce boom informatique, alors qu'il y a eu peu de développements dans d'autres aspects. L’algorithme Vision, le NLP et LeCake de Yann LeCun profitent tous de cet essor informatique.

Quelle inspiration nous donne cette tendance ? Si vous disposez d'un modèle sur-paramétré capable de gérer plus de données et que le modèle peut capturer toutes les fonctionnalités du réseau, associé à une forte puissance de calcul et des objectifs de formation, l'apprentissage en profondeur est presque toujours réalisable.

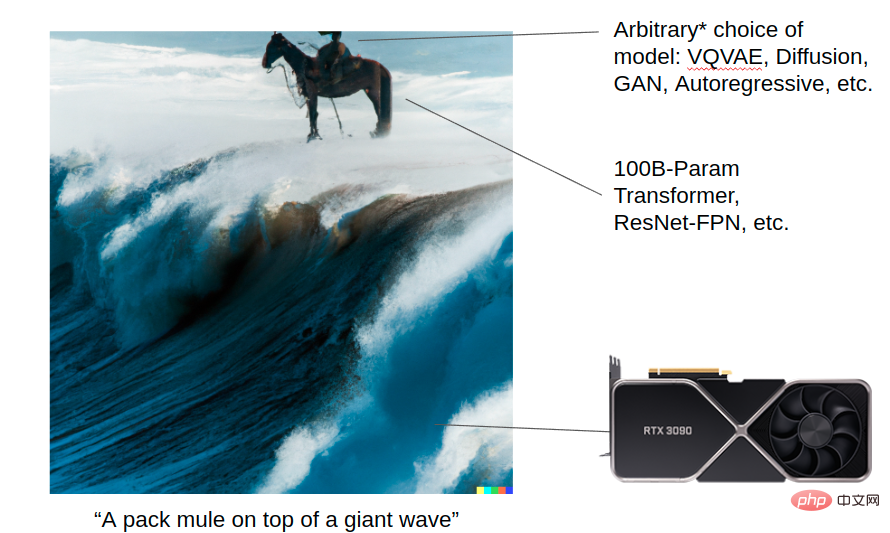

Laissez DALL-E 2 générer une image : une mule chevauchant une énorme vague. Cette image montre comment les modèles génératifs peuvent obtenir des résultats extraordinaires grâce au boom informatique. Vous disposez d'une puissance de calcul puissante (transformateur, Resnet, etc.), et vous pouvez choisir des algorithmes de modélisation VQVAE, Diffusion, GAN, Autoregressive et autres. Les détails de chaque algorithme sont importants aujourd’hui, mais ils n’auront peut-être plus d’importance à l’avenir une fois que les ordinateurs seront suffisamment puissants. Mais à long terme, l’échelle du modèle et une bonne architecture constituent le fondement de toutes ces avancées.

En revanche, la figure ci-dessous montre l'état actuel de la recherche en généralisation dans le domaine de la robotique. Actuellement, de nombreux chercheurs en robotique forment encore de petits modèles et n’ont pas encore utilisé Vision Transformer !

Pour ceux qui sont engagés dans la recherche sur les robots, ils espèrent tous que les robots pourront être plus largement utilisés dans le monde réel et jouer un rôle plus important. Dans le domaine des modèles génératifs, les chercheurs sont confrontés à relativement peu de problèmes, tandis que dans le domaine de la recherche en robotique, ils rencontrent souvent des problèmes tels que des difficultés de déploiement du robot et des données bruitées, que les chercheurs travaillant sur des modèles génératifs ne rencontreront pas.

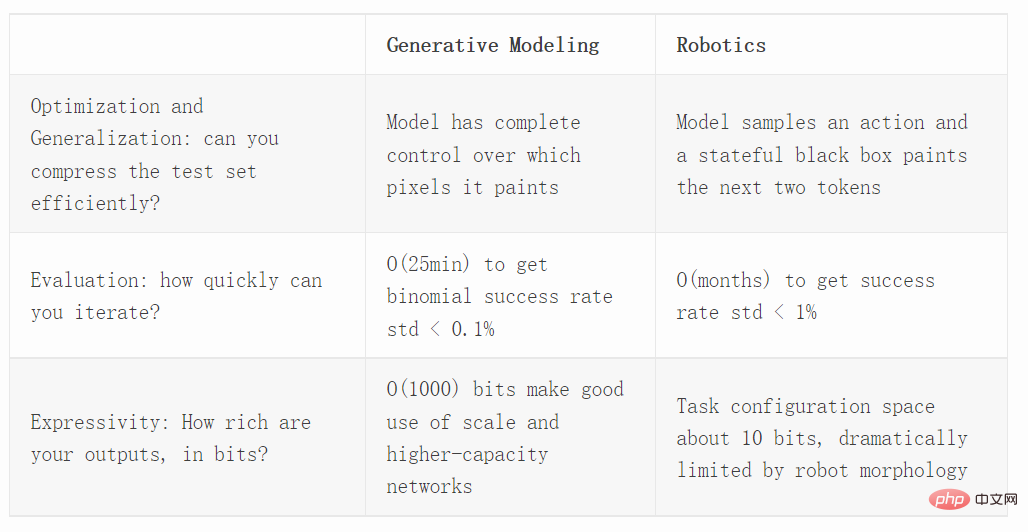

Ensuite, nous comparons les modèles génératifs et la robotique dans trois dimensions différentes, notamment les capacités d'optimisation, d'évaluation et d'expression.

Optimisation

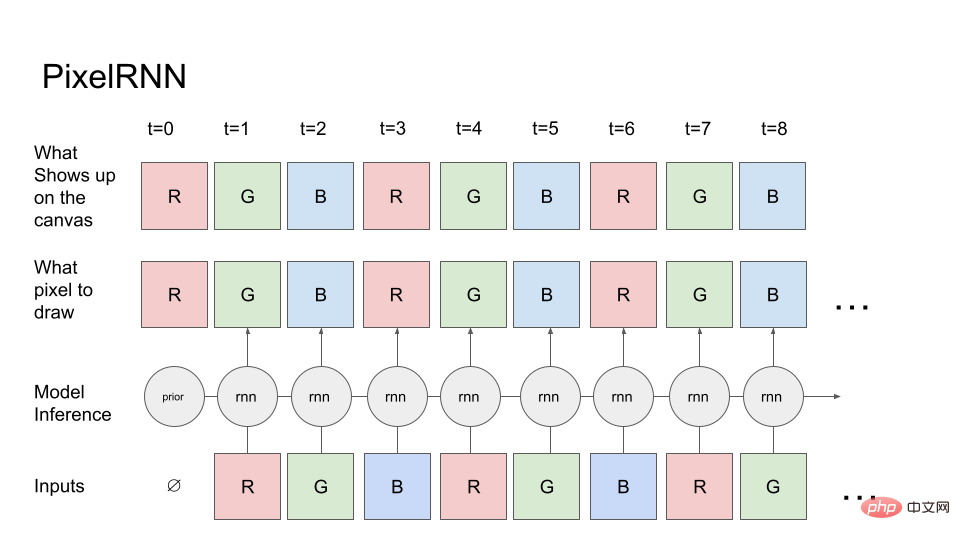

Regardons d'abord un modèle génératif simple : PixelRNN.

À partir du canal rouge du premier pixel (la probabilité a priori du canal rouge est connue), le modèle indique au canevas (rangée du haut) quel pixel il souhaite dessiner. Le canevas dessinera exactement comme indiqué, il copie donc les valeurs de pixels sur le canevas, puis relit le canevas dans le modèle pour prédire le canal suivant qui est le canal vert. Ensuite, les valeurs sur le canevas R et G sont renvoyées au RNN, et ainsi de suite, générant finalement la séquence RGBRGBRGB....

Dans les tâches réelles de génération d'images, la diffusion ou le transformateur peuvent être utilisés. Mais par souci de simplicité, nous utilisons uniquement des RNN à exécution directe.

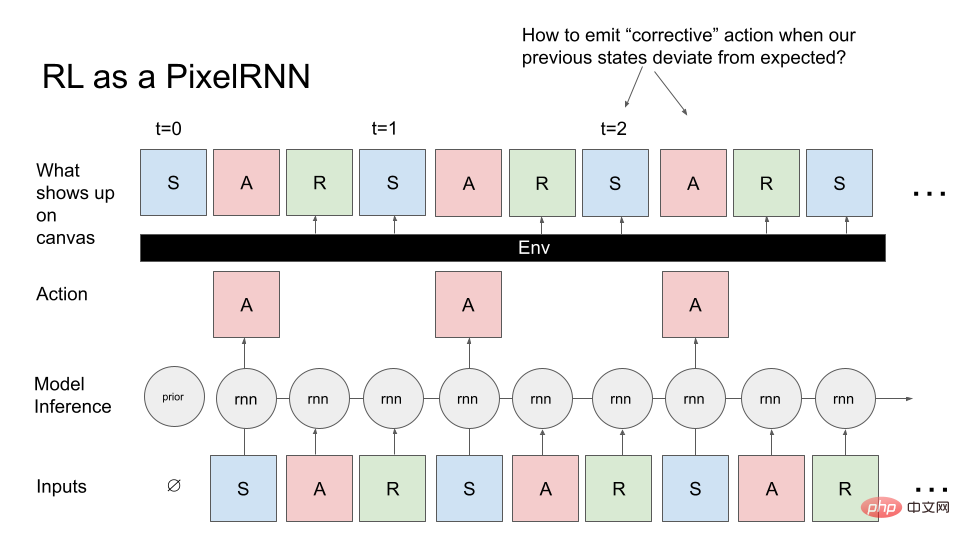

Convertissons maintenant le problème de contrôle général en PixelRNN. Au lieu de générer des images, nous souhaitons générer des MDP (Markov Decision Processes) : des séquences d'états, d'actions et de récompenses. Nous voulons générer un MDP qui correspond à un agent (comme un robot) qui effectue une tâche. Ici encore, nous partons de connaissances préalables et le modèle échantillonne l'état initial de l'environnement d'apprentissage par renforcement (RL). Il s'agit de la première entrée du modèle, le RNN échantillonne le premier pixel (A) et le canevas génère A exactement comme indiqué. Cependant, contrairement à la génération d'images, Canvas renvoie toujours la sortie RNN précédente, et l'opération actuelle est que les deux pixels suivants (R, S) sont déterminés par l'environnement actuel : c'est-à-dire qu'il accepte l'action et tous les états précédents, et calcule R, S en quelque sorte.

Nous pouvons considérer l'environnement RL comme un objet peintre, qui effectue des actions RNN au lieu de dessiner le contenu souhaité directement sur le canevas, il utilise des fonctions arbitrairement complexes pour dessiner des pixels.

Si nous le comparons avec le PixelRNN qui a dessiné l'image plus tôt, cette tâche est évidemment plus difficile car lorsque vous essayez d'échantillonner l'image que vous souhaitez, il y aura une boîte noire, et cette boîte noire affectera l'image vous voulez dessiner. Le contenu crée des difficultés.

Un problème typique rencontré lors du processus de dessin : si l'environnement dessine un état inattendu, il y aura un problème, c'est-à-dire comment émettre des instructions correctives afin que nous puissions revenir à l'image que nous essayons de dessiner. De plus, contrairement à la génération d'images, nous devons générer des images MDP de manière séquentielle et ne pouvons pas revenir en arrière pour les éditer, ce qui pose également des problèmes d'optimisation.

Si nous voulons comprendre comment les méthodes RL comme PPO se généralisent, nous devons les comparer dans un environnement non contrôlé, les appliquer aux techniques de génération d'images et les comparer avec les modèles génératifs modernes. Dans les travaux de Hinton et Nair de 2006, ils ont utilisé le système Springs pour modéliser la synthèse numérique MNIST. DeepMind réplique une partie de ce travail de synthèse d’images à l’aide des méthodes RL.

La génération d'images est une excellente référence pour étudier l'optimisation et le contrôle car elle met vraiment l'accent sur la nécessité de généraliser à des milliers de scénarios différents.

Des projets récents tels que Decision Transformer, Trajectory Transformer et Multi-Game Decision Transformer ont montré que la technologie RL à l'envers fait un bon travail de généralisation. Alors, comment les techniques RL inversées se comparent-elles aux algorithmes RL en ligne (PPO) ou hors ligne (CQL) ? Il est également facile à évaluer, on peut évaluer la densité (modèle de vraisemblance de l'observation complète de l'expert) et vérifier si un choix donné d'algorithme RL peut se généraliser à un grand nombre d'images lors de la mesure de la vraisemblance du test.

Évaluation

Si l'on souhaite estimer le taux de réussite d'un robot sur certaines tâches, on peut utiliser la distribution binomiale.

La variance de la distribution binomiale est p(1−p)/N, p est la moyenne de l'échantillon (taux de réussite estimé) N est le nombre d'essais ; Dans le pire des cas, si p=50% (variance maximale), alors 3000 échantillons sont nécessaires pour ramener l'écart type à moins de 1% !

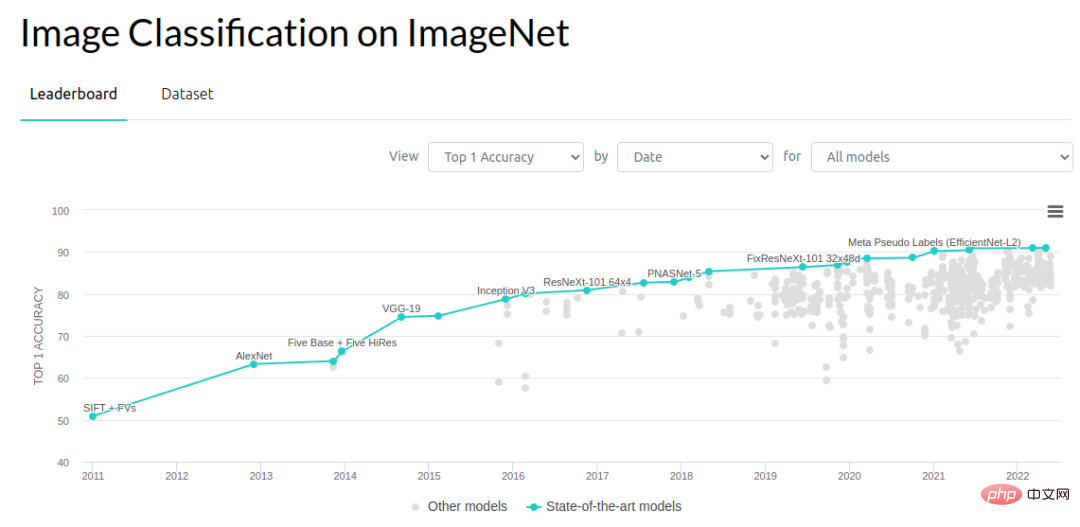

Si nous l’examinons du point de vue de la vision par ordinateur, des améliorations de l’ordre de 0,1 à 1 % sont un moteur de progrès important. Le problème de reconnaissance d'objets ImageNet a beaucoup progressé depuis 2012. Le taux d'erreur a diminué de 3 % entre 2012 et 2014, puis d'environ 1 % par an. De nombreuses personnes travaillent sur la manière de faire fonctionner cela. Peut-être que cette année (2022) a atteint un goulot d'étranglement dans l'amélioration des références, mais au cours des sept années allant de 2012 à 2018, les chercheurs ont fait beaucoup de progrès et de résultats.

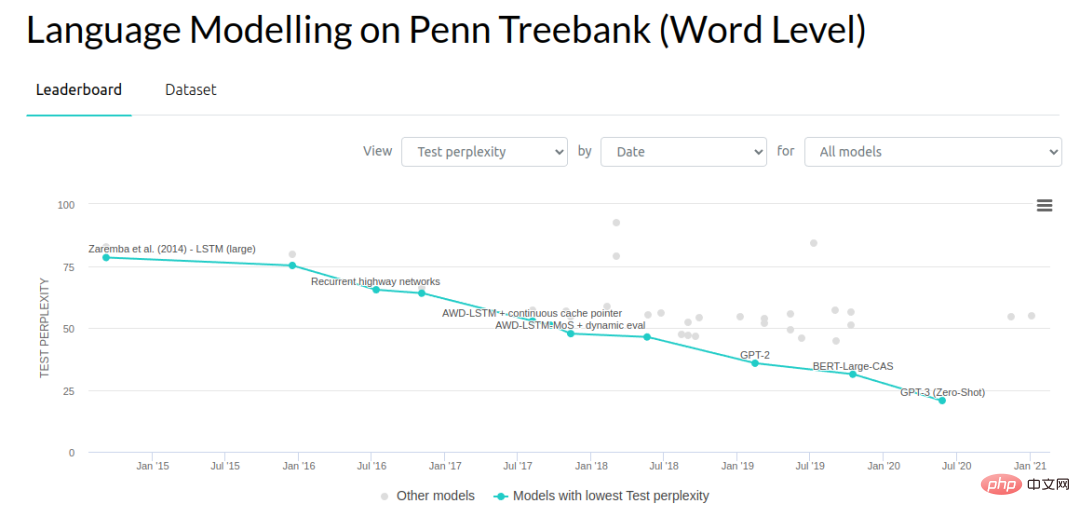

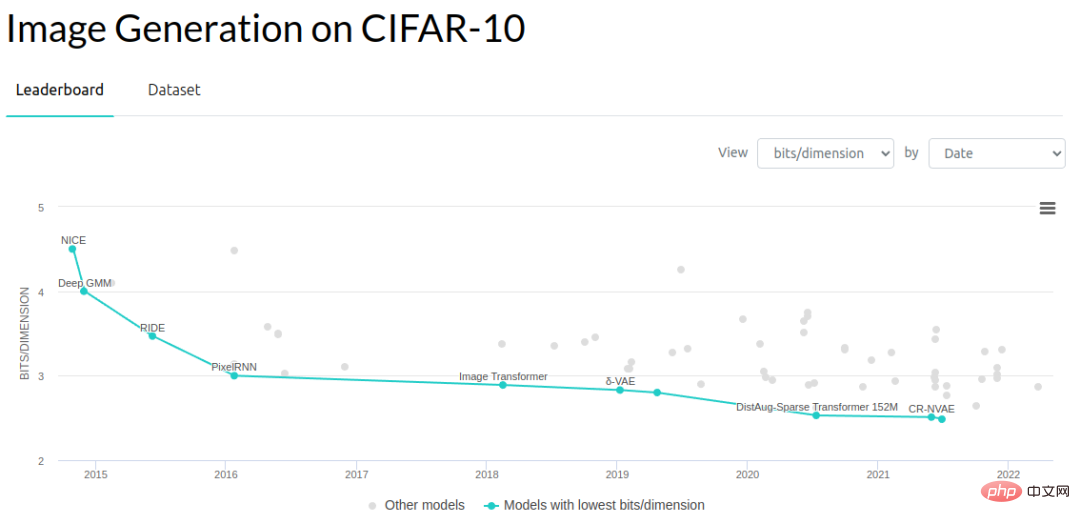

Dans d'autres domaines de la modélisation générative, les chercheurs ont réduit la complexité des modèles de langage et le nombre de bits par dimension des modèles génératifs sur les images.

Ce qui suit est une comparaison approximative de la vitesse d'évaluation des benchmarks courants. L'ensemble de tests de reconnaissance d'objets ImageNet 2012 contient 150 000 images. En supposant une vitesse d'inférence de 10 ms par image et en évaluant chaque image consécutivement, il faudrait environ 25 minutes pour évaluer chaque exemple de test (en fait, l'évaluation est beaucoup plus rapide car le traitement par lots est possible). Mais ici, nous supposons que nous n’avons qu’un seul robot effectuant l’opération d’évaluation et que les images doivent être traitées en continu.

Comme il y a des images massives, nous pouvons obtenir une estimation d'erreur standard à moins de 0,1 %. En fait, nous n’avons pas besoin d’une erreur type de 0,1 % pour progresser dans ce domaine, peut-être que 1 % suffit.

En termes d'évaluation de la complexité, les performances de bout en bout sont également un élément important. Voyons comment effectuer une évaluation de bout en bout des performances des réseaux de neurones dans des tâches simulées. Habitat Sim est l'un des simulateurs les plus rapides disponibles et est conçu pour minimiser la surcharge entre l'inférence du réseau neuronal et l'évolution de l'environnement. Le simulateur peut effectuer 10 000 pas par seconde, mais comme le passage en avant du réseau neuronal est d'environ 10 ms, ce goulot d'étranglement entraîne un temps d'évaluation de 2 secondes par épisode (en supposant un épisode de navigation typique de 200 pas). C'est beaucoup plus rapide que d'exécuter un vrai robot, mais beaucoup plus lent que d'évaluer un seul échantillon de vision par ordinateur.

Si l'on devait évaluer un système robotique de bout en bout avec un niveau de diversité similaire à celui que nous avons fait avec ImageNet, une évaluation typique prendrait 1 semaine pour traiter des centaines de milliers de scénarios d'évaluation. Il ne s’agit pas d’une comparaison tout à fait raisonnable, puisque chaque épisode comporte en réalité environ 200 passes d’inférence, mais nous ne pouvons pas traiter les images d’un seul épisode comme des ensembles de validation indépendants. Sans aucune autre mesure de l'épisode, nous savons uniquement si la tâche a réussi, de sorte que toute inférence au sein de l'épisode ne contribue qu'à un seul échantillon de l'estimation binomiale. Nous devons estimer les taux de réussite sur la base de dizaines de milliers d’épisodes plutôt que d’images. Bien sûr, nous pourrions essayer d’utiliser d’autres méthodes d’évaluation des politiques, mais ces algorithmes ne sont pas encore suffisamment fiables pour fonctionner directement.

Dans l'étape suivante, nous procédons à une évaluation sur site du vrai robot. Dans le monde réel, l'évaluation de chaque épisode prend environ 30 secondes. Ainsi, si une équipe de 10 opérateurs effectue l'évaluation et que chaque opérateur peut réaliser 300 épisodes par jour, alors environ 3 000 évaluations peuvent être effectuées par jour.

S'il faut une journée entière pour évaluer un modèle, cela limite considérablement la productivité car vous ne pouvez essayer qu'une seule idée par jour. Nous ne pouvons donc plus travailler sur de petites idées qui améliorent progressivement les performances de 0,1 %, ou sur des idées très extrêmes. Il fallait trouver un moyen de faire un grand bond en avant en termes de performances. Même si cela semble bien, c'est difficile à mettre en pratique.

Lorsque vous envisagez un processus itératif d'apprentissage de robot, il est facile de voir le nombre d'essais d'évaluation dépasser de loin vos données d'entraînement ! Des mois d’évaluation continue ont produit environ des dizaines de milliers d’épisodes, ce qui est déjà plus volumineux que la plupart des ensembles de données de démonstration d’apprentissage robotique en profondeur.

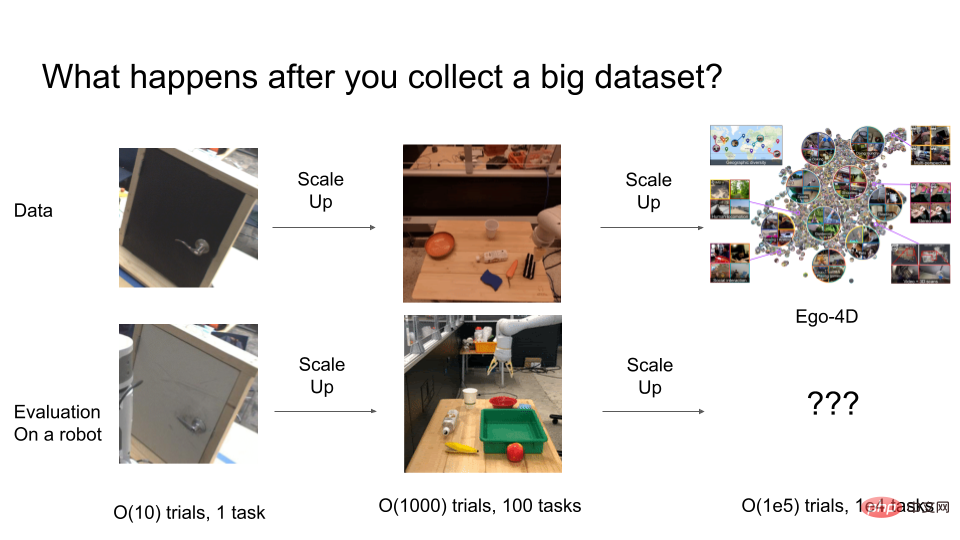

Il y a quelques années, les chercheurs résolvaient encore des problèmes comme faire en sorte que des bras robotiques ouvrent des portes, mais ces stratégies ne se généralisaient pas bien. Les chercheurs effectuent généralement des évaluations dans une séquence d’environ 10 épisodes. Mais 10 à 50 essais ne suffisent pas pour garantir la robustesse statistique. Pour obtenir de bons résultats, plus de 1 000 essais peuvent être effectués pour l'évaluation finale.

Mais que se passe-t-il lorsque l’essai est encore élargi ? Supposons que nous ayons finalement besoin de former un système robotique extrêmement général avec des comportements O (100 000). De combien d’essais avons-nous besoin pour évaluer un système aussi général ? C’est là que le coût de l’évaluation devient extrêmement élevé.

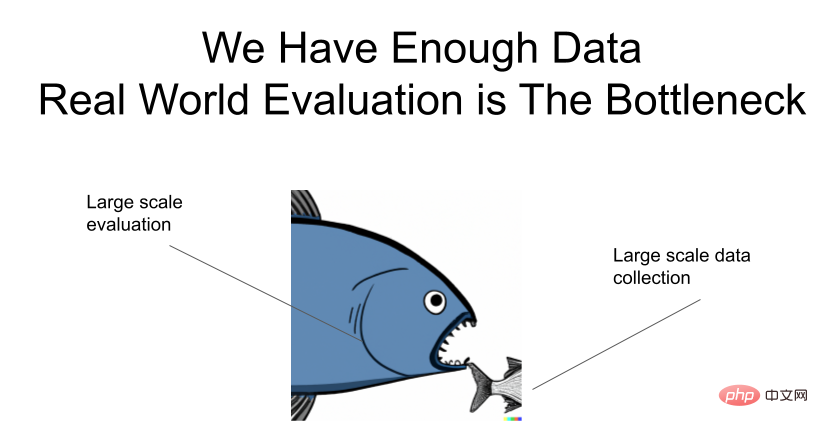

Je le souligne encore : les données sont suffisantes, mais il y a un goulot d'étranglement dans l'évaluation !

Comment accélérer l'évaluation ?

Voici quelques idées sur la façon d'accélérer l'évaluation des systèmes robotiques universels.

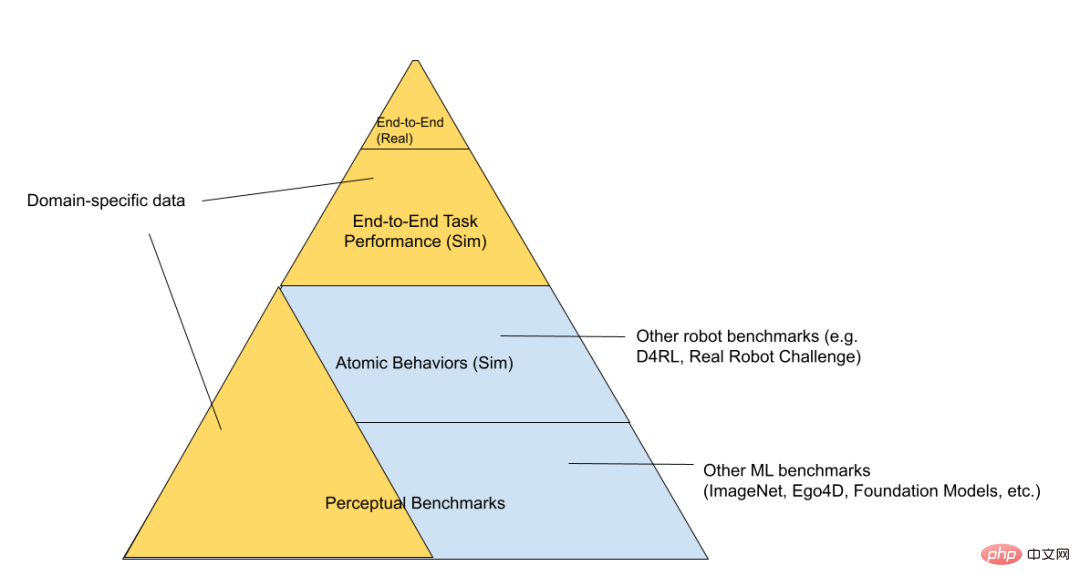

Une solution consiste à étudier séparément le problème de généralisation et le robot. En fait, la communauté du deep learning a déjà atteint cet objectif. La plupart des chercheurs en vision par ordinateur et en modélisation générative ne testent pas directement leurs idées sur des robots réels, mais s'attendent à ce qu'une fois que leurs modèles auront atteint de fortes capacités de généralisation, ils seront rapidement transférés aux robots. Les ResNets, développés dans le domaine de la vision par ordinateur, simplifient considérablement de nombreuses options de modélisation de mouvements visuels robotiques. Imaginez si un chercheur devait tester son idée sur un vrai robot à chaque fois qu’il voulait essayer une architecture de réseau neuronal différente ! Une autre réussite est CLIPort, qui dissocie les puissantes capacités de généralisation multimodale des modèles image-texte du raisonnement géométrique sous-jacent à la planification de la compréhension.

Nous pouvons diviser en outre la pile technologique RL en trois couches : « environnement de jouet simulé », « robot simulé » et « robot réel » (classés par ordre de difficulté croissante d'évaluation).

Au bas de la pyramide, il y a les benchmarks généraux, comme les benchmarks des compétitions Kaggle. En montant, il y a un ensemble de "problèmes de contrôle des jouets", qui étudient le problème de manière "bare metal", seuls le simulateur et le réseau neuronal fonctionnent, ainsi que tout le code lié aux robots du monde réel, comme la gestion de la batterie. , n'existe pas. En montant plus haut dans la pyramide, on arrive à des domaines plus spécifiques, plus pertinents par rapport au problème que vous essayez de résoudre. Par exemple, un « robot simulé » et un « robot réel » peuvent être utilisés pour la même tâche et réutiliser le même code robot sous-jacent. Les environnements de jouets simulés peuvent être utilisés pour étudier des algorithmes généraux, mais chevauchent moins le domaine de la robotique finale. Au sommet de la « pyramide d’évaluation » se trouvent les véritables tâches robotiques que nous essayons de résoudre. L'itération directe de ce processus est très lente, nous voulons donc tous passer le moins de temps possible ici. Nous espérons que les modèles de base formés et évalués aux niveaux inférieurs aideront à comprendre quelles idées fonctionnent sans avoir à effectuer chaque évaluation au niveau supérieur.

De même, le domaine fonctionne déjà de cette manière découplée. La plupart des personnes intéressées à contribuer aux robots ne les exploiteront pas nécessairement. Ils peuvent former des représentations visuelles et des architectures qui pourraient éventuellement être utiles aux robots. Bien entendu, l’inconvénient du découplage est que les améliorations des bases de perception ne correspondent pas toujours aux améliorations des capacités du robot. Par exemple, alors que la métrique mAP améliore la précision de la segmentation sémantique ou de la classification vidéo, ou même les tests de compression sans perte (ce qui en théorie devraient éventuellement y contribuer), nous ne savons pas comment les améliorations des objectifs de représentation se traduisent réellement par des améliorations dans les tâches en aval. En fin de compte, vous devez tester le système de bout en bout pour comprendre où se trouvent les véritables goulots d’étranglement.

Google a publié un article intéressant « Challenging Common Assumptions in Unsupervised Learning of Disentangled Representations ». Ils ont prouvé que de nombreuses méthodes d'apprentissage des représentations totalement non supervisées n'apporteront pas d'améliorations significatives des performances dans les tâches en aval, à moins que nous effectuions l'évaluation et. sélection de modèles en utilisant des critères finaux en aval qui nous tiennent à cœur.

Adresse papier : https://arxiv.org/pdf/1811.12359.pdf

Une autre façon de réduire le coût de l'évaluation est de garantir que le processus de collecte de données et d'évaluation est cohérent. Nous pouvons collecter simultanément des données d’évaluation et des données opérationnelles d’experts. Nous pouvons collecter des données HG-dagger grâce à certaines interventions, afin que des données de formation utiles puissent être collectées. Dans le même temps, le nombre moyen d’interventions par épisode peut nous indiquer approximativement si la stratégie est suffisamment efficace. Nous pouvons également observer des métriques scalaires au lieu de métriques binomiales car chaque épisode de ces métriques produit plus d'informations qu'un seul succès/échec.

L'utilisation d'algorithmes RL pour la collecte autonome de données est une autre façon de combiner évaluation et collecte de données, mais cette méthode nous oblige à noter manuellement les épisodes ou à utiliser une fonction de récompense soigneusement conçue. Toutes ces approches nécessitent le déploiement d’un grand nombre de robots dans le monde réel, qui s’enlise encore dans des itérations constantes dans le monde réel.

La façon de rendre l'algorithme d'évaluation plus rapide est d'améliorer l'algorithme de migration de la simulation vers le réel. Nous pouvons simuler plusieurs robots en parallèle donc il n’y a aucune contrainte. Mohi Khansari, Daniel Ho, Yuqing Du et d'autres ont développé une technique appelée « Perte de cohérence des tâches », qui régularise les représentations du sim et du réel en invariants, de sorte que la stratégie est en sim. Le comportement doit être similaire au réel. Lorsque nous migrons des stratégies évaluées en simulation vers des stratégies réelles, nous voulons nous assurer que les mesures de performances plus élevées en simulation correspondent également à des mesures de performances plus élevées en réalité. Plus l’écart sim-réel est petit, plus les indicateurs de l’expérience de simulation sont fiables.

Expressivité

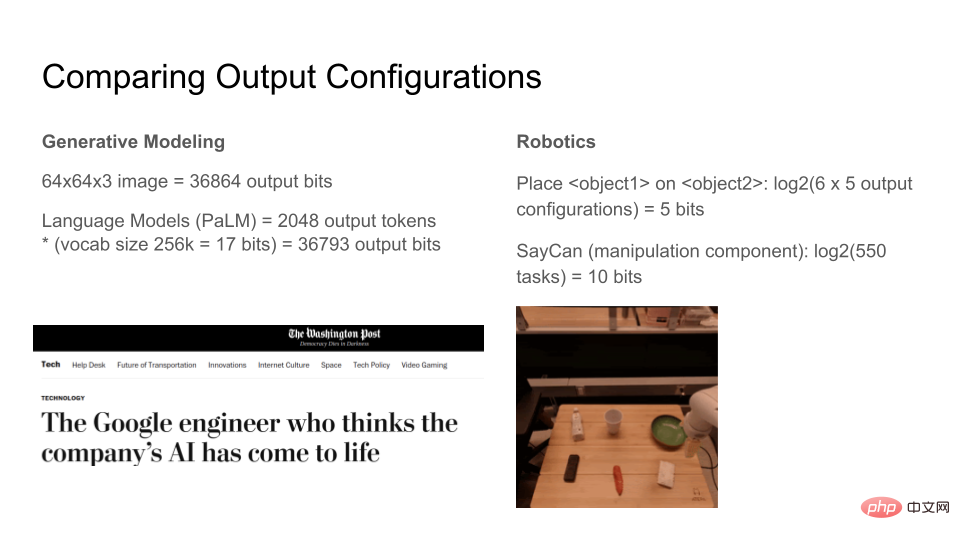

Voyons combien de bits un modèle génératif moderne peut produire. Une image RVB 64x64x3 avec 8 bits par canal équivaut à 36864 bits. Le modèle de langage peut générer n'importe quel nombre de jetons, mais si l'on fixe la fenêtre de sortie à 2048 jetons, chaque jeton a 17 bits, pour un total de 36793 bits. Par conséquent, les modèles de génération d’images et de texte peuvent synthétiser environ 37 kbits. À mesure que les modèles deviennent plus expressifs, la perception qu'en ont les gens connaîtra un saut qualitatif. Certains commencent même à penser que les modèles de langage sont partiellement conscients parce qu’ils sont très expressifs !

En comparaison, dans quelle mesure les robots actuels sont-ils expressifs ? Ici, nous concevons un environnement réel simplifié. Il y a 6 éléments sur la table. La tâche du robot est de déplacer un élément vers le haut d'un autre ou de transporter certains éléments, pour un total de 100 tâches. log2(100) fait environ 7 bits, ce qui signifie « étant donné l'état du monde, le robot peut déplacer les atomes vers l'un des N états, où N peut être décrit avec 7 bits ». L’algorithme SayCan de Google peut effectuer environ 550 opérations avec un seul réseau neuronal, ce qui est assez impressionnant par rapport aux normes actuelles d’apprentissage en profondeur de la robotique, en seulement 10 bits environ au total.

Cette comparaison n'est pas parfaitement raisonnable car la définition de l'information est différente entre les deux, elle n'est fournie ici que pour fournir une intuition approximative lorsque l'on mesure la complexité relative d'un ensemble de tâches par rapport à un autre. ce qui est important.

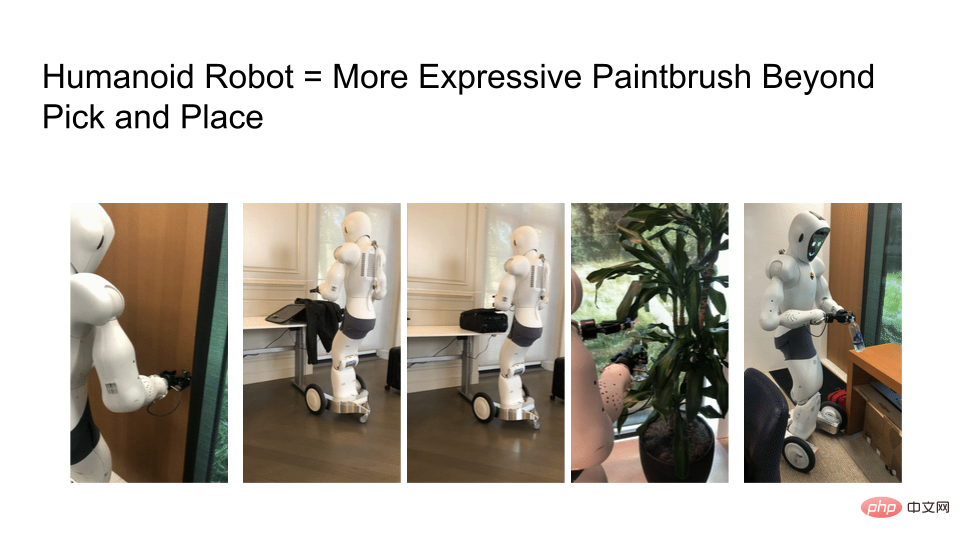

L'un des défis que nous avons rencontrés est que les fonctionnalités du robot sont encore limitées. Si vous regardez l’ensemble de données Ego4D, de nombreuses tâches nécessitent deux mains, mais la plupart des robots utilisent encore aujourd’hui un manipulateur mobile à un seul bras et à base de roues. Ils ne peuvent ni bouger ni aller nulle part, et évidemment tout ce que nous avons est un « bras robotique », ce qui exclut de nombreuses tâches intéressantes.

Nous devons étudier des robots plus expressifs, mais l'expressivité des algorithmes d'apprentissage des robots est limitée par le matériel. Ci-dessous, une photo du robot ouvrant une porte, préparant une valise, la fermant, arrosant une plante et retournant le bouchon d'une bouteille d'eau. À mesure que le matériel robotique se rapproche des vrais humains, le nombre de choses que vous pouvez faire dans un monde centré sur l’humain augmente de façon exponentielle.

À mesure que les robots deviennent plus expressifs, nous avons non seulement besoin de données de formation à l'échelle d'Internet, mais également de processus d'évaluation à l'échelle d'Internet. Si vous regardez les progrès des grands modèles de langage (LLM), de nombreux articles examinent actuellement le réglage et ce que les modèles existants peuvent et ne peuvent pas faire.

Par exemple, le benchmark de BigBench compile une série de tâches et demande ce que nous pouvons gagner de ces modèles. OpenAI permet aux internautes d'évaluer leurs modèles DALLE-2 et GPT-3. Leurs équipes d'ingénierie et de produits peuvent apprendre des expériences d'IA impliquées par les utilisateurs, car les détails des modèles LLM sont difficiles à maîtriser pour un seul chercheur.

Enfin, une question pour les lecteurs, quelle est la technologie équivalente à l'API GPT-3 ou DALLE-2 dans le domaine de la robotique ? Grâce à cette technologie équivalente, les chercheurs de la communauté Internet peuvent-ils remettre en question la recherche sur les robots et comprendre ce qu’ils peuvent réellement faire ?

Enfin, utilisez un tableau pour résumer la comparaison entre optimisation, évaluation et expressivité :

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Cet article vous amènera à comprendre SHAP : explication du modèle pour l'apprentissage automatique

Jun 01, 2024 am 10:58 AM

Cet article vous amènera à comprendre SHAP : explication du modèle pour l'apprentissage automatique

Jun 01, 2024 am 10:58 AM

Dans les domaines de l’apprentissage automatique et de la science des données, l’interprétabilité des modèles a toujours été au centre des préoccupations des chercheurs et des praticiens. Avec l'application généralisée de modèles complexes tels que l'apprentissage profond et les méthodes d'ensemble, la compréhension du processus décisionnel du modèle est devenue particulièrement importante. Explainable AI|XAI contribue à renforcer la confiance dans les modèles d'apprentissage automatique en augmentant la transparence du modèle. L'amélioration de la transparence des modèles peut être obtenue grâce à des méthodes telles que l'utilisation généralisée de plusieurs modèles complexes, ainsi que les processus décisionnels utilisés pour expliquer les modèles. Ces méthodes incluent l'analyse de l'importance des caractéristiques, l'estimation de l'intervalle de prédiction du modèle, les algorithmes d'interprétabilité locale, etc. L'analyse de l'importance des fonctionnalités peut expliquer le processus de prise de décision du modèle en évaluant le degré d'influence du modèle sur les fonctionnalités d'entrée. Estimation de l’intervalle de prédiction du modèle

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

Implémentation d'algorithmes d'apprentissage automatique en C++ : défis et solutions courants

Jun 03, 2024 pm 01:25 PM

Implémentation d'algorithmes d'apprentissage automatique en C++ : défis et solutions courants

Jun 03, 2024 pm 01:25 PM

Les défis courants rencontrés par les algorithmes d'apprentissage automatique en C++ incluent la gestion de la mémoire, le multithread, l'optimisation des performances et la maintenabilité. Les solutions incluent l'utilisation de pointeurs intelligents, de bibliothèques de threads modernes, d'instructions SIMD et de bibliothèques tierces, ainsi que le respect des directives de style de codage et l'utilisation d'outils d'automatisation. Des cas pratiques montrent comment utiliser la bibliothèque Eigen pour implémenter des algorithmes de régression linéaire, gérer efficacement la mémoire et utiliser des opérations matricielles hautes performances.

Surpassant largement le DPO : l'équipe de Chen Danqi a proposé une optimisation simple des préférences SimPO et a également affiné le modèle open source 8B le plus puissant.

Jun 01, 2024 pm 04:41 PM

Surpassant largement le DPO : l'équipe de Chen Danqi a proposé une optimisation simple des préférences SimPO et a également affiné le modèle open source 8B le plus puissant.

Jun 01, 2024 pm 04:41 PM

Afin d'aligner les grands modèles de langage (LLM) sur les valeurs et les intentions humaines, il est essentiel d'apprendre les commentaires humains pour garantir qu'ils sont utiles, honnêtes et inoffensifs. En termes d'alignement du LLM, une méthode efficace est l'apprentissage par renforcement basé sur le retour humain (RLHF). Bien que les résultats de la méthode RLHF soient excellents, certains défis d’optimisation sont impliqués. Cela implique de former un modèle de récompense, puis d'optimiser un modèle politique pour maximiser cette récompense. Récemment, certains chercheurs ont exploré des algorithmes hors ligne plus simples, dont l’optimisation directe des préférences (DPO). DPO apprend le modèle politique directement sur la base des données de préférence en paramétrant la fonction de récompense dans RLHF, éliminant ainsi le besoin d'un modèle de récompense explicite. Cette méthode est simple et stable

Cinq écoles d'apprentissage automatique que vous ne connaissez pas

Jun 05, 2024 pm 08:51 PM

Cinq écoles d'apprentissage automatique que vous ne connaissez pas

Jun 05, 2024 pm 08:51 PM

L'apprentissage automatique est une branche importante de l'intelligence artificielle qui donne aux ordinateurs la possibilité d'apprendre à partir de données et d'améliorer leurs capacités sans être explicitement programmés. L'apprentissage automatique a un large éventail d'applications dans divers domaines, de la reconnaissance d'images et du traitement du langage naturel aux systèmes de recommandation et à la détection des fraudes, et il change notre façon de vivre. Il existe de nombreuses méthodes et théories différentes dans le domaine de l'apprentissage automatique, parmi lesquelles les cinq méthodes les plus influentes sont appelées les « Cinq écoles d'apprentissage automatique ». Les cinq grandes écoles sont l’école symbolique, l’école connexionniste, l’école évolutionniste, l’école bayésienne et l’école analogique. 1. Le symbolisme, également connu sous le nom de symbolisme, met l'accent sur l'utilisation de symboles pour le raisonnement logique et l'expression des connaissances. Cette école de pensée estime que l'apprentissage est un processus de déduction inversée, à travers les connaissances existantes.

IA explicable : Expliquer les modèles IA/ML complexes

Jun 03, 2024 pm 10:08 PM

IA explicable : Expliquer les modèles IA/ML complexes

Jun 03, 2024 pm 10:08 PM

Traducteur | Revu par Li Rui | Chonglou Les modèles d'intelligence artificielle (IA) et d'apprentissage automatique (ML) deviennent aujourd'hui de plus en plus complexes, et le résultat produit par ces modèles est une boîte noire – impossible à expliquer aux parties prenantes. L'IA explicable (XAI) vise à résoudre ce problème en permettant aux parties prenantes de comprendre comment fonctionnent ces modèles, en s'assurant qu'elles comprennent comment ces modèles prennent réellement des décisions et en garantissant la transparence des systèmes d'IA, la confiance et la responsabilité pour résoudre ce problème. Cet article explore diverses techniques d'intelligence artificielle explicable (XAI) pour illustrer leurs principes sous-jacents. Plusieurs raisons pour lesquelles l’IA explicable est cruciale Confiance et transparence : pour que les systèmes d’IA soient largement acceptés et fiables, les utilisateurs doivent comprendre comment les décisions sont prises

Aucune donnée OpenAI requise, rejoignez la liste des grands modèles de code ! UIUC publie StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

Aucune donnée OpenAI requise, rejoignez la liste des grands modèles de code ! UIUC publie StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

À la pointe de la technologie logicielle, le groupe de l'UIUC Zhang Lingming, en collaboration avec des chercheurs de l'organisation BigCode, a récemment annoncé le modèle de grand code StarCoder2-15B-Instruct. Cette réalisation innovante a permis une percée significative dans les tâches de génération de code, dépassant avec succès CodeLlama-70B-Instruct et atteignant le sommet de la liste des performances de génération de code. Le caractère unique de StarCoder2-15B-Instruct réside dans sa stratégie d'auto-alignement pur. L'ensemble du processus de formation est ouvert, transparent et complètement autonome et contrôlable. Le modèle génère des milliers d'instructions via StarCoder2-15B en réponse au réglage fin du modèle de base StarCoder-15B sans recourir à des annotations manuelles coûteuses.

Flash Attention est-il stable ? Meta et Harvard ont constaté que les écarts de poids de leur modèle fluctuaient de plusieurs ordres de grandeur.

May 30, 2024 pm 01:24 PM

Flash Attention est-il stable ? Meta et Harvard ont constaté que les écarts de poids de leur modèle fluctuaient de plusieurs ordres de grandeur.

May 30, 2024 pm 01:24 PM

MetaFAIR s'est associé à Harvard pour fournir un nouveau cadre de recherche permettant d'optimiser le biais de données généré lors de l'apprentissage automatique à grande échelle. On sait que la formation de grands modèles de langage prend souvent des mois et utilise des centaines, voire des milliers de GPU. En prenant comme exemple le modèle LLaMA270B, sa formation nécessite un total de 1 720 320 heures GPU. La formation de grands modèles présente des défis systémiques uniques en raison de l’ampleur et de la complexité de ces charges de travail. Récemment, de nombreuses institutions ont signalé une instabilité dans le processus de formation lors de la formation des modèles d'IA générative SOTA. Elles apparaissent généralement sous la forme de pics de pertes. Par exemple, le modèle PaLM de Google a connu jusqu'à 20 pics de pertes au cours du processus de formation. Le biais numérique est à l'origine de cette imprécision de la formation,