Périphériques technologiques

Périphériques technologiques

IA

IA

Les raisons techniques du succès de ChatGPT et son inspiration pour le domaine des sciences de la vie

Les raisons techniques du succès de ChatGPT et son inspiration pour le domaine des sciences de la vie

Les raisons techniques du succès de ChatGPT et son inspiration pour le domaine des sciences de la vie

Dès les années 1950, certains chercheurs ont proposé le concept d'intelligence artificielle (Artificial Intelligence), dont le but était de faire en sorte que les ordinateurs possèdent une intelligence humaine (ou une partie de l'intelligence humaine). Après de nombreuses années de développement dans ce domaine, aucune avancée majeure n’a été réalisée jusqu’à l’émergence de la technologie du deep learning en 2012. L'apprentissage profond résout principalement le goulot d'étranglement des capacités de représentation des modèles. Les problèmes de modélisation auxquels nous sommes confrontés, tels que la compréhension des images, la traduction du langage, la reconnaissance vocale, la prédiction de la conformation des liaisons molécule-protéine et d'autres technologies, sont tous des problèmes non linéaires très complexes. Avant l'émergence de l'apprentissage profond, la capacité de représentation du modèle était très faible et incapable. à une représentation précise de ces problèmes complexes. La technologie d'apprentissage profond peut théoriquement créer des modèles de n'importe quelle profondeur grâce à l'empilement de modèles en couches, éliminant ainsi le goulot d'étranglement des capacités de représentation des modèles, réalisant ainsi des progrès révolutionnaires dans des domaines tels que la reconnaissance vocale, la vision par ordinateur et la compréhension du langage naturel.

L'émergence de la technologie d'apprentissage profond marque que l'intelligence artificielle est entrée dans une nouvelle étape. Appelons la vague d'intelligence artificielle entraînée par l'apprentissage profond qui a commencé vers 2012 une nouvelle génération d'ère d'intelligence artificielle (en fait l'application de l'apprentissage profond dans le domaine de la reconnaissance vocale remonte à ses débuts, mais étant donné que de nombreuses avancées ultérieures en matière d'apprentissage profond sont venues du domaine de la vision par ordinateur, nous prenons l'émergence d'AlexNet en 2012 comme point de départ). Cette période peut être considérée comme la première étape de la nouvelle génération d'intelligence artificielle pilotée par l'apprentissage profond, c'est-à-dire le modèle d'apprentissage profond basé sur les données d'annotation, qui a considérablement amélioré les capacités de représentation du modèle, favorisant ainsi l'amélioration significative de l'intelligence artificielle. technologie, et dans les domaines de la vision par ordinateur et de la reconnaissance vocale ont obtenu un succès produit et commercial. La principale limite de cette étape est qu’elle dépend fortement de la quantité de données étiquetées. À mesure que le nombre de paramètres du modèle augmente, une grande quantité de données d’entraînement est nécessaire comme contrainte pour résoudre autant de paramètres du modèle. Il est très coûteux d'obtenir une grande quantité de données annotées, et il sera difficile de s'améliorer après avoir atteint le niveau de 100 millions, et la taille effective du modèle prise en charge par les données est également limitée. Au cours de la période 2012 à 2015, la vision par ordinateur était le domaine le plus actif, avec l'émergence de divers modèles de réseaux profonds, dont ResNet. En 2017, une œuvre de base importante, Transformer, est apparue. En 2019, dans le domaine du traitement du langage naturel (NLP), qui n'a pas pu réaliser de percées majeures, un travail appelé BERT s'est démarqué et a obtenu les meilleurs résultats dans plus d'une douzaine de tâches différentes de traitement du langage naturel (NLP). les différences entre ces tâches sont très importantes, c'est pourquoi, après la publication des travaux du BERT, ils ont immédiatement attiré l'attention de l'ensemble du domaine. BERT adopte une idée appelée Pré-formation auto-supervisée

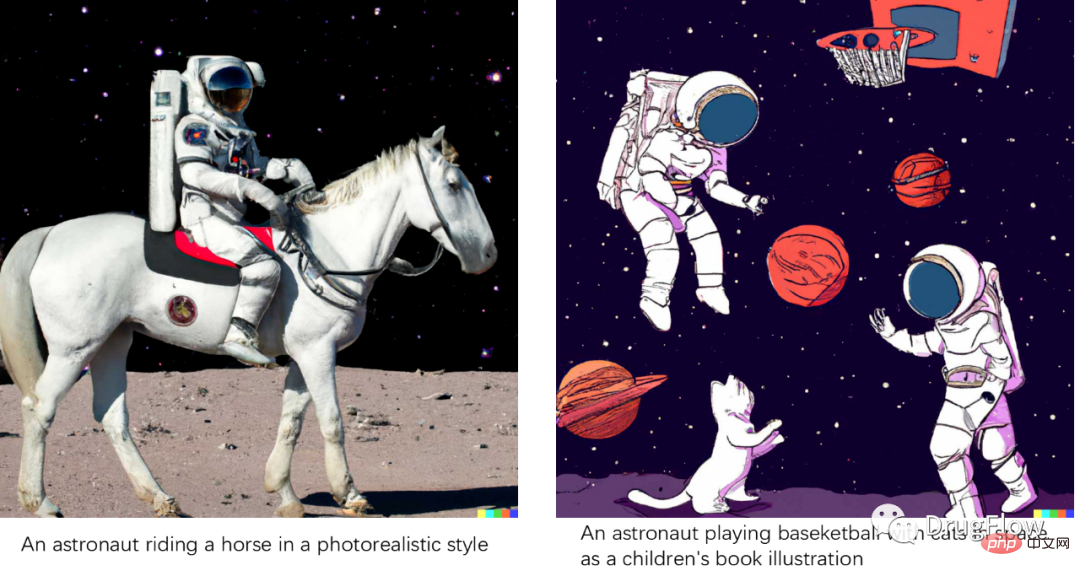

Il peut entraîner le modèle sans étiqueter les données et utilise uniquement les contraintes du corpus de texte lui-même (par exemple, seuls certains mots limités peuvent être utilisés dans une certaine position). d'une phrase) , afin qu'un corpus de haute qualité existant sur Internet puisse être utilisé pour la formation sans calibrage manuel, ce qui augmente soudainement considérablement la quantité de données de formation disponibles. Couplé à de grands modèles, l'effet du modèle BERT est bien meilleur que celui du modèle BERT. dans le passé, le modèle présente une bonne polyvalence entre différentes tâches et est devenu l'un des jalons dans le domaine de la PNL.En fait, avant l'apparition de BERT en 2018, il existait un autre travail appelé GPT (c'est-à-dire GPT1.0), qui utilisait auparavant l'idée depré-formation auto-supervisée pour la génération de texte, c'est-à-dire la saisie le texte précédent et la prédiction du modèle Sortez le texte suivant et un corpus de haute qualité sur le terrain peut être formé sans annotation. BERT et GPT ont été développés sur la base de Transformer, et Transformer est progressivement devenu un modèle général dans le domaine de l'IA. L'effet de GPT1.0 n'est pas étonnant. Peu de temps après l'émergence de BERT, GPT a rapidement publié GPT2.0. La taille du modèle et la quantité de données de formation ont été considérablement améliorées. En tant que modèle général (c'est-à-dire sans tâches en aval pour la formation et les résultats de tests directs), les résultats sont meilleurs. que les actuels sur la plupart des tâches. Il existe des modèles. Cependant, comme le modèle BERT présente plus d'avantages que le modèle GPT2.0 en termes de représentation des fonctionnalités et est plus facile à entraîner, le travail le plus concerné dans le domaine à ce stade reste BERT. Mais en juillet 2020, GPT3.0 est né, époustouflant tout le monde avec 170 milliards de paramètres. Plus important encore, en termes d'effet, GPT3.0 sert de modèle de langage universel. Il suffit de lui fournir une simple description pour décrire la génération. que vous souhaitez générer. En fonction du contenu, vous pouvez générer du code exécutable, générer des pages Web ou des icônes, compléter un article ou une actualité et écrire de la poésie et de la musique selon des invites sans vous recycler. Après l'émergence de GPT3.0, il a reçu une large attention de la part de l'industrie. De nombreux développeurs ont créé de nombreuses applications intéressantes basées sur GPT3.0. GPT3.0 est devenu le modèle de génération de texte le meilleur et le plus populaire. Après l'émergence de la technologie de pré-entraînement auto-supervisé, nous pouvons penser que la nouvelle génération d'intelligence artificielle est passée à la deuxième étape, c'est-à-dire que la technologie de pré-entraînement auto-supervisé a amélioré les données d'entraînement disponibles en plusieurs ordres de grandeur, et les données de formation ont été grandement améliorées Avec le soutien de L'ère des grands modèles généraux basés sur la pré-formation auto-supervisée. Après , GPT3.0, ainsi que d’autres travaux dans le domaine, ont déclenché une vague de courses aux armements de taille réduite, mais peu de technologies véritablement révolutionnaires ont émergé. Tout le monde se rend compte que le simple fait d’augmenter la taille du modèle ne résout pas fondamentalement le problème. Juste au moment où tout le monde attend avec impatience l'émergence de travaux de suivi tels que GPT4.0, GPT n'a pas été mis à jour depuis deux années complètes. Au cours de cette période, les travaux les plus actifs dans le domaine de l'intelligence artificielle se sont principalement concentrés sur deux aspects, les modèles unifiés multimodaux et la génération de contenu. Modèle unifié multimodal, dans l'espoir de construire un modèle unifié multimodal ou intermodal, essayant de représenter uniformément différentes données modales telles que le texte, l'image et la voix dans un seul modèle, y compris le premier modèle de représentation intermodale CLIP, et une série de modèles de représentation unifiée multimodale. Dans le domaine de la génération de contenu, d'une part, au niveau technique, des modèles de base tels que le modèle de diffusion ont émergé. Le développement du modèle de diffusion et d'une série de modèles variantes a fait le domaine de la génération de contenu d'intelligence artificielle (IA). Generated Content, AIGC) est devenu très en vogue et s'est étendu du domaine de la génération d'images aux domaines du traitement du langage naturel et des sciences de la vie. En revanche, au niveau des applications, de nombreux progrès substantiels ont été réalisés. domaine de la génération d'images basée sur le texte. Parmi eux, l'ouvrage le plus représentatif, DALLE2, le modèle peut suivre le texte saisi et produire des images qui semblent réalistes, et même lorsque la description textuelle dépasse la réalité, il est toujours possible de générer des images. qui semblent raisonnablement conformes à la description textuelle, comme le montre la figure ci-dessous. Le succès d'une série de travaux comme DALLE2 est dû d'une part à la grande quantité de données de correspondance texte-image (environ des centaines de millions de paires), qui modélise la correspondance entre sémantique texte et image, et d'autre part au modèle de diffusion qui surmonte le GAN, le VAE et d'autres modèles présentent des inconvénients tels qu'une difficulté de formation et une mémorisation insuffisante des détails des effets générés. Les effets de génération d’images sont si époustouflants que beaucoup de gens pensent que l’IA peut déjà créer du contenu.

Image. Effet de génération DALLE2

Le temps est venu à la fin du mois de novembre 2022, OpenAI a publié ChatGPT. Après la sortie de ChatGPT, tout le monde a trouvé que ce chatbot était très inhabituel et donnait souvent des réponses étonnantes. Il existe de nombreux robots conversationnels dans le domaine des robots conversationnels, tels que Siri d'Apple, Xiaobing Xiaona de Microsoft, etc. L'expérience de ces systèmes conversationnels généraux n'est pas très idéale. Les gens les utilisent pour les taquiner puis les jeter de côté. Le cadre système des robots de questions-réponses d'exécution de commandes utilisés dans des produits tels que les haut-parleurs intelligents est basé sur des systèmes de gestion de dialogue basés sur des règles. Il existe un grand nombre de règles manuelles, ce qui rend ces systèmes incapables d'être étendus à des domaines généraux. et ne peut fournir que des réponses simples et stylisées, en revanche, ne peut pas gérer les informations sémantiques environnementales (Contexte) de plusieurs cycles de dialogue. D'un point de vue technique, ChatGPT est complètement différent du système de dialogue traditionnel d'origine. L'ensemble du système est basé sur un grand modèle de génération profonde. Pour une entrée donnée, il est traité par le modèle profond et génère directement une réponse résumée. En termes d'expérience produit, ChatGPT surpasse également de loin les anciens systèmes de chat. En tant que chatbot général, il peut répondre à des questions dans presque tous les domaines, et sa précision a atteint un niveau tel que les humains sont prêts à continuer à l'utiliser. Il peut toujours maintenir une très bonne expérience dans plusieurs séries de scénarios de dialogue.

Bien sûr, ChatGPT n'est pas parfait. En tant que modèle d'apprentissage profond, ChatGPT présente des défauts qui ne peuvent pas être précis à 100 % pour certaines questions qui nécessitent des réponses précises (comme les calculs mathématiques, le raisonnement logique ou les noms, etc.). , il y aura des erreurs perceptibles. Il y a eu quelques améliorations plus tard. Par exemple, certains travaux fourniront des liens Web de référence pour obtenir des informations. Dans le dernier travail de Facebook ToolFormer , ils essaient de confier des tâches spécifiques à des API spécifiques pour le calcul dans le modèle généré. Le modèle devrait résoudre le problème selon lequel le modèle ne peut pas être précis à 100 %. Si cette voie continue, le modèle génératif profond devrait devenir le cadre central de l'AGI, et il est très excitant de penser à l'intégration d'autres API de compétences via des plug-ins.

Sur le plan commercial, d'une part, ChatGPT a suscité l'imagination sur les défis des moteurs de recherche tels que Google. D'autre part, tout le monde a vu diverses opportunités d'applications de produits verticaux liées à la compréhension du langage naturel. Il ne fait aucun doute que ChatGPT crée une nouvelle opportunité commerciale dans le domaine de la compréhension du langage naturel qui pourrait rivaliser avec les recommandations de recherche.

Pourquoi ChatGPT a-t-il des effets si étonnants ? L'une des principales raisons est que ChatGPT est construit sur la base du grand modèle génératif GPT3.5, qui devrait être le meilleur modèle de génération de texte dans le domaine actuel de la compréhension du langage naturel (GPT3.5 utilise plus de données et est plus grand que le modèle GPT3.0, avec de meilleurs résultats).

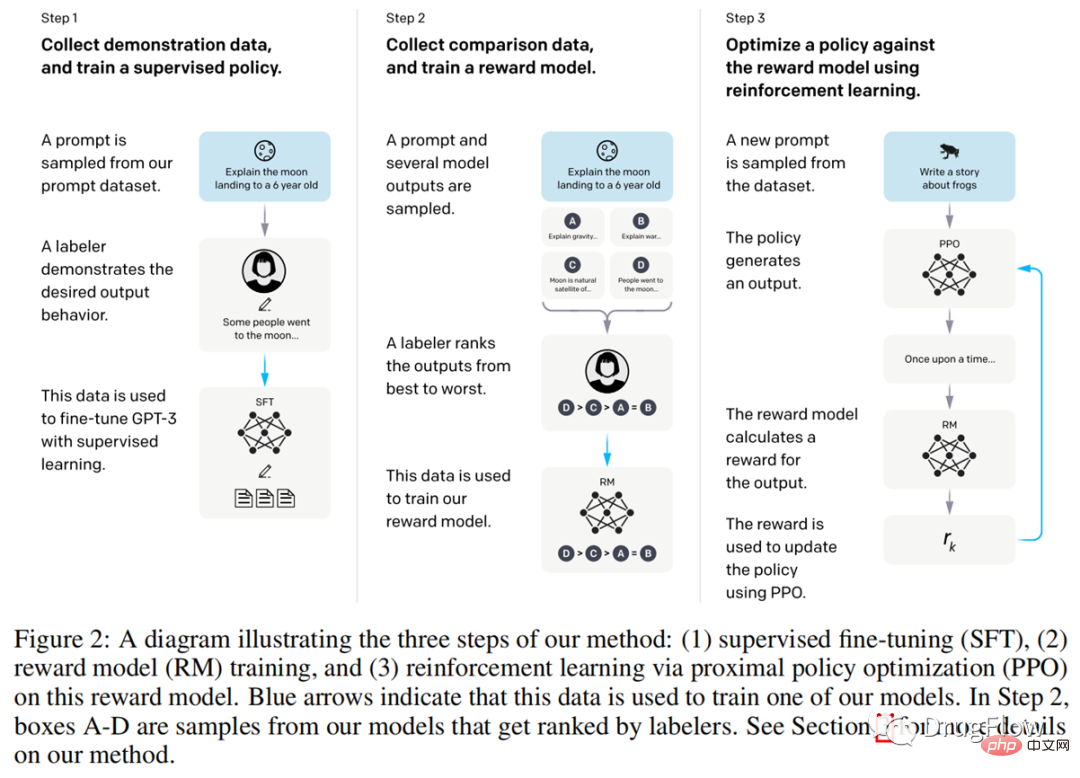

La deuxième raison principale est la technologie d'apprentissage par renforcement basée sur la rétroaction humaine, à savoir l'apprentissage par renforcement à partir de la rétroaction humaine (en abrégé RLHF). Étant donné qu'OpenAI n'a pas publié d'article sur ChatGPT et n'a pas rendu le code public, on pense généralement qu'il est très similaire à la technologie divulguée dans un article précédent, InstructGPT (https://arxiv.org/pdf/2203.02155.pdf ). Comme le montre la figure ci-dessous, selon la description dans InstructGPT, la première étape consiste à collecter les données de préférence de l'utilisateur pour différentes réponses à la même question ; la deuxième étape consiste à utiliser ces données de préférence pour recycler le modèle GPT. sur le réglage fin des informations de supervision ; La troisième étape consiste à former une fonction de notation en fonction des préférences de l'utilisateur pour différentes réponses. Un score sera attribué pour la réponse de ChatGPT. Ce score reflétera la préférence de l'utilisateur pour différentes réponses. L'étape consiste à utiliser cette fonction de notation comme méthode d'apprentissage par renforcement. Feedback (Récompense) entraîne le modèle d'apprentissage par renforcement, ce qui rend les réponses finales produites par ChatGPT plus orientées vers les réponses appréciées des utilisateurs. Grâce au processus ci-dessus, ChatGPT génère des réponses plus conviviales aux entrées des utilisateurs basées sur GPT3.5.

ChatGPT La première étape de formation du modèle de génération GPT utilise beaucoup de données de formation, environ des dizaines de To, et la formation d'un modèle coûte des dizaines de millions de dollars, tandis que la deuxième étape est basée sur l'apprentissage par renforcement Une petite quantité de retours de données de haute qualité ne nécessite que des dizaines de milliers de données de haute qualité. Nous pouvons voir que la technologie ChatGPT est basée sur de grands modèles de pré-formation auto-supervisés combinés à une technologie d'apprentissage par renforcement basée sur le feedback humain, et a fait des progrès très significatifs. Ce nouveau paradigme pourrait devenir la technologie de base de la troisième étape de l'intelligence artificielle, c'est-à-dire d'abord basée sur de grands modèles de pré-formation auto-supervisée, puis combinée avec une technologie d'apprentissage par renforcement basée sur une petite quantité d'informations de haut niveau. un retour de données de qualité pour former une boucle fermée de modèles et un retour de données pour obtenir de nouvelles avancées technologiques.

Concernant ChatGPT, nos avis sont les suivants :

(1) ChatGPT est en effet l'un des plus grands travaux de cette époque, nous permettant de voir la différence entre générer de grands modèles basés sur des pré-supervisés auto-supervisés. -formation et basée sur un petit nombre de haute qualité L'effet étonnant de l'IA après les résultats de la stratégie de rétroaction d'apprentissage par renforcement des données a changé notre cognition dans un sens.

(2) Les technologies liées à ChatGPT ont une très grande valeur commerciale, ce qui fait que de nombreux produits, y compris les moteurs de recherche, ont la possibilité d'être reconstruits ou subvertis. Cela apportera sans aucun doute de nombreuses nouvelles opportunités commerciales et l'ensemble du domaine de la PNL en bénéficiera.

(3) Le paradigme d'apprentissage basé sur une stratégie de rétroaction de pré-formation et d'apprentissage par renforcement auto-supervisée basée sur une petite quantité de données de haute qualité devrait devenir la force motrice de l'avancement de divers domaines à l'avenir. En plus du domaine de la PNL, elle devrait être utilisée dans les sciences de la vie et la robotique, la conduite autonome et d'autres domaines ont déclenché un nouveau boom de l'intelligence artificielle.

(4) ChatGPT ne prouve pas que l'intelligence artificielle a un esprit humain. Une partie de la créativité et de l'intelligence démontrée par ChatGPT est due au fait que le corpus de compréhension du langage naturel contient de la sémantique et de la logique, et que le modèle génératif est formé sur la base du naturel. corpus linguistique. , ces correspondances ont été apprises dans un sens statistique, et il semble avoir de l'intelligence, mais il n'a pas vraiment d'esprit humain. ChatGPT est génial, mais il n'est pas assez rigoureux pour dire que son intelligence est égale à celle d'un enfant de plusieurs années. Car fondamentalement, l’IA n’a pas encore la capacité de permettre aux gens d’acquérir de nouvelles connaissances, d’effectuer un raisonnement logique, de faire preuve d’imagination et de faire des retours de mouvement. Un battage médiatique excessif sur l’intelligence et les capacités de ChatGPT chassera les bonnes pièces et nuira à l’ensemble du secteur.

(5) Dans ce domaine, il existe encore une lacune dans la technologie chinoise. Au cours des deux dernières années, nous n'avons pas vu de modèle de génération de texte capable de reproduire véritablement l'effet de GPT3.0 et 3.5. il n'y aurait pas de ChatGPT. Des travaux tels que GPT3, GPT3.5 et ChatGPT ne sont pas open source, et même l'API est bloquée en Chine. Il s'agit d'une difficulté pratique pour copier des travaux. Pour le dire de manière plus pessimiste, la plupart des équipes qui souhaitent reproduire les effets de ChatGPT n’y parviendront pas.

(6) ChatGPT n'est pas une avancée algorithmique réalisée par un ou deux chercheurs, mais le résultat d'un système d'ingénierie algorithmique très complexe guidé par des concepts avancés, qui doit être adapté en termes d'équipe et d'organisation (analogue à OpenAI et DeepMind). Une équipe purement axée sur la recherche risque de ne pas réussir, tout comme une équipe qui ne comprend pas suffisamment l’apprentissage profond et qui est trop orientée vers l’ingénierie. Cette équipe a besoin : premièrement, d'un soutien en ressources suffisant pour prendre en charge une formation coûteuse en apprentissage en profondeur et le recrutement de talents ; deuxièmement, des leaders experts qui ont véritablement dirigé de grandes équipes d'ingénierie dans l'industrie ont non seulement l'innovation en matière d'algorithmes, mais aussi l'innovation en matière de systèmes d'ingénierie ; troisièmement, et c'est peut-être le plus important, cela nécessite une organisation unie, qui collabore, qui a un leadership unifié et qui ne cherche pas à publier des articles (une organisation lâche est propice à l'innovation en matière d'algorithmes, mais pas à la recherche sur les algorithmes d'ingénierie), et qui est adéquatement adaptée. équipé. Quels grands talents en ingénierie et en algorithmique.

(7) Nous cherchons non seulement à créer un ChatGPT, mais continuons également à poursuivre l'innovation technologique qui se cache derrière, c'est-à-dire à développer vigoureusement une pré-formation auto-supervisée pour générer de grands modèles et une technologie de stratégie de retour d'apprentissage par renforcement basée sur un petite quantité de données de haute qualité. C'est la prochaine génération. La technologie de base de ChatGPT est également la technologie qui favorise le progrès global dans le domaine de l'intelligence artificielle. La plus grande préoccupation est que beaucoup de ressources seront gaspillées en raison de la dispersion du pouvoir due à la spéculation et à la poursuite des tendances, ou qu'une publicité excessive de ChatGPT nuira à l'industrie.

(8) ChatGPT a encore place à l'amélioration, et ce n'est pas la seule technologie digne d'attention et d'attente. L’idée fausse la plus répandue à propos de l’IA est de surestimer ses performances à court terme et de sous-estimer ses performances à long terme. Nous vivons une époque formidable dans laquelle l’IA est devenue la principale force motrice, mais l’IA ne deviendra pas omnipotente aussi rapidement et nécessite nos efforts à long terme.

Nous résumons brièvement ici l'évolution technologique clé dans la nouvelle génération de vague d'intelligence artificielle provoquée par l'apprentissage profond depuis 2012 :

(1) Dans la première étape, le progrès clé est étiqueté datadriven The Le modèle d'apprentissage profond supervisé a considérablement amélioré les capacités de représentation du modèle, favorisant ainsi des progrès significatifs dans la technologie de l'intelligence artificielle. Les domaines les plus actifs à ce stade sont la vision par ordinateur et la reconnaissance vocale. La principale limite est que les données étiquetées sont relativement coûteuses, ce qui limite ce qui se passe. La quantité de données, à son tour, limite la taille effective du modèle que les données peuvent prendre en charge.

(2) Dans la deuxième étape, le progrès clé est le pré-entraînement auto-supervisé de grands modèles généraux basés sur le Big Data La technologie de pré-entraînement auto-supervisé a amélioré les données d'entraînement disponibles de plusieurs fois. ordres de grandeur, prenant ainsi en charge la taille du modèle a également été améliorée de plusieurs ordres de grandeur, devenant un modèle général qui n'a pas besoin de s'appuyer sur les données des champs de tâches en aval pour le recyclage du domaine de la compréhension du langage naturel. le plus progressé et est le plus actif à ce stade ; la principale limitation est qu'il nécessite une formation massive de données, et le modèle est très volumineux, très coûteux à former et à utiliser, et il est également très peu pratique de recycler le modèle de scène verticale. .

(3) Même si la troisième étape ne peut pas encore être finalisée, elle montre une certaine tendance. Une clé technique très importante à l'avenir est de savoir si, sur la base du grand modèle, l'apprentissage par renforcement, les invites et d'autres méthodes peuvent être utilisées pour affecter de manière significative les résultats de sortie du grand modèle avec seulement une petite quantité de données de haute qualité . Si cette technologie décolle, des domaines tels que la conduite autonome, la robotique et les sciences de la vie, où l’acquisition de données est coûteuse, en bénéficieront considérablement. Dans le passé, si l’on souhaitait améliorer les problèmes d’un modèle d’IA, il fallait collecter une grande quantité de données et recycler le modèle. Si, dans le domaine des robots qui nécessitent une interaction hors ligne, sur la base de grands modèles pré-entraînés, la prise de décision du robot ne peut être affectée qu'en l'informant de certains choix d'action corrects et erronés dans des scènes réelles, alors la technologie en les domaines de la conduite sans conducteur et de la robotique seront plus efficaces. Dans le domaine des sciences de la vie, si seulement une petite quantité de données expérimentales pouvait affecter de manière significative les résultats de prédiction du modèle, la révolution dans l’intégration de l’ensemble du domaine des sciences de la vie avec l’informatique se produirait plus rapidement. À ce stade, ChatGPT constitue une étape très importante et je pense qu’il y aura beaucoup de travail à venir.

Revenons au domaine des sciences de la vie qui nous préoccupe davantage.

Étant donné que les progrès technologiques apportés par ChatGPT ont amélioré la plupart des domaines liés à la PNL, les technologies et produits liés à la requête, à la récupération et à l'extraction d'informations dans le domaine des sciences de la vie en bénéficieront en premier. Par exemple, est-il possible qu'à l'avenir il y ait un moteur de recherche vertical conversationnel dans le domaine des sciences de la vie ? Les experts pourront lui poser toutes les questions (telles que des questions sur les maladies, les cibles, les protéines, etc.). , il peut donner des tendances globales (peut-être pas si précises, mais probablement correctes, nous aide à comprendre rapidement un domaine), d'autre part, il peut donner des informations pertinentes et précieuses sur un certain sujet, ce qui améliorera sans aucun doute considérablement l'information. efficacité du traitement des experts. Un autre exemple est de savoir si vous pouvez créer un médecin IA afin que les patients puissent consulter sur leurs connaissances sur la maladie et les méthodes de traitement (limitée par des limitations techniques, l'IA ne peut pas donner de réponses précises, et encore moins remplacer les médecins), mais elle peut donner beaucoup d'informations à titre de référence et traitement de suivi. Pour des suggestions sur ce qu'il faut faire, l'expérience sera certainement bien meilleure que celle des moteurs de recherche actuels.

Il existe encore de nombreuses tâches importantes qui n'ont pas été résolues dans le domaine des sciences de la vie, telles que la conformation de liaison petite molécule-protéine et la prédiction d'affinité, la prédiction de l'interaction protéine-protéine, la représentation et la prédiction des propriétés des petites molécules, la prédiction des propriétés des protéines. , et la génération de petites molécules, la conception de protéines, la conception de voies rétrosynthétiques et d'autres tâches. À l’heure actuelle, ces problèmes n’ont pas été parfaitement résolus. Si des avancées sont réalisées dans ces domaines, la découverte de médicaments et même le domaine des sciences de la vie dans son ensemble entraîneront d’énormes changements.

Le domaine AIGC basé sur de grands modèles et le domaine RLHF basé sur des retours d'experts ou expérimentaux bénéficieront de la promotion de ChatGPT et déboucheront certainement sur une nouvelle vague de progrès technologique. Parmi eux, la technologie AIGC (génération de contenu d’intelligence artificielle) a fait de bons progrès dans les domaines de la génération de petites molécules et de la conception de protéines au cours de l’année écoulée. Nous prévoyons que dans un avenir proche, les tâches suivantes bénéficieront de manière significative du développement de la technologie de génération d'AIGC et produiront des étapes technologiques :

(1) Technologie de génération et d'optimisation de petites molécules, c'est-à-dire comment ne pas s'appuyer sur des technologies actives informations sur le ligand, au lieu de cela, il est basé sur des informations sur la structure des poches protéiques pour générer de petites molécules de ligand qui prennent en compte de manière globale diverses conditions telles que l'activité, la pharmacobilité et la synthétisabilité. Cette partie de la technologie bénéficiera considérablement du développement du domaine AIGC ;

(2) La prédiction de la conformation peut être considérée comme un problème de génération dans un sens, et les tâches de prédiction de la conformation de liaison aux petites molécules et aux protéines bénéficieront également du développement des technologies liées à l'AIGC ;(3) Protéines, peptides, L'AAV et d'autres domaines de conception de séquences bénéficieront également certainement du développement de la technologie AIGC.

Les tâches liées à l'AIGC mentionnées ci-dessus, ainsi que presque toutes les tâches nécessitant un retour de vérification expérimentale, y compris, mais sans s'y limiter, la prédiction d'activité, la prédiction de propriétés, la conception d'itinéraires synthétiques, etc., auront l'opportunité de bénéficier de les dividendes apportés par la technologie RLHF.

Bien sûr, les défis sont nombreux. Limités par la quantité de données disponibles, les modèles de la génération actuelle utilisés dans le domaine des sciences de la vie sont encore relativement superficiels et les modèles d'apprentissage profond superficiels tels que GNN sont principalement utilisés (le GNN est limité par la fluidité de la transmission des messages et le nombre de couches). ne peut être utilisé que sur environ 3 couches. ), bien que l'effet de génération montre un bon potentiel, il n'est toujours pas aussi étonnant que ChatGPT. La technologie d'apprentissage par renforcement basée sur les retours d'experts ou expérimentaux est limitée par la vitesse de génération des données expérimentales et les capacités d'expression insuffisantes du modèle généré, et il faudra également un certain temps pour présenter des résultats étonnants. Cependant, à en juger par la tendance d'évolution de la technologie ChatGPT, si nous pouvons former un grand modèle génératif suffisamment profond et doté de capacités de représentation suffisamment fortes, et utiliser l'apprentissage par renforcement pour améliorer encore l'effet du grand modèle basé sur une petite quantité de données élevées. -des données expérimentales de qualité ou des retours d'experts, on peut s'attendre à ce que le domaine de l'AIDD soit définitivement une révolution.

En bref, ChatGPT n'est pas seulement une avancée technologique dans le domaine de la compréhension du langage naturel, il déclenchera une nouvelle série de tendances commerciales dans le domaine des services d'information et de la génération de contenu. la technologie de génération profonde basée sur des données massives et la technologie d'apprentissage par renforcement basée sur la rétroaction humaine sont un moteur de progrès à long terme et conduiront à un développement rapide dans des domaines tels que les sciences de la vie. Nous allons inaugurer une autre vague d’avancement de la technologie de l’IA et de mise en œuvre industrielle.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Quelle méthode est utilisée pour convertir les chaînes en objets dans vue.js?

Apr 07, 2025 pm 09:39 PM

Quelle méthode est utilisée pour convertir les chaînes en objets dans vue.js?

Apr 07, 2025 pm 09:39 PM

Lors de la conversion des chaînes en objets dans vue.js, JSON.Parse () est préféré pour les chaînes JSON standard. Pour les chaînes JSON non standard, la chaîne peut être traitée en utilisant des expressions régulières et réduisez les méthodes en fonction du format ou du codé décodé par URL. Sélectionnez la méthode appropriée en fonction du format de chaîne et faites attention aux problèmes de sécurité et d'encodage pour éviter les bogues.

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

L'article présente le fonctionnement de la base de données MySQL. Tout d'abord, vous devez installer un client MySQL, tel que MySQLWorkBench ou le client de ligne de commande. 1. Utilisez la commande MySQL-UROot-P pour vous connecter au serveur et connecter avec le mot de passe du compte racine; 2. Utilisez Createdatabase pour créer une base de données et utilisez Sélectionner une base de données; 3. Utilisez CreateTable pour créer une table, définissez des champs et des types de données; 4. Utilisez InsertInto pour insérer des données, remettre en question les données, mettre à jour les données par mise à jour et supprimer les données par Supprimer. Ce n'est qu'en maîtrisant ces étapes, en apprenant à faire face à des problèmes courants et à l'optimisation des performances de la base de données que vous pouvez utiliser efficacement MySQL.

Vue.js Comment convertir un tableau de type de chaîne en un tableau d'objets?

Apr 07, 2025 pm 09:36 PM

Vue.js Comment convertir un tableau de type de chaîne en un tableau d'objets?

Apr 07, 2025 pm 09:36 PM

Résumé: Il existe les méthodes suivantes pour convertir les tableaux de chaîne Vue.js en tableaux d'objets: Méthode de base: utilisez la fonction de carte pour convenir à des données formatées régulières. Gameplay avancé: l'utilisation d'expressions régulières peut gérer des formats complexes, mais ils doivent être soigneusement écrits et considérés. Optimisation des performances: Considérant la grande quantité de données, des opérations asynchrones ou des bibliothèques efficaces de traitement des données peuvent être utilisées. MEILLEUR PRATIQUE: Effacer le style de code, utilisez des noms de variables significatifs et des commentaires pour garder le code concis.

Comment définir le délai de Vue Axios

Apr 07, 2025 pm 10:03 PM

Comment définir le délai de Vue Axios

Apr 07, 2025 pm 10:03 PM

Afin de définir le délai d'expiration de Vue Axios, nous pouvons créer une instance AxiOS et spécifier l'option Timeout: dans les paramètres globaux: vue.prototype. $ Axios = axios.create ({timeout: 5000}); Dans une seule demande: ce. $ axios.get ('/ api / utilisateurs', {timeout: 10000}).

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Traiter efficacement 7 millions d'enregistrements et créer des cartes interactives avec la technologie géospatiale. Cet article explore comment traiter efficacement plus de 7 millions d'enregistrements en utilisant Laravel et MySQL et les convertir en visualisations de cartes interactives. Exigences initiales du projet de défi: extraire des informations précieuses en utilisant 7 millions d'enregistrements dans la base de données MySQL. Beaucoup de gens considèrent d'abord les langages de programmation, mais ignorent la base de données elle-même: peut-il répondre aux besoins? La migration des données ou l'ajustement structurel est-il requis? MySQL peut-il résister à une charge de données aussi importante? Analyse préliminaire: les filtres et les propriétés clés doivent être identifiés. Après analyse, il a été constaté que seuls quelques attributs étaient liés à la solution. Nous avons vérifié la faisabilité du filtre et établi certaines restrictions pour optimiser la recherche. Recherche de cartes basée sur la ville

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Il existe de nombreuses raisons pour lesquelles la startup MySQL échoue, et elle peut être diagnostiquée en vérifiant le journal des erreurs. Les causes courantes incluent les conflits de port (vérifier l'occupation du port et la configuration de modification), les problèmes d'autorisation (vérifier le service exécutant les autorisations des utilisateurs), les erreurs de fichier de configuration (vérifier les paramètres des paramètres), la corruption du répertoire de données (restaurer les données ou reconstruire l'espace de la table), les problèmes d'espace de la table InNODB (vérifier les fichiers IBDATA1), la défaillance du chargement du plug-in (vérification du journal des erreurs). Lors de la résolution de problèmes, vous devez les analyser en fonction du journal d'erreur, trouver la cause profonde du problème et développer l'habitude de sauvegarder régulièrement les données pour prévenir et résoudre des problèmes.

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Ingénieur backend à distance Emploi Vacant Société: Emplacement du cercle: Bureau à distance Type d'emploi: Salaire à temps plein: 130 000 $ - 140 000 $ Description du poste Participez à la recherche et au développement des applications mobiles Circle et des fonctionnalités publiques liées à l'API couvrant l'intégralité du cycle de vie de développement logiciel. Les principales responsabilités complètent indépendamment les travaux de développement basés sur RubyOnRails et collaborent avec l'équipe frontale React / Redux / Relay. Créez les fonctionnalités de base et les améliorations des applications Web et travaillez en étroite collaboration avec les concepteurs et le leadership tout au long du processus de conception fonctionnelle. Promouvoir les processus de développement positifs et hiérarchiser la vitesse d'itération. Nécessite plus de 6 ans de backend d'applications Web complexe

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

L'optimisation des performances MySQL doit commencer à partir de trois aspects: configuration d'installation, indexation et optimisation des requêtes, surveillance et réglage. 1. Après l'installation, vous devez ajuster le fichier my.cnf en fonction de la configuration du serveur, tel que le paramètre innodb_buffer_pool_size, et fermer query_cache_size; 2. Créez un index approprié pour éviter les index excessifs et optimiser les instructions de requête, telles que l'utilisation de la commande Explication pour analyser le plan d'exécution; 3. Utilisez le propre outil de surveillance de MySQL (ShowProcessList, Showstatus) pour surveiller la santé de la base de données, et sauvegarde régulièrement et organisez la base de données. Ce n'est qu'en optimisant en continu ces étapes que les performances de la base de données MySQL peuvent être améliorées.