Périphériques technologiques

Périphériques technologiques

IA

IA

Que dois-je faire si l'IA ne comprend pas « il, elle, cela » ? Les verbes sont devenus une nouvelle avancée. Lorsque le robot entend du beurre, il sait saisir un couteau et une fourchette.

Que dois-je faire si l'IA ne comprend pas « il, elle, cela » ? Les verbes sont devenus une nouvelle avancée. Lorsque le robot entend du beurre, il sait saisir un couteau et une fourchette.

Que dois-je faire si l'IA ne comprend pas « il, elle, cela » ? Les verbes sont devenus une nouvelle avancée. Lorsque le robot entend du beurre, il sait saisir un couteau et une fourchette.

Lorsque vous donnez des instructions à l'IA, avez-vous toujours l'impression que communiquer avec les gens est différent ?

Oui, l'IA peut comprendre certaines instructions humaines spécifiques, telles que :

Aidez à déplacer une chaise du restaurant.

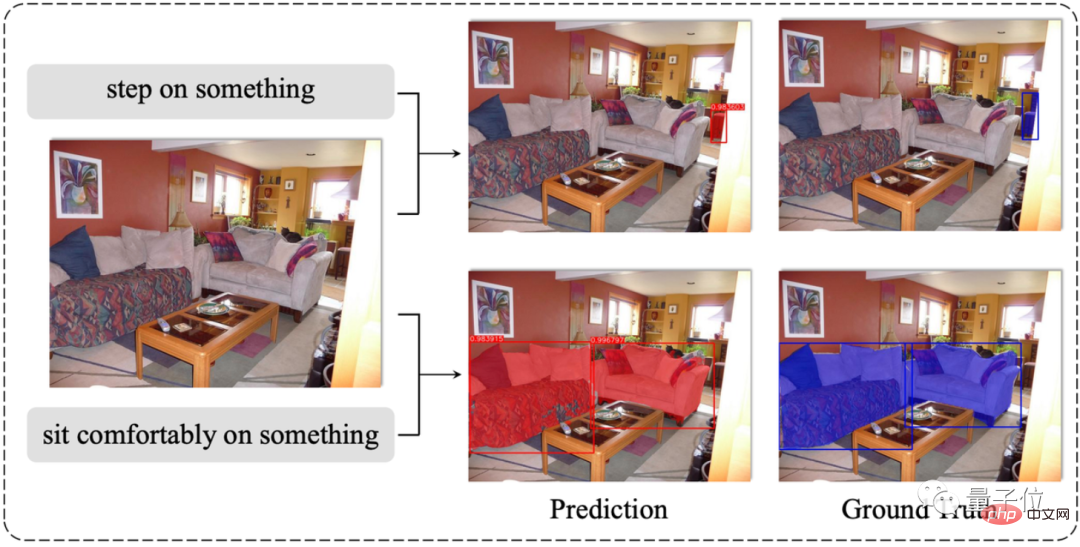

Mais s'il était remplacé par des instructions vagues avec uniquement des pronoms (il/elle/ce/cela/chose...) et des verbes, l'IA serait confuse :

Aidez à trouver quelque chose qui puisse tenir sur votre pieds.

Maintenant, les chercheurs ont enfin trouvé une nouvelle façon de résoudre ce problème : ne suffirait-il pas de permettre à l’IA d’apprendre à comprendre les verbes ?

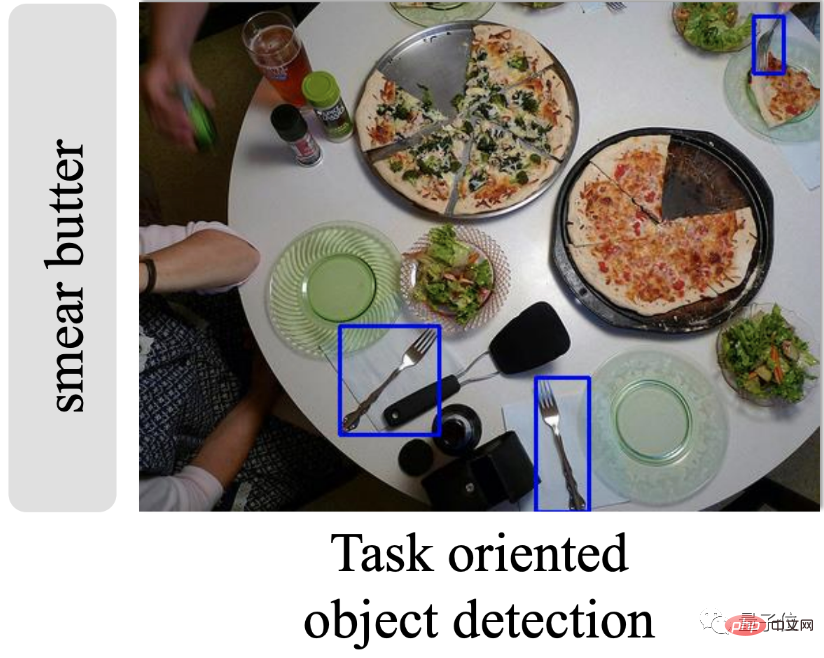

Le verbe lui-même est lié à certains noms spécifiques. Par exemple, l'action de « étaler du beurre » est définitivement indissociable de noms tels que « couteau » et « fourchette ».

Il vous suffit de les faire correspondre. Aucune instruction nominale telle que "couteau et fourchette" n'est nécessaire. L'IA peut également trouver avec précision l'objet cible :

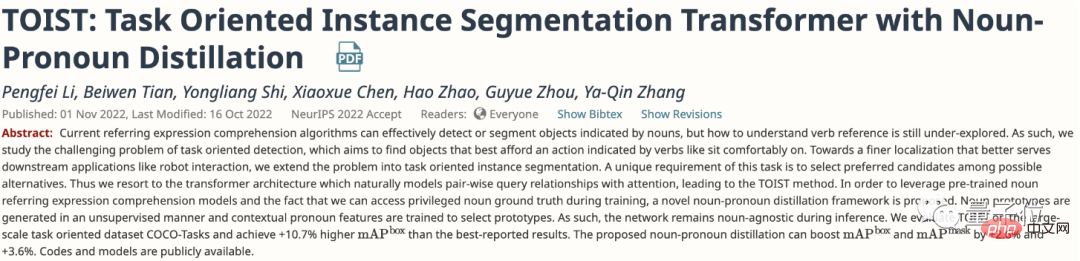

À l'heure actuelle, cet article a été officiellement inclus dans NeurIPS 2022, et le modèle associé a également été open source :

Alors, comment entraîne-t-il exactement l'IA à comprendre les verbes ?

Couvrir les noms permet à l'IA de « trouver des objets en regardant des images »

L'article propose un cadre appelé TOIST.

TOIST est "Task Oriented Instance Segmentation Transformer" (Task Oriented Instance Segmentation Transformer), qui est une nouvelle solution de segmentation d'instance basée sur Transformer.

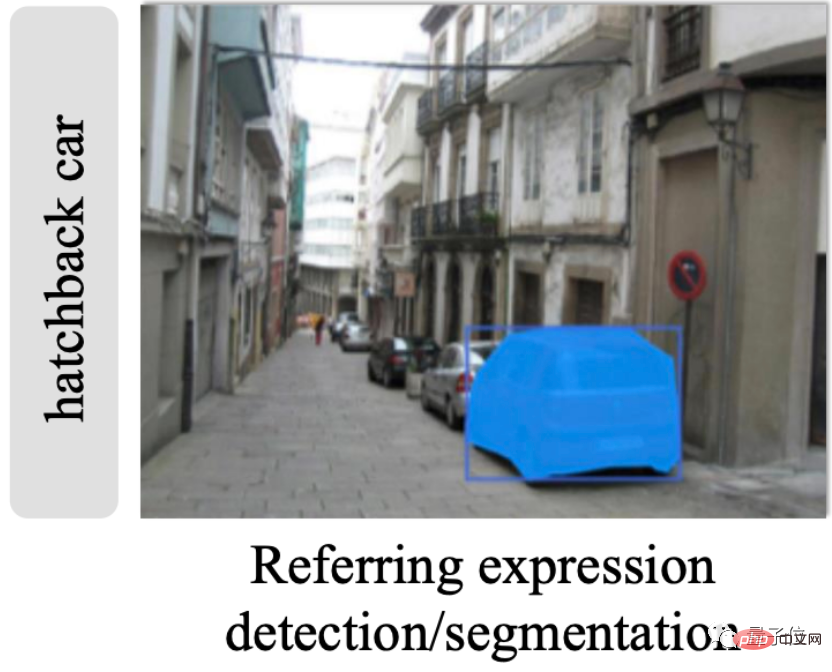

La segmentation d'instance est différente de la « découpe d'image complète » de la segmentation sémantique. Elle présente également les caractéristiques de la détection de cible. Par exemple, l'image suivante utilise le nom « voiture à hayon » pour trouver directement l'objet correspondant :

.

Auparavant, les modèles de segmentation d'instances étaient généralement divisés en « deux étapes ». La première étape consistait à détecter les cibles possibles, et la deuxième étape consistait à trier les cibles possibles et à prédire les résultats les plus probables.

Mais contrairement à cette approche, le framework TOIST adopte directement une architecture Transformer entière, dans laquelle le mécanisme d'auto-attention du décodeur peut établir la relation de préférence entre les cibles candidates.

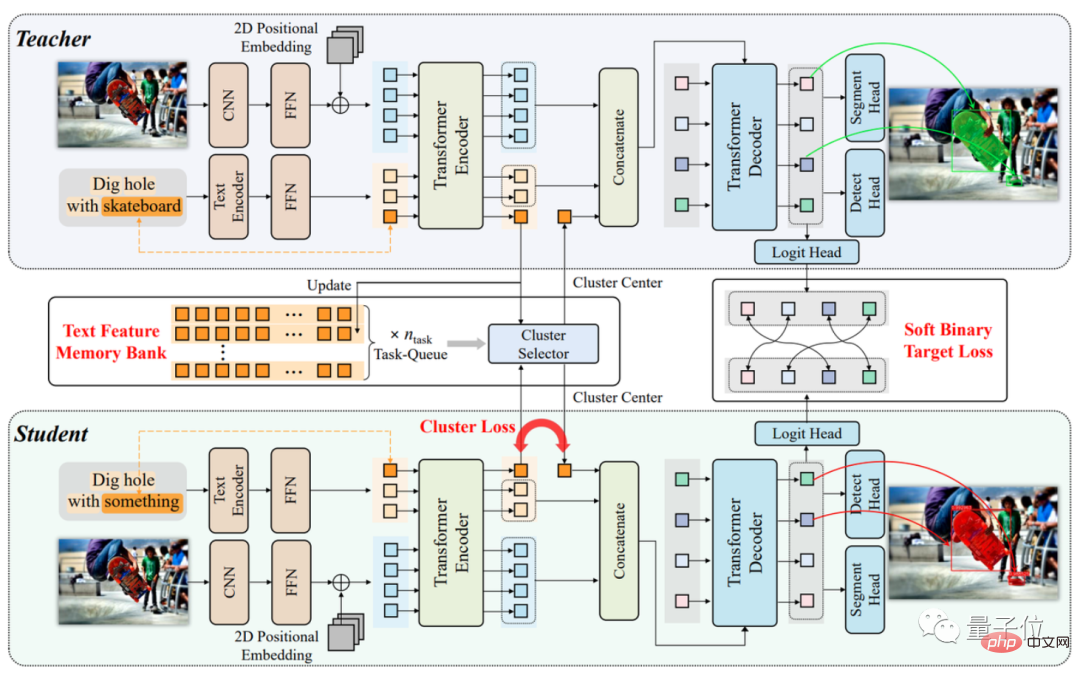

Le cadre TOIST est divisé en trois parties.

Parmi eux, l'encodeur multimodal (partie marron) est responsable de l'extraction des marqueurs de caractéristiques, et l'encodeur Transformer (partie verte) est responsable de l'agrégation des caractéristiques des deux modalités et en fonction de l'attention dans le décodeur Transformer (bleu partie) Mécanisme permettant de prédire la cible la plus appropriée.

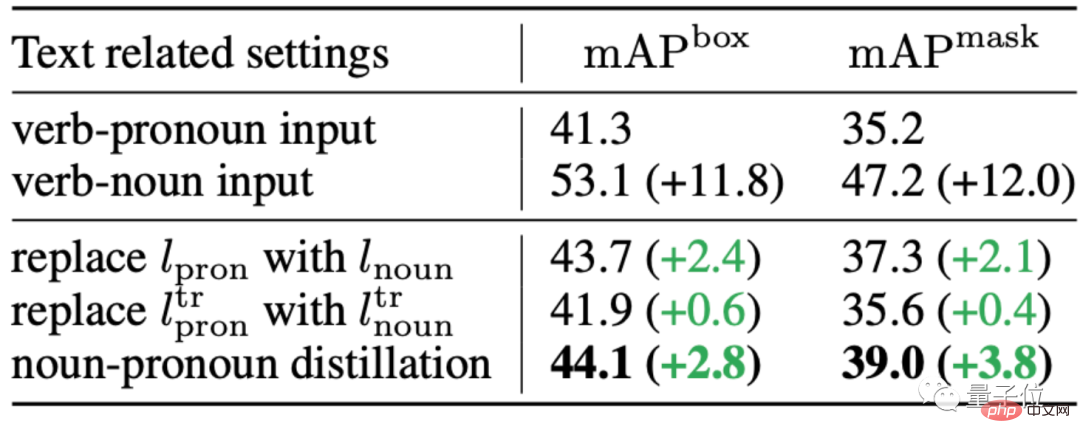

Par la suite, le journal a proposé une nouvelle méthode de distillation nom-pronom (distillation nom-pronom) pour entraîner le modèle.

Plus précisément, sur la base du cadre de distillation des connaissances (modèle enseignant-élève dans l'image ci-dessus), l'IA est entraînée à « deviner » des prototypes de noms en fonction du contexte, de manière non supervisée.

Par exemple, la tâche de segmentation d'instance originale est "creuser des trous avec un skateboard", mais lors de l'entraînement du modèle, le nom "skateboard" sera remplacé par le pronom "quelque chose":

Une telle IA Même lorsque vous Si vous ne connaissez pas le nom, vous pouvez deviner le nom correct à partir de rien et segmenter la bonne cible dans l'image :

Comment cet effet de segmentation fonctionne-t-il dans des cas réels ?

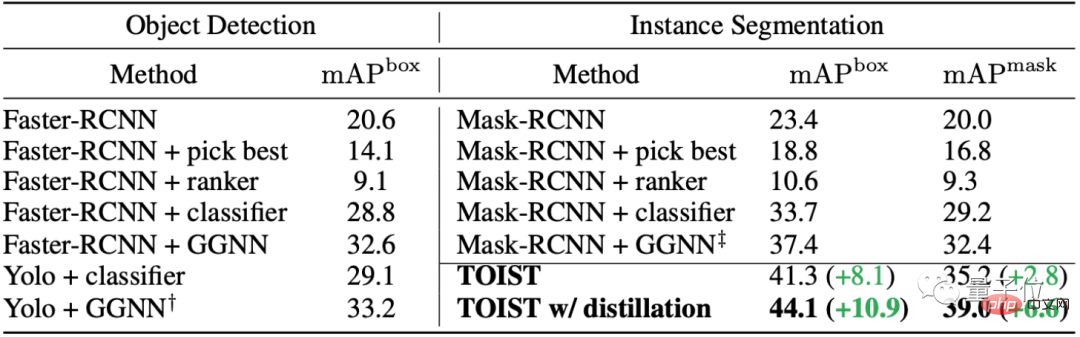

La précision de détection de la cible a augmenté de 10,9 %

L'article a testé TOIST sur l'ensemble de données de tâches à grande échelle COCO-Tasks.

La méthode d'évaluation utilise le mAP (mean Average Precision), qui est courant dans les tâches visuelles telles que la détection de cibles.

En termes simples, TOIST fonctionne mieux que le modèle SOTA de segmentation d'instance et de détection de cible précédent, et avec la "version améliorée" de TOIST ajoutée avec la méthode de distillation nom-pronom, les performances sont encore meilleures que TOIST.

Parmi eux, dans la tâche de détection de cible, par rapport au meilleur Yolo+GGNN actuel, la précision de la boîte de décision mAP de la « version améliorée » de TOIST est augmentée de 10,9 %. Dans la tâche de segmentation d'instance, la précision du masque est meilleure que celle de Mask-. RCNN+GGNN 6,6% plus élevé.

Quant à la méthode de distillation nom-pronom proposée, par rapport à la version originale de TOIST, la précision de la tâche de segmentation des instances a été améliorée de 2,8 % et 3,8 % respectivement.

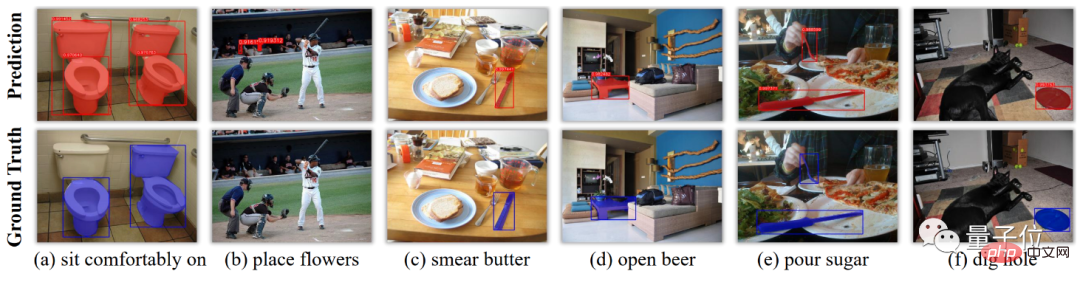

En termes de performances du boîtier, l'effet du modèle est également très proche de la vraie valeur réelle de la segmentation.

Par exemple, dans la figure (d), l'algorithme a même reconnu que le bouchon de la bouteille de bière peut être ouvert à l'aide d'une table, ce qui peut être considéré comme un score parfait pour comprendre :

Concernant l'intention initiale de faire cela recherche, l'auteur a répondu :

Notre laboratoire est en fait responsable de la recherche sur les robots, mais lors d'enquêtes quotidiennes, nous avons constaté que les utilisateurs préfèrent parfois décrire leurs « besoins » au robot plutôt que de lui dire directement quoi faire.

En d'autres termes, les algorithmes d'IA sont utilisés pour faire "réfléchir un pas de plus" au robot au lieu d'être simplement un assistant qui suit les ordres.

Introduction à l'auteur

Les auteurs de cet article viennent de l'Institut de recherche sur l'industrie intelligente (AIR) de l'Université de Tsinghua, de l'Université de Pékin et du doyen de l'AIR, Zhang Yaqin, est également l'un des auteurs.

Li Pengfei, le premier auteur de l'article, est doctorant à l'Institut de l'industrie intelligente de l'Université Tsinghua. Il est diplômé de l'Université de l'Académie chinoise des sciences avec un baccalauréat. Ses intérêts de recherche incluent la conduite autonome. et la vision par ordinateur.

L'auteur correspondant Zhao Hao est un nouveau professeur adjoint à l'Institut de recherche sur l'industrie intelligente de l'Université Tsinghua, un chercheur scientifique à l'Institut de recherche Intel China et un chercheur postdoctoral conjoint à l'Université de Pékin. Il est diplômé du Département d'ingénierie électronique. à l'Université Tsinghua. Ses intérêts de recherche sont la robotique et la direction visuelle.

Adresse papier : https://arxiv.org/abs/2210.10775

Adresse du projet : https://github.com/AIR-DISCOVER/TOIST

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Conseils de configuration du pare-feu Debian Mail Server

Apr 13, 2025 am 11:42 AM

Conseils de configuration du pare-feu Debian Mail Server

Apr 13, 2025 am 11:42 AM

La configuration du pare-feu d'un serveur de courrier Debian est une étape importante pour assurer la sécurité du serveur. Voici plusieurs méthodes de configuration de pare-feu couramment utilisées, y compris l'utilisation d'iptables et de pare-feu. Utilisez les iptables pour configurer le pare-feu pour installer iptables (sinon déjà installé): Sudoapt-getUpDaSuDoapt-getinstalliptableView Règles actuelles iptables: Sudoiptable-L Configuration

Méthode d'installation du certificat de Debian Mail Server SSL

Apr 13, 2025 am 11:39 AM

Méthode d'installation du certificat de Debian Mail Server SSL

Apr 13, 2025 am 11:39 AM

Les étapes pour installer un certificat SSL sur le serveur de messagerie Debian sont les suivantes: 1. Installez d'abord la boîte à outils OpenSSL, assurez-vous que la boîte à outils OpenSSL est déjà installée sur votre système. Si ce n'est pas installé, vous pouvez utiliser la commande suivante pour installer: Sudoapt-getUpDaSuDoapt-getInstallOpenSSL2. Générer la clé privée et la demande de certificat Suivant, utilisez OpenSSL pour générer une clé privée RSA 2048 bits et une demande de certificat (RSE): OpenSS

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

La commande de fermeture CENTOS est arrêtée et la syntaxe est la fermeture de [options] le temps [informations]. Les options incluent: -H Arrêtez immédiatement le système; -P éteignez l'alimentation après l'arrêt; -r redémarrer; -t temps d'attente. Les temps peuvent être spécifiés comme immédiats (maintenant), minutes (minutes) ou une heure spécifique (HH: mm). Des informations supplémentaires peuvent être affichées dans les messages système.

Sony confirme la possibilité d'utiliser des GPU spéciaux sur PS5 Pro pour développer une IA avec AMD

Apr 13, 2025 pm 11:45 PM

Sony confirme la possibilité d'utiliser des GPU spéciaux sur PS5 Pro pour développer une IA avec AMD

Apr 13, 2025 pm 11:45 PM

Mark Cerny, architecte en chef de SonyInterActiveTeretment (SIE, Sony Interactive Entertainment), a publié plus de détails matériels de l'hôte de nouvelle génération PlayStation5Pro (PS5PRO), y compris un GPU AMDRDNA2.x architecture amélioré sur les performances, et un programme d'apprentissage de l'intelligence machine / artificielle "AmethylSt" avec AMD. L'amélioration des performances de PS5PRO est toujours sur trois piliers, y compris un GPU plus puissant, un traçage avancé des rayons et une fonction de super-résolution PSSR alimentée par AI. GPU adopte une architecture AMDRDNA2 personnalisée, que Sony a nommé RDNA2.x, et il a une architecture RDNA3.

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

La politique de sauvegarde et de récupération de GitLab dans le système CentOS afin d'assurer la sécurité et la récupérabilité des données, Gitlab on CentOS fournit une variété de méthodes de sauvegarde. Cet article introduira plusieurs méthodes de sauvegarde courantes, paramètres de configuration et processus de récupération en détail pour vous aider à établir une stratégie complète de sauvegarde et de récupération de GitLab. 1. MANUEL BACKUP Utilisez le Gitlab-RakegitLab: Backup: Créer la commande pour exécuter la sauvegarde manuelle. Cette commande sauvegarde des informations clés telles que le référentiel Gitlab, la base de données, les utilisateurs, les groupes d'utilisateurs, les clés et les autorisations. Le fichier de sauvegarde par défaut est stocké dans le répertoire / var / opt / gitlab / backups. Vous pouvez modifier / etc / gitlab

Quelles sont les méthodes de réglage des performances de Zookeeper sur Centos

Apr 14, 2025 pm 03:18 PM

Quelles sont les méthodes de réglage des performances de Zookeeper sur Centos

Apr 14, 2025 pm 03:18 PM

Le réglage des performances de Zookeeper sur CentOS peut commencer à partir de plusieurs aspects, notamment la configuration du matériel, l'optimisation du système d'exploitation, le réglage des paramètres de configuration, la surveillance et la maintenance, etc. Assez de mémoire: allouez suffisamment de ressources de mémoire à Zookeeper pour éviter la lecture et l'écriture de disques fréquents. CPU multi-core: utilisez un processeur multi-core pour vous assurer que Zookeeper peut le traiter en parallèle.

Enfin changé! La fonction de recherche Microsoft Windows inaugurera une nouvelle mise à jour

Apr 13, 2025 pm 11:42 PM

Enfin changé! La fonction de recherche Microsoft Windows inaugurera une nouvelle mise à jour

Apr 13, 2025 pm 11:42 PM

Les améliorations de Microsoft aux fonctions de recherche Windows ont été testées sur certains canaux d'initiés Windows dans l'UE. Auparavant, la fonction de recherche Windows intégrée a été critiquée par les utilisateurs et avait une mauvaise expérience. Cette mise à jour divise la fonction de recherche en deux parties: recherche locale et recherche Web basée sur Bing pour améliorer l'expérience utilisateur. La nouvelle version de l'interface de recherche effectue la recherche de fichiers locale par défaut. Si vous devez rechercher en ligne, vous devez cliquer sur l'onglet "Microsoft Bingwebsearch" pour changer. Après le changement, la barre de recherche affichera "Microsoft BingWebsearch:", où les utilisateurs peuvent entrer des mots clés. Ce mouvement évite efficacement le mélange des résultats de recherche locaux avec les résultats de recherche Bing

Comment entraîner le modèle Pytorch sur Centos

Apr 14, 2025 pm 03:03 PM

Comment entraîner le modèle Pytorch sur Centos

Apr 14, 2025 pm 03:03 PM

Une formation efficace des modèles Pytorch sur les systèmes CentOS nécessite des étapes, et cet article fournira des guides détaillés. 1. Préparation de l'environnement: Installation de Python et de dépendance: le système CentOS préinstalle généralement Python, mais la version peut être plus ancienne. Il est recommandé d'utiliser YUM ou DNF pour installer Python 3 et Mettez PIP: sudoyuMupDatePython3 (ou sudodnfupdatepython3), pip3install-upradepip. CUDA et CUDNN (accélération GPU): Si vous utilisez Nvidiagpu, vous devez installer Cudatool