Périphériques technologiques

Périphériques technologiques

IA

IA

Wang Wenbing, responsable de l'algorithme Rokid : le « son » sous AR est dans un état « merveilleux »

Wang Wenbing, responsable de l'algorithme Rokid : le « son » sous AR est dans un état « merveilleux »

Wang Wenbing, responsable de l'algorithme Rokid : le « son » sous AR est dans un état « merveilleux »

Le son est omniprésent dans notre vie quotidienne et constitue un élément indispensable, et il en va de même dans le monde du métaverse. Afin d'obtenir une immersion complète dans les scènes du Metaverse, une mise à niveau et un développement continus de diverses technologies sonores sont nécessaires. Lors de la "AISummit Global Artificial Intelligence Technology Conference" organisée récemment par 51CTO, Wang Wenbing, le responsable de l'algorithme Rokid, a prononcé un discours d'ouverture sur le "Sound" sous AR dans "Wonderful" Land", il a présenté le concept, les principaux modules techniques, les difficultés techniques, les tendances de développement de la combinaison avec AR et l'intention originale de développer la technologie du champ sonore spatial 6DoF auto-développé par Rokid, et a expliqué l'incarnation importante de la technologie du champ sonore spatial dans le monde du métaverse.

Le contenu de la conférence est désormais organisé comme suit :

Qu'est-ce que le champ sonore spatial 6dof ?

Quand on parle de ce problème, vous pouvez d'abord mettre de côté les limitations techniques et imaginer comment le son sur AR devrait être présenté. En fait, la plupart des téléviseurs et des téléphones portables que nous utilisons actuellement sont à deux canaux, comme la stéréo. Les cinémas maison utilisent déjà le multicanal. Les scènes professionnelles telles que les salles de cinéma disposent également de haut-parleurs dans la disposition spatiale.

Comment doit-il être présenté en AR ? Nous pouvons imaginer une scène, comme les réunions en ligne ou l'éducation en ligne, qui sont très populaires maintenant. Si vous voyez la personne numérique à droite dans le monde du métaverse parler tout le temps, mais que la voix vient de votre gauche, cela vous semble-t-il bizarre ? cette fois?

De plus, nous pouvons imaginer des jeux AR. Dans la vision 2D précédente, le son peut se déplacer avec le focus de la vision, mais dans la plage de 360 degrés de la scène 3D, les yeux humains ne peuvent pas saisir la scène entière. focalisation, tandis que le son a une focalisation globale. C'est pourquoi, dans de nombreux jeux, les joueurs changent de perspective en fonction du son. Par conséquent, nous pouvons voir certaines des caractéristiques que le son en RA doit avoir : il doit répondre à la haute sensibilité sonore des gens, à l'orientation globale du son et aux exigences de réalisme du son.

Ensuite, introduisons le développement de la forme sonore à partir de trois dimensions.

Tout d'abord, la dimension de l'expression spatiale. La dimension d'expression de l'ensemble du son va du mono/stéréo au multicanal dans un plan tel que 5.1/7.1/9.1/..., au multicanal dans un espace tel que 5.1. Il y en a de plus en plus, et. la position de placement a également augmenté du plan à l'espace

Deuxièmement, la dimension de la méthode d'encodage. Depuis le tout début, basé sur le canal (c'est-à-dire un encodage basé sur le canal, chaque canal aura une variété de sons, tels que nos expressions habituelles des canaux gauche et droit), jusqu'à l'objet (c'est-à-dire pour les objets qui se produisent sont codés), y compris les sources cinématographiques Dolby Atmos que tout le monde a regardé au cinéma. Par exemple, lorsqu'un boulet de canon est abattu, l'objet de ce boulet de canon est spécialement codé et sa trajectoire de mouvement est enregistrée dans les métadonnées, puis basée. sur la position du haut-parleur correspondante, mais notre objectif ultime est d'obtenir un effet entièrement basé sur la scène, similaire à la méthode sonore panoramique telle que HOA, non seulement les boulets de canon, mais aussi la chute des fleurs, de l'herbe et des feuilles. Nous espérons tous qu'il pourra avoir une sensation d'espace.

Troisièmement, la dimension de l'expérience XR. Dans le passé, le son virtuel et le monde réel étaient séparés. Aujourd'hui, en XR, en particulier en AR, ce que nous faisons est l'intégration du virtuel et de la réalité.

La raison pour laquelle les gens peuvent distinguer les sons avec autant de détails est due au mode binaural. Techniquement parlant, il s'agit de l'ITD et de l'ILD, qui correspondent à la différence de temps et d'intensité sonore entre les deux oreilles. Ces deux différences nous aideront à localiser rapidement la direction du son de l'objet.

Alors comment rendre le son 3D populaire ? Comment dépasser les limites des lieux ? Comment réduire les coûts de consommation des utilisateurs ? Comment tout le monde peut-il profiter de la technologie ? Le champ sonore spatial 6dof développé par Rokid aidera à résoudre ces problèmes.

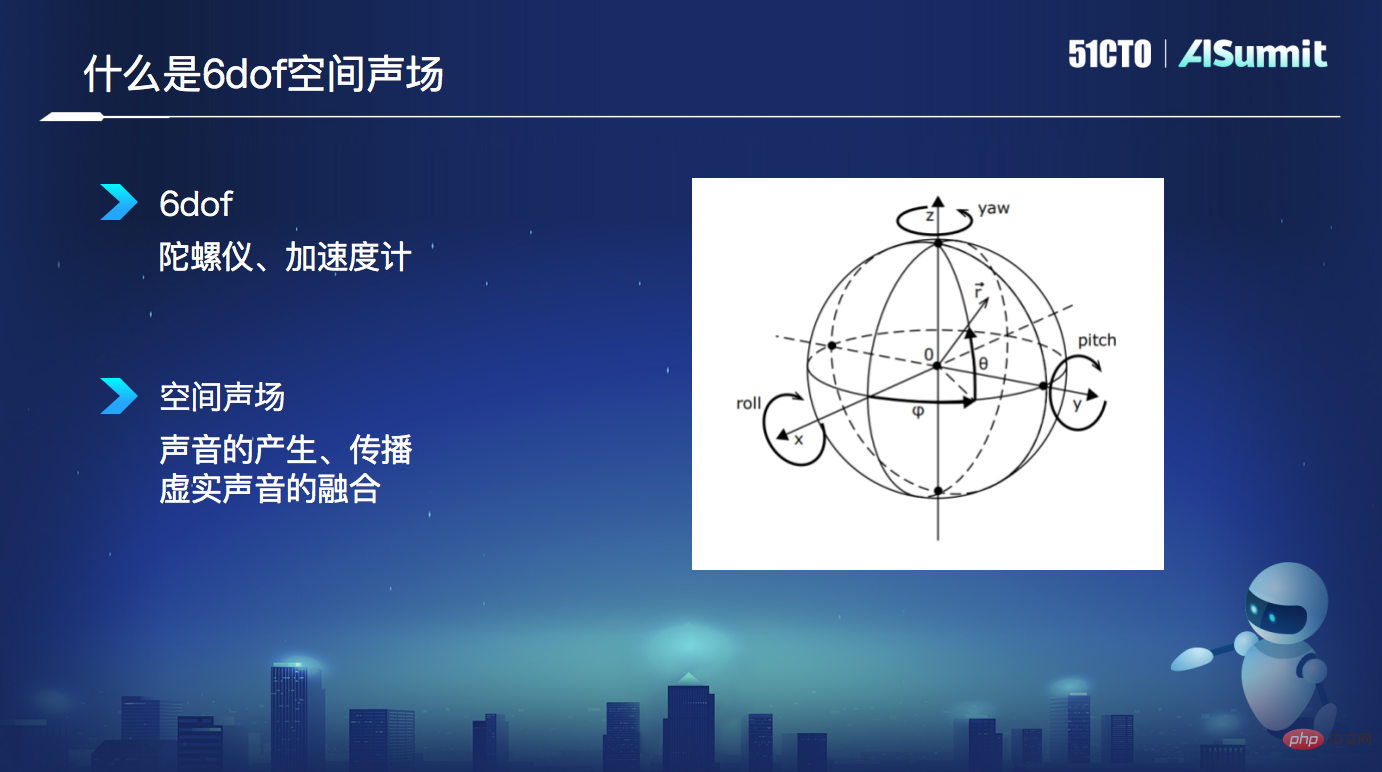

Champ sonore spatial 6dof peut être divisé en deux parties à partir du nom : 6dof et champ sonore spatial. 6dof exprime principalement six degrés de liberté. Le gyroscope assure la rotation autour des trois directions de XYZ et l'accéléromètre fournit l'accélération dans les trois directions de XYZ.

6dof champ sonore spatial implique la génération, la propagation, le rendu, l'encodage et le décodage du son, ainsi que la fusion et l'interaction des sons virtuels et réels tout au long du processus.

La technologie principale du champ sonore spatial 6dof

Les principaux modules technologiques du champ sonore spatial 6dof comprennent les HRTF, le rendu du champ sonore et les effets sonores . Les HRTF sont la fonction d'impact de la source sonore du champ libre au tympan. Il s'agit du processus de transmission du son global à l'oreille humaine dans un environnement de chambre anéchoïque simulé. Le rendu du champ sonore peut donner aux utilisateurs la possibilité de distinguer la position des sons en écoutant et peut mélanger des objets virtuels et réels pour gérer parfaitement l'impact des objets réels sur les sources sonores virtuelles. L'effet sonore consiste à enrichir la qualité sonore en utilisant des haut-parleurs ouverts conçus pour l'intimité afin de réduire les fuites sonores et d'assurer le volume.

Le SDK en haut du diagramme d'architecture fournit des modules spatiaux externes, à savoir les exportations de moteur spatial et les exportations de moteur vocal. Les informations spatiales peuvent être acquises et modélisées, contribuant ainsi à intégrer les mondes numérique et physique.

De plus, nous avons également apporté quelques modifications à Room Effect. Son cadre global est similaire à la structure de réseau classique. Tout d'abord, le réseau est construit, puis un réseau théorique sans perte est généré. Ensuite, sur la base de cette théorie, divers paramètres liés à l'atténuation et aux pertes sont effectués, notamment l'absorption, l'occlusion, la réflexion, etc. En fait, notre objectif n'est pas de créer divers effets sonores. Nous fournissons simplement des effets sonores basés sur les scénarios d'utilisation du produit, tels que le théâtre ou la musique, afin que les utilisateurs puissent vivre une bonne expérience audiovisuelle. les lunettes AR de nouvelle génération Rokid Max.

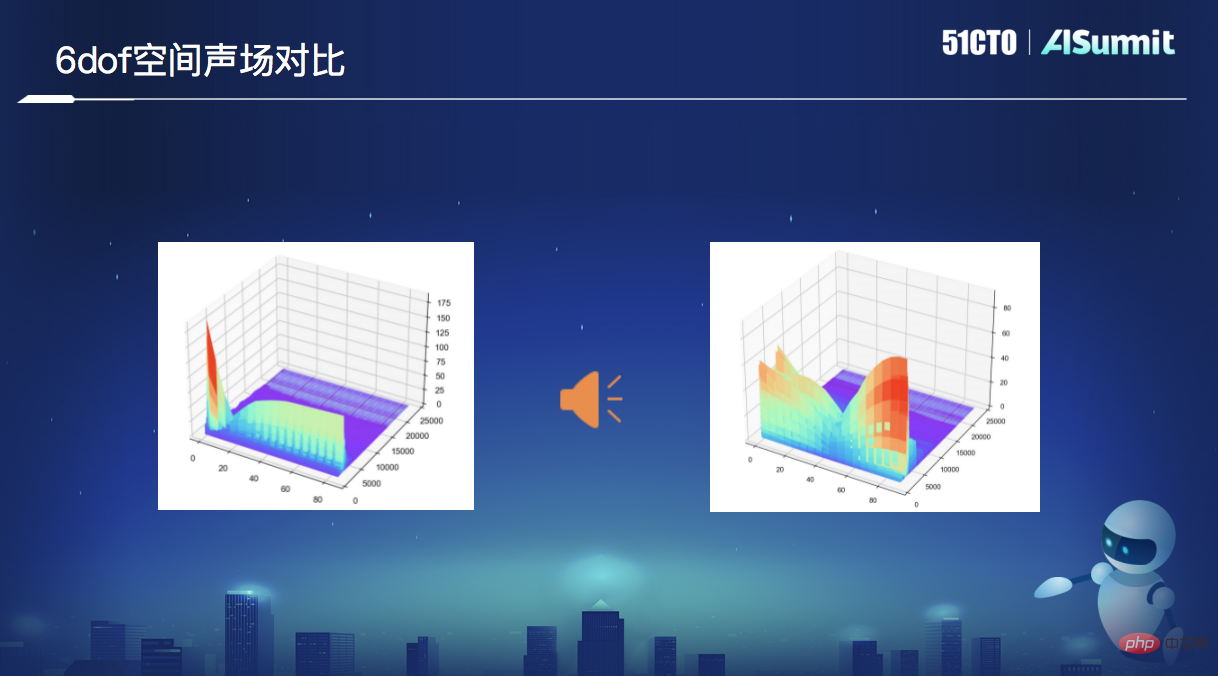

Comparaison du champ sonore spatial 6dof. Le côté gauche est l'effet d'un SDK tiers lors d'une rotation de 0 degrés à 90 degrés, le changement de chaque fréquence n'est pas fluide, et la diminution est forte au début, et les changements ultérieurs sont très faibles. Le champ sonore spatial 6dof réalisé par Rokid à droite présente des changements évidents dans différentes bandes de fréquences à mesure que votre position change. L'image montre les performances de différents angles, différentes bandes de fréquences et différentes amplitudes.

La tendance au développement du champ sonore spatial 6dof

Avec l'avènement de l'ère du métaverse et l'essor des technologies AR et VR, le développement des champs sonores spatiaux a également ouvert la voie à de nouvelles opportunités.

La tendance au développement des champs sonores spatiaux se reflète principalement dans trois aspects :

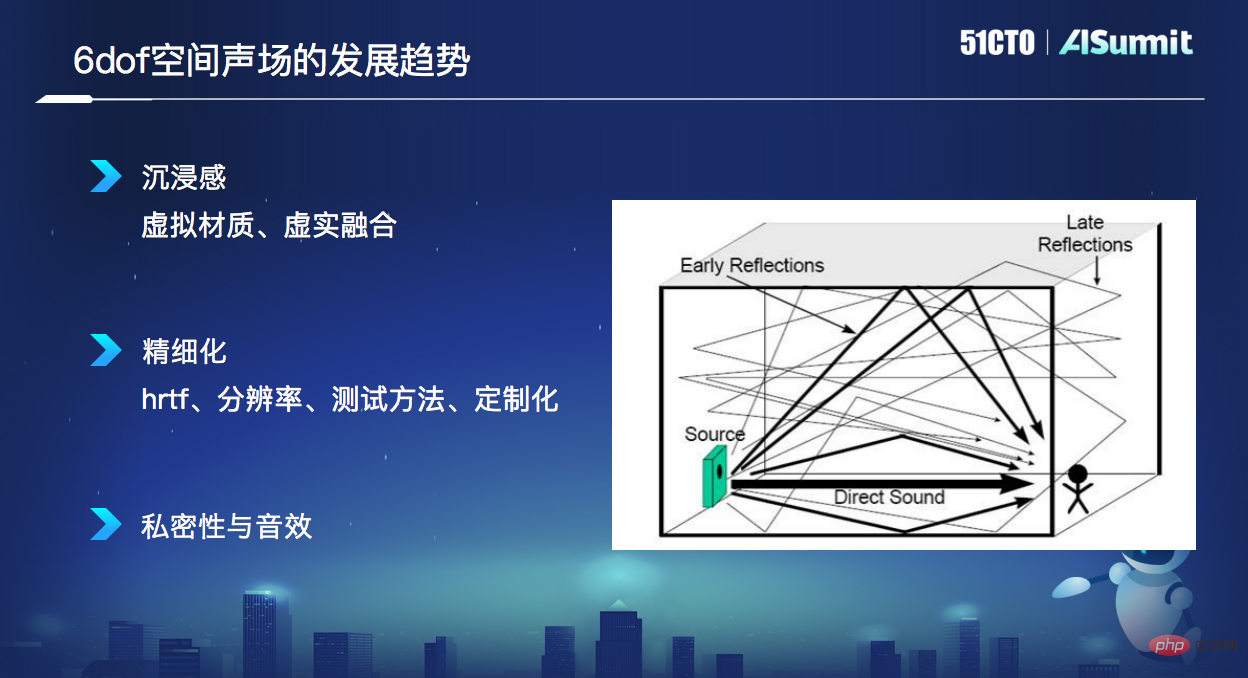

Premièrement, l'immersion, les gens peuvent fournir des commentaires basés sur le monde réel, mieux intégrer et interagir avec le virtuel et le réel, et réaliser véritablement un expérience immersive. Tous les sons du monde virtuel ne doivent pas être exempts de l'influence d'objets du monde réel, car cela donnera aux gens le sentiment qu'ils sont toujours séparés. En plus de l'intégration, une interaction est également requise. Par exemple, dans le monde virtuel, vous pouvez interagir avec le son amélioré sur le terminal AR via différentes méthodes telles que la voix et les gestes, pour choisir de mettre en pause, de lire ou de changer de fenêtre. niveaux et perspectives, ou pour ressentir votre propre chemin, des voix d'intérêt et plus encore.

Le second est le raffinement, qui implique une exploration et une pratique raffinées dans différents aspects tels que le HRTF, la résolution, les méthodes de test et la personnalisation. La chose la plus difficile à affiner est le passage de la tête, car la méthode de génération du passage de la tête elle-même prend plus de temps et est plus laborieuse. Elle doit jouer chaque point à différentes distances dans tout l'espace sphérique, puis échantillonner le conduit auditif. . Actuellement, certains chercheurs étudient comment générer le même degré de raffinement avec moins de points d'échantillonnage et comment obtenir une plus grande précision par interpolation ou d'autres moyens techniques. Dans une perspective à plus long terme, la limite de raffinement est personnalisée ; mise en œuvre.

Le troisième est l'intimité et les effets sonores, vivez le festin auditif apporté par les sons dans différentes bandes de fréquences. Différentes harmoniques ou différentes bandes de fréquences nous donnent des sensations différentes. Par exemple, une réverbération sévère affectera l'audition humaine, tandis qu'une réverbération appropriée apportera une expérience d'écoute riche en termes de qualité sonore, en particulier une réverbération précoce, elle est souvent utilisée pour juger du timbre, en dessous de 3K. La réverbération et la réflexion latérale aideront à créer une meilleure sensation de l'espace et la profondeur, tandis que la composante haute fréquence nous aidera à obtenir une sensation d'ambiance.

L'intention originale d'explorer les champs sonores spatiaux

Pourquoi Rokid crée-t-il des champs sonores spatiaux ? Il y a trois raisons principales :

Premièrement, l'immersion. Nous poursuivons l'intégration du monde numérique et du monde physique, comme la vivacité lors des jeux, la réalité lors des réunions en ligne ou l'éducation en ligne.

Deuxièmement, l'interaction entre le virtuel et le réel. Nous pensons que l'avenir dans ce monde sera une fusion de réalité et de réalité. Sur la base de la fusion, de nombreuses interactions peuvent être réalisées, y compris le processus de perception spatiale, l'interaction de comportements subjectifs, etc. La perception spatiale fait référence à des aspects du monde tels que la taille des objets, la taille de l'espace, les matériaux, etc. Cette perception a alors un impact sur les sons virtuels ; l'interaction du comportement subjectif est l'intervention humaine, la sélection et l'interaction avec les sons ; le monde numérique communiquer.

Trois, qualité ultime. AR Glass est différent des téléphones mobiles, tablettes, téléviseurs et autres produits. Lorsque vous utilisez votre téléphone mobile, une déconnexion ou un décalage du réseau est tolérable, mais les exigences en temps réel pour les lunettes AR portées sur vos yeux sont très élevées. Comment pouvons-nous répondre à cette exigence élevée en temps réel ? Cela implique l'optimisation globale des algorithmes, de l'ingénierie, des systèmes, du matériel et des applications.

Ce sont les missions que nous poursuivons. Rokid espère promouvoir et vulgariser directement ces capacités auprès du public via les produits AR Glass. En même temps, nous espérons également publier ces technologies en tant que fonctionnalités de base dans notre système d'exploitation Yoda ; afin de toucher la majorité des utilisateurs. L'utilisation par les développeurs profite indirectement aux utilisateurs et responsabilise tous les horizons.

Maintenant que la rediffusion du discours de la conférence et le PPT sont en ligne, rendez-vous sur le site officiel pour voir le contenu passionnant (https://www.php.cn/link/53253027fef2ab5162a602f2acfed431)

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Bytedance Cutting lance le super abonnement SVIP : 499 yuans pour un abonnement annuel continu, offrant une variété de fonctions d'IA

Jun 28, 2024 am 03:51 AM

Bytedance Cutting lance le super abonnement SVIP : 499 yuans pour un abonnement annuel continu, offrant une variété de fonctions d'IA

Jun 28, 2024 am 03:51 AM

Ce site a rapporté le 27 juin que Jianying est un logiciel de montage vidéo développé par FaceMeng Technology, une filiale de ByteDance. Il s'appuie sur la plateforme Douyin et produit essentiellement du contenu vidéo court pour les utilisateurs de la plateforme. Il est compatible avec iOS, Android et. Windows, MacOS et autres systèmes d'exploitation. Jianying a officiellement annoncé la mise à niveau de son système d'adhésion et a lancé un nouveau SVIP, qui comprend une variété de technologies noires d'IA, telles que la traduction intelligente, la mise en évidence intelligente, l'emballage intelligent, la synthèse humaine numérique, etc. En termes de prix, les frais mensuels pour le clipping SVIP sont de 79 yuans, les frais annuels sont de 599 yuans (attention sur ce site : équivalent à 49,9 yuans par mois), l'abonnement mensuel continu est de 59 yuans par mois et l'abonnement annuel continu est de 59 yuans par mois. est de 499 yuans par an (équivalent à 41,6 yuans par mois) . En outre, le responsable de Cut a également déclaré que afin d'améliorer l'expérience utilisateur, ceux qui se sont abonnés au VIP d'origine

Assistant de codage d'IA augmenté par le contexte utilisant Rag et Sem-Rag

Jun 10, 2024 am 11:08 AM

Assistant de codage d'IA augmenté par le contexte utilisant Rag et Sem-Rag

Jun 10, 2024 am 11:08 AM

Améliorez la productivité, l’efficacité et la précision des développeurs en intégrant une génération et une mémoire sémantique améliorées par la récupération dans les assistants de codage IA. Traduit de EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG, auteur JanakiramMSV. Bien que les assistants de programmation d'IA de base soient naturellement utiles, ils ne parviennent souvent pas à fournir les suggestions de code les plus pertinentes et les plus correctes, car ils s'appuient sur une compréhension générale du langage logiciel et des modèles d'écriture de logiciels les plus courants. Le code généré par ces assistants de codage est adapté à la résolution des problèmes qu’ils sont chargés de résoudre, mais n’est souvent pas conforme aux normes, conventions et styles de codage des équipes individuelles. Cela aboutit souvent à des suggestions qui doivent être modifiées ou affinées pour que le code soit accepté dans l'application.

Sept questions d'entretien technique Cool GenAI et LLM

Jun 07, 2024 am 10:06 AM

Sept questions d'entretien technique Cool GenAI et LLM

Jun 07, 2024 am 10:06 AM

Pour en savoir plus sur l'AIGC, veuillez visiter : 51CTOAI.x Community https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou est différent de la banque de questions traditionnelle que l'on peut voir partout sur Internet. nécessite de sortir des sentiers battus. Les grands modèles linguistiques (LLM) sont de plus en plus importants dans les domaines de la science des données, de l'intelligence artificielle générative (GenAI) et de l'intelligence artificielle. Ces algorithmes complexes améliorent les compétences humaines et stimulent l’efficacité et l’innovation dans de nombreux secteurs, devenant ainsi la clé permettant aux entreprises de rester compétitives. LLM a un large éventail d'applications. Il peut être utilisé dans des domaines tels que le traitement du langage naturel, la génération de texte, la reconnaissance vocale et les systèmes de recommandation. En apprenant de grandes quantités de données, LLM est capable de générer du texte

Le réglage fin peut-il vraiment permettre au LLM d'apprendre de nouvelles choses : l'introduction de nouvelles connaissances peut amener le modèle à produire davantage d'hallucinations

Jun 11, 2024 pm 03:57 PM

Le réglage fin peut-il vraiment permettre au LLM d'apprendre de nouvelles choses : l'introduction de nouvelles connaissances peut amener le modèle à produire davantage d'hallucinations

Jun 11, 2024 pm 03:57 PM

Les grands modèles linguistiques (LLM) sont formés sur d'énormes bases de données textuelles, où ils acquièrent de grandes quantités de connaissances du monde réel. Ces connaissances sont intégrées à leurs paramètres et peuvent ensuite être utilisées en cas de besoin. La connaissance de ces modèles est « réifiée » en fin de formation. À la fin de la pré-formation, le modèle arrête effectivement d’apprendre. Alignez ou affinez le modèle pour apprendre à exploiter ces connaissances et répondre plus naturellement aux questions des utilisateurs. Mais parfois, la connaissance du modèle ne suffit pas, et bien que le modèle puisse accéder à du contenu externe via RAG, il est considéré comme bénéfique de l'adapter à de nouveaux domaines grâce à un réglage fin. Ce réglage fin est effectué à l'aide de la contribution d'annotateurs humains ou d'autres créations LLM, où le modèle rencontre des connaissances supplémentaires du monde réel et les intègre.

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

L'ensemble de données ScienceAI Question Answering (QA) joue un rôle essentiel dans la promotion de la recherche sur le traitement du langage naturel (NLP). Des ensembles de données d'assurance qualité de haute qualité peuvent non seulement être utilisés pour affiner les modèles, mais également évaluer efficacement les capacités des grands modèles linguistiques (LLM), en particulier la capacité à comprendre et à raisonner sur les connaissances scientifiques. Bien qu’il existe actuellement de nombreux ensembles de données scientifiques d’assurance qualité couvrant la médecine, la chimie, la biologie et d’autres domaines, ces ensembles de données présentent encore certaines lacunes. Premièrement, le formulaire de données est relativement simple, et la plupart sont des questions à choix multiples. Elles sont faciles à évaluer, mais limitent la plage de sélection des réponses du modèle et ne peuvent pas tester pleinement la capacité du modèle à répondre aux questions scientifiques. En revanche, les questions et réponses ouvertes

Cinq écoles d'apprentissage automatique que vous ne connaissez pas

Jun 05, 2024 pm 08:51 PM

Cinq écoles d'apprentissage automatique que vous ne connaissez pas

Jun 05, 2024 pm 08:51 PM

L'apprentissage automatique est une branche importante de l'intelligence artificielle qui donne aux ordinateurs la possibilité d'apprendre à partir de données et d'améliorer leurs capacités sans être explicitement programmés. L'apprentissage automatique a un large éventail d'applications dans divers domaines, de la reconnaissance d'images et du traitement du langage naturel aux systèmes de recommandation et à la détection des fraudes, et il change notre façon de vivre. Il existe de nombreuses méthodes et théories différentes dans le domaine de l'apprentissage automatique, parmi lesquelles les cinq méthodes les plus influentes sont appelées les « Cinq écoles d'apprentissage automatique ». Les cinq grandes écoles sont l’école symbolique, l’école connexionniste, l’école évolutionniste, l’école bayésienne et l’école analogique. 1. Le symbolisme, également connu sous le nom de symbolisme, met l'accent sur l'utilisation de symboles pour le raisonnement logique et l'expression des connaissances. Cette école de pensée estime que l'apprentissage est un processus de déduction inversée, à travers les connaissances existantes.

Les performances de SOTA, la méthode d'IA de prédiction d'affinité protéine-ligand multimodale de Xiamen, combinent pour la première fois des informations sur la surface moléculaire

Jul 17, 2024 pm 06:37 PM

Les performances de SOTA, la méthode d'IA de prédiction d'affinité protéine-ligand multimodale de Xiamen, combinent pour la première fois des informations sur la surface moléculaire

Jul 17, 2024 pm 06:37 PM

Editeur | KX Dans le domaine de la recherche et du développement de médicaments, il est crucial de prédire avec précision et efficacité l'affinité de liaison des protéines et des ligands pour le criblage et l'optimisation des médicaments. Cependant, les études actuelles ne prennent pas en compte le rôle important des informations sur la surface moléculaire dans les interactions protéine-ligand. Sur cette base, des chercheurs de l'Université de Xiamen ont proposé un nouveau cadre d'extraction de caractéristiques multimodales (MFE), qui combine pour la première fois des informations sur la surface des protéines, la structure et la séquence 3D, et utilise un mécanisme d'attention croisée pour comparer différentes modalités. alignement. Les résultats expérimentaux démontrent que cette méthode atteint des performances de pointe dans la prédiction des affinités de liaison protéine-ligand. De plus, les études d’ablation démontrent l’efficacité et la nécessité des informations sur la surface des protéines et de l’alignement des caractéristiques multimodales dans ce cadre. Les recherches connexes commencent par "S

NTT QONOQ Devices dévoile les lunettes XR sans fil Mirza pour smartphones

Sep 09, 2024 pm 06:30 PM

NTT QONOQ Devices dévoile les lunettes XR sans fil Mirza pour smartphones

Sep 09, 2024 pm 06:30 PM

NTT QONOQ Devices a dévoilé les lunettes XR sans fil Mirza pour smartphones, évitant ainsi aux utilisateurs d'avoir à se débattre avec des cordons. Les lunettes peuvent afficher du contenu AR virtuel dans des espaces du monde réel comme Pokemon Go ou le contenu de leur téléphone sur un grand écran virtuel.