Périphériques technologiques

Périphériques technologiques

IA

IA

Une stratégie basée sur un réseau neuronal pour améliorer les simulations quantiques

Une stratégie basée sur un réseau neuronal pour améliorer les simulations quantiques

Une stratégie basée sur un réseau neuronal pour améliorer les simulations quantiques

Les ordinateurs quantiques récents constituent une plateforme prometteuse pour trouver l’état fondamental des systèmes quantiques, une tâche fondamentale en physique, chimie et science des matériaux. Cependant, les méthodes récentes sont limitées par le bruit et les ressources matérielles quantiques récentes limitées.

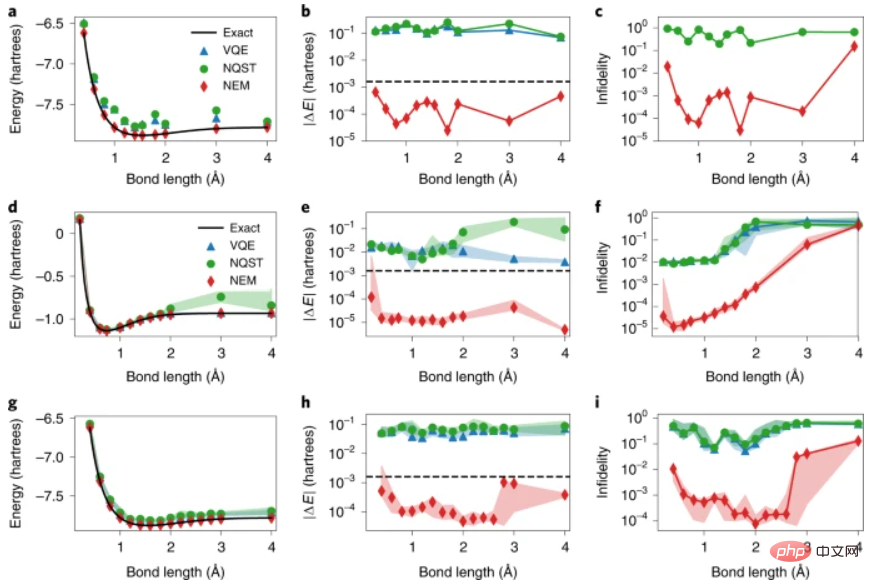

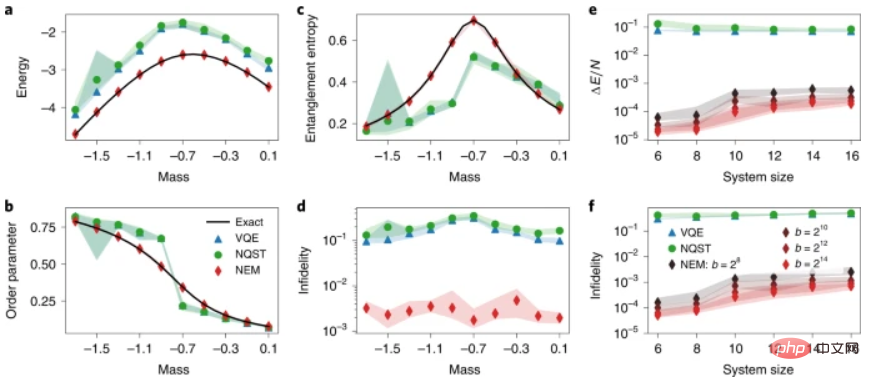

Des chercheurs de l'Université de Waterloo au Canada ont introduit l'atténuation des erreurs neuronales, qui utilise des réseaux de neurones pour améliorer les estimations de l'état fondamental et des observables de l'état fondamental obtenues à l'aide de récentes simulations quantiques. Pour démontrer la large applicabilité de la méthode, les chercheurs ont utilisé l'atténuation des erreurs neuronales pour trouver les états fondamentaux des hamiltoniens moléculaires H2 et LiH préparés par un solveur propre quantique variationnel ainsi que le modèle de Schwinger en réseau.

Les résultats expérimentaux montrent que l'atténuation des erreurs neuronales améliore les calculs numériques et expérimentaux du solveur de signature quantique variationnelle pour produire des erreurs de faible énergie, une haute fidélité et une robustesse à des observables plus complexes (par exemple, les paramètres d'ordre et l'entropie d'intrication) une estimation précise sans nécessiter de données supplémentaires. ressources quantiques. De plus, l’atténuation des erreurs neuronales est indépendante de l’algorithme de préparation d’état quantique utilisé, du matériel quantique qui le met en œuvre et des canaux de bruit spécifiques affectant l’expérience, contribuant ainsi à sa polyvalence en tant qu’outil de simulation quantique.

La recherche s'intitule « Neural Error Mitigation of Near-Term Quantum Simulations » et a été publiée dans « Nature Machine Intelligence » le 20 juillet 2022.

Depuis le début du 20e siècle, les scientifiques développent des théories complètes décrivant le comportement des systèmes de mécanique quantique. Cependant, les coûts de calcul requis pour étudier ces systèmes dépassent souvent les capacités des méthodes et du matériel informatique scientifique actuels. Par conséquent, l’infaisabilité informatique reste un obstacle à l’application pratique de ces théories aux problèmes scientifiques et techniques.

La simulation de systèmes quantiques sur des ordinateurs quantiques (appelée ici simulation quantique) s'avère prometteuse pour surmonter ces obstacles et a été une force motrice fondamentale derrière le concept et la création d'ordinateurs quantiques. En particulier, les simulations quantiques des états fondamentaux et stationnaires des systèmes quantiques à N corps au-delà des capacités des ordinateurs classiques devraient avoir un impact significatif sur la physique nucléaire, la physique des particules, la gravité quantique, la physique de la matière condensée, la chimie quantique et la science des matériaux. . Les capacités des ordinateurs quantiques actuels et à court terme continuent d’être limitées par des limitations telles que le nombre de qubits et les effets du bruit. La technologie de correction des erreurs quantiques peut éliminer les erreurs causées par le bruit, ouvrant ainsi la voie à une informatique quantique tolérante aux pannes. En pratique, cependant, la mise en œuvre de la correction d’erreurs quantiques entraîne une surcharge importante en termes de nombre de qubits requis et de faibles taux d’erreur, qui dépassent tous deux les capacités des dispositifs actuels et à court terme.

En attendant que des simulations quantiques tolérantes aux pannes puissent être réalisées, les algorithmes variationnels modernes atténuent considérablement le besoin de matériel quantique et exploitent les capacités des dispositifs quantiques bruyants à moyenne échelle.

Un exemple frappant est le solveur propre quantique variationnel (VQE), un algorithme quantique classique hybride qui s'approche de manière itérative du minimum d'un hamiltonien cible grâce à l'optimisation variationnelle d'une série de valeurs propres énergétiques de circuits quantiques paramétrés. Parmi d’autres algorithmes variationnels, celui-ci est devenu une stratégie de premier plan pour obtenir un avantage quantique en utilisant des appareils récents et accélérer les progrès dans de multiples domaines scientifiques et technologiques.

La mise en œuvre expérimentale d'algorithmes quantiques variationnels reste un défi pour de nombreux problèmes scientifiques, car les dispositifs quantiques bruyants de moyenne échelle sont affectés par diverses sources de bruit et défauts. Actuellement, plusieurs méthodes d'atténuation des erreurs quantiques (QEM) pour atténuer ces problèmes ont été proposées et vérifiées expérimentalement, améliorant ainsi l'informatique quantique sans les ressources quantiques requises pour la correction des erreurs quantiques.

En règle générale, ces méthodes utilisent des informations spécifiques sur les canaux de bruit affectant le calcul quantique, la mise en œuvre matérielle ou l'algorithme quantique lui-même ; y compris des représentations implicites des modèles de bruit et la façon dont ils affectent les estimations des observables requis, préparées Connaissance spécifique du sous-espace d'état dans quels états quantiques devraient résider et la caractérisation et l'atténuation des sources de bruit sur divers composants de l'informatique quantique, telles que les erreurs de porte à un et deux qubits, ainsi que les erreurs de préparation et de mesure des états.

Les techniques d'apprentissage automatique ont récemment été réutilisées comme outils pour résoudre des problèmes complexes de physique quantique à N corps et de traitement de l'information quantique, offrant ainsi une approche alternative au QEM. Ici, des chercheurs de l'Université de Waterloo présentent une stratégie QEM appelée Neural Error Mitigation (NEM), qui utilise des réseaux neuronaux pour atténuer les erreurs dans la préparation approximative de l'état fondamental quantique de l'hamiltonien.

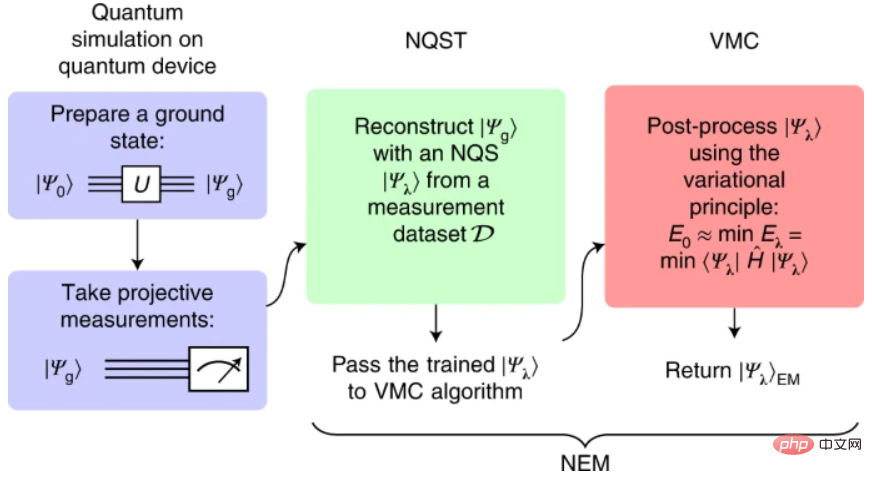

L'algorithme NEM se compose de deux étapes. Tout d’abord, les chercheurs ont effectué une tomographie de l’état quantique neuronal (NQS) (NQST) pour entraîner l’ansatz NQS à représenter les états fondamentaux approximatifs préparés par des dispositifs quantiques bruyants à l’aide de mesures accessibles expérimentalement. Inspirée de la tomographie d'état quantique (QST) traditionnelle, NQST est une méthode d'apprentissage automatique QST basée sur les données qui utilise un nombre limité de mesures pour reconstruire efficacement des états quantiques complexes.

Ensuite, un algorithme variationnel de Monte Carlo (VMC) est appliqué sur le même ansatz NQS (également connu sous le nom d'ansatz NEM) pour améliorer la représentation de l'état fondamental inconnu. Dans l'esprit de VQE, VMC se rapproche de l'état fondamental de l'hamiltonien sur la base de l'ansatz variationnel classique, dans l'exemple NQS ansatz.

Illustration : programme NEM. (Source : article)

Ici, les chercheurs ont utilisé un réseau neuronal génératif autorégressif comme ansatz NEM, plus spécifiquement, ils ont utilisé l'architecture Transformer et ont montré que le modèle fonctionnait bien en tant que NQS ; En raison de sa capacité à simuler des corrélations temporelles et spatiales à longue portée, cette architecture a été utilisée dans de nombreuses expériences de pointe dans les domaines du langage naturel et du traitement d'images, et a le potentiel de simuler des corrélations quantiques à longue portée. .

NEM présente plusieurs avantages par rapport aux autres techniques d'atténuation des erreurs. Premièrement, sa surcharge expérimentale est faible ; elle ne nécessite qu’un simple ensemble de mesures réalisables expérimentalement pour apprendre les propriétés des états quantiques bruités préparés par VQE. Par conséquent, la surcharge liée à l’atténuation des erreurs dans NEM est transférée des ressources quantiques (c’est-à-dire la réalisation d’expériences et de mesures quantiques supplémentaires) aux ressources informatiques classiques pour l’apprentissage automatique. En particulier, les chercheurs ont noté que le principal coût du NEM est la réalisation du VMC avant la convergence. Un autre avantage du NEM est qu’il est indépendant de l’algorithme de simulation quantique, du dispositif qui le met en œuvre et des canaux de bruit spécifiques qui affectent la simulation quantique. Par conséquent, il peut également être combiné avec d’autres techniques QEM et peut être appliqué pour simuler des circuits quantiques analogiques ou numériques.

NEM résout également le problème de faible précision des mesures qui se pose lors de l'estimation des observables quantiques à l'aide d'appareils quantiques récents. Ceci est particulièrement important dans les simulations quantiques, où une estimation précise des observables quantiques est cruciale pour les applications pratiques. NEM résout essentiellement le problème de la faible précision des mesures à chaque étape de l’algorithme. Dans un premier temps, NQST améliore la variance des estimations observables au prix de l'introduction d'un petit biais d'estimation. Ce biais, ainsi que la variance résiduelle, peuvent être encore réduits en entraînant NEM ansatz avec VMC, ce qui conduit à des valeurs attendues de variance nulle des estimations d'énergie après avoir atteint l'état fondamental.

En combinant l'utilisation de circuits quantiques paramétriques comme le VQE d'ansatz, et l'utilisation de réseaux de neurones comme le NQST et le VMC d'ansatz, NEM combine deux familles d'états quantiques paramétriques et trois problèmes d'optimisation concernant leurs cas de pertes combinés. Les chercheurs se sont interrogés sur la nature des relations entre ces familles d’États, leurs pertes et avantages quantiques. L’examen de ces relations offre une nouvelle façon d’étudier le potentiel des algorithmes quantiques bruyants à moyenne échelle dans la recherche d’un avantage quantique. Cela peut faciliter une meilleure démarcation entre les simulations de systèmes quantiques classiquement traitables et les simulations nécessitant des ressources quantiques.

Lien papier : https://www.nature.com/articles/s42256-022-00509-0

Rapports associés : https://techxplore.com/news/ 2022-08-stratégie-basée sur les réseaux neuronaux-near-term-quantum.html

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

YOLO est immortel ! YOLOv9 est sorti : performances et vitesse SOTA~

Feb 26, 2024 am 11:31 AM

YOLO est immortel ! YOLOv9 est sorti : performances et vitesse SOTA~

Feb 26, 2024 am 11:31 AM

Les méthodes d'apprentissage profond d'aujourd'hui se concentrent sur la conception de la fonction objectif la plus appropriée afin que les résultats de prédiction du modèle soient les plus proches de la situation réelle. Dans le même temps, une architecture adaptée doit être conçue pour obtenir suffisamment d’informations pour la prédiction. Les méthodes existantes ignorent le fait que lorsque les données d’entrée subissent une extraction de caractéristiques couche par couche et une transformation spatiale, une grande quantité d’informations sera perdue. Cet article abordera des problèmes importants lors de la transmission de données via des réseaux profonds, à savoir les goulots d'étranglement de l'information et les fonctions réversibles. Sur cette base, le concept d'information de gradient programmable (PGI) est proposé pour faire face aux différents changements requis par les réseaux profonds pour atteindre des objectifs multiples. PGI peut fournir des informations d'entrée complètes pour la tâche cible afin de calculer la fonction objectif, obtenant ainsi des informations de gradient fiables pour mettre à jour les pondérations du réseau. De plus, un nouveau cadre de réseau léger est conçu

La fondation, la frontière et l'application du GNN

Apr 11, 2023 pm 11:40 PM

La fondation, la frontière et l'application du GNN

Apr 11, 2023 pm 11:40 PM

Les réseaux de neurones graphiques (GNN) ont réalisé des progrès rapides et incroyables ces dernières années. Le réseau neuronal graphique, également connu sous le nom d'apprentissage profond graphique, d'apprentissage de représentation graphique (apprentissage de représentation graphique) ou d'apprentissage profond géométrique, est le sujet de recherche qui connaît la croissance la plus rapide dans le domaine de l'apprentissage automatique, en particulier de l'apprentissage profond. Le titre de ce partage est « Bases, frontières et applications du GNN ». Il présente principalement le contenu général du livre complet « Bases, frontières et applications des réseaux de neurones graphiques » compilé par les chercheurs Wu Lingfei, Cui Peng, Pei Jian et Zhao. Liang. 1. Introduction aux réseaux de neurones graphiques 1. Pourquoi étudier les graphiques ? Les graphiques sont un langage universel pour décrire et modéliser des systèmes complexes. Le graphe en lui-même n’est pas complexe, il se compose principalement d’arêtes et de nœuds. Nous pouvons utiliser des nœuds pour représenter n'importe quel objet que nous voulons modéliser et des arêtes pour représenter deux

Un aperçu des trois architectures de puces traditionnelles pour la conduite autonome dans un seul article

Apr 12, 2023 pm 12:07 PM

Un aperçu des trois architectures de puces traditionnelles pour la conduite autonome dans un seul article

Apr 12, 2023 pm 12:07 PM

Les puces IA actuelles sont principalement divisées en trois catégories : GPU, FPGA et ASIC. Les GPU et les FPGA sont des architectures de puces relativement matures à un stade précoce et sont des puces à usage général. ASIC est une puce personnalisée pour des scénarios d'IA spécifiques. L’industrie a confirmé que les processeurs ne sont pas adaptés au calcul de l’IA, mais qu’ils sont également essentiels dans les applications d’IA. Comparaison de l'architecture de la solution GPU entre le GPU et le CPU Le CPU suit l'architecture von Neumann, dont le cœur est le stockage des programmes/données et l'exécution séquentielle en série. Par conséquent, l'architecture du CPU nécessite une grande quantité d'espace pour placer l'unité de stockage (Cache) et l'unité de contrôle (Control). En revanche, l'unité de calcul (ALU) n'occupe qu'une petite partie, le CPU est donc performant à grande échelle. calcul parallèle.

'Le propriétaire de Bilibili UP a créé avec succès le premier réseau neuronal au monde basé sur la pierre rouge, qui a fait sensation sur les réseaux sociaux et a été salué par Yann LeCun.'

May 07, 2023 pm 10:58 PM

'Le propriétaire de Bilibili UP a créé avec succès le premier réseau neuronal au monde basé sur la pierre rouge, qui a fait sensation sur les réseaux sociaux et a été salué par Yann LeCun.'

May 07, 2023 pm 10:58 PM

Dans Minecraft, la redstone est un élément très important. C'est un matériau unique dans le jeu. Les interrupteurs, les torches de redstone et les blocs de redstone peuvent fournir une énergie semblable à l'électricité aux fils ou aux objets. Les circuits Redstone peuvent être utilisés pour construire des structures permettant de contrôler ou d'activer d'autres machines. Ils peuvent eux-mêmes être conçus pour répondre à une activation manuelle par les joueurs, ou ils peuvent émettre des signaux à plusieurs reprises ou répondre à des changements provoqués par des non-joueurs, tels que le mouvement des créatures. et des objets. Chute, croissance des plantes, jour et nuit, et plus encore. Par conséquent, dans mon monde, Redstone peut contrôler de nombreux types de machines, allant des machines simples telles que les portes automatiques, les interrupteurs d'éclairage et les alimentations stroboscopiques, aux énormes ascenseurs, aux fermes automatiques, aux petites plates-formes de jeu et même aux machines intégrées aux jeux. Récemment, la station B UP principale @

Un drone capable de résister aux vents violents ? Caltech utilise 12 minutes de données de vol pour apprendre aux drones à voler dans le vent

Apr 09, 2023 pm 11:51 PM

Un drone capable de résister aux vents violents ? Caltech utilise 12 minutes de données de vol pour apprendre aux drones à voler dans le vent

Apr 09, 2023 pm 11:51 PM

Lorsque le vent est suffisamment fort pour souffler sur le parapluie, le drone est stable, comme ceci : voler dans le vent fait partie du vol dans les airs. À un niveau élevé, lorsque le pilote fait atterrir l'avion, la vitesse du vent peut être élevée. Ce qui leur pose des défis ; à un niveau moindre, les rafales de vent peuvent également affecter le vol des drones. Actuellement, les drones volent dans des conditions contrôlées, sans vent, ou sont pilotés par des humains à l’aide de télécommandes. Les drones sont contrôlés par les chercheurs pour voler en formations à ciel ouvert, mais ces vols sont généralement effectués dans des conditions et des environnements idéaux. Cependant, pour que les drones puissent effectuer de manière autonome des tâches nécessaires mais routinières, comme la livraison de colis, ils doivent être capables de s'adapter aux conditions de vent en temps réel. Pour rendre les drones plus maniables lorsqu'ils volent face au vent, une équipe d'ingénieurs de Caltech

Multi-chemin, multi-domaine, tout compris ! Google AI publie le modèle général d'apprentissage multi-domaines MDL

May 28, 2023 pm 02:12 PM

Multi-chemin, multi-domaine, tout compris ! Google AI publie le modèle général d'apprentissage multi-domaines MDL

May 28, 2023 pm 02:12 PM

Les modèles d'apprentissage profond pour les tâches de vision (telles que la classification d'images) sont généralement formés de bout en bout avec des données provenant d'un seul domaine visuel (telles que des images naturelles ou des images générées par ordinateur). Généralement, une application qui effectue des tâches de vision pour plusieurs domaines doit créer plusieurs modèles pour chaque domaine distinct et les former indépendamment. Les données ne sont pas partagées entre différents domaines. Lors de l'inférence, chaque modèle gérera un domaine spécifique. Même s'ils sont orientés vers des domaines différents, certaines caractéristiques des premières couches entre ces modèles sont similaires, de sorte que la formation conjointe de ces modèles est plus efficace. Cela réduit la latence et la consommation d'énergie, ainsi que le coût de la mémoire lié au stockage de chaque paramètre du modèle. Cette approche est appelée apprentissage multidomaine (MDL). De plus, les modèles MDL peuvent également surpasser les modèles simples.

1,3 ms prend 1,3 ms ! La dernière architecture de réseau neuronal mobile open source de Tsinghua, RepViT

Mar 11, 2024 pm 12:07 PM

1,3 ms prend 1,3 ms ! La dernière architecture de réseau neuronal mobile open source de Tsinghua, RepViT

Mar 11, 2024 pm 12:07 PM

Adresse papier : https://arxiv.org/abs/2307.09283 Adresse code : https://github.com/THU-MIG/RepViTRepViT fonctionne bien dans l'architecture ViT mobile et présente des avantages significatifs. Ensuite, nous explorons les contributions de cette étude. Il est mentionné dans l'article que les ViT légers fonctionnent généralement mieux que les CNN légers sur les tâches visuelles, principalement en raison de leur module d'auto-attention multi-têtes (MSHA) qui permet au modèle d'apprendre des représentations globales. Cependant, les différences architecturales entre les ViT légers et les CNN légers n'ont pas été entièrement étudiées. Dans cette étude, les auteurs ont intégré des ViT légers dans le système efficace.

Une nouvelle recherche révèle le potentiel du Monte Carlo quantique à surpasser les réseaux neuronaux en dépassant les limites, et un sous-numéro de Nature détaille les derniers progrès.

Apr 24, 2023 pm 09:16 PM

Une nouvelle recherche révèle le potentiel du Monte Carlo quantique à surpasser les réseaux neuronaux en dépassant les limites, et un sous-numéro de Nature détaille les derniers progrès.

Apr 24, 2023 pm 09:16 PM

Après quatre mois, un autre travail collaboratif entre ByteDance Research et le groupe de recherche de Chen Ji à l'École de physique de l'Université de Pékin a été publié dans la revue internationale de premier plan Nature Communications : l'article « Vers l'état fondamental des molécules via les réseaux neuronaux de diffusion Monte Carlo ». combine les réseaux de neurones avec les méthodes de diffusion Monte Carlo, améliorant considérablement l'application des méthodes de réseaux de neurones en chimie quantique. La précision du calcul, l'efficacité et l'échelle du système sur les tâches connexes sont devenues le dernier SOTA. Lien papier : https://www.nature.com