Périphériques technologiques

Périphériques technologiques

IA

IA

Les deux apprentis de Li Feifei guident conjointement : un robot capable de comprendre les 'invites multimodales' peut améliorer de 2,9 fois les performances du tir zéro

Les deux apprentis de Li Feifei guident conjointement : un robot capable de comprendre les 'invites multimodales' peut améliorer de 2,9 fois les performances du tir zéro

Les deux apprentis de Li Feifei guident conjointement : un robot capable de comprendre les 'invites multimodales' peut améliorer de 2,9 fois les performances du tir zéro

La prochaine opportunité de développement dans le domaine de l'intelligence artificielle pourrait être de doter le modèle d'IA d'un « corps » et d'interagir avec le monde réel pour apprendre.

Par rapport aux tâches existantes telles que le traitement du langage naturel et la vision par ordinateur qui sont effectuées dans des environnements spécifiques, la technologie robotique en champ ouvertest évidemment plus difficile.

Par exemple, l'apprentissage basé sur des invites peut permettre à un modèle de langage unique d'effectuer toutes les tâches de traitement du langage naturel, telles que l'écriture de code, la création de résumés et les questions et réponses, simplement en modifiant l'invite.

Mais il existe d'autres types de spécifications de tâches en robotique, comme imiter un échantillon de démonstration unique, suivre des instructions linguistiques ou atteindre un certain objectif visuel. Celles-ci sont généralement considérées comme des tâches différentes et sont spécialement formées par . modèles Pour y faire face.

Récemment, des chercheurs de NVIDIA, de l'Université Stanford, du Macalester College, de Caltech, de l'Université Tsinghua et de l'Université du Texas à Austin ont proposé conjointement un Agent robot universel basé sur un transformateur VIMA, qui utilise multi-modalité L'invite atteint des performances de généralisation extrêmement élevées et peut gérer un grand nombre de tâches de fonctionnement du robot.

Lien papier : https://arxiv.org/abs/2210.03094

Lien du projet : https://vimalabs.github.io/

Lien des codes : https://github.com/vimalabs/VIMA

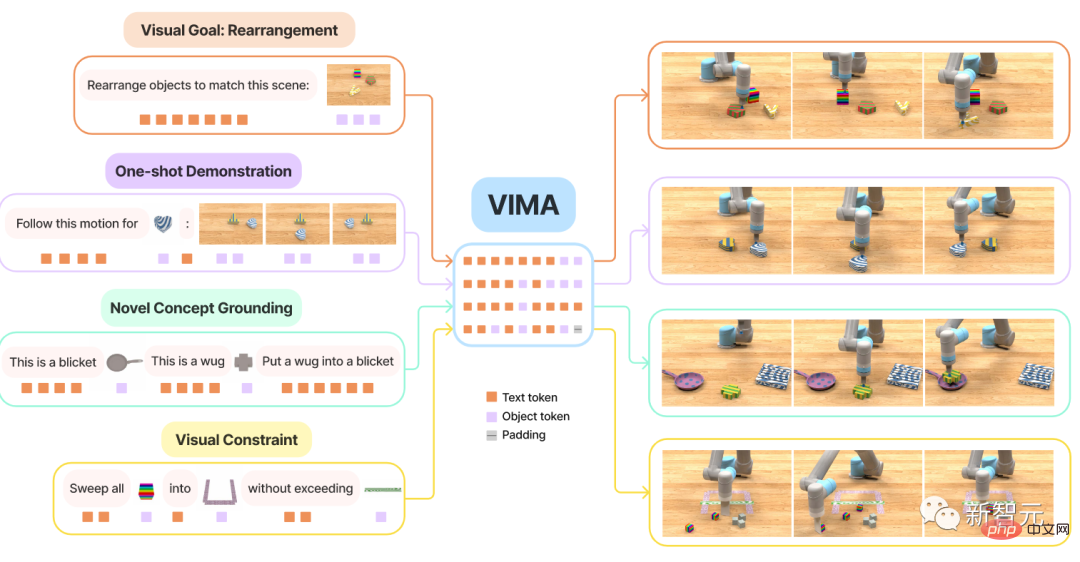

L'invite de saisie est un texte entrelacé et des symboles visuels.

Pour former et évaluer VIMA, les chercheurs proposent un nouvel ensemble de données de référence de simulation, qui contient des milliers de tâches de bureau générées de manière procédurale avec des invites multimodales, et plus de 600 000 trajectoires expertes pour l'apprentissage par imitation, les performances de généralisation du Le modèle est évalué avec quatre niveaux.

Avec le même modèle de taille et la même quantité de données d'entraînement, le taux de réussite de VIMA dans le cadre de généralisation zéro-shot le plus difficile est 2,9 fois supérieur à celui de la méthode sota actuelle.

Avec une réduction de 10 fois des données d'entraînement, VIMA fonctionne toujours 2,7 fois mieux que les autres méthodes.

Actuellement, tous les codes, modèles pré-entraînés, ensembles de données et tests de simulation sont entièrement open source.

Le premier auteur de l'article est Yunfan Jiang, étudiant en deuxième année de maîtrise à l'Université de Stanford et actuellement stagiaire au NVIDIA Research Institute. Diplômé de l'Université d'Édimbourg en 2020. Son principal domaine de recherche est l’intelligence artificielle incarnée (Emboded AI), qui apprend par interaction avec l’environnement. Le contenu spécifique de la recherche porte sur la manière d'utiliser des modèles de base à grande échelle pour réaliser des agents incarnés ouverts. L'article comprend deux mentors, tous deux anciens étudiants de Li Feifei.

Zhu Yuke

Zhu Yuke

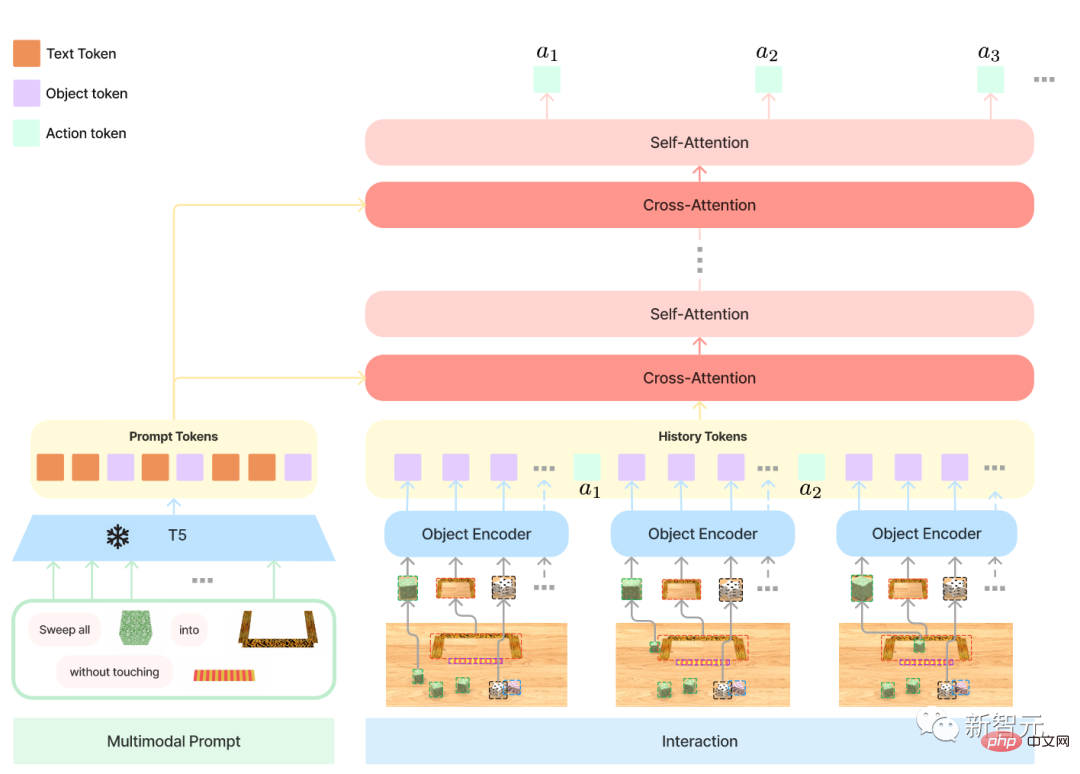

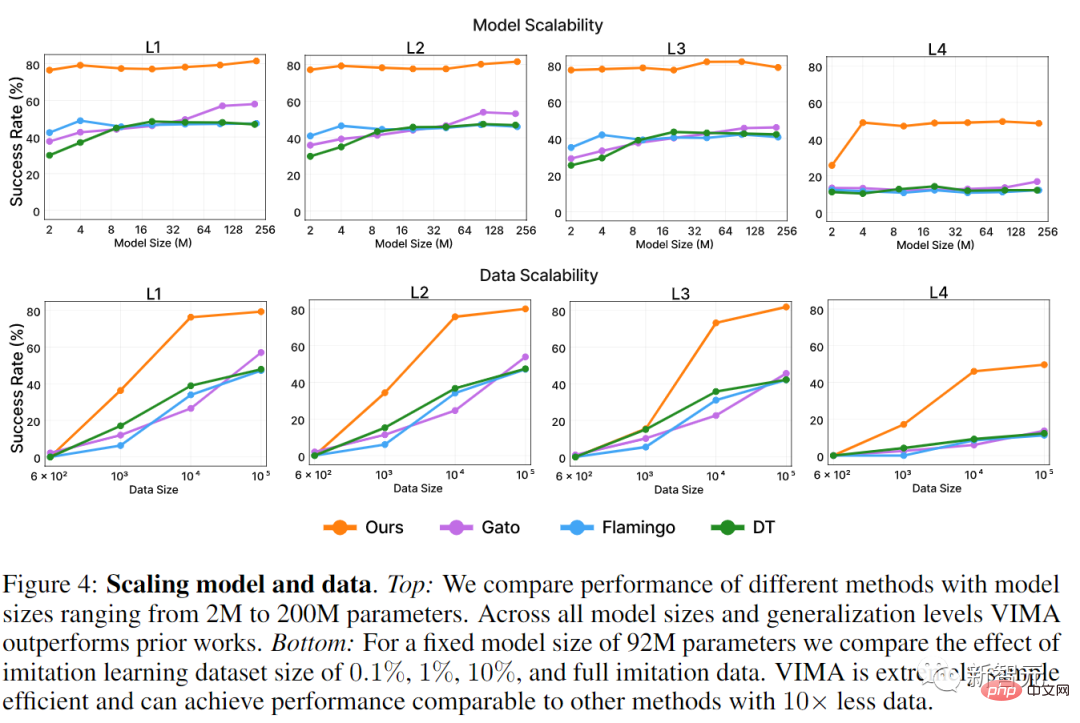

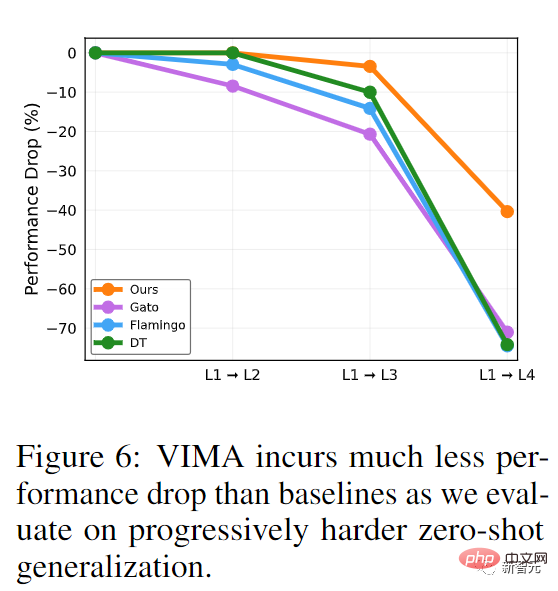

Fan Linxi, diplômé d'un doctorat de l'Université de Stanford, a étudié sous la direction de Li Feifei et est actuellement chercheur scientifique chez NVIDIA AI. La principale direction de recherche est le développement d'agents autonomes généralement capables. Des travaux de recherche spécifiques couvrent les modèles de base, l'apprentissage politique, la robotique, l'apprentissage multimodal et les systèmes à grande échelle. Transformer a atteint de très hautes performances en multitâche dans le domaine de la PNL. Un seul modèle peut compléter simultanément des questions et réponses, une traduction automatique, un résumé de texte, etc. L'interface pour la mise en œuvre de différentes tâches réside dans les invites de saisie de texte, transmettant ainsi les exigences spécifiques des tâches au grand modèle général. Cette interface d'invite peut-elle être utilisée sur un agent robot général ? Pour un robot ménager, idéalement, il suffit de saisir Apportez-le-moi, et le robot pourra récupérer la tasse selon la photo. Lorsque le robot a besoin d'acquérir de nouvelles compétences, il est préférable de les apprendre en saisissant des démonstrations vidéo. Si le robot doit interagir avec des objets inconnus, cela peut être facilement expliqué avec une simple illustration. Dans le même temps, afin d'assurer un déploiement sécurisé, les utilisateurs peuvent préciser davantage les contraintes visuelles, telles que Ne pas entrer dans la salle Afin de réaliser ces fonctions, le modèle VIMA contient principalement trois parties : 1, Invite multimodale formelle, transformant la tâche de manipulation du robot en un problème de modélisation de séquence 2 Un nouveau modèle d'agent robot, capable d'opérations multitâches 3. Un nouveau modèle d'agent robot avec différents Benchmarks à grande échelle de la tâche pour évaluer systématiquement l'évolutivité et la généralité des agents Premièrement, la flexibilité apportée par les invites multimodales permet aux développeurs de spécifier et de créer un seul modèle pour prendre en charge un grand nombre de spécifications de tâches, cet article considère principalement six types de tâches : 1, Manipulation d'objet simple (Manipulation d'objet simple) , où l'emplacement correspondant est l'image de l'objet ; 2, Objectif visuel atteint, manipuler des objets pour atteindre l'établissement d'objectifs, comme le réarrangement 3, Accepter de nouveaux concepts (base de concept novateur), les invites incluent Certains mots inhabituels, tels que dax, blicket, etc., peuvent être expliqués à travers des images dans les invites, puis utilisés directement dans les instructions, ce qui peut tester la vitesse cognitive de l'agent face aux nouveaux concepts 4, Échantillon unique d'imitation vidéo One-shot, regardez la démonstration vidéo et apprenez à reproduire un objet spécifique avec la même trajectoire de mouvement 5, Satisfaire la satisfaction des contraintes visuelles, le robot doit manipuler les objets avec soin pour éviter de les violer ; restrictions de sécurité ; 6. Raisonnement visuel (Raisonnement visuel) dans le conteneur, puis remettez-le dans sa position d'origine" Il est à noter que ces six types de tâches ne s'excluent pas mutuellement, par exemple, certaines tâches Un verbe ( Novel Concept) qui n'a pas été vu auparavant peut être présenté à travers la vidéo de démonstration (imitation) Il est difficile pour une femme intelligente de cuisiner sans riz Afin de former le modèle, le. les chercheurs ont également préparé des données à l'appui sous le nom de Référence pour l'apprentissage des robots multimodaux VIMA-BENCH. Dans l'Environnement de simulation, les benchmarks existants visent généralement des spécifications de tâches spécifiques. Actuellement, il n'existe aucun benchmark capable de fournir une riche suite de tâches multimodales et une plate-forme de test complète pour cibler les capacités des agents de détection. À cette fin, les chercheurs ont construit VIMA-BENCH en étendant le simulateur de robot Ravens pour prendre en charge une collection extensible d'objets et de textures afin de composer des signaux multimodaux et de générer de manière procédurale un grand nombre de tâches. Plus précisément, VIMA-BENCH fournit 17 méta-tâches avec des modèles d'invites multimodaux, qui peuvent être instanciées en 1000 tâches indépendantes. Chaque méta-tâche appartient à une ou plusieurs des six méthodes de spécification de tâches ci-dessus. VIMA-BENCH peut générer une grande quantité de données d'apprentissage par imitation via des agents Oracle scriptés. Sur Observation and Actions, l'espace d'observation du simulateur comprend des images RVB rendues à partir de vues de face et de haut en bas, et le benchmark fournit également une segmentation d'objets réaliste et des cadres de délimitation pour les modèles centrés sur les objets Train. VIM-BENCH hérite de l'espace d'action avancé des travaux précédents, qui comprend les compétences de mouvement les plus élémentaires, telles que « choisir et placer », « essuyer », etc., qui sont déterminées par la posture de l'effet terminal. . Le simulateur comprend également un programme Oracle scripté qui peut générer des démonstrations d'experts en utilisant des informations privilégiées sur l'état du simulateur, telles que l'emplacement précis de tous les objets et l'interprétation sous-jacente des instructions multimodales. Enfin, les chercheurs ont généré un vaste ensemble de données hors ligne de trajectoires d'experts pour l'apprentissage par imitation grâce à des oracles préprogrammés. L'ensemble de données comprend 50 000 trajectoires pour chaque méta-tâche, pour un total de 650 000 trajectoires réussies. Conservez également un sous-ensemble de modèles d'objets et de textures pour une évaluation facile, et utilisez 4 des 17 méta-tâches pour des tests de généralisation sans tir. Chaque norme de tâche de VIMA-BENCH n'a que du succès et de l'échec, et il n'y a pas de signal de récompense pour les états intermédiaires. Au moment du test, les chercheurs ont exécuté la stratégie d'agent dans un simulateur physique pour calculer le taux de réussite, et le taux de réussite moyen pour toutes les métatâches évaluées était la mesure finale rapportée. Le protocole d'évaluation contient quatre niveaux pour systématiquement sonder la capacité de généralisation de l'agent. Chaque niveau s'écarte davantage de la répartition de la formation, donc à proprement parler, un niveau est plus difficile que le suivant. 1. Généralisation du placement : pendant la formation, toutes les invites sont textuelles, mais pendant les tests, le placement des objets sur le bureau est aléatoire. 2, Généralisation combinatoire : Tous les matériaux (adjectifs) et objets tridimensionnels (noms) peuvent être vus dans la formation, mais de nouvelles formes de combinaison apparaîtront lors des tests. 3. Nouvelle généralisation des objets : les invites de test et les espaces de travail simulés incluent de nouveaux adjectifs et objets. 4, Nouvelle généralisation des tâches : Une nouvelle méta-tâche avec un nouveau modèle d'invite pendant les tests Au total, trois formats sont inclus dans l'invite multimodale : 1, Texte, utilisez le modèle T5 pré-entraîné pour segmenter les mots et obtenir des vecteurs de mots 2, La scène entière du bureau, utilisez d'abord le masque R-CNN pour identifier tous les objets indépendants, chaque objet est représenté par un cadre de délimitation et une image recadrée, puis codé à l'aide d'un encodeur bo englobant et de ViT respectivement. 3, Image d'un seul objet, utilisez également ViT pour obtenir des jetons, puis saisissez la séquence de résultats dans le modèle d'encodeur T5 pré-entraîné. Contrôleur de robot, c'est-à-dire que l'entrée du décodeur est la séquence de représentation et d'historique de trajectoire après plusieurs couches d'attention croisée sur la séquence d'invite. Une telle conception peut améliorer la connexion aux invites ; mieux conserver et traiter les jetons d'invite d'origine et une meilleure efficacité informatique ; La conception expérimentale en phase de test consiste principalement à répondre à trois questions : 1, Comparaison des performances de VIMA et des précédents agents basés sur SOTA Transformer sur diverses tâches avec des invites multimodales ; 2, Les propriétés de mise à l'échelle de VIMA en termes de capacité de modèle et de volume de données ; 3, Si différents segmenteurs de mots visuels, astuces conditionnelles et encodage conditionnel affecteront la prise de décision finale ; Les modèles de base comparés incluent Gato, Flamingo et Decision Transformer (DT) Tout d'abord sur Mise à l'échelle du modèle, les chercheurs ont mis à l'échelle toutes les méthodes de 2M à 200M. Le nombre de paramètres est utilisé pour la formation, et la taille de l'encodeur est toujours maintenue comme base T5 est nettement meilleure que les autres travaux d'évaluation de généralisation zéro-shot à tous les niveaux. Bien que Gato et Flamingo aient amélioré leurs performances sur les modèles de plus grande taille, VIMA est toujours meilleur que tous les modèles. Dans Data Scaling, les chercheurs ont mené différentes expériences sur les données d'entraînement de chaque méthode à 0,1%, 1%, 10% et l'ensemble complet de données d'apprentissage d'imitation n'a besoin que de 1% avec les données. , vous pouvez atteindre les indicateurs de généralisation L1 et L2 formés par d'autres méthodes en utilisant 10 fois plus de données. Sur l'indicateur L4, avec seulement 1% des données d'entraînement, VIMA est déjà meilleur que les autres modèles entraînés sur la totalité des données. Dans la comparaison des performances de la Généralisation Progressive, aucun réglage fin n'a été utilisé dans les tâches de généralisation les plus difficiles. Le modèle VIMA présente la plus faible régression des performances, notamment de L1 à L2 et de L1 à L3, tandis que d'autres modèles se sont dégradés de plus de 20 %, ce qui signifie également que VIMA a appris une stratégie plus généralisée et une représentation plus robuste. Référence : https://arxiv.org/abs/2210.03094Robots et invites multimodales

Modèle VIMA

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Les traits du visage volent, ouvrent la bouche, regardent fixement et lèvent les sourcils. L'IA peut les imiter parfaitement, ce qui rend impossible la prévention des escroqueries vidéo.

Dec 14, 2023 pm 11:30 PM

Les traits du visage volent, ouvrent la bouche, regardent fixement et lèvent les sourcils. L'IA peut les imiter parfaitement, ce qui rend impossible la prévention des escroqueries vidéo.

Dec 14, 2023 pm 11:30 PM

Avec une capacité d'imitation de l'IA aussi puissante, il est vraiment impossible de l'empêcher. Le développement de l’IA a-t-il atteint ce niveau aujourd’hui ? Votre pied avant fait voler les traits de votre visage, et sur votre pied arrière, la même expression est reproduite. Regarder fixement, lever les sourcils, faire la moue, aussi exagérée que soit l'expression, tout est parfaitement imité. Augmentez la difficulté, haussez les sourcils, ouvrez plus grand les yeux, et même la forme de la bouche est tordue, et l'avatar du personnage virtuel peut parfaitement reproduire l'expression. Lorsque vous ajustez les paramètres à gauche, l'avatar virtuel à droite modifiera également ses mouvements en conséquence pour donner un gros plan de la bouche et des yeux. On ne peut pas dire que l'imitation soit exactement la même, seule l'expression est exactement la même. idem (extrême droite). La recherche provient d'institutions telles que l'Université technique de Munich, qui propose GaussianAvatars, qui

L'Ameca deuxième génération est là ! Il peut communiquer couramment avec le public, ses expressions faciales sont plus réalistes et il peut parler des dizaines de langues.

Mar 04, 2024 am 09:10 AM

L'Ameca deuxième génération est là ! Il peut communiquer couramment avec le public, ses expressions faciales sont plus réalistes et il peut parler des dizaines de langues.

Mar 04, 2024 am 09:10 AM

Le robot humanoïde Ameca est passé à la deuxième génération ! Récemment, lors de la Conférence mondiale sur les communications mobiles MWC2024, le robot le plus avancé au monde, Ameca, est à nouveau apparu. Autour du site, Ameca a attiré un grand nombre de spectateurs. Avec la bénédiction de GPT-4, Ameca peut répondre à divers problèmes en temps réel. "Allons danser." Lorsqu'on lui a demandé si elle avait des émotions, Ameca a répondu avec une série d'expressions faciales très réalistes. Il y a quelques jours à peine, EngineeredArts, la société britannique de robotique derrière Ameca, vient de présenter les derniers résultats de développement de l'équipe. Dans la vidéo, le robot Ameca a des capacités visuelles et peut voir et décrire toute la pièce et des objets spécifiques. Le plus étonnant, c'est qu'elle peut aussi

Comment l'IA peut-elle rendre les robots plus autonomes et adaptables ?

Jun 03, 2024 pm 07:18 PM

Comment l'IA peut-elle rendre les robots plus autonomes et adaptables ?

Jun 03, 2024 pm 07:18 PM

Dans le domaine de la technologie de l’automatisation industrielle, il existe deux points chauds récents qu’il est difficile d’ignorer : l’intelligence artificielle (IA) et Nvidia. Ne changez pas le sens du contenu original, affinez le contenu, réécrivez le contenu, ne continuez pas : « Non seulement cela, les deux sont étroitement liés, car Nvidia ne se limite pas à son unité de traitement graphique d'origine (GPU ), il étend son GPU. La technologie s'étend au domaine des jumeaux numériques et est étroitement liée aux technologies émergentes d'IA "Récemment, NVIDIA a conclu une coopération avec de nombreuses entreprises industrielles, notamment des sociétés d'automatisation industrielle de premier plan telles qu'Aveva, Rockwell Automation, Siemens. et Schneider Electric, ainsi que Teradyne Robotics et ses sociétés MiR et Universal Robots. Récemment, Nvidiahascoll

Le premier robot capable d'accomplir de manière autonome des tâches humaines apparaît, avec cinq doigts flexibles et rapides, et de grands modèles prennent en charge l'entraînement dans l'espace virtuel

Mar 11, 2024 pm 12:10 PM

Le premier robot capable d'accomplir de manière autonome des tâches humaines apparaît, avec cinq doigts flexibles et rapides, et de grands modèles prennent en charge l'entraînement dans l'espace virtuel

Mar 11, 2024 pm 12:10 PM

Cette semaine, FigureAI, une entreprise de robotique investie par OpenAI, Microsoft, Bezos et Nvidia, a annoncé avoir reçu près de 700 millions de dollars de financement et prévoit de développer un robot humanoïde capable de marcher de manière autonome au cours de la prochaine année. Et l’Optimus Prime de Tesla a reçu à plusieurs reprises de bonnes nouvelles. Personne ne doute que cette année sera celle de l’explosion des robots humanoïdes. SanctuaryAI, une entreprise canadienne de robotique, a récemment lancé un nouveau robot humanoïde, Phoenix. Les responsables affirment qu’il peut accomplir de nombreuses tâches de manière autonome, à la même vitesse que les humains. Pheonix, le premier robot au monde capable d'accomplir des tâches de manière autonome à la vitesse d'un humain, peut saisir, déplacer et placer avec élégance chaque objet sur ses côtés gauche et droit. Il peut identifier des objets de manière autonome

Après 2 mois, le robot humanoïde Walker S peut plier les vêtements

Apr 03, 2024 am 08:01 AM

Après 2 mois, le robot humanoïde Walker S peut plier les vêtements

Apr 03, 2024 am 08:01 AM

Rédacteur en chef du Machine Power Report : Wu Xin La version domestique de l'équipe robot humanoïde + grand modèle a accompli pour la première fois la tâche d'exploitation de matériaux flexibles complexes tels que le pliage de vêtements. Avec le dévoilement de Figure01, qui intègre le grand modèle multimodal d'OpenAI, les progrès connexes des pairs nationaux ont attiré l'attention. Hier encore, UBTECH, le « stock numéro un de robots humanoïdes » en Chine, a publié la première démo du robot humanoïde WalkerS, profondément intégré au grand modèle de Baidu Wenxin, présentant de nouvelles fonctionnalités intéressantes. Maintenant, WalkerS, bénéficiant des capacités de grands modèles de Baidu Wenxin, ressemble à ceci. Comme la figure 01, WalkerS ne se déplace pas, mais se tient derrière un bureau pour accomplir une série de tâches. Il peut suivre les commandes humaines et plier les vêtements

Mar 22, 2024 pm 08:51 PM

Mar 22, 2024 pm 08:51 PM

Les 10 robots humanoïdes suivants façonnent notre avenir : 1. ASIMO : Développé par Honda, ASIMO est l'un des robots humanoïdes les plus connus. Mesurant 4 pieds de haut et pesant 119 livres, ASIMO est équipé de capteurs avancés et de capacités d'intelligence artificielle qui lui permettent de naviguer dans des environnements complexes et d'interagir avec les humains. La polyvalence d'ASIMO le rend adapté à une variété de tâches, allant de l'assistance aux personnes handicapées à la réalisation de présentations lors d'événements. 2. Pepper : Créé par Softbank Robotics, Pepper vise à être un compagnon social pour les humains. Avec son visage expressif et sa capacité à reconnaître les émotions, Pepper peut participer à des conversations, aider dans les commerces de détail et même fournir un soutien pédagogique. Poivrons

Le robot de balayage et de nettoyage Cloud Whale Xiaoyao 001 a un « cerveau » ! Expérience |

Apr 26, 2024 pm 04:22 PM

Le robot de balayage et de nettoyage Cloud Whale Xiaoyao 001 a un « cerveau » ! Expérience |

Apr 26, 2024 pm 04:22 PM

Les robots de balayage et de nettoyage sont l’un des appareils électroménagers intelligents les plus populaires auprès des consommateurs ces dernières années. La commodité d'utilisation qu'il apporte, voire l'absence d'opération, permet aux paresseux de libérer leurs mains, permettant aux consommateurs de « se libérer » des tâches ménagères quotidiennes et de consacrer plus de temps à ce qu'ils aiment. Une qualité de vie améliorée sous une forme déguisée. Surfant sur cet engouement, presque toutes les marques d'électroménager du marché fabriquent leurs propres robots de balayage et de nettoyage, rendant l'ensemble du marché des robots de balayage et de nettoyage très vivant. Cependant, l'expansion rapide du marché entraînera inévitablement un danger caché : de nombreux fabricants utiliseront la tactique de la mer de machines pour occuper rapidement plus de parts de marché, ce qui entraînera de nombreux nouveaux produits sans aucun point de mise à niveau. ce sont des modèles de "matriochka". Ce n'est pas une exagération. Cependant, tous les robots de balayage et de nettoyage ne sont pas

Le robot humanoïde peut faire de la magie, laissez l'équipe du programme du Gala de la Fête du Printemps en savoir plus

Feb 04, 2024 am 09:03 AM

Le robot humanoïde peut faire de la magie, laissez l'équipe du programme du Gala de la Fête du Printemps en savoir plus

Feb 04, 2024 am 09:03 AM

En un clin d’œil, les robots ont appris à faire de la magie ? On a vu qu'il avait d'abord ramassé la cuillère à eau sur la table, prouvant au public qu'il n'y avait rien dedans... Ensuite, il a mis l'objet en forme d'œuf dans sa main, puis a remis la cuillère à eau sur la table. et a commencé à « jeter un sort »... … Juste au moment où il a repris la cuillère à eau, un miracle s'est produit. L'œuf qui avait été initialement mis dedans a disparu et la chose qui a sauté s'est transformée en ballon de basket... Regardons à nouveau les actions continues : △ Cette animation montre un ensemble d'actions à une vitesse 2x, et cela se déroule sans problème uniquement en regardant. la vidéo à plusieurs reprises à une vitesse de 0,5x peut-elle être comprise. Finalement, j'ai découvert les indices : si la vitesse de ma main était plus rapide, je pourrais peut-être la cacher à l'ennemi. Certains internautes ont déploré que les compétences magiques du robot soient encore supérieures aux leurs : c'est Mag qui a réalisé cette magie pour nous.