Périphériques technologiques

Périphériques technologiques

IA

IA

Quel est le potentiel des modèles à paramètres fixes ? Les Chinois de Hong Kong, le Shanghai AI Lab et d'autres ont proposé un cadre efficace de compréhension vidéo EVL

Quel est le potentiel des modèles à paramètres fixes ? Les Chinois de Hong Kong, le Shanghai AI Lab et d'autres ont proposé un cadre efficace de compréhension vidéo EVL

Quel est le potentiel des modèles à paramètres fixes ? Les Chinois de Hong Kong, le Shanghai AI Lab et d'autres ont proposé un cadre efficace de compréhension vidéo EVL

Les modèles visuels de base ont connu un développement remarquable au cours des deux dernières années. D'une part, le pré-entraînement basé sur des données Internet à grande échelle a prédéfini un grand nombre de concepts sémantiques pour le modèle, ayant ainsi de bonnes performances de généralisation, mais d'autre part, afin d'utiliser pleinement la taille du modèle apportée ; par des ensembles de données à grande échelle La croissance rend les modèles associés confrontés à des problèmes d'inefficacité lors de la migration vers des tâches en aval, en particulier pour les modèles de compréhension vidéo qui doivent traiter plusieurs images.

- Lien papier : https://arxiv.org/abs/2208.03550

- Lien code : https://github.com/OpenGVLab/efficient-video-recognition

Sur la base des deux caractéristiques ci-dessus, des chercheurs de l'Université chinoise de Hong Kong, du Laboratoire d'intelligence artificielle de Shanghai et d'autres institutions ont proposé un cadre d'apprentissage par transfert de compréhension vidéo efficace EVL, qui économise les calculs d'entraînement et la mémoire en fixant le poids de la base de base modèle de consommation ; dans le même temps, en utilisant des fonctionnalités intermédiaires à plusieurs niveaux et à granularité fine, la flexibilité du réglage fin traditionnel de bout en bout est maintenue autant que possible.

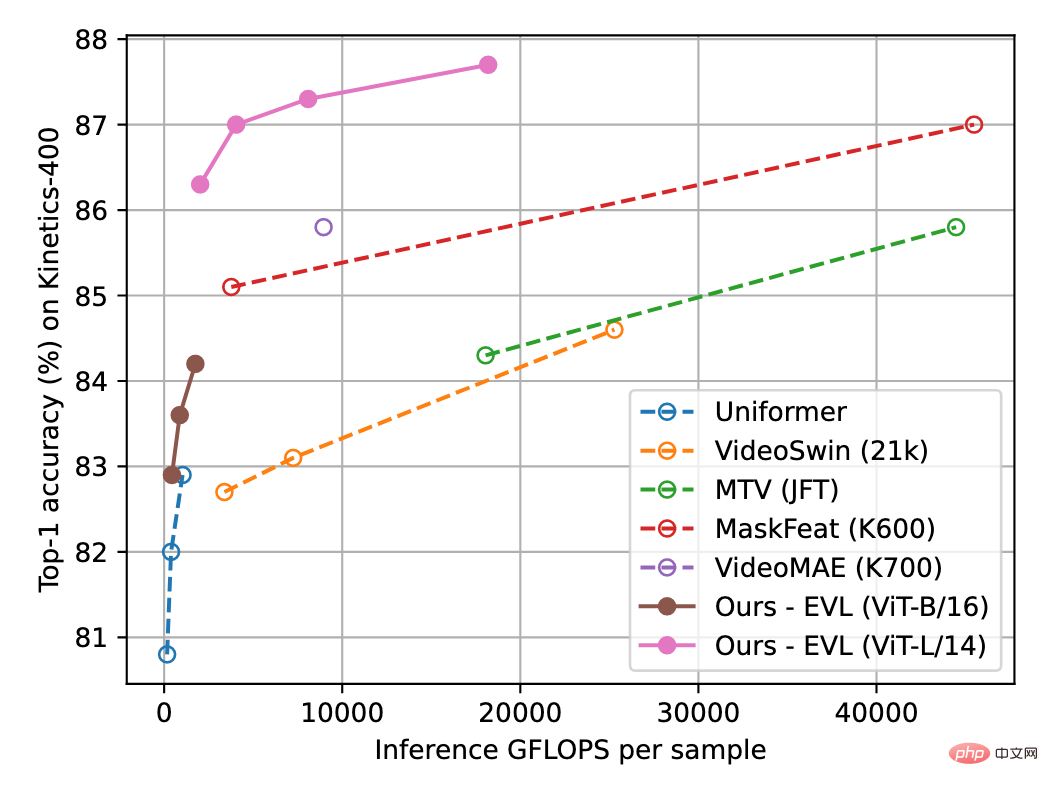

La figure 1 ci-dessous montre les résultats de la méthode EVL sur l'ensemble de données de compréhension vidéo Kinetics-400. Les expériences montrent que tout en réduisant les frais de formation, cette méthode explore pleinement le potentiel du modèle visuel de base dans les tâches de compréhension vidéo.

Figure 1 : Comparaison de la précision de reconnaissance de Kinetics-400 L'axe horizontal est la quantité de calcul d'inférence et l'axe vertical est la précision. Le diagramme schématique global de l'algorithme de la

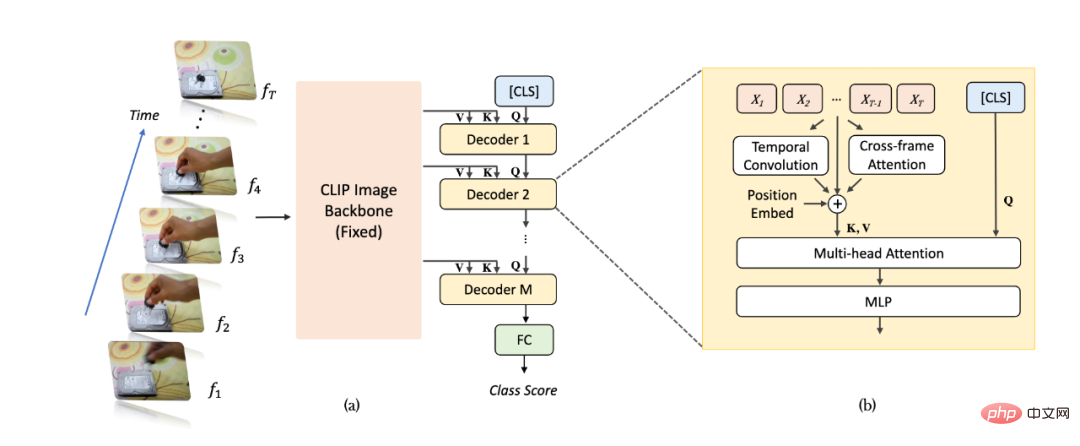

méthode

est présenté à la figure 2 (a). Pour un échantillon vidéo, nous prenons des images T et les entrons dans un réseau de reconnaissance d'image (en prenant CLIP comme exemple) et extrayons les fonctionnalités. Par rapport aux méthodes traditionnelles, nous extrayons des fonctionnalités multicouches non regroupées des dernières couches du réseau de reconnaissance d'images pour obtenir des informations d'image plus riches et plus fines, et les poids des paramètres du réseau de reconnaissance d'images sont toujours cohérents dans l'apprentissage vidéo. fixé. Par la suite, les cartes de caractéristiques multicouches sont entrées séquentiellement dans un décodeur Transformer pour l'agrégation d'informations au niveau vidéo. Les caractéristiques décodées multicouches [CLS] sont utilisées pour générer la prédiction de classification finale.

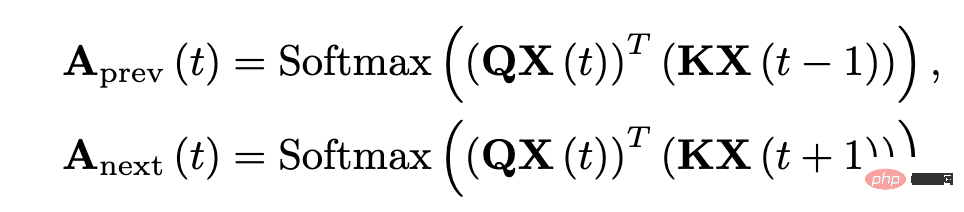

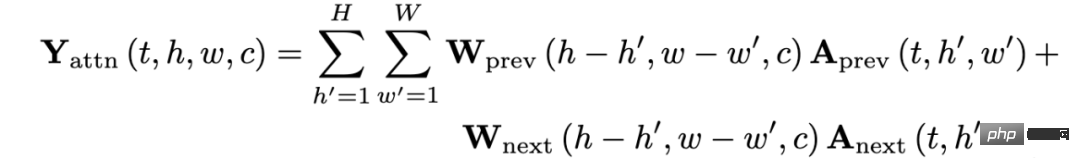

Comme le montre la figure 2 (b), en raison du désordre lorsque le décodeur Transformer regroupe les fonctionnalités, nous avons ajouté un module de modélisation d'informations de synchronisation supplémentaire dans le réseau pour mieux extraire les informations de synchronisation à grain fin liées à la position. Plus précisément, nous ajoutons trois types supplémentaires d'informations temporelles liées à la position : le premier est l'intégration de la position temporelle (Position Embeddings), le deuxième est la convolution séparable en profondeur de la dimension temporelle (Depthwise Convolution) et le troisième est l'attention entre les images adjacentes. forcer les informations. Pour les informations d'attention inter-trames, nous extrayons les caractéristiques de requête et clés de la couche correspondante du réseau de reconnaissance d'image et calculons la carte d'attention entre les trames adjacentes (différente du réseau de reconnaissance d'image, la carte d'attention est composée de la requête du même cadre et caractéristiques clés sont obtenus). La carte d'attention résultante peut refléter explicitement les changements de position des objets entre des images adjacentes. Après projection linéaire, la carte d'attention obtient un groupe de vecteurs qui reflète les caractéristiques de déplacement de l'objet et est intégrée aux caractéristiques de l'image sous la forme d'une addition élément par élément.

Figure 2 : Diagramme de structure de l'algorithme EVL. (a) Structure globale, (b) Module de modélisation d'informations séquentielles.

Figure 3 : Expression mathématique des caractéristiques d'attention inter-cadres.

Expérience

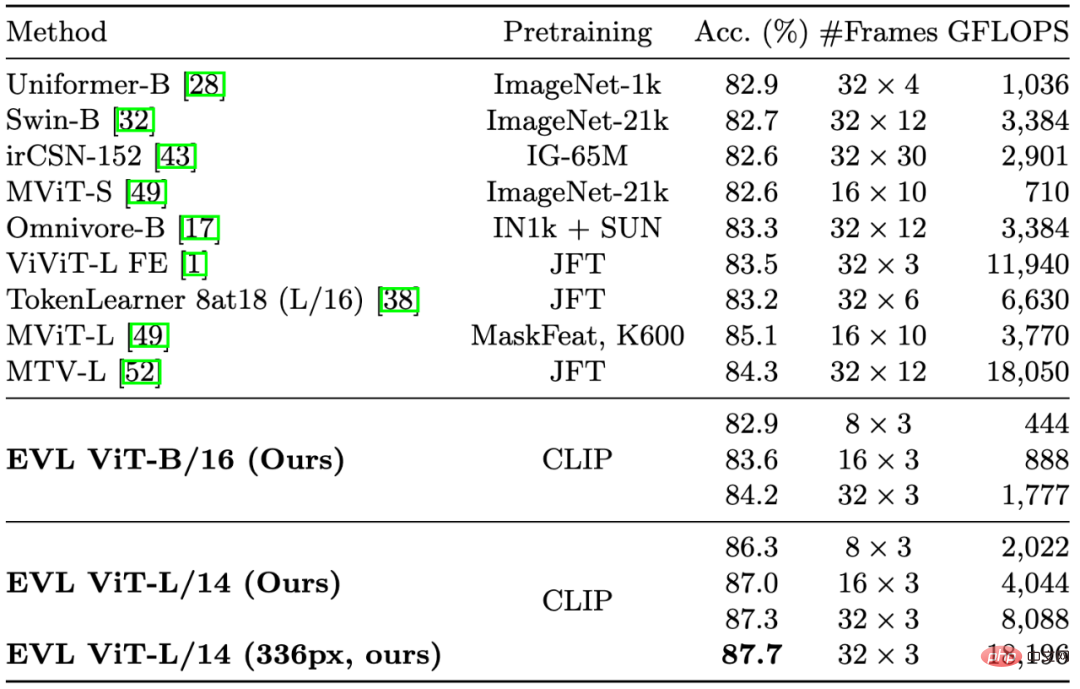

Dans la figure 1 et le tableau 1, nous avons cité quelques méthodes importantes dans la compréhension des vidéos précédentes. Bien qu'elle se concentre sur la réduction des frais de formation, notre méthode surpasse toujours les méthodes existantes en termes de précision (avec la même quantité de calcul).

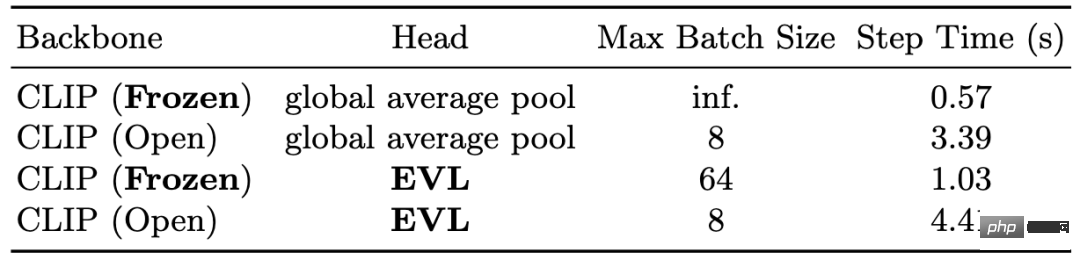

Dans le tableau 2, nous montrons la réduction des frais de formation apportée par le réseau fédérateur fixe. En termes de mémoire, sur le GPU V100 16 Go, le réseau fédérateur fixe peut permettre à une taille de lot d'une seule carte d'atteindre un maximum de 64, tandis que la formation de bout en bout ne peut atteindre que 8 en termes de temps, le fédérateur fixe ; Le réseau peut économiser 3 à 4 fois le temps de formation.

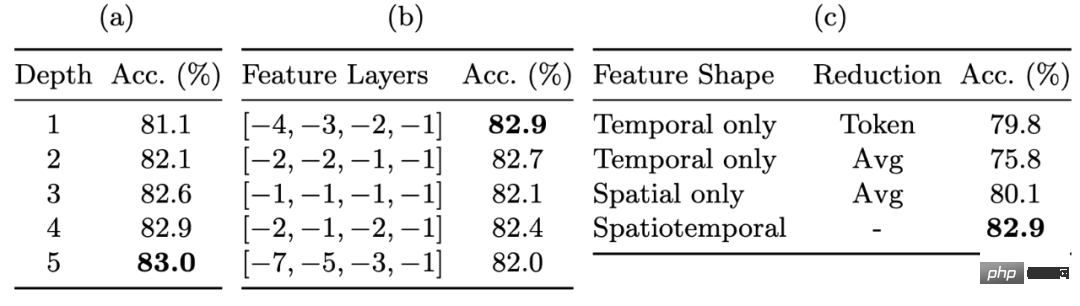

Dans le tableau 3, nous montrons l'amélioration des performances de reconnaissance grâce à des cartes de fonctionnalités à granularité fine. Les fonctionnalités multicouches non poolées nous permettent de conserver un degré considérable de flexibilité lors de la fixation des poids du réseau fédérateur. L'utilisation de fonctionnalités non poolées apporte l'amélioration la plus significative (environ 3 %), suivie par l'utilisation de décodeurs multicouches et de fonctionnalités de couche intermédiaire, qui apportent également chacune une amélioration des performances d'environ 1 %.

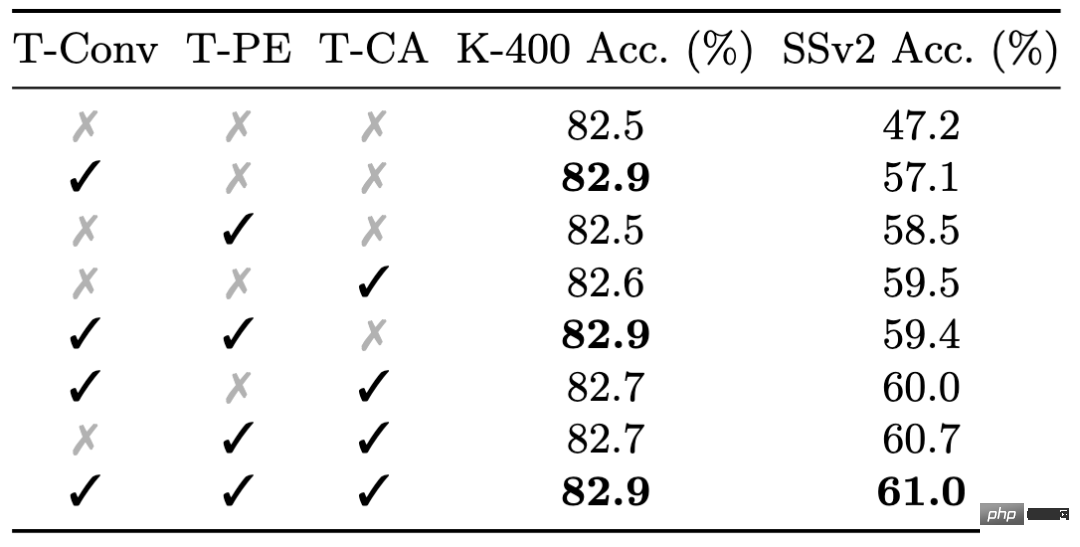

Enfin, nous montrons l'effet du module d'informations de synchronisation à granularité fine dans le tableau 4. Bien que les informations de synchronisation fines aient un impact limité sur les performances de Kinetics-400, elles sont très importantes pour les performances de Something-Something-v2 : les trois types de modules d'informations de synchronisation fines apportent un total d'environ 0,5 % et environ 14 % d’amélioration des performances.

Tableau 1 : Résultats de comparaison avec les méthodes existantes sur Kinetics-400

Tableau 2 : Réduction des frais généraux de formation causée par les poids fixes du réseau principal

Tableau 3 : L'impact des cartes de caractéristiques à granularité fine sur la précision

Tableau 4 : L'effet de la modélisation d'informations temporelles à granularité fine sur différents ensembles de données

Résumé

Cet article propose le cadre d'apprentissage de compréhension vidéo EVL, qui démontre pour la première fois le grand potentiel d'un réseau fédérateur d'images fixes dans les problèmes de compréhension vidéo, et rend également la compréhension vidéo haute performance plus conviviale pour les groupes de recherche disposant de ressources informatiques limitées. ressources. Nous pensons également qu'à mesure que la qualité et l'échelle des modèles visuels de base s'améliorent, notre méthode peut fournir une référence pour les recherches ultérieures sur les algorithmes légers d'apprentissage par transfert.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Aucune donnée OpenAI requise, rejoignez la liste des grands modèles de code ! UIUC publie StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

Aucune donnée OpenAI requise, rejoignez la liste des grands modèles de code ! UIUC publie StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

À la pointe de la technologie logicielle, le groupe de l'UIUC Zhang Lingming, en collaboration avec des chercheurs de l'organisation BigCode, a récemment annoncé le modèle de grand code StarCoder2-15B-Instruct. Cette réalisation innovante a permis une percée significative dans les tâches de génération de code, dépassant avec succès CodeLlama-70B-Instruct et atteignant le sommet de la liste des performances de génération de code. Le caractère unique de StarCoder2-15B-Instruct réside dans sa stratégie d'auto-alignement pur. L'ensemble du processus de formation est ouvert, transparent et complètement autonome et contrôlable. Le modèle génère des milliers d'instructions via StarCoder2-15B en réponse au réglage fin du modèle de base StarCoder-15B sans recourir à des annotations manuelles coûteuses.

Yolov10 : explication détaillée, déploiement et application en un seul endroit !

Jun 07, 2024 pm 12:05 PM

Yolov10 : explication détaillée, déploiement et application en un seul endroit !

Jun 07, 2024 pm 12:05 PM

1. Introduction Au cours des dernières années, les YOLO sont devenus le paradigme dominant dans le domaine de la détection d'objets en temps réel en raison de leur équilibre efficace entre le coût de calcul et les performances de détection. Les chercheurs ont exploré la conception architecturale de YOLO, les objectifs d'optimisation, les stratégies d'expansion des données, etc., et ont réalisé des progrès significatifs. Dans le même temps, le recours à la suppression non maximale (NMS) pour le post-traitement entrave le déploiement de bout en bout de YOLO et affecte négativement la latence d'inférence. Dans les YOLO, la conception de divers composants manque d’une inspection complète et approfondie, ce qui entraîne une redondance informatique importante et limite les capacités du modèle. Il offre une efficacité sous-optimale et un potentiel d’amélioration des performances relativement important. Dans ce travail, l'objectif est d'améliorer encore les limites d'efficacité des performances de YOLO à la fois en post-traitement et en architecture de modèle. à cette fin

L'Université Tsinghua a pris le relais et YOLOv10 est sorti : les performances ont été grandement améliorées et il figurait sur la hot list de GitHub

Jun 06, 2024 pm 12:20 PM

L'Université Tsinghua a pris le relais et YOLOv10 est sorti : les performances ont été grandement améliorées et il figurait sur la hot list de GitHub

Jun 06, 2024 pm 12:20 PM

La série de référence YOLO de systèmes de détection de cibles a une fois de plus reçu une mise à niveau majeure. Depuis la sortie de YOLOv9 en février de cette année, le relais de la série YOLO (YouOnlyLookOnce) a été passé entre les mains de chercheurs de l'Université Tsinghua. Le week-end dernier, la nouvelle du lancement de YOLOv10 a attiré l'attention de la communauté IA. Il est considéré comme un cadre révolutionnaire dans le domaine de la vision par ordinateur et est connu pour ses capacités de détection d'objets de bout en bout en temps réel, poursuivant l'héritage de la série YOLO en fournissant une solution puissante alliant efficacité et précision. Adresse de l'article : https://arxiv.org/pdf/2405.14458 Adresse du projet : https://github.com/THU-MIG/yo

Rapport technique Google Gemini 1.5 : prouvez facilement les questions de l'Olympiade mathématique, la version Flash est 5 fois plus rapide que GPT-4 Turbo

Jun 13, 2024 pm 01:52 PM

Rapport technique Google Gemini 1.5 : prouvez facilement les questions de l'Olympiade mathématique, la version Flash est 5 fois plus rapide que GPT-4 Turbo

Jun 13, 2024 pm 01:52 PM

En février de cette année, Google a lancé le grand modèle multimodal Gemini 1.5, qui a considérablement amélioré les performances et la vitesse grâce à l'ingénierie et à l'optimisation de l'infrastructure, à l'architecture MoE et à d'autres stratégies. Avec un contexte plus long, des capacités de raisonnement plus fortes et une meilleure gestion du contenu multimodal. Ce vendredi, Google DeepMind a officiellement publié le rapport technique de Gemini 1.5, qui couvre la version Flash et d'autres mises à jour récentes. Le document fait 153 pages. Lien du rapport technique : https://storage.googleapis.com/deepmind-media/gemini/gemini_v1_5_report.pdf Dans ce rapport, Google présente Gemini1

Comment évaluer la rentabilité du support commercial des frameworks Java

Jun 05, 2024 pm 05:25 PM

Comment évaluer la rentabilité du support commercial des frameworks Java

Jun 05, 2024 pm 05:25 PM

L'évaluation du rapport coût/performance du support commercial pour un framework Java implique les étapes suivantes : Déterminer le niveau d'assurance requis et les garanties de l'accord de niveau de service (SLA). L’expérience et l’expertise de l’équipe d’appui à la recherche. Envisagez des services supplémentaires tels que les mises à niveau, le dépannage et l'optimisation des performances. Évaluez les coûts de support commercial par rapport à l’atténuation des risques et à une efficacité accrue.

Revoir! Résumer de manière exhaustive le rôle important des modèles de base dans la promotion de la conduite autonome

Jun 11, 2024 pm 05:29 PM

Revoir! Résumer de manière exhaustive le rôle important des modèles de base dans la promotion de la conduite autonome

Jun 11, 2024 pm 05:29 PM

Écrit ci-dessus et compréhension personnelle de l'auteur : Récemment, avec le développement et les percées de la technologie d'apprentissage profond, les modèles de base à grande échelle (Foundation Models) ont obtenu des résultats significatifs dans les domaines du traitement du langage naturel et de la vision par ordinateur. L’application de modèles de base à la conduite autonome présente également de grandes perspectives de développement, susceptibles d’améliorer la compréhension et le raisonnement des scénarios. Grâce à une pré-formation sur un langage riche et des données visuelles, le modèle de base peut comprendre et interpréter divers éléments des scénarios de conduite autonome et effectuer un raisonnement, fournissant ainsi un langage et des commandes d'action pour piloter la prise de décision et la planification. Le modèle de base peut être constitué de données enrichies d'une compréhension du scénario de conduite afin de fournir les rares caractéristiques réalisables dans les distributions à longue traîne qui sont peu susceptibles d'être rencontrées lors d'une conduite de routine et d'une collecte de données.

Comment la courbe d'apprentissage des frameworks PHP se compare-t-elle à celle d'autres frameworks de langage ?

Jun 06, 2024 pm 12:41 PM

Comment la courbe d'apprentissage des frameworks PHP se compare-t-elle à celle d'autres frameworks de langage ?

Jun 06, 2024 pm 12:41 PM

La courbe d'apprentissage d'un framework PHP dépend de la maîtrise du langage, de la complexité du framework, de la qualité de la documentation et du support de la communauté. La courbe d'apprentissage des frameworks PHP est plus élevée par rapport aux frameworks Python et inférieure par rapport aux frameworks Ruby. Par rapport aux frameworks Java, les frameworks PHP ont une courbe d'apprentissage modérée mais un temps de démarrage plus court.

Comment les options légères des frameworks PHP affectent-elles les performances des applications ?

Jun 06, 2024 am 10:53 AM

Comment les options légères des frameworks PHP affectent-elles les performances des applications ?

Jun 06, 2024 am 10:53 AM

Le framework PHP léger améliore les performances des applications grâce à une petite taille et une faible consommation de ressources. Ses fonctionnalités incluent : une petite taille, un démarrage rapide, une faible utilisation de la mémoire, une vitesse de réponse et un débit améliorés et une consommation de ressources réduite. Cas pratique : SlimFramework crée une API REST, seulement 500 Ko, une réactivité élevée et un débit élevé.