Périphériques technologiques

Périphériques technologiques

IA

IA

En apprenant ChatGPT, que se passera-t-il si le feedback humain est introduit dans la peinture IA ?

En apprenant ChatGPT, que se passera-t-il si le feedback humain est introduit dans la peinture IA ?

En apprenant ChatGPT, que se passera-t-il si le feedback humain est introduit dans la peinture IA ?

Récemment, les modèles génératifs profonds ont obtenu un succès remarquable dans la génération d'images de haute qualité à partir d'invites de texte, en partie grâce à la mise à l'échelle des modèles génératifs profonds vers des ensembles de données Web à grande échelle tels que LAION. Cependant, des défis importants subsistent, empêchant les modèles texte-image à grande échelle de générer des images parfaitement alignées avec les invites textuelles. Par exemple, les modèles texte-image actuels ne parviennent souvent pas à générer un texte visuel fiable et ont des difficultés à générer des images combinées.

De retour dans le domaine de la modélisation du langage, l'apprentissage à partir des commentaires humains est devenu une solution puissante pour « aligner le comportement du modèle sur les intentions humaines ». Ce type de méthode apprend d'abord une fonction de récompense conçue pour refléter ce qui intéresse les humains dans la tâche grâce à un retour humain sur la sortie du modèle, puis utilise la fonction de récompense apprise via un algorithme d'apprentissage par renforcement (tel que l'optimisation de politique proximale PPO) pour optimiser le langage. modèles. Ce cadre d'apprentissage par renforcement avec rétroaction humaine (RLHF) a combiné avec succès des modèles de langage à grande échelle (tels que GPT-3) avec une évaluation sophistiquée de la qualité humaine.

Récemment, inspirés par le succès du RLHF dans le domaine linguistique, des chercheurs de Google Research et de Berkeley, en Californie, ont proposé une méthode de réglage fin pour aligner le texte sur des modèles d'image en utilisant la rétroaction humaine.

Adresse papier : https://arxiv.org/pdf/2302.12192v1.pdf

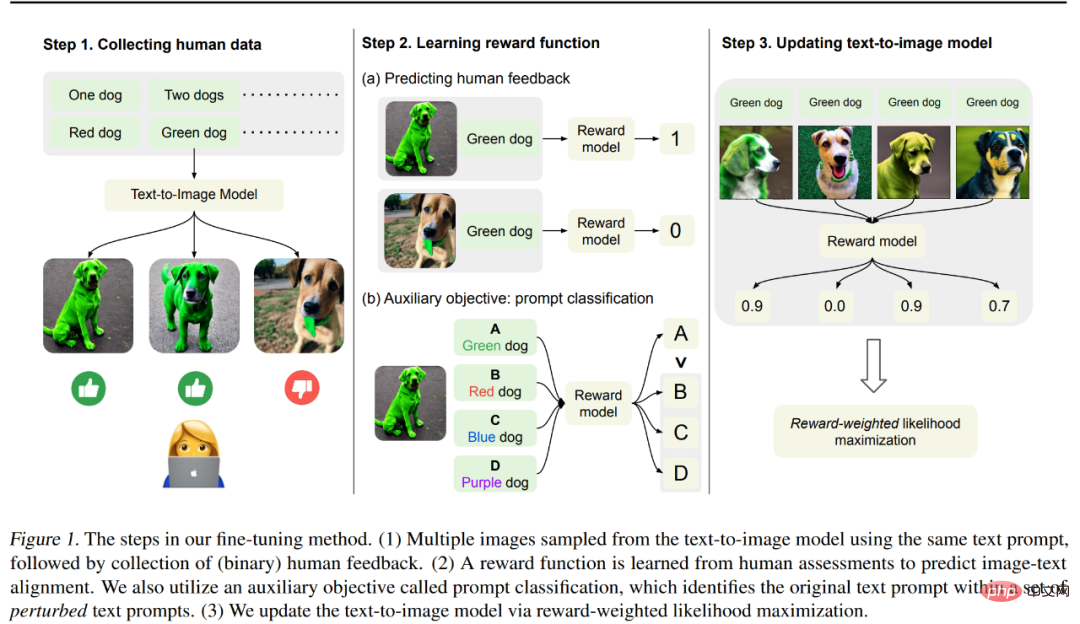

La méthode de cet article est présentée dans la figure 1 ci-dessous, qui est principalement divisée en 3 mesures.

Étape 1 : Générez d'abord différentes images à partir d'un ensemble d'invites de texte "conçues pour tester l'alignement du texte sur la sortie du modèle d'image". Plus précisément, examinez les invites du modèle pré-entraîné les plus sujettes aux erreurs : générer des objets avec une couleur, un nombre et un arrière-plan spécifiques, puis collecter des commentaires humains binaires utilisés pour évaluer la sortie du modèle.

Étape 2 : À l'aide d'un ensemble de données étiquetées par des humains, entraînez une fonction de récompense pour prédire les commentaires humains à partir d'invites d'images et de texte. Nous proposons une tâche auxiliaire pour identifier les invites textuelles originales parmi un ensemble d’invites textuelles perturbées afin d’utiliser plus efficacement les commentaires humains pour l’apprentissage par récompense. Cette technique améliore la généralisation de la fonction de récompense aux images et aux invites textuelles invisibles.

Étape 3 : Mettez à jour le modèle texte-image via une maximisation de la probabilité pondérée par les récompenses pour mieux l'aligner sur les commentaires humains. Contrairement aux travaux précédents qui utilisaient l’apprentissage par renforcement pour l’optimisation, les chercheurs ont utilisé l’apprentissage semi-supervisé pour mettre à jour le modèle afin de mesurer la qualité du résultat du modèle, qui est la fonction de récompense apprise.

Les chercheurs ont utilisé 27 000 paires image-texte avec des commentaires humains pour affiner le modèle de diffusion stable. Les résultats ont montré que le modèle affiné a permis d'obtenir des améliorations significatives dans la génération d'objets avec des couleurs, des quantités et des quantités spécifiques. et les arrière-plans. Amélioration jusqu'à 47 % de l'alignement image-texte avec une légère perte de fidélité de l'image.

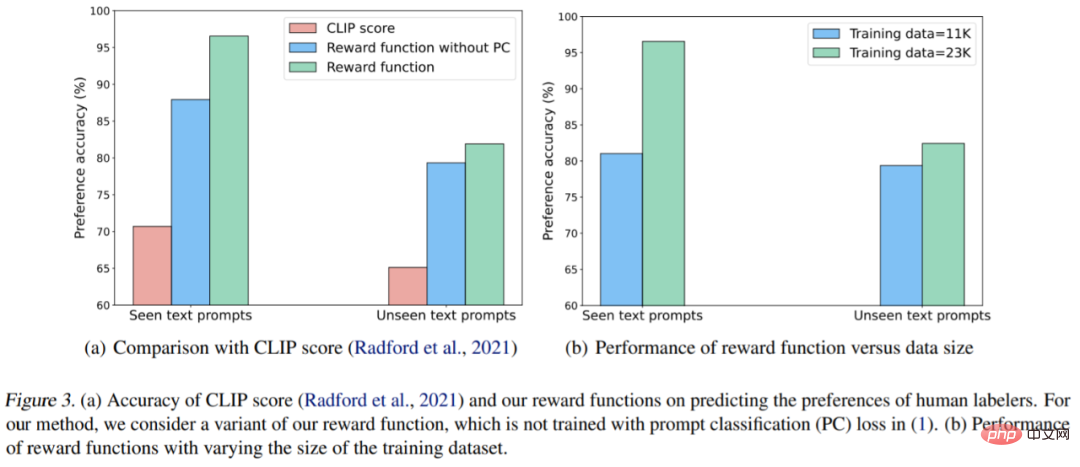

De plus, les résultats de génération combinée ont été améliorés pour mieux générer des objets invisibles grâce à une combinaison d'invites de couleur, de quantité et d'arrière-plan invisibles. Ils ont également observé que la fonction de récompense apprise correspondait mieux aux évaluations humaines de l’alignement que les scores CLIP sur les invites textuelles du test.

Cependant, Kimin Lee, le premier auteur de l'article, a également déclaré que les résultats de cet article n'ont pas résolu tous les modèles d'échec du modèle texte-image existant et qu'il reste encore de nombreux défis. Ils espèrent que ce travail mettra en évidence le potentiel de l’apprentissage à partir de la rétroaction humaine dans l’alignement des modèles de graphes Vincent.

Introduction à la méthode

Afin d'aligner l'image générée avec l'invite de texte, cette étude a effectué une série de réglages fins sur le modèle pré-entraîné, et le processus est illustré dans la figure 1 ci-dessus. Tout d'abord, les images correspondantes ont été générées à partir d'un ensemble d'invites textuelles, un processus conçu pour tester diverses performances du modèle graphique vincentien ; puis des évaluateurs humains ont fourni un retour binaire sur ces images générées. Ensuite, l'étude a formé un modèle de récompense pour prédire le retour humain ; des invites de texte et des images en entrée ; enfin, l'étude utilise la log-vraisemblance pondérée en fonction des récompenses pour affiner le modèle de graphique de Vincent afin d'améliorer l'alignement texte-image.

Collecte de données humaines

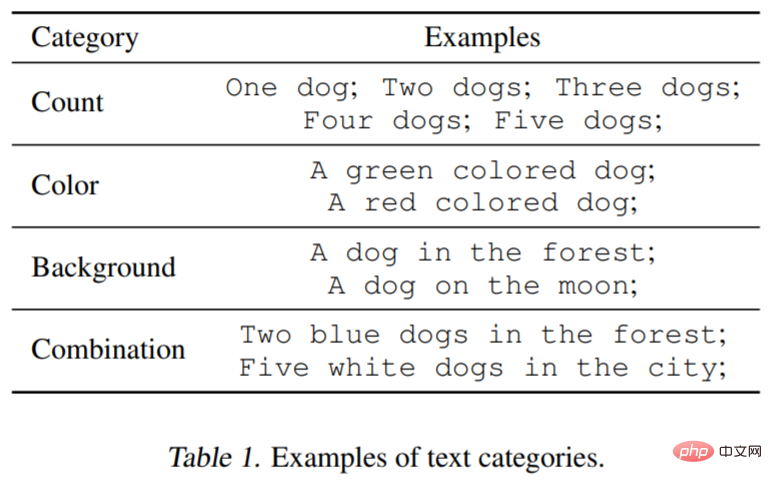

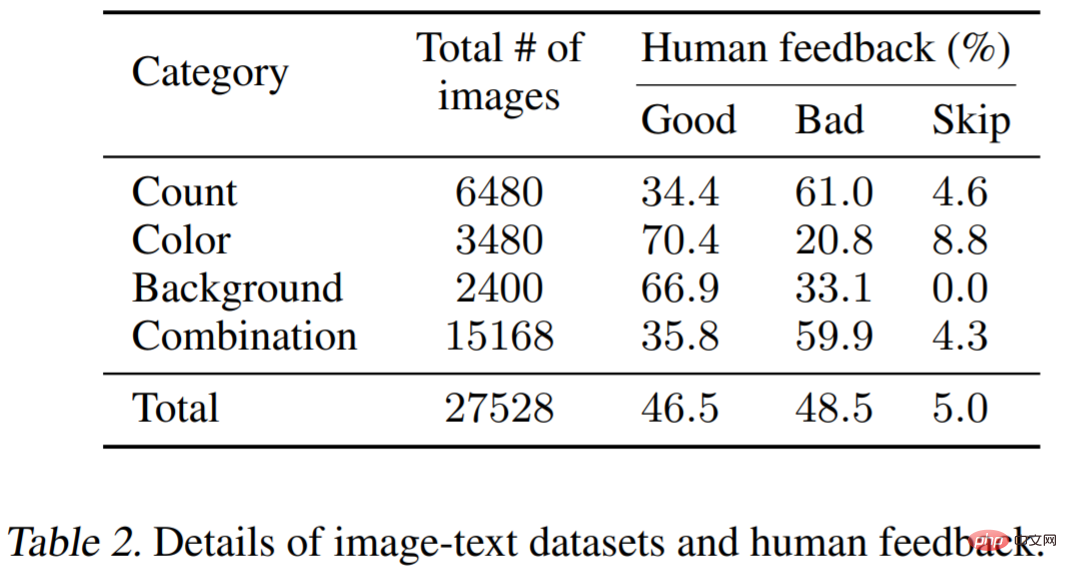

Pour tester la fonctionnalité du modèle de graphique vincentien, l'étude a considéré trois types d'invites textuelles : le nombre spécifié, la couleur et l'arrière-plan. Pour chaque catégorie, l'étude a généré des invites en associant chaque mot ou expression décrivant l'objet, comme le vert (couleur) avec un chien (quantité). De plus, l’étude a examiné des combinaisons de trois catégories (par exemple, deux chiens teints en vert dans une ville). Le tableau 1 ci-dessous illustre mieux la classification des ensembles de données. Chaque invite sera utilisée pour générer 60 images, et le modèle est principalement Stable Diffusion v1.5.

Commentaires humains

Vient ensuite les commentaires humains sur les images générées. Trois images générées par la même invite seront présentées aux étiqueteurs, et il leur sera demandé d'évaluer si chaque image générée est cohérente avec l'invite, et les critères d'évaluation seront bons ou mauvais. Cette tâche étant relativement simple, une rétroaction binaire suffira.

Reward Learning

Pour mieux évaluer l'alignement image-texte, cette étude utilise une fonction de récompense  pour le mesurer, qui peut mapper l'intégration CLIP de l'image x et de l'invite de texte z à la norme ampleur. Il est ensuite utilisé pour prédire le feedback humain k_y ∈ {0, 1} (1 = bon, 0 = mauvais).

pour le mesurer, qui peut mapper l'intégration CLIP de l'image x et de l'invite de texte z à la norme ampleur. Il est ensuite utilisé pour prédire le feedback humain k_y ∈ {0, 1} (1 = bon, 0 = mauvais).

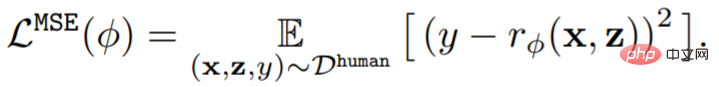

Formellement parlant, étant donné l'ensemble de données de rétroaction humaine D^human = {(x, z, y)}, la fonction de récompense  est entraînée en minimisant l'erreur quadratique moyenne (MSE) :

est entraînée en minimisant l'erreur quadratique moyenne (MSE) :

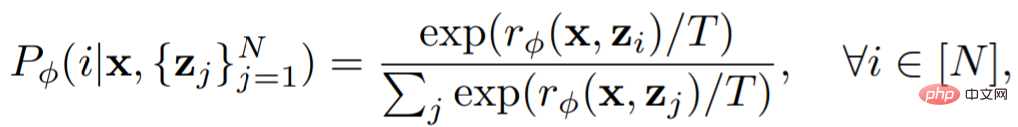

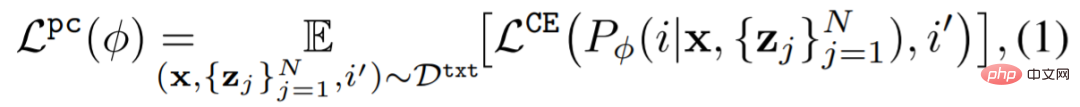

Des études précédentes ont montré que les méthodes d'augmentation des données peuvent améliorer considérablement l'efficacité des données et les performances d'apprentissage des modèles. Afin d'utiliser efficacement les ensembles de données de rétroaction, cette étude a conçu un schéma simple d'augmentation des données et récompense la perte auxiliaire d'apprentissage. Cette étude utilise des invites améliorées dans une tâche auxiliaire, c'est-à-dire que l'apprentissage des récompenses de classification est effectué sur les invites d'origine. Le classificateur Prompt utilise une fonction de récompense comme suit :

La perte auxiliaire est :

Enfin, le modèle graphique Vincent est mis à jour. Étant donné que la diversité de l'ensemble de données généré par le modèle est limitée, cela peut conduire à un surajustement. Pour atténuer cela, l'étude a également minimisé la perte avant l'entraînement comme suit :

Résultats expérimentaux

La partie expérimentale est conçue pour tester l'efficacité du feedback humain participant à la mise au point du modèle. Le modèle utilisé dans l'expérience est Stable Diffusion v1.5 ; les informations sur l'ensemble de données sont présentées dans le tableau 1 (voir ci-dessus) et le tableau 2. Le tableau 2 montre la distribution des commentaires fournis par plusieurs étiqueteurs humains.

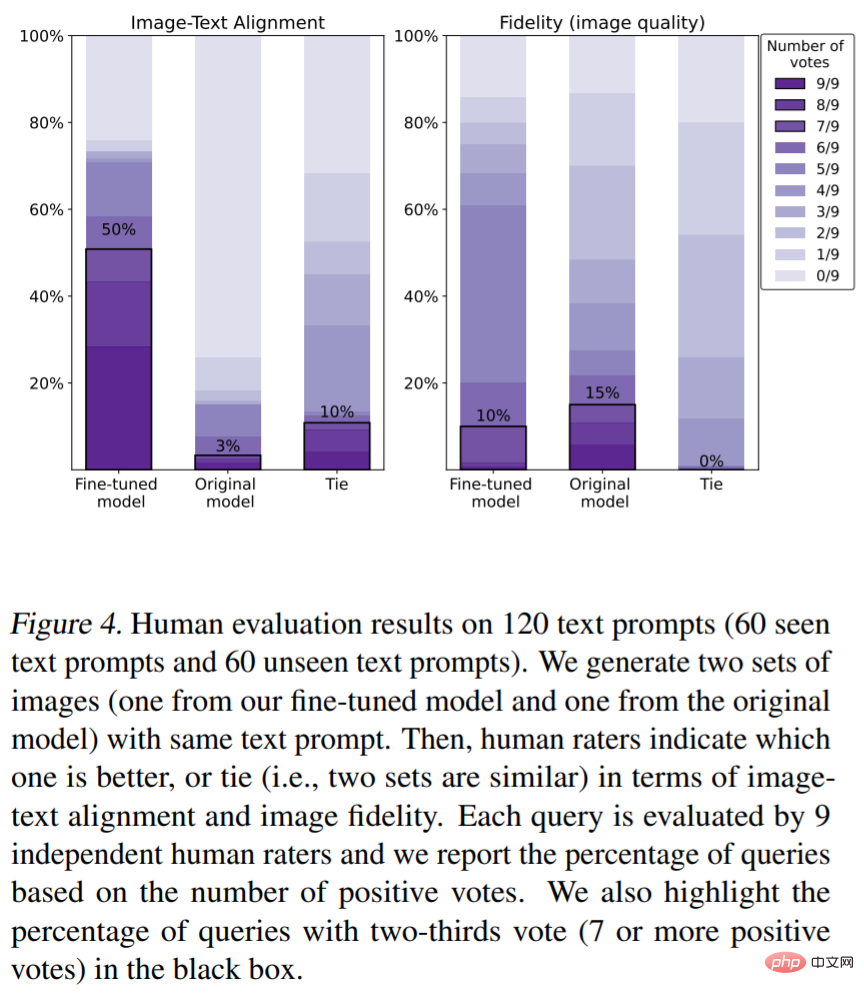

Évaluations humaines de l'alignement texte-image (les mesures d'évaluation sont la couleur, le nombre d'objets). Comme le montre la figure 4, notre méthode a considérablement amélioré l'alignement image-texte. Plus précisément, 50 % des échantillons générés par le modèle ont reçu au moins les deux tiers des votes favorables (le nombre de votes était de 7 votes favorables ou plus). . votes), cependant, le réglage fin réduit légèrement la fidélité de l'image (15 % contre 10 %).

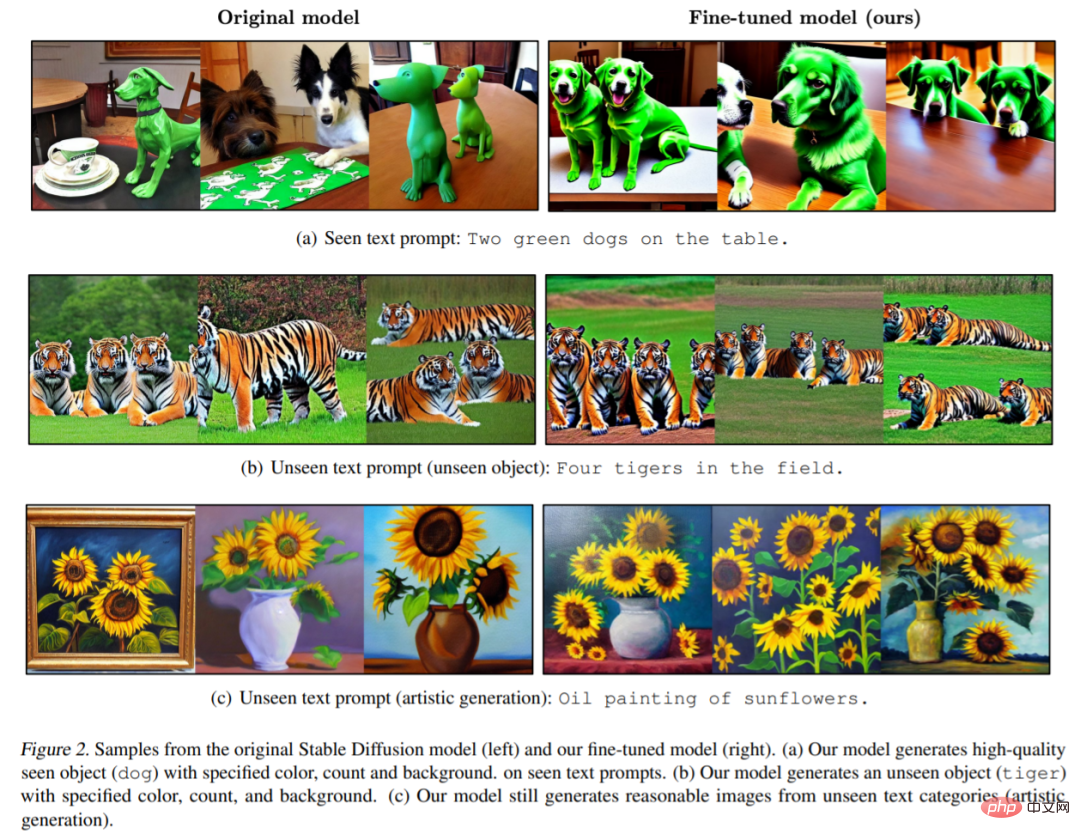

La figure 2 montre des exemples d'images du modèle original et du modèle correspondant affiné de ce document. On peut voir que le modèle d'origine a généré des images qui manquaient de détails (tels que la couleur, l'arrière-plan ou le nombre) (Figure 2 (a)) et que l'image générée par notre modèle est conforme à la couleur, au nombre et à l'arrière-plan spécifiés par l'invite. . Il convient de noter que le modèle présenté dans cet article peut également générer des images d'invite de texte invisibles de très haute qualité (Figure 2 (b)).

Récompensez les résultats d'apprentissage. La figure 3 (a) montre les scores du modèle dans les invites textuelles vues et invisibles. Avoir des récompenses (vert) est plus cohérent avec les intentions humaines typiques que les scores CLIP (rouge).

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Une plongée approfondie dans les modèles, les données et les frameworks : une revue exhaustive de 54 pages de grands modèles de langage efficaces

Jan 14, 2024 pm 07:48 PM

Une plongée approfondie dans les modèles, les données et les frameworks : une revue exhaustive de 54 pages de grands modèles de langage efficaces

Jan 14, 2024 pm 07:48 PM

Les modèles linguistiques à grande échelle (LLM) ont démontré des capacités convaincantes dans de nombreuses tâches importantes, notamment la compréhension du langage naturel, la génération de langages et le raisonnement complexe, et ont eu un impact profond sur la société. Cependant, ces capacités exceptionnelles nécessitent des ressources de formation importantes (illustrées dans l’image de gauche) et de longs temps d’inférence (illustrés dans l’image de droite). Les chercheurs doivent donc développer des moyens techniques efficaces pour résoudre leurs problèmes d’efficacité. De plus, comme on peut le voir sur le côté droit de la figure, certains LLM (LanguageModels) efficaces tels que Mistral-7B ont été utilisés avec succès dans la conception et le déploiement de LLM. Ces LLM efficaces peuvent réduire considérablement la mémoire d'inférence tout en conservant une précision similaire à celle du LLaMA1-33B

Le papier Stable Diffusion 3 est enfin publié, et les détails architecturaux sont révélés. Cela aidera-t-il à reproduire Sora ?

Mar 06, 2024 pm 05:34 PM

Le papier Stable Diffusion 3 est enfin publié, et les détails architecturaux sont révélés. Cela aidera-t-il à reproduire Sora ?

Mar 06, 2024 pm 05:34 PM

L'article de StableDiffusion3 est enfin là ! Ce modèle est sorti il y a deux semaines et utilise la même architecture DiT (DiffusionTransformer) que Sora. Il a fait beaucoup de bruit dès sa sortie. Par rapport à la version précédente, la qualité des images générées par StableDiffusion3 a été considérablement améliorée. Il prend désormais en charge les invites multithèmes, et l'effet d'écriture de texte a également été amélioré et les caractères tronqués n'apparaissent plus. StabilityAI a souligné que StableDiffusion3 est une série de modèles avec des tailles de paramètres allant de 800M à 8B. Cette plage de paramètres signifie que le modèle peut être exécuté directement sur de nombreux appareils portables, réduisant ainsi considérablement l'utilisation de l'IA.

Cet article vous suffit pour en savoir plus sur la conduite autonome et la prédiction de trajectoire !

Feb 28, 2024 pm 07:20 PM

Cet article vous suffit pour en savoir plus sur la conduite autonome et la prédiction de trajectoire !

Feb 28, 2024 pm 07:20 PM

La prédiction de trajectoire joue un rôle important dans la conduite autonome. La prédiction de trajectoire de conduite autonome fait référence à la prédiction de la trajectoire de conduite future du véhicule en analysant diverses données pendant le processus de conduite du véhicule. En tant que module central de la conduite autonome, la qualité de la prédiction de trajectoire est cruciale pour le contrôle de la planification en aval. La tâche de prédiction de trajectoire dispose d'une riche pile technologique et nécessite une connaissance de la perception dynamique/statique de la conduite autonome, des cartes de haute précision, des lignes de voie, des compétences en architecture de réseau neuronal (CNN&GNN&Transformer), etc. Il est très difficile de démarrer ! De nombreux fans espèrent se lancer dans la prédiction de trajectoire le plus tôt possible et éviter les pièges. Aujourd'hui, je vais faire le point sur quelques problèmes courants et des méthodes d'apprentissage introductives pour la prédiction de trajectoire ! Connaissances introductives 1. Existe-t-il un ordre d'entrée pour les épreuves de prévisualisation ? R : Regardez d’abord l’enquête, p

DualBEV : dépassant largement BEVFormer et BEVDet4D, ouvrez le livre !

Mar 21, 2024 pm 05:21 PM

DualBEV : dépassant largement BEVFormer et BEVDet4D, ouvrez le livre !

Mar 21, 2024 pm 05:21 PM

Cet article explore le problème de la détection précise d'objets sous différents angles de vue (tels que la perspective et la vue à vol d'oiseau) dans la conduite autonome, en particulier comment transformer efficacement les caractéristiques de l'espace en perspective (PV) en vue à vol d'oiseau (BEV). implémenté via le module Visual Transformation (VT). Les méthodes existantes sont globalement divisées en deux stratégies : la conversion 2D en 3D et la conversion 3D en 2D. Les méthodes 2D vers 3D améliorent les caractéristiques 2D denses en prédisant les probabilités de profondeur, mais l'incertitude inhérente aux prévisions de profondeur, en particulier dans les régions éloignées, peut introduire des inexactitudes. Alors que les méthodes 3D vers 2D utilisent généralement des requêtes 3D pour échantillonner des fonctionnalités 2D et apprendre les poids d'attention de la correspondance entre les fonctionnalités 3D et 2D via un transformateur, ce qui augmente le temps de calcul et de déploiement.

Le premier modèle mondial de génération de vidéos de scènes de conduite autonomes multi-vues DrivingDiffusion : nouvelles idées pour les données et la simulation BEV

Oct 23, 2023 am 11:13 AM

Le premier modèle mondial de génération de vidéos de scènes de conduite autonomes multi-vues DrivingDiffusion : nouvelles idées pour les données et la simulation BEV

Oct 23, 2023 am 11:13 AM

Quelques réflexions personnelles de l'auteur Dans le domaine de la conduite autonome, avec le développement de sous-tâches/solutions de bout en bout basées sur BEV, les données d'entraînement multi-vues de haute qualité et la construction de scènes de simulation correspondantes sont devenues de plus en plus importantes. En réponse aux problèmes des tâches actuelles, la « haute qualité » peut être divisée en trois aspects : des scénarios à longue traîne dans différentes dimensions : comme les véhicules à courte portée dans les données sur les obstacles et les angles de cap précis lors du découpage des voitures, et les données sur les lignes de voie. . Scènes telles que des courbes avec des courbures différentes ou des rampes/fusions/fusions difficiles à capturer. Celles-ci reposent souvent sur de grandes quantités de données collectées et sur des stratégies complexes d’exploration de données, qui sont coûteuses. Valeur réelle 3D - image hautement cohérente : l'acquisition actuelle des données BEV est souvent affectée par des erreurs d'installation/calibrage du capteur, des cartes de haute précision et l'algorithme de reconstruction lui-même. cela m'a amené à

'Minecraft' se transforme en une ville IA et les habitants des PNJ jouent comme de vraies personnes

Jan 02, 2024 pm 06:25 PM

'Minecraft' se transforme en une ville IA et les habitants des PNJ jouent comme de vraies personnes

Jan 02, 2024 pm 06:25 PM

Veuillez noter que cet homme carré fronça les sourcils, pensant à l'identité des « invités non invités » devant lui. Il s’est avéré qu’elle se trouvait dans une situation dangereuse, et une fois qu’elle s’en est rendu compte, elle a rapidement commencé une recherche mentale pour trouver une stratégie pour résoudre le problème. Finalement, elle a décidé de fuir les lieux, de demander de l'aide le plus rapidement possible et d'agir immédiatement. En même temps, la personne de l'autre côté pensait la même chose qu'elle... Il y avait une telle scène dans "Minecraft" où tous les personnages étaient contrôlés par l'intelligence artificielle. Chacun d’eux a un cadre identitaire unique. Par exemple, la jeune fille mentionnée précédemment est une coursière de 17 ans mais intelligente et courageuse. Ils ont la capacité de se souvenir, de penser et de vivre comme des humains dans cette petite ville de Minecraft. Ce qui les anime est une toute nouvelle,

Adaptateur I2V de la communauté SD : aucune configuration requise, plug and play, parfaitement compatible avec le plug-in vidéo Tusheng

Jan 15, 2024 pm 07:48 PM

Adaptateur I2V de la communauté SD : aucune configuration requise, plug and play, parfaitement compatible avec le plug-in vidéo Tusheng

Jan 15, 2024 pm 07:48 PM

La tâche de génération d'image en vidéo (I2V) est un défi dans le domaine de la vision par ordinateur qui vise à convertir des images statiques en vidéos dynamiques. La difficulté de cette tâche est d'extraire et de générer des informations dynamiques dans la dimension temporelle à partir d'une seule image tout en conservant l'authenticité et la cohérence visuelle du contenu de l'image. Les méthodes I2V existantes nécessitent souvent des architectures de modèles complexes et de grandes quantités de données de formation pour atteindre cet objectif. Récemment, un nouveau résultat de recherche « I2V-Adapter : AGeneralImage-to-VideoAdapter for VideoDiffusionModels » dirigé par Kuaishou a été publié. Cette recherche introduit une méthode innovante de conversion image-vidéo et propose un module adaptateur léger, c'est-à-dire

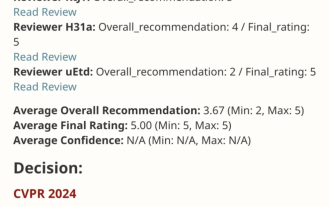

Papier de score parfait VPR 2024 ! Meta propose EfficientSAM : divisez tout rapidement !

Mar 02, 2024 am 10:10 AM

Papier de score parfait VPR 2024 ! Meta propose EfficientSAM : divisez tout rapidement !

Mar 02, 2024 am 10:10 AM

Ce travail d'EfficientSAM a été inclus dans le CVPR2024 avec une note parfaite de 5/5/5 ! L'auteur a partagé le résultat sur les réseaux sociaux, comme le montre l'image ci-dessous : Le lauréat du prix LeCun Turing a également fortement recommandé ce travail ! Dans des recherches récentes, les chercheurs de Meta ont proposé une nouvelle méthode améliorée, à savoir le pré-entraînement d'image de masque (SAMI) utilisant SAM. Cette méthode combine la technologie de pré-entraînement MAE et les modèles SAM pour obtenir des encodeurs ViT pré-entraînés de haute qualité. Grâce à SAMI, les chercheurs tentent d'améliorer les performances et l'efficacité du modèle et de proposer de meilleures solutions pour les tâches de vision. La proposition de cette méthode apporte de nouvelles idées et opportunités pour explorer et développer davantage les domaines de la vision par ordinateur et de l’apprentissage profond. en combinant différents