Périphériques technologiques

Périphériques technologiques

IA

IA

La précision de GPT-3 dans la résolution de problèmes mathématiques est passée à 92,5 % ! Microsoft propose MathPrompter pour créer des modèles de langage « scientifiques » sans réglage fin

La précision de GPT-3 dans la résolution de problèmes mathématiques est passée à 92,5 % ! Microsoft propose MathPrompter pour créer des modèles de langage « scientifiques » sans réglage fin

La précision de GPT-3 dans la résolution de problèmes mathématiques est passée à 92,5 % ! Microsoft propose MathPrompter pour créer des modèles de langage « scientifiques » sans réglage fin

Le défaut le plus critiqué des grands modèles de langage, outre de graves absurdités, est probablement leur « incapacité à faire des mathématiques ».

Par exemple, pour un problème mathématique complexe qui nécessite un raisonnement en plusieurs étapes, le modèle de langage est généralement incapable de donner la bonne réponse. Même avec la bénédiction de la technologie de la « chaîne de pensée », des erreurs se produisent souvent. dans les étapes intermédiaires.

Contrairement aux tâches de compréhension du langage naturel dans les arts libéraux, les questions mathématiques n'ont souvent qu'une seule bonne réponse, avec une gamme de réponses moins ouverte, ce qui rend la tâche de génération de solutions précises plus difficile pour les grands modèles de langage.

De plus, lorsqu'il s'agit de problèmes mathématiques, les modèles de langage existants ne fournissent généralement pas de confiance dans leurs réponses, laissant les utilisateurs incapables de juger de la crédibilité des réponses générées.

Afin de résoudre ce problème, Microsoft Research a proposé la technologie MathPrompter, qui peut améliorer les performances du LLM sur les problèmes arithmétiques tout en augmentant son recours à la prédiction.

Lien papier : https://arxiv.org/abs/2303.05398

MathPrompter utilise la technologie d'invite de chaîne de réflexion Zero-shot pour générer plusieurs expressions algébriques ou fonctions Python afin de résoudre les mêmes problèmes mathématiques de différentes manières. , améliorant ainsi la crédibilité des résultats.

Par rapport à d'autres méthodes CoT basées sur des indices, MathPrompter vérifie également la validité des étapes intermédiaires.

Basé sur le paramètre GPT 175B, en utilisant la méthode MathPrompter pour augmenter la précision de l'ensemble de données MultiArith de 78,7 % à 92,5 % !

Prompt spécialisé en mathématiques

Ces dernières années, le développement du traitement du langage naturel est en grande partie dû à l'expansion continue de l'échelle des grands modèles de langage (LLM), qui ont démontré d'étonnantes capacités de tir zéro et peu de tirs a également contribué au développement de la technologie d'invite. Les utilisateurs n'ont besoin que de saisir quelques échantillons simples dans LLM pour prédire de nouvelles tâches.

prompt peut être considéré comme assez efficace pour les tâches en une seule étape, mais dans les tâches nécessitant un raisonnement en plusieurs étapes, les performances de la technologie prompte sont encore insuffisantes.

Lorsque les humains résolvent un problème complexe, ils le décomposent et tentent de le résoudre étape par étape. La technologie d'invite « Chaîne de pensée » (CoT) étend cette intuition aux LLM, dans une série de tâches qui nécessitent un raisonnement. Des améliorations des performances ont été obtenues dans les tâches PNL.

Cet article étudie principalement la méthode Zero-shot-CoT « pour résoudre des tâches de raisonnement mathématique ». Des travaux antérieurs ont permis d'améliorer considérablement la précision de l'ensemble de données MultiArith, de 17,7 % à 78,7 %. :

1. Bien que la chaîne de réflexion suivie par le modèle améliore les résultats, il ne vérifie pas l'efficacité de chaque étape suivie par les invites de la chaîne de réflexion

2, ne fournit pas de confiance pour les résultats de prédiction du LLM ; .

MathPrompter

Pour combler ces lacunes dans une certaine mesure, les chercheurs s'inspirent de « la façon dont les humains résolvent les problèmes mathématiques », décomposant les problèmes complexes en procédures plus simples en plusieurs étapes et utilisant plusieurs méthodes pour résoudre chaque problème. la méthode en une seule étape.

Étant donné que LLM est un modèle génératif, il devient très délicat de garantir que les réponses générées sont exactes, en particulier pour les tâches de raisonnement mathématique.

Les chercheurs ont observé le processus par lequel les élèves résolvent des problèmes arithmétiques et ont résumé plusieurs étapes suivies par les élèves pour vérifier leurs solutions :

Conformité aux résultats connus En comparant la solution avec les résultats connus, vous pouvez évaluer son exactitude et effectuer les ajustements nécessaires ; lorsque le problème est un problème standard avec une solution mature, cela est particulièrement utile. La

Multi-vérification, en abordant le problème sous plusieurs angles et en comparant les résultats, permet de confirmer l'efficacité de la solution et garantit qu'elle est à la fois raisonnable et précise.

Vérification croisée, le processus de résolution du problème est aussi nécessaire que la réponse finale ; vérifier l'exactitude des étapes intermédiaires du processus peut fournir une compréhension claire du processus de réflexion derrière la solution.

La vérification informatique, l'utilisation d'une calculatrice ou d'un ordinateur pour effectuer des calculs arithmétiques peut aider à vérifier l'exactitude de la réponse finale

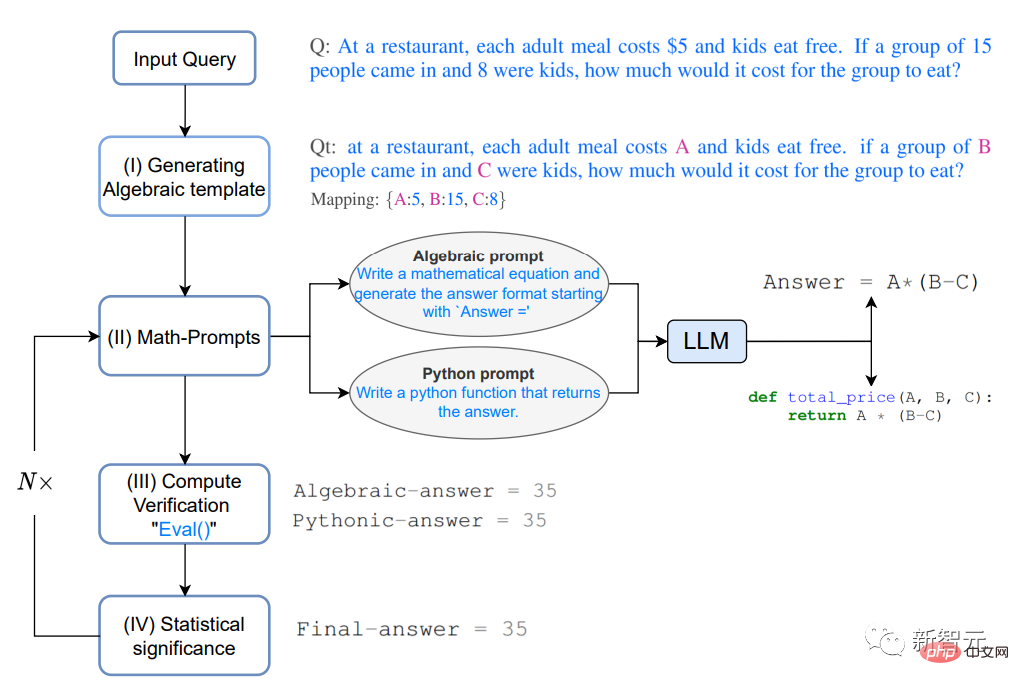

Plus précisément, étant donné une question Q,

Dans un restaurant, le prix de chaque repas adulte est de 5 $ et les enfants mangent gratuitement. Si 15 personnes entrent et que 8 d’entre elles sont des enfants, combien cela coûte-t-il de manger pour ce groupe de personnes ?

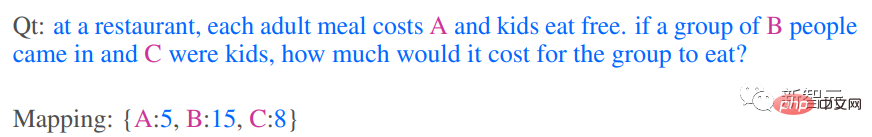

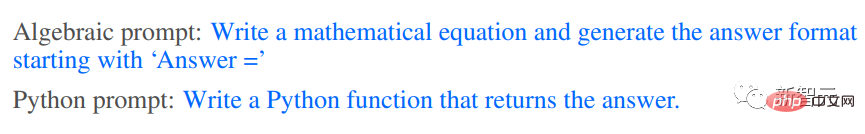

1. Génération d'un modèle algébrique

Convertissez d'abord le problème sous forme algébrique, en utilisant le mappage clé-valeur pour remplacer les éléments numériques par des variables, puis obtenez le problème modifié Qt

2. Invites mathématiques

Sur la base de l'intuition fournie par le processus de réflexion ci-dessus de validation multiple et de vérification croisée, deux méthodes différentes sont utilisées pour générer des solutions d'analyse pour Qt, à savoir algébriquement et Pythoniquement, LLM reçoit les astuces suivantes pour générer un contexte supplémentaire pour Qt.

L'invite peut être "Dériver une expression algébrique" ou "Écrire une fonction Python"

Le modèle LLM peut générer l'expression suivante après avoir répondu à l'invite.

Le plan d'analyse généré ci-dessus fournit aux utilisateurs des conseils sur le "processus de réflexion intermédiaire" du LLM. L'ajout de conseils supplémentaires peut améliorer l'exactitude et la cohérence des résultats, ce qui à son tour améliorera MathPrompter pour générer des résultats plus précis et plus précis. Capacité à apporter des solutions efficaces.

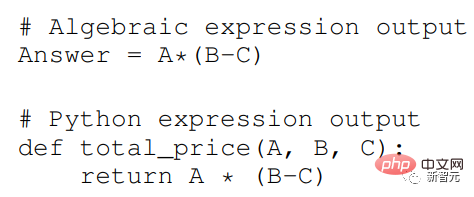

3. Vérification du calcul

Utilisez plusieurs cartes clé-valeur aléatoires de variables d'entrée dans Qt pour évaluer les expressions générées à l'étape précédente et utilisez la méthode eval() de Python pour évaluer ces expressions. une évaluation.

Comparez ensuite les résultats pour voir si vous pouvez trouver un consensus dans la réponse, ce qui peut également fournir une plus grande confiance dans le fait que la réponse est correcte et fiable.

Une fois l'expression convenue sur la sortie, utilisez les valeurs des variables dans l'entrée Q pour calculer la réponse finale.

4. Signification statistique

Pour garantir un consensus dans la sortie de diverses expressions, répétez les étapes 2 et 3 environ 5 fois dans l'expérience et signalez l'occurrence observée des valeurs de réponse les plus fréquentes.

En l'absence de consensus clair, répétez les étapes 2, 3 et 4.

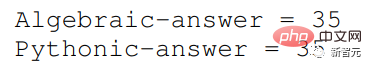

Résultats expérimentaux

Évaluez MathPrompter sur l'ensemble de données MultiArith. Les questions mathématiques qu'il contient sont spécifiquement utilisées pour tester la capacité du modèle d'apprentissage automatique à effectuer des opérations et des raisonnements arithmétiques complexes. raisonnement logique pour réussir à résoudre.

Les résultats de précision sur l'ensemble de données MultiArith montrent que MathPrompter surpasse toutes les lignes de base Zero-shot et Zero-shot-CoT, augmentant la précision de 78,7% à 92,5%

On peut voir que les performances du modèle MathPrompter basé sur le paramètre 175B GPT3 DaVinci sont comparables au modèle de paramètre 540B et à la méthode Few-shot-CoT de SOTA.

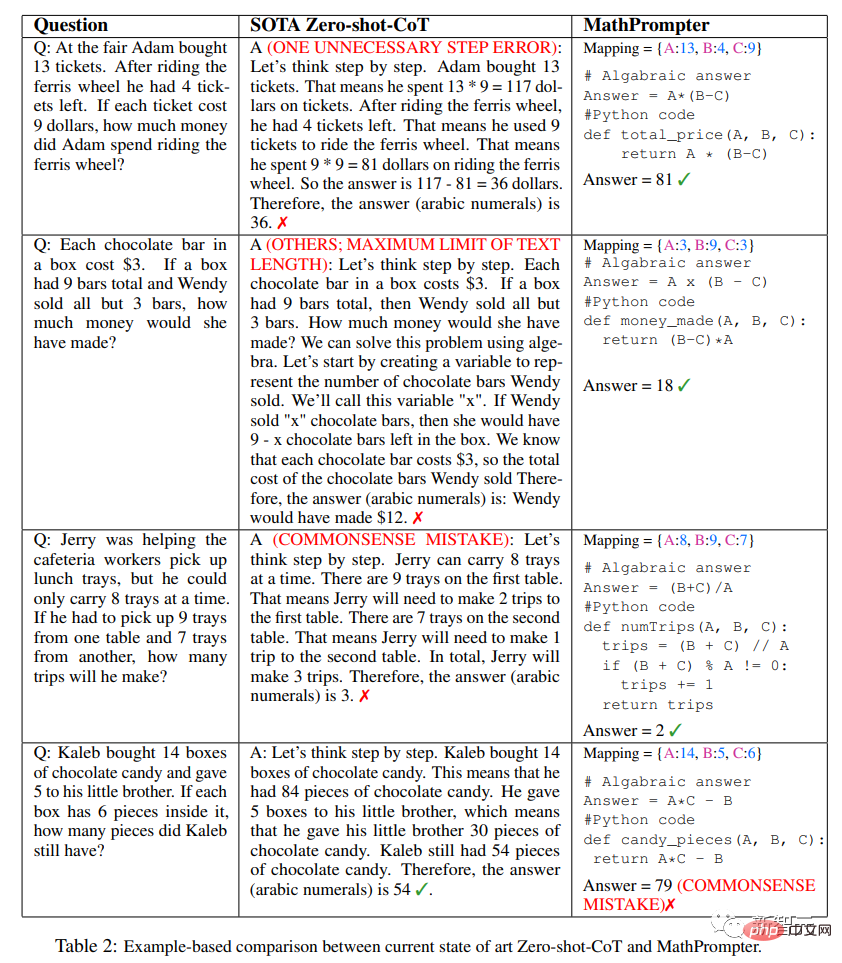

Comme vous pouvez le voir dans le tableau ci-dessus, la conception de MathPrompter peut compenser des problèmes tels que "les réponses générées ont parfois une différence d'un cran", qui peuvent être évitées en exécutant le modèle plusieurs fois. et rendre compte des résultats du consensus.

De plus, le problème selon lequel l'étape d'inférence peut être trop longue peut être résolu par des méthodes pythoniques ou algébriques, qui nécessitent généralement moins de jetons

De plus, l'étape d'inférence peut être correcte, mais le résultat final du calcul n'est pas incorrect, MathPrompter résout ce problème en utilisant la fonction de méthode eval() de Python.

Dans la plupart des cas, MathPrompter peut générer des réponses intermédiaires et finales correctes, mais il existe quelques cas, comme la dernière question du tableau, où les résultats algébriques et pythoniques sont cohérents, mais il y a des erreurs.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

Le DALL-E 3 a été officiellement introduit en septembre 2023 en tant que modèle considérablement amélioré par rapport à son prédécesseur. Il est considéré comme l’un des meilleurs générateurs d’images IA à ce jour, capable de créer des images avec des détails complexes. Cependant, au lancement, c'était exclu

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L’IA change effectivement les mathématiques. Récemment, Tao Zhexuan, qui a prêté une attention particulière à cette question, a transmis le dernier numéro du « Bulletin de l'American Mathematical Society » (Bulletin de l'American Mathematical Society). En se concentrant sur le thème « Les machines changeront-elles les mathématiques ? », de nombreux mathématiciens ont exprimé leurs opinions. L'ensemble du processus a été plein d'étincelles, intense et passionnant. L'auteur dispose d'une équipe solide, comprenant Akshay Venkatesh, lauréat de la médaille Fields, le mathématicien chinois Zheng Lejun, l'informaticien de l'Université de New York Ernest Davis et de nombreux autres universitaires bien connus du secteur. Le monde de l’IA a radicalement changé. Vous savez, bon nombre de ces articles ont été soumis il y a un an.

La combinaison parfaite de ChatGPT et Python : créer un chatbot de service client intelligent

Oct 27, 2023 pm 06:00 PM

La combinaison parfaite de ChatGPT et Python : créer un chatbot de service client intelligent

Oct 27, 2023 pm 06:00 PM

La combinaison parfaite de ChatGPT et Python : Création d'un chatbot de service client intelligent Introduction : À l'ère de l'information d'aujourd'hui, les systèmes de service client intelligents sont devenus un outil de communication important entre les entreprises et les clients. Afin d'offrir une meilleure expérience de service client, de nombreuses entreprises ont commencé à se tourner vers les chatbots pour effectuer des tâches telles que la consultation des clients et la réponse aux questions. Dans cet article, nous présenterons comment utiliser le puissant modèle ChatGPT et le langage Python d'OpenAI pour créer un chatbot de service client intelligent afin d'améliorer

Comment installer chatgpt sur un téléphone mobile

Mar 05, 2024 pm 02:31 PM

Comment installer chatgpt sur un téléphone mobile

Mar 05, 2024 pm 02:31 PM

Étapes d'installation : 1. Téléchargez le logiciel ChatGTP depuis le site officiel ou la boutique mobile de ChatGTP ; 2. Après l'avoir ouvert, dans l'interface des paramètres, sélectionnez la langue chinoise 3. Dans l'interface de jeu, sélectionnez le jeu homme-machine et définissez la langue. Spectre chinois ; 4. Après avoir démarré, entrez les commandes dans la fenêtre de discussion pour interagir avec le logiciel.

Comment développer un chatbot intelligent en utilisant ChatGPT et Java

Oct 28, 2023 am 08:54 AM

Comment développer un chatbot intelligent en utilisant ChatGPT et Java

Oct 28, 2023 am 08:54 AM

Dans cet article, nous présenterons comment développer des chatbots intelligents à l'aide de ChatGPT et Java, et fournirons quelques exemples de code spécifiques. ChatGPT est la dernière version du Generative Pre-training Transformer développé par OpenAI, une technologie d'intelligence artificielle basée sur un réseau neuronal qui peut comprendre le langage naturel et générer du texte de type humain. En utilisant ChatGPT, nous pouvons facilement créer des discussions adaptatives

Chatgpt peut-il être utilisé en Chine ?

Mar 05, 2024 pm 03:05 PM

Chatgpt peut-il être utilisé en Chine ?

Mar 05, 2024 pm 03:05 PM

chatgpt peut être utilisé en Chine, mais ne peut pas être enregistré, ni à Hong Kong et Macao. Si les utilisateurs souhaitent s'inscrire, ils peuvent utiliser un numéro de téléphone mobile étranger pour s'inscrire. Notez que lors du processus d'enregistrement, l'environnement réseau doit être basculé vers. une adresse IP étrangère.

Comment utiliser ChatGPT et Python pour implémenter la fonction de reconnaissance des intentions de l'utilisateur

Oct 27, 2023 am 09:04 AM

Comment utiliser ChatGPT et Python pour implémenter la fonction de reconnaissance des intentions de l'utilisateur

Oct 27, 2023 am 09:04 AM

Comment utiliser ChatGPT et Python pour implémenter la fonction de reconnaissance des intentions des utilisateurs Introduction : À l'ère numérique d'aujourd'hui, la technologie de l'intelligence artificielle est progressivement devenue un élément indispensable dans divers domaines. Parmi eux, le développement de la technologie de traitement du langage naturel (Natural Language Processing, NLP) permet aux machines de comprendre et de traiter le langage humain. ChatGPT (Chat-GeneratingPretrainedTransformer) est une sorte de

Comment créer un robot de service client intelligent en utilisant ChatGPT PHP

Oct 28, 2023 am 09:34 AM

Comment créer un robot de service client intelligent en utilisant ChatGPT PHP

Oct 28, 2023 am 09:34 AM

Comment utiliser ChatGPTPHP pour créer un robot de service client intelligent Introduction : Avec le développement de la technologie de l'intelligence artificielle, les robots sont de plus en plus utilisés dans le domaine du service client. L'utilisation de ChatGPTPHP pour créer un robot de service client intelligent peut aider les entreprises à fournir des services client plus efficaces et personnalisés. Cet article explique comment utiliser ChatGPTPHP pour créer un robot de service client intelligent et fournit des exemples de code spécifiques. 1. Installez ChatGPTPHP et utilisez ChatGPTPHP pour créer un robot de service client intelligent.