Périphériques technologiques

Périphériques technologiques

IA

IA

Diffusion + détection de cible = génération d'images contrôlable ! L'équipe chinoise a proposé GLIGEN pour contrôler parfaitement la position spatiale des objets

Diffusion + détection de cible = génération d'images contrôlable ! L'équipe chinoise a proposé GLIGEN pour contrôler parfaitement la position spatiale des objets

Diffusion + détection de cible = génération d'images contrôlable ! L'équipe chinoise a proposé GLIGEN pour contrôler parfaitement la position spatiale des objets

Avec l'open source de Stable Diffusion, l'utilisation du langage naturel pour la génération d'images est progressivement devenue populaire, et de nombreux problèmes de l'AIGC ont également été exposés, tels que l'IA ne peut pas dessiner les mains, ne peut pas comprendre les relations d'action et est difficile à contrôler. position des objets, etc.

La raison principale est que "l'interface de saisie" n'a qu'un langage naturel, et ne peut pas obtenir un contrôle précis de l'écran.

Récemment, des centres de recherche de l'Université du Wisconsin-Madison, de l'Université de Columbia et de Microsoft ont proposé une toute nouvelle méthode GLIGEN, qui étend les fonctionnalités du « modèle de diffusion de texte en image pré-entraîné » existant basé sur une entrée de mise à la terre.

Lien papier : https://arxiv.org/pdf/2301.07093.pdf

Page d'accueil du projet : https://gligen.github.io/

Lien d'expérience : https://huggingface.co/spaces/gligen/demo

Afin de conserver une grande quantité de connaissances conceptuelles du modèle pré-entraîné, les chercheurs n'ont pas choisi d'affiner le modèle , mais a fait passer l'entrée via le mécanisme de déclenchement. Différentes conditions de mise à la terre sont injectées dans de nouvelles couches pouvant être entraînées pour contrôler la génération d'images en monde ouvert.

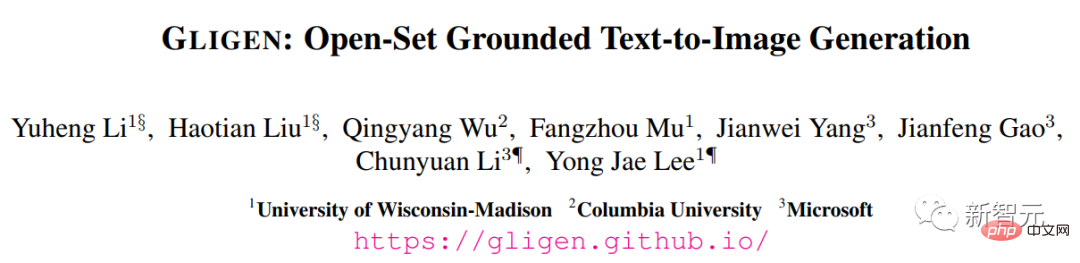

Actuellement, GLIGEN prend en charge quatre entrées.

(en haut à gauche) entité de texte + boîte (en haut à droite) entité d'image + boîte

(en bas à gauche) style d'image + texte + boîte (en bas à droite) entité de texte + clé point

Les résultats expérimentaux montrent également que les performances zéro tir de GLIGEN sur COCO et LVIS sont bien meilleures que la base de référence actuelle de mise en page supervisée en image.

Génération d'images contrôlables

Avant le modèle de diffusion, les réseaux contradictoires génératifs (GAN) ont toujours été le leader dans le domaine de la génération d'images, et leur espace latent et leur entrée conditionnelle ont été entièrement implémentés en termes de « fonctionnement contrôlable » et recherche « génération ».

Les modèles autorégressifs et de diffusion conditionnels de texte affichent une qualité d'image et une couverture conceptuelle étonnantes, grâce à leurs objectifs d'apprentissage plus stables et à leur formation à grande échelle sur les données appariées image-texte du réseau, et sortent rapidement du cercle et deviennent des outils d'aide. en conception et création artistique.

Cependant, les modèles de génération texte-image à grande échelle existants ne peuvent pas être conditionnés à d'autres modes de saisie « que le texte ». Ils n'ont pas la capacité de localiser avec précision des concepts ou d'utiliser des images de référence pour contrôler le processus de génération, ce qui limite l'expression de ceux-ci. information.

Par exemple, il est difficile de décrire l'emplacement précis d'un objet à l'aide de texte, mais des cadres de délimitation (bounding

boxes) ou des points clés (keypoints) peuvent être facilement réalisés.

Certains outils existants tels que l'inpainting, la génération layout2img, etc. peuvent utiliser des entrées modales autres que le texte, mais ces entrées sont rarement combinées pour une génération text2img contrôlable.

De plus, les modèles génératifs précédents sont généralement formés indépendamment sur des ensembles de données spécifiques à une tâche, tandis que dans le domaine de la reconnaissance d'images, le paradigme de longue date consiste à apprendre à partir de « données d'image à grande échelle » ou de « paires image-texte ». " Un modèle de base pré-entraîné commence à construire un modèle pour une tâche spécifique.

Les modèles de diffusion ont été formés sur des milliards de paires image-texte. Une question naturelle est : pouvons-nous nous appuyer sur les modèles de diffusion pré-entraînés existants et leur donner de nouvelles entrées conditionnelles ?

En raison de la grande quantité de connaissances conceptuelles possédées par le modèle pré-entraîné, il peut être possible d'obtenir de meilleures performances sur d'autres tâches de génération tout en gagnant plus de contrôlabilité que les modèles de génération texte-image existants.

GLIGEN

Sur la base des objectifs et des idées ci-dessus, le modèle GLIGEN proposé par les chercheurs conserve toujours le titre du texte en entrée, mais permet également d'autres modalités de saisie, telles que la boîte englobante du concept de mise à la terre, la référence de mise à la terre image et la clé du point de la pièce de mise à la terre.

Le problème clé ici est de conserver une grande quantité de connaissances conceptuelles originales dans le modèle pré-entraîné tout en apprenant à injecter de nouvelles informations de base.

Afin d'éviter l'oubli des connaissances, les chercheurs ont proposé de geler les poids du modèle d'origine et d'ajouter une nouvelle couche de transformateur fermée pouvant être entraînée pour absorber les nouvelles entrées de regroupement. Ce qui suit utilise des cadres de délimitation à titre d'exemple.

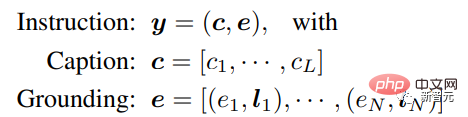

Saisie de commande

Chaque entité de texte de jointoiement est représentée comme une boîte englobante contenant les valeurs de coordonnées du coin supérieur gauche et du coin inférieur droit.

Il convient de noter que les travaux existants liés à layout2img nécessitent généralement un dictionnaire de concepts et ne peuvent gérer que des entités proches (telles que les catégories COCO) pendant la phase d'évaluation. Les informations de positionnement contenues dans l'ensemble de formation peuvent être généralisées à d'autres concepts.

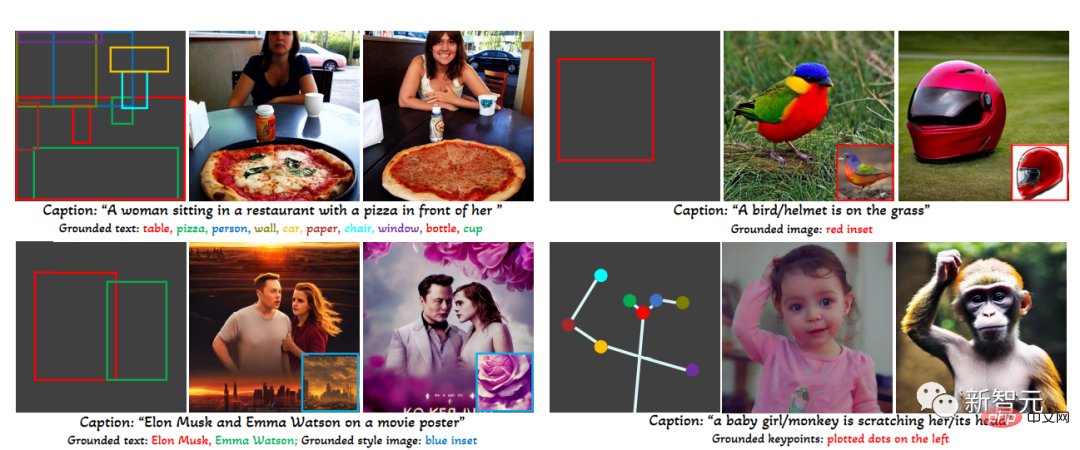

Données d'entraînement

Les données d'entraînement utilisées pour générer des images de base nécessitent le texte c et l'entité de base e comme conditions. En pratique, les contraintes sur les données peuvent être assouplies en envisageant des conditions plus flexibles. entrées Nécessite.

Il existe principalement trois types de données

1. Données de base

Chaque image est associée à un titre qui décrit l'entité nominale; titre et marquez le cadre de délimitation.

Étant donné que les entités nominales sont tirées directement des titres en langage naturel, elles peuvent couvrir un vocabulaire plus riche, ce qui est bénéfique à la génération fondamentale du vocabulaire du monde ouvert.

2. Données de détection Données de détection

L'entité nominale est une catégorie prédéfinie (telle que les 80 catégories d'objets dans COCO), choisissez d'utiliser le jeton de titre vide dans le classificateur. guide gratuit comme titre.

La quantité de données de détection (niveau en millions) est supérieure aux données de base (en milliers de niveaux), de sorte que les données globales d'entraînement peuvent être considérablement augmentées.

3. Données de détection et de légende

L'entité nominale est la même que l'entité nominale dans les données de détection, alors que l'image est décrite avec un titre de texte seul, il peut y avoir des entités nominales et des entités dans le titre Pas tout à fait cohérent.

Par exemple, le titre ne donne qu'une description générale du salon et ne mentionne pas les objets de la scène, tandis que l'annotation de détection fournit des détails plus fins au niveau de l'objet.

Mécanisme d'attention fermée

Les chercheurs visent à donner aux modèles existants de génération d'images et de langage à grande échelle de nouvelles capacités spatiales,

les modèles de diffusion à grande échelle ont des pré- formés sur du texte image à l'échelle du réseau pour obtenir les connaissances nécessaires pour synthétiser des images réalistes basées sur des instructions linguistiques diverses et complexes. Étant donné que la pré-formation est coûteuse, les performances sont également bonnes, tout en développant de nouvelles capacités. le modèle est pondéré afin que les nouveaux modules puissent être adaptés au fil du temps pour s'adapter à de nouvelles capacités.

Pendant le processus de formation, de nouvelles informations de base sont progressivement intégrées dans le modèle pré-entraîné à l'aide d'un mécanisme de déclenchement. Cette conception permet une flexibilité dans le processus d'échantillonnage pendant le processus de génération pour améliorer la qualité et la contrôlabilité.

L'expérience a également prouvé qu'en utilisant le modèle complet (toutes les couches) dans la première moitié de l'étape d'échantillonnage et en utilisant uniquement la couche d'origine (pas de couche de transformateur fermée) dans la seconde moitié, les résultats générés peuvent refléter plus précisément le Conditions de mise à la terre, tout en ayant une qualité d'image supérieure.

Partie expérimentale

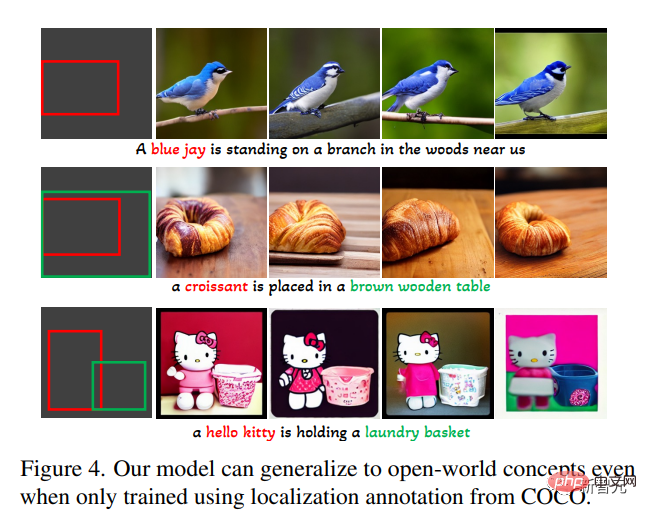

Dans la tâche de génération de texte en image ouverte, utilisez d'abord uniquement les annotations de base de COCO (COCO2014CD) pour la formation et évaluez si GLIGEN peut générer des entités de base autres que la catégorie COCO.

On peut voir que GLIGEN peut apprendre de nouveaux concepts tels que "corbeau bleu", "croissant", ou de nouveaux attributs d'objet tels que "table en bois marron", et cette information n'apparaît pas dans le catégorie de formation intermédiaire.

Les chercheurs pensent que cela est dû au fait que l'auto-attention fermée de GLIGEN a appris à repositionner les caractéristiques visuelles correspondant aux entités ancrées dans le titre pour la couche d'attention croisée suivante, et à cause du texte partagé dans l'espace des deux couches pour acquérir une capacité de généralisation. .

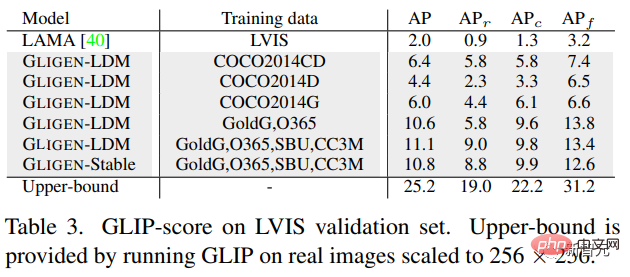

L'expérience a également évalué quantitativement les performances de génération zéro-shot de ce modèle sur LVIS, qui contient 1203 catégories d'objets à longue traîne. Utilisez GLIP pour prédire les cadres de délimitation à partir des images générées et calculer AP, nommé score GLIP ; en le comparant aux modèles de pointe conçus pour la tâche layout2img,

peut être trouvé, bien que le Le modèle GLIGEN est uniquement formé sur les annotations COCO, mais il fonctionne bien mieux que les lignes de base supervisées, probablement parce que les lignes de base formées à partir de zéro ont des difficultés à apprendre à partir d'annotations limitées, tandis que le modèle GLIGEN peut exploiter la vaste connaissance conceptuelle du modèle pré-entraîné.

En général, cet article :

1 propose une nouvelle méthode de génération text2img, qui donne au modèle de diffusion text2img existant une nouvelle contrôlabilité de base

2. ing pré -poids entraînés et apprentissage pour intégrer progressivement de nouvelles couches de positionnement, ce modèle réalise une génération de text2img et une entrée de boîte englobante en monde ouvert, c'est-à-dire qu'il intègre de nouveaux concepts de positionnement non observés lors de la formation

3. les performances sur la tâche layout2img sont nettement meilleures que l'état de l'art précédent, prouvant que de grands modèles génératifs pré-entraînés peuvent améliorer les performances des tâches en aval

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

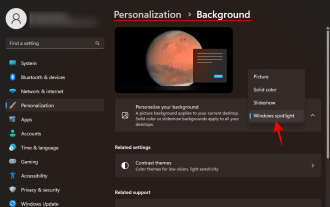

Comment effacer l'historique des images récentes de l'arrière-plan du bureau dans Windows 11

Apr 14, 2023 pm 01:37 PM

Comment effacer l'historique des images récentes de l'arrière-plan du bureau dans Windows 11

Apr 14, 2023 pm 01:37 PM

<p>Windows 11 améliore la personnalisation du système, permettant aux utilisateurs d'afficher un historique récent des modifications précédemment apportées à l'arrière-plan du bureau. Lorsque vous entrez dans la section de personnalisation de l'application Paramètres système Windows, vous pouvez voir diverses options, la modification du fond d'écran en fait partie. Mais vous pouvez maintenant voir le dernier historique des fonds d’écran définis sur votre système. Si vous n'aimez pas voir cela et souhaitez effacer ou supprimer cet historique récent, continuez à lire cet article, qui vous aidera à en savoir plus sur la façon de le faire à l'aide de l'Éditeur du Registre. </p><h2>Comment utiliser la modification du registre

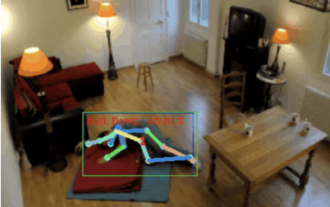

Détection de chute, basée sur la reconnaissance de l'action humaine au point squelettique, une partie du code est complétée avec Chatgpt

Apr 12, 2023 am 08:19 AM

Détection de chute, basée sur la reconnaissance de l'action humaine au point squelettique, une partie du code est complétée avec Chatgpt

Apr 12, 2023 am 08:19 AM

Bonjour à tous. Aujourd'hui j'aimerais partager avec vous un projet de détection de chute, pour être précis, il s'agit de reconnaissance de mouvements humains basée sur des points squelettiques. Il est grossièrement divisé en trois étapes : la reconnaissance du corps humain, le code source du projet de classification des actions des points du squelette humain a été emballé, voir la fin de l'article pour savoir comment l'obtenir. 0. chatgpt Tout d'abord, nous devons obtenir le flux vidéo surveillé. Ce code est relativement fixe. Nous pouvons directement laisser chatgpt compléter le code écrit par chatgpt. Il n'y a aucun problème et peut être utilisé directement. Mais lorsqu'il s'agit de tâches commerciales ultérieures, comme l'utilisation de Mediapipe pour identifier les points du squelette humain, le code fourni par chatgpt est incorrect. Je pense que chatgpt peut être utilisé comme une boîte à outils indépendante de la logique métier. Vous pouvez essayer de le confier à c.

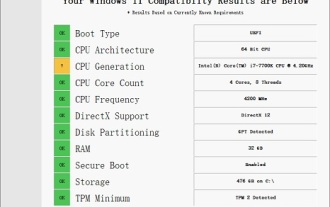

Solution au i7-7700 impossible de passer à Windows 11

Dec 26, 2023 pm 06:52 PM

Solution au i7-7700 impossible de passer à Windows 11

Dec 26, 2023 pm 06:52 PM

Les performances du i77700 sont tout à fait suffisantes pour exécuter Win11, mais les utilisateurs constatent que leur i77700 ne peut pas être mis à niveau vers Win11. Cela est principalement dû aux restrictions imposées par Microsoft, ils peuvent donc l'installer tant qu'ils ignorent cette restriction. Le i77700 ne peut pas être mis à niveau vers win11 : 1. Parce que Microsoft limite la version du processeur. 2. Seules les versions Intel de huitième génération et supérieures peuvent directement passer à Win11. 3. En tant que 7ème génération, i77700 ne peut pas répondre aux besoins de mise à niveau de Win11. 4. Cependant, le i77700 est tout à fait capable d'utiliser Win11 en douceur en termes de performances. 5. Vous pouvez donc utiliser le système d'installation directe win11 de ce site. 6. Une fois le téléchargement terminé, cliquez avec le bouton droit sur le fichier et « chargez-le ». 7. Double-cliquez pour exécuter l'opération "Un clic

Comment télécharger l'image de fond d'écran Windows Spotlight sur PC

Aug 23, 2023 pm 02:06 PM

Comment télécharger l'image de fond d'écran Windows Spotlight sur PC

Aug 23, 2023 pm 02:06 PM

Les fenêtres ne négligent jamais l’esthétique. Des champs verts bucoliques de XP au design tourbillonnant bleu de Windows 11, les fonds d’écran par défaut sont une source de plaisir pour les utilisateurs depuis des années. Avec Windows Spotlight, vous avez désormais un accès direct chaque jour à des images magnifiques et impressionnantes pour votre écran de verrouillage et votre fond d’écran. Malheureusement, ces images ne traînent pas. Si vous êtes tombé amoureux de l'une des images phares de Windows, vous voudrez savoir comment les télécharger afin de pouvoir les conserver comme arrière-plan pendant un certain temps. Voici tout ce que vous devez savoir. Qu’est-ce que WindowsSpotlight ? Window Spotlight est un programme de mise à jour automatique du fond d'écran disponible dans Personnalisation et dans l'application Paramètres.

Le dernier chef-d'œuvre du MIT : utiliser GPT-3.5 pour résoudre le problème de la détection des anomalies des séries chronologiques

Jun 08, 2024 pm 06:09 PM

Le dernier chef-d'œuvre du MIT : utiliser GPT-3.5 pour résoudre le problème de la détection des anomalies des séries chronologiques

Jun 08, 2024 pm 06:09 PM

Aujourd'hui, j'aimerais vous présenter un article publié par le MIT la semaine dernière, utilisant GPT-3.5-turbo pour résoudre le problème de la détection des anomalies des séries chronologiques et vérifiant dans un premier temps l'efficacité du LLM dans la détection des anomalies des séries chronologiques. Il n'y a pas de réglage fin dans l'ensemble du processus et GPT-3.5-turbo est utilisé directement pour la détection des anomalies. Le cœur de cet article est de savoir comment convertir des séries temporelles en entrées pouvant être reconnues par GPT-3.5-turbo et comment concevoir. des invites ou des pipelines pour laisser LLM résoudre la tâche de détection des anomalies. Permettez-moi de vous présenter une introduction détaillée à ce travail. Titre de l'article image : Largelangagemodelscanbezero-shotanomalydete

Comment utiliser la technologie de segmentation sémantique d'images en Python ?

Jun 06, 2023 am 08:03 AM

Comment utiliser la technologie de segmentation sémantique d'images en Python ?

Jun 06, 2023 am 08:03 AM

Avec le développement continu de la technologie de l’intelligence artificielle, la technologie de segmentation sémantique des images est devenue une direction de recherche populaire dans le domaine de l’analyse d’images. Dans la segmentation sémantique d'image, nous segmentons différentes zones d'une image et classons chaque zone pour obtenir une compréhension globale de l'image. Python est un langage de programmation bien connu. Ses puissantes capacités d'analyse et de visualisation de données en font le premier choix dans le domaine de la recherche sur les technologies d'intelligence artificielle. Cet article expliquera comment utiliser la technologie de segmentation sémantique d'images en Python. 1. Les connaissances préalables s’approfondissent

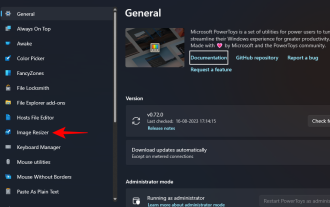

Comment redimensionner par lots des images à l'aide de PowerToys sous Windows

Aug 23, 2023 pm 07:49 PM

Comment redimensionner par lots des images à l'aide de PowerToys sous Windows

Aug 23, 2023 pm 07:49 PM

Ceux qui doivent travailler quotidiennement avec des fichiers image doivent souvent les redimensionner pour les adapter aux besoins de leurs projets et de leurs tâches. Cependant, si vous avez trop d’images à traiter, les redimensionner individuellement peut prendre beaucoup de temps et d’efforts. Dans ce cas, un outil comme PowerToys peut s'avérer utile, entre autres, pour redimensionner par lots des fichiers image à l'aide de son utilitaire de redimensionnement d'image. Voici comment configurer vos paramètres de redimensionnement d'image et commencer le redimensionnement par lots d'images avec PowerToys. Comment redimensionner des images par lots avec PowerToys PowerToys est un programme tout-en-un doté d'une variété d'utilitaires et de fonctionnalités pour vous aider à accélérer vos tâches quotidiennes. L'un de ses utilitaires est les images

iOS 17 : Comment utiliser le recadrage en un clic des photos

Sep 20, 2023 pm 08:45 PM

iOS 17 : Comment utiliser le recadrage en un clic des photos

Sep 20, 2023 pm 08:45 PM

Avec l'application iOS 17 Photos, Apple facilite le recadrage des photos selon vos spécifications. Lisez la suite pour savoir comment. Auparavant, dans iOS 16, le recadrage d'une image dans l'application Photos impliquait plusieurs étapes : appuyez sur l'interface d'édition, sélectionnez l'outil de recadrage, puis ajustez le recadrage à l'aide d'un geste de pincement pour zoomer ou en faisant glisser les coins de l'outil de recadrage. Dans iOS 17, Apple a heureusement simplifié ce processus afin que lorsque vous zoomez sur une photo sélectionnée dans votre bibliothèque Photos, un nouveau bouton Recadrer apparaisse automatiquement dans le coin supérieur droit de l'écran. En cliquant dessus, l'interface de recadrage complète s'affichera avec le niveau de zoom de votre choix. Vous pourrez ainsi recadrer la partie de l'image que vous aimez, faire pivoter l'image, inverser l'image, appliquer un rapport d'écran ou utiliser des marqueurs.