Quoi, tu ne connais pas encore NeRF ?

En tant que technologie d'IA la plus en vogue dans le domaine de la vision par ordinateur cette année, NeRF peut être considérée comme étant largement utilisée et a un brillant avenir.

Les amis du site B ont utilisé cette technologie de manière nouvelle.

Alors, qu'est-ce que le NeRF exactement ?

NeRF (Neural Radiance Fields) est un concept proposé pour la première fois dans le meilleur article de la conférence ECCV 2020. Il pousse l'expression implicite à un nouveau niveau et peut être exprimé en utilisant uniquement des images posées en 2D comme scènes 3D complexes.

Une pierre a soulevé mille vagues. Depuis lors, le NeRF s'est développé rapidement et a été appliqué à de nombreuses directions techniques, telles que la « synthèse de nouveaux points de vue, la reconstruction tridimensionnelle », etc.

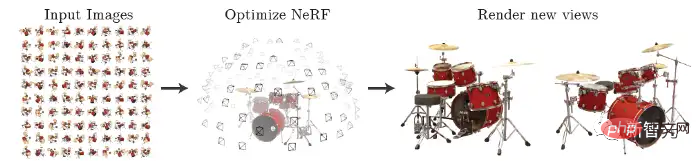

NeRF utilise des images multi-angles d'entrée clairsemées avec des poses pour s'entraîner et obtient un modèle de champ de rayonnement neuronal. Selon ce modèle, des photos claires sous n'importe quel angle de vue peuvent être rendues, comme le montre la figure ci-dessous. Cela peut également être brièvement résumé comme l’utilisation d’un MLP pour apprendre implicitement une scène tridimensionnelle.

Les internautes compareront naturellement NeRF avec le tout aussi populaire Deepfake.

Un article récent publié par MetaPhysics a fait le point sur l'histoire évolutive, les défis et les avantages du NeRF, et a prédit que le NeRF finirait par remplacer Deepfake.

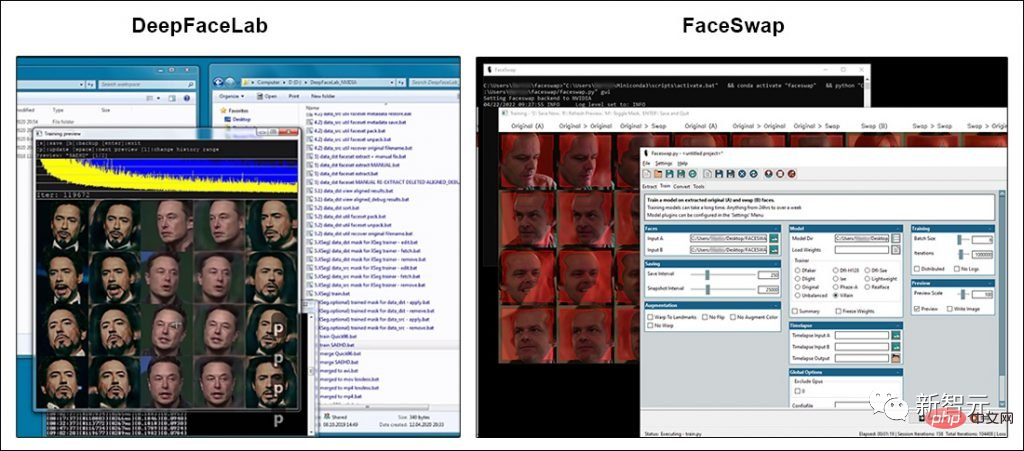

La plupart des sujets accrocheurs sur la technologie deepfake font référence aux deux logiciels open source qui sont devenus populaires depuis que les deepfakes sont entrés dans la conscience du public en 2017 : DeepFaceLab (DFL) et FaceSwap.

Bien que les deux packages disposent de bases d'utilisateurs étendues et de communautés de développeurs actives, aucun des deux projets ne s'écarte de manière significative du code GitHub.

Bien sûr, les développeurs de DFL et FaceSwap ne sont pas restés inactifs : il est désormais possible de former des modèles deepfake en utilisant des images d'entrée plus grandes, même si cela nécessite des GPU plus chers.

Mais en fait, au cours des trois dernières années, l'amélioration de la qualité des images deepfake promue par les médias est principalement due aux utilisateurs finaux.

Ils ont accumulé une expérience rare et rapide dans la collecte de données, la meilleure façon de former des modèles (parfois une seule expérience peut prendre des semaines), et ont appris à exploiter et à étendre les limitations les plus extrêmes du code original de 2017.

Certains membres des communautés de recherche VFX et ML tentent de briser les « limites strictes » du populaire package deepfake en étendant l'architecture afin que les modèles d'apprentissage automatique puissent être entraînés sur des images jusqu'à 1024 × 1024.

Ses pixels sont deux fois supérieurs à la plage actuelle de DeepFaceLab ou FaceSwap, plus proches des résolutions utiles dans la production cinématographique et télévisuelle.

Ensuite, découvrons NeRF~

NeRF (Neural Radiance Fields), apparu en 2020, est une méthode de reconstruction d'objets et d'environnements en couplant plusieurs photos de points de vue au sein d'une méthode de réseau neuronal.

Il obtient les meilleurs résultats pour synthétiser des vues de scènes complexes en optimisant la fonction de scène volumétrique continue sous-jacente à l'aide d'un ensemble clairsemé de vues d'entrée.

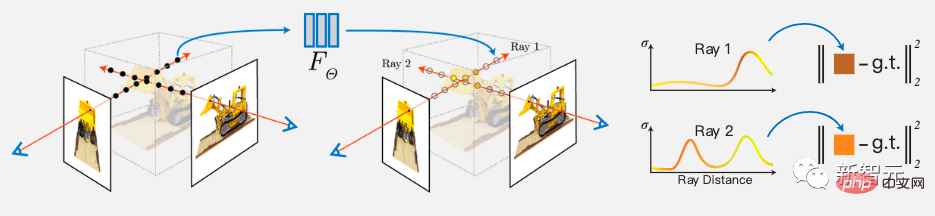

L'algorithme utilise également un réseau profond entièrement connecté pour représenter une scène, dont l'entrée est une seule coordonnée 5D continue (position spatiale (x, y, z) et direction de visualisation (θ, φ)) et dont la sortie est le volume de cette position spatiale Densité et luminosité d'amplitude d'émission associée.

Synthétisez la vue en interrogeant les coordonnées 5D le long du rayon de la caméra et projetez la couleur et la densité de sortie dans l'image à l'aide des techniques classiques de rendu de volume.

Processus de mise en œuvre :

Tout d'abord, une scène continue est représentée comme une fonction de valeur vectorielle 5D, dont l'entrée est une position 3D et une direction de visualisation 2D, et la sortie correspondante est une couleur d'émission c et une densité volumique σ.

En pratique, le vecteur unitaire cartésien 3D d est utilisé pour représenter la direction. Cette représentation continue de scène 5D est approximée avec un réseau MLP et ses poids sont optimisés.

De plus, la représentation est encouragée à être cohérente sur plusieurs vues en limitant le réseau à prédire la densité volumique σ en fonction de la position x, tout en permettant également de prédire la couleur RVB c en fonction de la position et de la direction de visualisation.

Pour y parvenir, le MLP traite d'abord les coordonnées 3D d'entrée x avec 8 couches entièrement connectées (en utilisant l'activation ReLU et 256 canaux par couche) et génère des vecteurs de caractéristiques σ et 256 dimensions.

Ce vecteur de caractéristiques est ensuite concaténé avec la direction de visualisation du rayon de la caméra et transmis à une couche supplémentaire entièrement connectée qui génère la couleur RVB associée à la vue.

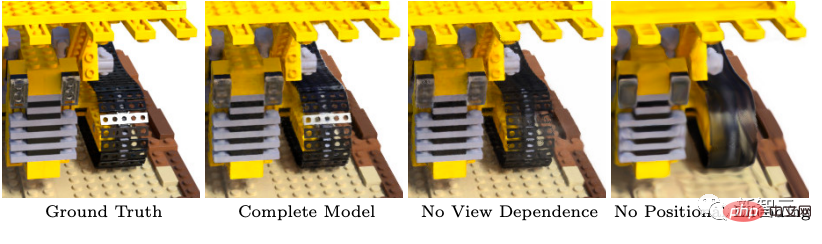

De plus, NeRF introduit également deux améliorations pour obtenir la représentation de scènes complexes en haute résolution. Le premier est un codage positionnel pour aider MLP à représenter les fonctions haute fréquence, et le second est un processus d'échantillonnage stratifié pour lui permettre d'échantillonner efficacement les représentations haute fréquence.

Comme nous le savons tous, le codage de position dans l'architecture Transformer peut fournir la position discrète du marqueur dans la séquence comme entrée de l'architecture entière. NeRF utilise le codage de position pour mapper les coordonnées d'entrée continues sur un espace dimensionnel supérieur, ce qui permet à MLP de se rapprocher plus facilement des fonctions de fréquence plus élevée.

Comme le montre la figure, la suppression du codage de position réduira considérablement la capacité du modèle à représenter la géométrie et la texture à haute fréquence, conduisant finalement à une apparence trop lisse.

Étant donné que la stratégie de rendu consistant à évaluer de manière dense le réseau de champs de rayonnement neuronal à N points d'interrogation le long de chaque rayon de caméra est très inefficace, NeRF adopte finalement une représentation hiérarchique qui s'améliore en attribuant des échantillons proportionnellement à l'effet attendu du rendu final. Efficacité du rendu.

En bref, NeRF n'utilise plus qu'un seul réseau pour représenter la scène, mais optimise deux réseaux à la fois, un réseau « à gros grain » et un réseau « à grain fin ».

NeRF résout les lacunes du passé, qui consiste à utiliser MLP pour représenter des objets et des scènes comme des fonctions continues. Par rapport aux méthodes précédentes, NeRF peut produire de meilleurs effets de rendu.

Cependant, NeRF est également confronté à de nombreux goulots d'étranglement techniques. Par exemple, l'accélérateur de NeRF sacrifiera d'autres fonctions relativement utiles (telles que la flexibilité) pour obtenir une faible latence, des environnements plus interactifs et moins de temps de formation.

Ainsi, même si le NeRF constitue une avancée majeure, il faut encore un certain temps pour obtenir des résultats parfaits.

La technologie avance et l'avenir est toujours prometteur !

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Configurer le fichier HOSTS

Configurer le fichier HOSTS

Comment désactiver l'invite de mise à niveau Win10

Comment désactiver l'invite de mise à niveau Win10

Quelles sont les différences entre weblogic et Tomcat

Quelles sont les différences entre weblogic et Tomcat

Comment utiliser les macros Excel

Comment utiliser les macros Excel

Logiciel de cryptage de téléphone portable

Logiciel de cryptage de téléphone portable

Logiciel de partition de disque dur mobile

Logiciel de partition de disque dur mobile

utilisation du descripteur de propriété

utilisation du descripteur de propriété

Comment résoudre 404 introuvable

Comment résoudre 404 introuvable

utilisation de plusieurs fonctions

utilisation de plusieurs fonctions