Périphériques technologiques

Périphériques technologiques

IA

IA

Une nouvelle recherche de Stanford et de Berkeley renverse la « suprématie quantique » de Google ! Beau en théorie, mais inutile en pratique

Une nouvelle recherche de Stanford et de Berkeley renverse la « suprématie quantique » de Google ! Beau en théorie, mais inutile en pratique

Une nouvelle recherche de Stanford et de Berkeley renverse la « suprématie quantique » de Google ! Beau en théorie, mais inutile en pratique

Suprématie quantique, ce terme existe depuis près de 4 ans.

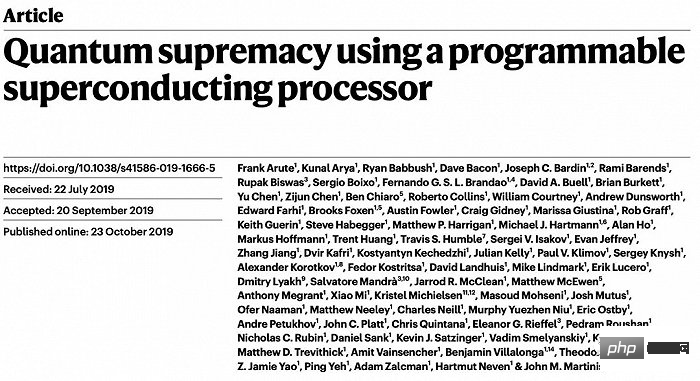

En 2019, les physiciens de Google ont annoncé avoir réussi à atteindre l'hégémonie quantique avec une machine de 53 qubits, ce qui constituait une étape symbolique importante.

Dans un article publié dans Nature, il a été déclaré que le système quantique ne prenait que 200 secondes pour effectuer un calcul, alors que le même calcul prenait environ 10 000 ans à l'aide de Summit, le supercalculateur le plus puissant de l'époque.

Qu'est-ce que la suprématie quantique ?

La soi-disant « suprématie quantique » ou « avantage quantique » (ci-après dénommé « suprématie quantique ») signifie que les tâches que les ordinateurs quantiques peuvent accomplir dépassent la portée de tout algorithme classique réalisable.

Même si ces tâches sont confiées aux supercalculateurs traditionnels les plus avancés, le long temps de calcul (souvent des milliers d'années) fera perdre à l'algorithme sa signification pratique.

Fait intéressant, dans les résultats de Google en 2019, il indiquait seulement que l’hégémonie quantique avait été atteinte, mais n’expliquait pas les cas spécifiques dans lesquels les ordinateurs quantiques ont surpassé les ordinateurs classiques.

C'est une question difficile à répondre car actuellement les ordinateurs quantiques sont en proie à des erreurs qui peuvent s'accumuler et nuire aux performances et à la stabilité de l'informatique quantique.

En fait, par rapport au domaine de la réalisation de l'hégémonie quantique, ce que les scientifiques veulent en savoir plus est une autre question : à mesure que les ordinateurs quantiques deviennent de plus en plus grands, les algorithmes classiques peuvent-ils suivre le rythme ?

Scott Aaronson, informaticien à l'Université du Texas à Austin, a déclaré : "Nous espérons qu'à terme, le côté quantique prendra complètement ses distances et mettra complètement fin à cette compétition.

La plupart des chercheurs spéculent que." , La réponse est non.

C'est-à-dire que les algorithmes classiques seront un jour complètement incapables de suivre le rythme de l'informatique quantique, mais ils ont été incapables de le prouver de manière précise et complète. Une façon de prouver définitivement cette inférence est de trouver les conditions dans lesquelles l’informatique quantique peut acquérir un « avantage durable » sur l’informatique traditionnelle.

Maintenant, cette question semble avoir une réponse préliminaire :

Gain de temps : l'informatique quantique produira des erreurs si la correction des erreurs ne peut pas suivre, ces erreurs briseront l'idéal « hégémonie quantique », permettant le classique. algorithmes pour suivre les algorithmes quantiques.

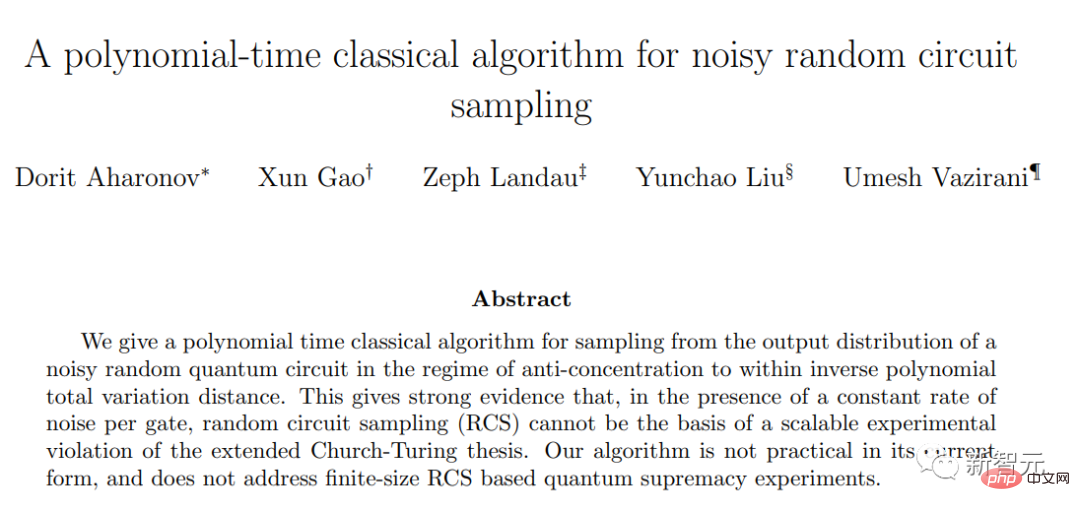

Récemment, dans un article préimprimé publié sur Arxiv, une équipe conjointe de l'Université Harvard, de l'Université de Californie à Berkeley et de l'Université hébraïque d'Israël a fait un grand pas en avant pour confirmer cette conclusion.

Ils ont démontré que la correction d'erreurs ciblée est une condition nécessaire pour une suprématie quantique durable dans l'échantillonnage de circuits aléatoires, confirmant les conclusions des recherches de Google il y a quelques années. Au niveau actuel de correction des erreurs quantiques, la suprématie quantique n’existe en réalité pas.

Il n'y a plus de « zone dorée » pour la suprématie quantique

Les chercheurs ont développé un algorithme classique capable de simuler des expériences d'échantillonnage de circuits aléatoires lorsque des erreurs existent pour prouver cette conclusion.

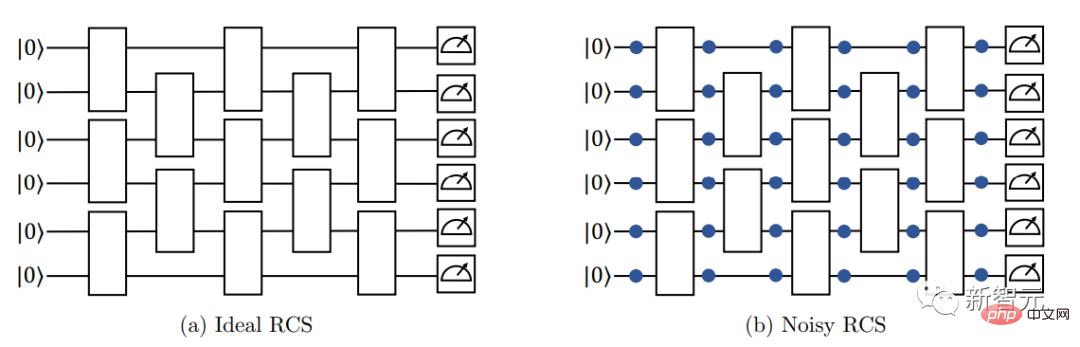

Commencez avec un tableau de qubits et manipulez ces qubits de manière aléatoire à l'aide d'opérations appelées « portes quantiques ». Certaines portes quantiques provoquent l’intrication de paires de qubits, ce qui signifie qu’ils partagent un état quantique qui ne peut être décrit individuellement.

La configuration répétée de ces portes quantiques dans des circuits multicouches peut permettre aux qubits d'entrer dans des états intriqués plus complexes.

Pour comprendre cet état quantique, les chercheurs ont mesuré tous les qubits du réseau. Ce comportement provoque l’effondrement de l’état quantique collectif de tous les qubits en une chaîne aléatoire de bits ordinaires, à savoir des 0 et des 1.

Le nombre de résultats possibles augmente rapidement avec le nombre de qubits dans le tableau. Dans l'expérience de Google de 2019, 53 qubits contenaient près de 10 000 milliards de résultats.

De plus, cette méthode nécessite plusieurs mesures répétées à partir d'un circuit aléatoire pour construire une carte de distribution de probabilité des résultats.

La question concernant la suprématie quantique est la suivante : est-il difficile, voire impossible, d'imiter cette distribution de probabilité avec un algorithme classique qui n'utilise aucune intrication ?

En 2019, des chercheurs de Google ont prouvé que cet objectif est difficile à atteindre pour les circuits quantiques sans erreur qui ne produisent pas d'erreurs. Il est en effet difficile de simuler sans erreurs une expérience d’échantillonnage de circuits aléatoires en utilisant des algorithmes classiques.

Du point de vue de la complexité informatique, lorsque le nombre de qubits augmente, la complexité informatique des algorithmes de classification traditionnels augmente de façon exponentielle, tandis que la complexité informatique des algorithmes quantiques augmente de manière polynomiale.

Lorsque n augmente suffisamment grand, un algorithme exponentiel en n est loin derrière tout algorithme polynomial en n.

C'est la différence à laquelle nous faisons référence lorsque nous parlons d'un problème difficile pour un ordinateur classique mais facile pour un ordinateur quantique. Les meilleurs algorithmes classiques prennent un temps exponentiel, tandis que les ordinateurs quantiques peuvent résoudre des problèmes en temps polynomial.

Cependant, l'article de 2019 n'a pas pris en compte l'impact des erreurs causées par des portes quantiques imparfaites, et la conclusion de la recherche a en fait laissé un trou. En d'autres termes, l'échantillonnage de circuits aléatoires sans correction d'erreur peut-il encore atteindre l'hégémonie quantique ?

En fait, si l'on considère les erreurs qui se produisent dans l'intrication quantique et peuvent s'accumuler, alors la difficulté de simuler des expériences d'échantillonnage de circuits aléatoires avec des algorithmes classiques sera considérablement réduite. Et si la complexité informatique de la simulation d’algorithmes classiques est réduite au même niveau polynomial que celle des algorithmes quantiques, l’hégémonie quantique n’existera plus.

Ce nouvel article montre que, en supposant que la profondeur du circuit reste constante, disons 3 couches très peu profondes, à mesure que le nombre de qubits augmente, il n'y aura pas trop d'intrication quantique et la sortie peut toujours être simulée de manière classique.

D'un autre côté, si la profondeur du circuit est augmentée pour suivre le nombre croissant de qubits, alors l'effet cumulatif des erreurs de porte quantique diluera la complexité causée par l'intrication, et il deviendra encore plus facile de simuler le sortie avec des algorithmes classiques.

Il existe une « zone dorée » entre les deux, c'est-à-dire la fenêtre dans laquelle l'hégémonie quantique peut continuer à survivre, c'est-à-dire la plage où les simulations algorithmiques traditionnelles ne peuvent pas suivre l'intrication quantique.

Avant la publication de cet article, même si le nombre de qubits augmentait, la suprématie quantique existait toujours lorsque le nombre de qubits atteignait une certaine plage intermédiaire.

À cette profondeur de circuit, il est difficile de simuler l'algorithme classique à chaque étape, même si la sortie se dégrade régulièrement en raison d'erreurs de l'algorithme quantique.

Ce nouveau papier élimine presque cette "zone dorée".

L'article dérive un algorithme classique pour simuler un échantillonnage de circuit aléatoire et prouve que son temps d'exécution est une

fonction polynomialedu temps nécessaire pour exécuter l'expérience quantique correspondante, plutôt qu'une fonction exponentielle. Ce résultat établit un lien théorique étroit entre la rapidité de la méthode classique d'échantillonnage de circuits aléatoires et la méthode quantique, c'est-à-dire qu'il déclare que l'hégémonie quantique, qui a été réalisée en théorie, n'existe pratiquement pas.

La raison pour laquelle je dis "presque" est que les hypothèses de base du nouvel algorithme ne sont pas valables pour certains circuits moins profonds, laissant un "petit écart" inconnu.

Cependant, peu de chercheurs espèrent encore atteindre la suprématie quantique dans cette lacune. Même Bill Fefferman, informaticien à l'Université de Chicago et l'un des auteurs de l'article de Google de 2019, a déclaré : « Je pense que les chances sont assez faibles. »

On peut dire que selon les normes strictes de la théorie de la complexité informatique, l'échantillonnage de circuits aléatoires ne produira plus de suprématie quantique.

De plus, face à cette conclusion, tous les chercheurs s'accordent sur l'importance cruciale de la correction des erreurs quantiques pour le succès à long terme de l'informatique quantique. Fefferman a déclaré : "En fin de compte, nous avons découvert que la correction des erreurs quantiques est la solution."

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Une plongée approfondie dans les modèles, les données et les frameworks : une revue exhaustive de 54 pages de grands modèles de langage efficaces

Jan 14, 2024 pm 07:48 PM

Une plongée approfondie dans les modèles, les données et les frameworks : une revue exhaustive de 54 pages de grands modèles de langage efficaces

Jan 14, 2024 pm 07:48 PM

Les modèles linguistiques à grande échelle (LLM) ont démontré des capacités convaincantes dans de nombreuses tâches importantes, notamment la compréhension du langage naturel, la génération de langages et le raisonnement complexe, et ont eu un impact profond sur la société. Cependant, ces capacités exceptionnelles nécessitent des ressources de formation importantes (illustrées dans l’image de gauche) et de longs temps d’inférence (illustrés dans l’image de droite). Les chercheurs doivent donc développer des moyens techniques efficaces pour résoudre leurs problèmes d’efficacité. De plus, comme on peut le voir sur le côté droit de la figure, certains LLM (LanguageModels) efficaces tels que Mistral-7B ont été utilisés avec succès dans la conception et le déploiement de LLM. Ces LLM efficaces peuvent réduire considérablement la mémoire d'inférence tout en conservant une précision similaire à celle du LLaMA1-33B

Crushing H100, le GPU nouvelle génération de Nvidia se dévoile ! La première conception de module multipuce 3 nm, dévoilée en 2024

Sep 30, 2023 pm 12:49 PM

Crushing H100, le GPU nouvelle génération de Nvidia se dévoile ! La première conception de module multipuce 3 nm, dévoilée en 2024

Sep 30, 2023 pm 12:49 PM

Processus 3 nm, les performances dépassent le H100 ! Récemment, le média étranger DigiTimes a annoncé que Nvidia développait le GPU de nouvelle génération, le B100, dont le nom de code est "Blackwell". Il s'agirait d'un produit destiné aux applications d'intelligence artificielle (IA) et de calcul haute performance (HPC). , le B100 utilisera le processus de traitement 3 nm de TSMC, ainsi qu'une conception de module multi-puces (MCM) plus complexe, et apparaîtra au quatrième trimestre 2024. Pour Nvidia, qui monopolise plus de 80 % du marché des GPU d’intelligence artificielle, il peut utiliser le B100 pour frapper pendant que le fer est chaud et attaquer davantage des challengers comme AMD et Intel dans cette vague de déploiement d’IA. Selon les estimations de NVIDIA, d'ici 2027, la valeur de production de ce domaine devrait atteindre environ

La puissante combinaison de modèles de diffusion + super-résolution, la technologie derrière le générateur d'images de Google Imagen

Apr 10, 2023 am 10:21 AM

La puissante combinaison de modèles de diffusion + super-résolution, la technologie derrière le générateur d'images de Google Imagen

Apr 10, 2023 am 10:21 AM

Ces dernières années, l’apprentissage multimodal a reçu beaucoup d’attention, en particulier dans les deux directions de la synthèse texte-image et de l’apprentissage contrastif image-texte. Certains modèles d'IA ont attiré l'attention du grand public en raison de leur application dans la génération et l'édition d'images créatives, tels que les modèles d'images texte DALL・E et DALL-E 2 lancés par OpenAI, ainsi que GauGAN et GauGAN2 de NVIDIA. Pour ne pas être en reste, Google a publié fin mai son propre modèle de conversion texte-image, Imagen, qui semble repousser encore les limites de la génération d'images conditionnelles aux légendes. À partir d'une simple description d'une scène, Imagen peut générer des images de haute qualité et haute résolution.

La revue la plus complète des grands modèles multimodaux est ici ! 7 chercheurs Microsoft ont coopéré vigoureusement, 5 thèmes majeurs, 119 pages de document

Sep 25, 2023 pm 04:49 PM

La revue la plus complète des grands modèles multimodaux est ici ! 7 chercheurs Microsoft ont coopéré vigoureusement, 5 thèmes majeurs, 119 pages de document

Sep 25, 2023 pm 04:49 PM

La revue la plus complète des grands modèles multimodaux est ici ! Écrit par 7 chercheurs chinois de Microsoft, il compte 119 pages - il part de deux types d'orientations de recherche multimodales sur grands modèles qui ont été complétées et sont toujours à l'avant-garde, et résume de manière exhaustive cinq sujets de recherche spécifiques : la compréhension visuelle et la génération visuelle. L'agent multimodal grand modèle multimodal supporté par le modèle visuel unifié LLM se concentre sur un phénomène : le modèle de base multimodal est passé de spécialisé à universel. Ps. C'est pourquoi l'auteur a directement dessiné une image de Doraemon au début de l'article. Qui devrait lire cette critique (rapport) ? Dans les mots originaux de Microsoft : tant que vous souhaitez apprendre les connaissances de base et les derniers progrès des modèles de base multimodaux, que vous soyez un chercheur professionnel ou un étudiant, ce contenu est très approprié pour vous réunir.

Une nouvelle recherche révèle le potentiel du Monte Carlo quantique à surpasser les réseaux neuronaux en dépassant les limites, et un sous-numéro de Nature détaille les derniers progrès.

Apr 24, 2023 pm 09:16 PM

Une nouvelle recherche révèle le potentiel du Monte Carlo quantique à surpasser les réseaux neuronaux en dépassant les limites, et un sous-numéro de Nature détaille les derniers progrès.

Apr 24, 2023 pm 09:16 PM

Après quatre mois, un autre travail collaboratif entre ByteDance Research et le groupe de recherche de Chen Ji à l'École de physique de l'Université de Pékin a été publié dans la revue internationale de premier plan Nature Communications : l'article « Vers l'état fondamental des molécules via les réseaux neuronaux de diffusion Monte Carlo ». combine les réseaux de neurones avec les méthodes de diffusion Monte Carlo, améliorant considérablement l'application des méthodes de réseaux de neurones en chimie quantique. La précision du calcul, l'efficacité et l'échelle du système sur les tâches connexes sont devenues le dernier SOTA. Lien papier : https://www.nature.com

Adaptateur I2V de la communauté SD : aucune configuration requise, plug and play, parfaitement compatible avec le plug-in vidéo Tusheng

Jan 15, 2024 pm 07:48 PM

Adaptateur I2V de la communauté SD : aucune configuration requise, plug and play, parfaitement compatible avec le plug-in vidéo Tusheng

Jan 15, 2024 pm 07:48 PM

La tâche de génération d'image en vidéo (I2V) est un défi dans le domaine de la vision par ordinateur qui vise à convertir des images statiques en vidéos dynamiques. La difficulté de cette tâche est d'extraire et de générer des informations dynamiques dans la dimension temporelle à partir d'une seule image tout en conservant l'authenticité et la cohérence visuelle du contenu de l'image. Les méthodes I2V existantes nécessitent souvent des architectures de modèles complexes et de grandes quantités de données de formation pour atteindre cet objectif. Récemment, un nouveau résultat de recherche « I2V-Adapter : AGeneralImage-to-VideoAdapter for VideoDiffusionModels » dirigé par Kuaishou a été publié. Cette recherche introduit une méthode innovante de conversion image-vidéo et propose un module adaptateur léger, c'est-à-dire

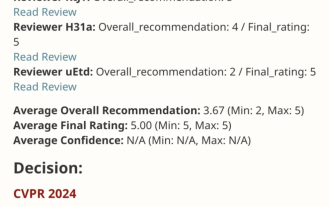

Papier de score parfait VPR 2024 ! Meta propose EfficientSAM : divisez tout rapidement !

Mar 02, 2024 am 10:10 AM

Papier de score parfait VPR 2024 ! Meta propose EfficientSAM : divisez tout rapidement !

Mar 02, 2024 am 10:10 AM

Ce travail d'EfficientSAM a été inclus dans le CVPR2024 avec une note parfaite de 5/5/5 ! L'auteur a partagé le résultat sur les réseaux sociaux, comme le montre l'image ci-dessous : Le lauréat du prix LeCun Turing a également fortement recommandé ce travail ! Dans des recherches récentes, les chercheurs de Meta ont proposé une nouvelle méthode améliorée, à savoir le pré-entraînement d'image de masque (SAMI) utilisant SAM. Cette méthode combine la technologie de pré-entraînement MAE et les modèles SAM pour obtenir des encodeurs ViT pré-entraînés de haute qualité. Grâce à SAMI, les chercheurs tentent d'améliorer les performances et l'efficacité du modèle et de proposer de meilleures solutions pour les tâches de vision. La proposition de cette méthode apporte de nouvelles idées et opportunités pour explorer et développer davantage les domaines de la vision par ordinateur et de l’apprentissage profond. en combinant différents

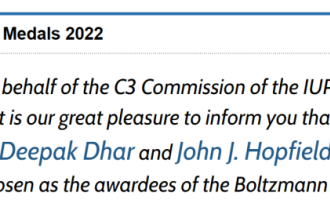

Annonce du prix Boltzmann 2022 : le fondateur de Hopfield Network remporte le prix

Aug 13, 2023 pm 08:49 PM

Annonce du prix Boltzmann 2022 : le fondateur de Hopfield Network remporte le prix

Aug 13, 2023 pm 08:49 PM

Les deux scientifiques qui ont remporté le prix Boltzmann 2022 ont été annoncés. Ce prix a été créé par le comité de physique statistique (C3) de l'IUPAP pour récompenser les chercheurs qui ont réalisé des réalisations exceptionnelles dans le domaine de la physique statistique. Le gagnant doit être un scientifique qui n’a jamais remporté de prix Boltzmann ou de prix Nobel. Ce prix a débuté en 1975 et est décerné tous les trois ans pour commémorer Ludwig Boltzmann, le fondateur de la physique statistique, Deepak Dharistheoriginalstatement. Raison de l'attribution : en reconnaissance des contributions pionnières de Deepak Dharistheoriginalstatement au domaine de la physique statistique, y compris la solution exacte de l'auto-organisation. modèle critique, croissance d'interface, désordre