Périphériques technologiques

Périphériques technologiques

IA

IA

NeurIPS 2022 | DetCLIP, une nouvelle méthode de détection de domaine ouvert, améliore l'efficacité du raisonnement de 20 fois

NeurIPS 2022 | DetCLIP, une nouvelle méthode de détection de domaine ouvert, améliore l'efficacité du raisonnement de 20 fois

NeurIPS 2022 | DetCLIP, une nouvelle méthode de détection de domaine ouvert, améliore l'efficacité du raisonnement de 20 fois

Le problème de détection de domaine ouvert fait référence au problème de savoir comment implémenter la détection de catégories arbitraires dans des scénarios en aval en utilisant un grand nombre de paires image-texte explorées à partir d'Internet ou certaines catégories de données annotées manuellement pour la formation en amont. Les applications des méthodes de détection de domaine ouvert dans l'industrie incluent principalement la détection d'objets routiers dans les systèmes de conduite autonome, la détection de scènes complètes dans le cloud, etc.

Adresse de l'article : https://arxiv.org/abs/2209.09407

Cet article partage l'article sélectionné par NeurIPS 2022 "DetCLIP : Dictionary-Enriched Visual-Concept Parlleled Pre-training for Open -world Detection", cet article propose un cadre de formation parallèle efficace pour combiner conjointement plusieurs sources de données pour le problème de détection en domaine ouvert, et construit également une base de connaissances supplémentaire pour fournir des relations implicites entre les catégories. Dans le même temps, DetCLIP a remporté la première place dans la catégorie détection zéro tir avec un indice de détection moyen de 24,9 % lors du concours ECCV2022 OdinW (Object Detection in the Wild[1]) organisé par Microsoft.

Introduction au problème

Avec la popularité des modèles de pré-entraînement multimodaux (tels que CLIP) formés sur la base de paires d'images et de textes explorés à partir d'Internet, et ses excellentes performances dans le domaine de la classification zéro-shot , de plus en plus De plus en plus de méthodes tentent de transférer cette capacité vers la prédiction dense de domaine ouvert (comme la détection de catégories arbitraires, la segmentation, etc.). Les méthodes existantes utilisent souvent de grands modèles de classification pré-entraînés pour la distillation au niveau des caractéristiques [1] ou apprennent par pseudo-étiquetage et auto-formation [2], mais cela est souvent limité par les performances des grands modèles de classification et le problème de. annotation de légende incomplète.

Le modèle de détection de domaine ouvert SOTA existant GLIP[3] effectue une formation conjointe de plusieurs sources de données en convertissant le format des données de détection au format de données Grounding, tirant pleinement parti des avantages des différentes sources de données (les données de détection l'ensemble de données a des exigences particulières pour les catégories communes (annotation plus complète, tandis que l'ensemble de données Grounding a une gamme plus large d'intervalles de couverture de catégorie). Cependant, nous avons constaté que la manière de concaténer les noms de catégorie conduit à une réduction de l’efficacité globale de l’apprentissage du modèle, tandis que l’utilisation directe de mots de catégorie comme saisie de texte ne peut pas fournir de relations a priori fines entre les catégories.

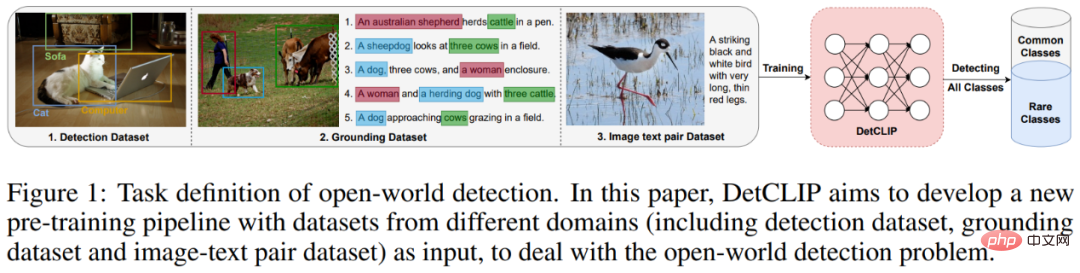

Figure 1 : Pipeline de modèle de détection de domaine ouvert de pré-formation conjointe multi-sources de données

Cadre de modèle

Comme le montre la figure ci-dessous, il est construit sur la base de l'ATSS[4 ] modèle de détection en une seule étape, DetCLIP Il contient un encodeur d'image pour obtenir les caractéristiques d'image du boîtier de détection , et un encodeur de texte pour obtenir les caractéristiques de texte de la catégorie . Ensuite, sur la base des caractéristiques de l'image et du texte ci-dessus, la perte d'alignement de classification correspondante , la perte de point central et la perte de régression sont calculées.

Figure 2 : Cadre du modèle DetCLIP

Comme le montrent en haut à droite et en haut à gauche de la figure 2, les principaux points d'innovation de cet article sont 1) Proposer de traiter plusieurs sources de données objets avec entrée parallèle - union de texte Cadre de formation pour optimiser l'efficacité de la formation 2) Créer une base de connaissances d'objets supplémentaire pour faciliter la formation à la détection de domaine ouvert ;

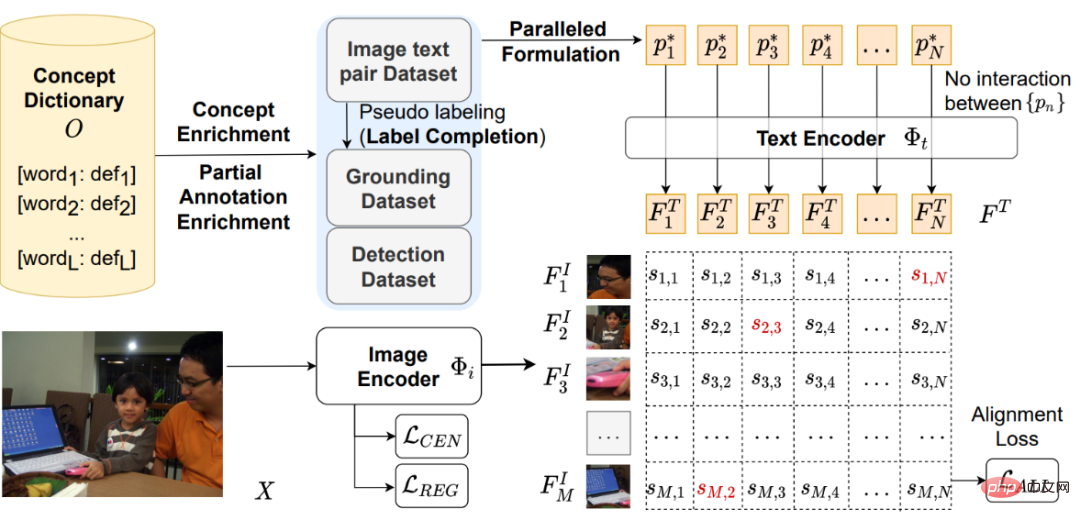

Cadre de pré-formation à saisie parallèle à plusieurs sources de données

Par rapport à GLIP, qui convertit les données de détection en forme de mise à la terre (série) en épissant les noms de catégorie, nous extrayons les phrases nominales correspondantes dans les données de mise à la terre et les combinons avec la détection. Les catégories sont utilisées comme entrées indépendantes et sont entrées dans l'encodeur de texte (en parallèle) pour éviter les calculs d'attention inutiles et obtenir une efficacité de formation plus élevée.

Figure 3 : Comparaison entre le cadre de pré-formation des entrées parallèles DetCLIP et GLIP

Base de connaissances d'objets

Afin de résoudre le problème de l'espace de catégories non uniforme de différentes sources de données (le les mêmes noms de catégories sont différents, ou les catégories contiennent, etc.) et fournissons des informations préalables sur la relation entre les catégories, nous construisons une base de connaissances d'objets pour obtenir une formation plus efficace.

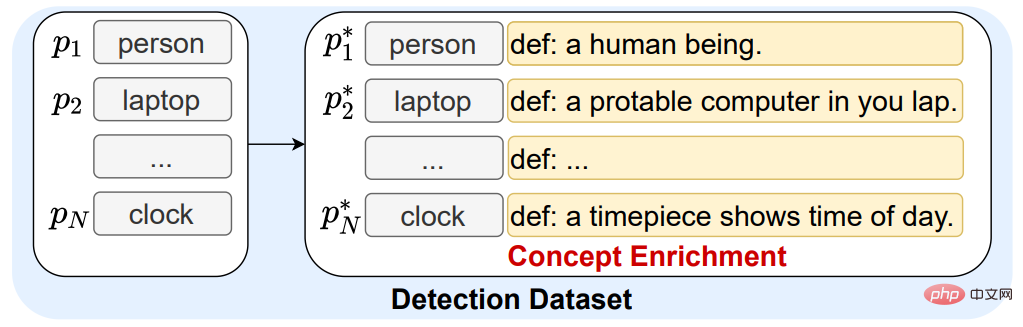

Construction : Nous intégrons simultanément les catégories dans les données de détection, les phrases nominales dans la paire image-texte et les définitions correspondantes pour construire la base de connaissances des objets.

Utilisation : 1. Nous utilisons la définition de la base de connaissances des objets pour étendre les mots de catégorie dans les données de détection existantes afin de fournir des informations préalables (enrichissement des concepts) sur la relation entre les catégories.

Figure 4 : Exemple d'utilisation de la base de connaissances d'objets pour étendre les définitions de mots de catégorie

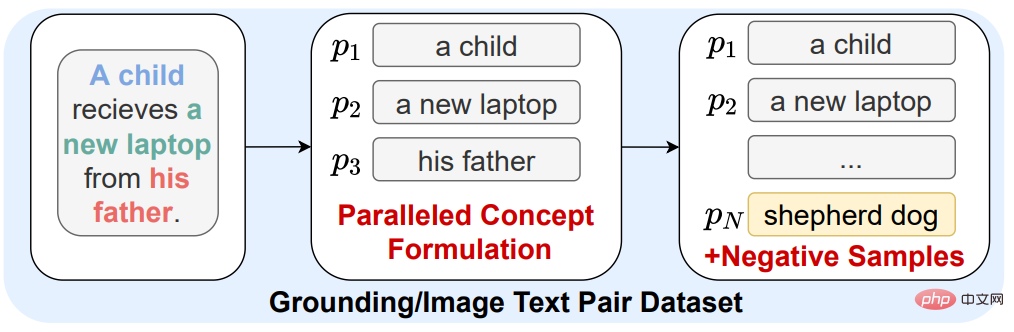

2. En raison du problème d'annotation de légende incomplète dans les données de base et les données de légende d'image (apparaît). sur l'image) la catégorie n'apparaît pas dans la légende), ce qui entraîne un très petit nombre de catégories qui peuvent être utilisées comme échantillons négatifs lors de la formation de ces images, ce qui rend le modèle moins distinguable pour certaines catégories inhabituelles. Par conséquent, nous sélectionnons au hasard des noms d'objets dans la base de connaissances des objets en tant que catégories d'échantillons négatifs afin d'améliorer la discrimination par le modèle des caractéristiques des catégories rares (+ échantillons négatifs).

Figure 5 : Introduction de catégories dans la base de connaissances d'objets en tant qu'échantillons de catégories négatives

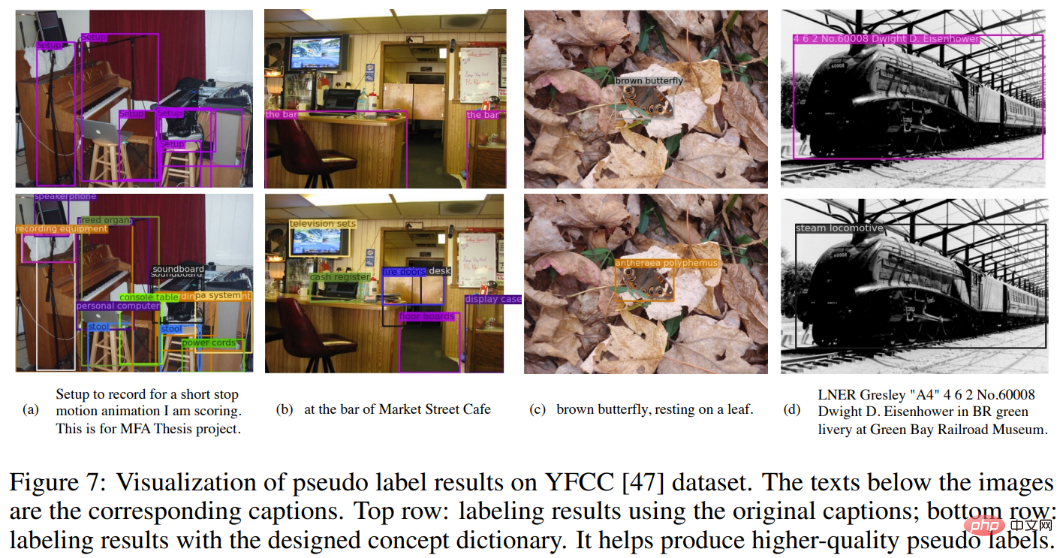

3 Pour les données de paire image-texte sans annotation de cadre, nous utilisons l'auto-recherche de Huawei Noah. le modèle FILIP [5] et le RPN pré-entraîné l'étiquetent afin qu'il puisse être converti en données de mise à la terre normales pour l'entraînement. Dans le même temps, afin d'atténuer le problème de l'annotation incomplète des objets dans l'image dans la légende, nous utilisons toutes les expressions de catégorie de la base de connaissances des objets comme catégories candidates pour le pseudo-étiquetage (deuxième ligne), et utilisons uniquement la catégorie effet d'annotation dans la légende (première ligne). La comparaison est la suivante :

Figure 6 : Introduction de catégories dans la base de connaissances d'objets en tant que catégories candidates pour un faux étiquetage

Résultats expérimentaux

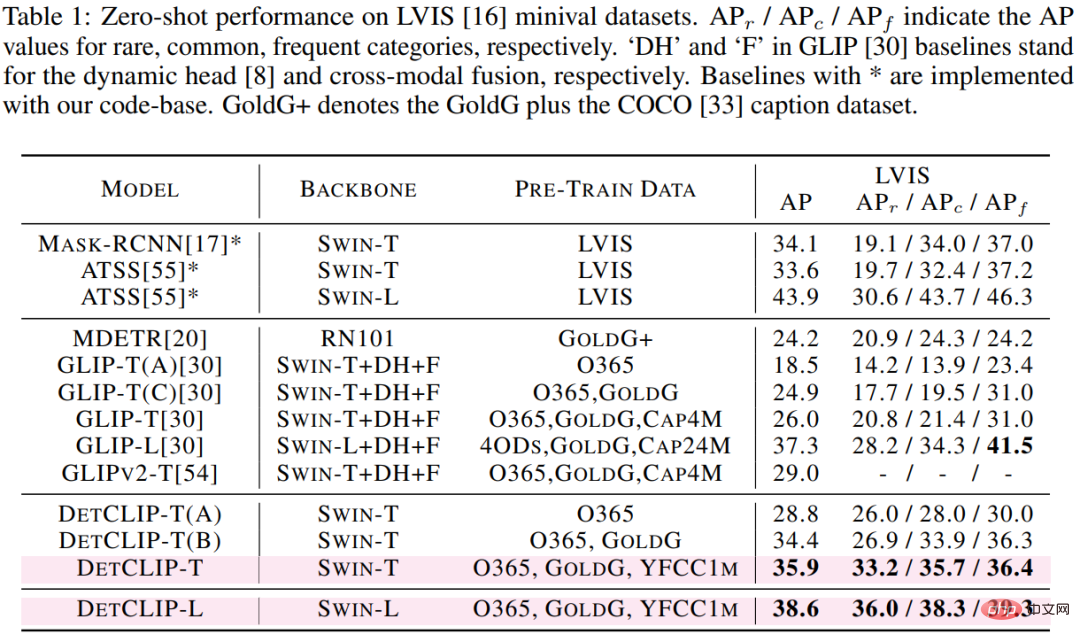

Nous avons utilisé l'ensemble de données de détection LVIS en aval (1203 catégories) pour vérifier les performances de détection de domaine ouvert de la méthode proposée. On peut voir que sur l'architecture basée sur le backbone swin-t, DetCLIP a obtenu une amélioration AP de 9,9%. par rapport au modèle SOTA existant GLIP, et une amélioration de 12,4 dans la catégorie Rare % AP, bien que nous n'utilisions que moins de la moitié de la quantité de données par rapport à GLIP. Notez que l'ensemble d'entraînement ne contient aucune image dans LVIS.

Tableau 1 : Comparaison des performances de transfert zéro-shot de différentes méthodes sur LVIS

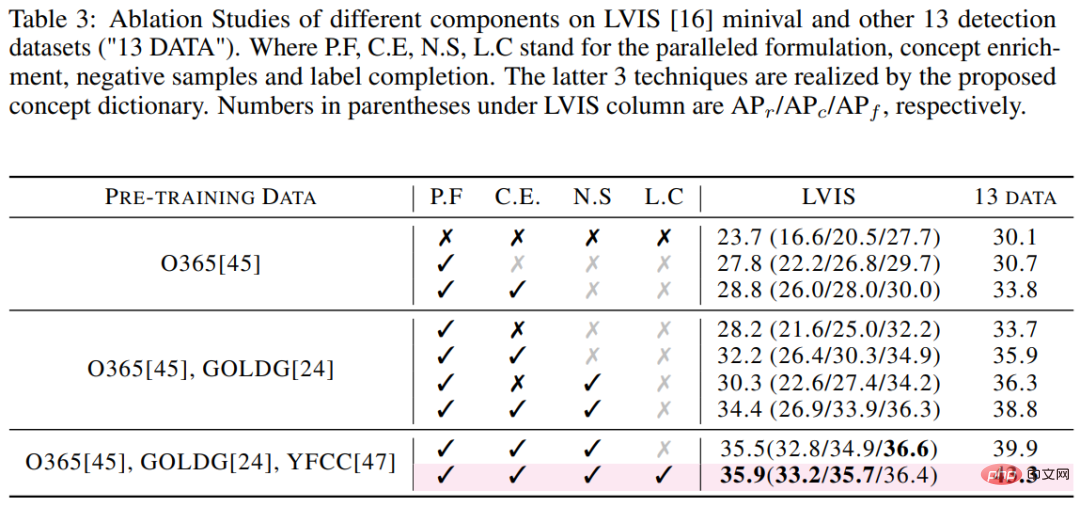

En termes d'efficacité de la formation, sur la base des mêmes conditions matérielles 32 V100, le temps de formation du GLIP -T est DetCLIP 5x de -T (10,7 000 heures GPU contre 2 000 heures GPU). En termes d'efficacité des tests, basée sur un seul V100, l'efficacité d'inférence de DetCLIP-T de 2,3 FPS (0,4 seconde par image) est 20 fois supérieure à celle de 0,12 FPS de GLIP-T (8,6 secondes par image). Nous avons également étudié séparément l'impact des innovations clés de DetCLIP (cadre parallèle et base de connaissances des objets) sur la précision.

Tableau 3 : Résultats de l'étude d'ablation DetCLIP sur l'ensemble de données LVIS

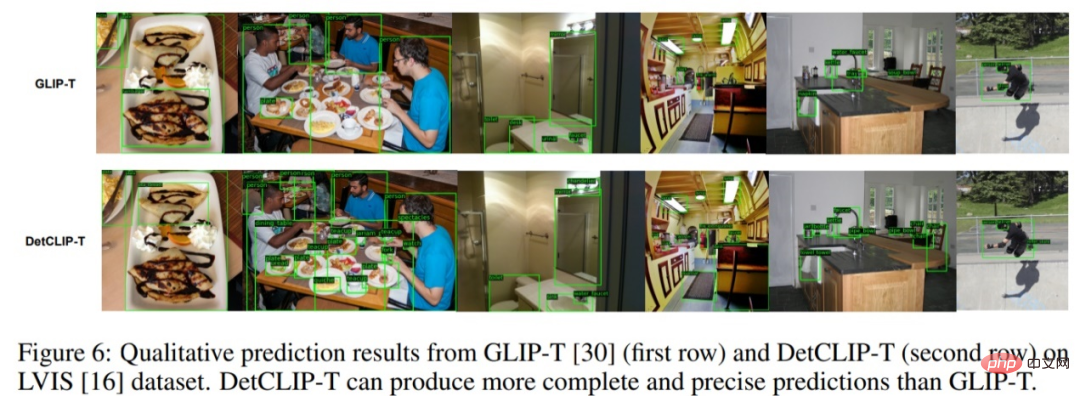

Résultats de visualisation

Comme le montre la figure ci-dessous, basée sur le même squelette swin-t, visualisation sur l'ensemble de données LVIS. L'effet a été significativement amélioré par rapport à GLIP, notamment dans l'annotation des catégories rares et l'exhaustivité de l'annotation.

Figure 7 : Comparaison visuelle des résultats de prédiction de DetCLIP et GLIP sur l'ensemble de données LVIS

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Utilisez ddrescue pour récupérer des données sous Linux

Mar 20, 2024 pm 01:37 PM

Utilisez ddrescue pour récupérer des données sous Linux

Mar 20, 2024 pm 01:37 PM

DDREASE est un outil permettant de récupérer des données à partir de périphériques de fichiers ou de blocs tels que des disques durs, des SSD, des disques RAM, des CD, des DVD et des périphériques de stockage USB. Il copie les données d'un périphérique bloc à un autre, laissant derrière lui les blocs corrompus et ne déplaçant que les bons blocs. ddreasue est un puissant outil de récupération entièrement automatisé car il ne nécessite aucune interruption pendant les opérations de récupération. De plus, grâce au fichier map ddasue, il peut être arrêté et repris à tout moment. Les autres fonctionnalités clés de DDREASE sont les suivantes : Il n'écrase pas les données récupérées mais comble les lacunes en cas de récupération itérative. Cependant, il peut être tronqué si l'outil est invité à le faire explicitement. Récupérer les données de plusieurs fichiers ou blocs en un seul

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

0. À quoi sert cet article ? Nous proposons DepthFM : un modèle d'estimation de profondeur monoculaire génératif de pointe, polyvalent et rapide. En plus des tâches traditionnelles d'estimation de la profondeur, DepthFM démontre également des capacités de pointe dans les tâches en aval telles que l'inpainting en profondeur. DepthFM est efficace et peut synthétiser des cartes de profondeur en quelques étapes d'inférence. Lisons ce travail ensemble ~ 1. Titre des informations sur l'article : DepthFM : FastMonocularDepthEstimationwithFlowMatching Auteur : MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Comment utiliser la fonction de filtre Excel avec plusieurs conditions

Feb 26, 2024 am 10:19 AM

Comment utiliser la fonction de filtre Excel avec plusieurs conditions

Feb 26, 2024 am 10:19 AM

Si vous avez besoin de savoir comment utiliser le filtrage avec plusieurs critères dans Excel, le didacticiel suivant vous guidera à travers les étapes pour vous assurer que vous pouvez filtrer et trier efficacement vos données. La fonction de filtrage d'Excel est très puissante et peut vous aider à extraire les informations dont vous avez besoin à partir de grandes quantités de données. Cette fonction peut filtrer les données en fonction des conditions que vous définissez et afficher uniquement les pièces qui remplissent les conditions, rendant la gestion des données plus efficace. En utilisant la fonction de filtre, vous pouvez trouver rapidement des données cibles, ce qui vous fait gagner du temps dans la recherche et l'organisation des données. Cette fonction peut non seulement être appliquée à de simples listes de données, mais peut également être filtrée en fonction de plusieurs conditions pour vous aider à localiser plus précisément les informations dont vous avez besoin. Dans l’ensemble, la fonction de filtrage d’Excel est très utile

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Les performances de JAX, promu par Google, ont dépassé celles de Pytorch et TensorFlow lors de récents tests de référence, se classant au premier rang sur 7 indicateurs. Et le test n’a pas été fait sur le TPU présentant les meilleures performances JAX. Bien que parmi les développeurs, Pytorch soit toujours plus populaire que Tensorflow. Mais à l’avenir, des modèles plus volumineux seront peut-être formés et exécutés sur la base de la plate-forme JAX. Modèles Récemment, l'équipe Keras a comparé trois backends (TensorFlow, JAX, PyTorch) avec l'implémentation native de PyTorch et Keras2 avec TensorFlow. Premièrement, ils sélectionnent un ensemble de

Vitesse Internet lente des données cellulaires sur iPhone : correctifs

May 03, 2024 pm 09:01 PM

Vitesse Internet lente des données cellulaires sur iPhone : correctifs

May 03, 2024 pm 09:01 PM

Vous êtes confronté à un décalage et à une connexion de données mobile lente sur iPhone ? En règle générale, la puissance de l'Internet cellulaire sur votre téléphone dépend de plusieurs facteurs tels que la région, le type de réseau cellulaire, le type d'itinérance, etc. Vous pouvez prendre certaines mesures pour obtenir une connexion Internet cellulaire plus rapide et plus fiable. Correctif 1 – Forcer le redémarrage de l'iPhone Parfois, le redémarrage forcé de votre appareil réinitialise simplement beaucoup de choses, y compris la connexion cellulaire. Étape 1 – Appuyez simplement une fois sur la touche d’augmentation du volume et relâchez-la. Ensuite, appuyez sur la touche de réduction du volume et relâchez-la à nouveau. Étape 2 – La partie suivante du processus consiste à maintenir le bouton sur le côté droit. Laissez l'iPhone finir de redémarrer. Activez les données cellulaires et vérifiez la vitesse du réseau. Vérifiez à nouveau Correctif 2 – Changer le mode de données Bien que la 5G offre de meilleures vitesses de réseau, elle fonctionne mieux lorsque le signal est plus faible

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

Je pleure à mort. Le monde construit à la folie de grands modèles. Les données sur Internet ne suffisent pas du tout. Le modèle de formation ressemble à « The Hunger Games », et les chercheurs en IA du monde entier se demandent comment nourrir ces personnes avides de données. Ce problème est particulièrement important dans les tâches multimodales. À une époque où rien ne pouvait être fait, une équipe de start-up du département de l'Université Renmin de Chine a utilisé son propre nouveau modèle pour devenir la première en Chine à faire de « l'auto-alimentation des données générées par le modèle » une réalité. De plus, il s’agit d’une approche à deux volets, du côté compréhension et du côté génération, les deux côtés peuvent générer de nouvelles données multimodales de haute qualité et fournir un retour de données au modèle lui-même. Qu'est-ce qu'un modèle ? Awaker 1.0, un grand modèle multimodal qui vient d'apparaître sur le Forum Zhongguancun. Qui est l'équipe ? Moteur Sophon. Fondé par Gao Yizhao, doctorant à la Hillhouse School of Artificial Intelligence de l’Université Renmin.

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles

Le premier robot capable d'accomplir de manière autonome des tâches humaines apparaît, avec cinq doigts flexibles et rapides, et de grands modèles prennent en charge l'entraînement dans l'espace virtuel

Mar 11, 2024 pm 12:10 PM

Le premier robot capable d'accomplir de manière autonome des tâches humaines apparaît, avec cinq doigts flexibles et rapides, et de grands modèles prennent en charge l'entraînement dans l'espace virtuel

Mar 11, 2024 pm 12:10 PM

Cette semaine, FigureAI, une entreprise de robotique investie par OpenAI, Microsoft, Bezos et Nvidia, a annoncé avoir reçu près de 700 millions de dollars de financement et prévoit de développer un robot humanoïde capable de marcher de manière autonome au cours de la prochaine année. Et l’Optimus Prime de Tesla a reçu à plusieurs reprises de bonnes nouvelles. Personne ne doute que cette année sera celle de l’explosion des robots humanoïdes. SanctuaryAI, une entreprise canadienne de robotique, a récemment lancé un nouveau robot humanoïde, Phoenix. Les responsables affirment qu’il peut accomplir de nombreuses tâches de manière autonome, à la même vitesse que les humains. Pheonix, le premier robot au monde capable d'accomplir des tâches de manière autonome à la vitesse d'un humain, peut saisir, déplacer et placer avec élégance chaque objet sur ses côtés gauche et droit. Il peut identifier des objets de manière autonome