Les modèles de diffusion de débruitage sont une classe émergente de réseaux de neurones génératifs qui génèrent des images à partir d'une distribution de formation via un processus de débruitage itératif. Ce type de modèle de diffusion produit des échantillons de meilleure qualité et est plus facile à mettre à l’échelle et à contrôler que les méthodes précédentes telles que les GAN et les VAE. En conséquence, après un développement rapide, ils peuvent déjà produire des images haute résolution, et les grands modèles tels que le DALL-E 2 suscitent un grand intérêt du public.

La beauté des modèles de diffusion générative réside dans leur capacité à synthétiser de nouvelles images qui, superficiellement, ne ressemblent à rien de l'ensemble d'entraînement. En fait, les efforts de formation à grande échelle réalisés dans le passé n’ont pas révélé que le surajustement constituerait un problème. Des chercheurs travaillant dans des domaines sensibles à la vie privée ont même suggéré que les modèles de diffusion pouvaient être utilisés pour protéger la vie privée en générant des exemples synthétiques pour générer des images réelles. Cette série de travaux est menée sous l'hypothèse que le modèle de diffusion ne mémorise ni ne régénère les données d'entraînement. Cela violerait toutes les garanties de confidentialité et engendrerait de nombreux problèmes de généralisation des modèles et de contrefaçon numérique.

Dans cet article, des chercheurs de Google, DeepMind et d'autres institutions ont prouvé que le modèle de diffusion SOTA peut effectivement mémoriser et régénérer un seul exemple de formation.

Adresse papier : https://arxiv.org/pdf/2301.13188v1.pdf

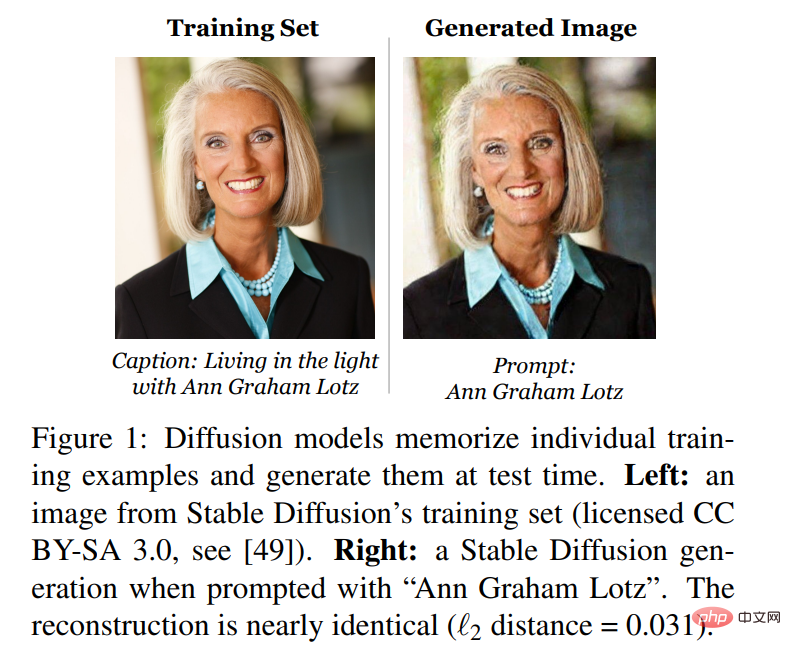

Premièrement, la recherche propose et met en œuvre une nouvelle définition de la mémoire dans les modèles d'images. Ensuite, l’étude a conçu une attaque d’extraction de données en deux étapes, utilisant des méthodes standard pour générer des images et étiqueter certaines images. L'étude a appliqué cette méthode à Stable Diffusion et Imagen, ce qui a abouti à l'extraction de plus de 100 copies presque identiques d'images de formation, allant de photos personnellement identifiables à des logos de marque (Figure 1).

Pour mieux comprendre comment fonctionne la mémoire et pourquoi, les chercheurs ont formé des centaines de modèles de diffusion sur CIFAR10 pour analyser l'impact de la précision du modèle, des hyperparamètres, de l'amélioration et de la déduplication sur l'influence sur la confidentialité. Les modèles de diffusion sont la forme la moins privée de modèles d'image évalués dans l'étude, divulguant deux fois plus de données de formation que les GAN. Pire encore, les recherches révèlent également que les technologies existantes améliorant la confidentialité ne parviennent pas à fournir des compromis acceptables entre confidentialité et utilité. Dans l’ensemble, cet article met en évidence la tension qui existe entre des modèles génératifs de plus en plus puissants et la confidentialité des données, et soulève des questions sur le fonctionnement des modèles de diffusion et sur la manière dont ils peuvent être déployés de manière appropriée.

Il y a deux motivations pour comprendre comment les modèles de diffusion mémorisent et régénèrent les données d'entraînement.

La première est de comprendre les risques liés à la vie privée. La régénération des modèles de diffusion qui récupèrent les données d'Internet peut présenter des risques similaires en matière de confidentialité et de droits d'auteur que les modèles linguistiques. Par exemple, il a été souligné que la mémorisation et la régénération de textes et de codes sources protégés par le droit d'auteur présentent des indicateurs potentiels de violation. De même, copier une image créée par un artiste professionnel s’appelle une contrefaçon numérique, et il y a un débat dans le monde de l’art.

La seconde est de comprendre la généralisation. Outre la confidentialité des données, comprendre comment et pourquoi les modèles de diffusion mémorisent les données de formation permet de comprendre leur capacité à généraliser. Par exemple, une question courante avec les modèles génératifs à grande échelle est de savoir si leurs résultats impressionnants résultent d'une véritable génération ou sont le résultat de la copie et du remixage directs des données d'entraînement. En étudiant la mémoire, il est possible de fournir une description empirique concrète de la vitesse à laquelle les modèles génératifs effectuent ce type de réplication de données.

Extraire les données de Stable Diffusion

Maintenant, extrayez les données d'entraînement de Stable Diffusion, le modèle de diffusion open source le plus grand et le plus populaire.

Cette extraction applique la méthode du travail précédent à l'image, comprenant deux étapes :

1. Utilisez un modèle de diffusion avec échantillonnage standard et générez plusieurs exemples en utilisant l'invite connue de la section précédente.

2. Effectuez l'inférence et séparez le modèle de nouvelle génération du modèle d'entraînement mémorisé.

Pour évaluer l'efficacité de l'intrusion, l'étude a sélectionné 350 000 exemples les plus répétés dans l'ensemble de données de formation et a généré 500 images candidates pour chaque invite (générant 175 millions d'images au total).

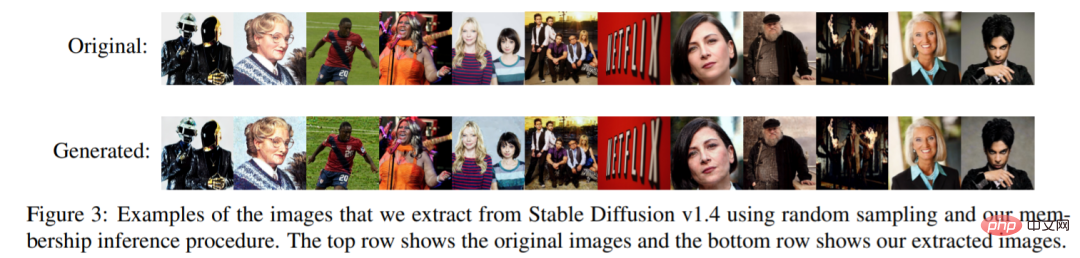

Tout d'abord, l'étude trie toutes ces images générées pour déterminer lesquelles sont générées par la mémorisation des données d'entraînement. Chacune de ces images générées est ensuite comparée aux images de formation sous la définition 1 de l'article, et chaque image est annotée comme extraite ou non extraite. L'étude a révélé que 94 images ont été extraites. Pour garantir que ces images ne correspondaient pas à une définition arbitraire, l'étude a également annoté manuellement les 1 000 premières images générées par analyse visuelle, avec ou sans mémoire, ainsi que 13 autres (109 images au total). se sont avérés être presque des copies des exemples de formation, même s'ils ne répondaient pas à la définition de la norme L_2 de l'étude. La figure 3 montre un sous-ensemble des images extraites, qui sont reproduites avec une précision de pixel presque parfaite.

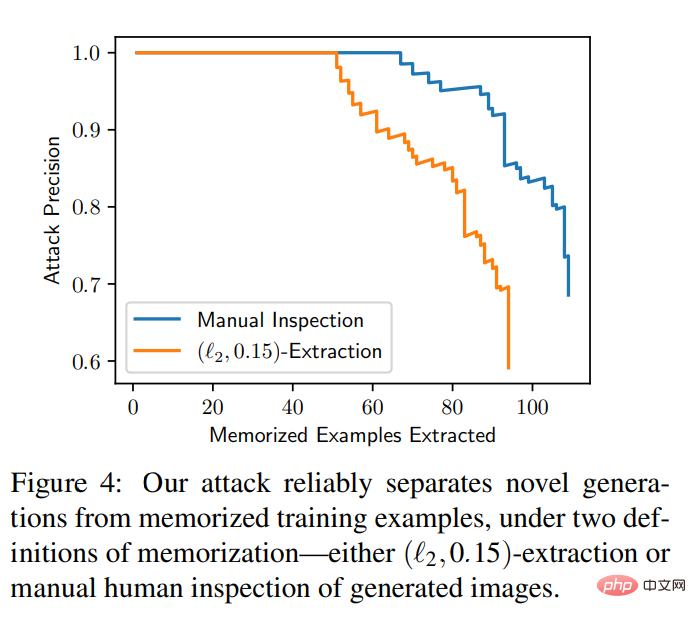

L'expérience donne également une courbe de calcul pour évaluer le nombre d'images extraites et le taux de faux positifs d'intrusion étant donné un ensemble d'images ordonnées annotées. L’intrusion est incroyablement précise : sur 175 millions d’images générées, 50 images mémoire avec 0 faux positif ont pu être identifiées, et toutes les images mémoire ont pu être extraites avec une précision de plus de 50 %. La figure 4 contient des courbes précision-rappel pour les deux définitions de la mémoire.

Extraction de données à partir d'images

Bien que la diffusion stable soit le meilleur choix parmi les modèles de diffusion actuellement disponibles au public, certains modèles non publics ont été obtenus en utilisant des modèles et des ensembles de données plus grands. De meilleures performances. Des recherches antérieures ont montré que les modèles plus grands sont plus susceptibles de mémoriser les données d'entraînement. Cette étude a donc porté sur Imagen, un modèle de diffusion texte-image à 2 milliards de paramètres.

Étonnamment, des recherches ont montré que le piratage d'images non distribuées dans Imagen est plus efficace que dans Stable Diffusion. Sur Imagen, l'étude a tenté d'extraire 500 images avec le score hors distribution (OOD) le plus élevé. Imagen mémorise et copie 3 des images (qui sont uniques dans l'ensemble de données d'entraînement). En revanche, lorsque l’étude a appliqué la même méthode à la diffusion stable, elle n’a réussi à identifier aucun souvenir, même après avoir tenté d’extraire les 10 000 échantillons les plus aberrants. Par conséquent, Imagen est moins privé que Stable Diffusion sur les images copiées et non copiées. Cela peut être dû au fait qu'Imagen utilise un modèle plus grand que Stable Diffusion et mémorise donc plus d'images. De plus, Imagen s'entraîne avec plus d'itérations sur des ensembles de données plus petits, ce qui peut également contribuer à améliorer les niveaux de mémoire.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Comment lier des données dans une liste déroulante

Comment lier des données dans une liste déroulante

Quelles sont les méthodes permettant à Docker d'entrer dans le conteneur ?

Quelles sont les méthodes permettant à Docker d'entrer dans le conteneur ?

Comment ouvrir le fichier DB

Comment ouvrir le fichier DB

Quels sont les problèmes liés à l'utilisation de php

Quels sont les problèmes liés à l'utilisation de php

Quelles sont les définitions des tableaux ?

Quelles sont les définitions des tableaux ?

Comment modifier le registre

Comment modifier le registre

Solution http500

Solution http500

Vérifier la taille du dossier sous Linux

Vérifier la taille du dossier sous Linux