Périphériques technologiques

Périphériques technologiques

IA

IA

Subvertissez trois concepts ! Dernière recherche de Google : est-il plus précis de calculer la « similarité » avec un modèle peu performant ?

Subvertissez trois concepts ! Dernière recherche de Google : est-il plus précis de calculer la « similarité » avec un modèle peu performant ?

Subvertissez trois concepts ! Dernière recherche de Google : est-il plus précis de calculer la « similarité » avec un modèle peu performant ?

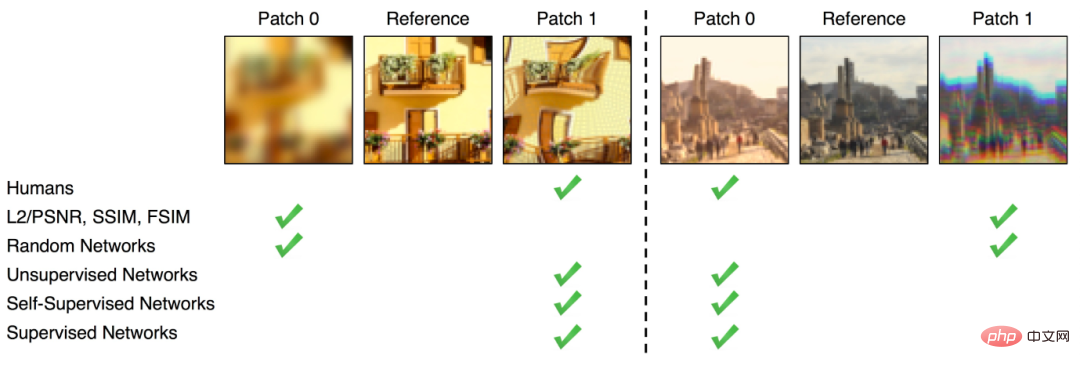

Le calcul de la similarité entre images est un problème ouvert en vision par ordinateur.

Aujourd'hui, alors que la génération d'images est populaire partout dans le monde,

Comment définir la « similarité »est également une question clé dans l'évaluation de l'authenticité des images générées. Bien qu'il existe actuellement des méthodes relativement directes pour calculer la similarité d'une image, comme la mesure des

différences en pixels(comme FSIM, SSIM), la différence de similarité obtenue par cette méthode n'est pas la même que la différence perçue par le œil humain La différence est profonde. Après l'essor du deep learning, certains chercheurs ont découvert que la représentation intermédiaire

obtenue après une formation sur ImageNet par certains classificateurs de réseaux neuronaux, tels qu'AlexNet, VGG, SqueezeNet, etc., peut être utilisée pour le calcul de la perception similarité.En d’autres termes, l’intégration est plus proche de la perception qu’ont les gens de la similitude de plusieurs images que les pixels

.

Bien sûr, ceci  n'est qu'une hypothèse

n'est qu'une hypothèse

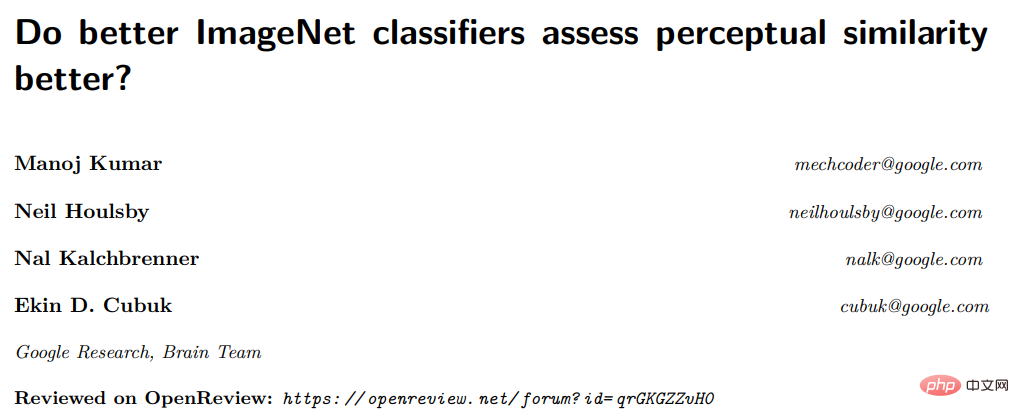

Récemment, Google a publié un article étudiant spécifiquement si le classificateur ImageNet peut mieux évaluer la similarité perceptuelle.

Lien papier : https://openreview.net/pdf?id=qrGKGZZvH0

Lien papier : https://openreview.net/pdf?id=qrGKGZZvH0

Bien qu'il y ait eu des travaux sur l'ensemble de données BAPPS

publié en 2018, basé sur leLes scores perceptuels ont été étudiés sur le classificateur ImageNet de première génération. Afin d'évaluer davantage la corrélation entre la précision et les scores perceptuels, ainsi que l'impact de divers hyperparamètres, l'article a ajouté les résultats de recherche du dernier modèle ViT. Plus la précision est élevée, plus la similarité perçue est mauvaise ?

Il est bien connu que les fonctionnalités apprises grâce à la formation sur ImageNet peuvent être bien transférées à de nombreuses tâches en aval et améliorer les performances des tâches en aval, ce qui fait également de la pré-formation sur ImageNet une opération standard.De plus, obtenir une plus grande précision sur ImageNet signifie souvent de meilleures performances sur un ensemble diversifié de tâches en aval, telles que la robustesse aux images endommagées, aux données non distribuées, etc. Performances de généralisation et transfert d'apprentissage vers des ensembles de données catégorielles plus petits.

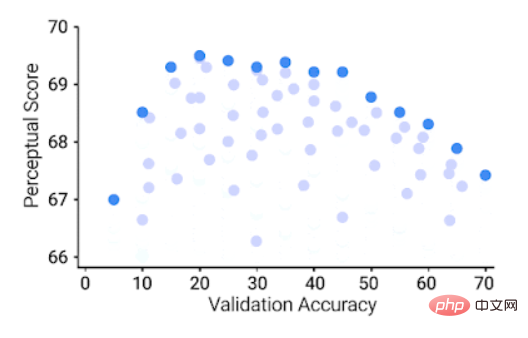

Mais en termes de calcul de similarité perceptuelle, tout semble inversé.

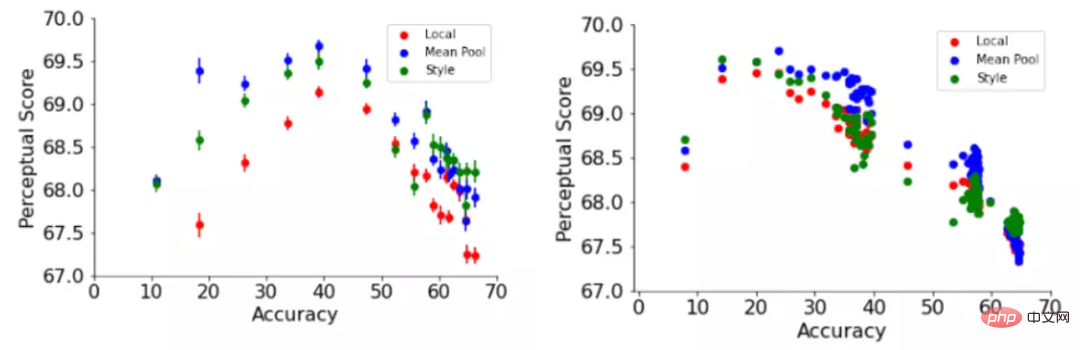

Les modèles qui atteignent une grande précision sur ImageNet ont en fait de moins bons scores de perception, tandis que les modèles avec des scores « moyens » ont les meilleures performances sur la tâche de similarité perceptuelle.

Précision de validation ImageNet 64 × 64 (axe x), score perceptuel 64 × 64 sur l'ensemble de données BAPPS (axe y), chaque point bleu représente un classificateur ImageNet

Précision de validation ImageNet 64 × 64 (axe x), score perceptuel 64 × 64 sur l'ensemble de données BAPPS (axe y), chaque point bleu représente un classificateur ImageNet

Vous pouvez voir On peut voir qu'un meilleur classificateur ImageNet atteint un meilleur score de perception dans une certaine mesure, mais au-delà d'un certain seuil, l'amélioration de la précision réduira le score de perception. La précision du classificateur est modérée (20,0-40,0), ce qui peut obtenir. le meilleur score de perception .

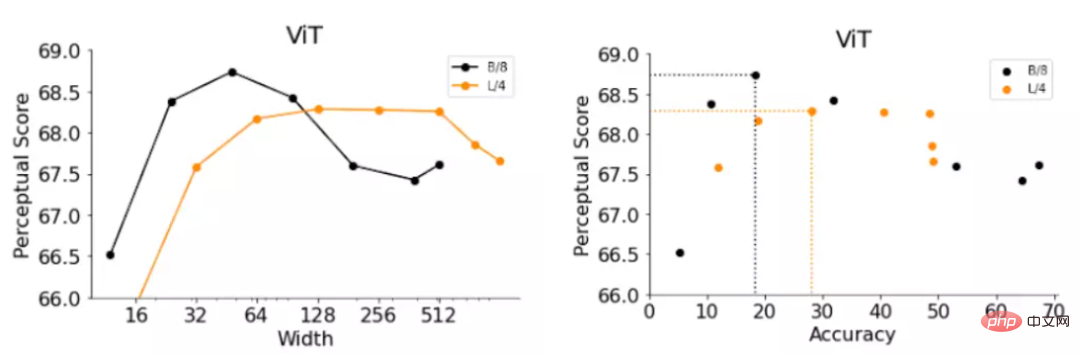

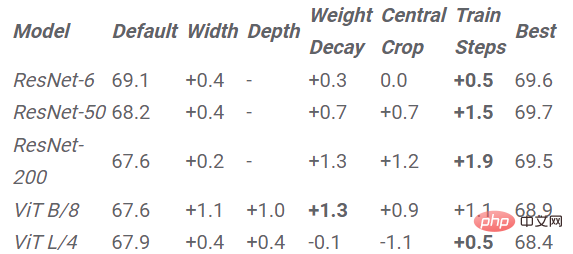

L'article étudie également l'impact des hyperparamètres du réseau neuronal sur les scores de perception, tels que la largeur, la profondeur, le nombre d'étapes d'entraînement, l'atténuation du poids, le lissage et l'abandon des étiquettes.

Pour chaque hyperparamètre, il existe une précision optimale, L’augmentation de la précision améliore le score de perception, mais cette valeur optimale est assez faible et est atteinte très tôt dans le balayage des hyperparamètres.

De plus, une augmentation de la précision du classificateur entraîne un pire score de perception.

Par exemple, l'article donne le changement de score perceptuel par rapport à deux hyperparamètres : les étapes d'entraînement dans les ResNets et la largeur dans les ViT.

Les ResNets arrêtés précocement ont obtenu les meilleurs scores de perception à différents réglages de profondeur de 6, 50 et 200 Les scores de perception de ResNet-50 et ResNet-200 ont atteint leurs valeurs les plus élevées au cours des premières époques de formation, Mais après le pic, la valeur du score perceptuel du classificateur le plus performant a chuté plus fortement. Les résultats montrent que l'ajustement du taux de formation et d'apprentissage des ResNets peut améliorer la précision du modèle à mesure que le pas augmente. De même, après le pic, le modèle présente également une diminution progressive des scores de similarité perceptuelle qui correspond à cette précision progressivement croissante. ViTs se compose d'un ensemble de blocs Transformer appliqués à l'image d'entrée. La largeur du modèle ViT est le nombre de neurones de sortie d'un seul bloc Transformer. En remplaçant la largeur des deux variantes ViT, les chercheurs ont obtenu deux modèles B/8 (c'est-à-dire le modèle Base-ViT, la taille du patch est de 4) et L/4 (c'est-à-dire le modèle Large-ViT), et ont évalué avec précision la sexualité. et les évaluations de perception. Les résultats sont toujours similaires aux observations ResNets à arrêt précoce, avec des ViT plus étroits avec une précision inférieure et fonctionnant mieux que la largeur par défaut. Cependant, les largeurs optimales de ViT-B/8 et ViT-L/4 sont respectivement de 6 % et 12 % de leurs largeurs par défaut. L'article fournit également une liste expérimentale plus détaillée pour d'autres hyperparamètres tels. comme la largeur, la profondeur, le nombre d'étapes d'entraînement, la diminution du poids, le lissage des étiquettes et l'abandon sur ResNet et ViT. Donc, si vous souhaitez améliorer la similarité perçue, la stratégie est simple, il suffit de réduire la précision de manière appropriée. Améliorez le score de perception en réduisant le modèle ImageNet, les valeurs du tableau représentent l'amélioration obtenue en mettant à l'échelle le modèle avec des hyperparamètres donnés par rapport au modèle avec des hyperparamètres par défaut selon la conclusion ci-dessus, nous proposons une stratégie simple pour améliorer le score perceptuel d'une architecture : réduire le modèle pour réduire la précision jusqu'à ce que le score perceptuel optimal soit atteint. L'amélioration du score de perception obtenue en réduisant chaque modèle sur chaque hyperparamètre est également visible dans les résultats expérimentaux. L'arrêt anticipé entraîne l'amélioration du score la plus élevée sur toutes les architectures, à l'exception de ViT-L/4, et l'arrêt anticipé est la stratégie la plus efficace sans nécessiter de longues recherches dans la grille. Dans des travaux antérieurs, la fonction de similarité perceptuelle a été calculée en utilisant la distance euclidienne à travers les dimensions de l'espace image. Cette approche suppose une correspondance directe entre les pixels, mais cette correspondance peut ne pas s'appliquer aux images courbes, translatées ou pivotées. Dans cet article, les chercheurs ont adopté deux fonctions perceptuelles qui reposent sur la représentation globale de l'image, à savoir la fonction de perte de style et la normalisation dans le travail de transfert de style neuronal qui capture la similitude de style entre deux images. fonction. La fonction de perte de style compare la matrice de corrélation croisée inter-canaux entre deux images, tandis que la fonction de pooling moyen compare la représentation globale moyenne spatialement. La fonction globale du perceptron améliore systématiquement le score de perception des hyperparamètres par défaut de la formation réseau et de ResNet-200 en fonction de l'époque de la formation L'article explore également certaines hypothèses pour expliquer l'exactitude et les relations entre les scores de perception et en ont tiré des informations supplémentaires. Par exemple, la précision du modèle sans la connexion de saut couramment utilisée est également inversement proportionnelle au score de perception, les couches plus proches de la sortie ayant en moyenne des scores de perception inférieurs à celles des couches plus proches de l'entrée. Exploration également plus approfondie de la sensibilité à la distorsion, de la granularité de la catégorie ImageNet et de la sensibilité à la fréquence spatiale. En bref, cet article explore la question de savoir si l'amélioration de la précision de la classification produira de meilleures mesures de perception. Il étudie la relation entre la précision et les scores de perception sur les ResNets et les ViT sous différents hyperparamètres, et constate que les scores de perception et la précision présentent un U inversé. relation de type, dans laquelle les scores de précision et de perception sont liés dans une certaine mesure, montrant une relation en forme de U inversé. Enfin, l'article discute en détail de la relation entre la précision et le score de perception, y compris la connexion sautée, la fonction de similarité globale, la sensibilité à la distorsion, le score de perception hiérarchique, la sensibilité à la fréquence spatiale et la granularité des catégories ImageNet. Bien que l'explication exacte du compromis entre la précision d'ImageNet et la similarité perceptuelle reste un mystère, cet article constitue un premier pas en avant.

Fonction perceptuelle globale

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

La multiplication matricielle universelle de CUDA : de l'entrée à la maîtrise !

Mar 25, 2024 pm 12:30 PM

La multiplication matricielle universelle de CUDA : de l'entrée à la maîtrise !

Mar 25, 2024 pm 12:30 PM

La multiplication matricielle générale (GEMM) est un élément essentiel de nombreuses applications et algorithmes, et constitue également l'un des indicateurs importants pour évaluer les performances du matériel informatique. Une recherche approfondie et l'optimisation de la mise en œuvre de GEMM peuvent nous aider à mieux comprendre le calcul haute performance et la relation entre les systèmes logiciels et matériels. En informatique, une optimisation efficace de GEMM peut augmenter la vitesse de calcul et économiser des ressources, ce qui est crucial pour améliorer les performances globales d’un système informatique. Une compréhension approfondie du principe de fonctionnement et de la méthode d'optimisation de GEMM nous aidera à mieux utiliser le potentiel du matériel informatique moderne et à fournir des solutions plus efficaces pour diverses tâches informatiques complexes. En optimisant les performances de GEMM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Les performances de JAX, promu par Google, ont dépassé celles de Pytorch et TensorFlow lors de récents tests de référence, se classant au premier rang sur 7 indicateurs. Et le test n’a pas été fait sur le TPU présentant les meilleures performances JAX. Bien que parmi les développeurs, Pytorch soit toujours plus populaire que Tensorflow. Mais à l’avenir, des modèles plus volumineux seront peut-être formés et exécutés sur la base de la plate-forme JAX. Modèles Récemment, l'équipe Keras a comparé trois backends (TensorFlow, JAX, PyTorch) avec l'implémentation native de PyTorch et Keras2 avec TensorFlow. Premièrement, ils sélectionnent un ensemble de

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L’IA change effectivement les mathématiques. Récemment, Tao Zhexuan, qui a prêté une attention particulière à cette question, a transmis le dernier numéro du « Bulletin de l'American Mathematical Society » (Bulletin de l'American Mathematical Society). En se concentrant sur le thème « Les machines changeront-elles les mathématiques ? », de nombreux mathématiciens ont exprimé leurs opinions. L'ensemble du processus a été plein d'étincelles, intense et passionnant. L'auteur dispose d'une équipe solide, comprenant Akshay Venkatesh, lauréat de la médaille Fields, le mathématicien chinois Zheng Lejun, l'informaticien de l'Université de New York Ernest Davis et de nombreux autres universitaires bien connus du secteur. Le monde de l’IA a radicalement changé. Vous savez, bon nombre de ces articles ont été soumis il y a un an.

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

La détection de cibles est un problème relativement mature dans les systèmes de conduite autonome, parmi lesquels la détection des piétons est l'un des premiers algorithmes à être déployés. Des recherches très complètes ont été menées dans la plupart des articles. Cependant, la perception de la distance à l’aide de caméras fisheye pour une vue panoramique est relativement moins étudiée. En raison de la distorsion radiale importante, la représentation standard du cadre de délimitation est difficile à mettre en œuvre dans les caméras fisheye. Pour alléger la description ci-dessus, nous explorons les conceptions étendues de boîtes englobantes, d'ellipses et de polygones généraux dans des représentations polaires/angulaires et définissons une métrique de segmentation d'instance mIOU pour analyser ces représentations. Le modèle fisheyeDetNet proposé avec une forme polygonale surpasse les autres modèles et atteint simultanément 49,5 % de mAP sur l'ensemble de données de la caméra fisheye Valeo pour la conduite autonome.