Voici comment apprendre à ChatGPT à lire des images

Le modèle « Wen Sheng Tu » sera populaire en 2022, qu'est-ce qui sera populaire en 2023 ?

La réponse de l’ingénieur en apprentissage automatique Daniel Bourke est : l’inverse !

Non, un nouveau modèle de « texte basé sur une image » a explosé sur Internet, et ses excellents effets ont incité de nombreux internautes à le republier et à l'aimer.

Non seulement la fonction de base « regarder des images et parler », mais aussi écrire des poèmes d'amour, expliquer des intrigues, concevoir des dialogues pour les objets en images, etc., cette IA peut tout gérer en douceur !

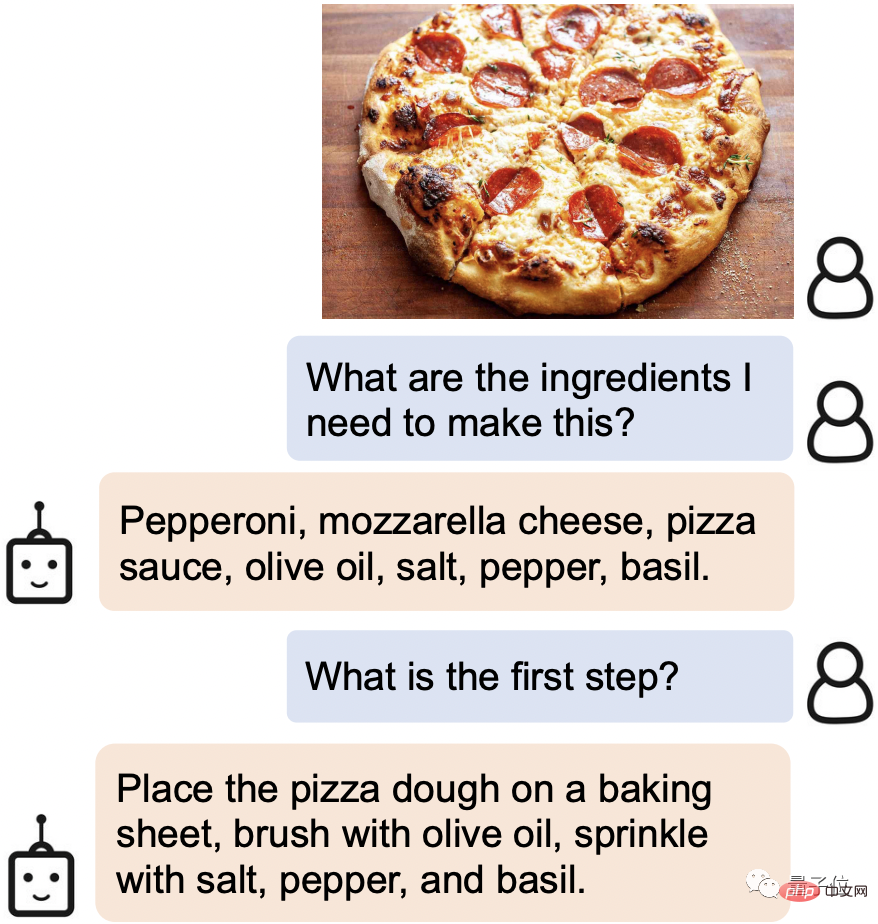

Par exemple, lorsque vous trouvez un plat alléchant en ligne, envoyez-lui simplement la photo, et il reconnaîtra immédiatement les ingrédients et les étapes de cuisson requis :

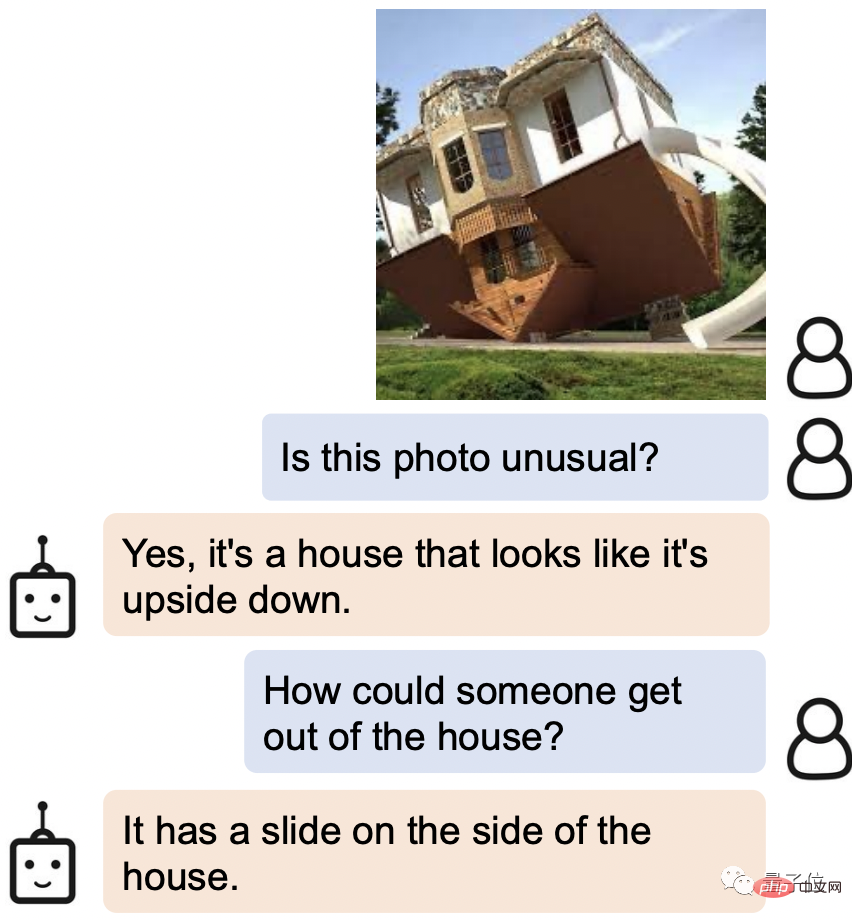

Même certains des détails de la photo de Leeuwenhoek peuvent également être "vu" clairement.

Quand on lui a demandé comment sortir de la maison à l’envers sur la photo, la réponse d’AI a été : n’y a-t-il pas un toboggan sur le côté ?

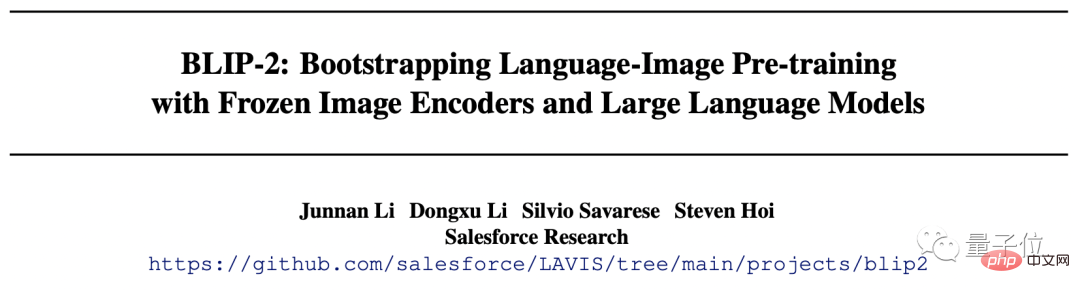

Cette nouvelle IA s'appelle BLIP-2 (Bootstrapping Language-Image Pre-training 2), et le code est actuellement open source.

La chose la plus importante est que, contrairement aux recherches précédentes, BLIP-2 utilise un cadre de pré-formation universel, il peut donc être connecté arbitrairement à votre propre modèle de langage.

Certains internautes réfléchissent déjà à la combinaison puissante après avoir changé l'interface en ChatGPT.

L'un des auteurs, Steven Hoi, a même déclaré : BLIP-2 sera la "version multimodale de ChatGPT" dans le futur.

Alors, quelles sont les autres choses étonnantes à propos de BLIP-2 ? Regardez en bas ensemble.

Excellente capacité de compréhension

BLIP-2 peut être considéré comme étant très diversifié dans son gameplay.

Il vous suffit de fournir une image, et vous pouvez lui parler, et elle peut répondre à diverses exigences telles que raconter des histoires, raisonner et générer un texte personnalisé.

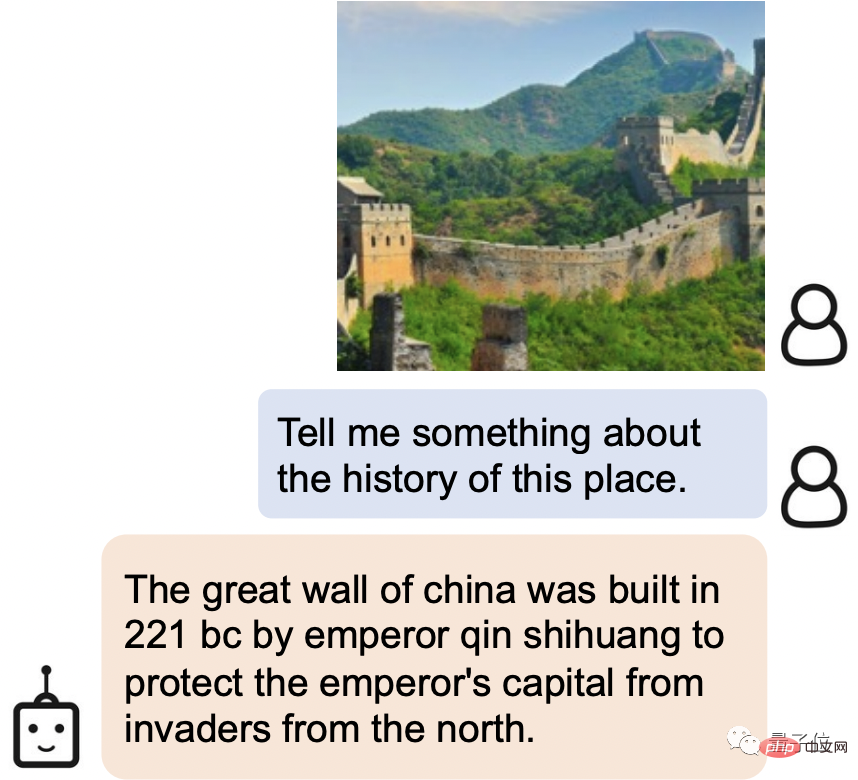

Par exemple, BLIP-2 peut non seulement identifier facilement l'endroit pittoresque de l'image comme étant la Grande Muraille, mais également présenter l'histoire de la Grande Muraille :

La Grande Muraille de Chine a été construite par Qin Shihuang en 221 avant JC pour protéger la capitale impériale de l'invasion du Nord.

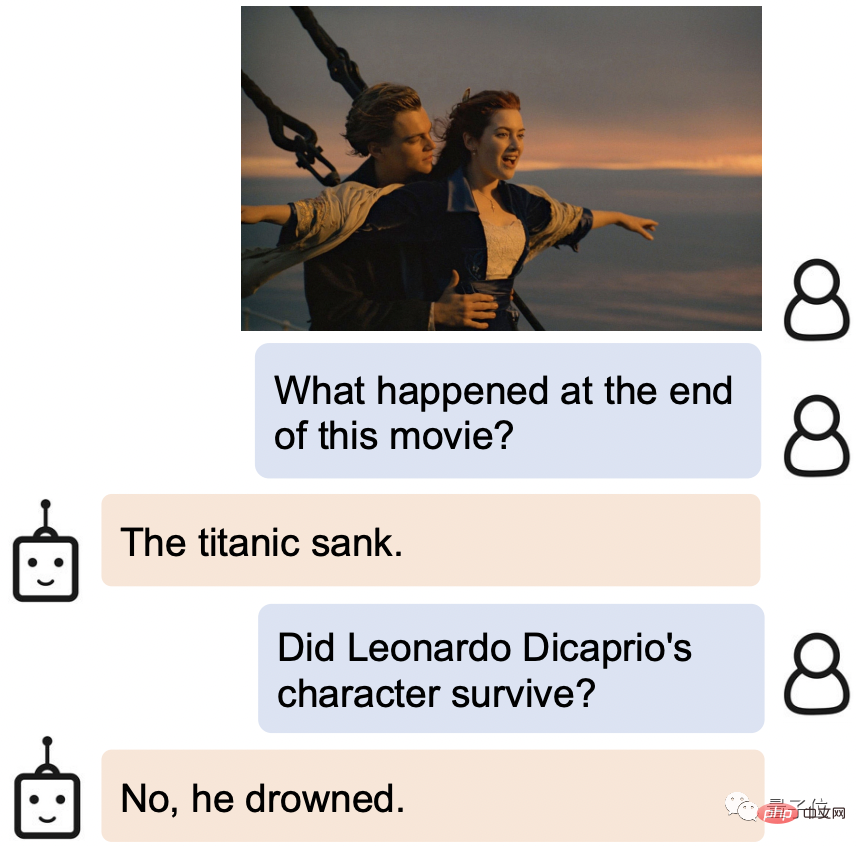

Filmez-le encore, BLIP-2 sait non seulement d'où il vient, mais connaît également la fin de l'histoire : le Titanic a coulé et le héros s'est noyé.

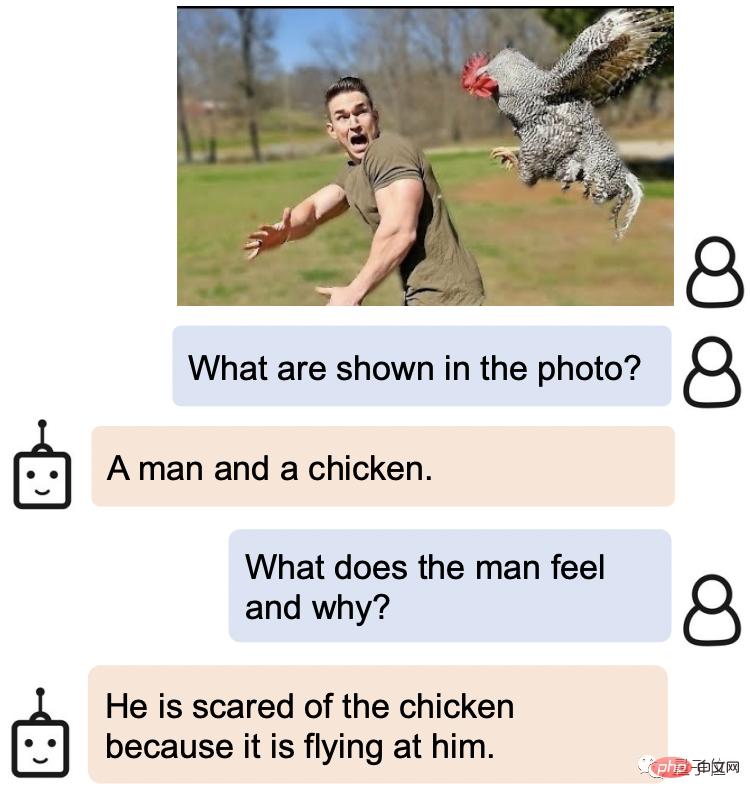

BLIP-2 saisit également très précisément l'expression humaine.

Quand on lui demande quelle est l'expression de l'homme sur cette photo et pourquoi il est comme ça, la réponse de BLIP-2 est : il a peur du poulet parce qu'il vole vers lui.

Ce qui est encore plus étonnant, c'est que BLIP-2 fonctionne également très bien sur de nombreuses questions ouvertes.

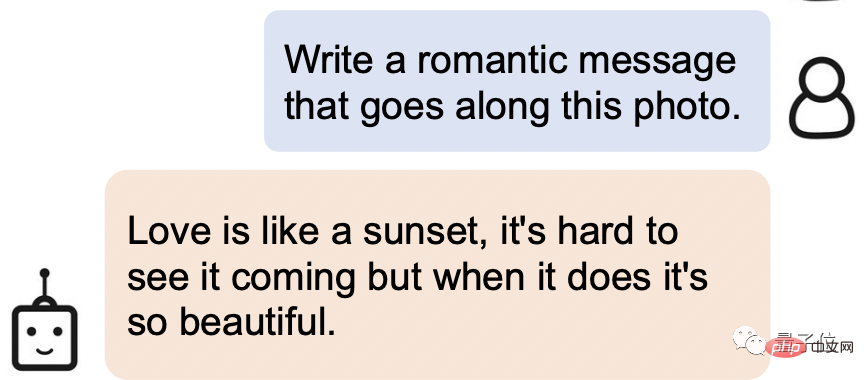

Demandez-lui d'écrire une phrase romantique basée sur l'image ci-dessous :

Voici la réponse : L'amour est comme un coucher de soleil, c'est difficile de le voir venir, mais quand ça arrive, c'est tellement beau.

Non seulement cette personne a une parfaite capacité de compréhension, mais ses connaissances littéraires sont également assez fortes !

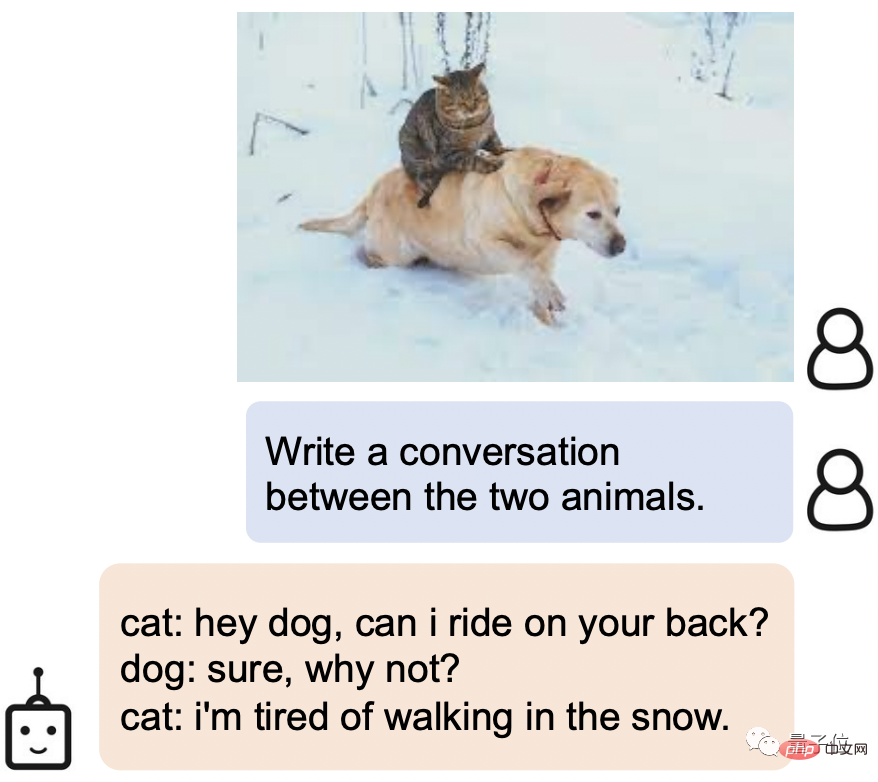

Laissez-le générer un dialogue pour les deux animaux de l'image. BLIP-2 peut également facilement gérer le paramètre chat arrogant x chien idiot :

.Chat : Hé, chien, puis-je monter sur ton dos ?

Chien : Bien sûr, pourquoi pas ?

Chat : J'en ai marre de marcher dans la neige.

Alors, comment BLIP-2 atteint-il une capacité de compréhension aussi puissante ?

Réalisez un nouveau SOTA sur plusieurs tâches de langage visuel

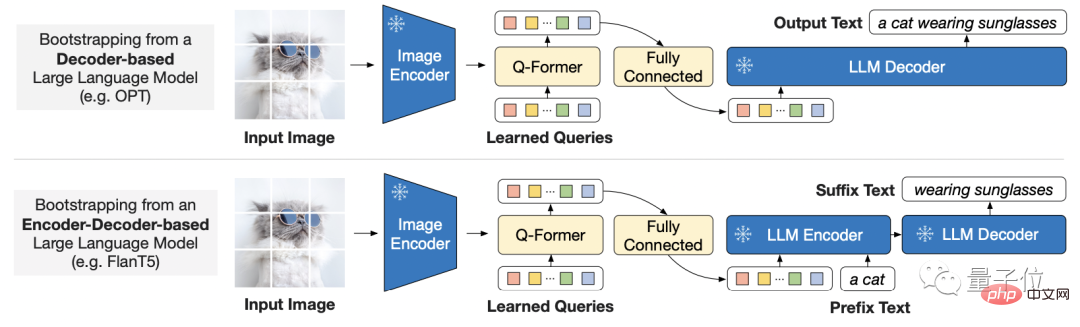

Considérant le coût croissant de la formation de bout en bout de modèles à grande échelle, BLIP-2 utilise une stratégie de pré-formation générale et efficace :

Provenant du commerce Pré-entraînement guidé du langage visuel dans des encodeurs d'images pré-entraînés gelés et de grands modèles de langage gelés.

Cela signifie également que chacun peut choisir le modèle qu'il souhaite utiliser.

Afin de combler le fossé entre les modes, le chercheur a proposé un transformateur de requête léger.

Ce Transformer est pré-entraîné en deux étapes :

La première étape amorce l'apprentissage de la représentation visuelle du langage à partir d'un encodeur d'image figé, et la deuxième étape amorce la vision d'un modèle de langage figé à l'apprentissage de la génération de langage.

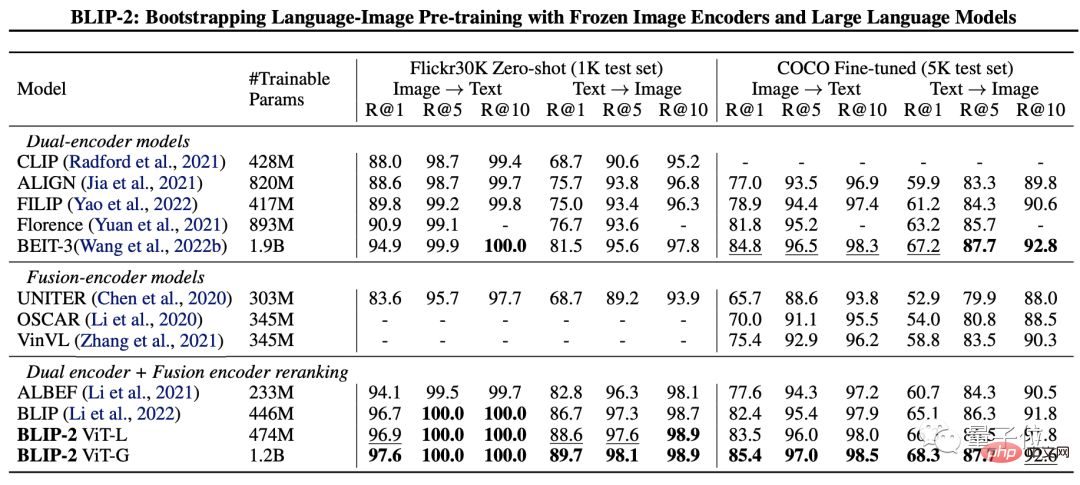

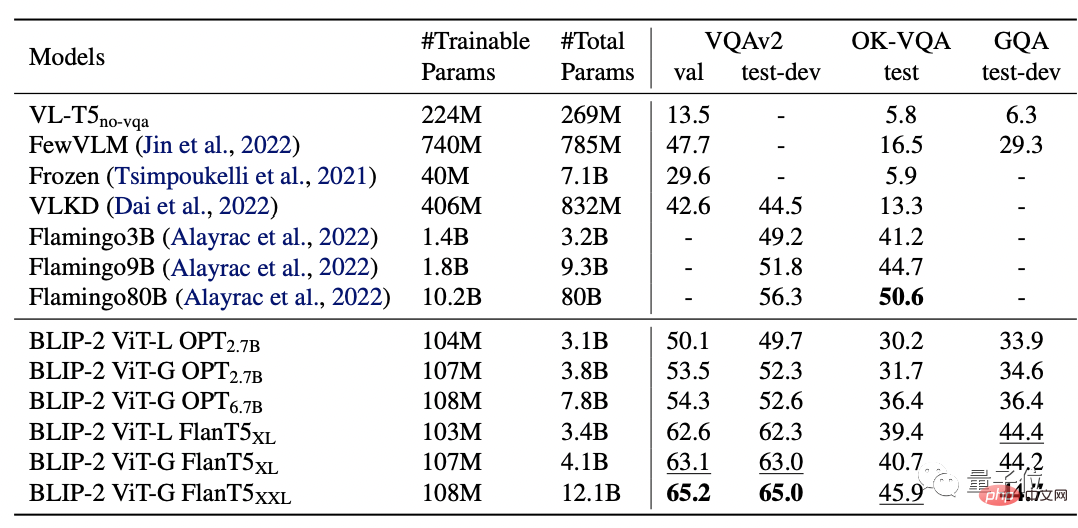

Afin de tester les performances de BLIP-2, les chercheurs l'ont évalué sur des tâches de génération de texte d'image zéro, de réponse visuelle à des questions, de récupération de texte d'image et de sous-titrage d'image.

Les résultats finaux montrent que BLIP-2 a atteint SOTA sur plusieurs tâches de langage visuel.

Parmi eux, BLIP-2 est 8,7% plus élevé que Flamingo 80B sur Zero-shot VQAv2, et les paramètres d'entraînement sont réduits de 54 fois.

Et il est évident qu’un encodeur d’image plus puissant ou un modèle de langage plus puissant donnera de meilleures performances.

Il convient de mentionner que le chercheur a également mentionné à la fin de l'article que BLIP-2 présente encore une lacune, à savoir le manque de capacité d'apprentissage du contexte :

Chaque échantillon ne contient qu'une seule image- paire de texte, il n'est actuellement pas possible d'apprendre des corrélations entre plusieurs paires image-texte en une seule séquence.

Équipe de recherche

L'équipe de recherche de BLIP-2 est issue de Salesforce Research.

Le premier auteur est Junnan Li, qui est également le premier auteur de BLIP lancé il y a un an.

Actuellement, il est chercheur scientifique principal au Salesforce Asia Research Institute. Diplômé de l'Université de Hong Kong avec un baccalauréat et un doctorat de l'Université nationale de Singapour.

Le champ de recherche est très large, incluant l'apprentissage auto-supervisé, l'apprentissage semi-supervisé, l'apprentissage faiblement supervisé et le langage visuel.

Ce qui suit est le lien papier et le lien GitHub du BLIP-2. Les amis intéressés peuvent le récupérer ~

Lien papier : https://arxiv.org/pdf/2301.12597.pdf

Lien GitHub : https: /. /github.com/salesforce/LAVIS/tree/main/projects/blip2

Lien de référence : [1]https://twitter.com/mrdbourke/status/1620353263651688448

[2]https://twitter com. /LiJunnan0409/status/1620259379223343107

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

Le DALL-E 3 a été officiellement introduit en septembre 2023 en tant que modèle considérablement amélioré par rapport à son prédécesseur. Il est considéré comme l’un des meilleurs générateurs d’images IA à ce jour, capable de créer des images avec des détails complexes. Cependant, au lancement, c'était exclu

Comment écrire un roman dans l'application Tomato Free Novel Partagez le tutoriel sur la façon d'écrire un roman dans l'application Tomato Novel

Mar 28, 2024 pm 12:50 PM

Comment écrire un roman dans l'application Tomato Free Novel Partagez le tutoriel sur la façon d'écrire un roman dans l'application Tomato Novel

Mar 28, 2024 pm 12:50 PM

Tomato Novel est un logiciel de lecture de romans très populaire. Nous avons souvent de nouveaux romans et bandes dessinées à lire dans Tomato Novel. De nombreux amis souhaitent également gagner de l'argent de poche et éditer le contenu de leur roman. Je veux écrire dans du texte. Alors, comment pouvons-nous y écrire le roman ? Mes amis ne le savent pas, alors allons ensemble sur ce site. Prenons le temps de regarder une introduction à la façon d'écrire un roman. Partagez le didacticiel du roman Tomato sur la façon d'écrire un roman. 1. Ouvrez d'abord l'application de roman gratuite Tomato sur votre téléphone mobile et cliquez sur Personal Center - Writer Center 2. Accédez à la page Tomato Writer Assistant - cliquez sur Créer un nouveau livre. à la fin du roman.

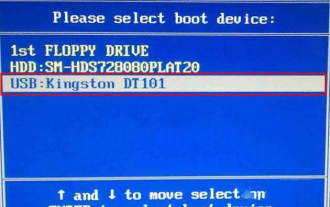

Comment entrer dans le bios sur la carte mère Colorful ? Apprenez-vous deux méthodes

Mar 13, 2024 pm 06:01 PM

Comment entrer dans le bios sur la carte mère Colorful ? Apprenez-vous deux méthodes

Mar 13, 2024 pm 06:01 PM

Les cartes mères colorées jouissent d'une grande popularité et d'une part de marché élevée sur le marché intérieur chinois, mais certains utilisateurs de cartes mères colorées ne savent toujours pas comment accéder au BIOS pour les paramètres ? En réponse à cette situation, l'éditeur vous a spécialement proposé deux méthodes pour accéder au bios coloré de la carte mère. Venez l'essayer ! Méthode 1 : utilisez la touche de raccourci de démarrage du disque U pour accéder directement au système d'installation du disque U. La touche de raccourci de la carte mère Colorful pour démarrer le disque U en un seul clic est ESC ou F11. Tout d'abord, utilisez Black Shark Installation Master pour créer un Black. Disque de démarrage Shark U, puis allumez l'ordinateur lorsque vous voyez l'écran de démarrage, appuyez continuellement sur la touche ESC ou F11 du clavier pour accéder à une fenêtre de sélection de la séquence d'éléments de démarrage. Déplacez le curseur à l'endroit où "USB. " s'affiche, puis

Comment récupérer des contacts supprimés sur WeChat (un tutoriel simple vous explique comment récupérer des contacts supprimés)

May 01, 2024 pm 12:01 PM

Comment récupérer des contacts supprimés sur WeChat (un tutoriel simple vous explique comment récupérer des contacts supprimés)

May 01, 2024 pm 12:01 PM

Malheureusement, les gens suppriment souvent certains contacts accidentellement pour certaines raisons. WeChat est un logiciel social largement utilisé. Pour aider les utilisateurs à résoudre ce problème, cet article explique comment récupérer les contacts supprimés de manière simple. 1. Comprendre le mécanisme de suppression des contacts WeChat. Cela nous offre la possibilité de récupérer les contacts supprimés. Le mécanisme de suppression des contacts dans WeChat les supprime du carnet d'adresses, mais ne les supprime pas complètement. 2. Utilisez la fonction intégrée « Récupération du carnet de contacts » de WeChat. WeChat fournit une « Récupération du carnet de contacts » pour économiser du temps et de l'énergie. Les utilisateurs peuvent récupérer rapidement les contacts précédemment supprimés grâce à cette fonction. 3. Accédez à la page des paramètres WeChat et cliquez sur le coin inférieur droit, ouvrez l'application WeChat « Moi » et cliquez sur l'icône des paramètres dans le coin supérieur droit pour accéder à la page des paramètres.

Comment définir la taille de la police sur le téléphone mobile (ajustez facilement la taille de la police sur le téléphone mobile)

May 07, 2024 pm 03:34 PM

Comment définir la taille de la police sur le téléphone mobile (ajustez facilement la taille de la police sur le téléphone mobile)

May 07, 2024 pm 03:34 PM

La définition de la taille de la police est devenue une exigence de personnalisation importante à mesure que les téléphones mobiles deviennent un outil important dans la vie quotidienne des gens. Afin de répondre aux besoins des différents utilisateurs, cet article présentera comment améliorer l'expérience d'utilisation du téléphone mobile et ajuster la taille de la police du téléphone mobile grâce à des opérations simples. Pourquoi avez-vous besoin d'ajuster la taille de la police de votre téléphone mobile - L'ajustement de la taille de la police peut rendre le texte plus clair et plus facile à lire - Adapté aux besoins de lecture des utilisateurs d'âges différents - Pratique pour les utilisateurs malvoyants qui souhaitent utiliser la taille de la police fonction de configuration du système de téléphonie mobile - Comment accéder à l'interface des paramètres du système - Dans Rechercher et entrez l'option "Affichage" dans l'interface des paramètres - recherchez l'option "Taille de la police" et ajustez-la. application - téléchargez et installez une application prenant en charge l'ajustement de la taille de la police - ouvrez l'application et entrez dans l'interface des paramètres appropriée - en fonction de l'individu

Le secret de l'éclosion des œufs de dragon mobiles est révélé (étape par étape pour vous apprendre à réussir l'éclosion des œufs de dragon mobiles)

May 04, 2024 pm 06:01 PM

Le secret de l'éclosion des œufs de dragon mobiles est révélé (étape par étape pour vous apprendre à réussir l'éclosion des œufs de dragon mobiles)

May 04, 2024 pm 06:01 PM

Les jeux mobiles font désormais partie intégrante de la vie des gens avec le développement de la technologie. Il a attiré l'attention de nombreux joueurs avec sa jolie image d'œuf de dragon et son processus d'éclosion intéressant, et l'un des jeux qui a beaucoup attiré l'attention est la version mobile de Dragon Egg. Pour aider les joueurs à mieux cultiver et faire grandir leurs propres dragons dans le jeu, cet article vous présentera comment faire éclore des œufs de dragon dans la version mobile. 1. Choisissez le type d'œuf de dragon approprié. Les joueurs doivent choisir soigneusement le type d'œuf de dragon qu'ils aiment et qui leur conviennent, en fonction des différents types d'attributs et de capacités d'œuf de dragon fournis dans le jeu. 2. Améliorez le niveau de la machine d'incubation. Les joueurs doivent améliorer le niveau de la machine d'incubation en accomplissant des tâches et en collectant des accessoires. Le niveau de la machine d'incubation détermine la vitesse d'éclosion et le taux de réussite de l'éclosion. 3. Collectez les ressources nécessaires à l'éclosion. Les joueurs doivent être dans le jeu.

Maîtrisez rapidement : comment ouvrir deux comptes WeChat sur les téléphones mobiles Huawei révélé !

Mar 23, 2024 am 10:42 AM

Maîtrisez rapidement : comment ouvrir deux comptes WeChat sur les téléphones mobiles Huawei révélé !

Mar 23, 2024 am 10:42 AM

Dans la société actuelle, les téléphones portables sont devenus un élément indispensable de nos vies. En tant qu'outil important pour notre communication, notre travail et notre vie quotidienne, WeChat est souvent utilisé. Cependant, il peut être nécessaire de séparer deux comptes WeChat lors du traitement de différentes transactions, ce qui nécessite que le téléphone mobile prenne en charge la connexion à deux comptes WeChat en même temps. En tant que marque nationale bien connue, les téléphones mobiles Huawei sont utilisés par de nombreuses personnes. Alors, quelle est la méthode pour ouvrir deux comptes WeChat sur les téléphones mobiles Huawei ? Dévoilons le secret de cette méthode. Tout d'abord, vous devez utiliser deux comptes WeChat en même temps sur votre téléphone mobile Huawei. Le moyen le plus simple est de le faire.

La différence entre les méthodes et fonctions du langage Go et l'analyse des scénarios d'application

Apr 04, 2024 am 09:24 AM

La différence entre les méthodes et fonctions du langage Go et l'analyse des scénarios d'application

Apr 04, 2024 am 09:24 AM

La différence entre les méthodes et les fonctions du langage Go réside dans leur association avec des structures : les méthodes sont associées à des structures et sont utilisées pour faire fonctionner des données de structure ou des fonctions de méthodes sont indépendantes des types et sont utilisées pour effectuer des opérations générales ;