Périphériques technologiques

Périphériques technologiques

IA

IA

Est-ce le prototype de la version Meta de ChatGPT ? Open source, peut fonctionner sur un seul GPU, bat GPT-3 avec 1/10 du nombre de paramètres

Est-ce le prototype de la version Meta de ChatGPT ? Open source, peut fonctionner sur un seul GPU, bat GPT-3 avec 1/10 du nombre de paramètres

Est-ce le prototype de la version Meta de ChatGPT ? Open source, peut fonctionner sur un seul GPU, bat GPT-3 avec 1/10 du nombre de paramètres

Les très grands modèles avec des centaines de milliards ou des milliards de paramètres ont besoin de quelqu'un pour les étudier, tout comme les grands modèles avec des milliards ou des dizaines de milliards de paramètres.

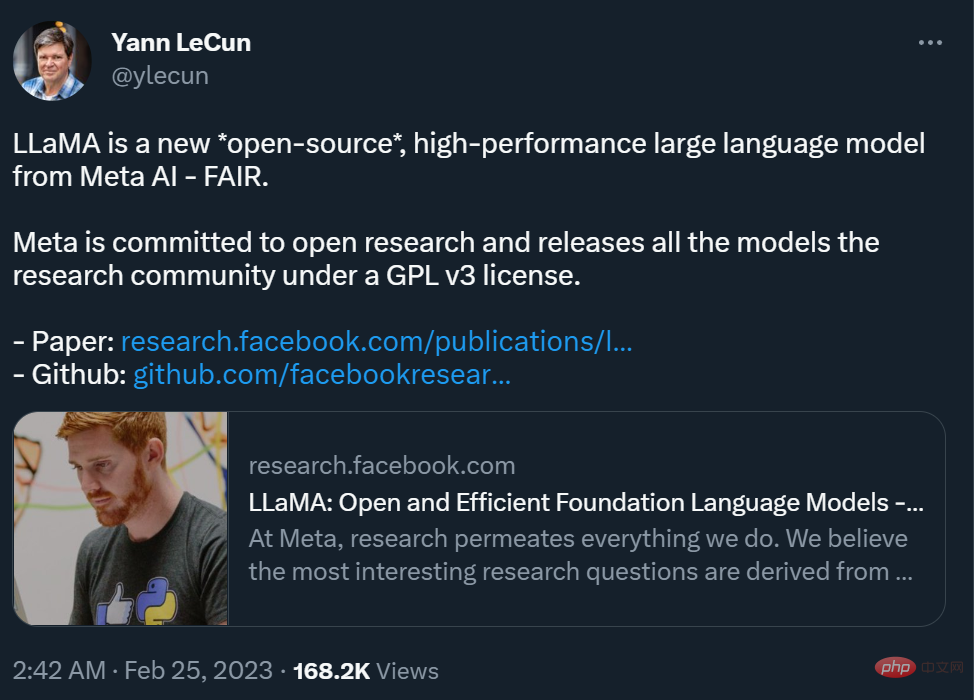

Tout à l'heure, Yann LeCun, scientifique en chef de l'IA chez Meta, a annoncé avoir "open source" une nouvelle grande série de modèles - LLaMA (Large Language Model Meta AI), avec des paramètres allant de 7 milliards à 65 milliards. Les performances de ces modèles sont excellentes : le modèle LLaMA avec 13 milliards de paramètres peut surpasser GPT-3 (175 milliards de paramètres) « sur la plupart des benchmarks » et peut fonctionner sur un seul GPU V100 tandis que le plus grand modèle paramétrique LLaMA de 65 milliards est comparable ; aux Chinchilla-70B et PaLM-540B de Google.

Comme nous le savons tous, les paramètres sont des variables utilisées par les modèles d'apprentissage automatique pour prédire ou classer en fonction des données d'entrée. Le nombre de paramètres dans un modèle de langage est un facteur clé affectant ses performances. Les modèles plus grands sont généralement capables de gérer des tâches plus complexes et de produire des résultats plus cohérents, ce que Richard Sutton appelle une « leçon amère ». Au cours des dernières années, les grands géants de la technologie ont lancé une course aux armements autour de grands modèles comportant des centaines de milliards et des milliards de paramètres, améliorant considérablement les performances des modèles d’IA.

Cependant, ce type de compétition de recherche visant à concourir pour la « capacité monétaire » n'est pas favorable aux chercheurs ordinaires qui ne travaillent pas pour des géants de la technologie, et entrave leurs recherches sur les principes de fonctionnement des grands modèles et les solutions potentielles aux problèmes. De plus, dans les applications pratiques, davantage de paramètres occuperont plus d’espace et nécessiteront plus de ressources informatiques pour fonctionner, ce qui entraînera des coûts d’application élevés pour les grands modèles. Par conséquent, si un modèle peut obtenir les mêmes résultats qu’un autre modèle avec moins de paramètres, cela représente une augmentation significative de l’efficacité. Ceci est très convivial pour les chercheurs ordinaires et il sera plus facile de déployer le modèle dans des environnements réels. C’est le but des recherches de Meta.

"Je pense maintenant que d'ici un an ou deux, nous exécuterons des modèles de langage avec une partie importante des capacités de ChatGPT sur nos téléphones et ordinateurs portables (haut de gamme)," Simon Willison, chercheur indépendant en intelligence artificielle. analysé le nouveau modèle d'IA de Meta L'impact a été écrit quand.

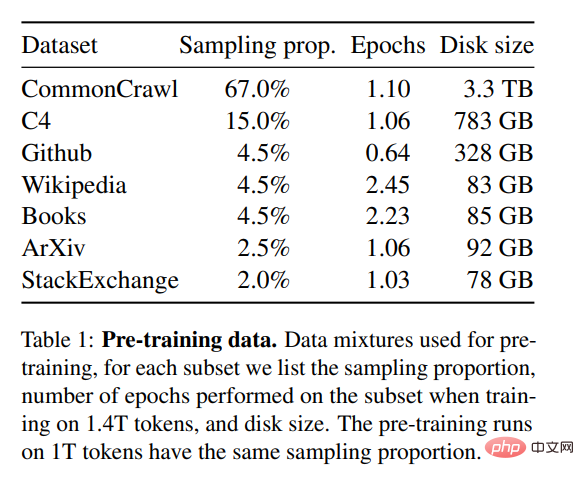

Afin d'entraîner ce modèle tout en répondant aux exigences d'open source et de reproductibilité, Meta utilise uniquement des ensembles de données accessibles au public, ce qui est différent de la plupart des grands modèles qui s'appuient sur des données non publiques. Ces modèles ne sont souvent pas open source et constituent des actifs privés de grands géants de la technologie. Afin d'améliorer les performances du modèle, Meta s'est entraîné sur davantage de jetons : LLaMA 65B et LLaMA 33B ont été formés sur 1 400 milliards de jetons, et le plus petit LLaMA 7B a également utilisé 1 000 milliards de jetons.

Sur Twitter, LeCun a également montré quelques résultats de continuation de texte en utilisant le modèle LLaMA. Il a été demandé au mannequin de poursuivre : « Saviez-vous que Yann LeCun a sorti un album de rap l'année dernière ? Nous l'avons écouté et voici ce que nous en avons pensé : ____ » En termes d'utilisation commerciale, les différences entre le blog Meta et les déclarations de LeCun sur Twitter ont suscité une certaine controverse.

https://docs.google.com/forms/d/e/1FAIpQLSfqNECQnMkycAp2jP4Z9TFX0cGR4uf7b_fBxjY_OjhJILlKGA/viewform

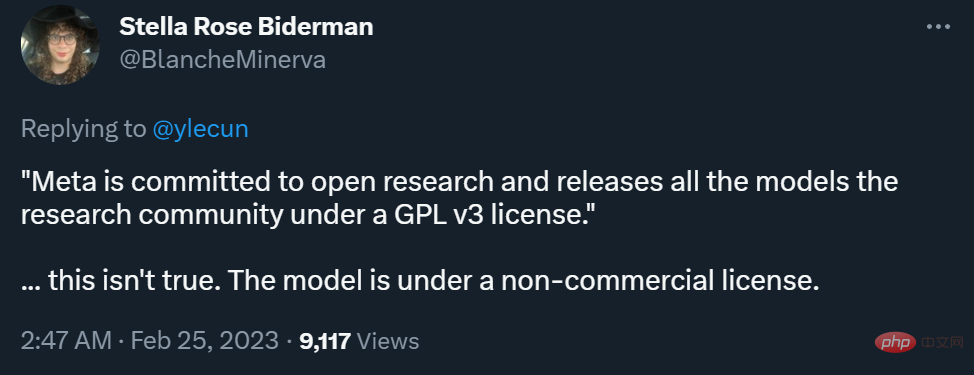

LeCun a déclaré que Meta s'engage dans la recherche ouverte et publie tous les modèles à la communauté des chercheurs sous la licence GPL v3 (GPL v3 permet une utilisation commerciale).

Cette déclaration est assez controversée car il n'a pas précisé si le « modèle » ici fait référence au code ou aux poids, ou aux deux. De l’avis de nombreux chercheurs, le poids du modèle est bien plus important que le code.

À cet égard, LeCun a expliqué que ce qui est ouvert sous la licence GPL v3 est le code du modèle.

Certaines personnes pensent que ce niveau d'ouverture n'est pas une véritable « démocratisation de l'IA ».

Actuellement, Meta a téléchargé l'article sur arXiv, et certains contenus ont également été téléchargés sur le référentiel GitHub. Vous pouvez aller le parcourir.

- Lien papier : https://research.facebook.com/publications/llama-open-and-efficient-foundation-lingual-models/

- Lien GitHub : https ://github.com/facebookresearch/llama

Research Overview

Les grands modèles de langage (LLM) formés sur des corpus de textes à grande échelle ont montré leur capacité à effectuer de nouvelles tâches à partir d'invites de texte ou à partir d'un petit nombre de tâche d'échantillons. Ces propriétés en quelques plans sont apparues pour la première fois lors de la mise à l'échelle de modèles à une échelle suffisamment grande, donnant naissance à une ligne de travail axée sur la mise à l'échelle ultérieure de ces modèles.

Ces efforts reposent sur l'hypothèse selon laquelle davantage de paramètres conduiront à de meilleures performances. Cependant, des travaux récents de Hoffmann et al. (2022) montrent que pour un budget de calcul donné, les meilleures performances ne sont pas obtenues par les modèles les plus grands, mais par des modèles plus petits entraînés sur davantage de données. L'objectif des lois de mise à l'échelle proposées par

Hoffmann et al. (2022) est de déterminer la meilleure façon de mettre à l'échelle la taille des ensembles de données et des modèles dans le cadre d'un budget de calcul d'entraînement spécifique. Cependant, cet objectif ignore le budget d'inférence, qui devient critique lors de la diffusion de modèles de langage à grande échelle. Dans ce cas, étant donné un niveau de performance cible, le modèle privilégié n’est pas le plus rapide à entraîner, mais le plus rapide à déduire. Même s’il peut être moins coûteux d’entraîner un grand modèle pour atteindre un certain niveau de performance, un modèle plus petit dont l’entraînement prend plus de temps sera finalement moins cher en termes d’inférence. Par exemple, bien que Hoffmann et al. (2022) aient recommandé de former un modèle 10B sur des jetons 200B, les chercheurs ont constaté que les performances du modèle 7B continuaient de s'améliorer même après des jetons 1T.

L'objectif de ce travail est de former une famille de modèles de langage pour obtenir des performances optimales avec une variété de budgets d'inférence en s'entraînant sur plus de jetons que ceux généralement utilisés. Le modèle résultant, appelé LLaMA, a des paramètres allant de 7B à 65B et fonctionne de manière compétitive avec les meilleurs LLM existants. Par exemple, bien qu’il soit 10 fois plus petit que GPT-3, LLaMA-13B surpasse GPT-3 sur la plupart des benchmarks.

Les chercheurs affirment que ce modèle contribuera à démocratiser la recherche LLM car il peut fonctionner sur un seul GPU. À des échelles supérieures, le modèle paramétrique LLaMA-65B est également comparable aux meilleurs grands modèles linguistiques tels que Chinchilla ou PaLM-540B.

Contrairement à Chinchilla, PaLM ou GPT-3, ce modèle utilise uniquement des données accessibles au public, ce qui rend ce travail compatible open source, alors que la plupart des modèles existants s'appuient sur des données qui ne sont pas accessibles au public ou non documentées (par exemple Books-2TB ou réseaux sociaux). conversations médiatiques). Il existe bien sûr quelques exceptions, notamment OPT (Zhang et al., 2022), GPT-NeoX (Black et al., 2022), BLOOM (Scao et al., 2022) et GLM (Zeng et al., 2022), Mais aucun ne peut rivaliser avec le PaLM-62B ou le Chinchilla.

Le reste de cet article décrit les modifications apportées par les chercheurs à l'architecture du transformateur et aux méthodes de formation. Les performances du modèle sont ensuite présentées et comparées à d'autres grands modèles de langage sur un ensemble de tests standards. Enfin, nous démontrons les biais et la toxicité des modèles en utilisant certains des derniers benchmarks de la communauté responsable de l’IA.

Aperçu de la méthode

La méthode de formation utilisée par les chercheurs est similaire à la méthode décrite dans des travaux antérieurs tels que (Brown et al., 2020), (Chowdhery et al., 2022), et est soumise à la mise à l'échelle du Chinchilla. lois (Hoffmann et al., 2022). Les chercheurs ont utilisé un optimiseur standard pour entraîner de grands transformateurs sur de grandes quantités de données textuelles.

Données de pré-entraînement

Comme le montre le tableau 1, l'ensemble de données de formation pour cette étude est un mélange de plusieurs sources, couvrant différents domaines. Dans la plupart des cas, les chercheurs réutilisent des sources de données qui ont été utilisées pour former d'autres grands modèles de langage, mais la restriction ici est que seules les données accessibles au public peuvent être utilisées et qu'elles sont compatibles avec les ressources ouvertes. La combinaison de données et leurs pourcentages dans l'ensemble de formation sont les suivants :

- Anglais CommonCrawl [67%]

- C4 [15%] ; Wikipédia [4,5%];

- Gutenberg et Books3 [4,5%];

- ArXiv [2,5%]

- Stack Exchange [2%].

- L'ensemble des données de formation contient environ 1,4T de jetons après tokenisation. Pour la plupart des données de formation, chaque jeton n'est utilisé qu'une seule fois pendant la formation, à l'exception des domaines Wikipédia et Books, sur lesquels nous effectuons environ deux époques.

Basée sur des travaux récents sur de grands modèles de langage, cette recherche utilise également l'architecture du transformateur. Les chercheurs se sont appuyés sur diverses améliorations qui ont ensuite été proposées et utilisées dans différents modèles, tels que PaLM. Dans l'article, les chercheurs ont présenté ses principales différences par rapport à l'architecture originale :

Pré-normalisation [GPT3]. Afin d'améliorer la stabilité de la formation, les chercheurs ont normalisé l'entrée de chaque sous-couche du transformateur au lieu de normaliser la sortie. Ils ont utilisé la fonction de normalisation RMSNorm proposée par Zhang et Sennrich (2019).

Fonction d'activation SwiGLU [PaLM]. Les chercheurs ont utilisé la fonction d'activation SwiGLU proposée par Shazeer (2020) pour remplacer la non-linéarité ReLU afin d'améliorer les performances. Ils utilisent respectivement les dimensions 2D, 3D et 4D au lieu de 4D dans PaLM.

- Rotation Intégration [GPTNeo]. Les chercheurs ont supprimé l’intégration de position absolue et ajouté l’intégration de position pivotée (RoPE) proposée par Su et al (2021) à chaque couche du réseau. Les détails des hyperparamètres des différents modèles peuvent être trouvés dans le tableau 2. Dans le tableau 3, les chercheurs comparent avec des modèles existants de différentes tailles et rapportent les résultats dans le numéro de papier correspondant. Premièrement, le LLaMA-65B surpasse le Chinchilla-70B sur tous les tests rapportés, à l'exception de BoolQ. Encore une fois, ce modèle surpasse le PaLM540B dans tous les aspects sauf sur BoolQ et WinoGrande. Le modèle LLaMA-13B surpasse également le GPT-3 sur la plupart des benchmarks bien qu'il soit 10 fois plus petit.

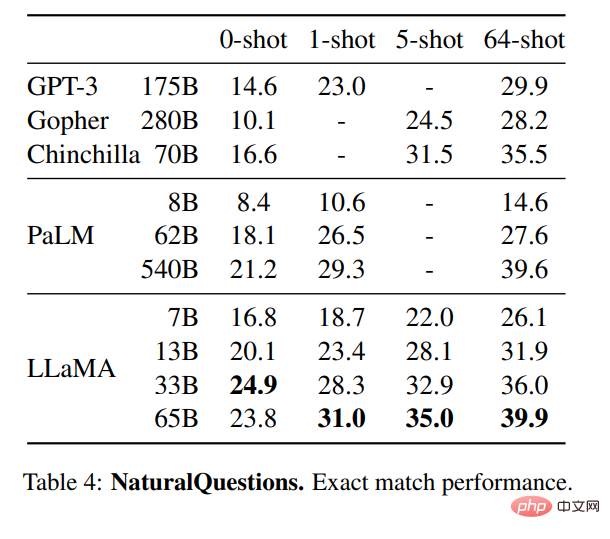

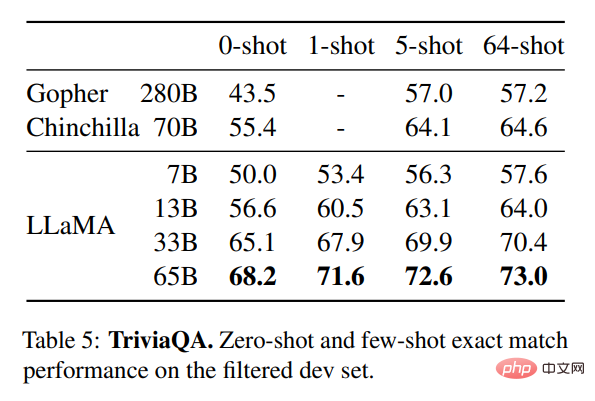

- Réponses à livre fermé

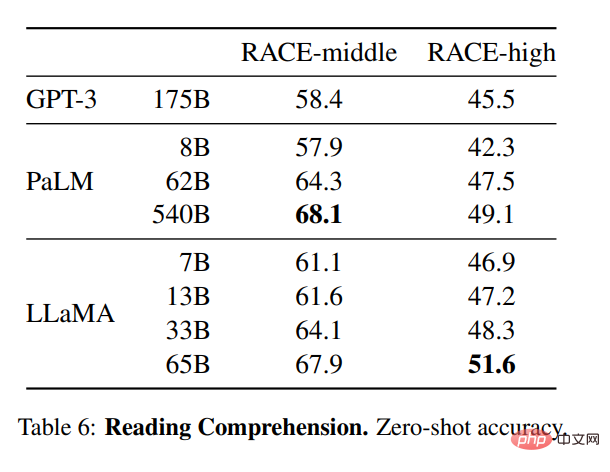

Le tableau 4 montre les performances de NaturalQuestions et le tableau 5 montre les performances de TriviaQA. Dans les deux benchmarks, le LLaMA-65B atteint des performances de pointe dans les réglages de zéro et de quelques coups. De plus, LLaMA-13B est tout aussi compétitif sur ces critères, bien qu'il soit entre un cinquième et un dixième de la taille de GPT-3 et de Chinchilla. Le processus d'inférence du modèle est exécuté sur un seul GPU V100. Les chercheurs ont également évalué le modèle sur la base de référence de compréhension en lecture RACE (Lai et al., 2017). La configuration d'évaluation de Brown et al. (2020) est suivie ici et le tableau 6 montre les résultats de l'évaluation. Sur ces benchmarks, LLaMA-65B est compétitif avec PaLM-540B et LLaMA-13B surpasse le GPT-3 de plusieurs points de pourcentage.

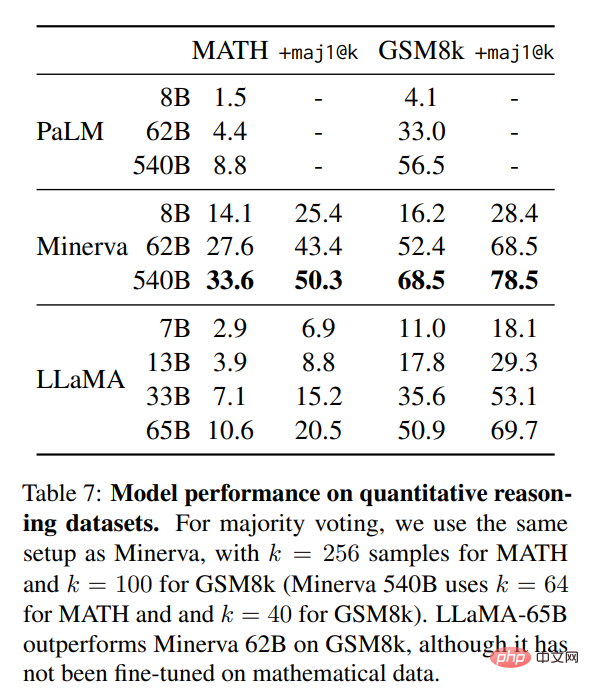

Raisonnement mathématique

Raisonnement mathématique

Dans le tableau 7, les chercheurs l'ont comparé à PaLM et Minerva (Lewkowycz et al., 2022). Sur GSM8k, ils ont observé que LLaMA65B surpassait Minerva-62B, bien qu’il n’ait pas été affiné sur les données mathématiques.

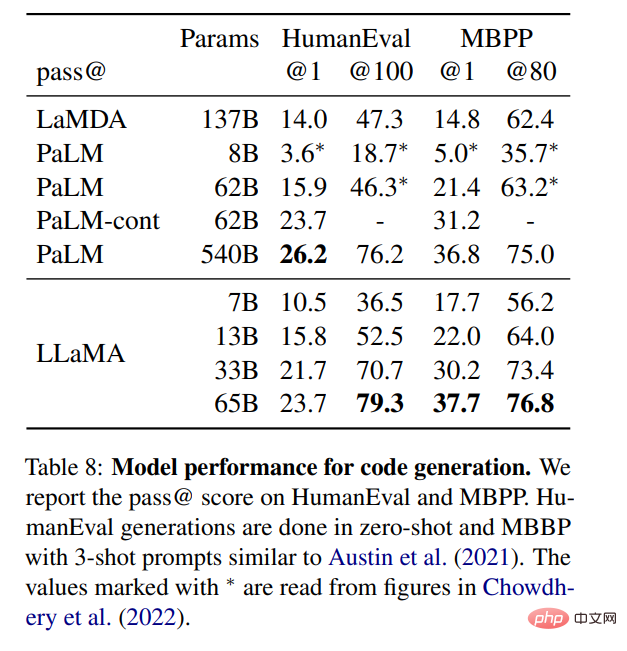

Génération de code

Génération de code

Comme le montre le tableau 8, pour un nombre similaire de paramètres, LLaMA fonctionne mieux que d'autres modèles généraux, tels que LaMDA et PaLM, qui n'ont pas été dédiés formation au code ou mise au point. Sur HumanEval et MBPP, LLaMA dépasse LaMDA de 137B pour les paramètres supérieurs à 13B. LLaMA 65B surpasse également le PaLM 62B, même si son entraînement prend plus de temps.

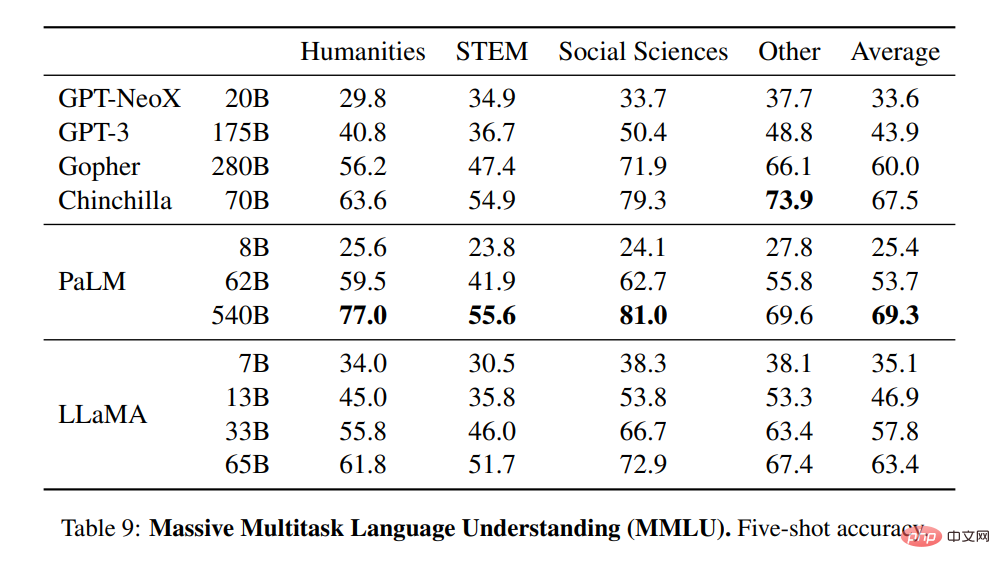

Compréhension du langage multitâche à grande échelle

Compréhension du langage multitâche à grande échelle

Les chercheurs ont utilisé les exemples fournis par le benchmark pour évaluer le modèle dans le cas à 5 coups et montrer les résultats dans le tableau 9 . Sur ce point de référence, ils ont observé que LLaMA-65B était en retard sur Chinchilla70B et PaLM-540B de quelques points de pourcentage en moyenne dans la plupart des domaines. Une explication potentielle est que les chercheurs ont utilisé un nombre limité de livres et d'articles universitaires dans les données de pré-formation, à savoir ArXiv, Gutenberg et Books3, qui totalisaient seulement 177 Go, alors que les modèles ont été formés sur jusqu'à 2 To de livres. Le grand nombre de livres utilisés par Gopher, Chinchilla et PaLM peut également expliquer pourquoi Gopher surpasse GPT-3 sur ce benchmark mais est à égalité sur d'autres benchmarks.

Changements de performances pendant la formation

Changements de performances pendant la formation

Pendant la période de formation, les chercheurs ont suivi les performances du modèle LLaMA sur certaines réponses à des questions et des points de repère de bon sens, et les résultats sont présentés dans la figure 2. Les performances s'améliorent régulièrement sur la plupart des benchmarks et sont positivement corrélées à la perplexité de formation du modèle (voir Figure 1).

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment optimiser les performances de Debian Readdir

Apr 13, 2025 am 08:48 AM

Comment optimiser les performances de Debian Readdir

Apr 13, 2025 am 08:48 AM

Dans Debian Systems, les appels du système ReadDir sont utilisés pour lire le contenu des répertoires. Si ses performances ne sont pas bonnes, essayez la stratégie d'optimisation suivante: simplifiez le nombre de fichiers d'annuaire: divisez les grands répertoires en plusieurs petits répertoires autant que possible, en réduisant le nombre d'éléments traités par appel ReadDir. Activer la mise en cache de contenu du répertoire: construire un mécanisme de cache, mettre à jour le cache régulièrement ou lorsque le contenu du répertoire change et réduire les appels fréquents à Readdir. Les caches de mémoire (telles que Memcached ou Redis) ou les caches locales (telles que les fichiers ou les bases de données) peuvent être prises en compte. Adoptez une structure de données efficace: si vous implémentez vous-même la traversée du répertoire, sélectionnez des structures de données plus efficaces (telles que les tables de hachage au lieu de la recherche linéaire) pour stocker et accéder aux informations du répertoire

Comment définir le niveau de journal Debian Apache

Apr 13, 2025 am 08:33 AM

Comment définir le niveau de journal Debian Apache

Apr 13, 2025 am 08:33 AM

Cet article décrit comment ajuster le niveau de journalisation du serveur Apacheweb dans le système Debian. En modifiant le fichier de configuration, vous pouvez contrôler le niveau verbeux des informations de journal enregistrées par Apache. Méthode 1: Modifiez le fichier de configuration principal pour localiser le fichier de configuration: le fichier de configuration d'Apache2.x est généralement situé dans le répertoire / etc / apache2 /. Le nom de fichier peut être apache2.conf ou httpd.conf, selon votre méthode d'installation. Modifier le fichier de configuration: Ouvrez le fichier de configuration avec les autorisations racine à l'aide d'un éditeur de texte (comme Nano): Sutonano / etc / apache2 / apache2.conf

Comment implémenter le tri des fichiers par Debian Readdir

Apr 13, 2025 am 09:06 AM

Comment implémenter le tri des fichiers par Debian Readdir

Apr 13, 2025 am 09:06 AM

Dans Debian Systems, la fonction ReadDir est utilisée pour lire le contenu du répertoire, mais l'ordre dans lequel il revient n'est pas prédéfini. Pour trier les fichiers dans un répertoire, vous devez d'abord lire tous les fichiers, puis les trier à l'aide de la fonction QSORT. Le code suivant montre comment trier les fichiers de répertoire à l'aide de ReadDir et QSort dans Debian System: # include # include # include # include # include // Fonction de comparaison personnalisée, utilisée pour qsortintCompare (constvoid * a, constvoid * b) {returnstrcmp (* (

Conseils de configuration du pare-feu Debian Mail Server

Apr 13, 2025 am 11:42 AM

Conseils de configuration du pare-feu Debian Mail Server

Apr 13, 2025 am 11:42 AM

La configuration du pare-feu d'un serveur de courrier Debian est une étape importante pour assurer la sécurité du serveur. Voici plusieurs méthodes de configuration de pare-feu couramment utilisées, y compris l'utilisation d'iptables et de pare-feu. Utilisez les iptables pour configurer le pare-feu pour installer iptables (sinon déjà installé): Sudoapt-getUpDaSuDoapt-getinstalliptableView Règles actuelles iptables: Sudoiptable-L Configuration

Méthode d'installation du certificat de Debian Mail Server SSL

Apr 13, 2025 am 11:39 AM

Méthode d'installation du certificat de Debian Mail Server SSL

Apr 13, 2025 am 11:39 AM

Les étapes pour installer un certificat SSL sur le serveur de messagerie Debian sont les suivantes: 1. Installez d'abord la boîte à outils OpenSSL, assurez-vous que la boîte à outils OpenSSL est déjà installée sur votre système. Si ce n'est pas installé, vous pouvez utiliser la commande suivante pour installer: Sudoapt-getUpDaSuDoapt-getInstallOpenSSL2. Générer la clé privée et la demande de certificat Suivant, utilisez OpenSSL pour générer une clé privée RSA 2048 bits et une demande de certificat (RSE): OpenSS

Comment Debian OpenSSL empêche les attaques de l'homme au milieu

Apr 13, 2025 am 10:30 AM

Comment Debian OpenSSL empêche les attaques de l'homme au milieu

Apr 13, 2025 am 10:30 AM

Dans Debian Systems, OpenSSL est une bibliothèque importante pour le chiffrement, le décryptage et la gestion des certificats. Pour empêcher une attaque d'homme dans le milieu (MITM), les mesures suivantes peuvent être prises: utilisez HTTPS: assurez-vous que toutes les demandes de réseau utilisent le protocole HTTPS au lieu de HTTP. HTTPS utilise TLS (Protocole de sécurité de la couche de transport) pour chiffrer les données de communication pour garantir que les données ne sont pas volées ou falsifiées pendant la transmission. Vérifiez le certificat de serveur: vérifiez manuellement le certificat de serveur sur le client pour vous assurer qu'il est digne de confiance. Le serveur peut être vérifié manuellement via la méthode du délégué d'URLSession

Comment faire Debian Hadoop Log Management

Apr 13, 2025 am 10:45 AM

Comment faire Debian Hadoop Log Management

Apr 13, 2025 am 10:45 AM

Gérer les journaux Hadoop sur Debian, vous pouvez suivre les étapes et les meilleures pratiques suivantes: l'agrégation de journal Activer l'agrégation de journaux: définir yarn.log-aggregation-inable à true dans le fichier yarn-site.xml pour activer l'agrégation de journaux. Configurer la stratégie de rétention du journal: Définissez Yarn.log-agregation.retain-secondes pour définir le temps de rétention du journal, tel que 172800 secondes (2 jours). Spécifiez le chemin de stockage des journaux: via yarn.n

Comment Debian Readdir s'intègre à d'autres outils

Apr 13, 2025 am 09:42 AM

Comment Debian Readdir s'intègre à d'autres outils

Apr 13, 2025 am 09:42 AM

La fonction ReadDir dans le système Debian est un appel système utilisé pour lire le contenu des répertoires et est souvent utilisé dans la programmation C. Cet article expliquera comment intégrer ReadDir avec d'autres outils pour améliorer sa fonctionnalité. Méthode 1: combinant d'abord le programme de langue C et le pipeline, écrivez un programme C pour appeler la fonction readdir et sortir le résultat: # include # include # include # includeIntmain (intargc, char * argv []) {dir * dir; structDirent * entrée; if (argc! = 2) {