Périphériques technologiques

Périphériques technologiques

IA

IA

Le déploiement de ChatGPT domestique ne nécessite que 6 Go de mémoire vidéo ! Le modèle ChatYuan est ouvert au téléchargement : le premier grand modèle chinois open source de dialogue fonctionnel de l'industrie

Le déploiement de ChatGPT domestique ne nécessite que 6 Go de mémoire vidéo ! Le modèle ChatYuan est ouvert au téléchargement : le premier grand modèle chinois open source de dialogue fonctionnel de l'industrie

Le déploiement de ChatGPT domestique ne nécessite que 6 Go de mémoire vidéo ! Le modèle ChatYuan est ouvert au téléchargement : le premier grand modèle chinois open source de dialogue fonctionnel de l'industrie

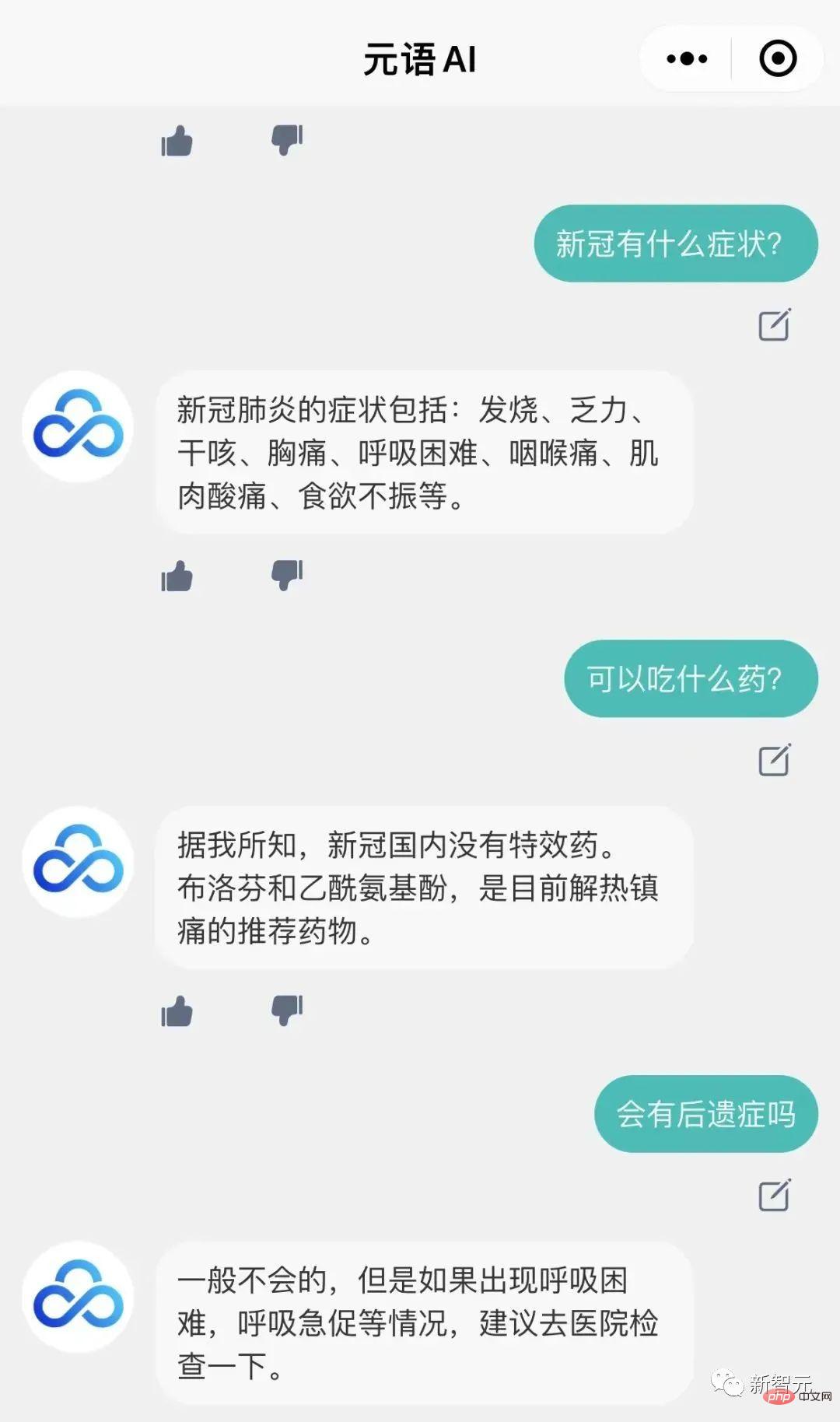

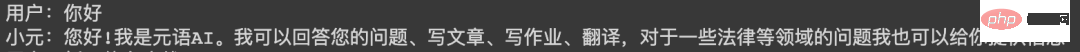

Il y a quelque temps, l'équipe de développement intelligent de Yuanyu a formé un grand modèle de dialogue fonctionnel ChatYuan similaire à ChatGPT et a ouvert une interface d'essai dans la version Web.

Vous pouvez désormais également déployer un ChatYuan sur votre propre machine !

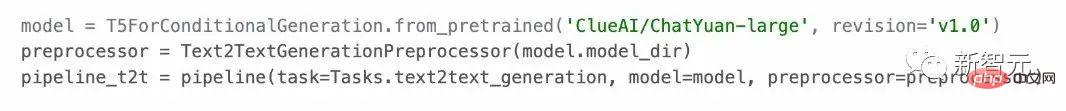

Le modèle peut être utilisé dans des scénarios de questions et réponses, et peut mener des dialogues et diverses tâches de génération en fonction du contexte, y compris l'écriture créative, et peut également répondre à des questions dans des domaines tels que le droit et le COVID-19. .

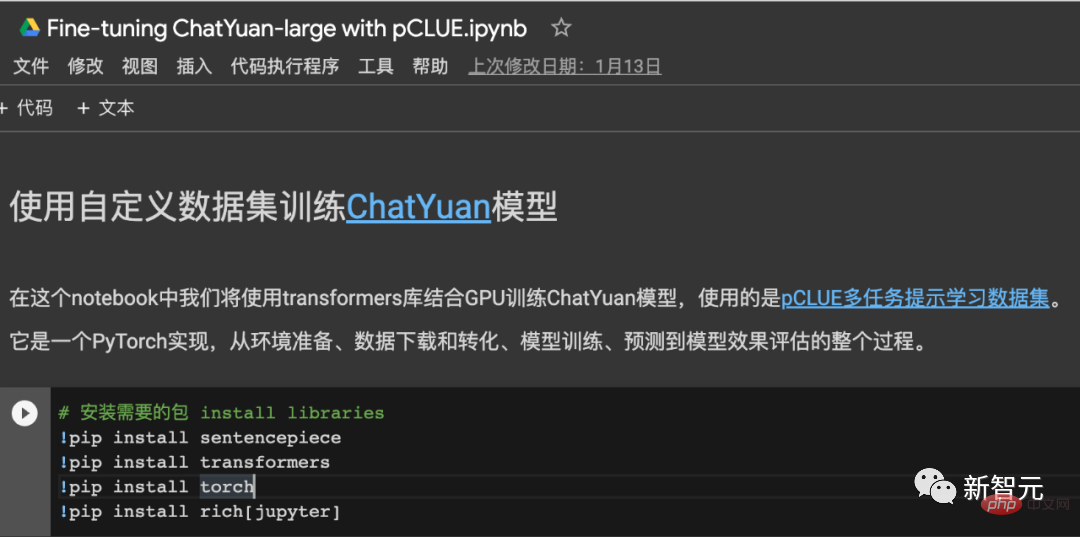

Et il prend en charge l'apprentissage sans échantillon dans toutes les tâches chinoises. Les utilisateurs peuvent l'utiliser en fournissant des invites. Il prend en charge près de 30 types de tâches chinoises dans les catégories de génération de texte, d'extraction d'informations et de compréhension.

ChatYuan est davantage formé sur la base de PromptCLUE-large combiné à des centaines de millions de questions et réponses fonctionnelles et de données de dialogue à plusieurs tours. Le modèle dispose de 770 millions de paramètres et d'environ 6 Go de mémoire vidéo. une carte graphique civile. Le modèle est actuellement ouvert au téléchargement.

PromptCLUE est pré-entraîné sur un corpus chinois de 100 milliards de jetons, a appris un total de 1,5 billion de jetons chinois et organise une formation basée sur les tâches Prompt sur des centaines de tâches.

Pour les tâches de compréhension, telles que la classification, l'analyse des sentiments, l'extraction, etc., le système d'étiquettes peut être personnalisé ; pour une variété de tâches de génération, l'échantillonnage peut être généré librement.

Comment utiliser1. Github

Adresse du projet : https://github.com/clue-ai/ChatYuan

2.

Adresse du projet : https://huggingface.co/ClueAI/ChatYuan-large-v1

3. ModelScope

Adresse du projet : https://modelscope.cn/models/ClueAI/ChatYuan-large

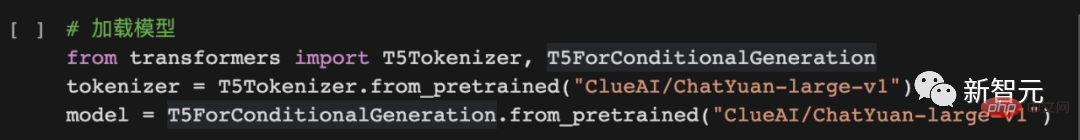

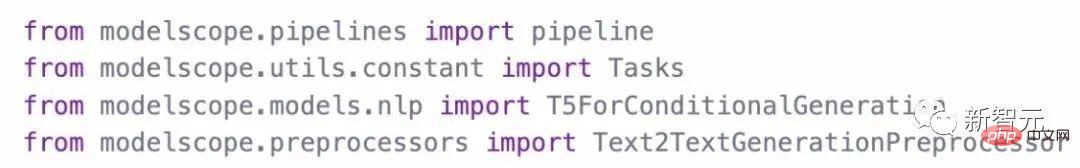

Charger le modèle :

Utilisez le modèle Raisonnement prédictif méthodes :

4. PaddlePaddle

Adresse du projet : https://aistudio.bai duo.com du.com/aistudio/projectdetail /5404182

Adresse du modèle : https://huggingface.co/ClueAI/ChatYuan-large-v1-paddle

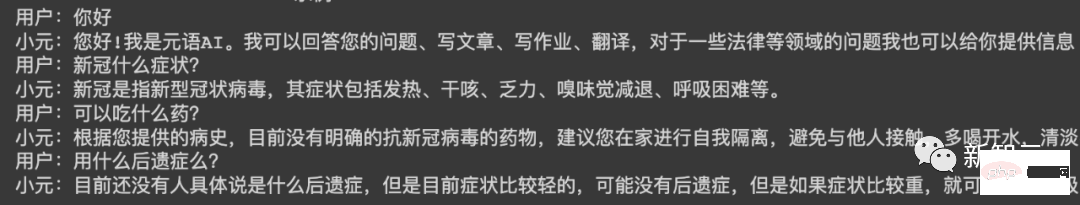

Utilisez vos propres données pour entraîner le modèle

1 Organisez les données

.Les données sont organisées dans un format unifié et se composent de deux parties : entrée (Input) et sortie (Output).

Pour une seule série de questions et réponses ou de génération :

Entrée : description de la tâche + texte de saisie

Sortie : le texte que le système doit prédire, comme indiqué après "Xiaoyuan" dans l'image ci-dessous le contenu.

Pour les conversations à plusieurs tours :

Entrée : description de la tâche + ci-dessus + texte de saisie

Sortie : le texte que le système doit prédire, comme le montre l'image ci-dessous "Xiao Yuan" le contenu suivant.

Format de données de conversation à un tour :

Format de données de conversation à plusieurs tours : 2. Modèle de formation

Pour le code de formation, veuillez vous référer à : Utilisation de l'ensemble de données pCLUE pour la formation, la prédiction et la vérification des effets, la mise en œuvre de pytorch - collaboration en ligne.

Projet Github : https://colab.research.google.com/drive/1lEyFhEfoc-5Z5xqpEKkZt_iMaojH1MP_?usp=sharing

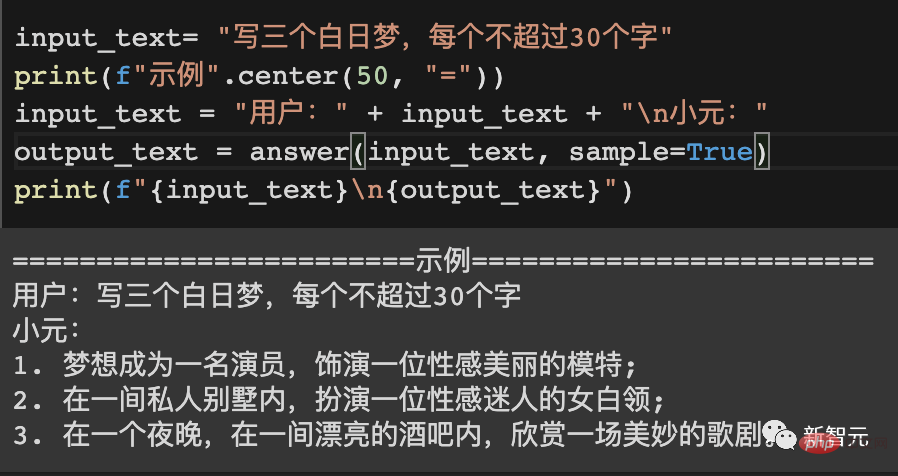

Un exemple

====== =====Exemple 1==========

Utilisateur :

Que pouvez-vous faire

Xiaoyuan :

Bonjour ! Je suis Yuanyu AI. Je peux répondre à vos questions, rédiger des articles, des devoirs, traduire, et je peux également vous fournir des informations sur des questions juridiques et autres.

==========Exemple 2==========

Utilisateur :

Écrire un poème sur l'hiver

Xiao Yuan :

La nuit d'hiver est calme et froide,

les nuages flottent dans le ciel,

sur la neige blanche gelée,froide comme la neige.

Les flocons de neige fondent en glace,

Comme ces flocons de neige qui tombent,

Dans le froid de l'hiver,

ressentez la joie du printemps.

En hiver,

le vent et la neige se sont progressivement calmés,

il y avait le silence,

Apportez du bonheur et de la chaleur à la maison. ==========Exemple 3========== Utilisateur : En stage pour les majeures de l'éducation préscolaire, sur l'élève côté Il y aura des problèmes, veuillez suggérer des mesures d'amélioration. 800 mots Xiaoyuan : Lors des stages dans les majeures de l'éducation préscolaire, il y aura certains problèmes avec les étudiants, tels que le manque de connaissances professionnelles des étudiants, le manque de conscience de la coopération, le manque de sens de base des responsabilités, etc., dont nous avons besoin. Nous prenons des mesures pour résoudre ces problèmes. Tout d'abord, pendant le processus de stage, nous devons cultiver la conscience d'équipe des étudiants, renforcer la coopération entre les étudiants et les enseignants, renforcer la communication avec les parents et améliorer leurs compétences en communication. En outre, nous devons également renforcer l'indépendance des élèves, leur permettre d'apprendre à penser de manière indépendante, à communiquer avec les enseignants et les parents et à cultiver leur indépendance. De plus, dans le travail quotidien, nous devons également offrir aux étudiants des opportunités et des opportunités appropriées, afin que les étudiants puissent avoir plus de contacts avec la société et participer à davantage d'activités sociales, approfondir leur compréhension de la société et de l'école et cultiver leur initiative. , la positivité et l'esprit d'innovation. Enfin, nous devons également prêter attention aux problèmes que rencontrent les étudiants lors des stages, notamment le manque de coopération des étudiants, la dépendance, le fait de ne pas savoir partager, la procrastination, etc. Ces étudiants doivent attirer notre attention et formuler des améliorations raisonnables. mesures. , améliorer ces problèmes. ChatYuan est un modèle obtenu par une formation continue basée sur PromptCLUE. Il supprime les tâches de compréhension de texte et d'extraction d'informations, et renforce l'apprentissage et la formation des questions et réponses, du dialogue et de diverses tâches génératives Compte tenu du fait que les dialogues à plusieurs tours sont facilement perturbés par le contexte, les données anti-interférences ; est ajouté afin que le modèle puisse ignorer le contexte non pertinent si nécessaire ; l'apprentissage des données de commentaires des utilisateurs est ajouté, de sorte que le modèle possède non seulement certaines capacités générales de compréhension du langage et des capacités de génération de tâches spécifiques, mais peut également mieux répondre aux intentions de l'utilisateur. Processus d'apprentissage PromptCLUETechnologie et processus de formation

- Trois unifications majeures : cadre de modèle unifié (texte à texte), formulaire de tâche unifié (invite), méthode d'application unifiée (zéro-shot/quelques-shots) (T0)

- Pré-formation à grande échelle : en t5 -large Sur la base de la version, des centaines de corpus chinois G ont été utilisés, 1 million d'étapes ont été formées et 1,5 billion de jetons au niveau des mots chinois ont été formés de manière cumulative

- Données de tâches à grande échelle : 16 types de tâches, des centaines de tâches et un un total cumulé de 100 millions ont été utilisés Données de tâches de niveau

- Pré-formation hybride : D'une part, les tâches en aval sont utilisées comme corpus de pré-formation, et d'autre part, les tâches en aval et le corpus de pré-formation sont entraînées ensemble pour réduire l'oubli de tâches en cas de catastrophe et raccourcir la distance entre les tâches de pré-formation et en aval pour une meilleure adaptation. un échantillonnage fluide est effectué en fonction de la quantité de données de la tâche, et les données de la tâche sont limitées en même temps par la limite supérieure du pool d'échantillonnage. Un échantillonnage fluide peut réduire les préjudices biaisés de l'entraînement aux tâches, et l'entraînement au sein de chaque lot peut réduire le transfert négatif d'entraînement entre des tâches hétérogènes (T5)

- Entraînement par phases : d'une part, il fait référence à la phase de pré-entraînement, impliquant le longueur de la séquence d'entraînement. Le phasage (128 et 512) accélère la vitesse de pré-entraînement (Bert) ; d'autre part, le phasage d'entraînement en aval implique des changements dans le taux d'apprentissage et la longueur de la séquence, ainsi qu'une diminution des restrictions de volume de données en aval. tâches, s'adaptant mieux aux différentes tâches en aval.

- Augmenter la formation du modèle de langage : reportez-vous à t5.1.1, en plus d'utiliser la construction Span Corrpution pour la formation non supervisée, et également d'utiliser le préfixe LM pour la formation afin d'améliorer la capacité à générer des tâches (LM adapté)

- Ajouter un encodeur au modèle Et formation au décodeur : construisez des corpus de données de pré-formation Data_text et Data_target respectivement basés sur les données de tâches en aval, et ajoutez-les à la pré-formation pour améliorer respectivement la capacité de compréhension de l'encodeur et la capacité de génération de décodeur du modèle (voir UIE)

- Reconstruire le modèle chinois dictionnaire : utilisez Sentencepiece pour apprendre et construire un dictionnaire modèle sur les jetons Qianyi, qui est plus conforme aux habitudes de la langue chinoise

- Travail de suivi

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Dix outils d'annotation de texte gratuits open source recommandés

Mar 26, 2024 pm 08:20 PM

Dix outils d'annotation de texte gratuits open source recommandés

Mar 26, 2024 pm 08:20 PM

L'annotation de texte est le travail d'étiquettes ou de balises correspondant à un contenu spécifique dans le texte. Son objectif principal est d’apporter des informations complémentaires au texte pour une analyse et un traitement plus approfondis, notamment dans le domaine de l’intelligence artificielle. L'annotation de texte est cruciale pour les tâches d'apprentissage automatique supervisées dans les applications d'intelligence artificielle. Il est utilisé pour entraîner des modèles d'IA afin de mieux comprendre les informations textuelles en langage naturel et d'améliorer les performances de tâches telles que la classification de texte, l'analyse des sentiments et la traduction linguistique. Grâce à l'annotation de texte, nous pouvons apprendre aux modèles d'IA à reconnaître les entités dans le texte, à comprendre le contexte et à faire des prédictions précises lorsque de nouvelles données similaires apparaissent. Cet article recommande principalement de meilleurs outils d'annotation de texte open source. 1.LabelStudiohttps://github.com/Hu

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

Le DALL-E 3 a été officiellement introduit en septembre 2023 en tant que modèle considérablement amélioré par rapport à son prédécesseur. Il est considéré comme l’un des meilleurs générateurs d’images IA à ce jour, capable de créer des images avec des détails complexes. Cependant, au lancement, c'était exclu

15 outils d'annotation d'images gratuits open source recommandés

Mar 28, 2024 pm 01:21 PM

15 outils d'annotation d'images gratuits open source recommandés

Mar 28, 2024 pm 01:21 PM

L'annotation d'images est le processus consistant à associer des étiquettes ou des informations descriptives à des images pour donner une signification et une explication plus profondes au contenu de l'image. Ce processus est essentiel à l’apprentissage automatique, qui permet d’entraîner les modèles de vision à identifier plus précisément les éléments individuels des images. En ajoutant des annotations aux images, l'ordinateur peut comprendre la sémantique et le contexte derrière les images, améliorant ainsi la capacité de comprendre et d'analyser le contenu de l'image. L'annotation d'images a un large éventail d'applications, couvrant de nombreux domaines, tels que la vision par ordinateur, le traitement du langage naturel et les modèles de vision graphique. Elle a un large éventail d'applications, telles que l'assistance aux véhicules pour identifier les obstacles sur la route, en aidant à la détection. et le diagnostic des maladies grâce à la reconnaissance d'images médicales. Cet article recommande principalement de meilleurs outils d'annotation d'images open source et gratuits. 1.Makesens

Recommandé : Excellent projet de détection et de reconnaissance des visages open source JS

Apr 03, 2024 am 11:55 AM

Recommandé : Excellent projet de détection et de reconnaissance des visages open source JS

Apr 03, 2024 am 11:55 AM

La technologie de détection et de reconnaissance des visages est déjà une technologie relativement mature et largement utilisée. Actuellement, le langage d'application Internet le plus utilisé est JS. La mise en œuvre de la détection et de la reconnaissance faciale sur le front-end Web présente des avantages et des inconvénients par rapport à la reconnaissance faciale back-end. Les avantages incluent la réduction de l'interaction réseau et de la reconnaissance en temps réel, ce qui réduit considérablement le temps d'attente des utilisateurs et améliore l'expérience utilisateur. Les inconvénients sont les suivants : il est limité par la taille du modèle et la précision est également limitée ; Comment utiliser js pour implémenter la détection de visage sur le web ? Afin de mettre en œuvre la reconnaissance faciale sur le Web, vous devez être familier avec les langages et technologies de programmation associés, tels que JavaScript, HTML, CSS, WebRTC, etc. Dans le même temps, vous devez également maîtriser les technologies pertinentes de vision par ordinateur et d’intelligence artificielle. Il convient de noter qu'en raison de la conception du côté Web

Le document multimodal Alibaba 7B comprenant le grand modèle remporte le nouveau SOTA

Apr 02, 2024 am 11:31 AM

Le document multimodal Alibaba 7B comprenant le grand modèle remporte le nouveau SOTA

Apr 02, 2024 am 11:31 AM

Nouveau SOTA pour des capacités de compréhension de documents multimodaux ! L'équipe Alibaba mPLUG a publié le dernier travail open source mPLUG-DocOwl1.5, qui propose une série de solutions pour relever les quatre défis majeurs que sont la reconnaissance de texte d'image haute résolution, la compréhension générale de la structure des documents, le suivi des instructions et l'introduction de connaissances externes. Sans plus tarder, examinons d’abord les effets. Reconnaissance et conversion en un clic de graphiques aux structures complexes au format Markdown : Des graphiques de différents styles sont disponibles : Une reconnaissance et un positionnement de texte plus détaillés peuvent également être facilement traités : Des explications détaillées sur la compréhension du document peuvent également être données : Vous savez, « Compréhension du document " est actuellement un scénario important pour la mise en œuvre de grands modèles linguistiques. Il existe de nombreux produits sur le marché pour aider à la lecture de documents. Certains d'entre eux utilisent principalement des systèmes OCR pour la reconnaissance de texte et coopèrent avec LLM pour le traitement de texte.

Fraichement publié! Un modèle open source pour générer des images de style anime en un seul clic

Apr 08, 2024 pm 06:01 PM

Fraichement publié! Un modèle open source pour générer des images de style anime en un seul clic

Apr 08, 2024 pm 06:01 PM

Permettez-moi de vous présenter le dernier projet open source AIGC-AnimagineXL3.1. Ce projet est la dernière itération du modèle texte-image sur le thème de l'anime, visant à offrir aux utilisateurs une expérience de génération d'images d'anime plus optimisée et plus puissante. Dans AnimagineXL3.1, l'équipe de développement s'est concentrée sur l'optimisation de plusieurs aspects clés pour garantir que le modèle atteigne de nouveaux sommets en termes de performances et de fonctionnalités. Premièrement, ils ont élargi les données d’entraînement pour inclure non seulement les données des personnages du jeu des versions précédentes, mais également les données de nombreuses autres séries animées bien connues dans l’ensemble d’entraînement. Cette décision enrichit la base de connaissances du modèle, lui permettant de mieux comprendre les différents styles et personnages d'anime. AnimagineXL3.1 introduit un nouvel ensemble de balises et d'esthétiques spéciales

Comment installer chatgpt sur un téléphone mobile

Mar 05, 2024 pm 02:31 PM

Comment installer chatgpt sur un téléphone mobile

Mar 05, 2024 pm 02:31 PM

Étapes d'installation : 1. Téléchargez le logiciel ChatGTP depuis le site officiel ou la boutique mobile de ChatGTP ; 2. Après l'avoir ouvert, dans l'interface des paramètres, sélectionnez la langue chinoise 3. Dans l'interface de jeu, sélectionnez le jeu homme-machine et définissez la langue. Spectre chinois ; 4. Après avoir démarré, entrez les commandes dans la fenêtre de discussion pour interagir avec le logiciel.

Une seule carte exécute Llama 70B plus rapidement que deux cartes, Microsoft vient de mettre le FP6 dans l'Open source A100 |

Apr 29, 2024 pm 04:55 PM

Une seule carte exécute Llama 70B plus rapidement que deux cartes, Microsoft vient de mettre le FP6 dans l'Open source A100 |

Apr 29, 2024 pm 04:55 PM

Le FP8 et la précision de quantification inférieure en virgule flottante ne sont plus le « brevet » du H100 ! Lao Huang voulait que tout le monde utilise INT8/INT4, et l'équipe Microsoft DeepSpeed a commencé à exécuter FP6 sur A100 sans le soutien officiel de NVIDIA. Les résultats des tests montrent que la quantification FP6 de la nouvelle méthode TC-FPx sur A100 est proche ou parfois plus rapide que celle de INT4, et a une précision supérieure à celle de cette dernière. En plus de cela, il existe également une prise en charge de bout en bout des grands modèles, qui ont été open source et intégrés dans des cadres d'inférence d'apprentissage profond tels que DeepSpeed. Ce résultat a également un effet immédiat sur l'accélération des grands modèles : dans ce cadre, en utilisant une seule carte pour exécuter Llama, le débit est 2,65 fois supérieur à celui des cartes doubles. un