Périphériques technologiques

Périphériques technologiques

IA

IA

Surpassant SOTA de 3,27 %, l'Université Jiao Tong de Shanghai et d'autres ont proposé une nouvelle méthode d'agrégation locale adaptative

Surpassant SOTA de 3,27 %, l'Université Jiao Tong de Shanghai et d'autres ont proposé une nouvelle méthode d'agrégation locale adaptative

Surpassant SOTA de 3,27 %, l'Université Jiao Tong de Shanghai et d'autres ont proposé une nouvelle méthode d'agrégation locale adaptative

Cet article présente un article inclus dans l'AAAI 2023. L'article est co-écrit par le professeur Hua Yang du Shanghai Key Laboratory of Scalable Computing and Systems de l'Université Jiao Tong de Shanghai, de l'Université Queen's de Belfast et du professeur Wang Hao de l'Université d'État de Louisiane. ensemble.

- Lien papier : https://arxiv.org/abs/2212.01197

- Lien de code (y compris les instructions d'utilisation du module ALA) : https://github .com/ TsingZ0/FedALA

Cet article propose une méthode d'agrégation locale adaptative pour l'apprentissage fédéré afin de traiter les problèmes de l'apprentissage fédéré en capturant automatiquement les informations requises par le client à partir du problème d'hétérogénéité statistique. L'auteur a comparé 11 modèles SOTA et a obtenu une excellente performance de 3,27 % au-delà de la méthode optimale. L'auteur a appliqué le module d'agrégation locale adaptative à d'autres méthodes d'apprentissage fédéré et a obtenu une amélioration allant jusqu'à 24,19 %.

1 Introduction

L'apprentissage fédéré (FL) aide les gens à explorer pleinement la valeur contenue dans les données des utilisateurs tout en protégeant la confidentialité en conservant les données privées des utilisateurs localement sans les diffuser. Cependant, les données entre clients n’étant pas visibles, l’hétérogénéité statistique des données (données non indépendantes et distribuées de manière identique (non-IID) et déséquilibre du volume de données) est devenue l’un des grands défis de FL. L'hétérogénéité statistique des données rend difficile pour les méthodes d'apprentissage fédéré traditionnelles (telles que FedAvg, etc.) d'obtenir un modèle global unique adapté à chaque client via la formation aux processus FL.

Ces dernières années, les méthodes d'apprentissage fédéré personnalisé (pFL) ont reçu une attention croissante en raison de leur capacité à faire face à l'hétérogénéité statistique des données. Contrairement au FL traditionnel, qui recherche un modèle global de haute qualité, l'approche pFL vise à former un modèle personnalisé adapté à chaque client avec la puissance de calcul collaborative de l'apprentissage fédéré. Les recherches pFL existantes sur l'agrégation de modèles sur le serveur peuvent être divisées dans les trois catégories suivantes :

(1) Méthodes pour apprendre un modèle global unique et l'affiner, y compris Per-FedAvg et FedRep ; 2 ) Méthodes d'apprentissage de modèles personnalisés supplémentaires, notamment pFedMe et Ditto ;

(3) Méthodes d'apprentissage de modèles locaux par agrégation personnalisée (ou agrégation locale), notamment FedAMP, FedPHP, FedFomo, APPLE et PartialFed.

Les méthodes pFL des catégories (1) et (2) utilisent toutes les informations du modèle global pour l'initialisation locale (faisant référence à l'initialisation du modèle local avant l'entraînement local à chaque itération). Cependant, dans le modèle global, seules les informations qui améliorent la qualité du modèle local (informations requises par le client qui répondent aux objectifs de formation locaux) sont bénéfiques pour le client. Les modèles globaux se généralisent mal car ils contiennent des informations à la fois nécessaires et non requises par un seul client. Par conséquent, les chercheurs proposent des méthodes pFL dans la catégorie (3) pour capturer les informations requises par chaque client dans le modèle global grâce à une agrégation personnalisée. Cependant, les méthodes pFL de la catégorie (3) existent toujours (a) ne prennent pas en compte les objectifs de formation locaux du client (comme FedAMP et FedPHP), (b) ont des coûts de calcul et de communication élevés (comme FedFomo et APPLE), (c ) Problèmes de confidentialité tels que les fuites (tels que FedFomo et APPLE) et (d) inadéquation entre l'agrégation personnalisée et les objectifs de formation locaux (tels que PartialFed). De plus, étant donné que ces méthodes apportent des modifications importantes au processus FL, les méthodes d'agrégation personnalisées qu'elles utilisent ne peuvent pas être directement utilisées dans la plupart des méthodes FL existantes.

Afin de capturer avec précision les informations requises par le client à partir du modèle global sans augmenter le coût de communication à chaque itération par rapport à FedAvg, l'auteur propose une méthode d'agrégation locale adaptative pour l'apprentissage fédéré (FedALA). Comme le montre la figure 1, FedALA capture les informations requises dans le modèle global en agrégeant le modèle global avec le modèle local via le module d'agrégation locale adaptative (ALA) avant chaque formation locale. Étant donné que FedALA utilise uniquement ALA pour modifier le processus d'initialisation du modèle local à chaque itération par rapport à FedAvg, sans modifier les autres processus FL, ALA peut être directement appliqué à la plupart des autres méthodes FL existantes pour améliorer leur individualité.

Figure 1 : Processus d'apprentissage local sur le client en itération

2 Méthode

2.1 Agrégation locale adaptative (ALA)

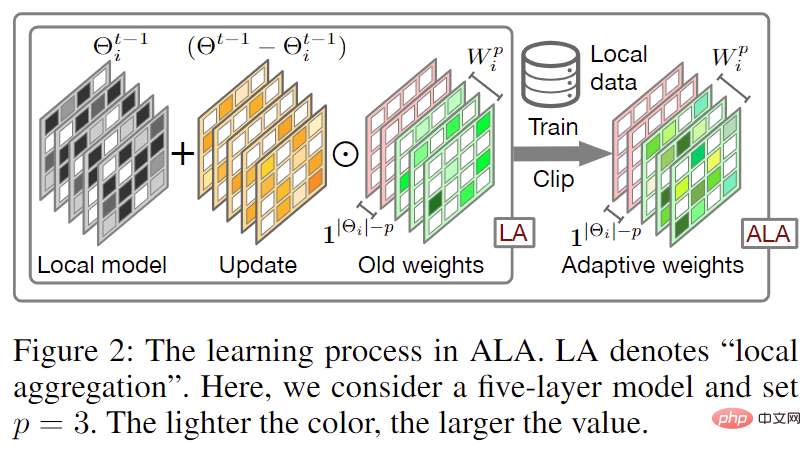

Figure 2 : Agrégation locale adaptative ation (ALA) Processus

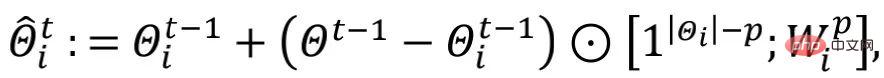

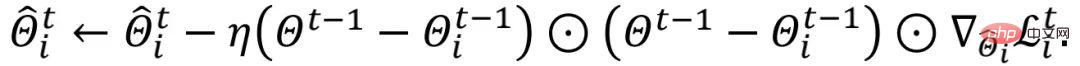

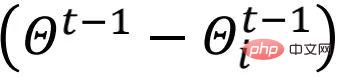

Le processus d'agrégation locale adaptative (ALA) est illustré à la figure 2. Par rapport à l'apprentissage fédéré traditionnel, qui écrase directement le modèle local avec le modèle global téléchargé pour obtenir un modèle initialisé local (c'est-à-dire ), FedALA apprend des modèles locaux pour chaque paramètre Agrégez les poids pour une agrégation locale adaptative.

Parmi eux, l'auteur appelle  "mise à jour". De plus, l'auteur implémente la régularisation via la méthode d'élagage du poids par élément

"mise à jour". De plus, l'auteur implémente la régularisation via la méthode d'élagage du poids par élément  et limite les valeurs dans

et limite les valeurs dans  à [0,1].

à [0,1].

Parce que le réseau de couche inférieure du réseau de neurones profonds (DNN) a tendance à apprendre relativement plus d'informations générales que la couche supérieure, et que les informations générales sont les informations requises par chaque modèle local, donc le réseau de couche inférieure dans le monde modèle La plupart des informations sont cohérentes avec les informations requises par les réseaux de niveau inférieur dans le modèle local. Afin de réduire le coût de calcul requis pour apprendre les poids d'agrégation locaux, l'auteur introduit un hyperparamètre p pour contrôler la portée de l'ALA, de sorte que les paramètres de réseau de couche inférieure dans le modèle global couvrent directement le réseau de couche inférieure dans le modèle local, et uniquement dans la couche supérieure Activer ALA.

Parmi eux,  représente le nombre de couches de réseau neuronal (ou blocs de réseau neuronal) dans

représente le nombre de couches de réseau neuronal (ou blocs de réseau neuronal) dans  ,

,  est cohérent avec la forme du réseau de bas niveau dans

est cohérent avec la forme du réseau de bas niveau dans  , et

, et  est cohérent avec

est cohérent avec  Les réseaux de haut niveau de couche p restants ont la même forme.

Les réseaux de haut niveau de couche p restants ont la même forme.

L'auteur initialise toutes les valeursdans  à 1, et met à jour

à 1, et met à jour  en fonction de l'ancienne

en fonction de l'ancienne  lors de chaque tour d'initialisation locale. Afin de réduire davantage le coût de calcul, l'auteur utilise un échantillonnage aléatoire s

lors de chaque tour d'initialisation locale. Afin de réduire davantage le coût de calcul, l'auteur utilise un échantillonnage aléatoire s

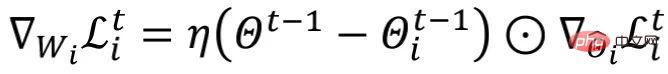

où  est le taux d'apprentissage de la mise à jour

est le taux d'apprentissage de la mise à jour  . En cours d'apprentissage

. En cours d'apprentissage  , l'auteur fige les autres paramètres entraînables sauf

, l'auteur fige les autres paramètres entraînables sauf  .

.

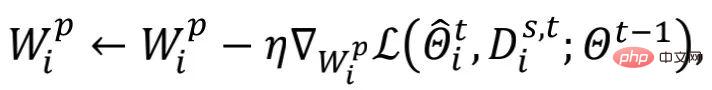

Figure 3 : Courbe d'apprentissage du client 8 sur les ensembles de données MNIST et Cifar10

En choisissant une valeur p plus petite, les performances de FedALA sont améliorées considérablement sans presque affecter les performances de FedALA. paramètres requis pour la formation en ALA. De plus, comme le montre la figure 3, les auteurs ont observé qu'une fois entraîné à la convergence lors de la première formation  , il n'a pas un grand impact sur la qualité du modèle local même s'il est entraîné

, il n'a pas un grand impact sur la qualité du modèle local même s'il est entraîné  lors des itérations suivantes. Autrement dit, chaque client peut réutiliser l'ancien

lors des itérations suivantes. Autrement dit, chaque client peut réutiliser l'ancien  pour capturer les informations dont il a besoin. L'auteur adopte la méthode de réglage fin

pour capturer les informations dont il a besoin. L'auteur adopte la méthode de réglage fin  dans les itérations ultérieures pour réduire le coût de calcul.

dans les itérations ultérieures pour réduire le coût de calcul.

2.2 Analyse ALA

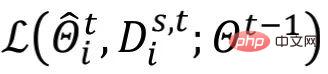

Sans affecter l'analyse, par souci de simplicité, l'auteur ignore  et suppose

et suppose  . D'après la formule ci-dessus, nous pouvons obtenir

. D'après la formule ci-dessus, nous pouvons obtenir  , où

, où  représente

représente  . Les auteurs peuvent considérer la mise à jour de

. Les auteurs peuvent considérer la mise à jour de  dans ALA comme une mise à jour de

dans ALA comme une mise à jour de  .

.

Le terme de dégradé est mis à l'échelle élément par élément à chaque tour. Différent de la méthode de formation (ou de réglage fin) du modèle local, le processus de mise à jour ci-dessus de

est mis à l'échelle élément par élément à chaque tour. Différent de la méthode de formation (ou de réglage fin) du modèle local, le processus de mise à jour ci-dessus de  peut percevoir les informations communes dans le modèle global. Entre les différentes itérations, le

peut percevoir les informations communes dans le modèle global. Entre les différentes itérations, le  qui change dynamiquement introduit des informations dynamiques dans le module ALA, permettant à FedALA de s'adapter facilement à des environnements complexes.

qui change dynamiquement introduit des informations dynamiques dans le module ALA, permettant à FedALA de s'adapter facilement à des environnements complexes.

3 Expérience

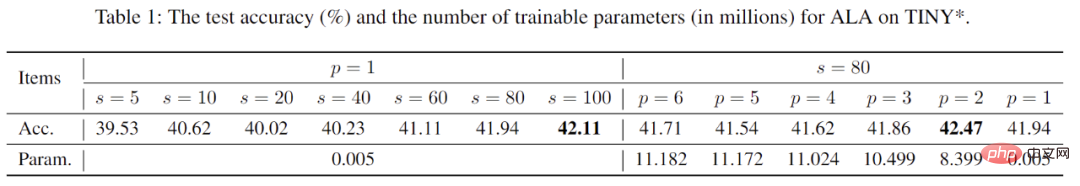

L'auteur a utilisé ResNet-18 pour étudier l'impact des hyperparamètres s et p sur FedALA sur l'ensemble de données Tiny-ImageNet dans un environnement hétérogène de données pratiques, comme le montre le tableau 1. Pour les s, l'utilisation de données de formation locales échantillonnées de manière plus aléatoire pour l'apprentissage du module ALA peut améliorer les performances du modèle personnalisé, mais cela augmente également le coût de calcul. Lors de l'utilisation d'ALA, la taille de s peut être ajustée en fonction de la puissance de calcul de chaque client. Comme le montre le tableau, FedALA offre toujours des performances exceptionnelles même en utilisant des s extrêmement petits (tels que s=5). Pour p, différentes valeurs p n'ont presque aucun impact sur les performances du modèle personnalisé, mais il existe une énorme différence dans le coût de calcul. Ce phénomène montre également d'un certain point de vue l'efficacité de méthodes telles que FedRep, qui divise le modèle et maintient la couche de réseau neuronal proche de la sortie sans la télécharger sur le client. Lors de l'utilisation d'ALA, nous pouvons utiliser une valeur p plus petite et appropriée pour réduire davantage le coût de calcul tout en garantissant les capacités de performance du modèle personnalisé.

Tableau 1 : Recherche sur les hyperparamètres et leur impact sur FedALA

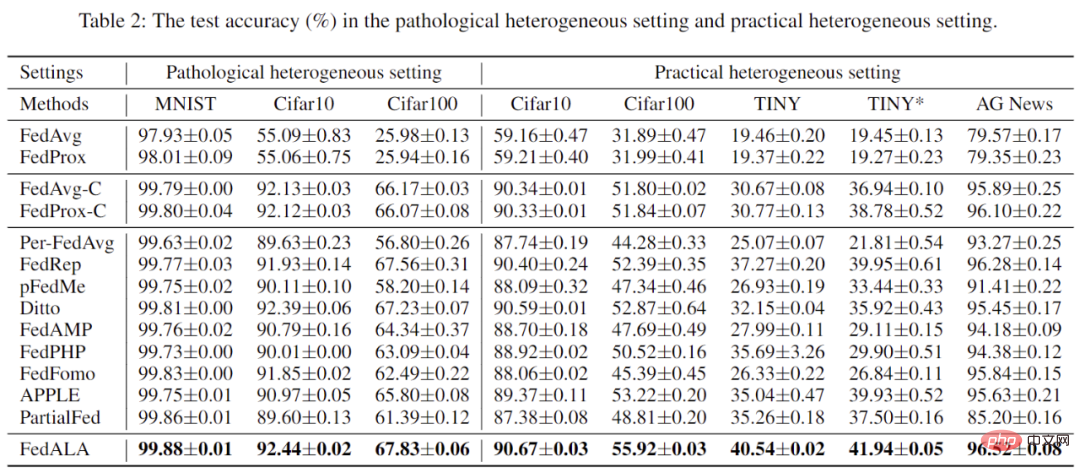

L'auteur a comparé FedALA avec 11 en données pathologiques environnement hétérogène et données pratiques en environnement hétérogène Plusieurs méthodes SOTA ont été comparées et analysées en détail. Comme le montre le tableau 2, les données montrent que FedALA surpasse ces 11 méthodes SOTA dans tous les cas, où « TINY » signifie l'utilisation d'un CNN à 4 couches sur Tiny-ImageNet. Par exemple, FedALA dépasse la référence optimale de 3,27 % dans le cas TINY.

Tableau 2 : Résultats expérimentaux dans des environnements hétérogènes de données pathologiques et réelles

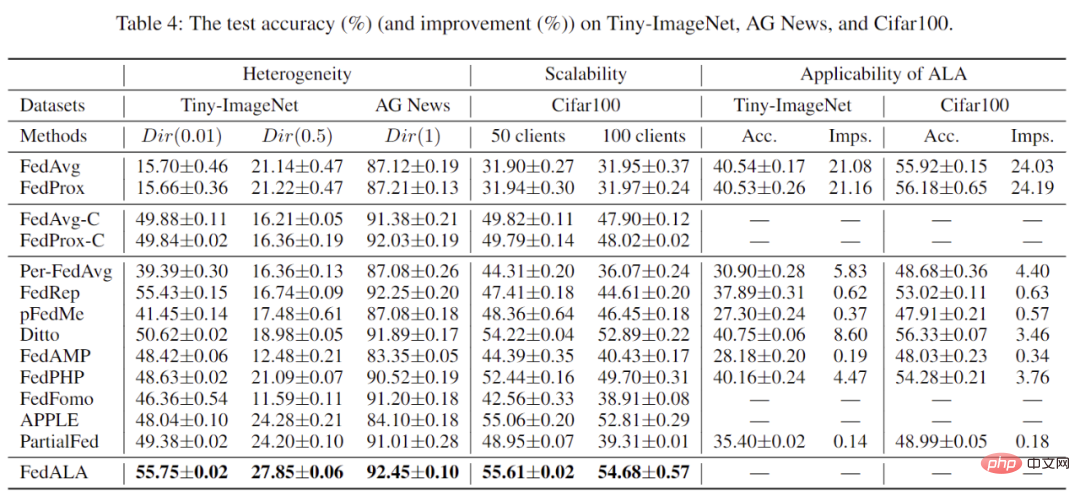

De plus, les auteurs ont également évalué les performances de FedALA dans différents environnements hétérogènes et le nombre total de clients. Comme le montre le tableau 3, FedALA maintient toujours d'excellentes performances dans ces conditions.

Tableau 3 : Autres résultats expérimentaux

Selon les résultats expérimentaux du tableau 3, l'application du module ALA à d'autres méthodes peut atteindre jusqu'à 24,19 % d'amélioration.

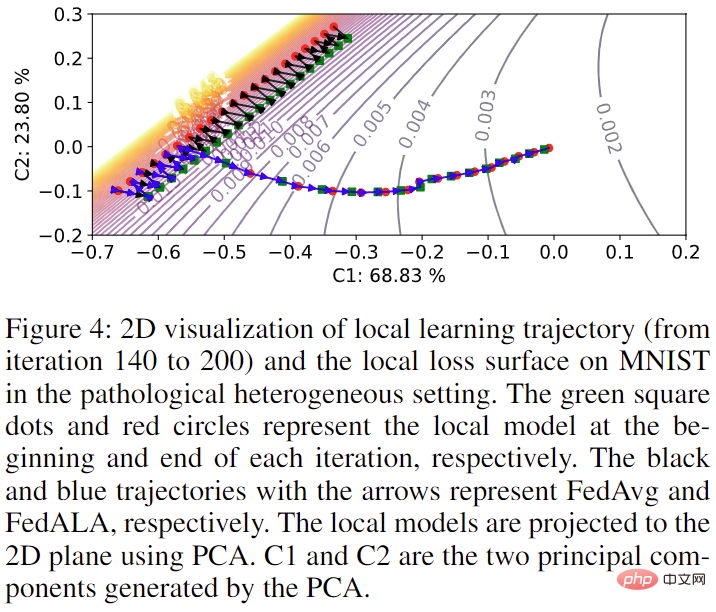

Enfin, l'auteur a également visualisé l'impact de l'ajout du module ALA sur la formation des modèles dans le processus FL d'origine sur MNIST, comme le montre la figure 4. Lorsque ALA n'est pas activé, la trajectoire de formation du modèle est cohérente avec l'utilisation de FedAvg. Une fois ALA activé, le modèle peut optimiser directement vers l'objectif optimal avec les informations nécessaires à sa formation capturées dans le modèle global.

Figure 4 : Visualisation de la trajectoire de formation du modèle sur le client 4

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Utilisez ddrescue pour récupérer des données sous Linux

Mar 20, 2024 pm 01:37 PM

Utilisez ddrescue pour récupérer des données sous Linux

Mar 20, 2024 pm 01:37 PM

DDREASE est un outil permettant de récupérer des données à partir de périphériques de fichiers ou de blocs tels que des disques durs, des SSD, des disques RAM, des CD, des DVD et des périphériques de stockage USB. Il copie les données d'un périphérique bloc à un autre, laissant derrière lui les blocs corrompus et ne déplaçant que les bons blocs. ddreasue est un puissant outil de récupération entièrement automatisé car il ne nécessite aucune interruption pendant les opérations de récupération. De plus, grâce au fichier map ddasue, il peut être arrêté et repris à tout moment. Les autres fonctionnalités clés de DDREASE sont les suivantes : Il n'écrase pas les données récupérées mais comble les lacunes en cas de récupération itérative. Cependant, il peut être tronqué si l'outil est invité à le faire explicitement. Récupérer les données de plusieurs fichiers ou blocs en un seul

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

0. À quoi sert cet article ? Nous proposons DepthFM : un modèle d'estimation de profondeur monoculaire génératif de pointe, polyvalent et rapide. En plus des tâches traditionnelles d'estimation de la profondeur, DepthFM démontre également des capacités de pointe dans les tâches en aval telles que l'inpainting en profondeur. DepthFM est efficace et peut synthétiser des cartes de profondeur en quelques étapes d'inférence. Lisons ce travail ensemble ~ 1. Titre des informations sur l'article : DepthFM : FastMonocularDepthEstimationwithFlowMatching Auteur : MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Les performances de JAX, promu par Google, ont dépassé celles de Pytorch et TensorFlow lors de récents tests de référence, se classant au premier rang sur 7 indicateurs. Et le test n’a pas été fait sur le TPU présentant les meilleures performances JAX. Bien que parmi les développeurs, Pytorch soit toujours plus populaire que Tensorflow. Mais à l’avenir, des modèles plus volumineux seront peut-être formés et exécutés sur la base de la plate-forme JAX. Modèles Récemment, l'équipe Keras a comparé trois backends (TensorFlow, JAX, PyTorch) avec l'implémentation native de PyTorch et Keras2 avec TensorFlow. Premièrement, ils sélectionnent un ensemble de

Vitesse Internet lente des données cellulaires sur iPhone : correctifs

May 03, 2024 pm 09:01 PM

Vitesse Internet lente des données cellulaires sur iPhone : correctifs

May 03, 2024 pm 09:01 PM

Vous êtes confronté à un décalage et à une connexion de données mobile lente sur iPhone ? En règle générale, la puissance de l'Internet cellulaire sur votre téléphone dépend de plusieurs facteurs tels que la région, le type de réseau cellulaire, le type d'itinérance, etc. Vous pouvez prendre certaines mesures pour obtenir une connexion Internet cellulaire plus rapide et plus fiable. Correctif 1 – Forcer le redémarrage de l'iPhone Parfois, le redémarrage forcé de votre appareil réinitialise simplement beaucoup de choses, y compris la connexion cellulaire. Étape 1 – Appuyez simplement une fois sur la touche d’augmentation du volume et relâchez-la. Ensuite, appuyez sur la touche de réduction du volume et relâchez-la à nouveau. Étape 2 – La partie suivante du processus consiste à maintenir le bouton sur le côté droit. Laissez l'iPhone finir de redémarrer. Activez les données cellulaires et vérifiez la vitesse du réseau. Vérifiez à nouveau Correctif 2 – Changer le mode de données Bien que la 5G offre de meilleures vitesses de réseau, elle fonctionne mieux lorsque le signal est plus faible

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

Je pleure à mort. Le monde construit à la folie de grands modèles. Les données sur Internet ne suffisent pas du tout. Le modèle de formation ressemble à « The Hunger Games », et les chercheurs en IA du monde entier se demandent comment nourrir ces personnes avides de données. Ce problème est particulièrement important dans les tâches multimodales. À une époque où rien ne pouvait être fait, une équipe de start-up du département de l'Université Renmin de Chine a utilisé son propre nouveau modèle pour devenir la première en Chine à faire de « l'auto-alimentation des données générées par le modèle » une réalité. De plus, il s’agit d’une approche à deux volets, du côté compréhension et du côté génération, les deux côtés peuvent générer de nouvelles données multimodales de haute qualité et fournir un retour de données au modèle lui-même. Qu'est-ce qu'un modèle ? Awaker 1.0, un grand modèle multimodal qui vient d'apparaître sur le Forum Zhongguancun. Qui est l'équipe ? Moteur Sophon. Fondé par Gao Yizhao, doctorant à la Hillhouse School of Artificial Intelligence de l’Université Renmin.

L'US Air Force présente son premier avion de combat IA de grande envergure ! Le ministre a personnellement effectué l'essai routier sans intervenir pendant tout le processus, et 100 000 lignes de code ont été testées 21 fois.

May 07, 2024 pm 05:00 PM

L'US Air Force présente son premier avion de combat IA de grande envergure ! Le ministre a personnellement effectué l'essai routier sans intervenir pendant tout le processus, et 100 000 lignes de code ont été testées 21 fois.

May 07, 2024 pm 05:00 PM

Récemment, le milieu militaire a été submergé par la nouvelle : les avions de combat militaires américains peuvent désormais mener des combats aériens entièrement automatiques grâce à l'IA. Oui, tout récemment, l’avion de combat IA de l’armée américaine a été rendu public pour la première fois, dévoilant ainsi son mystère. Le nom complet de ce chasseur est Variable Stability Simulator Test Aircraft (VISTA). Il a été personnellement piloté par le secrétaire de l'US Air Force pour simuler une bataille aérienne en tête-à-tête. Le 2 mai, le secrétaire de l'US Air Force, Frank Kendall, a décollé à bord d'un X-62AVISTA à la base aérienne d'Edwards. Notez que pendant le vol d'une heure, toutes les actions de vol ont été effectuées de manière autonome par l'IA ! Kendall a déclaré : "Au cours des dernières décennies, nous avons réfléchi au potentiel illimité du combat air-air autonome, mais cela a toujours semblé hors de portée." Mais maintenant,

Le premier robot capable d'accomplir de manière autonome des tâches humaines apparaît, avec cinq doigts flexibles et rapides, et de grands modèles prennent en charge l'entraînement dans l'espace virtuel

Mar 11, 2024 pm 12:10 PM

Le premier robot capable d'accomplir de manière autonome des tâches humaines apparaît, avec cinq doigts flexibles et rapides, et de grands modèles prennent en charge l'entraînement dans l'espace virtuel

Mar 11, 2024 pm 12:10 PM

Cette semaine, FigureAI, une entreprise de robotique investie par OpenAI, Microsoft, Bezos et Nvidia, a annoncé avoir reçu près de 700 millions de dollars de financement et prévoit de développer un robot humanoïde capable de marcher de manière autonome au cours de la prochaine année. Et l’Optimus Prime de Tesla a reçu à plusieurs reprises de bonnes nouvelles. Personne ne doute que cette année sera celle de l’explosion des robots humanoïdes. SanctuaryAI, une entreprise canadienne de robotique, a récemment lancé un nouveau robot humanoïde, Phoenix. Les responsables affirment qu’il peut accomplir de nombreuses tâches de manière autonome, à la même vitesse que les humains. Pheonix, le premier robot au monde capable d'accomplir des tâches de manière autonome à la vitesse d'un humain, peut saisir, déplacer et placer avec élégance chaque objet sur ses côtés gauche et droit. Il peut identifier des objets de manière autonome

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles