Périphériques technologiques

Périphériques technologiques

IA

IA

Comprendre le schéma de conception d'application des capteurs radar de conduite autonome dans un seul article

Comprendre le schéma de conception d'application des capteurs radar de conduite autonome dans un seul article

Comprendre le schéma de conception d'application des capteurs radar de conduite autonome dans un seul article

Les capteurs sont des éléments clés des voitures sans conducteur. La possibilité de surveiller la distance par rapport aux véhicules devant, derrière ou sur le côté fournit des données vitales au contrôleur central. Les caméras optiques et infrarouges, les lasers, les ultrasons et les radars peuvent tous être utilisés pour fournir des données sur l'environnement, les routes et autres véhicules. Par exemple, des caméras peuvent être utilisées pour détecter des marquages sur la route afin de maintenir les véhicules dans la bonne voie. Ceci est déjà utilisé pour fournir une alerte de sortie de voie dans les systèmes d’aide à la conduite (ADAS). Les systèmes ADAS actuels utilisent également un radar pour les avertissements de détection de collision et un régulateur de vitesse adaptatif, grâce auquel le véhicule peut suivre celui qui le précède.

Sans intervention du conducteur, les voitures autonomes nécessitent davantage de systèmes de capteurs, utilisant souvent plusieurs entrées provenant de différents capteurs pour fournir un niveau d'assurance plus élevé. Ces systèmes de capteurs s'adaptent à partir d'implémentations ADAS éprouvées, bien que l'architecture du système évolue pour gérer une gamme plus large de capteurs et des débits de données plus élevés.

Utilisation du radar

Avec l'adoption croissante des systèmes ADAS pour le régulateur de vitesse adaptatif et la détection de collision, le coût des capteurs radar 24 GHz diminue. Ces exigences deviennent désormais des exigences pour les constructeurs automobiles afin d'obtenir la note de sécurité NCAP européenne de cinq étoiles.

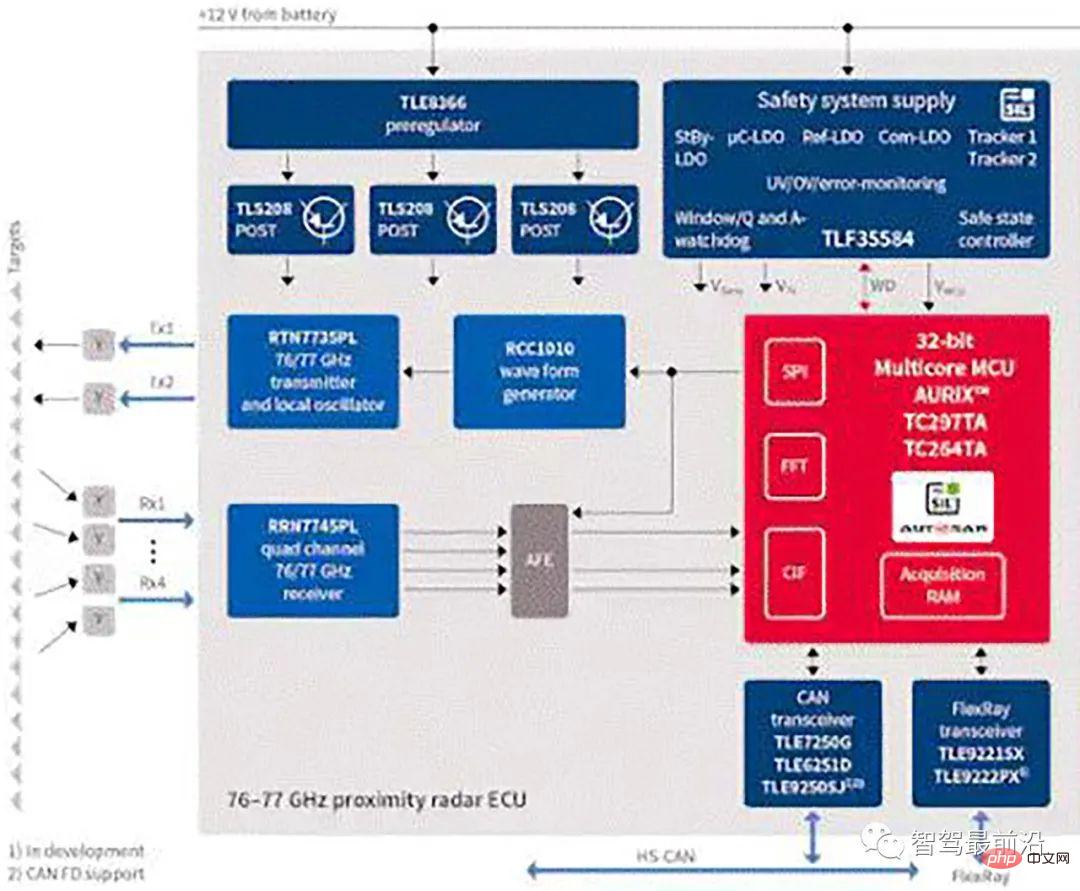

Par exemple, le capteur radar BGT24M 24 GHz d'Infineon Technologies peut être utilisé avec un microcontrôleur externe dans une unité de commande électronique (ECU) pour modifier l'accélérateur afin de maintenir une distance constante par rapport au véhicule qui précède, avec une portée allant jusqu'à 20 m, comme le montre la figure 1.

Figure 1 : Système de détection radar automobile d'Infineon Technologies.

De nombreux systèmes de radar automobile utilisent la méthode Doppler à impulsions, dans laquelle l'émetteur fonctionne pendant une courte période de temps, appelée intervalle de répétition d'impulsions (PRI), puis le système passe en mode réception jusqu'à la prochaine impulsion transmise. Au retour du radar, les réflexions sont traitées de manière cohérente pour extraire la portée et le mouvement relatif des objets détectés.

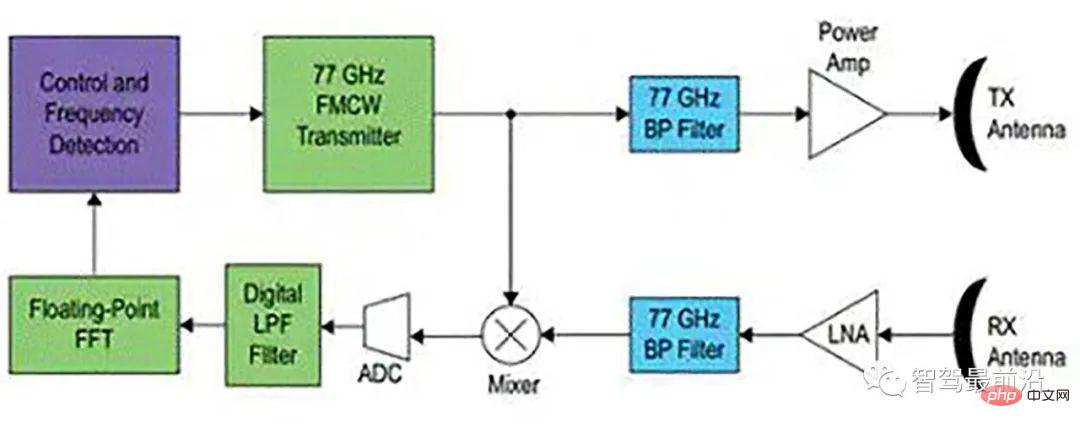

Une autre méthode consiste à utiliser la modulation de fréquence d'onde continue (CWFM). Celui-ci utilise une fréquence porteuse continue qui change dans le temps et le récepteur est constamment allumé. Pour éviter que le signal d'émission ne s'infiltre dans le récepteur, des antennes d'émission et de réception distinctes doivent être utilisées.

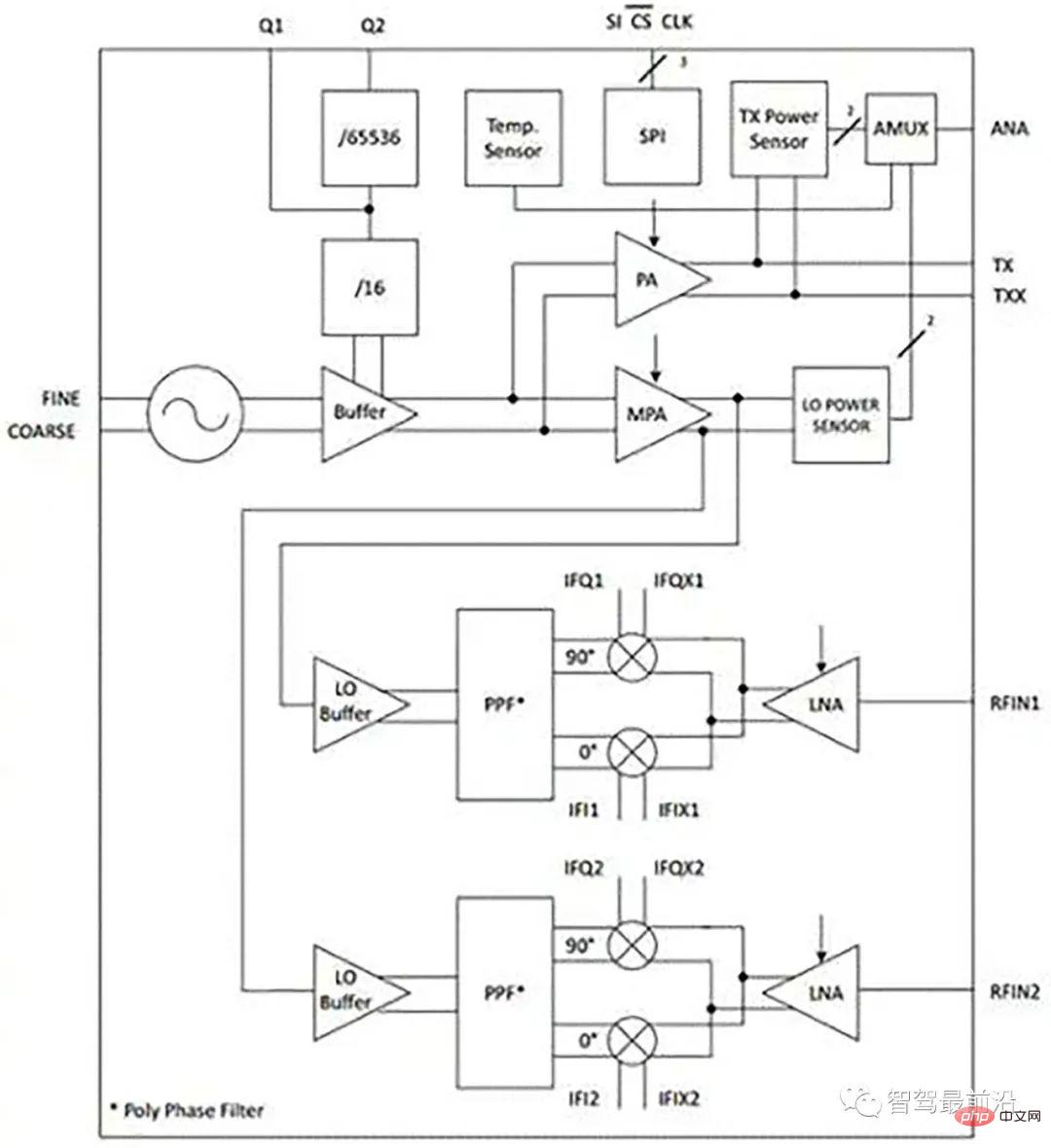

Le BGT24MTR12 est un capteur au silicium germanium (SiGe) pour la génération et la réception de signaux, fonctionnant de 24,0 à 24,25 GHz. Il utilise un oscillateur contrôlé en tension fondamentale de 24 GHz et comprend un préscaler de fréquence commutable avec des fréquences de sortie de 1,5 GHz et 23 kHz.

Un filtre polyphasé RC (PPF) est utilisé pour la génération de phase en quadrature LO du mélangeur down-convertisseur, tandis qu'un capteur de puissance de sortie et un capteur de température sont intégrés dans le dispositif pour la surveillance.

Figure 2 : Capteur radar BGT24MTR12 d'Infineon Technologies.

L'appareil est contrôlé via SPI, fabriqué à l'aide de la technologie SiGe:C de 0,18 µm, a une fréquence de coupure de 200 GHz et est livré dans un boîtier VQFN sans fil à 32 broches.

Cependant, l’architecture des véhicules autonomes évolue. Plutôt que d'être locales à l'ECU, les données provenant de divers systèmes radar autour du véhicule sont transmises à un contrôleur central hautes performances qui combine les signaux avec les signaux des caméras et éventuellement des capteurs laser lidar.

Le contrôleur peut être un processeur polyvalent hautes performances avec une unité de contrôle graphique (GCU) ou un réseau de portes programmable sur site où le traitement du signal peut être géré par un matériel dédié. Cela met davantage l'accent sur les dispositifs d'interface frontale analogique (AFE) qui doivent gérer des débits de données plus élevés et davantage de sources de données.

Les types de capteurs radar utilisés évoluent également. Le capteur 77 GHz offre une portée plus longue et une résolution plus élevée. Le capteur radar 77 GHz ou 79 GHz peut être ajusté en temps réel pour fournir une détection à longue portée jusqu'à 200 m dans un arc de 10°, par exemple pour détecter d'autres véhicules, mais il peut également être utilisé pour une détection plus large à 30° jusqu'à Arc de portée inférieure de 30 m. Des fréquences plus élevées offrent une plus grande résolution, permettant aux systèmes de capteurs radar de distinguer plusieurs objets en temps réel, par exemple en détectant de nombreux piétons dans un arc de 30°, ce qui donne aux contrôleurs de véhicules autonomes plus de temps et plus de données.

Le capteur 77 GHz utilise un transistor bipolaire silicium-germanium avec une fréquence d'oscillation de 300 GHz. Cela permet d'utiliser un capteur radar dans une variété de systèmes de sécurité tels que l'alerte avant, l'avertissement de collision et le freinage automatique. La technologie 77 GHz est également plus résistante aux vibrations du véhicule, ce qui nécessite moins de filtrage.

Figure 3 : Différents cas d'utilisation des capteurs radar dans les véhicules autonomes fournis par NXP.

Le capteur est utilisé pour détecter la distance, la vitesse et l'azimut du véhicule cible dans le système de coordonnées du véhicule (VCS). La précision des données dépend de l'alignement du capteur radar.

L'algorithme d'alignement du capteur radar fonctionne à plus de 40 Hz pendant que le véhicule est en marche. Il doit calculer l'angle de désalignement en 1 milliseconde sur la base des données fournies par le capteur radar ainsi que de la vitesse du véhicule, de la position du capteur sur le véhicule et de son angle de pointage.

Un outil logiciel peut être utilisé pour analyser les données de capteurs enregistrées lors des essais routiers de véhicules réels. Ces données de test peuvent être utilisées pour développer un algorithme d'alignement de capteur radar qui utilise un algorithme de carrés pour calculer les angles de désalignement du capteur en fonction des détections radar brutes et de la vitesse du véhicule hôte. Cela permet également d'estimer la précision de l'angle calculé en fonction du résidu de la solution carrée.

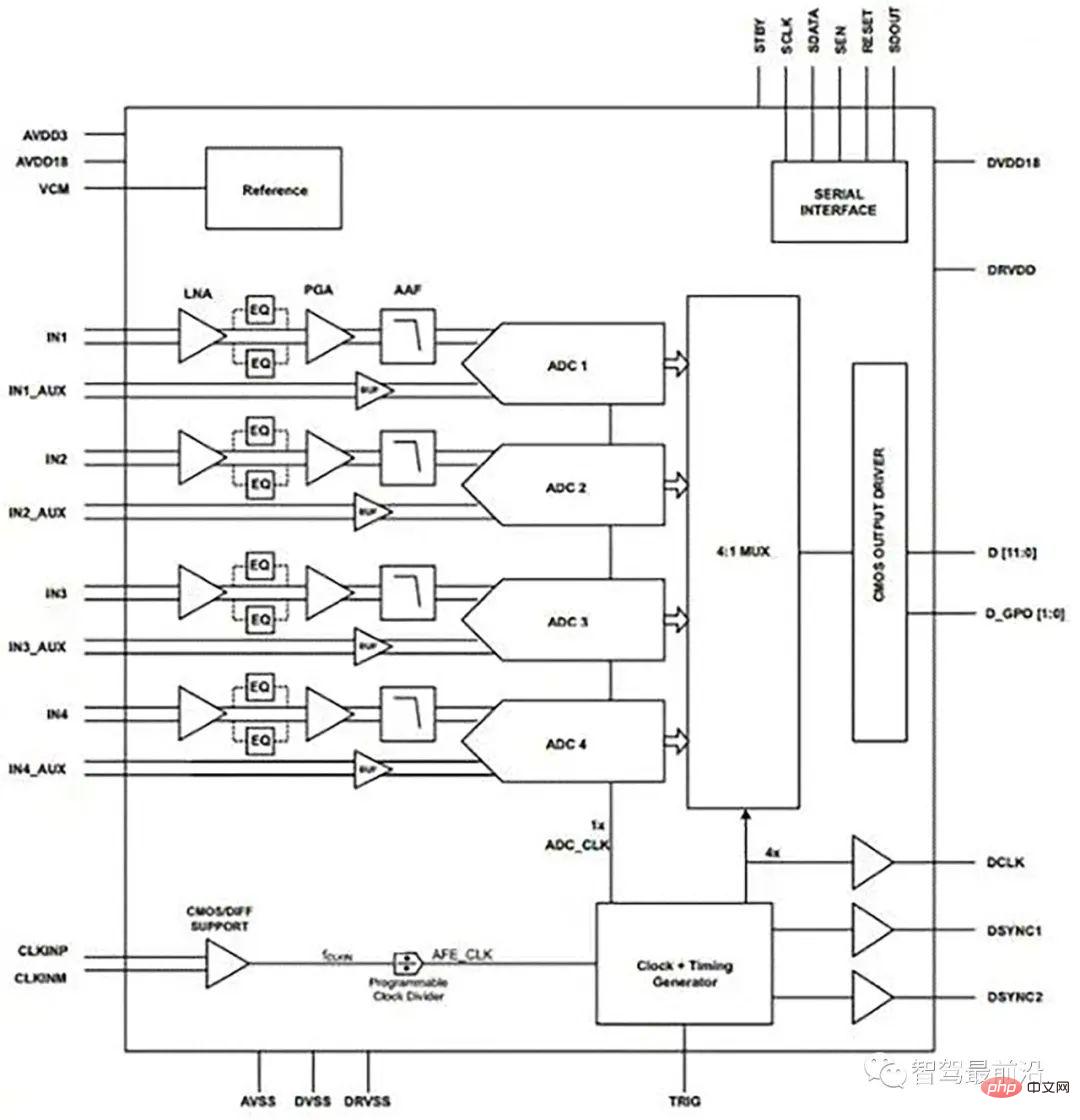

02 Architecture du système

Un frontal analogique tel que l'AFE5401-Q1 de Texas Instruments (Figure 4) peut être utilisé pour connecter le capteur radar au reste du système automobile, comme le montre la Figure 1. L'AFE5401 contient quatre canaux, chacun contenant un amplificateur à faible bruit (LNA), un égaliseur sélectionnable (EQ), un amplificateur à gain programmable (PGA) et un filtre anti-aliasing, suivis d'un signal analogique-numérique 12 bits haute vitesse. de 25 convertisseurs MSPS (ADC) par canal. Les quatre sorties ADC sont multiplexées sur un bus de sortie parallèle 12 bits compatible CMOS.

Figure 4 : Quatre canaux du frontal analogique du radar AFE5401 de Texas Instruments peuvent être utilisés pour plusieurs capteurs.

Pour les systèmes à faible coût, l'AD8284 d'Analog Devices fournit un frontal analogique avec un multiplexeur différentiel (mux) à quatre canaux qui peut être utilisé avec un amplificateur de gain programmable (PGA) et un filtre anti-aliasing à canal unique. alimenté par un préamplificateur à faible bruit (LNA) (AAF). Celui-ci utilise également un seul canal direct vers ADC, le tout intégré à un seul convertisseur analogique-numérique (ADC) de 12 bits. L'AD8284 contient également un circuit de détection de saturation pour détecter les conditions de surtension haute fréquence qui autrement seraient filtrées par l'AAF. La plage de gain du canal analogique est de 17 dB à 35 dB par incréments de 6 dB, et le taux de conversion ADC peut atteindre 60 MSPS. Le bruit de tension de référence d'entrée combiné pour l'ensemble du canal est de 3,5 nV/√Hz au gain. La sortie du

AFE est alimentée par un processeur ou un FPGA tel que l'IGLOO2 ou Fusion de Microsemi ou le Cyclone IV d'Intel. Cela permet à la FFT 2D d'être implémentée dans le matériel à l'aide d'outils de conception FPGA pour traiter la FFT et fournir les données requises sur les objets environnants. Celui-ci peut ensuite être introduit dans un contrôleur central.

Un défi clé pour les FPGA est la détection de plusieurs objets, ce qui est plus complexe pour les architectures CWFM que le Doppler à impulsions. Une approche consiste à faire varier la durée et la fréquence de la rampe et à évaluer la façon dont les fréquences détectées se déplacent dans le spectre avec différentes inclinaisons de rampe de fréquence. Puisque la rampe peut changer par intervalles de 1 ms, des centaines de changements peuvent être analysés par seconde.

Figure 5 : frontal radar CWFM utilisé avec le FPGA d'Intel.

La fusion des données d'autres capteurs peut également être utile, car les données des caméras peuvent être utilisées pour distinguer les échos plus forts des véhicules des échos plus faibles des personnes, ainsi que le type de décalage Doppler attendu.

Une autre option est le radar multimode, qui utilise le CWFM pour trouver des cibles à plus longue portée sur les autoroutes, et le radar Doppler à impulsions à courte portée pour les zones urbaines où les piétons sont plus facilement détectés.

03 Conclusion

Le développement de systèmes de capteurs ADAS pour véhicules autonomes change la manière dont les systèmes radar sont mis en œuvre. Passer d’un simple système d’évitement des collisions ou d’un régulateur de vitesse adaptatif à une détection globale constitue un défi de taille. Le radar est une technologie de détection très populaire et largement acceptée par les constructeurs automobiles et constitue donc la technologie idéale pour cette approche. La combinaison de capteurs à fréquence plus élevée de 77 GHz avec des architectures multimodes CWFM et Doppler pulsé et des données provenant d'autres capteurs tels que des caméras pose également des défis importants aux sous-systèmes de traitement. Relever ces défis de manière sûre, cohérente et rentable est essentiel au développement continu des véhicules autonomes.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Pourquoi le Gaussian Splatting est-il si populaire dans la conduite autonome que le NeRF commence à être abandonné ?

Jan 17, 2024 pm 02:57 PM

Pourquoi le Gaussian Splatting est-il si populaire dans la conduite autonome que le NeRF commence à être abandonné ?

Jan 17, 2024 pm 02:57 PM

Écrit ci-dessus et compréhension personnelle de l'auteur Le Gaussiansplatting tridimensionnel (3DGS) est une technologie transformatrice qui a émergé dans les domaines des champs de rayonnement explicites et de l'infographie ces dernières années. Cette méthode innovante se caractérise par l’utilisation de millions de gaussiennes 3D, ce qui est très différent de la méthode du champ de rayonnement neuronal (NeRF), qui utilise principalement un modèle implicite basé sur les coordonnées pour mapper les coordonnées spatiales aux valeurs des pixels. Avec sa représentation explicite de scènes et ses algorithmes de rendu différenciables, 3DGS garantit non seulement des capacités de rendu en temps réel, mais introduit également un niveau de contrôle et d'édition de scène sans précédent. Cela positionne 3DGS comme un révolutionnaire potentiel pour la reconstruction et la représentation 3D de nouvelle génération. À cette fin, nous fournissons pour la première fois un aperçu systématique des derniers développements et préoccupations dans le domaine du 3DGS.

Comment résoudre le problème de la longue traîne dans les scénarios de conduite autonome ?

Jun 02, 2024 pm 02:44 PM

Comment résoudre le problème de la longue traîne dans les scénarios de conduite autonome ?

Jun 02, 2024 pm 02:44 PM

Hier, lors de l'entretien, on m'a demandé si j'avais posé des questions à longue traîne, j'ai donc pensé faire un bref résumé. Le problème à longue traîne de la conduite autonome fait référence aux cas extrêmes dans les véhicules autonomes, c'est-à-dire à des scénarios possibles avec une faible probabilité d'occurrence. Le problème perçu de la longue traîne est l’une des principales raisons limitant actuellement le domaine de conception opérationnelle des véhicules autonomes intelligents à véhicule unique. L'architecture sous-jacente et la plupart des problèmes techniques de la conduite autonome ont été résolus, et les 5 % restants des problèmes à longue traîne sont progressivement devenus la clé pour restreindre le développement de la conduite autonome. Ces problèmes incluent une variété de scénarios fragmentés, de situations extrêmes et de comportements humains imprévisibles. La « longue traîne » des scénarios limites dans la conduite autonome fait référence aux cas limites dans les véhicules autonomes (VA). Les cas limites sont des scénarios possibles avec une faible probabilité d'occurrence. ces événements rares

Choisir une caméra ou un lidar ? Une étude récente sur la détection robuste d'objets 3D

Jan 26, 2024 am 11:18 AM

Choisir une caméra ou un lidar ? Une étude récente sur la détection robuste d'objets 3D

Jan 26, 2024 am 11:18 AM

0. Écrit à l'avant&& Compréhension personnelle que les systèmes de conduite autonome s'appuient sur des technologies avancées de perception, de prise de décision et de contrôle, en utilisant divers capteurs (tels que caméras, lidar, radar, etc.) pour percevoir l'environnement et en utilisant des algorithmes et des modèles pour une analyse et une prise de décision en temps réel. Cela permet aux véhicules de reconnaître les panneaux de signalisation, de détecter et de suivre d'autres véhicules, de prédire le comportement des piétons, etc., permettant ainsi de fonctionner en toute sécurité et de s'adapter à des environnements de circulation complexes. Cette technologie attire actuellement une grande attention et est considérée comme un domaine de développement important pour l'avenir des transports. . un. Mais ce qui rend la conduite autonome difficile, c'est de trouver comment faire comprendre à la voiture ce qui se passe autour d'elle. Cela nécessite que l'algorithme de détection d'objets tridimensionnels du système de conduite autonome puisse percevoir et décrire avec précision les objets dans l'environnement, y compris leur emplacement,

Avez-vous vraiment maîtrisé la conversion des systèmes de coordonnées ? Des enjeux multi-capteurs indispensables à la conduite autonome

Oct 12, 2023 am 11:21 AM

Avez-vous vraiment maîtrisé la conversion des systèmes de coordonnées ? Des enjeux multi-capteurs indispensables à la conduite autonome

Oct 12, 2023 am 11:21 AM

Le premier article pilote et clé présente principalement plusieurs systèmes de coordonnées couramment utilisés dans la technologie de conduite autonome, et comment compléter la corrélation et la conversion entre eux, et enfin construire un modèle d'environnement unifié. L'objectif ici est de comprendre la conversion du véhicule en corps rigide de caméra (paramètres externes), la conversion de caméra en image (paramètres internes) et la conversion d'image en unité de pixel. La conversion de 3D en 2D aura une distorsion, une traduction, etc. Points clés : Le système de coordonnées du véhicule et le système de coordonnées du corps de la caméra doivent être réécrits : le système de coordonnées planes et le système de coordonnées des pixels Difficulté : la distorsion de l'image doit être prise en compte. La dé-distorsion et l'ajout de distorsion sont compensés sur le plan de l'image. 2. Introduction Il existe quatre systèmes de vision au total : système de coordonnées du plan de pixels (u, v), système de coordonnées d'image (x, y), système de coordonnées de caméra () et système de coordonnées mondiales (). Il existe une relation entre chaque système de coordonnées,

Cet article vous suffit pour en savoir plus sur la conduite autonome et la prédiction de trajectoire !

Feb 28, 2024 pm 07:20 PM

Cet article vous suffit pour en savoir plus sur la conduite autonome et la prédiction de trajectoire !

Feb 28, 2024 pm 07:20 PM

La prédiction de trajectoire joue un rôle important dans la conduite autonome. La prédiction de trajectoire de conduite autonome fait référence à la prédiction de la trajectoire de conduite future du véhicule en analysant diverses données pendant le processus de conduite du véhicule. En tant que module central de la conduite autonome, la qualité de la prédiction de trajectoire est cruciale pour le contrôle de la planification en aval. La tâche de prédiction de trajectoire dispose d'une riche pile technologique et nécessite une connaissance de la perception dynamique/statique de la conduite autonome, des cartes de haute précision, des lignes de voie, des compétences en architecture de réseau neuronal (CNN&GNN&Transformer), etc. Il est très difficile de démarrer ! De nombreux fans espèrent se lancer dans la prédiction de trajectoire le plus tôt possible et éviter les pièges. Aujourd'hui, je vais faire le point sur quelques problèmes courants et des méthodes d'apprentissage introductives pour la prédiction de trajectoire ! Connaissances introductives 1. Existe-t-il un ordre d'entrée pour les épreuves de prévisualisation ? R : Regardez d’abord l’enquête, p

SIMPL : un benchmark de prédiction de mouvement multi-agents simple et efficace pour la conduite autonome

Feb 20, 2024 am 11:48 AM

SIMPL : un benchmark de prédiction de mouvement multi-agents simple et efficace pour la conduite autonome

Feb 20, 2024 am 11:48 AM

Titre original : SIMPL : ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving Lien article : https://arxiv.org/pdf/2402.02519.pdf Lien code : https://github.com/HKUST-Aerial-Robotics/SIMPL Affiliation de l'auteur : Université des sciences de Hong Kong et technologie Idée DJI Paper : cet article propose une base de référence de prédiction de mouvement (SIMPL) simple et efficace pour les véhicules autonomes. Par rapport au cent agent traditionnel

NuScenes dernier SOTA SparseAD : les requêtes clairsemées contribuent à une conduite autonome efficace de bout en bout !

Apr 17, 2024 pm 06:22 PM

NuScenes dernier SOTA SparseAD : les requêtes clairsemées contribuent à une conduite autonome efficace de bout en bout !

Apr 17, 2024 pm 06:22 PM

Écrit à l'avant et point de départ Le paradigme de bout en bout utilise un cadre unifié pour réaliser plusieurs tâches dans les systèmes de conduite autonome. Malgré la simplicité et la clarté de ce paradigme, les performances des méthodes de conduite autonome de bout en bout sur les sous-tâches sont encore loin derrière les méthodes à tâche unique. Dans le même temps, les fonctionnalités de vue à vol d'oiseau (BEV) denses, largement utilisées dans les méthodes de bout en bout précédentes, rendent difficile l'adaptation à davantage de modalités ou de tâches. Un paradigme de conduite autonome de bout en bout (SparseAD) centré sur la recherche clairsemée est proposé ici, dans lequel la recherche clairsemée représente entièrement l'ensemble du scénario de conduite, y compris l'espace, le temps et les tâches, sans aucune représentation BEV dense. Plus précisément, une architecture clairsemée unifiée est conçue pour la connaissance des tâches, notamment la détection, le suivi et la cartographie en ligne. De plus, lourd

Parlons des systèmes de conduite autonome de bout en bout et de nouvelle génération, ainsi que de quelques malentendus sur la conduite autonome de bout en bout ?

Apr 15, 2024 pm 04:13 PM

Parlons des systèmes de conduite autonome de bout en bout et de nouvelle génération, ainsi que de quelques malentendus sur la conduite autonome de bout en bout ?

Apr 15, 2024 pm 04:13 PM

Au cours du mois dernier, pour des raisons bien connues, j'ai eu des échanges très intensifs avec divers professeurs et camarades de classe du secteur. Un sujet inévitable dans l'échange est naturellement le populaire Tesla FSDV12 de bout en bout. Je voudrais profiter de cette occasion pour trier certaines de mes pensées et opinions en ce moment pour votre référence et votre discussion. Comment définir un système de conduite autonome de bout en bout et quels problèmes devraient être résolus de bout en bout ? Selon la définition la plus traditionnelle, un système de bout en bout fait référence à un système qui saisit les informations brutes des capteurs et génère directement les variables pertinentes pour la tâche. Par exemple, en reconnaissance d'images, CNN peut être appelé de bout en bout par rapport à la méthode traditionnelle d'extraction de caractéristiques + classificateur. Dans les tâches de conduite autonome, saisir les données de divers capteurs (caméra/LiDAR