Périphériques technologiques

Périphériques technologiques

IA

IA

L'avenir du CV est sur ces 68 photos ? Google Brain examine en profondeur ImageNet : les top modèles ne parviennent pas à prédire

L'avenir du CV est sur ces 68 photos ? Google Brain examine en profondeur ImageNet : les top modèles ne parviennent pas à prédire

L'avenir du CV est sur ces 68 photos ? Google Brain examine en profondeur ImageNet : les top modèles ne parviennent pas à prédire

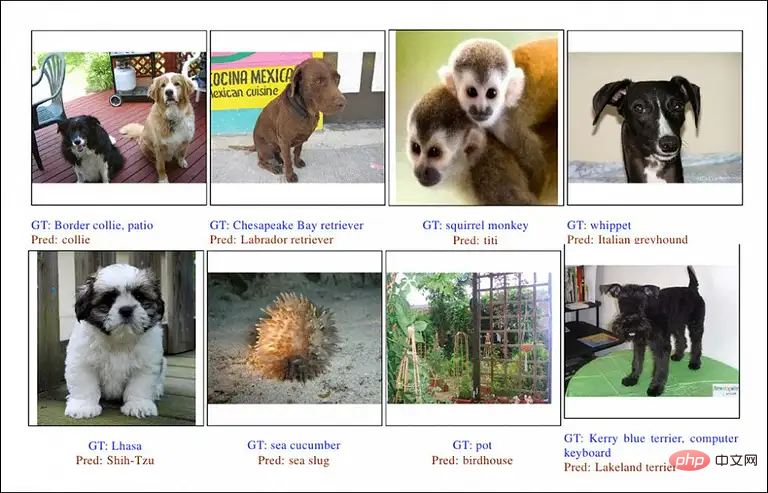

Au cours des dix dernières années, ImageNet a essentiellement été le « baromètre » dans le domaine de la vision par ordinateur. Si le taux de précision s'est amélioré, vous saurez s'il y a une nouvelle technologie qui sort.

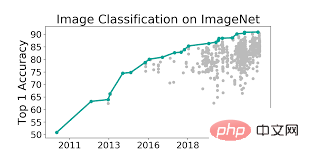

« Brosser la liste » a toujours été le moteur de l'innovation en matière de modèles, poussant la précision top 1 du modèle à plus de 90 %, ce qui est supérieur à celui des humains.

Mais l'ensemble de données ImageNet est-il vraiment aussi utile qu'on le pense ?

De nombreux articles ont remis en question ImageNet, comme la couverture des données, les problèmes de biais, le fait que les étiquettes soient complètes, etc.

La chose la plus importante est la suivante : la précision à 90 % du modèle est-elle vraiment exacte ?

Récemment, des chercheurs de l'équipe Google Brain et de l'Université de Californie à Berkeley ont réexaminé les résultats de prédiction de plusieurs modèles sota et ont découvert que la véritable précision des modèles avait peut-être été sous-estimée !

Lien papier : https://arxiv.org/pdf/2205.04596.pdf

Les chercheurs ont acquis un aperçu de la longue histoire des ensembles de données de référence en examinant et en classant manuellement chaque erreur commise par certains des meilleurs modèles de Tail. erreur.

L'accent principal est mis sur l'évaluation de sous-ensembles multi-étiquettes d'ImageNet. Le meilleur modèle a pu atteindre une précision Top-1 de 97 %.

L'analyse de l'étude a révélé que près de la moitié des soi-disant erreurs de prédiction n'étaient pas du tout des erreurs, et de nouveaux multi-étiquettes ont également été trouvés dans les images, ce qui signifie que si aucun humain n'avait examiné les prédictions, comme par conséquent, les performances de ces modèles peuvent être « sous-estimées » !

Les annotateurs de données participatifs non qualifiés étiquettent souvent les données de manière incorrecte, ce qui affecte grandement l'authenticité de la précision du modèle.

Afin de calibrer l'ensemble de données ImageNet et de promouvoir de bons progrès à l'avenir, les chercheurs fournissent une version mise à jour de l'ensemble d'évaluation multi-étiquettes dans l'article et combinent 68 exemples avec des erreurs évidentes dans les prédictions du modèle sota dans de nouvelles données. a défini ImageNet-Major , pour aider les futurs chercheurs en CV à surmonter ces mauvais cas

et à rembourser la "dette technique"

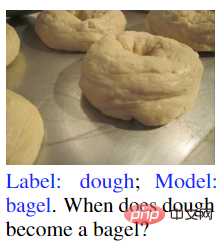

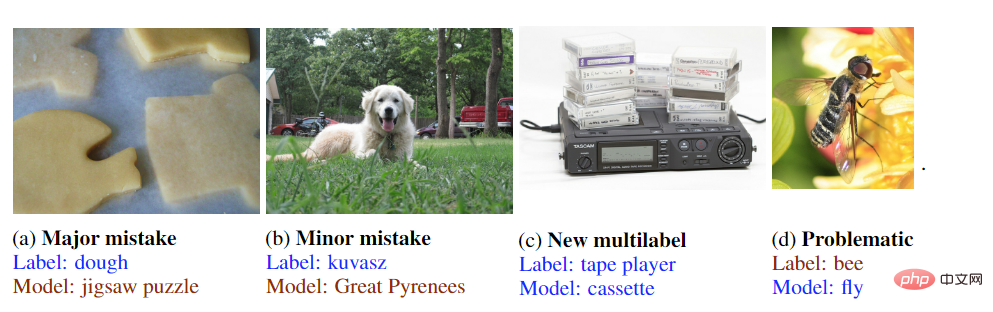

D'après le titre de l'article "Quand la pâte devient-elle un bagel, on voit que l'auteur est principalement concerné ?" à propos du problème d'étiquetage dans ImageNet. C'est aussi un problème laissé par l'histoire.

L'image ci-dessous est un exemple très typique d'ambiguïté d'étiquette. L'étiquette sur l'image est « pâte », et le résultat de la prédiction du modèle est « bagel ».

Théoriquement, ce modèle n'a pas d'erreur de prédiction, car la pâte est en train de cuire et est sur le point de devenir un bagel, c'est donc à la fois de la pâte et du bagel.

On constate que le modèle a effectivement pu prédire que cette pâte va "devenir" un bagel, mais il n'a pas obtenu ce score en termes de précision.

En fait, en utilisant la tâche de classification de l'ensemble de données ImageNet standard comme critère d'évaluation, des problèmes tels que l'absence d'étiquettes multiples, le bruit des étiquettes et les catégories non spécifiées sont inévitables.

Du point de vue des annotateurs participatifs chargés d'identifier de tels objets, il s'agit d'un problème sémantique et même philosophique qui ne peut être résolu que par le multi-étiquetage, il est donc principalement amélioré dans l'ensemble de données dérivé d'ImageNet. C'est une question d'étiquetage.

Cela fait 16 ans depuis la création d'ImageNet. Les annotateurs et les développeurs de modèles de l'époque n'avaient certainement pas une compréhension aussi riche des données qu'aujourd'hui, et ImageNet était l'un des premiers systèmes de données de grande capacité et relativement bien annotés. défini, donc ImageNet est naturellement devenu la norme établie pour les classements de CV.

Mais le budget consacré à l'étiquetage des données n'est évidemment pas aussi important que celui consacré au développement de modèles, donc améliorer le problème de l'étiquetage est devenu une sorte de dette technique.

Pour découvrir les erreurs restantes dans ImageNet, les chercheurs ont utilisé un modèle ViT-3B standard avec 3 milliards de paramètres (capable d'atteindre une précision de 89,5 %), avec JFT-3B comme modèle pré-entraîné, et sur ImageNet- Fine- le réglage a été effectué sur 1K.

En utilisant l'ensemble de données ImageNet2012_multilabel comme ensemble de test, ViT-3B a initialement atteint une précision de 96,3 %, dans laquelle le modèle a manifestement mal prédit 676 images, puis a mené des recherches approfondies sur ces exemples.

Lors du réétiquetage des données, l'auteur n'a pas choisi le crowdsourcing, mais a formé une équipe de 5 évaluateurs experts pour effectuer l'étiquetage, car ce type d'erreurs d'étiquetage est difficile à identifier pour les non-professionnels.

Par exemple, dans l'image (a), les annotateurs ordinaires peuvent simplement écrire « tableau », mais en fait il y a de nombreux autres objets dans l'image, tels que des écrans, des moniteurs, des tasses, etc.

Le sujet de l'image (b) est deux personnes, mais l'étiquette est une palissade, ce qui est évidemment imparfait. Les étiquettes possibles incluent un nœud papillon, un uniforme, etc.

L'image (c) est également un exemple évident Si seul « éléphant d'Afrique » est marqué, l'ivoire peut être ignoré.

L'image (d) est étiquetée bord de lac, mais il n'y a en fait rien de mal à l'étiqueter bord de mer.

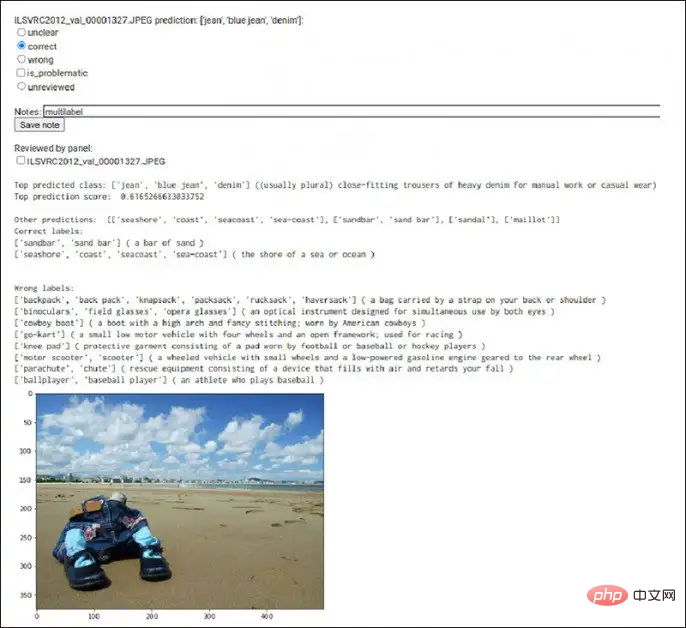

Afin d'augmenter l'efficacité de l'annotation, les chercheurs ont également développé un outil dédié capable d'afficher simultanément les catégories, les scores de prédiction, les étiquettes et les images prédites par le modèle.

Dans certains cas, il peut encore y avoir des différends sur les étiquettes entre les groupes d'experts. À ce stade, les images seront insérées dans la recherche Google pour faciliter l'étiquetage.

Par exemple, dans un exemple, les résultats de prédiction du modèle incluent les taxis, mais il n'y a pas de marque de taxi sur l'image à l'exception de « un peu jaune ».

L'annotation de cette image était principalement basée sur la recherche d'images Google et a révélé que l'arrière-plan de l'image est un pont emblématique. Ensuite, les chercheurs ont localisé la ville où se trouve l'image, et après avoir récupéré des images de taxis dans la ville, ils ont reconnu. cette image. L'image contient un taxi et non une voiture ordinaire. Et une comparaison de la conception des plaques d'immatriculation a également permis de vérifier que la prédiction du modèle était correcte.

Après un examen préliminaire des erreurs constatées à plusieurs étapes de la recherche, les auteurs les ont d'abord divisées en deux catégories en fonction de leur gravité :

1 : Les humains sont capables de comprendre la signification des étiquettes, et du modèle. La prédiction n'a rien à voir avec l'étiquette ;

2. Erreur mineure (Mineur) : L'étiquette peut être erronée ou incomplète en raison d'erreurs de prédiction. Les corrections nécessitent un examen expert des données.

Pour les 155 erreurs majeures commises par le modèle ViT-3B, les chercheurs ont trouvé trois autres modèles à prédire ensemble pour augmenter la diversité des résultats de prédiction.

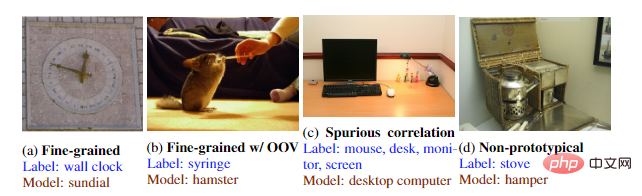

Il y a 68 erreurs majeures que les quatre modèles n'ont pas réussi à prédire, puis nous avons analysé les prédictions de tous les modèles pour ces exemples et vérifié qu'aucune d'entre elles n'était correcte pour le nouveau multi-étiquette, c'est-à-dire les résultats de prédiction de chaque modèle étaient en effet une erreur majeure.

Ces 68 exemples ont plusieurs caractéristiques communes. La première est que les modèles sota formés de différentes manières ont commis des erreurs sur ce sous-ensemble, et les évaluateurs experts estiment également que les résultats des prédictions sont totalement hors de propos.

L'ensemble de données de 68 images est également suffisamment petit pour faciliter l'évaluation manuelle par les chercheurs ultérieurs. Si ces 68 exemples sont conquis à l'avenir, le modèle CV pourrait réaliser de nouvelles avancées.

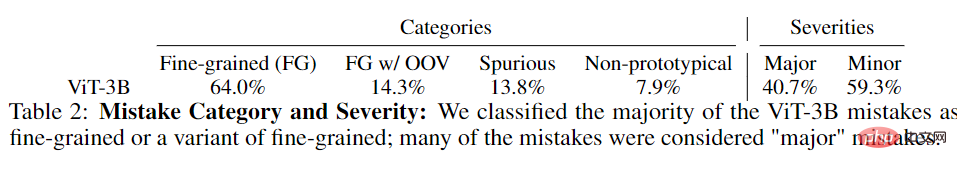

En analysant les données, les chercheurs ont divisé les erreurs de prédiction en quatre types :

1. Erreurs à granularité fine, dans lesquelles les catégories prédites sont similaires aux étiquettes réelles, mais pas exactement les mêmes ; -erreurs de vocabulaire (OOV) ), où le modèle identifie une classe dont la catégorie est correcte mais n'existe pas pour l'objet dans ImageNet

3 Corrélation fallacieuse, où l'étiquette prédite est lue à partir du contexte de l'image ; 4. Non-prototype, où l'objet dans l'étiquette est similaire à l'étiquette prédite, mais pas exactement la même.

Après avoir examiné les 676 erreurs originales, les chercheurs ont constaté que 298 d'entre elles devraient être correctes, ou il a été déterminé que l'étiquette originale était erronée ou problématique.

1 Lorsqu'un modèle à grande échelle et de haute précision fait de nouvelles prédictions que les autres modèles n'ont pas, environ 50 % d'entre elles. sont corrects. Les nouveaux multi-étiquettes ;

1 Lorsqu'un modèle à grande échelle et de haute précision fait de nouvelles prédictions que les autres modèles n'ont pas, environ 50 % d'entre elles. sont corrects. Les nouveaux multi-étiquettes ;

2. Les modèles de plus grande précision ne montrent aucune corrélation claire entre les catégories et la gravité des erreurs.

3 Les modèles SOTA d'aujourd'hui fonctionnent bien mieux sur les sous-ensembles multi-étiquettes évalués par des humains. Correspond largement ou dépasse le meilleur expert ; performances humaines ;

4. Les données d'entraînement bruyantes et les catégories non spécifiées peuvent être un facteur qui limite la mesure efficace des améliorations de la classification des images.

Peut-être que le problème de l'étiquetage des images doit encore attendre que la technologie de traitement du langage naturel soit résolue ?

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment commenter Deepseek

Feb 19, 2025 pm 05:42 PM

Comment commenter Deepseek

Feb 19, 2025 pm 05:42 PM

Deepseek est un puissant outil de récupération d'informations. .

Comment rechercher Deepseek

Feb 19, 2025 pm 05:39 PM

Comment rechercher Deepseek

Feb 19, 2025 pm 05:39 PM

Deepseek est un moteur de recherche propriétaire qui ne recherche que dans une base de données ou un système spécifique, plus rapide et plus précis. Lorsque vous l'utilisez, il est conseillé aux utilisateurs de lire le document, d'essayer différentes stratégies de recherche, de demander de l'aide et des commentaires sur l'expérience utilisateur afin de tirer le meilleur parti de leurs avantages.

Sesame Open Door Exchange Page d'enregistrement de page Enregistrement Gate Trading App The Registration Site Web

Feb 28, 2025 am 11:06 AM

Sesame Open Door Exchange Page d'enregistrement de page Enregistrement Gate Trading App The Registration Site Web

Feb 28, 2025 am 11:06 AM

Cet article présente le processus d'enregistrement de la version Web de Sesame Open Exchange (GATE.IO) et l'application Gate Trading en détail. Qu'il s'agisse de l'enregistrement Web ou de l'enregistrement de l'application, vous devez visiter le site Web officiel ou l'App Store pour télécharger l'application authentique, puis remplir le nom d'utilisateur, le mot de passe, l'e-mail, le numéro de téléphone mobile et d'autres informations et terminer la vérification des e-mails ou du téléphone mobile.

Pourquoi le lien d'échange de Bybit ne peut-il pas être téléchargé directement et installé?

Feb 21, 2025 pm 10:57 PM

Pourquoi le lien d'échange de Bybit ne peut-il pas être téléchargé directement et installé?

Feb 21, 2025 pm 10:57 PM

Pourquoi le lien d'échange de Bybit ne peut-il pas être téléchargé directement et installé? Bybit est un échange de crypto-monnaie qui fournit des services de trading aux utilisateurs. Les applications mobiles de l'échange ne peuvent pas être téléchargées directement via AppStore ou GooglePlay pour les raisons suivantes: 1. La politique de l'App Store empêche Apple et Google d'avoir des exigences strictes sur les types d'applications autorisées dans l'App Store. Les demandes d'échange de crypto-monnaie ne répondent souvent pas à ces exigences car elles impliquent des services financiers et nécessitent des réglementations et des normes de sécurité spécifiques. 2. Conformité des lois et réglementations Dans de nombreux pays, les activités liées aux transactions de crypto-monnaie sont réglementées ou restreintes. Pour se conformer à ces réglementations, l'application ByBit ne peut être utilisée que via des sites Web officiels ou d'autres canaux autorisés

Sesame Open Door Trading Platform Download Version mobile Gateio Trading Plateforme de téléchargement Adresse de téléchargement

Feb 28, 2025 am 10:51 AM

Sesame Open Door Trading Platform Download Version mobile Gateio Trading Plateforme de téléchargement Adresse de téléchargement

Feb 28, 2025 am 10:51 AM

Il est crucial de choisir un canal formel pour télécharger l'application et d'assurer la sécurité de votre compte.

Top 10 recommandé pour l'application de trading d'actifs numériques crypto (2025 Global Ranking)

Mar 18, 2025 pm 12:15 PM

Top 10 recommandé pour l'application de trading d'actifs numériques crypto (2025 Global Ranking)

Mar 18, 2025 pm 12:15 PM

Cet article recommande les dix principales plates-formes de trading de crypto-monnaie qui méritent d'être prêtées, notamment Binance, Okx, Gate.io, Bitflyer, Kucoin, Bybit, Coinbase Pro, Kraken, Bydfi et Xbit décentralisées. Ces plateformes ont leurs propres avantages en termes de quantité de devises de transaction, de type de transaction, de sécurité, de conformité et de fonctionnalités spéciales. Le choix d'une plate-forme appropriée nécessite une considération complète en fonction de votre propre expérience de trading, de votre tolérance au risque et de vos préférences d'investissement. J'espère que cet article vous aide à trouver le meilleur costume pour vous-même

Binance Binance Site officiel Dernière version Portail de connexion

Feb 21, 2025 pm 05:42 PM

Binance Binance Site officiel Dernière version Portail de connexion

Feb 21, 2025 pm 05:42 PM

Pour accéder à la dernière version du portail de connexion du site Web de Binance, suivez simplement ces étapes simples. Accédez au site officiel et cliquez sur le bouton "Connectez-vous" dans le coin supérieur droit. Sélectionnez votre méthode de connexion existante. Entrez votre numéro de mobile ou votre mot de passe enregistré et votre mot de passe et complétez l'authentification (telles que le code de vérification mobile ou Google Authenticator). Après une vérification réussie, vous pouvez accéder à la dernière version du portail de connexion du site Web officiel de Binance.

La dernière adresse de téléchargement de Bitget en 2025: étapes pour obtenir l'application officielle

Feb 25, 2025 pm 02:54 PM

La dernière adresse de téléchargement de Bitget en 2025: étapes pour obtenir l'application officielle

Feb 25, 2025 pm 02:54 PM

Ce guide fournit des étapes de téléchargement et d'installation détaillées pour l'application officielle Bitget Exchange, adaptée aux systèmes Android et iOS. Le guide intègre les informations de plusieurs sources faisant autorité, y compris le site officiel, l'App Store et Google Play, et met l'accent sur les considérations pendant le téléchargement et la gestion des comptes. Les utilisateurs peuvent télécharger l'application à partir des chaînes officielles, y compris l'App Store, le téléchargement officiel du site Web APK et le saut de site Web officiel, ainsi que des paramètres d'enregistrement, de vérification d'identité et de sécurité. De plus, le guide couvre les questions et considérations fréquemment posées, telles que