Périphériques technologiques

Périphériques technologiques

IA

IA

La reconstruction 3D du visage de Jimmy Lin peut être réalisée à l'aide de deux A100 et d'un CNN 2D !

La reconstruction 3D du visage de Jimmy Lin peut être réalisée à l'aide de deux A100 et d'un CNN 2D !

La reconstruction 3D du visage de Jimmy Lin peut être réalisée à l'aide de deux A100 et d'un CNN 2D !

La technologie de reconstruction 3D a toujours été un domaine de recherche clé dans le domaine de l'infographie et de la vision par ordinateur.

En termes simples, la reconstruction 3D consiste à restaurer la structure de la scène 3D sur la base d'images 2D.

On dit qu'après que Jimmy Lin ait eu un accident de voiture, son plan de reconstruction faciale a utilisé une reconstruction tridimensionnelle.

Différentes voies techniques pour la reconstruction 3D devraient être intégrées

En fait, la technologie de reconstruction 3D a été largement utilisée dans les jeux, les films, l'arpentage et la cartographie, le positionnement, la navigation, la conduite autonome, la VR/AR, l'industrie. fabrication et biens de consommation.

Avec le développement du GPU et de l'informatique distribuée, ainsi que la maturité progressive des caméras de profondeur telles que la Kinect de Microsoft, la XTion d'ASUS et le RealSense d'Intel en termes de matériel, le coût de la reconstruction 3D a montré une tendance à la baisse.

En termes de fonctionnement, le processus de reconstruction 3D peut être grossièrement divisé en cinq étapes.

La première étape est l'acquisition d'images.

La reconstruction 3D étant le fonctionnement inverse d'une caméra, il faut d'abord utiliser une caméra pour obtenir une image 2D d'un objet 3D.

Cette étape ne peut être ignorée, car les conditions d'éclairage, les caractéristiques géométriques de la caméra, etc. ont un grand impact sur le traitement ultérieur de l'image.

La deuxième étape est le calibrage de la caméra.

Cette étape consiste à utiliser les images capturées par la caméra pour restituer les objets dans l'espace.

On suppose généralement qu'il existe une relation linéaire entre l'image capturée par la caméra et l'objet dans l'espace tridimensionnel. Le processus de résolution des paramètres de la relation linéaire est appelé calibrage de la caméra.

La troisième étape est l'extraction de fonctionnalités.

Les caractéristiques comprennent principalement des points caractéristiques, des lignes caractéristiques et des zones.

Dans la plupart des cas, les points caractéristiques sont utilisés comme primitives de correspondance. La forme sous laquelle les points caractéristiques sont extraits est étroitement liée à la stratégie de correspondance utilisée.

Par conséquent, lors de l'extraction de points caractéristiques, vous devez d'abord déterminer quelle méthode de correspondance utiliser.

La quatrième étape est la correspondance stéréo.

La correspondance stéréo consiste à établir une correspondance entre des paires d'images en fonction des caractéristiques extraites, c'est-à-dire à faire correspondre les points d'imagerie du même point de l'espace physique dans deux images différentes, un à un.

La cinquième étape, la reconstruction tridimensionnelle.

Avec des résultats de correspondance relativement précis, combinés aux paramètres internes et externes de l'étalonnage de la caméra, les informations de la scène tridimensionnelle peuvent être restaurées.

Ces cinq étapes sont imbriquées. Ce n'est que lorsque chaque lien est effectué avec une grande précision et de petites erreurs qu'un système de vision stéréoscopique relativement précis peut être conçu.

En termes d'algorithme, la reconstruction 3D peut être grossièrement divisée en deux catégories. L'une est l'algorithme de reconstruction 3D basé sur la géométrie multi-vue traditionnelle.

L'autre est un algorithme de reconstruction tridimensionnelle basé sur l'apprentissage profond.

Actuellement, en raison des énormes avantages de CNN dans la correspondance des caractéristiques des images, de plus en plus de chercheurs commencent à tourner leur attention vers la reconstruction tridimensionnelle basée sur l'apprentissage profond.

Cependant, cette méthode est principalement une méthode d'apprentissage supervisé et dépend fortement de l'ensemble de données.

La collecte et l'étiquetage d'ensembles de données ont toujours été une source de problèmes pour l'apprentissage supervisé. C'est pourquoi la reconstruction tridimensionnelle basée sur l'apprentissage profond est principalement étudiée dans le sens de la reconstruction d'objets plus petits.

De plus, la reconstruction 3D basée sur l'apprentissage profond a une haute fidélité et de meilleures performances en termes de précision.

Mais la formation du modèle prend beaucoup de temps et les couches convolutives 3D pour la reconstruction 3D sont très coûteuses.

Par conséquent, certains chercheurs ont commencé à réexaminer la méthode traditionnelle de reconstruction tridimensionnelle.

Bien que la méthode traditionnelle de reconstruction tridimensionnelle présente des défauts de performances, la technologie est relativement mature.

Ensuite, une certaine intégration des deux méthodes pourra conduire à de meilleurs résultats.

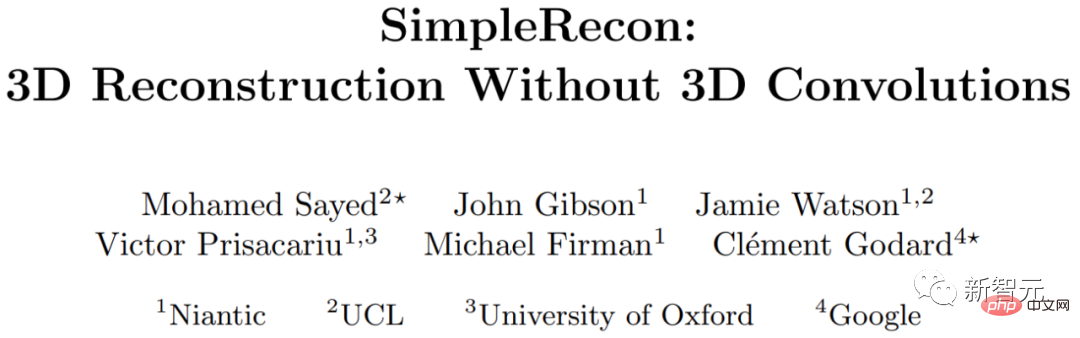

La reconstruction 3D est possible sans couches convolutionnelles 3D

Des chercheurs d'institutions telles que l'Université de Londres, l'Université d'Oxford, Google et Niantic (une société licorne issue de Google qui étudie la RA), explorent. Méthode de reconstruction 3D sans convolution 3D.

Ils proposent un estimateur de profondeur multi-vues simple et à la pointe de la technologie.

Cet estimateur de profondeur multi-vues présente deux avancées.

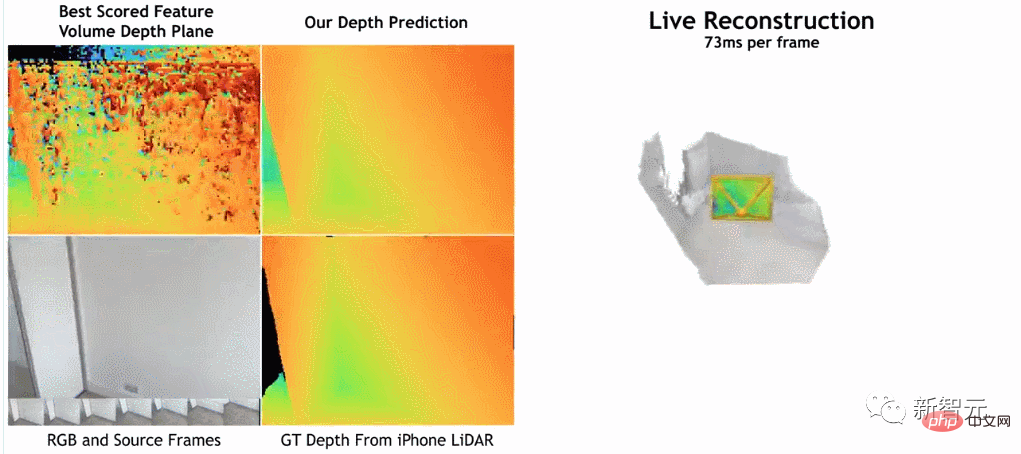

Premièrement, un CNN 2D bien conçu peut tirer parti de puissants a priori d'images et obtenir des quantités de caractéristiques de balayage plan et des pertes géométriques.

Deuxièmement, il peut intégrer des images clés et des métadonnées géométriques dans le volume de coûts, permettant ainsi d'être informé ; notation du plan de profondeur.

Selon les chercheurs, leur méthode a une nette avance sur les méthodes de pointe actuelles en matière d'estimation en profondeur.

et est proche ou meilleur pour la reconstruction 3D sur ScanNet et 7-Scenes, mais permet toujours la reconstruction en ligne et en temps réel avec une faible mémoire.

De plus, la vitesse de reconstruction est très rapide, ne prenant qu'environ 73 ms par image.

Les chercheurs pensent que cela rend possible une reconstruction précise grâce à une fusion profonde rapide.

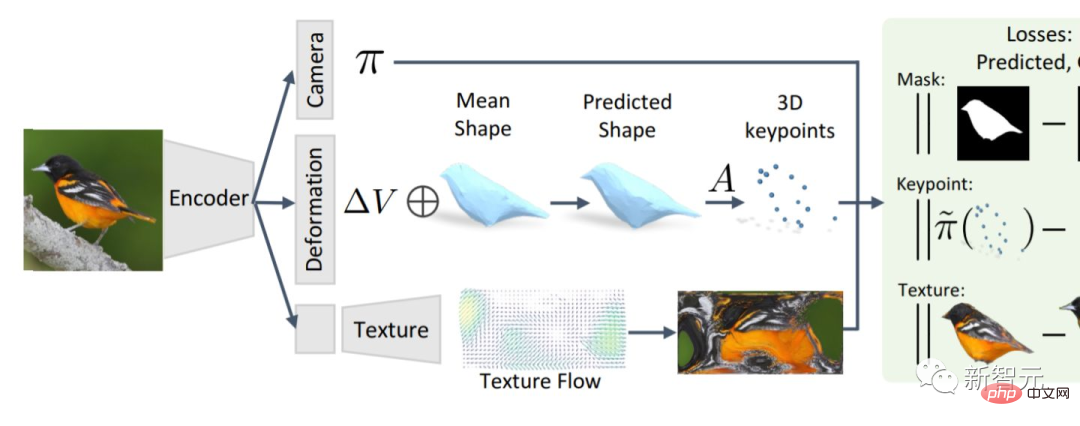

Selon les chercheurs, leur méthode consiste à utiliser un encodeur d'image pour extraire les caractéristiques correspondantes de l'image de référence et de l'image source, puis à les saisir dans le volume de coût, puis à utiliser un outil convolutif 2D. réseau d'encodeurs/décodeurs Traite les résultats de sortie du volume de coûts.

Cette recherche a été mise en œuvre à l'aide de PyTorch et a utilisé ResNet18 pour l'extraction des fonctionnalités correspondantes. Elle a également utilisé deux GPU A100 de 40 Go. Il a fallu 36 heures pour terminer l'ensemble du travail.

De plus, bien que le modèle n'utilise pas de couches convolutives 3D, il surpasse le modèle de base en termes d'indicateurs de prédiction de profondeur.

Cela montre qu'un réseau 2D bien conçu et entraîné est suffisant pour une estimation de profondeur de haute qualité.

Les lecteurs intéressés peuvent lire le texte original de l'article :

https://nianticlabs.github.io/simplerecon/resources/SimpleRecon.pdf

Cependant, il doit être a rappelé qu'il existe un seuil professionnel pour lire cet article et que certains détails peuvent ne pas être facilement remarqués.

Autant jeter un œil à ce que les internautes étrangers ont découvert dans ce journal.

Un internaute nommé "stickshiftplease" a déclaré : "Bien que le temps d'inférence sur l'A100 soit d'environ 70 millisecondes, il peut être raccourci grâce à diverses techniques, et la mémoire requise ne doit pas nécessairement être de 40 Go, le plus petit modèle fonctionne à 2,6 Go. mémoire".

Un autre internaute nommé "IrreverentHippie" a souligné : "Veuillez noter que cette étude est toujours basée sur l'échantillonnage d'un capteur de profondeur LiDAR. C'est pourquoi cette méthode atteint une si bonne qualité et précision."

Il y a aussi un commentaire relativement long d'un internaute nommé "nickthorpie". Il a déclaré : "Les avantages et les inconvénients des caméras ToF sont bien documentés. ToF résout divers problèmes qui affectent le traitement des images brutes. Parmi eux, les deux principaux problèmes sont Évolutivité et détails. Les petits détails tels que les bords de table ou les poteaux fins sont toujours difficiles à détecter avec ToF. Ceci est crucial pour les applications autonomes ou semi-autonomes

De plus, puisque ToF est un capteur actif, donc lorsque plusieurs capteurs sont utilisés. ensemble, comme dans un carrefour bondé ou dans un entrepôt auto-construit, la qualité de l'image se dégrade rapidement

Évidemment, plus vous collectez de données dans une scène, plus la description que vous créez est mauvaise. étudier les données d'images brutes car elles sont plus flexibles.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Pourquoi le Gaussian Splatting est-il si populaire dans la conduite autonome que le NeRF commence à être abandonné ?

Jan 17, 2024 pm 02:57 PM

Pourquoi le Gaussian Splatting est-il si populaire dans la conduite autonome que le NeRF commence à être abandonné ?

Jan 17, 2024 pm 02:57 PM

Écrit ci-dessus et compréhension personnelle de l'auteur Le Gaussiansplatting tridimensionnel (3DGS) est une technologie transformatrice qui a émergé dans les domaines des champs de rayonnement explicites et de l'infographie ces dernières années. Cette méthode innovante se caractérise par l’utilisation de millions de gaussiennes 3D, ce qui est très différent de la méthode du champ de rayonnement neuronal (NeRF), qui utilise principalement un modèle implicite basé sur les coordonnées pour mapper les coordonnées spatiales aux valeurs des pixels. Avec sa représentation explicite de scènes et ses algorithmes de rendu différenciables, 3DGS garantit non seulement des capacités de rendu en temps réel, mais introduit également un niveau de contrôle et d'édition de scène sans précédent. Cela positionne 3DGS comme un révolutionnaire potentiel pour la reconstruction et la représentation 3D de nouvelle génération. À cette fin, nous fournissons pour la première fois un aperçu systématique des derniers développements et préoccupations dans le domaine du 3DGS.

CLIP-BEVFormer : superviser explicitement la structure BEVFormer pour améliorer les performances de détection à longue traîne

Mar 26, 2024 pm 12:41 PM

CLIP-BEVFormer : superviser explicitement la structure BEVFormer pour améliorer les performances de détection à longue traîne

Mar 26, 2024 pm 12:41 PM

Écrit ci-dessus et compréhension personnelle de l'auteur : À l'heure actuelle, dans l'ensemble du système de conduite autonome, le module de perception joue un rôle essentiel. Le véhicule autonome roulant sur la route ne peut obtenir des résultats de perception précis que via le module de perception en aval. dans le système de conduite autonome, prend des jugements et des décisions comportementales opportuns et corrects. Actuellement, les voitures dotées de fonctions de conduite autonome sont généralement équipées d'une variété de capteurs d'informations de données, notamment des capteurs de caméra à vision panoramique, des capteurs lidar et des capteurs radar à ondes millimétriques pour collecter des informations selon différentes modalités afin d'accomplir des tâches de perception précises. L'algorithme de perception BEV basé sur la vision pure est privilégié par l'industrie en raison de son faible coût matériel et de sa facilité de déploiement, et ses résultats peuvent être facilement appliqués à diverses tâches en aval.

Choisir une caméra ou un lidar ? Une étude récente sur la détection robuste d'objets 3D

Jan 26, 2024 am 11:18 AM

Choisir une caméra ou un lidar ? Une étude récente sur la détection robuste d'objets 3D

Jan 26, 2024 am 11:18 AM

0. Écrit à l'avant&& Compréhension personnelle que les systèmes de conduite autonome s'appuient sur des technologies avancées de perception, de prise de décision et de contrôle, en utilisant divers capteurs (tels que caméras, lidar, radar, etc.) pour percevoir l'environnement et en utilisant des algorithmes et des modèles pour une analyse et une prise de décision en temps réel. Cela permet aux véhicules de reconnaître les panneaux de signalisation, de détecter et de suivre d'autres véhicules, de prédire le comportement des piétons, etc., permettant ainsi de fonctionner en toute sécurité et de s'adapter à des environnements de circulation complexes. Cette technologie attire actuellement une grande attention et est considérée comme un domaine de développement important pour l'avenir des transports. . un. Mais ce qui rend la conduite autonome difficile, c'est de trouver comment faire comprendre à la voiture ce qui se passe autour d'elle. Cela nécessite que l'algorithme de détection d'objets tridimensionnels du système de conduite autonome puisse percevoir et décrire avec précision les objets dans l'environnement, y compris leur emplacement,

Les traits du visage volent, ouvrent la bouche, regardent fixement et lèvent les sourcils. L'IA peut les imiter parfaitement, ce qui rend impossible la prévention des escroqueries vidéo.

Dec 14, 2023 pm 11:30 PM

Les traits du visage volent, ouvrent la bouche, regardent fixement et lèvent les sourcils. L'IA peut les imiter parfaitement, ce qui rend impossible la prévention des escroqueries vidéo.

Dec 14, 2023 pm 11:30 PM

Avec une capacité d'imitation de l'IA aussi puissante, il est vraiment impossible de l'empêcher. Le développement de l’IA a-t-il atteint ce niveau aujourd’hui ? Votre pied avant fait voler les traits de votre visage, et sur votre pied arrière, la même expression est reproduite. Regarder fixement, lever les sourcils, faire la moue, aussi exagérée que soit l'expression, tout est parfaitement imité. Augmentez la difficulté, haussez les sourcils, ouvrez plus grand les yeux, et même la forme de la bouche est tordue, et l'avatar du personnage virtuel peut parfaitement reproduire l'expression. Lorsque vous ajustez les paramètres à gauche, l'avatar virtuel à droite modifiera également ses mouvements en conséquence pour donner un gros plan de la bouche et des yeux. On ne peut pas dire que l'imitation soit exactement la même, seule l'expression est exactement la même. idem (extrême droite). La recherche provient d'institutions telles que l'Université technique de Munich, qui propose GaussianAvatars, qui

Les dernières nouvelles de l'Université d'Oxford ! Mickey : correspondance d'images 2D en 3D SOTA ! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Les dernières nouvelles de l'Université d'Oxford ! Mickey : correspondance d'images 2D en 3D SOTA ! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Lien du projet écrit devant : https://nianticlabs.github.io/mickey/ Étant donné deux images, la pose de la caméra entre elles peut être estimée en établissant la correspondance entre les images. En règle générale, ces correspondances sont 2D à 2D et nos poses estimées sont à échelle indéterminée. Certaines applications, telles que la réalité augmentée instantanée, à tout moment et en tout lieu, nécessitent une estimation de pose des métriques d'échelle, elles s'appuient donc sur des estimateurs de profondeur externes pour récupérer l'échelle. Cet article propose MicKey, un processus de correspondance de points clés capable de prédire les correspondances métriques dans l'espace d'une caméra 3D. En apprenant la correspondance des coordonnées 3D entre les images, nous sommes en mesure de déduire des métriques relatives.

MotionLM : technologie de modélisation de langage pour la prédiction de mouvement multi-agents

Oct 13, 2023 pm 12:09 PM

MotionLM : technologie de modélisation de langage pour la prédiction de mouvement multi-agents

Oct 13, 2023 pm 12:09 PM

Cet article est reproduit avec la permission du compte public Autonomous Driving Heart. Veuillez contacter la source pour la réimpression. Titre original : MotionLM : Multi-Agent Motion Forecasting as Language Modeling Lien vers l'article : https://arxiv.org/pdf/2309.16534.pdf Affiliation de l'auteur : Conférence Waymo : ICCV2023 Idée d'article : Pour la planification de la sécurité des véhicules autonomes, prédisez de manière fiable le comportement futur des agents routiers est cruciale. Cette étude représente les trajectoires continues sous forme de séquences de jetons de mouvement discrets et traite la prédiction de mouvement multi-agents comme une tâche de modélisation du langage. Le modèle que nous proposons, MotionLM, présente les avantages suivants :

Le LLM est terminé ! OmniDrive : Intégration de la perception 3D et de la planification du raisonnement (la dernière version de NVIDIA)

May 09, 2024 pm 04:55 PM

Le LLM est terminé ! OmniDrive : Intégration de la perception 3D et de la planification du raisonnement (la dernière version de NVIDIA)

May 09, 2024 pm 04:55 PM

Écrit ci-dessus et compréhension personnelle de l'auteur : cet article est dédié à la résolution des principaux défis des grands modèles de langage multimodaux (MLLM) actuels dans les applications de conduite autonome, c'est-à-dire le problème de l'extension des MLLM de la compréhension 2D à l'espace 3D. Cette expansion est particulièrement importante car les véhicules autonomes (VA) doivent prendre des décisions précises concernant les environnements 3D. La compréhension spatiale 3D est essentielle pour les véhicules utilitaires car elle a un impact direct sur la capacité du véhicule à prendre des décisions éclairées, à prédire les états futurs et à interagir en toute sécurité avec l’environnement. Les modèles de langage multimodaux actuels (tels que LLaVA-1.5) ne peuvent souvent gérer que des entrées d'images de résolution inférieure (par exemple) en raison des limitations de résolution de l'encodeur visuel et des limitations de la longueur de la séquence LLM. Cependant, les applications de conduite autonome nécessitent

Le robot humanoïde universel intelligent GR-1 Fourier est sur le point de commencer la prévente !

Sep 27, 2023 pm 08:41 PM

Le robot humanoïde universel intelligent GR-1 Fourier est sur le point de commencer la prévente !

Sep 27, 2023 pm 08:41 PM

Le robot humanoïde, qui mesure 1,65 mètre, pèse 55 kilogrammes et possède 44 degrés de liberté dans son corps, peut marcher rapidement, éviter les obstacles rapidement, monter et descendre régulièrement les pentes et résister aux chocs et aux interférences. Vous pouvez désormais le ramener chez vous. ! Le robot humanoïde universel GR-1 de Fourier Intelligence a commencé la prévente. Salle de conférence Robot Le robot humanoïde universel Fourier GR-1 de Fourier Intelligence est maintenant ouvert à la prévente. GR-1 a une configuration de tronc hautement bionique et un contrôle de mouvement anthropomorphique. Il a 44 degrés de liberté dans tout le corps. Il a la capacité de marcher, d'éviter les obstacles, de franchir des obstacles, de monter et de descendre des pentes, de résister aux interférences et de s'adapter. à différentes surfaces routières. C'est un système d'intelligence artificielle général. Page de prévente du site officiel : www.fftai.cn/order#FourierGR-1# Fourier Intelligence doit être réécrit.