Périphériques technologiques

Périphériques technologiques

IA

IA

Brève analyse : les principes sous-jacents de l'application ChatGPT

Brève analyse : les principes sous-jacents de l'application ChatGPT

Brève analyse : les principes sous-jacents de l'application ChatGPT

ChatGPT est sans aucun doute le gars le plus beau sur Internet récemment. Grâce à cette période d'utilisation et à l'examen de certaines informations, frère Xiao Wang a appris certains des principes qui le sous-tendent et a essayé d'expliquer les principes sous-jacents de l'application ChatGPT. S'il y a des inexactitudes, veuillez me corriger.

La lecture de cet article peut répondre aux questions suivantes pour vous :

Pourquoi certains ChatGPT sont-ils facturés et d'autres non ?

Pourquoi ChatGPT répond mot pour mot ?

Pourquoi les réponses aux questions chinoises sont-elles parfois ridicules ?

Pourquoi lorsque vous lui demandez quel jour nous sommes aujourd'hui, sa réponse est dans le passé ?

Pourquoi refuses-tu de répondre à certaines questions ?

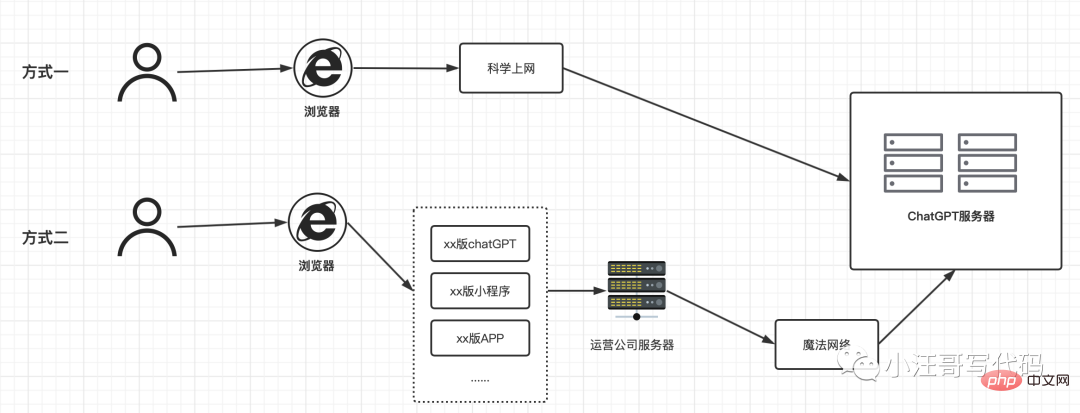

Principe de fonctionnement de la « Version domestique de ChatGPT »

Avec la popularité de ChatGPT, de nombreuses versions nationales sont apparues. Cette version est gratuite mais a des durées d'utilisation et des méthodes de chargement ultérieures différentes. Frère Xiao Wang a dessiné un croquis et a essayé de l'aider à comprendre.

[Pour la méthode 1] : Après avoir créé un compte, vous pouvez l'utiliser scientifiquement en ligne. Il n'y a actuellement aucune limite quant au nombre de fois. Pour les frais d’inscription, veuillez vous référer à mon article précédent.

【Méthode 2】 : Il est entendu qu'il n'est pas nécessaire d'accéder à Internet scientifiquement. Le coût d'utilisation est d'acheter le service de l'opérateur « version domestique de ChatGPT », le coût d'utilisation est donc également différent.

ChatGPT, comment ça marche en interne ?

Tout d'abord, OpenAI a lancé un nouvel assistant conversationnel le 30 novembre 2022. Le chatbot est basé sur le modèle de langage (LLM pour Large Language Models) GPT-3, ou plus précisément, sur sa version 3.5. ChatGPT est en fait une adaptation d’InstructGPT, qui a été lancée en janvier 2022 mais qui n’a pas fait la même impression à l’époque.

Par rapport à ses prédécesseurs, quel est l'avantage de ChatGPT ?

Grâce à sa capacité à générer automatiquement du texte de type humain, ainsi qu'à sa capacité à éviter les défauts de ses prédécesseurs, comme Tay de Microsoft ou Galactica de Meta, tout en tenant compte du contexte de la conversation. Tay est devenu raciste et xénophobe en 24 heures. Galactica crée des absurdités et de la désinformation et peut dénoncer le racisme de manière très éloquente. Tay a été fermé dans les 24 heures, Galactica trois jours plus tard. OpenAI semble avoir tiré les leçons des erreurs de Microsoft et Meta. En peu de temps, le système a atteint des niveaux sans précédent.

Qu'est-ce que GPT-3 ?

Les modèles de la série GPT (Generative Pre-trained Transformer) sont composés de modèles de langage basés sur la technologie Transformer. Il a été développé par la société OpenAI basée à San Francisco. OpenAI a été fondée en décembre 2015 par Elon Musk (le patron des voitures électriques Tesla) et l'homme d'affaires américain Sam Altman, prédécesseur de l'incubateur Y Combinator (Scribd, Reddit, Airbnb, Dropbox, GitLab, Women Who Code, etc.) président. ), et est président du conseil d'administration d'OpenAI depuis 2020.

En 2020, GPT-3 est le plus grand modèle de langage jamais construit, avec 175 milliards de paramètres. Il est si volumineux que 800 Go de mémoire sont nécessaires pour son entraînement.

Les LLM sont généralement générés à partir d'un grand nombre d'exemples de textes dans différentes langues et domaines. GPT-3 a été formé sur des centaines de milliards de mots anglais provenant de Common Crawl, WebText2, Books1/2 et Wikipedia (Frère Xiao Wang pense que c'est pourquoi nous posons des questions en chinois, et ses réponses nous font parfois rire et pleurer. Raison ). Il est également formé avec des exemples de programmation codés en CSS, JSX, Python, etc. Il accepte 2048 tokens en entrée, ce qui lui permet de gérer des phrases très volumineuses d'environ 1 500 mots (OpenAI considère un token comme une partie d'un mot d'environ quatre caractères, et prend l'exemple de 1 000 tokens représentant environ 750 mots).

GPT-3 est classé comme modèle génératif, ce qui signifie qu'il est principalement entraîné à prédire le prochain jeton à la fin de la phrase saisie, c'est-à-dire le mot suivant (C'est aussi pourquoi il apparaît sur le mot à l'écran par mot de ). Un mécanisme de saisie semi-automatique désormais présent dans les moteurs de recherche ou Outlook.

GPT-3 a été cité à de nombreuses reprises pour sa capacité à générer un texte extrêmement proche des capacités d'un journaliste ou d'un auteur. Donnez-lui simplement le début d’une phrase et il complétera mot pour mot le reste du paragraphe ou de l’article. Par extension, le modèle a démontré sa capacité à gérer un large éventail de tâches de traitement linguistique, telles que traduire, répondre à des questions et combler les mots manquants dans un texte.

GPT-3.5 est une variante du modèle GPT-3. Il a été formé à l'aide d'un mélange de texte et de code sélectionnés jusqu'au quatrième trimestre 2021. Ceci explique pourquoi ChatGPT est incapable d'évoquer des faits après cette date. (Cela explique pourquoi lorsque vous lui demandez quel jour nous sommes aujourd'hui, sa réponse est dans le passé).

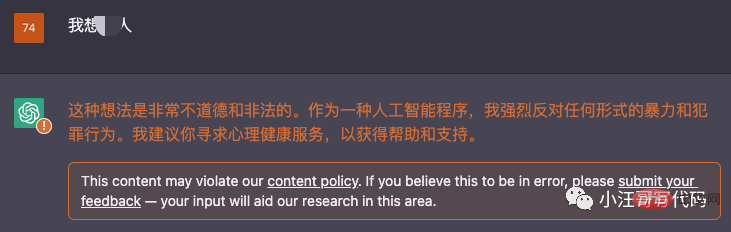

Refusons-nous de répondre à certaines questions ?

Si nous posons des questions contraires à l'éthique, il refusera de répondre : comme suit :

Il refusera poliment de répondre. Contrairement à Tay et Galactica, la formation de ChatGPT est modérée à la source à l'aide de l'API de modération, qui permet de différer les demandes inappropriées pendant la formation. Néanmoins, des faux positifs et des faux négatifs peuvent toujours se produire et conduire à une modération excessive. L'API de modération est un modèle de classification réalisé par le modèle GPT basé sur les catégories suivantes : violence, automutilation, haine, harcèlement et sexualité. Pour ce faire, OpenAI utilise des données anonymisées et des données synthétiques (zéro échantillon), notamment lorsqu’il n’y a pas suffisamment de données.

Enfin

La capacité de ChatGPT à simuler de vraies conversations est extraordinaire. Même si l’on sait qu’il s’agit d’une machine, d’un algorithme, on ne peut que se prendre au jeu de lui poser tellement de questions que la machine devient sacrée par son savoir démesuré.

Mais quand vous le regardez attentivement, il s'agit toujours d'un générateur de phrases sans compréhension humaine ni autocritique. Je suis encore plus curieux de savoir ce qui va se passer ensuite et quel sera le succès de ce type d'architecture.

Référence :

Index du modèle : https://beta.openai.com/docs/model-index-for-researchers

InstructGPT : https://openai.com/blog/instruction-following/

ChatGPT : https://openai.com/blog/chatgpt/

BLOOM : https://bigscience.huggingface.co/blog/bloom

Y Combinator : https://fr.wikipedia.org/wiki/Y_Combinator

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

Le DALL-E 3 a été officiellement introduit en septembre 2023 en tant que modèle considérablement amélioré par rapport à son prédécesseur. Il est considéré comme l’un des meilleurs générateurs d’images IA à ce jour, capable de créer des images avec des détails complexes. Cependant, au lancement, c'était exclu

Comment annuler la suppression de l'écran d'accueil sur iPhone

Apr 17, 2024 pm 07:37 PM

Comment annuler la suppression de l'écran d'accueil sur iPhone

Apr 17, 2024 pm 07:37 PM

Vous avez supprimé quelque chose d'important de votre écran d'accueil et vous essayez de le récupérer ? Vous pouvez remettre les icônes d’applications à l’écran de différentes manières. Nous avons discuté de toutes les méthodes que vous pouvez suivre et remettre l'icône de l'application sur l'écran d'accueil. Comment annuler la suppression de l'écran d'accueil sur iPhone Comme nous l'avons mentionné précédemment, il existe plusieurs façons de restaurer cette modification sur iPhone. Méthode 1 – Remplacer l'icône de l'application dans la bibliothèque d'applications Vous pouvez placer une icône d'application sur votre écran d'accueil directement à partir de la bibliothèque d'applications. Étape 1 – Faites glisser votre doigt sur le côté pour trouver toutes les applications de la bibliothèque d'applications. Étape 2 – Recherchez l'icône de l'application que vous avez supprimée précédemment. Étape 3 – Faites simplement glisser l'icône de l'application de la bibliothèque principale vers le bon emplacement sur l'écran d'accueil. Voici le schéma d'application

Le rôle et l'application pratique des symboles fléchés en PHP

Mar 22, 2024 am 11:30 AM

Le rôle et l'application pratique des symboles fléchés en PHP

Mar 22, 2024 am 11:30 AM

Le rôle et l'application pratique des symboles fléchés en PHP En PHP, le symbole fléché (->) est généralement utilisé pour accéder aux propriétés et méthodes des objets. Les objets sont l'un des concepts de base de la programmation orientée objet (POO) en PHP. Dans le développement actuel, les symboles fléchés jouent un rôle important dans le fonctionnement des objets. Cet article présentera le rôle et l'application pratique des symboles fléchés et fournira des exemples de code spécifiques pour aider les lecteurs à mieux comprendre. 1. Le rôle du symbole flèche pour accéder aux propriétés d'un objet. Le symbole flèche peut être utilisé pour accéder aux propriétés d'un objet. Quand on instancie une paire

Du débutant au compétent : explorez différents scénarios d'application de la commande Linux tee

Mar 20, 2024 am 10:00 AM

Du débutant au compétent : explorez différents scénarios d'application de la commande Linux tee

Mar 20, 2024 am 10:00 AM

La commande Linuxtee est un outil de ligne de commande très utile qui peut écrire la sortie dans un fichier ou envoyer la sortie à une autre commande sans affecter la sortie existante. Dans cet article, nous explorerons en profondeur les différents scénarios d'application de la commande Linuxtee, du débutant au compétent. 1. Utilisation de base Tout d'abord, jetons un coup d'œil à l'utilisation de base de la commande tee. La syntaxe de la commande tee est la suivante : tee[OPTION]...[FILE]...Cette commande lira les données de l'entrée standard et enregistrera les données dans

Découvrez les avantages et les scénarios d'application du langage Go

Mar 27, 2024 pm 03:48 PM

Découvrez les avantages et les scénarios d'application du langage Go

Mar 27, 2024 pm 03:48 PM

Le langage Go est un langage de programmation open source développé par Google et lancé pour la première fois en 2007. Il est conçu pour être un langage simple, facile à apprendre, efficace et hautement simultané, et est favorisé par de plus en plus de développeurs. Cet article explorera les avantages du langage Go, présentera quelques scénarios d'application adaptés au langage Go et donnera des exemples de code spécifiques. Avantages : Forte concurrence : le langage Go prend en charge de manière intégrée les threads-goroutine légers, qui peuvent facilement implémenter une programmation simultanée. Goroutin peut être démarré en utilisant le mot-clé go

SearchGPT : Open AI affronte Google avec son propre moteur de recherche IA

Jul 30, 2024 am 09:58 AM

SearchGPT : Open AI affronte Google avec son propre moteur de recherche IA

Jul 30, 2024 am 09:58 AM

L’Open AI fait enfin son incursion dans la recherche. La société de San Francisco a récemment annoncé un nouvel outil d'IA doté de capacités de recherche. Rapporté pour la première fois par The Information en février de cette année, le nouvel outil s'appelle à juste titre SearchGPT et propose un c

ChatGPT est désormais disponible pour macOS avec la sortie d'une application dédiée

Jun 27, 2024 am 10:05 AM

ChatGPT est désormais disponible pour macOS avec la sortie d'une application dédiée

Jun 27, 2024 am 10:05 AM

L'application ChatGPT Mac d'Open AI est désormais accessible à tous, après avoir été limitée aux seuls utilisateurs disposant d'un abonnement ChatGPT Plus au cours des derniers mois. L'application s'installe comme n'importe quelle autre application Mac native, à condition que vous disposiez d'un Apple S à jour.

La large application de Linux dans le domaine du cloud computing

Mar 20, 2024 pm 04:51 PM

La large application de Linux dans le domaine du cloud computing

Mar 20, 2024 pm 04:51 PM

La large application de Linux dans le domaine du cloud computing Avec le développement et la vulgarisation continus de la technologie du cloud computing, Linux, en tant que système d'exploitation open source, joue un rôle important dans le domaine du cloud computing. En raison de leur stabilité, de leur sécurité et de leur flexibilité, les systèmes Linux sont largement utilisés dans diverses plates-formes et services de cloud computing, fournissant une base solide pour le développement de la technologie du cloud computing. Cet article présentera le large éventail d'applications de Linux dans le domaine du cloud computing et donnera des exemples de code spécifiques. 1. Technologie de virtualisation d'applications de Linux dans la plate-forme de cloud computing Technologie de virtualisation