Donnez-moi une photo et générez une vidéo de 30 secondes !

L'IA a-t-elle encore progressé ?

Et c'est le genre qui génère une vidéo continue de 30 secondes à partir d'une image.

emm....La qualité n'est-elle pas un peu trop floue

Sachez que celle-ci n'est générée qu'à partir d'une seule image (la première image) et n'en a aucune affichée informations géométriques.

Il s'agit d'un cadre général pour les tâches de modélisation d'images et de vision basé sur la prédiction de trame probabiliste récemment proposée par DeepMind - Transframer.

Pour faire simple, Transframer est utilisé pour prédire la probabilité de n'importe quelle image.

Ces images peuvent être conditionnées sur une ou plusieurs images contextuelles annotées, qui peuvent être des images vidéo précédentes, des horodatages ou des scènes de vue étiquetées par une caméra.

Architecture Transframer

Voyons d'abord comment fonctionne cette architecture magique Transframer.

L'adresse papier est affichée ci-dessous, les enfants intéressés peuvent y jeter un oeil ~ https://arxiv.org/abs/2203.09494

Afin d'estimer la répartition des prédictions sur la cible image , nous avons besoin d’un modèle de génération d’expression capable de produire une sortie diversifiée et de haute qualité.

Bien que les résultats de DC Transformer sur un seul domaine d'image puissent répondre aux besoins, ils ne sont pas conditionnés à l'ensemble de textes multi-images {(In,an)} dont nous avons besoin.

Nous avons donc étendu DC Transformer pour permettre la prédiction conditionnelle d'images et d'annotations.

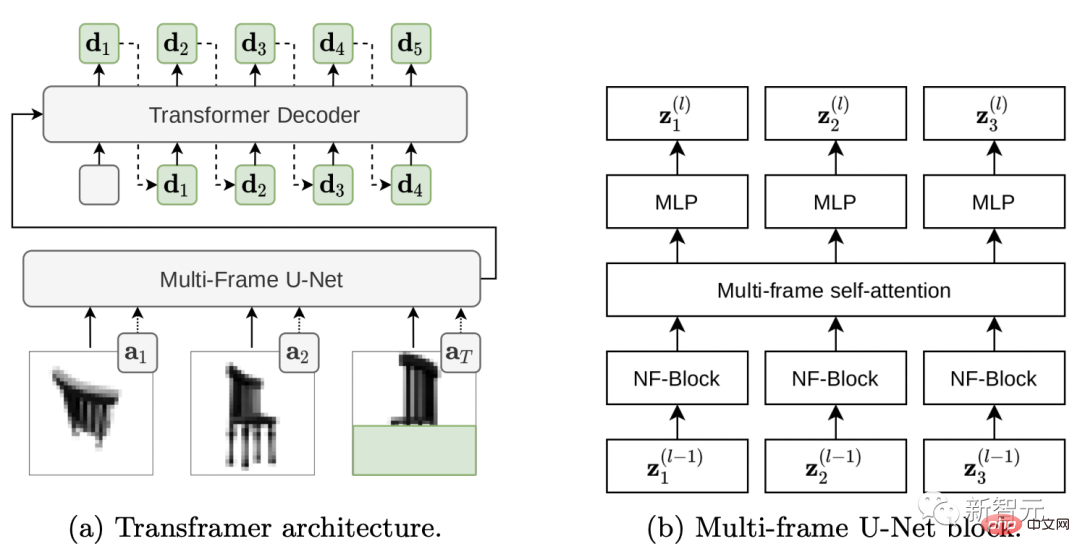

Nous remplaçons DC Transformer par un encodeur de style Vision-Transformer qui fonctionne sur une seule image DCT en utilisant une architecture U-Net multi-images pour traiter un ensemble d'images annotées ainsi qu'une image DCT cible partiellement cachée.

Voyons comment fonctionne l'architecture Transframer.

(a) Transframer prend en entrée les images DCT (a1 et a2) ainsi que l'image DCT cible partiellement cachée (aT) et des annotations supplémentaires, qui sont traitées par l'encodeur multi-trame U-Net. Ensuite, la sortie U-Net est transmise au décodeur DC-Transformer via une attention croisée, qui régresse automatiquement pour générer une séquence de jetons DCT (lettres vertes) correspondant à la partie cachée de l'image cible. (b) Le bloc U-Net multi-trame est composé d'un bloc de convolution NF-Net et d'un bloc d'auto-attention multi-trame, qui échangent des informations entre les trames d'entrée et le MLP résiduel de style transformateur.

Jetons un coup d'œil à Multi-Frame U-Net qui traite la saisie d'images.

L'entrée dans U-Net est une séquence composée de N trames DCT et de trames DCT cibles partiellement cachées, et les informations d'annotation sont fournies sous forme de vecteurs associés à chaque trame d'entrée.

Le composant principal d'U-Net est un bloc de calcul qui applique d'abord un bloc convolutionnel NF-ResNet partagé à chaque trame d'entrée, puis applique un bloc d'auto-attention de style Transformer pour agréger les informations entre les trames. (Figure 2 b)

Le bloc NF-ResNet est constitué de convolutions groupées et de couches de compression et d'excitation, visant à améliorer les performances du TPU.

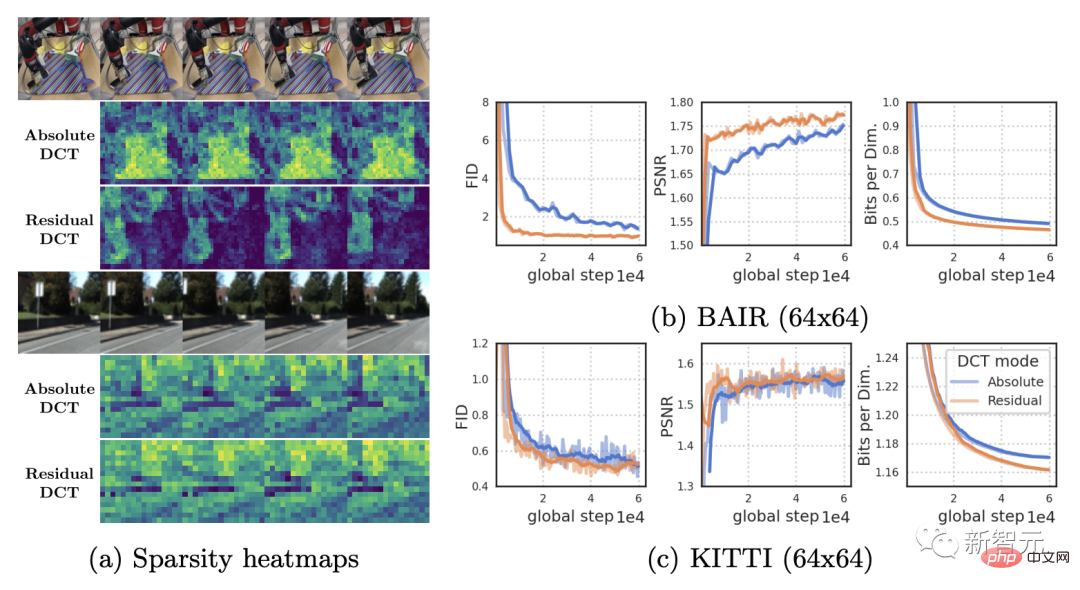

Ci-dessous, la figure (a) compare la rareté des représentations DCT absolues et résiduelles des vidéos RoboNet (128x128) et KITTI.

Étant donné que RoboNet est constitué de vidéos statiques avec seulement quelques éléments mobiles, la rareté de la représentation de l'image résiduelle augmente considérablement.

Et les vidéos KITTI ont généralement une caméra en mouvement, ce qui entraîne des écarts presque partout dans les images consécutives.

Mais dans ce cas, les bénéfices d'une petite parcimonie sont également affaiblis.

Puissant dans plusieurs tâches de vision

Grâce à des tests sur une série d'ensembles de données et de tâches, les résultats montrent que Transframer peut être appliqué à un large éventail de tâches.

Y compris la modélisation vidéo, la synthèse de nouvelles vues, la segmentation sémantique, la reconnaissance d'objets, l'estimation de la profondeur, la prédiction du flux optique, etc.

Modélisation vidéo

Prédisez l'image suivante à partir d'une séquence d'images vidéo d'entrée via Transframer.

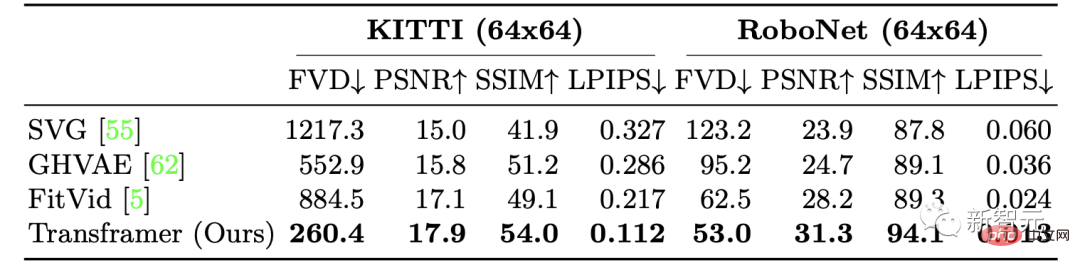

Les chercheurs ont entraîné les performances de Transframer en matière de génération vidéo sur deux ensembles de données : KITTI et RoboNet respectivement.

Pour KITTI, étant donné 5 cadres contextuels et 25 cadres d'échantillonnage, les résultats montrent que les performances du modèle Transframer s'améliorent sur toutes les métriques, parmi lesquelles les améliorations de LPIPS et FVD sont les plus évidentes.

Sur RoboNet, les chercheurs ont reçu 2 cadres contextuels et 10 cadres d'échantillonnage, formés respectivement à des résolutions de 64x64 et 128x128, et ont finalement obtenu de très bons résultats.

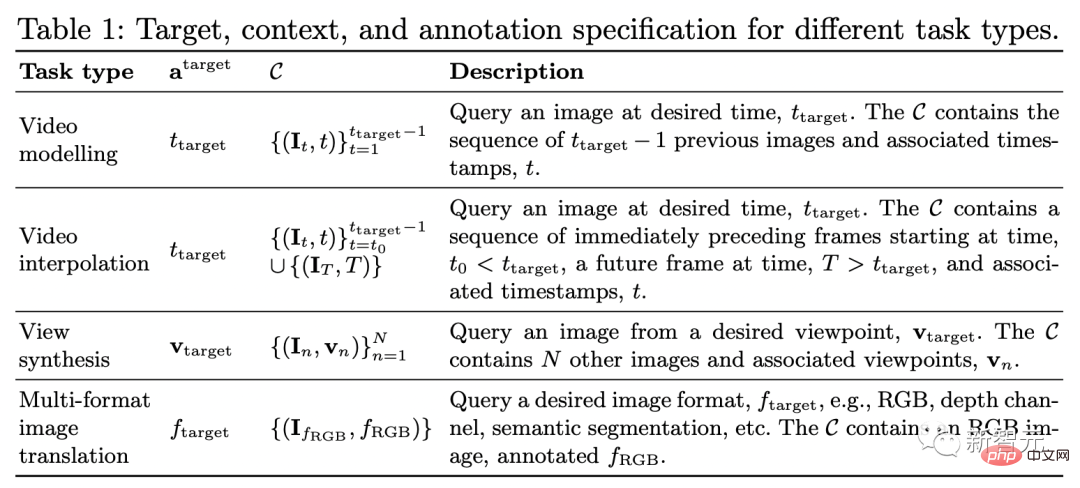

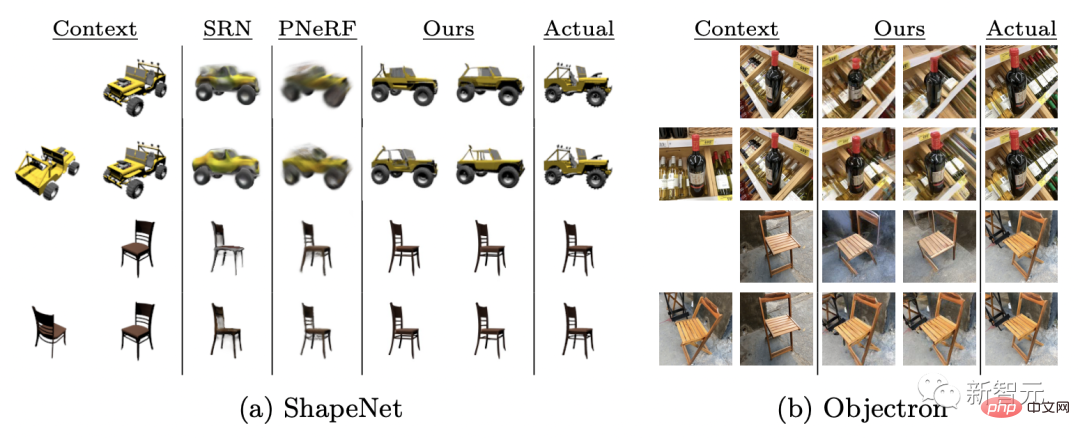

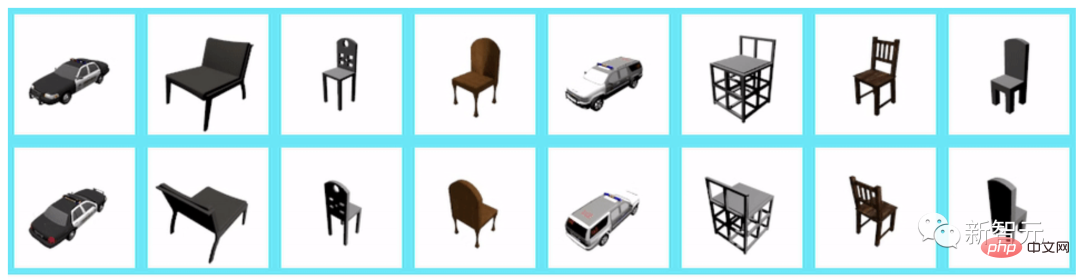

Synthèse de vues

En termes de synthèse de vues, nous fournissons des vues de caméra comme contexte et des annotations cibles comme décrit dans le tableau 1 (ligne 3), et échantillonnons uniformément plusieurs vues contextuelles. au maximum spécifié.

Model Transframer est évalué sur le benchmark ShapeNet, surpassant considérablement PixelNeRF et SRN en fournissant 1 à 2 vues contextuelles.

De plus, après évaluation sur l'ensemble de données Objectron, on peut voir que lorsqu'on lui donne une seule vue d'entrée, le modèle produit une sortie cohérente mais manque certaines fonctionnalités, telles que les pieds de chaise croisés.

Lorsqu'une vue contextuelle est donnée, la vue synthétisée à une résolution de 128 × 128 est la suivante :

Lorsque 2 vues contextuelles supplémentaires sont données, à une résolution de 128 × 128 La synthèse la vue est la suivante :

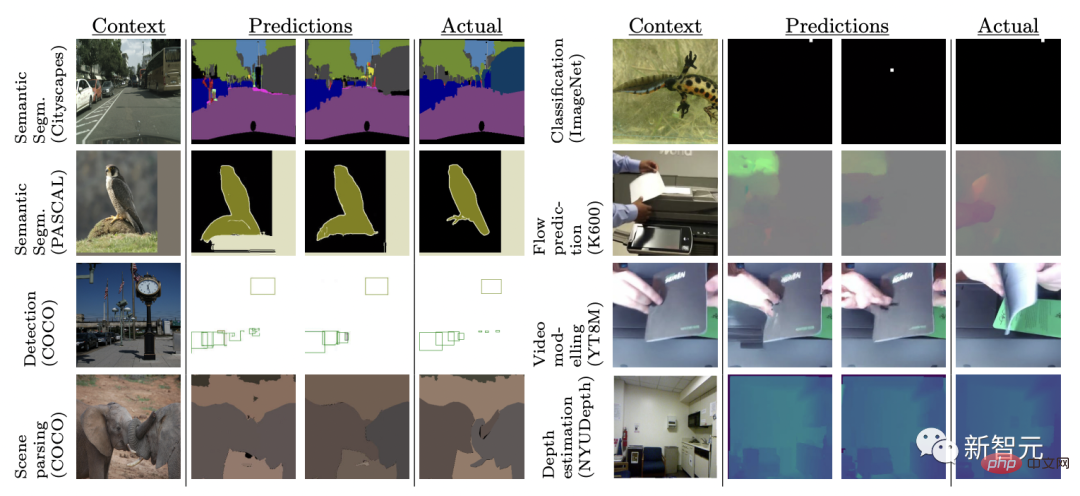

Tâches de vision multiples

Différentes tâches de vision par ordinateur sont généralement gérées à l'aide d'architectures complexes et de fonctions de perte.

Ici, les chercheurs ont formé conjointement le modèle Transframer sur 8 tâches et ensembles de données différents en utilisant la même fonction de perte.

Les 8 tâches sont : la prédiction du flux optique d'une image unique, la classification, la détection et la segmentation d'objets, la segmentation sémantique (sur 2 jeux de données), la prédiction de trames futures et l'estimation de la profondeur.

Les résultats montrent que Transframer apprend à générer différents échantillons dans des tâches complètement différentes, et dans certaines tâches, telles que les paysages urbains, le modèle produit un résultat de qualité.

Cependant, la qualité des résultats du modèle sur des tâches telles que la prédiction de trames futures et la détection de boîtes englobantes est variable, ce qui suggère que la modélisation dans ce contexte est plus difficile.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment évaluer la rentabilité du support commercial des frameworks Java

Jun 05, 2024 pm 05:25 PM

Comment évaluer la rentabilité du support commercial des frameworks Java

Jun 05, 2024 pm 05:25 PM

L'évaluation du rapport coût/performance du support commercial pour un framework Java implique les étapes suivantes : Déterminer le niveau d'assurance requis et les garanties de l'accord de niveau de service (SLA). L’expérience et l’expertise de l’équipe d’appui à la recherche. Envisagez des services supplémentaires tels que les mises à niveau, le dépannage et l'optimisation des performances. Évaluez les coûts de support commercial par rapport à l’atténuation des risques et à une efficacité accrue.

Comment la courbe d'apprentissage des frameworks PHP se compare-t-elle à celle d'autres frameworks de langage ?

Jun 06, 2024 pm 12:41 PM

Comment la courbe d'apprentissage des frameworks PHP se compare-t-elle à celle d'autres frameworks de langage ?

Jun 06, 2024 pm 12:41 PM

La courbe d'apprentissage d'un framework PHP dépend de la maîtrise du langage, de la complexité du framework, de la qualité de la documentation et du support de la communauté. La courbe d'apprentissage des frameworks PHP est plus élevée par rapport aux frameworks Python et inférieure par rapport aux frameworks Ruby. Par rapport aux frameworks Java, les frameworks PHP ont une courbe d'apprentissage modérée mais un temps de démarrage plus court.

Comment les options légères des frameworks PHP affectent-elles les performances des applications ?

Jun 06, 2024 am 10:53 AM

Comment les options légères des frameworks PHP affectent-elles les performances des applications ?

Jun 06, 2024 am 10:53 AM

Le framework PHP léger améliore les performances des applications grâce à une petite taille et une faible consommation de ressources. Ses fonctionnalités incluent : une petite taille, un démarrage rapide, une faible utilisation de la mémoire, une vitesse de réponse et un débit améliorés et une consommation de ressources réduite. Cas pratique : SlimFramework crée une API REST, seulement 500 Ko, une réactivité élevée et un débit élevé.

Comparaison des performances des frameworks Java

Jun 04, 2024 pm 03:56 PM

Comparaison des performances des frameworks Java

Jun 04, 2024 pm 03:56 PM

Selon les benchmarks, pour les petites applications hautes performances, Quarkus (démarrage rapide, mémoire faible) ou Micronaut (TechEmpower excellent) sont des choix idéaux. SpringBoot convient aux grandes applications full-stack, mais a des temps de démarrage et une utilisation de la mémoire légèrement plus lents.

Bonnes pratiques en matière de documentation du framework Golang

Jun 04, 2024 pm 05:00 PM

Bonnes pratiques en matière de documentation du framework Golang

Jun 04, 2024 pm 05:00 PM

La rédaction d'une documentation claire et complète est cruciale pour le framework Golang. Les meilleures pratiques incluent le respect d'un style de documentation établi, tel que le Go Coding Style Guide de Google. Utilisez une structure organisationnelle claire, comprenant des titres, des sous-titres et des listes, et fournissez la navigation. Fournit des informations complètes et précises, notamment des guides de démarrage, des références API et des concepts. Utilisez des exemples de code pour illustrer les concepts et l'utilisation. Maintenez la documentation à jour, suivez les modifications et documentez les nouvelles fonctionnalités. Fournir une assistance et des ressources communautaires telles que des problèmes et des forums GitHub. Créez des exemples pratiques, tels que la documentation API.

Comment choisir le meilleur framework Golang pour différents scénarios d'application

Jun 05, 2024 pm 04:05 PM

Comment choisir le meilleur framework Golang pour différents scénarios d'application

Jun 05, 2024 pm 04:05 PM

Choisissez le meilleur framework Go en fonction des scénarios d'application : tenez compte du type d'application, des fonctionnalités du langage, des exigences de performances et de l'écosystème. Frameworks Go courants : Gin (application Web), Echo (service Web), Fibre (haut débit), gorm (ORM), fasthttp (vitesse). Cas pratique : construction de l'API REST (Fiber) et interaction avec la base de données (gorm). Choisissez un framework : choisissez fasthttp pour les performances clés, Gin/Echo pour les applications Web flexibles et gorm pour l'interaction avec la base de données.

De nouveau intercepté par OpenAI, Google a lancé un modèle de langage visuel open source : PaliGemma

Jun 09, 2024 am 09:17 AM

De nouveau intercepté par OpenAI, Google a lancé un modèle de langage visuel open source : PaliGemma

Jun 09, 2024 am 09:17 AM

Préface Ce modèle combine le modèle visuel SigLIP et le modèle de langage Gemma, qui sont tous deux des composants ouverts, ce qui rend PaliGemma excellent dans le traitement des tâches combinant vision et langage. Les scénarios d'utilisation de PaliGemma incluent des sous-titres d'images, des balises d'image et des réponses visuelles aux questions. Ces scénarios d'application tirent parti de la capacité de PaliGemma à comprendre le contenu des images et à en extraire les caractéristiques clés, puis à convertir ces informations en sortie linguistique pour permettre l'interaction avec les utilisateurs ou la génération automatisée de contenu. Cette flexibilité rend PaliGemma adapté non seulement aux environnements de recherche et développement, mais également aux applications commerciales telles que le service client, les systèmes de recommandation de contenu, etc. Images Que peut faire PaliGemma ? Les images peuvent être utilisées lorsque vous y êtes invité.

Explication pratique détaillée du développement du framework Golang : questions et réponses

Jun 06, 2024 am 10:57 AM

Explication pratique détaillée du développement du framework Golang : questions et réponses

Jun 06, 2024 am 10:57 AM

Dans le développement du framework Go, les défis courants et leurs solutions sont les suivants : Gestion des erreurs : utilisez le package d'erreurs pour la gestion et utilisez un middleware pour gérer les erreurs de manière centralisée. Authentification et autorisation : intégrez des bibliothèques tierces et créez un middleware personnalisé pour vérifier les informations d'identification. Traitement simultané : utilisez des goroutines, des mutex et des canaux pour contrôler l'accès aux ressources. Tests unitaires : utilisez les packages, les simulations et les stubs gotest pour l'isolation, ainsi que les outils de couverture de code pour garantir la suffisance. Déploiement et surveillance : utilisez les conteneurs Docker pour regrouper les déploiements, configurer les sauvegardes de données et suivre les performances et les erreurs avec des outils de journalisation et de surveillance.