Périphériques technologiques

Périphériques technologiques

IA

IA

Un excellent article CoRL 2022 génère des protéines introuvables dans la nature ;

Un excellent article CoRL 2022 génère des protéines introuvables dans la nature ;

Un excellent article CoRL 2022 génère des protéines introuvables dans la nature ;

Les modèles de langage se généralisent au-delà des protéines naturelles Contrôle

Modèles de diffusion évolutifs avec transformateurs s : Fonctions de récompense interactives basées sur des exemples pour l'apprentissage des politiques

Radiostation hebdomadaire ArXiv : NLP, CV, ML Plus d'articles sélectionnés (avec audio)

- Article 1 : Les modèles de langage se généralisent au-delà des protéines naturelles

-

- Auteurs : Robert Verkuil, Ori Kabeli, etc.

- Adresse papier : https://www.biorxiv.org/content/10.1101/2022.12.21.521521v1.full.pdf

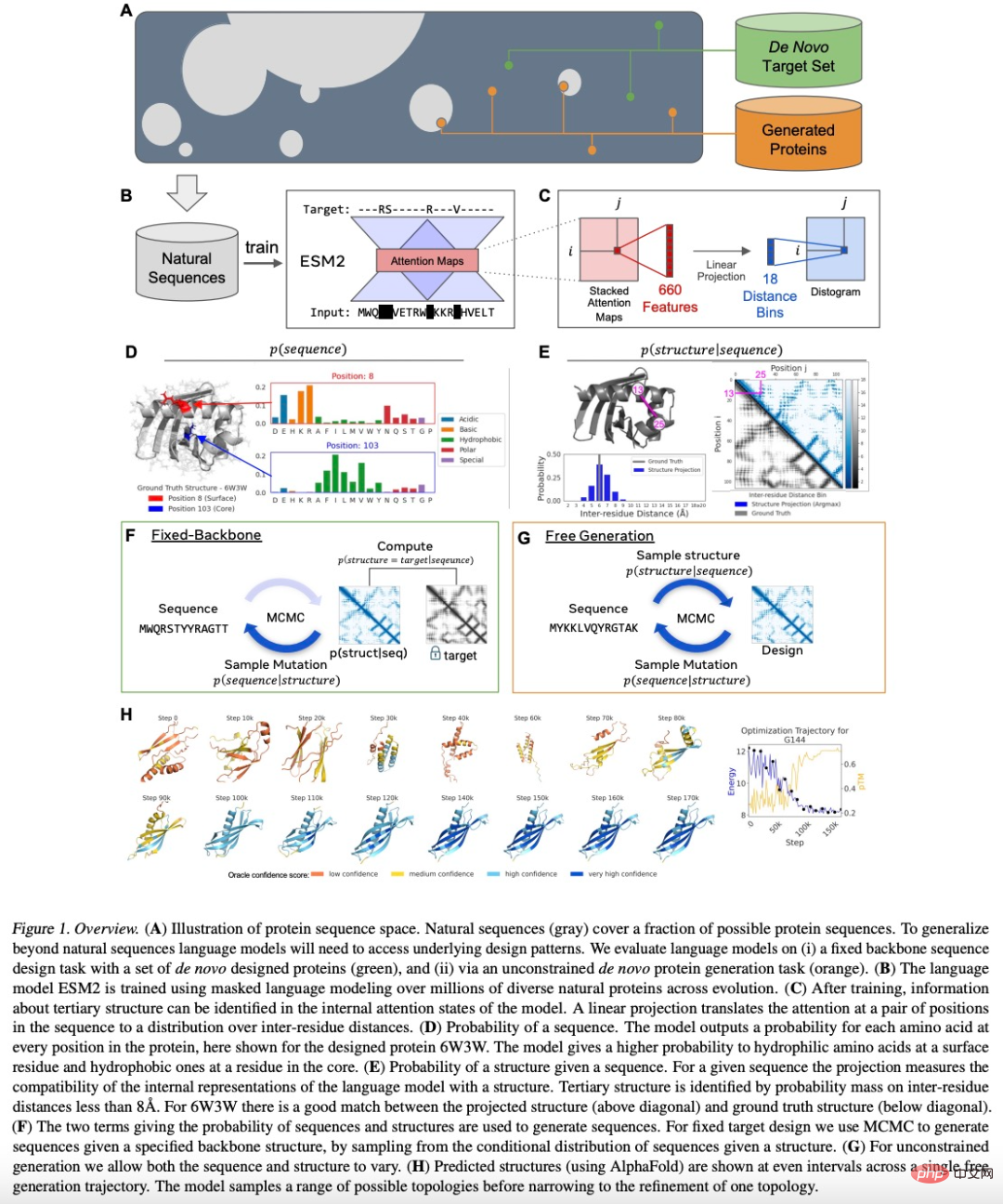

- Résumé : Les chercheurs se concentrent sur deux tâches de conception de protéines : la conception d'un squelette fixe d'une structure spécifiée et la génération sans contrainte de structures échantillonnées à partir de modèles ; Bien que les modèles de langage aient été formés uniquement sur des séquences, l’étude a révélé qu’ils étaient capables de concevoir des structures. Dans les résultats expérimentaux de cette étude, un total de 228 protéines ont été générées, avec un taux de réussite de conception de 152/228 (67 %).

- Sur les 152 modèles expérimentaux réussis, 35 ne présentaient aucune correspondance de séquence évidente avec une protéine native connue.

Pour les conceptions à squelette fixe, le modèle de langage a généré avec succès des conceptions de protéines pour 8 cibles à squelette fixe créées par l'homme et évaluées expérimentalement.

Pour le cas de génération sans contrainte, les protéines échantillonnées couvrent différentes topologies et compositions de structures secondaires, ce qui donne un taux de réussite expérimentale élevé de 71/129 (55 %).

- La figure 1 ci-dessous représente le processus global de conception des protéines par le modèle ESM2 :

- Recommandation : Cette étude a révélé que le modèle de langage ESM2 peut générer de nouvelles protéines autres que les protéines naturelles en apprenant grammaire profonde.

Article 2 : Un langage de programmation de haut niveau pour la conception générative de protéines

Auteurs : Brian Hie, Salvatore Candido, etc.

Adresse de l'article : https://www .biorxiv .org/content/10.1101/2022.12.21.521526v1.full.pdf

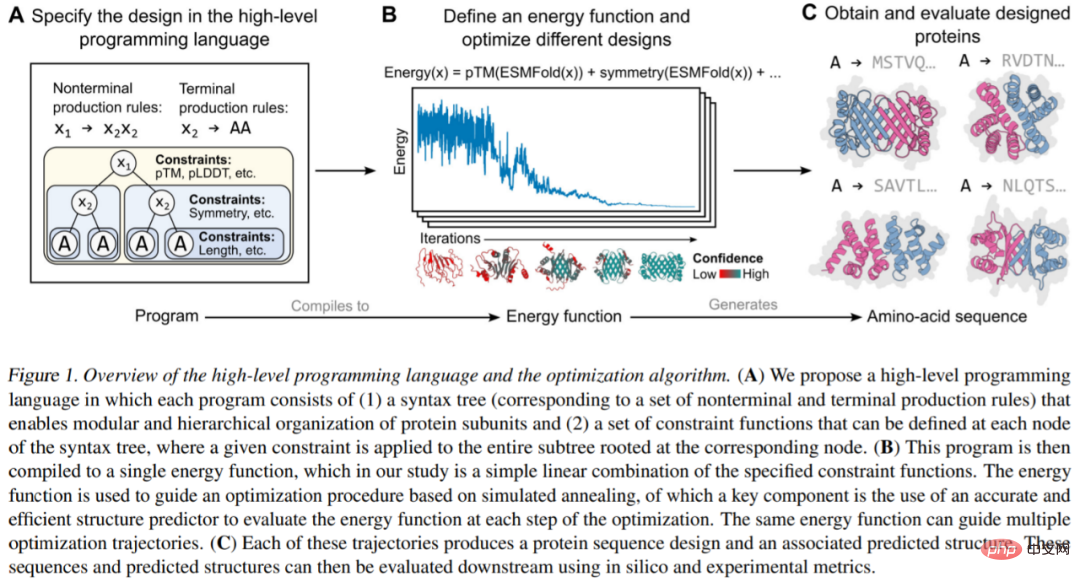

Abstract : Les chercheurs de FAIR partent de la modularité et de la programmabilité, plaçant les deux à un niveau supérieur d'abstraction, de conception de protéines. L'utilisateur uniquement doit réassembler les instructions de haut niveau, puis exécuter les instructions sur le modèle généré.

: Les chercheurs de FAIR partent de la modularité et de la programmabilité, plaçant les deux à un niveau supérieur d'abstraction, de conception de protéines. L'utilisateur uniquement doit réassembler les instructions de haut niveau, puis exécuter les instructions sur le modèle généré.

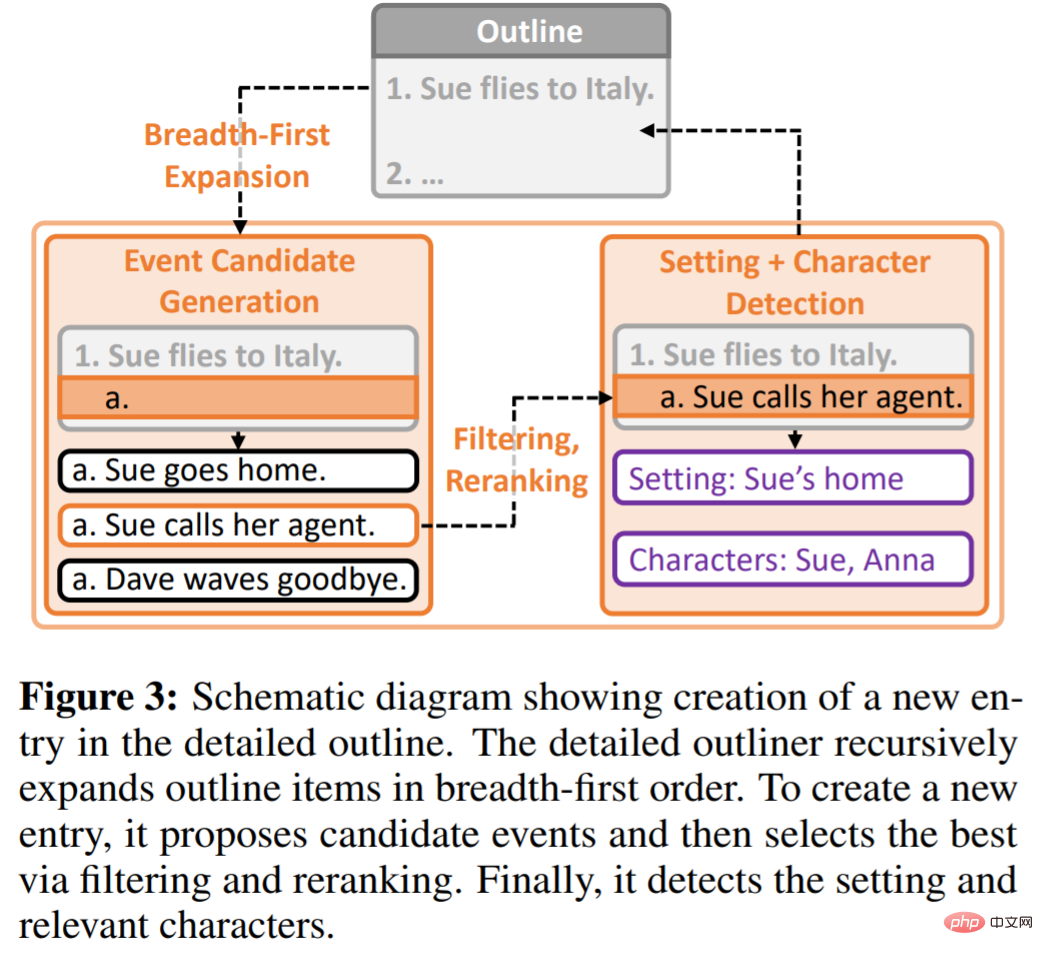

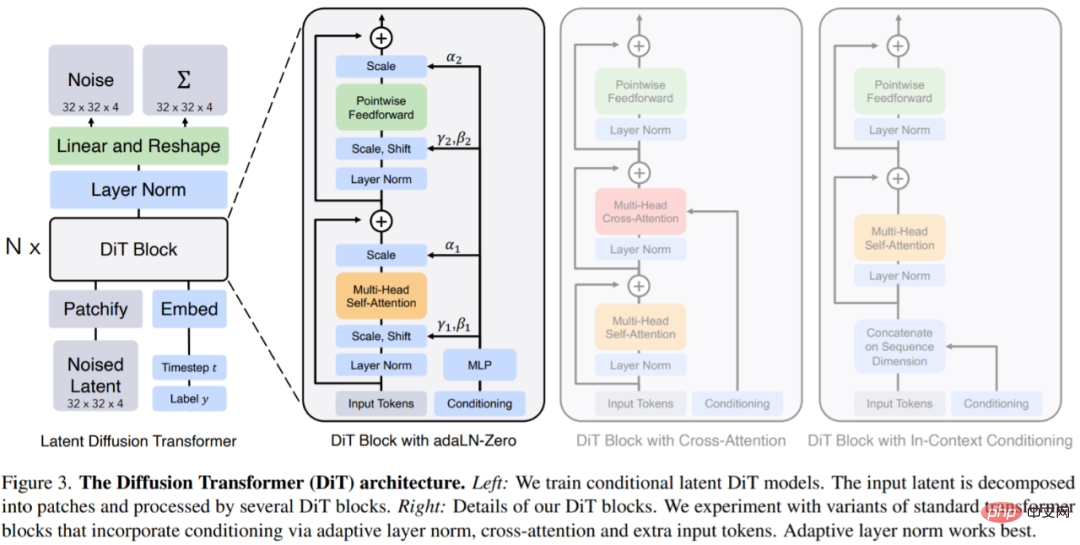

Le langage de programmation proposé pour générer des conceptions de protéines permet aux concepteurs de spécifier des procédures intuitives, modulaires et en couches. Le langage de programmation nécessite d'abord un arbre syntaxique (Figure 1A), composé de symboles terminaux (c'est-à-dire les feuilles de l'arbre) et de symboles non terminaux (c'est-à-dire les nœuds internes de l'arbre). Les premiers correspondent à une protéine unique. séquence (qui peut être répétée dans la protéine), cette dernière supporte l'organisation hiérarchique. De plus, un modèle de production basé sur l’énergie est nécessaire. Tout d’abord, Protein Designer spécifie un programme de haut niveau constitué d’un ensemble de contraintes organisées hiérarchiquement (Figure 1A). Le programme est ensuite compilé en une fonction énergétique utilisée pour évaluer la compatibilité avec des contraintes arbitraires et non différenciables (Figure 1B). Enfin, en incorporant des prédictions de structure au niveau atomique (supportées par des modèles de langage) dans les fonctions énergétiques, un grand nombre de conceptions de protéines complexes peuvent être générées (Figure 1C). Recommandé : Générez par programme des structures protéiques complexes et modulaires. Article 3 : DOC : Améliorer la cohérence des histoires longues avec un contrôle détaillé des contours Abstract : Il y a quelque temps, Re^3, un modèle de langage qui imite le processus d'écriture humain, a été publié. Ce modèle ne nécessite pas de réglage fin. de grands modèles, mais génère de la cohérence en concevant des invites fortes. Maintenant, l'équipe de recherche a proposé un nouveau modèle DOC pour générer des histoires. Les auteurs de l'article, Kevin Yang et Tian Yuandong, ont également posté sur Twitter pour promouvoir le modèle DOC, affirmant que les histoires générées par DOC sont plus cohérentes et intéressantes que celles générées par Re^3. Le framework DOC signifie contrôle de plan détaillé, qui est utilisé pour améliorer la cohérence de l'intrigue lors de la génération automatique d'histoires longues de milliers de mots. DOC se compose de deux composants complémentaires : Détaillé Outliner et Détaillé Contrôleur. Detailed Outliner est chargé de créer des plans détaillés et structurés hiérarchiquement qui font passer les idées d'écriture de la rédaction à la phase de planification. Le contrôleur détaillé garantit que les résultats générés suivent le plan détaillé en contrôlant l'alignement des paragraphes de l'histoire avec les détails du plan. L'étude a mené une évaluation manuelle de la capacité du modèle à générer automatiquement des histoires, et DOC a obtenu des gains substantiels dans plusieurs indicateurs : cohérence de l'intrigue (22,5 %), pertinence des grandes lignes (28,2 %) et intérêt (20,7 %). ce qui est bien meilleur que le modèle Re^3. De plus, DOC est plus facile à contrôler dans un environnement de construction interactif. Recommandation : Un autre nouveau travail de Tian Yuandong et d'autres membres originaux de l'équipe : l'IA génère de longues histoires, et de longs articles de milliers de mots peuvent être cohérents et intéressants. Article 4 : Modèles de diffusion évolutifs avec transformateurs Résumé : Dans cet article, William Peebles de l'UC Berkeley et Xie Saining de l'Université de New York ont écrit "Modèles de diffusion évolutifs avec transformateurs". L'objectif est de découvrir l'importance des choix architecturaux dans les modèles de diffusion et de fournir des informations. pour de futures recherches sur des modèles génératifs. Cette étude montre que la polarisation inductive U-Net n'est pas essentielle aux performances des modèles de diffusion et peut être facilement remplacée par des conceptions standards telles que des transformateurs. Cette recherche se concentre sur une nouvelle classe de modèles de diffusion basés sur des transformateurs : les transformateurs de diffusion (DiTs en abrégé). Les DiT suivent les meilleures pratiques des Vision Transformers (ViT), avec quelques ajustements mineurs mais importants. Il a été démontré que DiT évolue plus efficacement que les réseaux convolutifs traditionnels tels que ResNet. Plus précisément, cet article étudie le comportement de mise à l'échelle de Transformer en termes de complexité du réseau et de qualité des échantillons. Il est montré qu'en construisant et en évaluant l'espace de conception DiT dans le cadre du modèle de diffusion latente (LDM), où le modèle de diffusion est formé dans l'espace latent de VAE, il est possible de remplacer avec succès le squelette U-Net par un transformateur. Cet article montre en outre que DiT est une architecture évolutive pour les modèles de diffusion : il existe une forte corrélation entre la complexité du réseau (mesurée par Gflops) et la qualité des échantillons (mesurée par FID). En étendant simplement DiT et en entraînant un LDM avec un réseau fédérateur haute capacité (118,6 Gflops), des résultats de pointe de 2,27 FID sont obtenus sur le benchmark de génération ImageNet 256 × 256 conditionnel à la classe. Recommandation : Le U-Net qui domine le modèle de diffusion va être remplacé. Xie Saining et al. Papier 5 : Point-E : Un système pour générer des nuages de points 3D à partir d'invites complexes Abstract : Le générateur de modèles 3D open source d'OpenAI, Point-E, a déclenché une nouvelle vague d'engouement dans le cercle de l'IA. Point-E peut générer des modèles 3D en une à deux minutes sur un seul GPU Nvidia V100, selon un article publié avec le contenu open source. En comparaison, les systèmes existants tels que DreamFusion de Google nécessitent généralement des heures et plusieurs GPU. Point-E ne génère pas d'image 3D au sens traditionnel du terme, il génère un nuage de points ou un ensemble discret de points de données dans l'espace qui représente une forme 3D. Le E dans Point-E signifie « efficacité », ce qui signifie qu'il est plus rapide que les méthodes de génération d'objets 3D précédentes. Bien que les nuages de points soient plus faciles à synthétiser d’un point de vue informatique, ils ne peuvent pas capturer la forme ou la texture fine des objets – une limitation clé du Point-E actuellement. Pour résoudre ce problème, l'équipe OpenAI a formé un système d'intelligence artificielle supplémentaire pour convertir le nuage de points de Point-E en un maillage. Recommandé : L'IA texte-image tridimensionnelle devient : un seul GPU est expédié en moins d'une minute, par OpenAI. Passage 6 : Reprogrammation pour récupérer des informations épigénétiques juvéniles et restaurer la vision Résumé : Le 2 décembre 2020, plusieurs mots surprenants sont apparus sur la couverture de la revue scientifique de premier plan « Nature » : « Turning Back » Time » (tour retour du temps). Les recherches sur la couverture proviennent de l'équipe de David Sinclair, professeur titulaire à la Harvard Medical School. Bien que l'article ne fasse que quelques pages, il montre une nouvelle perspective : utiliser la thérapie génique pour induire la reprogrammation des cellules ganglionnaires et restaurer les informations épigénétiques de la jeunesse, permettant ainsi au nerf optique de se régénérer après des dommages et d'inverser la vision causée par le glaucome et le vieillissement. . David Sinclair a déclaré que l’objectif de recherche de l’équipe a toujours été de ralentir et d’inverser le vieillissement humain et de traiter les maladies en résolvant les causes plutôt que les symptômes. Sur la base de cette étude de 2020, l'équipe de David Sinclair utilise la technologie d'inversion de l'âge appelée "REVIVER" pour la tester sur des primates non humains afin de voir si elle est sûre et peut guérir la cécité comme les enfants. La dernière recherche vient de David Sinclair et d'une équipe de 60 personnes. Il a déclaré que le vieillissement est comme des rayures sur un CD qui peuvent être effacées, ou un logiciel endommagé dans le système, qui peut être inversé en le réinstallant simplement, tout comme As. indiqué dans le livre "Lifespan". Dans l'article de prépublication, les auteurs ont déclaré que tous les êtres vivants perdent des informations génétiques au fil du temps et perdent progressivement des fonctions cellulaires. Grâce à un système de souris génétiquement modifiées appelé ICE (pour Inducible Changes in the Epigenome), les chercheurs démontrent que le processus de réparation des cassures non mutagènes de l'ADN accélère les changements physiologiques, cognitifs et moléculaires liés à l'âge, y compris l'expression. Observez l'érosion génétique, la perte de cellules capacité, sénescence cellulaire, etc. Les chercheurs affirment que la reprogrammation épigénétique par expression ectopique peut restaurer les modèles d'expression génétique de la jeunesse. Recommandé : Recherche sur l'inversion du vieillissement. Article 7 : Entraîner des robots à évaluer des robots : fonctions de récompense interactives basées sur des exemples pour l'apprentissage des politiques Abstrait : Souvent, les interactions physiques aident à révéler des informations moins évidentes, comme par exemple si nous tirons sur un pied de table pour évaluer s'il est stable ou s'il tourne. bouteille d'eau à l'envers pour vérifier si elle fuit, l'étude suggère que ce comportement interactif pourrait être acquis automatiquement en entraînant un robot à évaluer les résultats de ses tentatives pour exécuter la compétence. Ces évaluations, à leur tour, servent d'IRF (fonctions de récompense interactives) utilisées pour entraîner des politiques d'apprentissage par renforcement afin d'exécuter des compétences cibles, telles que le serrage des pieds de table. De plus, l'IRF peut servir de mécanisme de validation pour améliorer l'exécution des tâches en ligne, même une fois la formation complète terminée. Pour une tâche donnée, la formation IRF est très pratique et ne nécessite aucune spécification supplémentaire. Les résultats de l'évaluation montrent qu'IRF peut réaliser des améliorations significatives des performances et même dépasser les références avec un accès à des démos ou à des récompenses soigneusement conçues. Par exemple, dans l'image ci-dessous, le robot doit d'abord fermer la porte, puis faire pivoter la poignée symétrique de la porte pour verrouiller complètement la porte.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Le papier Stable Diffusion 3 est enfin publié, et les détails architecturaux sont révélés. Cela aidera-t-il à reproduire Sora ?

Mar 06, 2024 pm 05:34 PM

Le papier Stable Diffusion 3 est enfin publié, et les détails architecturaux sont révélés. Cela aidera-t-il à reproduire Sora ?

Mar 06, 2024 pm 05:34 PM

L'article de StableDiffusion3 est enfin là ! Ce modèle est sorti il y a deux semaines et utilise la même architecture DiT (DiffusionTransformer) que Sora. Il a fait beaucoup de bruit dès sa sortie. Par rapport à la version précédente, la qualité des images générées par StableDiffusion3 a été considérablement améliorée. Il prend désormais en charge les invites multithèmes, et l'effet d'écriture de texte a également été amélioré et les caractères tronqués n'apparaissent plus. StabilityAI a souligné que StableDiffusion3 est une série de modèles avec des tailles de paramètres allant de 800M à 8B. Cette plage de paramètres signifie que le modèle peut être exécuté directement sur de nombreux appareils portables, réduisant ainsi considérablement l'utilisation de l'IA.

Prix papier ICCV'23 'Combat des Dieux' ! Meta Divide Everything et ControlNet ont été sélectionnés conjointement, et un autre article a surpris les juges.

Oct 04, 2023 pm 08:37 PM

Prix papier ICCV'23 'Combat des Dieux' ! Meta Divide Everything et ControlNet ont été sélectionnés conjointement, et un autre article a surpris les juges.

Oct 04, 2023 pm 08:37 PM

ICCV2023, la plus grande conférence sur la vision par ordinateur qui s'est tenue à Paris, en France, vient de se terminer ! Le prix du meilleur article de cette année est simplement un « combat entre dieux ». Par exemple, les deux articles qui ont remporté le prix du meilleur article incluaient ControlNet, un travail qui a bouleversé le domaine de l'IA graphique vincentienne. Depuis qu'il est open source, ControlNet a reçu 24 000 étoiles sur GitHub. Qu'il s'agisse des modèles de diffusion ou de l'ensemble du domaine de la vision par ordinateur, le prix de cet article est bien mérité. La mention honorable du prix du meilleur article a été décernée à un autre article tout aussi célèbre, le modèle SAM « Séparez tout » de Meta. Depuis son lancement, « Segment Everything » est devenu la « référence » pour divers modèles d'IA de segmentation d'images, y compris ceux venus de derrière.

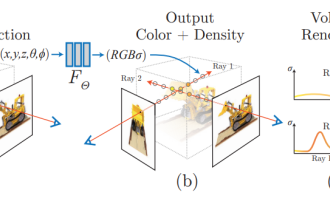

NeRF et le passé et le présent de la conduite autonome, résumé de près de 10 articles !

Nov 14, 2023 pm 03:09 PM

NeRF et le passé et le présent de la conduite autonome, résumé de près de 10 articles !

Nov 14, 2023 pm 03:09 PM

Depuis que Neural Radiance Fields a été proposé en 2020, le nombre d'articles connexes a augmenté de façon exponentielle. Il est non seulement devenu une branche importante de la reconstruction tridimensionnelle, mais est également progressivement devenu actif à la frontière de la recherche en tant qu'outil important pour la conduite autonome. . NeRF a soudainement émergé au cours des deux dernières années, principalement parce qu'il ignore l'extraction et la mise en correspondance des points caractéristiques, la géométrie et la triangulation épipolaires, le PnP plus l'ajustement du faisceau et d'autres étapes du pipeline de reconstruction CV traditionnel, et ignore même la reconstruction du maillage, la cartographie et le traçage de la lumière. , directement à partir de la 2D L'image d'entrée est utilisée pour apprendre un champ de rayonnement, puis une image rendue qui se rapproche d'une photo réelle est sortie du champ de rayonnement. En d’autres termes, supposons qu’un modèle tridimensionnel implicite basé sur un réseau neuronal s’adapte à la perspective spécifiée.

Les illustrations papier peuvent également être générées automatiquement, en utilisant le modèle de diffusion, et sont également acceptées par l'ICLR.

Jun 27, 2023 pm 05:46 PM

Les illustrations papier peuvent également être générées automatiquement, en utilisant le modèle de diffusion, et sont également acceptées par l'ICLR.

Jun 27, 2023 pm 05:46 PM

L'IA générative a pris d'assaut la communauté de l'intelligence artificielle. Les particuliers et les entreprises ont commencé à s'intéresser à la création d'applications de conversion modale associées, telles que les images Vincent, les vidéos Vincent, la musique Vincent, etc. Récemment, plusieurs chercheurs d'institutions de recherche scientifique telles que ServiceNow Research et LIVIA ont tenté de générer des graphiques dans des articles basés sur des descriptions textuelles. À cette fin, ils ont proposé une nouvelle méthode de FigGen, et l’article correspondant a également été inclus dans ICLR2023 sous le nom de TinyPaper. Adresse du document illustré : https://arxiv.org/pdf/2306.00800.pdf Certaines personnes peuvent se demander : pourquoi est-il si difficile de générer les graphiques dans le document ? En quoi cela aide-t-il la recherche scientifique ?

Les captures d'écran du chat révèlent les règles cachées de l'examen de l'IA ! AAAI 3000 yuans, c'est fort accepté ?

Apr 12, 2023 am 08:34 AM

Les captures d'écran du chat révèlent les règles cachées de l'examen de l'IA ! AAAI 3000 yuans, c'est fort accepté ?

Apr 12, 2023 am 08:34 AM

Alors que la date limite de soumission des articles pour l'AAAI 2023 approchait, une capture d'écran d'une discussion anonyme dans le groupe de soumission d'IA est soudainement apparue sur Zhihu. L'un d'eux a affirmé qu'il pouvait fournir un service « 3 000 yuans par acceptation forte ». Dès que la nouvelle est sortie, elle a immédiatement suscité l’indignation du public parmi les internautes. Cependant, ne vous précipitez pas encore. Le patron de Zhihu, "Fine Tuning", a déclaré qu'il s'agissait probablement simplement d'un "plaisir verbal". Selon "Fine Tuning", les salutations et les délits de gangs sont des problèmes inévitables dans tous les domaines. Avec l'essor de l'openreview, les différents inconvénients du cmt sont devenus de plus en plus évidents. L'espace laissé aux petits cercles pour fonctionner deviendra plus petit à l'avenir, mais il y aura toujours de la place. Parce qu'il s'agit d'un problème personnel, pas d'un problème avec le système et le mécanisme de soumission. Présentation de l'open r

Classement CVPR 2023 publié, le taux d'acceptation est de 25,78% ! 2 360 articles ont été acceptés et le nombre de soumissions a grimpé à 9 155

Apr 13, 2023 am 09:37 AM

Classement CVPR 2023 publié, le taux d'acceptation est de 25,78% ! 2 360 articles ont été acceptés et le nombre de soumissions a grimpé à 9 155

Apr 13, 2023 am 09:37 AM

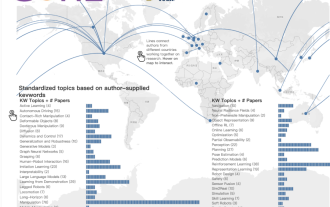

Tout à l'heure, le CVPR 2023 a publié un article disant : Cette année, nous avons reçu un nombre record de 9 155 articles (12 % de plus que le CVPR2022) et accepté 2 360 articles, avec un taux d'acceptation de 25,78 %. Selon les statistiques, le nombre de soumissions au CVPR n'a augmenté que de 1 724 à 2 145 au cours des 7 années allant de 2010 à 2016. Après 2017, il a grimpé en flèche et est entré dans une période de croissance rapide. En 2019, il a dépassé les 5 000 pour la première fois, et en 2022, le nombre de candidatures avait atteint 8 161. Comme vous pouvez le constater, un total de 9 155 articles ont été soumis cette année, ce qui constitue un record. Une fois l’épidémie atténuée, le sommet CVPR de cette année se tiendra au Canada. Cette année, il s'agira d'une conférence à voie unique et la traditionnelle sélection orale sera annulée. recherche Google

L'équipe chinoise a remporté les prix du meilleur article et du meilleur article système, et les résultats de la recherche CoRL ont été annoncés.

Nov 10, 2023 pm 02:21 PM

L'équipe chinoise a remporté les prix du meilleur article et du meilleur article système, et les résultats de la recherche CoRL ont été annoncés.

Nov 10, 2023 pm 02:21 PM

Depuis sa première tenue en 2017, CoRL est devenue l'une des conférences universitaires les plus importantes au monde à l'intersection de la robotique et de l'apprentissage automatique. CoRL est une conférence à thème unique pour la recherche sur l'apprentissage des robots, couvrant plusieurs sujets tels que la robotique, l'apprentissage automatique et le contrôle, y compris la théorie et l'application. La conférence CoRL 2023 se tiendra à Atlanta, aux États-Unis, du 6 au 9 novembre. Selon les données officielles, 199 articles provenant de 25 pays ont été sélectionnés pour CoRL cette année. Les sujets populaires incluent les opérations, l’apprentissage par renforcement, etc. Bien que CoRL soit à plus petite échelle que les grandes conférences universitaires sur l'IA telles que l'AAAI et le CVPR, à mesure que la popularité de concepts tels que les grands modèles, l'intelligence incarnée et les robots humanoïdes augmente cette année, des recherches pertinentes dignes d'attention seront également

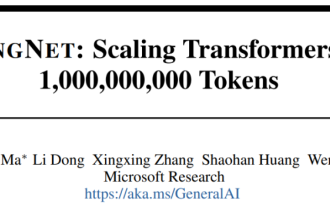

Le nouveau papier brûlant de Microsoft : Transformer s'étend à 1 milliard de jetons

Jul 22, 2023 pm 03:34 PM

Le nouveau papier brûlant de Microsoft : Transformer s'étend à 1 milliard de jetons

Jul 22, 2023 pm 03:34 PM

Alors que chacun continue de mettre à niveau et d'itérer ses propres grands modèles, la capacité du LLM (grand modèle de langage) à traiter les fenêtres contextuelles est également devenue un indicateur d'évaluation important. Par exemple, le modèle vedette GPT-4 prend en charge 32 000 jetons, ce qui équivaut à 50 pages de texte ; Anthropic, fondée par un ancien membre d'OpenAI, a augmenté les capacités de traitement des jetons de Claude à 100 000, soit environ 75 000 mots, soit environ équivalent à résumer "Harry Potter" en un clic 》Première partie. Dans les dernières recherches de Microsoft, ils ont cette fois directement étendu Transformer à 1 milliard de jetons. Cela ouvre de nouvelles possibilités pour modéliser des séquences très longues, comme par exemple traiter un corpus entier ou même l'ensemble d'Internet comme une seule séquence. A titre de comparaison, commun