Périphériques technologiques

Périphériques technologiques

IA

IA

Modèle de pré-formation Text-to-SQL multitâche en deux étapes MIGA basé sur T5

Modèle de pré-formation Text-to-SQL multitâche en deux étapes MIGA basé sur T5

Modèle de pré-formation Text-to-SQL multitâche en deux étapes MIGA basé sur T5

De plus en plus de travaux ont prouvé que les modèles linguistiques pré-entraînés (PLM) contiennent des connaissances riches. Pour différentes tâches, l'utilisation de méthodes de formation appropriées pour tirer parti du PLM peut mieux améliorer les capacités du modèle. Dans les tâches Text-to-SQL, les générateurs traditionnels actuels sont basés sur des arbres syntaxiques et doivent être conçus pour la syntaxe SQL.

Récemment, NetEase Interactive Entertainment AI Lab s'est associé à l'Université des études étrangères du Guangdong et à l'Université de Columbia pour proposer un modèle de pré-formation multitâche en deux étapes MIGA basé sur la méthode de pré-formation du modèle de langage pré-entraîné. T5. MIGA introduit trois tâches auxiliaires dans la phase de pré-formation et les organise dans un paradigme de tâches de génération unifiée, qui peut former uniformément tous les ensembles de données Text-to-SQL en même temps, dans la phase de réglage fin, MIGA cible les erreurs dans ; plusieurs tours de dialogue Le problème de transfert est utilisé pour la perturbation SQL, ce qui améliore la robustesse de la génération de modèle.

Actuellement pour la recherche Text-to-SQL, la méthode principale est principalement le modèle encodeur-décodeur basé sur l'arbre de syntaxe SQL, qui peut garantir que les résultats générés doivent être conformes à la syntaxe SQL, mais nécessite une conception spéciale pour la syntaxe SQL. . Il y a également eu des recherches récentes sur Text-to-SQL basées sur des modèles de langage génératifs, qui peuvent facilement hériter des connaissances et des capacités de modèles de langage pré-entraînés.

Afin de réduire la dépendance aux arbres syntaxiques et de mieux exploiter les capacités des modèles de langage pré-entraînés, cette étude propose une pré-formation Text-to-SQL multitâche en deux étapes dans le cadre du pré- formation modèle T5 Modèle MIGA (MultI-tâche Ggénération frAmework).

MIGA est divisé en deux étapes de processus de formation :

- Dans la phase de pré-formation, MIGA utilise le même paradigme de pré-formation que T5, et propose en plus trois tâches auxiliaires liées au Text-to-SQL , ainsi mieux inspirer les connaissances dans des modèles de langage pré-entraînés. Cette méthode de formation peut unifier tous les ensembles de données Text-to-SQL et élargir l'échelle des données de formation ; elle peut également concevoir de manière flexible des tâches auxiliaires plus efficaces pour explorer davantage les connaissances potentielles du modèle de langage pré-entraîné.

- Dans la phase de réglage fin, MIGA cible les problèmes de transmission d'erreurs susceptibles de se produire dans les conversations à plusieurs tours et SQL. Elle perturbe le SQL historique pendant le processus de formation, rendant ainsi l'effet de génération du cycle SQL actuel plus important. écurie.

Le modèle MIGA surpasse le meilleur modèle actuel basé sur un arbre syntaxique sur deux ensembles de données publiques Text-to-SQL de dialogue multi-tours, et les recherches connexes ont été acceptées par l'AAAI 2023.

Adresse papier : https://arxiv.org/abs/2212.09278

Détails du modèle MIGA

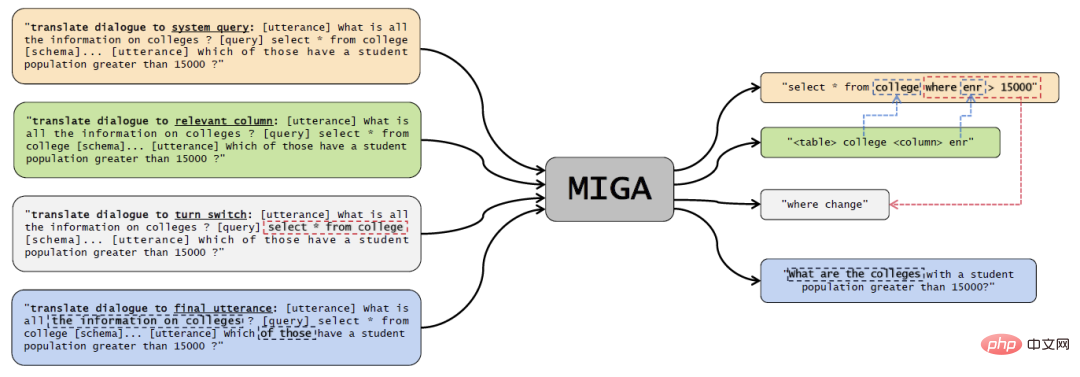

Figure 1 Schéma du modèle MIGA .

Phase de pré-entraînement multitâches

Cette recherche fait principalement référence à la méthode de pré-entraînement du T5, et sur la base du modèle T5 déjà entraîné, quatre tâches de pré-entraînement sont conçues :

- Tâche principale Text-to-SQL : pour la partie jaune dans l'image ci-dessus, concevez l'invite comme "traduire le dialogue en requête système", puis utilisez des jetons spéciaux pour saisir le dialogue historique, les informations de base de données et les instructions SQL dans T5- Dans l'encodeur, laissez le décodeur afficher directement l'instruction SQL correspondante ;

- Prédiction des informations associées : la partie verte dans l'image ci-dessus, l'invite de conception est "traduire le dialogue en colonne pertinente", l'entrée de l'encodeur T5. est également cohérent avec la tâche principale, le décodeur Ensuite, vous devez générer des tableaux de données et des colonnes liés au problème actuel, afin de renforcer la compréhension du modèle Text-to-SQL

- Prédiction des opérations du cycle en cours : la partie grise dans l'image ci-dessus, l'invite de conception est "traduire le dialogue pour activer le commutateur", cette tâche est principalement conçue pour la compréhension du contexte dans plusieurs tours de dialogue. Par rapport au cycle précédent de dialogue et de SQL, le décodeur doit afficher quoi. des modifications ont été apportées au but du dialogue actuel. Par exemple, l'exemple dans la figure montre où les conditions ont été modifiées.

- Prédiction finale du dialogue : la partie bleue dans l'image ci-dessus est conçue comme "traduire le dialogue ; à l'énoncé final". Le but est de permettre au modèle de mieux comprendre le dialogue contextuel. Le décodeur doit produire l'intégralité du dialogue à plusieurs tours. , une description complète du problème correspondant au SQL au dernier moment.

Grâce à une telle conception de méthode de formation unifiée, MIGA peut être polyvalente et flexible pour gérer davantage de tâches supplémentaires liées aux tâches, et elle présente également les avantages suivants :

- Se référer aux étapes des humains qui écrivent SQL, le texte de conversation en tâche SQL est décomposé en plusieurs sous-tâches, permettant à la tâche principale d'en tirer des leçons

- Le format de construction des échantillons de formation est cohérent avec T5, ce qui peut maximiser le potentiel du modèle T5 pré-entraîné pour la tâche cible ;

- Le cadre unifié permet une planification flexible de plusieurs tâches auxiliaires. Lorsqu'il est appliqué à une tâche spécifique, le modèle pré-entraîné ci-dessus doit uniquement être affiné en utilisant le même objectif de formation dans les données étiquetées de la tâche spécifique.

Au cours de la phase de pré-formation, l'étude a intégré les données de l'ensemble de données Text-to-SQL Spider et de l'ensemble de données conversationnel Text-to-SQL SparC et CoSQL pour entraîner le modèle T5.

Phase de réglage fin

Après la phase de pré-formation, cette étude utilise simplement des tâches Text-to-SQL pour affiner davantage le modèle en fonction des données annotées de la tâche cible. Lors de la prédiction du cycle SQL actuel, cette étude fusionnera le SQL prédit du cycle précédent. Dans ce processus, afin d'essayer de surmonter le problème de transmission d'erreurs causé par plusieurs cycles de dialogue et de génération, cette étude propose un schéma de perturbation SQL. , perturbe les tours historiques de SQL dans les données d'entrée avec une probabilité α. La perturbation de l'instruction SQL échantillonne principalement le jeton correspondant avec une probabilité de β, puis effectue l'une des perturbations suivantes :

- Utilisez des colonnes dans la même table de données pour modifier ou ajouter aléatoirement des colonnes dans la partie SELECT ;

- Modifiez aléatoirement la structure dans la condition JOIN, par exemple en échangeant les positions des deux tables ;

- Modifiez toutes les colonnes de "*" et quelques autres colonnes

- Échangez "asc" et "desc" ; .

Les perturbations mentionnées ci-dessus sont les erreurs de génération SQL les plus courantes causées par la transmission d'erreurs trouvées statistiquement dans l'expérience. Par conséquent, des perturbations sont effectuées pour ces situations afin de réduire la dépendance du modèle à cet aspect.

Évaluation expérimentaleEnsemble de données d'évaluation pour les conversations multi-tours Text-to-SQL : SparC et CoSQL.

Les indicateurs d'évaluation sont :

- QM : Question Match, indiquant la proportion de SQL généré dans une seule série de questions qui correspond complètement à la sortie de l'annotation

- IM : Interaction Match, indiquant l'ensemble ; dialogue à plusieurs tours Proportion de tout le SQL généré pour une exécution complète qui correspond exactement à la sortie de l'annotation.

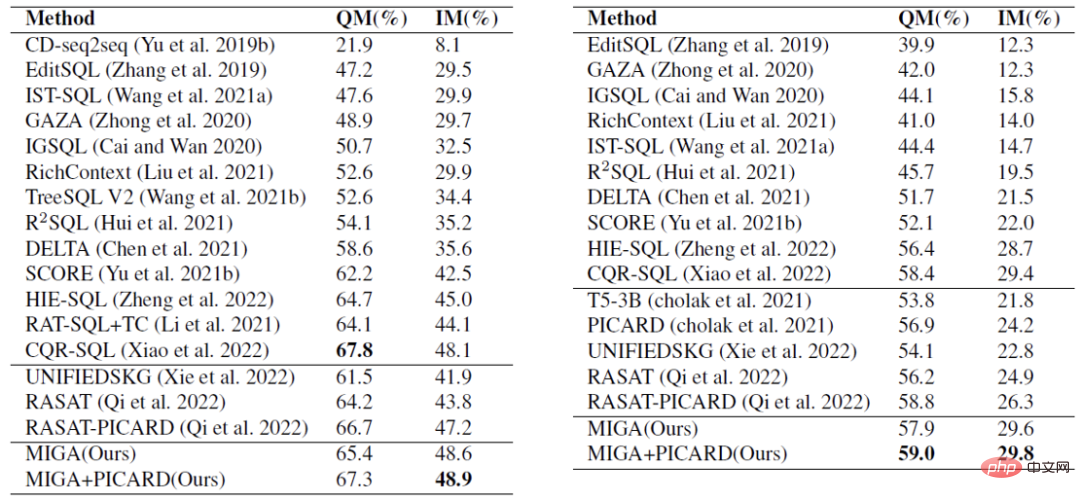

Dans l'expérience comparative du tableau 1, MIGA surpasse le meilleur modèle Text-to-SQL de dialogue multi-tours actuel en termes de scores IM sur les deux ensembles de données et de scores QM de CoSQL. Et par rapport au même type de solutions basées sur T5, la MIGA a amélioré respectivement la gestion de l'information de 7,0 % et la gestion de la qualité de 5,8 %.

Tableau 1 Analyse expérimentale comparative, la première partie est le modèle arborescent, et la deuxième partie est le modèle génératif basé sur la pré-entraînement.

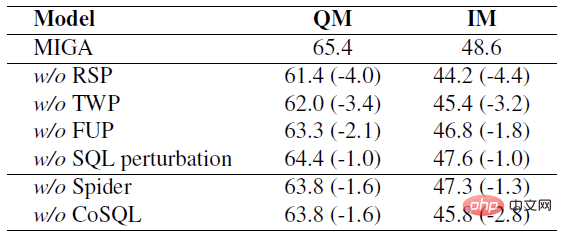

Dans l'expérience d'ablation du tableau 2, cette étude a exploré plusieurs tâches du processus de formation en deux étapes de la MIGA et a également prouvé que ces tâches amélioreront la tâche cible à des degrés divers.

Tableau 2 Pour la tâche SparC, la suppression de chaque tâche ou donnée respectivement a réduit les indicateurs.

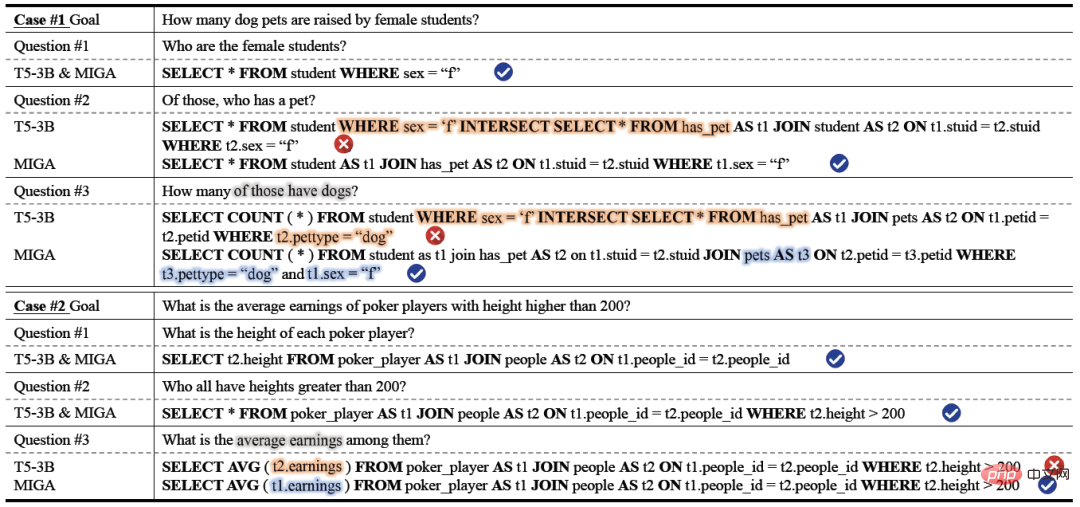

Dans les résultats réels de l'analyse de cas, la stabilité et l'exactitude de la génération MIGA sont meilleures que le modèle de formation basé sur T5-3B. On peut voir que MIGA est meilleur dans les opérations de connexion multi-tables et le mappage des colonnes. et des tables. Mieux que les autres modèles. Dans la question n°2 du cas n°1, le modèle T5-3B ne peut pas générer du SQL valide pour la structure JOIN relativement complexe (connexion à deux tables), ce qui conduit à des prédictions incorrectes pour la structure JOIN plus complexe (connexion à trois tables) dans la question. #3. MIGA prédit avec précision la structure JOIN et maintient bien la condition précédente t1.sex="f" . Dans le cas n°2, T5-3B confond plusieurs colonnes dans différentes tables et confond les gains avec une colonne de la table people, alors que MIGA identifie correctement cette colonne comme appartenant à la table poker_player et la lie à t1.

Tableau 3 Analyse de cas.

Conclusion

NetEase Interactive Entertainment AI Lab a proposé un modèle de pré-formation multitâche en deux étapes basé sur T5 pour Text-to-SQL : MIGA. Au cours de la phase de pré-formation, MIGA décompose la tâche Text-to-SQL en trois sous-tâches supplémentaires et les unifie dans un paradigme de génération séquence à séquence pour mieux motiver le modèle T5 pré-entraîné. Et un mécanisme de perturbation SQL est introduit lors de l'étape de réglage fin pour réduire l'impact de la transmission d'erreurs dans plusieurs cycles de scénarios de génération Text-to-SQL.

À l'avenir, l'équipe de recherche explorera davantage des stratégies plus efficaces pour exploiter la puissance de très grands modèles de langage, et explorera des moyens plus élégants et plus efficaces pour surmonter davantage le problème de performances réduites dues à une transmission incorrecte.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

Open source! Au-delà de ZoeDepth ! DepthFM : estimation rapide et précise de la profondeur monoculaire !

Apr 03, 2024 pm 12:04 PM

0. À quoi sert cet article ? Nous proposons DepthFM : un modèle d'estimation de profondeur monoculaire génératif de pointe, polyvalent et rapide. En plus des tâches traditionnelles d'estimation de la profondeur, DepthFM démontre également des capacités de pointe dans les tâches en aval telles que l'inpainting en profondeur. DepthFM est efficace et peut synthétiser des cartes de profondeur en quelques étapes d'inférence. Lisons ce travail ensemble ~ 1. Titre des informations sur l'article : DepthFM : FastMonocularDepthEstimationwithFlowMatching Auteur : MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L’IA change effectivement les mathématiques. Récemment, Tao Zhexuan, qui a prêté une attention particulière à cette question, a transmis le dernier numéro du « Bulletin de l'American Mathematical Society » (Bulletin de l'American Mathematical Society). En se concentrant sur le thème « Les machines changeront-elles les mathématiques ? », de nombreux mathématiciens ont exprimé leurs opinions. L'ensemble du processus a été plein d'étincelles, intense et passionnant. L'auteur dispose d'une équipe solide, comprenant Akshay Venkatesh, lauréat de la médaille Fields, le mathématicien chinois Zheng Lejun, l'informaticien de l'Université de New York Ernest Davis et de nombreux autres universitaires bien connus du secteur. Le monde de l’IA a radicalement changé. Vous savez, bon nombre de ces articles ont été soumis il y a un an.

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

La version Kuaishou de Sora 'Ke Ling' est ouverte aux tests : génère plus de 120 s de vidéo, comprend mieux la physique et peut modéliser avec précision des mouvements complexes

Jun 11, 2024 am 09:51 AM

La version Kuaishou de Sora 'Ke Ling' est ouverte aux tests : génère plus de 120 s de vidéo, comprend mieux la physique et peut modéliser avec précision des mouvements complexes

Jun 11, 2024 am 09:51 AM

Quoi? Zootopie est-elle concrétisée par l’IA domestique ? Avec la vidéo est exposé un nouveau modèle de génération vidéo domestique à grande échelle appelé « Keling ». Sora utilise une voie technique similaire et combine un certain nombre d'innovations technologiques auto-développées pour produire des vidéos qui comportent non seulement des mouvements larges et raisonnables, mais qui simulent également les caractéristiques du monde physique et possèdent de fortes capacités de combinaison conceptuelle et d'imagination. Selon les données, Keling prend en charge la génération de vidéos ultra-longues allant jusqu'à 2 minutes à 30 ips, avec des résolutions allant jusqu'à 1080p, et prend en charge plusieurs formats d'image. Un autre point important est que Keling n'est pas une démo ou une démonstration de résultats vidéo publiée par le laboratoire, mais une application au niveau produit lancée par Kuaishou, un acteur leader dans le domaine de la vidéo courte. De plus, l'objectif principal est d'être pragmatique, de ne pas faire de chèques en blanc et de se mettre en ligne dès sa sortie. Le grand modèle de Ke Ling est déjà sorti à Kuaiying.

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

La vitalité de la super intelligence s'éveille ! Mais avec l'arrivée de l'IA qui se met à jour automatiquement, les mères n'ont plus à se soucier des goulots d'étranglement des données.

Apr 29, 2024 pm 06:55 PM

Je pleure à mort. Le monde construit à la folie de grands modèles. Les données sur Internet ne suffisent pas du tout. Le modèle de formation ressemble à « The Hunger Games », et les chercheurs en IA du monde entier se demandent comment nourrir ces personnes avides de données. Ce problème est particulièrement important dans les tâches multimodales. À une époque où rien ne pouvait être fait, une équipe de start-up du département de l'Université Renmin de Chine a utilisé son propre nouveau modèle pour devenir la première en Chine à faire de « l'auto-alimentation des données générées par le modèle » une réalité. De plus, il s’agit d’une approche à deux volets, du côté compréhension et du côté génération, les deux côtés peuvent générer de nouvelles données multimodales de haute qualité et fournir un retour de données au modèle lui-même. Qu'est-ce qu'un modèle ? Awaker 1.0, un grand modèle multimodal qui vient d'apparaître sur le Forum Zhongguancun. Qui est l'équipe ? Moteur Sophon. Fondé par Gao Yizhao, doctorant à la Hillhouse School of Artificial Intelligence de l’Université Renmin.

L'US Air Force présente son premier avion de combat IA de grande envergure ! Le ministre a personnellement effectué l'essai routier sans intervenir pendant tout le processus, et 100 000 lignes de code ont été testées 21 fois.

May 07, 2024 pm 05:00 PM

L'US Air Force présente son premier avion de combat IA de grande envergure ! Le ministre a personnellement effectué l'essai routier sans intervenir pendant tout le processus, et 100 000 lignes de code ont été testées 21 fois.

May 07, 2024 pm 05:00 PM

Récemment, le milieu militaire a été submergé par la nouvelle : les avions de combat militaires américains peuvent désormais mener des combats aériens entièrement automatiques grâce à l'IA. Oui, tout récemment, l’avion de combat IA de l’armée américaine a été rendu public pour la première fois, dévoilant ainsi son mystère. Le nom complet de ce chasseur est Variable Stability Simulator Test Aircraft (VISTA). Il a été personnellement piloté par le secrétaire de l'US Air Force pour simuler une bataille aérienne en tête-à-tête. Le 2 mai, le secrétaire de l'US Air Force, Frank Kendall, a décollé à bord d'un X-62AVISTA à la base aérienne d'Edwards. Notez que pendant le vol d'une heure, toutes les actions de vol ont été effectuées de manière autonome par l'IA ! Kendall a déclaré : "Au cours des dernières décennies, nous avons réfléchi au potentiel illimité du combat air-air autonome, mais cela a toujours semblé hors de portée." Mais maintenant,