Périphériques technologiques

Périphériques technologiques

IA

IA

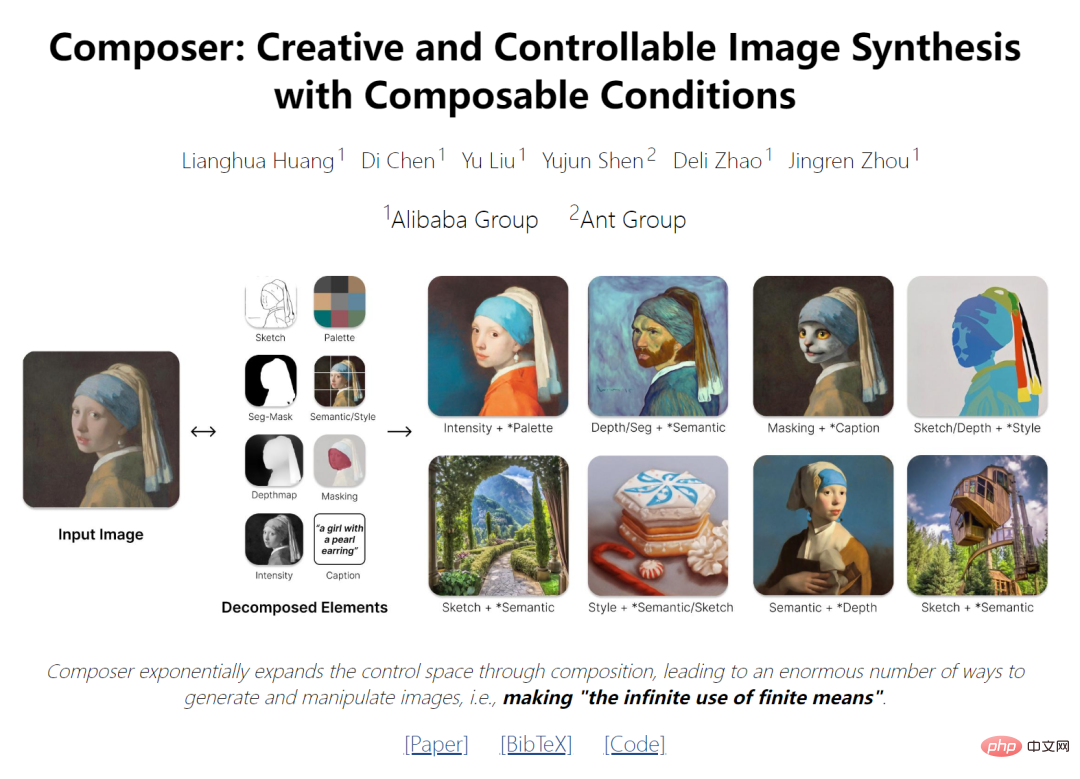

Nouvelles idées pour la peinture IA : nouveau modèle open source national avec 5 milliards de paramètres, réalisant un bond en avant en termes de contrôlabilité et de qualité synthétiques

Nouvelles idées pour la peinture IA : nouveau modèle open source national avec 5 milliards de paramètres, réalisant un bond en avant en termes de contrôlabilité et de qualité synthétiques

Nouvelles idées pour la peinture IA : nouveau modèle open source national avec 5 milliards de paramètres, réalisant un bond en avant en termes de contrôlabilité et de qualité synthétiques

- Adresse papier : https://arxiv.org/pdf/2302.09778v2.pdf

- Adresse du projet : https://github.com/damo-vilab/composer

Ces dernières années, les modèles génératifs à grande échelle appris sur le big data ont été capables de synthétiser des images de manière excellente, mais ont une contrôlabilité limitée. La clé d’une génération d’images contrôlable repose non seulement sur les conditions mais, plus important encore, sur la composition. Ce dernier peut étendre de manière exponentielle l'espace de contrôle en introduisant un grand nombre de combinaisons potentielles (par exemple 100 images avec 8 représentations chacune, donnant environ 100 ^ 8 combinaisons). Des concepts similaires ont été explorés dans les domaines de la compréhension du langage et de la scène, où la compositionnalité est connue sous le nom de généralisation combinatoire, la capacité d'identifier ou de générer un nombre potentiellement infini de nouvelles combinaisons à partir d'un ensemble limité de composants connus.

Les dernières recherches fournissent un paradigme de nouvelle génération capable de contrôler de manière flexible l'image de sortie (telle que la disposition spatiale et la palette de couleurs) tout en conservant la qualité de synthèse et la créativité du modèle.

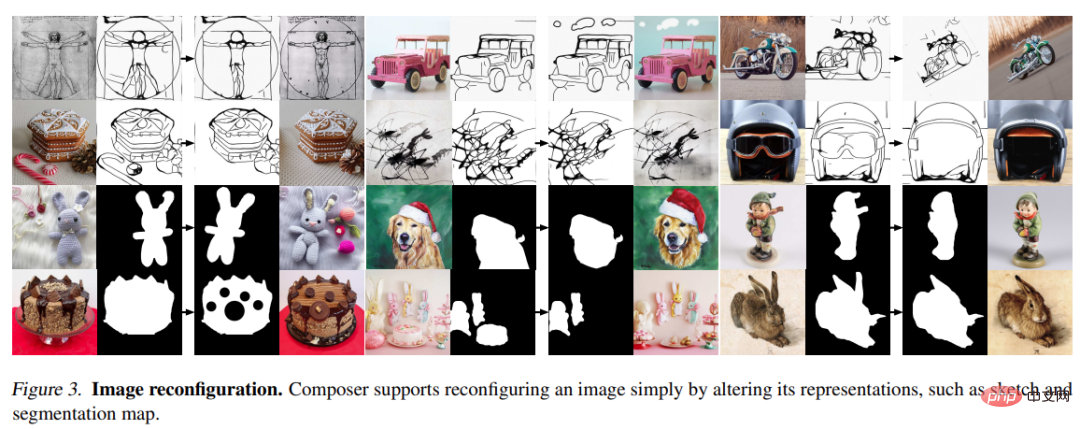

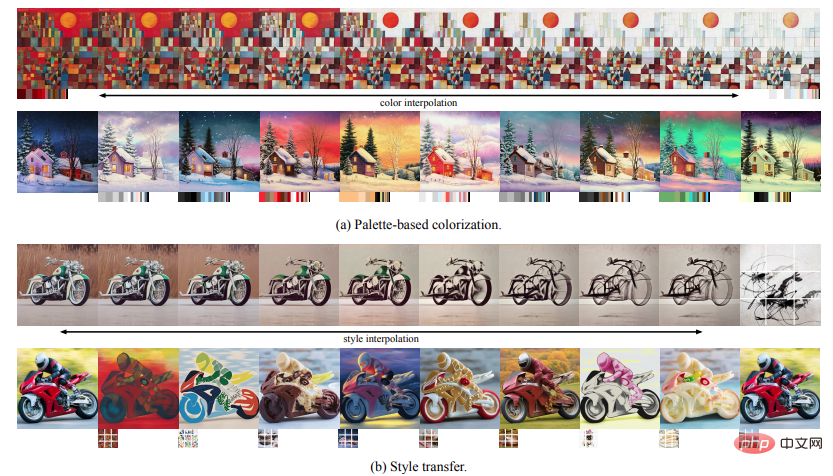

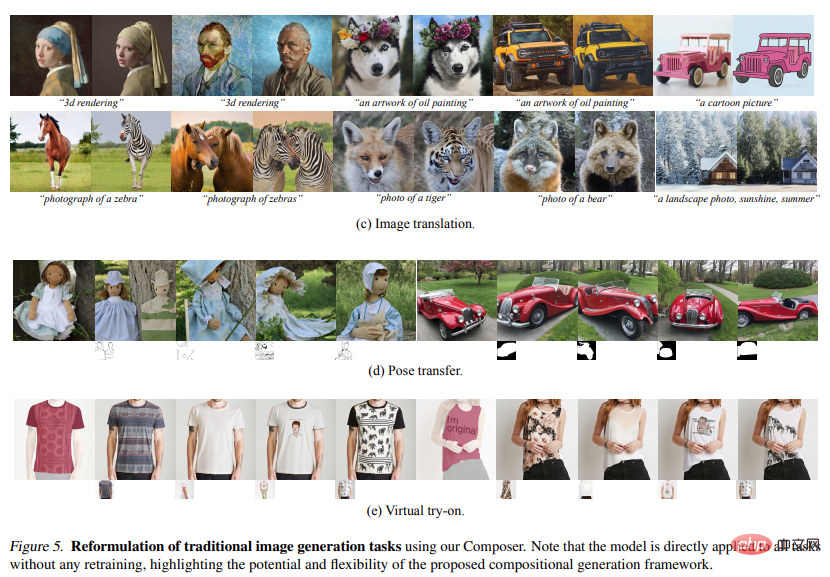

Cette recherche prend la compositionnalité comme idée centrale. Elle décompose d'abord l'image en facteurs représentatifs, puis entraîne un modèle de diffusion conditionné par ces facteurs pour réorganiser l'entrée. Pendant la phase d'inférence, de riches représentations intermédiaires servent d'éléments composables, offrant un immense espace de conception pour la création de contenu personnalisable (c'est-à-dire exponentiellement proportionnel au nombre de facteurs de décomposition). Il convient de noter que la méthode nommée Composer prend en charge différents niveaux de conditions, tels que les descriptions de texte comme informations globales, les cartes de profondeur et les croquis comme guidage local, les histogrammes de couleurs comme détails de bas niveau, etc.

En plus d'améliorer la contrôlabilité, cette étude confirme que Composer peut servir de cadre général facilitant un large éventail de tâches de génération classiques sans nécessiter de recyclage.

Méthode

Le cadre présenté dans cet article comprend une étape de décomposition (l'image est divisée en un ensemble de composants indépendants) et une étape de synthèse (les composants sont recombinés à l'aide d'un modèle de diffusion conditionnelle). Ici, nous présentons d'abord brièvement le modèle de diffusion et la direction de guidage implémentés à l'aide de Composer, puis détaillons la mise en œuvre de la décomposition et de la synthèse d'images.

2.1. Modèle de diffusion

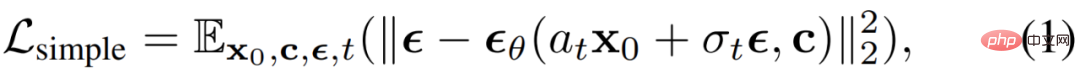

Le modèle de diffusion est un modèle génératif qui génère des données à partir du bruit gaussien via un processus de débruitage itératif. Une simple erreur quadratique moyenne est généralement utilisée comme cible de débruitage :

où, x_0 est les données d'entraînement avec la condition facultative c,  est un bruit gaussien additif, a_t, σ_t sont de t. fonction scalaire,

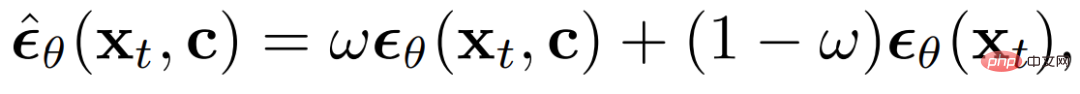

est un bruit gaussien additif, a_t, σ_t sont de t. fonction scalaire,  est un modèle de diffusion avec des paramètres apprenables θ. Le bootstrap sans classificateur a été le plus largement utilisé dans les travaux récents pour l'échantillonnage conditionnel de données de modèles de diffusion, où le bruit prédit est ajusté par :

est un modèle de diffusion avec des paramètres apprenables θ. Le bootstrap sans classificateur a été le plus largement utilisé dans les travaux récents pour l'échantillonnage conditionnel de données de modèles de diffusion, où le bruit prédit est ajusté par :

formule Dans  , ω est le poids de guidage. DDIM et DPM-Solver sont souvent utilisés pour accélérer le processus d'échantillonnage des modèles de diffusion. DDIM peut également être utilisé pour inverser un échantillon x_0 à son potentiel de bruit pur x_T, permettant diverses opérations d'édition d'image.

, ω est le poids de guidage. DDIM et DPM-Solver sont souvent utilisés pour accélérer le processus d'échantillonnage des modèles de diffusion. DDIM peut également être utilisé pour inverser un échantillon x_0 à son potentiel de bruit pur x_T, permettant diverses opérations d'édition d'image.

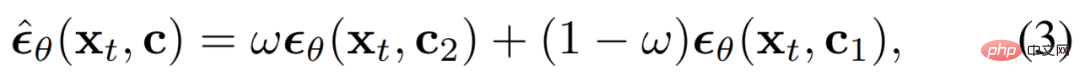

Direction de guidage : Composer est un modèle de diffusion qui peut accepter plusieurs conditions et peut atteindre diverses directions sans guidage de classificateur :

c_1 et c_2 sont deux ensembles de conditions. Différents choix de c_1 et c_2 représentent une emphase différente sur la condition. Les conditions dans

(c_2 c_1) sont soulignées comme ω, les conditions dans (c_1 c_2) sont supprimées comme (1−ω) et les conditions dans c1∩c2 ont un poids indicatif de 1,0. Guidage bidirectionnel : en utilisant la condition c_1 pour inverser l'image x_0 en x_T sous-jacent, puis en utilisant une autre condition c_2 pour échantillonner à partir de x_T, nous pouvons utiliser Composer pour manipuler l'image de manière démêlée, où la direction de manipulation est entre c_2 et c_1 définis par des différences.

Decomposition

étudie la décomposition des images en représentations découplées qui capturent divers aspects de l'image, et décrit les huit représentations utilisées dans cette tâche, qui sont extraites en temps réel pendant le processus de formation.

Légende : La recherche utilise directement les informations de titre ou de description dans les données de formation image-texte (par exemple, LAION-5B (Schuhmann et al., 2022)) comme légendes d'image. Les images pré-entraînées peuvent également être exploitées pour illustrer le modèle lorsque les annotations ne sont pas disponibles. Nous caractérisons ces titres à l'aide d'incorporations de phrases et de mots extraites du modèle CLIP ViT-L /14@336px pré-entraîné (Radford et al., 2021).

Sémantique et style : Étude à l'aide d'images incorporées extraites par le modèle CLIP ViT-L/14@336px pré-entraîné pour caractériser la sémantique et le style des images, similaire à unCLIP.

Color : Étudiez les statistiques de couleur des images à l'aide des histogrammes CIELab lissés. Quantifiez l'espace colorimétrique CIELab en 11 valeurs de teinte, 5 valeurs de saturation et 5 valeurs de lumière, en utilisant un sigma de lissage de 10. Par expérience, ce paramètre fonctionne mieux.

Sketch : Recherche sur l'application d'un modèle de détection de contour puis sur l'utilisation d'un algorithme de réduction d'esquisse pour extraire une esquisse de l'image. Sketch capture les détails locaux d'une image avec moins de sémantique.

Instances : Étudiez à l'aide du modèle YOLOv5 pré-entraîné pour appliquer la segmentation d'instance sur les images afin d'extraire leurs masques d'instance. Les masques de segmentation d'instance reflètent les informations de catégorie et de forme des objets visuels.

Depthmap : Étudiez l'utilisation d'un modèle d'estimation de profondeur monoculaire pré-entraîné pour extraire la carte de profondeur de l'image, capturant grossièrement la disposition de l'image.

Intensité : L'étude introduit l'image originale en niveaux de gris comme représentation, obligeant le modèle à apprendre à gérer le degré de liberté démêlé de la couleur. Pour introduire le caractère aléatoire, nous échantillonnons uniformément à partir d'un ensemble de poids de canal RVB prédéfinis pour créer des images en niveaux de gris.

Masking : Étudiez l'introduction du masquage d'image pour permettre à Composer de limiter la génération ou les opérations d'image aux zones modifiables. Une représentation à 4 canaux est utilisée, où les 3 premiers canaux correspondent à l'image RVB masquée et le dernier canal correspond au masque binaire.

Il convient de noter que bien que cet article ait mené des expériences en utilisant les huit conditions ci-dessus, les utilisateurs peuvent librement personnaliser les conditions à l'aide de Composer.

Composition

étudie l'utilisation de modèles de diffusion pour recombiner des images à partir d'un ensemble de représentations. Plus précisément, l'étude exploite l'architecture GLIDE et modifie son module de réglage. L'étude explore deux mécanismes différents pour adapter des modèles basés sur des représentations :

Conditionnement global : pour les représentations globales, y compris les intégrations de phrases CLIP, les intégrations d'images et les palettes de couleurs, nous les projetons et les ajoutons aux intégrations temporelles. De plus, nous projetons les intégrations d'images et les palettes de couleurs dans huit jetons supplémentaires et les concaténons avec des intégrations de mots CLIP, qui sont ensuite utilisées comme contexte pour l'attention croisée dans GLIDE, similaire à unCLIP. Étant donné que les conditions sont soit additives, soit masquées de manière sélective lors d'une attention croisée, les conditions peuvent être supprimées directement pendant la formation et l'inférence, ou de nouvelles conditions globales peuvent être introduites.

Conditionnement de localisation : pour les représentations localisées, y compris les croquis, les masques de segmentation, les cartes de profondeur, les images d'intensité et les images de masque, nous utilisons des couches convolutives empilées pour les projeter sur une moyenne avec la même taille spatiale que le potentiel de bruit x_t dimensionnellement intégré . La somme de ces intégrations est ensuite calculée et le résultat est concaténé à x_t, qui est ensuite introduit dans UNet. Puisque les plongements sont additifs, il est facile d’adapter les conditions manquantes ou d’incorporer de nouvelles conditions localisées.

Stratégie de formation commune : Il est important de concevoir une stratégie de formation commune qui permet au modèle d'apprendre à décoder des images à partir de diverses combinaisons de conditions. L'étude a expérimenté plusieurs configurations et identifié une configuration simple mais efficace qui utilise une probabilité de sortie indépendante de 0,5 pour chaque condition, une probabilité de 0,1 pour supprimer toutes les conditions et une probabilité de 0,1 pour conserver toutes les conditions. Une probabilité d'abandon spéciale de 0,7 est utilisée pour les images d'intensité car elles contiennent la grande majorité des informations sur l'image et peuvent affaiblir d'autres conditions pendant l'entraînement.

Le modèle de diffusion de base produit une image de résolution 64 × 64. Pour générer des images haute résolution, nous avons formé deux modèles de diffusion inconditionnelle pour le suréchantillonnage, respectivement le suréchantillonnage des images de 64 × 64 à 256 × 256 et de 256 × 256 à 1024 × 1024 de résolution. L'architecture du modèle de suréchantillonnage est modifiée par rapport à unCLIP, où l'utilisation de davantage de canaux dans les couches basse résolution est étudiée et des blocs d'auto-attention sont introduits pour étendre la capacité. Un modèle antérieur facultatif est également introduit qui génère des intégrations d'images à partir de sous-titres. Empiriquement, les modèles antérieurs peuvent améliorer la diversité des images générées dans des combinaisons spécifiques de conditions.

Expérimentation

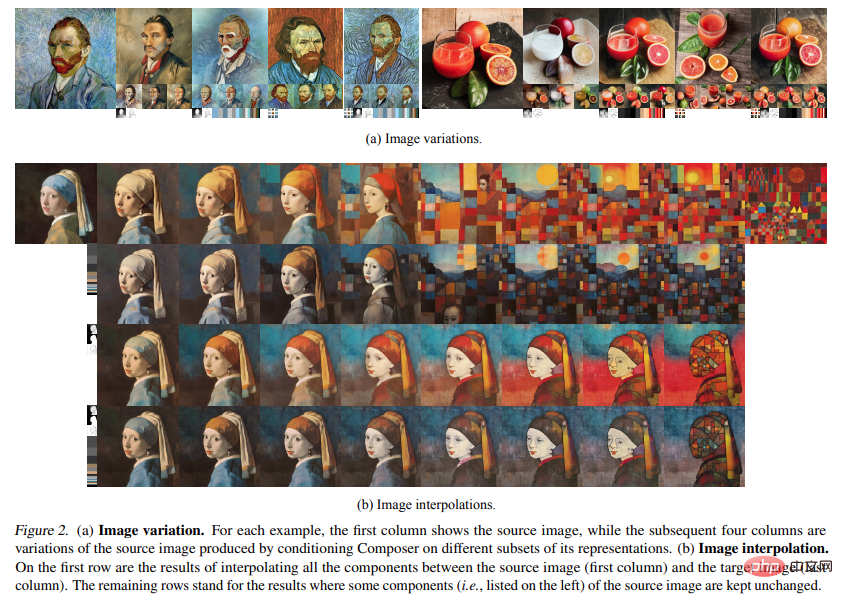

Variation : En utilisant Composer, il est possible de créer une nouvelle image similaire à une image donnée, mais quelque peu différente à certains égards en conditionnant un sous-ensemble spécifique de sa représentation. En choisissant soigneusement des combinaisons de différentes représentations, on peut contrôler de manière flexible la plage de changements d'image (Fig. 2a). Après avoir incorporé plus de conditions, la méthode présentée dans l'étude génère une variante d'unCLIP qui conditionne uniquement l'intégration de l'image : en utilisant Composer, il est possible de créer de nouvelles images similaires à une image donnée, mais conditionnelles à un sous-ensemble spécifique de sa représentation. La réflexion est différente à certains égards. En choisissant soigneusement des combinaisons de différentes représentations, on peut contrôler de manière flexible la plage de changements d'image (Fig. 2a). Après avoir incorporé plus de conditions, la méthode proposée atteint une précision de reconstruction plus élevée que unCLIP, qui est uniquement conditionnée aux intégrations d'images.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

La commande de fermeture CENTOS est arrêtée et la syntaxe est la fermeture de [options] le temps [informations]. Les options incluent: -H Arrêtez immédiatement le système; -P éteignez l'alimentation après l'arrêt; -r redémarrer; -t temps d'attente. Les temps peuvent être spécifiés comme immédiats (maintenant), minutes (minutes) ou une heure spécifique (HH: mm). Des informations supplémentaires peuvent être affichées dans les messages système.

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Guide complet pour vérifier la configuration HDFS dans les systèmes CentOS Cet article vous guidera comment vérifier efficacement la configuration et l'état de l'exécution des HDF sur les systèmes CentOS. Les étapes suivantes vous aideront à bien comprendre la configuration et le fonctionnement des HDF. Vérifiez la variable d'environnement Hadoop: Tout d'abord, assurez-vous que la variable d'environnement Hadoop est correctement définie. Dans le terminal, exécutez la commande suivante pour vérifier que Hadoop est installé et configuré correctement: HadoopVersion Check HDFS Fichier de configuration: Le fichier de configuration de base de HDFS est situé dans le répertoire / etc / hadoop / conf / le répertoire, où Core-site.xml et hdfs-site.xml sont cruciaux. utiliser

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

La politique de sauvegarde et de récupération de GitLab dans le système CentOS afin d'assurer la sécurité et la récupérabilité des données, Gitlab on CentOS fournit une variété de méthodes de sauvegarde. Cet article introduira plusieurs méthodes de sauvegarde courantes, paramètres de configuration et processus de récupération en détail pour vous aider à établir une stratégie complète de sauvegarde et de récupération de GitLab. 1. MANUEL BACKUP Utilisez le Gitlab-RakegitLab: Backup: Créer la commande pour exécuter la sauvegarde manuelle. Cette commande sauvegarde des informations clés telles que le référentiel Gitlab, la base de données, les utilisateurs, les groupes d'utilisateurs, les clés et les autorisations. Le fichier de sauvegarde par défaut est stocké dans le répertoire / var / opt / gitlab / backups. Vous pouvez modifier / etc / gitlab

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Activer l'accélération du GPU Pytorch sur le système CentOS nécessite l'installation de versions CUDA, CUDNN et GPU de Pytorch. Les étapes suivantes vous guideront tout au long du processus: CUDA et CUDNN Installation détermineront la compatibilité de la version CUDA: utilisez la commande NVIDIA-SMI pour afficher la version CUDA prise en charge par votre carte graphique NVIDIA. Par exemple, votre carte graphique MX450 peut prendre en charge CUDA11.1 ou plus. Téléchargez et installez Cudatoolkit: visitez le site officiel de Nvidiacudatoolkit et téléchargez et installez la version correspondante selon la version CUDA la plus élevée prise en charge par votre carte graphique. Installez la bibliothèque CUDNN:

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Docker utilise les fonctionnalités du noyau Linux pour fournir un environnement de fonctionnement d'application efficace et isolé. Son principe de travail est le suivant: 1. Le miroir est utilisé comme modèle en lecture seule, qui contient tout ce dont vous avez besoin pour exécuter l'application; 2. Le Système de fichiers Union (UnionFS) empile plusieurs systèmes de fichiers, ne stockant que les différences, l'économie d'espace et l'accélération; 3. Le démon gère les miroirs et les conteneurs, et le client les utilise pour l'interaction; 4. Les espaces de noms et les CGROUP implémentent l'isolement des conteneurs et les limitations de ressources; 5. Modes de réseau multiples prennent en charge l'interconnexion du conteneur. Ce n'est qu'en comprenant ces concepts principaux que vous pouvez mieux utiliser Docker.

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

L'installation de MySQL sur CENTOS implique les étapes suivantes: Ajout de la source MySQL YUM appropriée. Exécutez la commande YUM Install MySQL-Server pour installer le serveur MySQL. Utilisez la commande mysql_secure_installation pour créer des paramètres de sécurité, tels que la définition du mot de passe de l'utilisateur racine. Personnalisez le fichier de configuration MySQL selon les besoins. Écoutez les paramètres MySQL et optimisez les bases de données pour les performances.

Comment afficher les journaux Gitlab sous Centos

Apr 14, 2025 pm 06:18 PM

Comment afficher les journaux Gitlab sous Centos

Apr 14, 2025 pm 06:18 PM

Un guide complet pour consulter les journaux GitLab sous Centos System Cet article vous guidera comment afficher divers journaux GitLab dans le système CentOS, y compris les journaux principaux, les journaux d'exception et d'autres journaux connexes. Veuillez noter que le chemin du fichier journal peut varier en fonction de la version Gitlab et de la méthode d'installation. Si le chemin suivant n'existe pas, veuillez vérifier le répertoire d'installation et les fichiers de configuration de GitLab. 1. Afficher le journal GitLab principal Utilisez la commande suivante pour afficher le fichier journal principal de l'application GitLabRails: Commande: sudocat / var / log / gitlab / gitlab-rails / production.log Cette commande affichera le produit

Comment faire fonctionner la formation distribuée de Pytorch sur CentOS

Apr 14, 2025 pm 06:36 PM

Comment faire fonctionner la formation distribuée de Pytorch sur CentOS

Apr 14, 2025 pm 06:36 PM

La formation distribuée par Pytorch sur le système CentOS nécessite les étapes suivantes: Installation de Pytorch: La prémisse est que Python et PIP sont installés dans le système CentOS. Selon votre version CUDA, obtenez la commande d'installation appropriée sur le site officiel de Pytorch. Pour la formation du processeur uniquement, vous pouvez utiliser la commande suivante: pipinstalltorchtorchVisionTorChaudio Si vous avez besoin d'une prise en charge du GPU, assurez-vous que la version correspondante de CUDA et CUDNN est installée et utilise la version Pytorch correspondante pour l'installation. Configuration de l'environnement distribué: la formation distribuée nécessite généralement plusieurs machines ou des GPU multiples uniques. Lieu