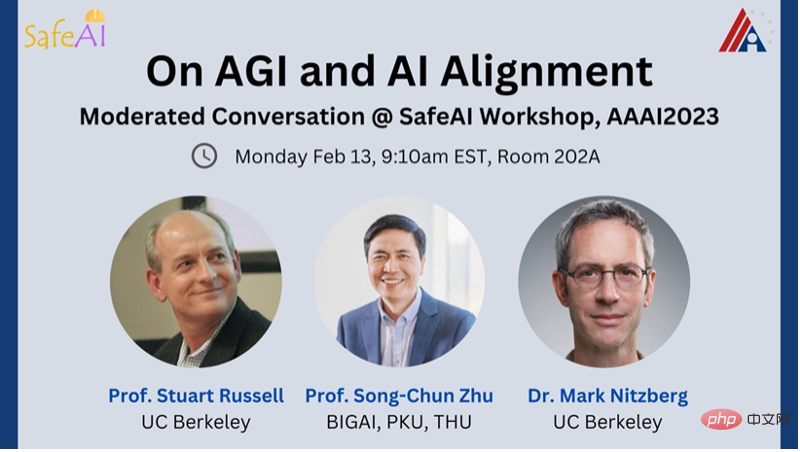

Mark Nitzberg : Aujourd'hui, nous avons l'honneur d'inviter deux meilleurs experts en intelligence artificielle à participer à ce séminaire SafeAI.

Il s'agit de : Stuart Russell, informaticien à l'Université de Californie à Berkeley, directeur du Center for Class-Compatible Artificial Intelligence (CHAI), et membre du comité directeur du Artificial Intelligence Research Laboratory (BAIR). Vice-président du Comité sur l'intelligence artificielle et la robotique du Forum économique mondial, AAAS Fellow et AAAI Fellow.

Zhu Songchun, président de l'Institut d'intelligence artificielle générale de Pékin, professeur titulaire de la chaire de l'Université de Pékin, doyen de l'École d'intelligence et de l'Institut de recherche en intelligence artificielle de l'Université de Pékin et professeur titulaire de la chaire de sciences fondamentales à l'Université Tsinghua.

Mark Nitzberg : Qu'est-ce que « l'intelligence artificielle générale » ? Existe-t-il un test bien défini pour déterminer quand nous l'avons créé ?

Stuart Russell : L'intelligence artificielle générale a été décrite comme étant capable d'accomplir toutes les tâches dont les humains sont capables, mais ce n'est qu'une déclaration générale. Nous espérons que l’intelligence artificielle générale pourra faire des choses que les humains ne peuvent pas faire, comme résumer toutes les connaissances ou simuler des interactions complexes entre particules.

Afin d'étudier l'intelligence artificielle générale, nous pouvons passer des repères de tâches spécifiques aux propriétés générales de l'environnement de tâche , telles que l'observabilité partielle, le long terme, l'imprévisibilité, etc., et demander vous-même si vous avez la capacité de fournir des solutions complètes pour ces propriétés. Si nous avons cette capacité, l’intelligence artificielle générale devrait être capable d’accomplir automatiquement des tâches que les humains peuvent accomplir, tout en ayant la capacité d’accomplir davantage de tâches. Bien qu'il existe certains tests (comme BigBench) qui prétendent tester la généralité, ils ne couvrent pas les tâches inaccessibles aux systèmes d'intelligence artificielle, comme « Pouvez-vous inventer un détecteur d'ondes gravitationnelles ? Il y a quelques années, beaucoup de gens pensaient que parvenir à une intelligence artificielle générale était un objectif inaccessible. Cependant, la récente popularité de ChatGPT a rendu tout le monde plein d'attentes, et il semble que l'intelligence artificielle générale soit à notre portée. Lorsque j'ai créé l'Institut d'intelligence artificielle générale de Pékin (BIGAI), une nouvelle institution de recherche et développement en Chine, j'ai spécifiquement décidé d'utiliser AGI dans le nom de l'institution pour la distinguer de l'intelligence artificielle spécialisée. Le mot « Tong » en Tongyuan est composé des trois lettres « A », « G » et « I ». Selon la prononciation du mot « tong », nous appelons également l'intelligence artificielle générale TongAI.

L'intelligence artificielle générale est l'intention originale et le but ultime de la recherche sur l'intelligence artificielle. L’objectif est de réaliser un agent intelligent général doté de capacités autonomes de perception, de cognition, de prise de décision, d’apprentissage, d’exécution et de collaboration sociale, et conforme aux émotions humaines, à l’éthique et aux concepts moraux. Cependant, au cours des 20 à 30 dernières années, les gens ont utilisé des quantités massives de données classifiées pour résoudre des tâches telles que la reconnaissance faciale, la détection de cibles et la traduction de texte une par une. Cela a soulevé la question de savoir combien de tâches peuvent être effectuées. être considéré comme universel ?

Je crois qu'il y a trois conditions clés pour parvenir à une intelligence artificielle générale. 1) Un agent général est capable de gérer des tâches illimitées

, y compris celles qui ne sont pas prédéfinies dans des environnements physiques et sociaux complexes et dynamiques. 2) Un agent général doit êtreautonome, c'est-à-dire qu'il doit l'être. capable de générer et d'accomplir des tâches par lui-même comme les humains ; 3) Un agent général doit avoir un système de valeurs, car ses objectifs sont définis par des valeurs. Les systèmes intelligents sont pilotés par des architectures cognitives dotées de systèmes de valeurs. Mark Nitzberg : Pensez-vous que les grands modèles linguistiques (LLM) et d'autres types de base peuvent atteindre l'intelligence artificielle générale ? Un article récent rédigé par un professeur de l'Université de Stanford affirme que les modèles de langage peuvent avoir des états mentaux comparables à ceux d'un enfant de 9 ans. Que pensez-vous de cette déclaration ?

Zhu Songchun : Bien que les modèles de langage à grande échelle aient fait des progrès étonnants, si nous comparons les trois normes ci-dessus, nous constaterons que les modèles de langage à grande échelle ne répondent pas encore aux exigences de l'intelligence artificielle générale. .

1) Les grands modèles de langage ont des capacités limitées dans le traitement des tâches. Ils ne peuvent gérer que des tâches dans le domaine du texte et ne peuvent pas interagir avec l'environnement physique et social. Cela signifie que des modèles comme ChatGPT ne peuvent pas vraiment « comprendre » le sens du langage car ils n’ont pas de corps pour expérimenter l’espace physique. Les philosophes chinois reconnaissent depuis longtemps le concept d'« unité de la connaissance et de l'action », c'est-à-dire que la « connaissance » du monde par les gens est basée sur « l'action ». C’est également la clé pour savoir si l’intelligence générale peut réellement pénétrer les scènes physiques et la société humaine. Ce n'est que lorsque les agents artificiels sont placés dans le monde physique réel et dans la société humaine qu'ils peuvent véritablement comprendre et apprendre les relations physiques entre les choses du monde réel et les relations sociales entre les différents agents intelligents, réalisant ainsi « l'unité de la connaissance et de l'action ».

2) Les modèles linguistiques à grande échelle ne sont pas autonomes. Ils nécessitent que les humains définissent spécifiquement chaque tâche, tout comme un « perroquet géant » qui ne peut qu'imiter des énoncés entraînés. Une intelligence véritablement autonome devrait être similaire à « l’intelligence des corbeaux ». Les corbeaux peuvent accomplir de manière autonome des tâches plus intelligentes que l’IA actuelle. Les systèmes d’IA actuels n’ont pas encore ce potentiel.

3) Bien que ChatGPT ait été formé à grande échelle sur différents corpus de données textuelles, y compris des textes avec des valeurs humaines implicites, il n'a pas la capacité de comprendre les valeurs humaines ni d'être cohérent avec les valeurs humaines, c'est-à-dire il lui manque ce qu’on appelle la boussole morale.

Concernant la découverte de l'article selon laquelle le modèle de langage peut avoir un état mental équivalent à celui d'un enfant de 9 ans, je pense que c'est un peu exagéré. L'article a découvert grâce à certains tests expérimentaux que GPT-3.5 peut répondre. 93% des questions correctement, Equivalent au niveau d'un enfant de 9 ans. Mais si certaines machines basées sur des règles peuvent passer des tests similaires, pouvons-nous dire que ces machines ont une théorie de l’esprit ? Même si GPT peut réussir ce test, cela ne fait que refléter sa capacité à réussir ce test de théorie de l'esprit, et cela ne signifie pas qu'il a une théorie de l'esprit. En même temps, nous devons également réfléchir à la pratique de l'utilisation de ces théories traditionnelles. tester des tâches pour vérifier si la machine a développé une théorie de l’esprit. Est-ce strict et légal ? Pourquoi les machines peuvent-elles accomplir ces tâches sans théorie de l’esprit ?

Stuart Russell : Dans un article de 1948, Turing posait le problème de générer des actions intelligentes à partir d'une immense table de recherche. Ce n'est pas pratique, car si vous souhaitez générer 2 000 mots, vous aurez besoin d'un tableau avec environ 10 ^ 10 000 entrées pour stocker toutes les séquences possibles, tout comme la taille de la fenêtre d'un grand modèle de langage utilisant des transformateurs. Un tel système peut paraître très intelligent, mais en réalité il lui manque des états mentaux et des processus de raisonnement (le sens fondamental des systèmes classiques d’intelligence artificielle).

En fait, rien ne prouve que ChatGPT possède un état mental, encore moins un état similaire à celui d'un enfant de 9 ans. Les LLM n'ont pas la capacité d'apprendre et d'exprimer des généralisations complexes, c'est pourquoi ils nécessitent de grandes quantités de données textuelles, bien plus que ce que n'importe quel enfant de 9 ans peut gérer, et ils produisent toujours des erreurs. C'est comme un programme de jeu d'échecs qui reconnaît des séquences de mouvements similaires de jeux de niveau maître précédents (tels que d4, c6, Cc3, etc.) et génère ensuite le coup suivant dans cette séquence. Même si vous le considérez la plupart du temps comme un maître des échecs, il effectue occasionnellement des mouvements illégaux car il ne connaît pas l'échiquier, les pièces ou le fait que le but est d'échec et mat l'adversaire.

Dans une certaine mesure, ChatGPT est comme ça dans tous les domaines. Nous ne sommes pas sûrs qu’il comprenne vraiment un domaine. Certaines erreurs peuvent être corrigées, mais cela revient à corriger les erreurs dans le tableau des valeurs des fonctions logarithmiques. Si une personne comprend uniquement « journal » comme signifiant « la valeur dans le tableau de la page 17 », alors la correction de la faute de frappe ne résoudra pas le problème. Ce tableau ne couvre pas encore la signification et la définition du « logarithme », il ne peut donc pas être déduit du tout. Augmenter la taille du tableau avec davantage de données ne résout pas la racine du problème.

Mark Nitzberg : Stuart, vous avez été l'un des premiers à nous mettre en garde contre les risques existentiels posés par l'intelligence artificielle générale, pensant que c'était comme l'énergie nucléaire. Pourquoi pensez-vous cela ? Comment pouvons-nous empêcher cela ? Matsuzumi, quels sont les risques liés à l'intelligence artificielle qui vous préoccupent le plus ?

Stuart Russell : En fait, Turing a été l'un des premiers à avertir. Il disait en 1951 : « Une fois qu’une machine commence à penser, elle nous dépassera bientôt. Par conséquent, à un moment donné, nous devrions nous attendre à ce que la machine soit capable d’être maîtrisée. Car lorsqu’une intelligence plus puissante que les humains émerge, les humains apparaissent. » sera bientôt Il est difficile de maintenir le pouvoir, surtout lorsque ces agents ont des objectifs incorrects ou incomplets.

Si quelqu’un pense qu’il est alarmiste d’envisager ces risques maintenant, vous pouvez lui demander directement : comment conserver le pouvoir pour toujours face à une intelligence plus puissante que les humains ? J'aimerais entendre leurs réponses. De plus, dans le domaine de l’intelligence artificielle, certains tentent encore d’éviter le problème et nient la faisabilité de l’AGI sans fournir aucune preuve.

La loi européenne sur l'intelligence artificielle définit un système d'intelligence artificielle standard qui peut atteindre des objectifs définis par les humains. On m'a dit que cette norme venait de l'OCDE, et les gens de l'OCDE m'ont dit qu'elle provenait d'une version antérieure de mon manuel. Maintenant, je pense que cette définition d’un système d’IA standard est fondamentalement erronée, car nous ne pouvons pas être complètement précis sur ce que nous voulons que l’IA fasse dans le monde réel, ni sur ce à quoi nous voulons que l’avenir ressemble . Un système d’IA qui poursuit de mauvais objectifs entraînera un avenir dont nous ne voulons pas.

Les systèmes de recommandation dans les médias sociaux en fournissent un exemple : les systèmes de recommandation tentent de maximiser les taux de clics ou l'engagement, et ils ont appris à le faire en manipulant les humains, les transformant en une version plus prévisible et apparemment plus extrême de moi-même. Rendre l’IA « meilleure » ne fera qu’aggraver les résultats humains.

Au lieu de cela, nous devons construire des systèmes d'IA qui 1) visent uniquement le bénéfice humain et 2) montrent clairement qu'ils n'ont aucune idée de ce que cela signifie. Puisque l’IA ne comprend pas le véritable sens des intérêts humains, elle doit rester incertaine quant aux préférences humaines pour garantir que nous en gardons le contrôle . Les machines devraient pouvoir être arrêtées lorsqu’elles ne sont pas sûres des préférences humaines. Une fois qu’il n’y a plus d’incertitude sur les objectifs de l’IA, ce sont les humains qui commettent les erreurs et les machines ne peuvent plus être éteintes.

Zhu Songchun :Si l'intelligence artificielle générale devient une réalité, elle pourrait constituer une menace pour l'existence humaine à long terme. En examinant la longue histoire de l’évolution de l’intelligence, nous pouvons déduire que la naissance de l’intelligence artificielle générale est presque inévitable.

La recherche scientifique moderne montre que les formes de vie sur terre évoluent constamment, de la matière inorganique à la matière organique, des cellules uniques aux organismes multicellulaires, en passant par les plantes, les animaux et enfin les créatures intelligentes comme les humains. Cela révèle qu'il existe un processus évolutif continu du « physique » vers « l'intelligent ». Quelle est la frontière entre les objets inanimés et l’intelligence vivante ? Cette question est très importante, car elle concerne la manière de comprendre et de définir les « agents intelligents » qui coexisteront avec nous dans la société future. Je pense que cette réponse est liée au « degré de vie », des formes de vie inanimées aux formes de vie simples. aux agents intelligents complexes. Le « degré de vie » « l'intelligence » devient de plus en plus grand, et « l'intelligence » devient de plus en plus complexe. Nous n'avons aucune raison de penser que les humains en seront la fin. spectre évolutif. Cela indique également qu’il est possible que l’intelligence générale dépasse les humains à l’avenir.

Afin d'éviter que l'intelligence artificielle générale future ne constitue une menace pour l'humanité, nous pouvons libérer progressivement l'espace des capacités et l'espace des valeurs de l'intelligence générale. Tout comme lorsque nous affrontons un robot, nous l'avons d'abord enfermé dans une « cage » et avons lentement ouvert ses autorisations. Désormais, des véhicules sans conducteur sont apparus sur des tronçons routiers spécifiques. Nous pouvons d’abord limiter les occasions applicables et l’espace d’action du système d’intelligence artificielle à des domaines spécifiques. À mesure que notre confiance dans les machines augmente et après avoir confirmé que les systèmes d’IA sont sûrs et contrôlables, nous leur accorderons progressivement plus d’espace. De plus, nous devrions promouvoir la transparence dans les processus décisionnels algorithmiques. Si nous pouvons représenter explicitement l’architecture cognitive de l’intelligence artificielle générale, afin de savoir comment elle fonctionne, nous pourrons mieux la contrôler.

Mark Nitzberg : Stuart, dans vos travaux de recherche, quelles orientations peuvent être considérées comme des recherches alignées ?

Stuart Russell : Notre objectif principal chez CHAI est de réaliser la vision ci-dessus, qui est de construire un système d'intelligence artificielle capable de gérer l'incertitude de la cible. Les méthodes existantes, peut-être à l’exception de l’apprentissage par imitation, supposent toutes à l’avance un objectif fixe connu pour le système d’intelligence artificielle, de sorte que ces méthodes devront peut-être être repensées.

En bref, nous essayons de simuler un système où plusieurs personnes et plusieurs machines interagissent. Puisque chacun a ses propres préférences, mais que la machine peut influencer de nombreuses personnes, nous définissons la fonction d’utilité de la machine comme la somme des fonctions d’utilité des individus. Cependant, nous sommes confrontés à trois problèmes.

La première question est de savoir comment regrouper les préférences de différentes personnes afin que la machine puisse comprendre et répondre aux besoins de la plupart des gens. Il a été suggéré que l’addition pourrait constituer une bonne fonction d’agrégation, car tout le monde a un poids égal et possède un bon sens de la forme, ce qui est bien démontré dans les travaux de l’économiste John Harsanyi et d’autres. Mais il doit y avoir d’autres perspectives.

La deuxième question est de savoir comment caractériser la richesse de la structure des préférences, c'est-à-dire l'ordre des distributions sur tous les futurs possibles de l'univers. Ce sont des structures de données très complexes qui ne sont explicites ni dans l'humain. le cerveau ou la machine. Par conséquent, nous avons besoin de moyens pour trier, décomposer et combiner efficacement les préférences.

Il existe actuellement des recherches sur l'IA qui tentent d'utiliser ce que l'on appelle les « réseaux CP » pour représenter certaines fonctions utilitaires complexes. La façon dont les réseaux CP décomposent les fonctions utilitaires multi-attributs est la même que les réseaux bayésiens pour les fonctions multi-variables complexes. modèles probabilistes. Cela se décompose à peu près de la même manière. Cependant, l’IA n’étudie pas vraiment le contenu du bonheur humain, ce qui est surprenant étant donné les prétentions de ce domaine d’aider les humains. Il existe en effet des communautés universitaires qui étudient le bien-être humain dans des domaines comme l'économie, la sociologie, le développement, etc. et qui ont tendance à dresser des listes de facteurs tels que la santé, la sécurité, le logement, l'alimentation, etc. le reste de l'humanité et les politiques publiques ne reflètent peut-être pas de nombreuses préférences tacites « évidentes », telles que « vouloir être en bonne santé ». À ma connaissance, ces chercheurs n'ont pas encore développé de théorie scientifique pour prédire le comportement humain, mais pour l'IA, nous avons besoin de la structure complète des préférences humaines, y compris toutes les préférences non déclarées possibles si nous avons manqué quelque chose d'important qui pourrait causer des problèmes.

La troisième question est de savoir comment déduire les préférences du comportement humain et caractériser la plasticité des préférences humaines. Si les préférences changent avec le temps, pour qui l’IA travaille-t-elle : vous aujourd’hui ou vous demain ? Nous ne voulons pas que l’intelligence artificielle modifie nos préférences pour se conformer à des états mondiaux facilement réalisables, ce qui entraînerait une perte de diversité dans le monde.

Au-delà de ces questions de recherche fondamentales, nous réfléchissons également à la manière de reconstruire de manière plus large toutes ces techniques d'intelligence artificielle (algorithmes de recherche, algorithmes de planification, algorithmes de programmation dynamique, apprentissage par renforcement, etc.). Un attribut clé du nouveau système est le flux d’informations sur les préférences des humains vers les machines pendant le fonctionnement du système. C'est tout à fait normal dans le monde réel. Par exemple, nous demandons à un chauffeur de taxi de « nous emmener à l'aéroport ». Il s’agit en fait d’un objectif plus large que notre véritable objectif. Lorsque nous étions à un kilomètre et demi, le chauffeur nous a demandé de quel terminal nous avions besoin. À mesure que nous nous rapprochons, le chauffeur pourrait demander quelle compagnie aérienne nous emmènera à la bonne porte. (Mais pas exactement à combien de millimètres de la porte !) Nous devons donc définir la forme d'incertitude et de transfert de préférences la mieux adaptée à une certaine classe d'algorithmes. Par exemple, un algorithme de recherche utilise une fonction de coût, afin que la machine puisse ; suppose des limites pour cette fonction et affine les limites en demandant aux humains laquelle des deux séquences d'actions est la plus appropriée.

En général, les machines ont toujours beaucoup d'incertitude quant aux préférences humaines ; pour cette raison, je pense que le terme « alignement » souvent utilisé dans ce domaine peut être trompeur, car les gens ont tendance à penser qu'il signifie « d'abord aligner complètement la machine ». et les préférences humaines, puis choisissez quoi faire. » Ce n’est peut-être pas le cas en réalité.

Mark Nitzberg : Song Chun, veuillez présenter la recherche sur l'alignement des valeurs que vous avez effectuée.

Zhu Songchun : Lorsque nous parlons d'alignement des valeurs, nous devons d'abord discuter de la « valeur ». Je pense que la recherche actuelle sur l'intelligence artificielle devrait passer d'une approche axée sur les données à une approche axée sur la valeur. Divers comportements intelligents des personnes sont motivés par la valeur, et les gens peuvent rapidement comprendre et apprendre la valeur. Par exemple, lorsque vous êtes assis sur une chaise, nous pouvons observer l'état d'équilibre grâce à l'analyse des forces de contact entre la chaise et le corps, inférant ainsi implicitement la valeur du « confort ». Cette valeur ne peut pas être décrite avec précision par des mots, mais elle peut être exprimée en interagissant avec la chaise. Nous pouvons également en apprendre davantage sur la valeur esthétique des gens grâce à la façon dont ils plient leurs vêtements.

De plus, je pense que le système de valeurs a un ensemble unifié de représentations, et la richesse actuelle des préférences est due à la cartographie de valeurs unifiées dans différentes conditions. Notre valeur changera selon différentes situations. Par exemple, un bus arrive à l'arrêt, si vous attendez le bus, vous souhaiterez peut-être que le bus reste plus longtemps pour vous permettre de monter dans une voiture. , vous souhaiterez peut-être que la porte se ferme immédiatement. Les systèmes d’IA doivent être capables de s’adapter rapidement aux changements de nos préférences. Une architecture cognitive axée sur la valeur est donc essentielle pour l’IA.

Pour atteindre l'intelligence générale au niveau cognitif humain, nous avons inclus l'élément d'alignement des valeurs dans notre recherche BIGAI et avons construit un système d'interaction homme-machine contenant quatre alignements. Le premier alignement est une représentation partagée, incluant une compréhension commune du monde. Le deuxième alignement concerne les connaissances de base partagées, telles que le bon sens de la physique, les chaînes causales, la logique, etc. Le troisième alignement concerne les normes sociales partagées, qui stipulent que l’IA doit suivre les normes de la société humaine et maintenir un comportement approprié. Le quatrième alignement est la valeur partagée selon laquelle l’IA doit être alignée sur les principes éthiques humains.

Nous avons publié une étude bidirectionnelle d'alignement des valeurs homme-robot en temps réel. Cette recherche propose un système d’intelligence artificielle explicable. Dans ce système, un groupe de robots déduit les objectifs de valeur de l'utilisateur grâce à une interaction en temps réel avec l'utilisateur et aux commentaires de l'utilisateur, et en même temps transmettent son processus de prise de décision à l'utilisateur par le biais d'« explications » afin que l'utilisateur comprenne la valeur. base du jugement du robot. De plus, le système génère des explications plus faciles à comprendre pour les utilisateurs en déduisant les préférences de valeur intrinsèques de l'utilisateur et en prédisant la meilleure façon d'expliquer.

Mark Nitzberg : Quelles caractéristiques des systèmes d'IA nous amènent à conclure qu'ils ne mèneront pas à une intelligence artificielle générale ?

Zhu Songchun : Comment pouvons-nous juger si une IA est une intelligence artificielle générale ? L'un des facteurs importants est la mesure dans laquelle nous lui faisons confiance. La confiance a deux niveaux : l'un est la confiance dans les capacités de l'IA, et l'autre est la confiance dans le fait que l'IA soit bénéfique aux émotions et aux valeurs humaines. Par exemple, les systèmes d’IA d’aujourd’hui peuvent très bien reconnaître les images, mais pour instaurer la confiance, elles doivent être explicables et compréhensibles. Certaines technologies sont très puissantes, mais si elles ne peuvent être expliquées, elles seront considérées comme peu fiables. Ceci est particulièrement important dans des domaines tels que les armes ou les systèmes aéronautiques, où les coûts liés aux erreurs sont élevés. Dans ce cas, la dimension émotionnelle de la confiance est plus importante, et les IA doivent expliquer comment elles prennent leurs décisions afin de gagner la confiance des humains. Par conséquent, nous devons améliorer la compréhension mutuelle grâce à l’itération, à la communication et à la collaboration entre les humains et les machines, puis parvenir à un consensus et générer une « confiance justifiée ».

En réfléchissant plus loin, se demander ce qu'est l'intelligence artificielle générale, c'est essentiellement se demander ce qu'est « l'humain » ? Tout le monde est agent général. Nous proposons une théorie basée sur le double système UV pour expliquer l'intelligence artificielle générale. Le système U est une fonction énergétique potentielle, comprenant les lois physiques objectives et les normes sociales maîtrisées par l'agent ; le système V comprend un ensemble de fonctions de valeur de l'agent. En référence à la théorie des besoins et à la recherche en psychologie du développement de Maslow. Les valeurs seront largement catégorisées. Sur la base du double système UV, nous essayons d'évaluer le niveau de développement de l'intelligence artificielle générale et d'élaborer différentes normes de L1 à L5. Ce système de test sera publié cette année.Stuart Russell : Les systèmes d'IA actuels ne sont pas universels car les circuits ne capturent pas bien l'universalité. Nous l'avons déjà vu dans la mesure où les grands modèles de langage ont des difficultés à apprendre les règles de base de l'arithmétique. Nos dernières recherches révèlent que malgré des millions d'exemples, les systèmes d'intelligence artificielle Go qui ont déjà battu les humains ne peuvent pas comprendre correctement les concepts de « grand dragon » et de « vie ou mort ». Nous, en tant que chercheurs sur les joueurs amateurs de Go, avons développé une stratégie. vaincu le programme Go. Si nous sommes convaincus que l’intelligence artificielle sera bénéfique à l’humanité, alors nous devons savoir comment elle fonctionne. Nous devons construire des systèmes d’intelligence artificielle sur un substrat sémantiquement composable soutenu par une logique explicite et une théorie des probabilités, constituant ainsi une bonne base pour parvenir à une intelligence artificielle générale à l’avenir. Une façon possible de créer un tel système est la programmation probabiliste, quelque chose que nous, au CHAI, avons récemment cherché à explorer. J'ai été encouragé de voir Matsuzumi explorer une direction similaire avec BIGAI.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Application de l'intelligence artificielle dans la vie

Application de l'intelligence artificielle dans la vie

Comment configurer un VPS sécurisé

Comment configurer un VPS sécurisé

Quel est le concept de base de l'intelligence artificielle

Quel est le concept de base de l'intelligence artificielle

webstorm a été remplacé par la version chinoise

webstorm a été remplacé par la version chinoise

css

css

Vérifiez si le port est ouvert sous Linux

Vérifiez si le port est ouvert sous Linux

Comment ouvrir le fichier HTML WeChat

Comment ouvrir le fichier HTML WeChat

Comment rendre l'arrière-plan transparent dans PS

Comment rendre l'arrière-plan transparent dans PS

Comment créer une page Web réactive

Comment créer une page Web réactive