Périphériques technologiques

Périphériques technologiques

IA

IA

Un seul GPU permet une prise de décision en ligne à 20 Hz, une interprétation de la dernière méthode efficace de planification de trajectoire basée sur un modèle de génération de séquences.

Un seul GPU permet une prise de décision en ligne à 20 Hz, une interprétation de la dernière méthode efficace de planification de trajectoire basée sur un modèle de génération de séquences.

Un seul GPU permet une prise de décision en ligne à 20 Hz, une interprétation de la dernière méthode efficace de planification de trajectoire basée sur un modèle de génération de séquences.

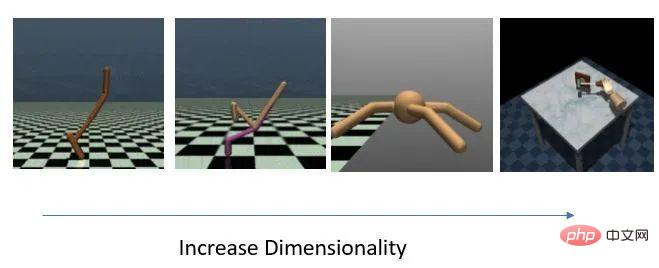

Précédemment, nous avons introduit l'application de méthodes de modélisation de séquence basées sur le modèle de transformateur et de diffusion dans l'apprentissage par renforcement, en particulier dans le domaine du contrôle continu hors ligne. Parmi eux, Trajectory Transformer (TT) et Diffusser sont des algorithmes de planification basés sur des modèles. Ils montrent une prédiction de trajectoire de très haute précision et une bonne flexibilité, mais le délai de prise de décision est relativement élevé. En particulier, TT discrétise chaque dimension indépendamment sous forme de symbole dans la séquence, ce qui rend la séquence entière très longue, et le temps de génération de séquence augmentera rapidement à mesure que les dimensions des états et des actions augmentent.

Afin de permettre au modèle de génération de trajectoire d'atteindre une vitesse de prise de décision de niveau pratique, nous avons lancé le projet de génération de trajectoire et de prise de décision efficaces en parallèle avec Diffusser (qui se chevauchent mais probablement plus tard). Notre première pensée est d'utiliser Transformateur + Mélange de Gaussien dans un espace continu au lieu d'une distribution discrète pour s'adapter à l'ensemble de la distribution de trajectoire. Bien que des problèmes de mise en œuvre ne soient pas exclus, nous n’avons pas pu obtenir un modèle de génération relativement stable avec cette approche. Ensuite, nous avons essayé Variational Autoencoder (VAE) et réalisé quelques avancées. Cependant, la précision de reconstruction du VAE n’est pas particulièrement idéale, ce qui rend les performances du contrôle en aval très différentes de celles du TT. Après plusieurs séries d'itérations, nous avons finalement sélectionné VQ-VAE comme modèle de base pour la génération de trajectoires, et avons finalement obtenu un nouvel algorithme capable d'échantillonner et de planifier efficacement, et qui fonctionne bien mieux que les autres méthodes basées sur des modèles sur les tâches de contrôle de grande dimension. Nous avons appelé Trajectory Autoencoding Planner (TAP).

- Project Home Page: https://sites.google.com/view/latentplan

- paper Homepage: https://arxiv.org/abs/2208.10291

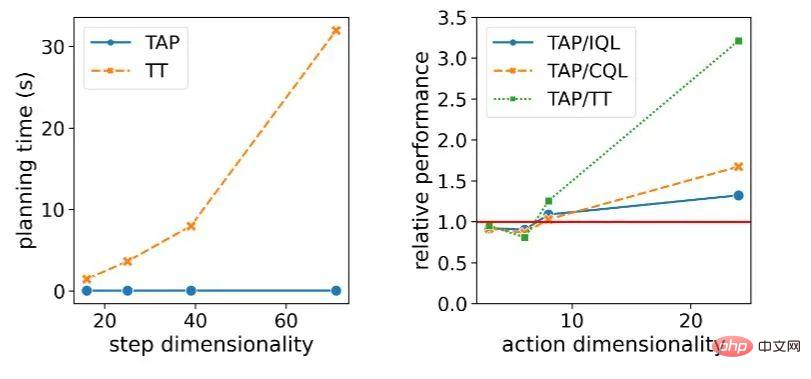

Efficacité et performances de planification en hautes dimensions

Sous un seul GPU, TAP peut facilement effectuer une prise de décision en ligne avec une efficacité de prise de décision de 20 Hz. Dans la tâche D4RL de faible dimension, le délai de prise de décision. ne représente qu'environ 1% de TT. Plus important encore, avec l'augmentation du statut de la tâche et de la dimension d'action D, le délai de prise de décision théorique de TT augmentera avec le cube  , Diffusser croîtra théoriquement de manière linéaire

, Diffusser croîtra théoriquement de manière linéaire  , alors que la vitesse de prise de décision de TAP ne l'est pas. affecté par la dimension

, alors que la vitesse de prise de décision de TAP ne l'est pas. affecté par la dimension  . En termes de performances décisionnelles de l'agent, à mesure que la dimension d'action augmente, les performances de TAP s'améliorent par rapport aux autres méthodes, et l'amélioration par rapport aux méthodes basées sur un modèle (telles que TT) est particulièrement évidente.

. En termes de performances décisionnelles de l'agent, à mesure que la dimension d'action augmente, les performances de TAP s'améliorent par rapport aux autres méthodes, et l'amélioration par rapport aux méthodes basées sur un modèle (telles que TT) est particulièrement évidente.

L'importance du délai de prise de décision pour les tâches de prise de décision et de contrôle est très évidente. Bien que les algorithmes comme MuZero fonctionnent bien dans les environnements de simulation, lorsqu'ils sont confrontés à des tâches qui nécessitent une réponse rapide et en temps réel dans le monde réel, la décision est prise. - des délais trop importants deviendront une difficulté majeure dans son déploiement. De plus, dans le cadre d'un environnement de simulation, la lenteur de la prise de décision entraînera également des coûts de test élevés pour des algorithmes similaires, et le coût de leur utilisation dans l'apprentissage par renforcement en ligne sera également relativement élevé.

De plus, nous pensons que permettre à la méthode de modélisation par génération de séquences d'être étendue en douceur à des tâches de dimensions plus élevées est également une contribution très importante de TAP. Dans le monde réel, la plupart des problèmes que nous espérons pouvoir résoudre par l’apprentissage par renforcement ont en réalité des dimensions d’état et d’action plus élevées. Par exemple, pour la conduite autonome, il est peu probable que les entrées des différents capteurs soient inférieures à 100, même après un prétraitement à différents niveaux de perception. La commande complexe d'un robot présente souvent également un espace d'action élevé. Les degrés de liberté de toutes les articulations humaines sont d'environ 240, ce qui correspond à un espace d'action d'au moins 240 dimensions. Un robot aussi flexible qu'un humain nécessite également une action de même dimension. espace.

Quatre ensembles de tâches aux dimensions progressivement croissantes

Changements dans la latence de décision et les performances relatives du modèle à mesure que les dimensions de la tâche augmentent

Présentation de la méthode

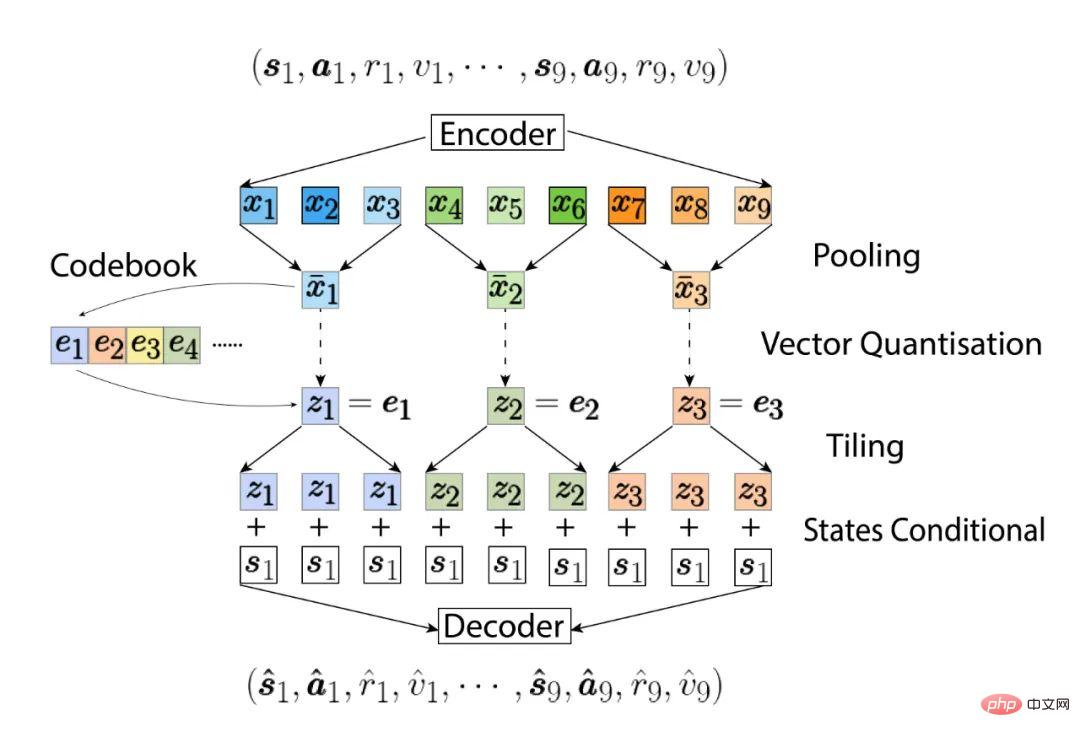

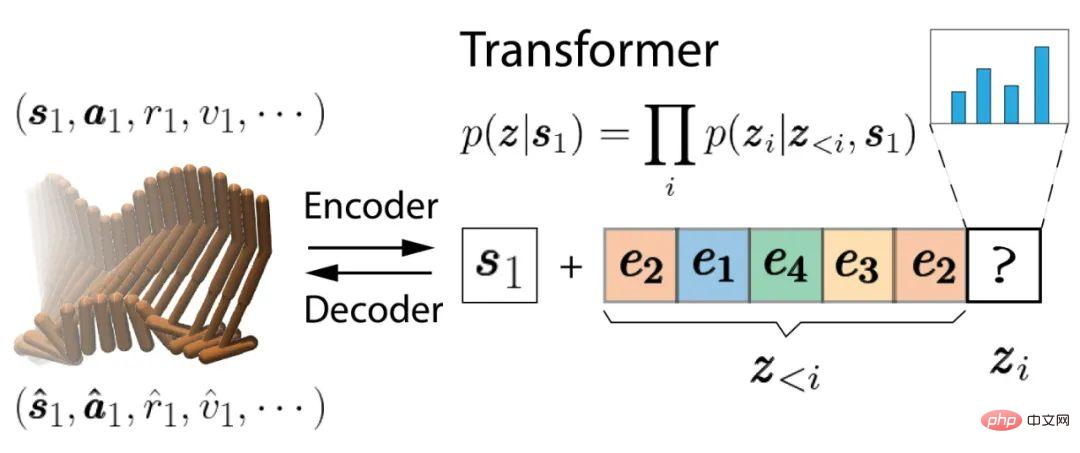

Tout d'abord, entraînez la partie auto-encodeurs du VQ-VAE, qui est la même que le VQ-VAE d'origine. Deux différents . La première différence est que l'encodeur et le décodeur sont tous deux basés sur Causal Transformer au lieu de CNN. La deuxième différence est que nous apprenons une distribution de probabilité conditionnelle et que les trajectoires possibles modélisées doivent partir de l'état actuel  . L'auto-encodeur apprend une cartographie bidirectionnelle entre les trajectoires à partir de l'état actuel

. L'auto-encodeur apprend une cartographie bidirectionnelle entre les trajectoires à partir de l'état actuel  et les codes latents. Ces codes latents sont classés par ordre chronologique comme la trajectoire originale, et chaque code latent sera mappé à la trajectoire réelle des

et les codes latents. Ces codes latents sont classés par ordre chronologique comme la trajectoire originale, et chaque code latent sera mappé à la trajectoire réelle des  étapes. Parce que nous utilisons Causal Transformer, les codes latents avec un classement temporel inférieur (tels que

étapes. Parce que nous utilisons Causal Transformer, les codes latents avec un classement temporel inférieur (tels que  ) ne transmettront pas d'informations aux séquences de rang supérieur (telles que

) ne transmettront pas d'informations aux séquences de rang supérieur (telles que  ), ce qui permet à TAP de transmettre les N premiers codes latents Décode partiellement une trajectoire de longueur NL, ce qui est très utile lors de son utilisation pour une planification ultérieure.

), ce qui permet à TAP de transmettre les N premiers codes latents Décode partiellement une trajectoire de longueur NL, ce qui est très utile lors de son utilisation pour une planification ultérieure.

Ensuite, nous utiliserons un autre transformateur de style GPT-2 pour modéliser la distribution de probabilité conditionnelle de ces codes latents  :

:

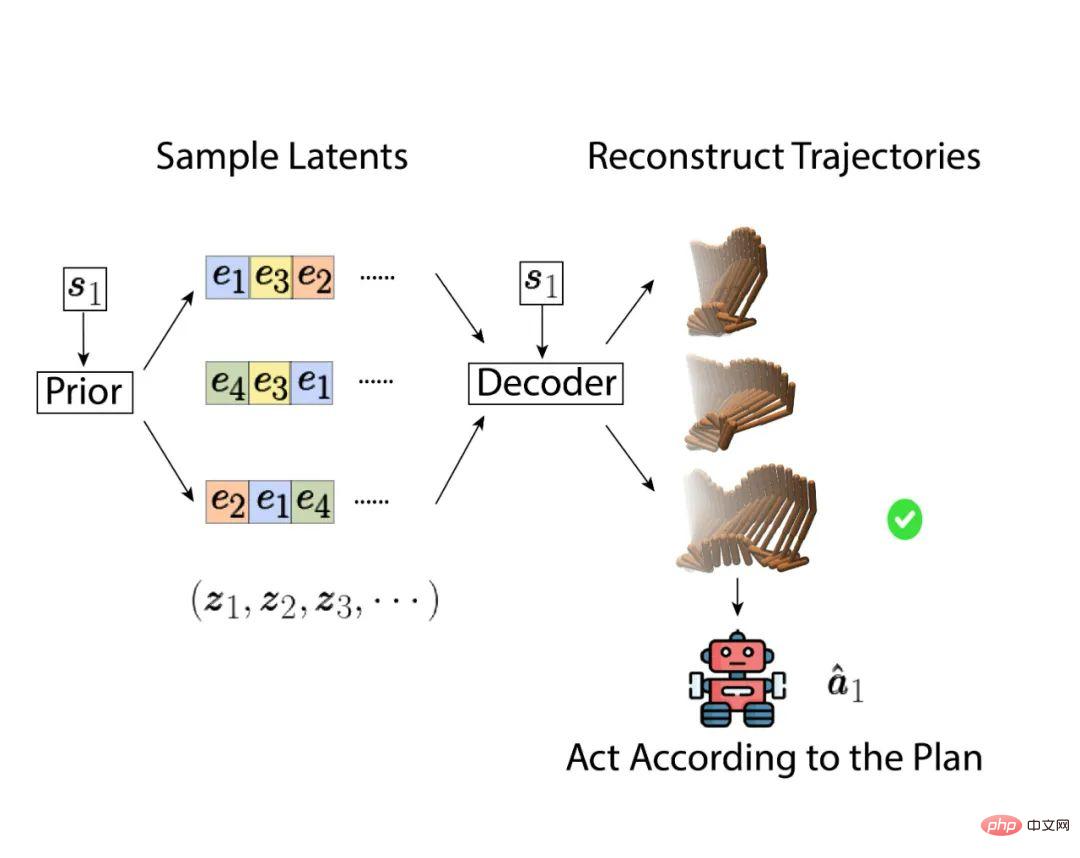

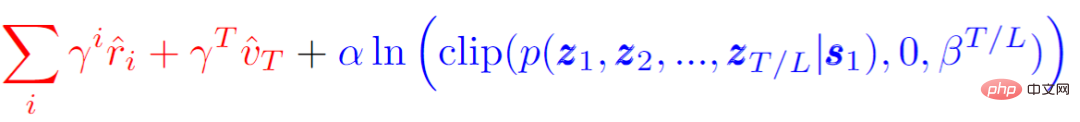

Lors de la prise de décisions, nous pouvons transmettre les variables latentes Optimisez dans l'espace pour trouver la meilleure trajectoire future, plutôt que d'optimiser dans l'espace d'action d'origine. Une méthode très simple mais efficace consiste à échantillonner directement à partir de la distribution de codage latent, puis à sélectionner la trajectoire la plus performante, comme indiqué ci-dessous :

Le score cible référencé lors de la sélection de la trajectoire optimale (score objectif) sera considérer à la fois le retour attendu de la trajectoire (récompense plus la valorisation de la dernière étape) et la faisabilité ou probabilité de la trajectoire elle-même. Comme la formule suivante, où  est un nombre bien supérieur au rendement le plus élevé. Lorsque la probabilité d'une trajectoire est supérieure à un seuil

est un nombre bien supérieur au rendement le plus élevé. Lorsque la probabilité d'une trajectoire est supérieure à un seuil  , le critère pour juger de cette trajectoire sera son rendement attendu (surligné en rouge). ), sinon cette La probabilité de la trajectoire elle-même sera la partie dominante (surlignée en bleu). Autrement dit, TAP sélectionnera celle ayant le rendement attendu le plus élevé parmi les trajectoires supérieures au seuil.

, le critère pour juger de cette trajectoire sera son rendement attendu (surligné en rouge). ), sinon cette La probabilité de la trajectoire elle-même sera la partie dominante (surlignée en bleu). Autrement dit, TAP sélectionnera celle ayant le rendement attendu le plus élevé parmi les trajectoires supérieures au seuil.

Bien que le nombre d'échantillons soit suffisamment grand, l'échantillonnage direct peut également être très efficace lorsque la séquence de prédiction est courte, sous réserve de limiter le nombre d'échantillons et le temps total requis pour la planification, l'utilisation d'un meilleur optimiseur apportera toujours de meilleurs résultats. résultats. Bonnes performances. Les deux animations suivantes montrent la différence entre les trajectoires générées par l'échantillonnage direct et la recherche de faisceau lors de la prévision de 144 pas dans le futur. Ces trajectoires sont triées selon le score cible final. Les trajectoires situées en haut de la couche supérieure ont des scores plus élevés, et les trajectoires empilées derrière elles ont des scores plus faibles. De plus, les trajectoires avec des scores faibles auront également une transparence moindre.

Sur l'image, nous pouvons voir que de nombreuses dynamiques des trajectoires générées par l'échantillonnage direct sont instables et ne sont pas conformes aux lois physiques. En particulier, les trajectoires plus légères en arrière-plan sont presque flottantes. Ce sont toutes des trajectoires avec une probabilité relativement faible et seront éliminées lors de la sélection du plan final. La trajectoire au premier rang semble plus dynamique, mais la performance correspondante est relativement mauvaise, et il semble qu'elle va baisser. En revanche, la recherche de faisceau prendra en compte dynamiquement la probabilité de la trajectoire lors de l'expansion de la prochaine variable cachée, de sorte que les branches avec une très faible probabilité seront terminées plus tôt, de sorte que les trajectoires candidates générées se concentreront sur les meilleures performances et possibilités. sont autour. E Échantillonnage direct des résultats expérimentaux d'aBeam Search

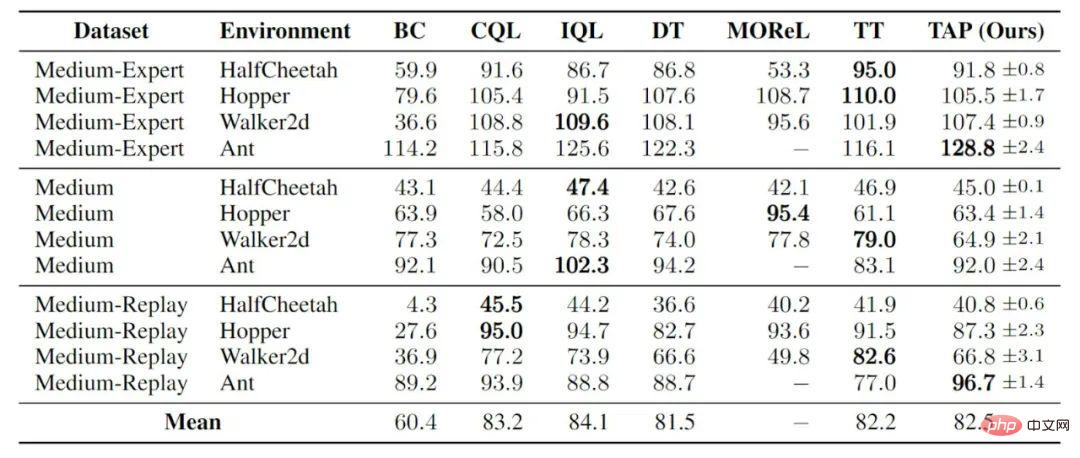

sans évaluation de niveau supérieur ni amélioration stratégique, s'appuyant uniquement sur les avantages de la précision prédictive, sur des tâches de faible dimension, TAP a atteint des performances comparables à d'autres apprentissages par renforcement hors ligne :

contrôle de la locomotion dans une salle de sport

Sur les tâches de grande dimension, TAP a réalisé bien plus que les autres méthodes basées sur les performances des méthodes basées sur un modèle surpasse également les méthodes courantes sans modèle. Il y a en fait deux questions ouvertes auxquelles on n’a pas encore répondu. La première est la raison pour laquelle les méthodes précédentes basées sur un modèle ont donné de mauvais résultats dans ces tâches d'apprentissage par renforcement hors ligne de grande dimension, et la seconde est la raison pour laquelle TAP peut surpasser de nombreuses méthodes sans modèle sur ces tâches. L’une de nos hypothèses est qu’il est très difficile d’optimiser une politique sur un problème de grande dimension tout en prenant en compte le fait d’éviter que la politique ne s’écarte trop de la politique comportementale. Lorsqu’un modèle est appris, des erreurs dans le modèle lui-même peuvent amplifier cette difficulté. TAP déplace l'espace d'optimisation vers un petit espace variable caché discret, ce qui rend l'ensemble du processus d'optimisation plus robuste.

Contrôle manuel robotique adroit

Contrôle manuel robotique adroit

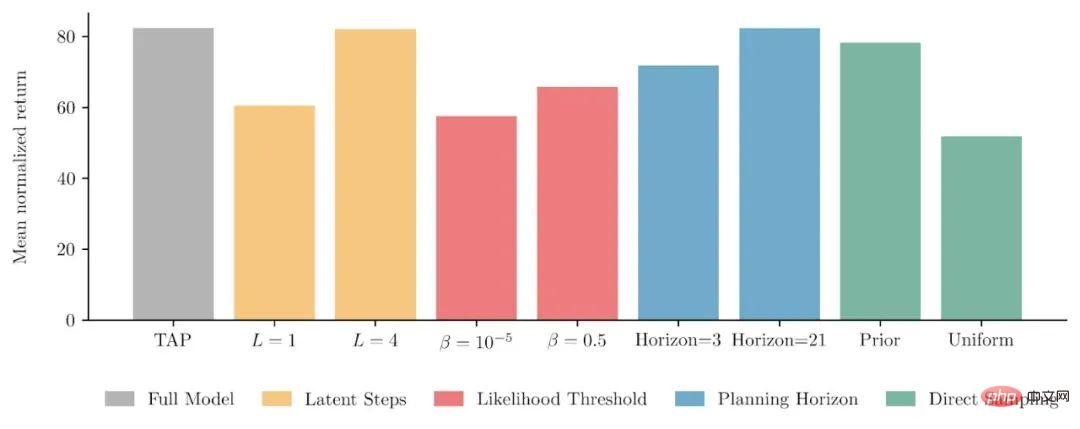

Quelques études de tranches

Pour de nombreuses conceptions dans TAP, nous avons également réalisé une série d'études de tranches sur la tâche de contrôle de la locomotion en salle de sport. Le premier est le nombre d'étapes de la trajectoire auxquelles correspond réellement chaque code latent (histogramme jaune). Les faits ont prouvé que laisser une variable latente correspondre à une transition d'état en plusieurs étapes présente non seulement des avantages informatiques, mais améliore également le modèle final. performance. En ajustant le seuil qui déclenche des pénalités de trajectoire de faible probabilité dans la fonction objectif de recherche(histogramme rouge), nous avons également confirmé que les deux parties de la fonction objectif sont effectivement utiles aux performances finales du modèle. Un autre point est que le nombre d'étapes planifiées dans le futur (horizon de planification, histogramme bleu) a peu d'impact sur les performances du modèle dans la recherche post-déploiement, même si une seule variable cachée est développée, les performances de l'agent final ne seront que réduites. de 10 % environ.

Enfin nous avons testé les performances du TAP sous échantillonnage direct (histogramme vert). Notez que le nombre d'échantillons échantillonnés ici est de 2 048, alors que le nombre dans l'animation ci-dessus n'est que de 256, et que l'animation ci-dessus génère un plan pour les 144 prochaines étapes, mais en fait notre modèle de base dirige la planification de 15 étapes. La conclusion est que l'échantillonnage direct peut atteindre des performances similaires à celles de la recherche par faisceau lorsque le nombre d'échantillons est suffisant et que le trajet prévu n'est pas long. Mais il s’agit d’un cas d’échantillonnage à partir de la distribution conditionnelle apprise des variables latentes. Si nous échantillonnons directement avec une probabilité égale à partir du codage latent, ce sera finalement bien pire que le modèle TAP complet.

Résultats de l'étude des tranches

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

Implémentation d'algorithmes d'apprentissage automatique en C++ : défis et solutions courants

Jun 03, 2024 pm 01:25 PM

Implémentation d'algorithmes d'apprentissage automatique en C++ : défis et solutions courants

Jun 03, 2024 pm 01:25 PM

Les défis courants rencontrés par les algorithmes d'apprentissage automatique en C++ incluent la gestion de la mémoire, le multithread, l'optimisation des performances et la maintenabilité. Les solutions incluent l'utilisation de pointeurs intelligents, de bibliothèques de threads modernes, d'instructions SIMD et de bibliothèques tierces, ainsi que le respect des directives de style de codage et l'utilisation d'outils d'automatisation. Des cas pratiques montrent comment utiliser la bibliothèque Eigen pour implémenter des algorithmes de régression linéaire, gérer efficacement la mémoire et utiliser des opérations matricielles hautes performances.

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

La détection de cibles est un problème relativement mature dans les systèmes de conduite autonome, parmi lesquels la détection des piétons est l'un des premiers algorithmes à être déployés. Des recherches très complètes ont été menées dans la plupart des articles. Cependant, la perception de la distance à l’aide de caméras fisheye pour une vue panoramique est relativement moins étudiée. En raison de la distorsion radiale importante, la représentation standard du cadre de délimitation est difficile à mettre en œuvre dans les caméras fisheye. Pour alléger la description ci-dessus, nous explorons les conceptions étendues de boîtes englobantes, d'ellipses et de polygones généraux dans des représentations polaires/angulaires et définissons une métrique de segmentation d'instance mIOU pour analyser ces représentations. Le modèle fisheyeDetNet proposé avec une forme polygonale surpasse les autres modèles et atteint simultanément 49,5 % de mAP sur l'ensemble de données de la caméra fisheye Valeo pour la conduite autonome.

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles

Une seule carte exécute Llama 70B plus rapidement que deux cartes, Microsoft vient de mettre le FP6 dans l'Open source A100 |

Apr 29, 2024 pm 04:55 PM

Une seule carte exécute Llama 70B plus rapidement que deux cartes, Microsoft vient de mettre le FP6 dans l'Open source A100 |

Apr 29, 2024 pm 04:55 PM

Le FP8 et la précision de quantification inférieure en virgule flottante ne sont plus le « brevet » du H100 ! Lao Huang voulait que tout le monde utilise INT8/INT4, et l'équipe Microsoft DeepSpeed a commencé à exécuter FP6 sur A100 sans le soutien officiel de NVIDIA. Les résultats des tests montrent que la quantification FP6 de la nouvelle méthode TC-FPx sur A100 est proche ou parfois plus rapide que celle de INT4, et a une précision supérieure à celle de cette dernière. En plus de cela, il existe également une prise en charge de bout en bout des grands modèles, qui ont été open source et intégrés dans des cadres d'inférence d'apprentissage profond tels que DeepSpeed. Ce résultat a également un effet immédiat sur l'accélération des grands modèles : dans ce cadre, en utilisant une seule carte pour exécuter Llama, le débit est 2,65 fois supérieur à celui des cartes doubles. un

Les dernières nouvelles de l'Université d'Oxford ! Mickey : correspondance d'images 2D en 3D SOTA ! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Les dernières nouvelles de l'Université d'Oxford ! Mickey : correspondance d'images 2D en 3D SOTA ! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Lien du projet écrit devant : https://nianticlabs.github.io/mickey/ Étant donné deux images, la pose de la caméra entre elles peut être estimée en établissant la correspondance entre les images. En règle générale, ces correspondances sont 2D à 2D et nos poses estimées sont à échelle indéterminée. Certaines applications, telles que la réalité augmentée instantanée, à tout moment et en tout lieu, nécessitent une estimation de pose des métriques d'échelle, elles s'appuient donc sur des estimateurs de profondeur externes pour récupérer l'échelle. Cet article propose MicKey, un processus de correspondance de points clés capable de prédire les correspondances métriques dans l'espace d'une caméra 3D. En apprenant la correspondance des coordonnées 3D entre les images, nous sommes en mesure de déduire des métriques relatives.