Périphériques technologiques

Périphériques technologiques

IA

IA

Jusqu'où Transformer a-t-il évolué en matière d'apprentissage par renforcement ? L'Université Tsinghua, l'Université de Pékin et d'autres ont publié conjointement une revue de TransformRL

Jusqu'où Transformer a-t-il évolué en matière d'apprentissage par renforcement ? L'Université Tsinghua, l'Université de Pékin et d'autres ont publié conjointement une revue de TransformRL

Jusqu'où Transformer a-t-il évolué en matière d'apprentissage par renforcement ? L'Université Tsinghua, l'Université de Pékin et d'autres ont publié conjointement une revue de TransformRL

L'apprentissage par renforcement (RL) fournit une forme mathématique pour la prise de décision séquentielle, et l'apprentissage par renforcement profond (DRL) a également fait de grands progrès ces dernières années. Cependant, les problèmes d’efficacité des échantillons entravent l’application généralisée des méthodes d’apprentissage par renforcement profond dans le monde réel. Pour résoudre ce problème, un mécanisme efficace consiste à introduire un biais inductif dans le cadre DRL.

Dans l'apprentissage par renforcement profond, les approximateurs de fonctions sont très importants. Cependant, par rapport à la conception architecturale en apprentissage supervisé (SL), les problématiques de conception architecturale en DRL sont encore rarement étudiées. La plupart des travaux existants sur les architectures RL ont été menés par la communauté d'apprentissage supervisé/semi-supervisé. Par exemple, lors du traitement d'entrées basées sur des images de grande dimension dans DRL, une approche courante consiste à introduire des réseaux de neurones convolutifs (CNN) [LeCun et al., 1998 ; Mnih et al., 2015] pour traiter l'observabilité partielle (partielle). observabilité) Une approche courante des images consiste à introduire des réseaux de neurones récurrents (RNN) [Hochreiter et Schmidhuber, 1997 ; Hausknecht et Stone, 2015].

Ces dernières années, l'architecture Transformer [Vaswani et al., 2017] a montré de meilleures performances que CNN et RNN, et est devenue un paradigme d'apprentissage dans de plus en plus de tâches SL [Devlin et al., 2018 ; et al., 2020 ; Dong et al., 2018]. L'architecture Transformer prend en charge la modélisation des dépendances à longue portée et présente une excellente évolutivité [Khan et al., 2022]. Inspiré par le succès de SL, l'application de Transformer à l'apprentissage par renforcement a suscité un vif intérêt, dans l'espoir d'appliquer les avantages de Transformer au domaine de RL. L'utilisation de

Transformer dans RL remonte à une étude réalisée en 2018 par Zambaldi et al., dans laquelle le mécanisme d'auto-attention a été utilisé pour le raisonnement relationnel de représentations d'état structurées. Par la suite, de nombreux chercheurs ont cherché à appliquer l’auto-attention à l’apprentissage de la représentation afin d’extraire les relations entre les entités pour un meilleur apprentissage politique [Vinyals et al., 2019 ; Baker et al., 2019].

En plus d'utiliser Transformer pour l'apprentissage des représentations, des travaux antérieurs ont également utilisé Transformer pour capturer des dépendances multitemporelles afin de traiter des problèmes d'observabilité partielle [Parisotto et al., 2020 Parisotto et Salakhutdinov, 2021]. Offline RL [Levine et al., 2020] a attiré l'attention pour sa capacité à utiliser des ensembles de données hors ligne à grande échelle. Inspirée par le RL hors ligne, des recherches récentes montrent que la structure Transformer peut être directement utilisée comme modèle de prise de décision séquentielle [Chen et al., 2021 ; Janner et al., 2021] et généralisée à plusieurs tâches et domaines [Lee et al. ., 2022 ; Carroll et coll., 2022].

En fait, l'utilisation de Transformer comme approximateur de fonctions dans l'apprentissage par renforcement se heurte à des défis particuliers, notamment :

- Les données de formation d'un agent d'apprentissage par renforcement sont généralement fonction de la politique actuelle, qui est fonction de la politique actuelle pendant l'apprentissage de Transformer conduira à la non-stationnarité

- Les algorithmes RL existants sont généralement très sensibles aux choix de conception au cours du processus de formation, y compris l'architecture et la capacité du modèle [Henderson et al., 2018] ; Les architectures basées sur des transformateurs sont souvent soumises à des coûts de calcul et de mémoire haute performance, ce qui rend la formation et l'inférence dans le processus d'apprentissage RL coûteuses.

- Par exemple, dans l'IA pour les jeux vidéo, l'efficacité de la génération d'échantillons (qui affecte dans une large mesure les performances de la formation) dépend du coût de calcul du réseau de politiques RL et du réseau de valeurs [Ye et al., 2020a ; Berner et coll., 2019].

Afin de mieux promouvoir le développement du domaine de l'apprentissage par renforcement, des chercheurs de l'Université Tsinghua, de l'Université de Pékin, de l'Institut de recherche sur l'intelligence artificielle Zhiyuan et de Tencent ont publié conjointement un article de synthèse sur Transformer (c'est-à-dire TransformRL) dans l'apprentissage par renforcement, résume le Les méthodes et défis existants actuels, et discute des orientations de développement futures. L'auteur estime que TransformRL jouera un rôle important dans la stimulation du potentiel de l'apprentissage par renforcement.

- Le chapitre 2 présente les connaissances de base de RL et de Transformer, puis présente brièvement comment les deux sont combinés.

- Le chapitre 3 décrit l'évolution de l'architecture réseau dans RL et le développement à long terme des défis RL qui entravent ; exploration généralisée de l'architecture Transformer ;

- Chapitre 4 L'auteur de l'article classe les Transformers dans RL et discute des méthodes représentatives actuelles ;

- Le chapitre 5 résume et souligne les orientations futures potentielles de la recherche ;

Le contenu principal commence à partir du chapitre 3 de l'article. Jetons un coup d'œil au contenu principal de l'article.

Architecture de réseau dans RL

Avant d'introduire la méthode de classification de TransformRL, l'article passe en revue les premiers progrès de la conception de l'architecture de réseau dans RL et résume ses défis existants. L'auteur estime que Transformer est une architecture de réseau neuronal avancée qui contribuera au développement de l'apprentissage par renforcement profond (DRL).

Architecture de l'approximateur de fonctions

Depuis les travaux pionniers de Deep Q-Network [Mnih et al., 2015], de nombreux efforts ont été réalisés sur l'architecture réseau des agents DRL. Les améliorations de l'architecture de réseau dans l'apprentissage par renforcement sont principalement divisées en deux catégories.

Un type consiste à concevoir de nouvelles structures et à combiner les biais inductifs RL pour réduire la difficulté des stratégies de formation ou des fonctions de valeur. Par exemple [Wang et al. 2016] ont proposé une architecture de réseau en duel, dans laquelle un réseau est utilisé pour la fonction de valeur d'état et l'autre pour la fonction d'avantage d'action liée à l'état. Cette conception architecturale combine un biais inductif.

L'autre catégorie consiste à étudier si les techniques de réseaux neuronaux couramment utilisées (telles que la régularisation, le saut de connexion, la normalisation par lots) peuvent être appliquées au RL. Par exemple, [Ota et al. 2020] ont constaté que l'augmentation de la dimension d'entrée tout en utilisant un extracteur de fonctionnalités en ligne pour améliorer la représentation de l'état peut contribuer à améliorer les performances et l'efficacité des échantillons des algorithmes DRL. [Sinha et al.2020] ont proposé une architecture profondément dense pour les agents DRL qui utilise des connexions résiduelles pour un apprentissage efficace et des biais inductifs pour atténuer le problème d'inégalité dans le traitement des données. [Ota et al. 2021] utilisent DenseNet [Huang et al., 2017] et l'apprentissage de représentation découplée pour améliorer le flux d'informations et les gradients dans les grands réseaux. Récemment, en raison des performances supérieures de Transformer, les chercheurs ont tenté d'appliquer l'architecture Transformer aux algorithmes d'optimisation des politiques, mais ont découvert que les conceptions Transformer ordinaires ne peuvent pas atteindre des performances idéales dans les tâches RL [Parisotto et al., 2020].

Défis

Bien que les architectures basées sur Transformer aient fait beaucoup de progrès dans le domaine du SL au cours des dernières années, appliquer Transformer à RL n'est pas simple. En fait, il existe plusieurs défis uniques.

Du point de vue du RL, de nombreuses études ont souligné que les algorithmes RL existants sont très sensibles à l'architecture des réseaux de neurones profonds [Henderson et al., 2018 ; . Premièrement, l’alternance paradigmatique entre la collecte de données et l’optimisation des politiques en RL conduit à une instabilité dans la formation. Deuxièmement, les algorithmes RL sont souvent très sensibles aux choix de conception effectués lors de la formation. [Emmons et al. 2021] démontrent qu'un choix judicieux de l'architecture et de la régularisation du modèle est essentiel à la performance des agents DRL.

Du point de vue de Transformer, les architectures basées sur Transformer souffrent d'une empreinte mémoire importante et d'une latence élevée, ce qui entrave leur déploiement et leur inférence efficaces. Récemment, de nombreuses recherches ont été menées sur l'amélioration de l'efficacité du calcul et de la mémoire de l'architecture originale du Transformer, mais la plupart de ces travaux se sont concentrés sur le domaine SL.

Dans le domaine du RL, Parisotto et Salakhutdinov ont proposé de transformer le modèle d'apprenant basé sur Transformer de grande capacité en un modèle d'acteur de petite capacité pour éviter la latence d'inférence élevée de Transformer. Cependant, cette approche reste coûteuse en termes de mémoire et de calcul. Actuellement, les transformateurs efficaces ou légers n'ont pas été entièrement explorés par la communauté RL.

Transformer in Reinforcement Learning

Bien que Transformer soit devenu le modèle de base pour la plupart des recherches sur l'apprentissage supervisé, il n'a pas été largement utilisé dans la communauté RL depuis longtemps en raison des défis susmentionnés. En fait, la plupart des premières tentatives de TransformRL utilisaient Transformer pour l'apprentissage de la représentation d'état ou pour fournir des informations sur la mémoire, tout en utilisant des algorithmes RL standard pour l'apprentissage des agents, tels que l'apprentissage des différences temporelles et l'optimisation des politiques.

Par conséquent, malgré l'introduction de Transformer comme approximateur de fonctions, ces méthodes sont toujours remises en question par les frameworks RL traditionnels. Jusqu'à récemment, le RL hors ligne permettait d'apprendre des politiques optimales à partir de données hors ligne à grande échelle. Inspirés du RL hors ligne, des travaux récents traitent en outre le problème RL comme un problème de modélisation de séquence conditionnelle avec une expérience fixe. Cela permet de contourner le problème des erreurs d'amorçage dans le RL traditionnel, permettant à l'architecture Transformer de libérer ses puissantes capacités de modélisation séquentielle.

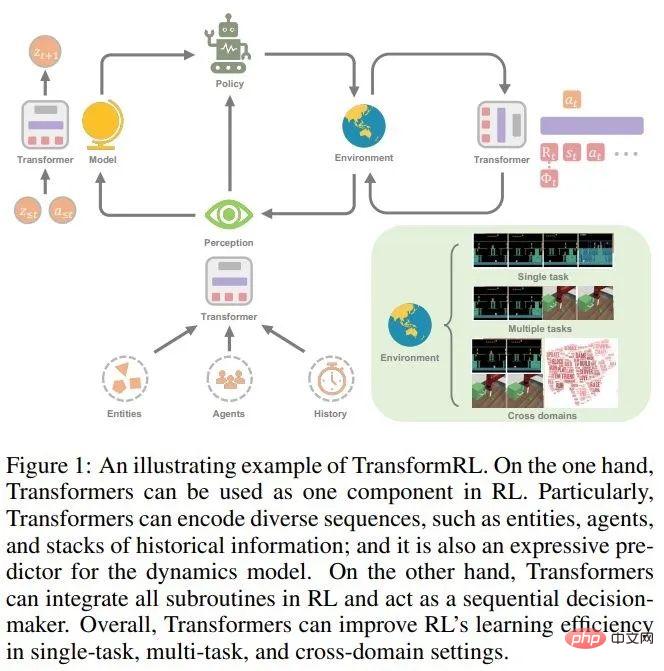

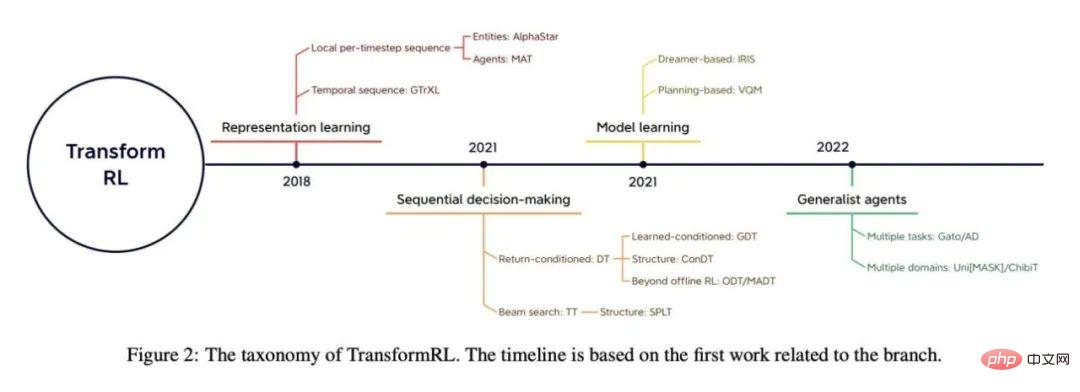

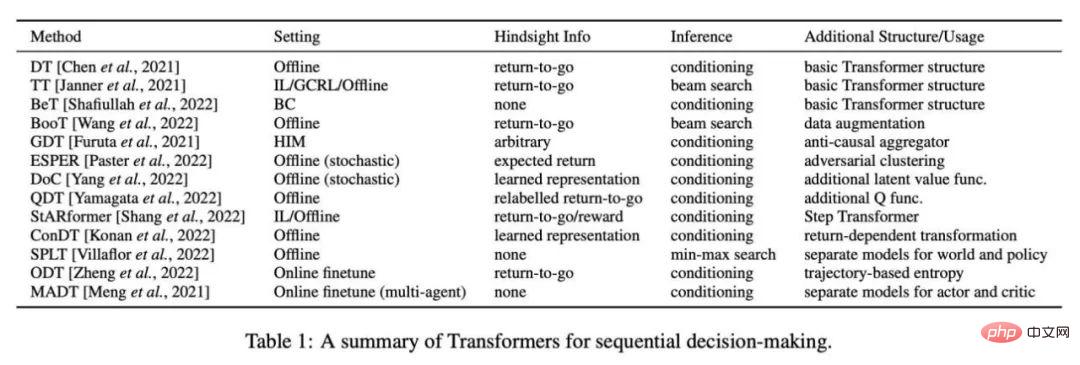

L'article passe en revue les progrès de TransformRL et présente les méthodes existantes par classification. Les auteurs classent les méthodes existantes en quatre catégories : l'apprentissage des représentations, l'apprentissage des modèles, la prise de décision séquentielle et les agents à usage général. La figure 2 montre un aperçu des classifications pertinentes.

Transformer pour l'apprentissage des représentations

Compte tenu de la nature séquentielle des tâches RL, il est raisonnable d'utiliser le module encodeur Transformer. En fait, diverses séquences dans les tâches RL doivent être traitées, telles que des séquences locales par pas de temps (séquences multi-entités [Vinyals et al., 2019 ; Baker et al., 2019], séquences multi-agents [Wen et al. , 2022]), séries chronologiques ([Parisotto et al., 2020 ; Banino et al., 2021]), etc.

Encodeur pour les séquences locales par pas de temps

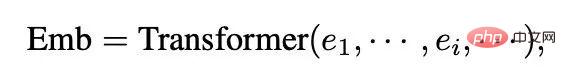

Le succès précoce significatif de cette approche s'est reflété dans l'utilisation de Transformers pour gérer les informations complexes d'un nombre variable d'entités observées par l'agent. [Zambaldi et al., 2018a] ont d'abord proposé d'utiliser l'attention des produits scalaires multi-têtes pour capturer le raisonnement relationnel d'observations structurées, puis AlphaStar [Vinyals et al., 2019] l'a implémenté dans un environnement multi-agents difficile (StarCraft II). observations multi-entités. Dans ce mécanisme appelé Transformateur d'entité, les observations sont codées sous la forme suivante :

où e_i représente l'observation de l'entité i par l'agent, soit découpée directement de l'observation entière, soit donnée par le tokenizer d'entité.

Certains travaux de suivi enrichissent le mécanisme Transformateur d'entité. [Hu et al. 2020] ont proposé une stratégie de découplage compatible pour associer explicitement les actions à diverses entités et tirer parti d'un mécanisme d'attention pour l'interprétation des politiques. Pour réaliser une imitation visuelle unique et stimulante, Dasari et Gupta [2021] utilisent Transformer pour apprendre des représentations qui se concentrent sur des éléments de tâche spécifiques.

Semblable aux entités dispersées dans les observations, certaines études utilisent des transformateurs pour traiter d'autres séquences locales par pas de temps. Tang et Ha [2021] exploitent le mécanisme d'attention de Transformer pour traiter des séquences perceptuelles et construire une stratégie d'entrée invariante par permutation. Dans le RL multitâche incompatible, [Kurin et al., 2020] ont proposé d'utiliser Transformer pour extraire les connaissances du domaine morphologique.

Timing Encoder

En même temps, il est également raisonnable d'utiliser Transformer pour traiter les séquences de synchronisation. Un encodeur temporel est utilisé comme architecture de stockage,

où o_t représente l'observation de l'agent au temps t et Emb_0:t représente l'intégration des observations historiques de l'observation initiale à l'observation actuelle.

Dans des travaux antérieurs, [Mishra et al. 2018] n'étaient pas en mesure de traiter des séquences temporelles à l'aide d'un transformateur vanille et ont constaté qu'il fonctionnait encore moins bien qu'une politique aléatoire sur certaines tâches spécifiques. Gated Transformer-XL (GTrXL) [Parisotto et al., 2020] est la première solution efficace à utiliser Transformer comme architecture de stockage pour traiter les trajectoires. GTrXL modifie l'architecture Transformer-XL [Dai et al., 2019] via la réorganisation de la carte d'identité pour fournir un chemin de « saut » de l'entrée séquentielle à la sortie du Transformer, ce qui peut aider à former un processus de formation stable dès le début. [Loynd et al. 2020] ont proposé un mécanisme de raccourci de vecteur mémoire pour les dépendances à long terme, et [Irie et al. 2021] ont combiné un transformateur linéaire avec un programmeur de poids rapide pour de meilleures performances. [Melo 2022] a proposé d'utiliser un mécanisme d'auto-attention pour simuler la récupération du stockage pour le méta-RL basé sur le stockage.

Bien que Transformer fonctionne mieux que LSTM/RNN à mesure que le stockage augmente et que la taille des paramètres augmente, il n'est pas efficace en matière de données sur RL. Des travaux ultérieurs exploitent certaines tâches auxiliaires auto-supervisées pour faciliter l'apprentissage [Banino et al., 2021] ou utilisent des architectures Transformer pré-entraînées comme encodeurs temporels [Li et al., 2022 ;

Transformer pour l'apprentissage de modèles

En plus d'utiliser Transformer comme encodeur pour l'intégration de séquences, l'architecture Transformer sert également d'épine dorsale du modèle d'environnement dans les algorithmes basés sur des modèles. Contrairement aux prédictions conditionnées par des observations et des actions en une seule étape, les Transformers permettent aux modèles d'environnement de prédire des transitions conditionnées par une certaine quantité d'informations historiques.

En fait, le succès de Dreamer et de ses algorithmes ultérieurs [Hafner et al., 2020, 2021 ; Seo et al., 2022] a été démontré dans certains environnements ou tâches partiellement observables qui nécessitent des mécanismes de mémoire basés sur l'histoire. Avantages du modèle du monde de l'information. Un modèle mondial conditionné sur des informations historiques se compose d'un encodeur d'observation qui capture des informations abstraites et d'un modèle de transformation qui apprend les transformations dans l'espace latent.

Des études ont été réalisées utilisant l'architecture Transformer au lieu de RNN pour créer des modèles du monde basés sur l'histoire. [Chen et al. 2022] Remplacez le modèle RSSM (Recurrent State-Space Model) basé sur RNN dans Dreamer par le modèle TSSM (Transformer State-Space Model) basé sur Transformer. IRIS (Imagination with autoRegression over an Inner Speech) [Micheli et al., 2022] apprend un modèle mondial basé sur Transformer grâce à l'apprentissage autorégressif de l'expérience de déploiement sans équilibrage KL comme Dreamer, et est implémenté dans Atari [Bellemare et al., 2013] et obtenu de bons résultats.

De plus, il existe également des études qui tentent d'utiliser des modèles mondiaux basés sur Transformer pour la planification. [Ozair et al. 2021] ont vérifié l'efficacité de la planification à l'aide du modèle de transformation Transformer pour effectuer des tâches stochastiques. [Sun et al. 2022] ont proposé un modèle de transformation Transformer conditionné par la cible, qui est efficace dans la planification visuelle des tâches procédurales.

RNN et Transformer conviennent tous deux à l'apprentissage de modèles du monde basés sur des informations historiques. Cependant, [Micheli et al. 2022] ont constaté que l'architecture Transformer est un modèle mondial plus efficace en matière de données que Dreamer. Les résultats expérimentaux sur TSSM montrent que l'architecture Transformer fonctionne bien dans les tâches nécessitant une mémoire à long terme.

Transformer pour la prise de décision séquentielle

En plus d'être intégré aux algorithmes RL traditionnels en tant qu'architecture haute performance, Transformer peut également être directement utilisé comme modèle de prise de décision séquentielle. En effet, RL peut être considéré comme un problème de modélisation de séquences conditionnelles : générer des séquences d'actions qui génèrent des récompenses élevées.

Compte tenu de l'excellente précision de Transformer dans la prédiction de séquence, Bootstrapped Transformer (BooT) [Wang et al., 2022] propose de générer des données via bootstrap Transformer tout en optimisant les données pour une prise de décision séquentielle. L'amorçage de Transformer pour l'augmentation des données peut augmenter le nombre et la couverture des ensembles de données hors ligne, améliorant ainsi les performances. Plus précisément, BooT compare différents schémas de génération de données et schémas d'amorçage pour analyser comment BooT facilite l'apprentissage des politiques. Les résultats montrent qu'il peut générer des données cohérentes avec le MDP sous-jacent sans contraintes supplémentaires.

Transformateur pour agents universels

Decision Transformer a joué un rôle énorme dans diverses tâches sur les données hors ligne. Certains chercheurs ont commencé à se demander si Transformer pouvait permettre aux agents à usage général de résoudre plusieurs tâches ou problèmes différents, comme dans les domaines du CV et de la PNL.

Généraliser à plusieurs tâches

Certains chercheurs s'appuient sur l'idée de pré-entraîner des ensembles de données à grande échelle en CV et en PNL, et tentent de faire abstraction de la généralisation du multitâche à grande échelle Stratégie d’ensembles de données. Multi-Game Decision Transformer (MGDT) [Lee et al., 2022] est une variante de DT qui apprend le DT sur un ensemble de données diversifié composé de données expertes et non expertes, et utilise un ensemble de paramètres pour atteindre des performances quasi humaines sur Jeux Atari. Afin d'obtenir des performances de niveau expert sur des ensembles de données de niveau non expert, MGDT a conçu un mécanisme de raisonnement d'action expert pour calculer la distribution postérieure de retour au niveau expert à partir de la distribution antérieure de retour et la calculer en fonction. à la formule bayésienne Probabilité de retour à l'état expert par défaut.

De même, Switch Trajectory Transformer (SwitchTT) [Lin et al., 2022] est une extension multitâche de TT, utilisant un modèle d'activation clairsemé pour remplacer la couche FFN par une couche experte hybride afin d'obtenir un multitâche efficace. apprentissage hors ligne. De plus, SwitchTT utilise un estimateur de valeur de trajectoire distribuée pour modéliser l'incertitude des estimations de valeur. S'appuyant sur ces deux améliorations, SwitchTT est bien amélioré par rapport à TT en termes de performances et de vitesse d'entraînement. MGDT et SwitchTT exploitent l'expérience acquise à partir de plusieurs tâches et de diverses politiques de niveau de performance pour apprendre une politique générale. Cependant, la création d’ensembles de données multitâches à grande échelle n’est pas une mince affaire.

Contrairement aux ensembles de données à grande échelle dans CV et NLP, qui utilisent généralement des données massives provenant d'Internet et un simple étiquetage manuel, les données de prise de décision séquentielle dans RL manquent toujours d'informations sur les actions et ne sont pas faciles à étiqueter. Par conséquent, [Baker et al. 2022] ont proposé un schéma semi-supervisé pour apprendre un modèle dynamique inverse (IDM) basé sur un transformateur utilisant des données en ligne à grande échelle sans informations d'action. Le modèle exploite les observations passées et futures pour prédire les informations sur les actions et est capable d'étiqueter de grandes quantités de données vidéo en ligne. IDM est appris sur un petit ensemble de données contenant des actions étiquetées manuellement et est suffisamment précis.

De nombreux travaux existants en PNL ont prouvé l'efficacité de l'invite pour s'adapter à de nouvelles tâches, et certains travaux utilisent une technologie d'invite basée sur les méthodes DT pour parvenir à une adaptation rapide. Le transformateur de décision basé sur des invites (Prompt-DT) [Xu et al., 2022] échantillonne une série de transformations sous forme d'invites à partir d'un ensemble de données de démonstration en quelques tirs et généralise la stratégie en quelques tirs aux tâches méta-RL hors ligne. [Reed et al. 2022] exploitent davantage l'architecture basée sur les invites pour apprendre un agent général (Gato) grâce à une modélisation de séquences autorégressives sur des ensembles de données à très grande échelle couvrant le langage naturel, les images, la prise de décision temporelle et les données multimodales. Gato est capable d'effectuer une gamme de tâches dans différents domaines, notamment la génération de texte et la prise de décision.

[Laskin et al. 2022] ont proposé la distillation algorithmique (AD) pour entraîner Transformer sur une séquence inter-épisodes de processus d'apprentissage d'algorithme RL à tâche unique. Par conséquent, même dans de nouvelles tâches, le Transformer peut apprendre à améliorer progressivement sa politique au cours du processus de génération autorégressive.

Généraliser à un plus large éventail de domaines

En plus de généraliser à plusieurs tâches, Transformer est également un puissant modèle « général » qui peut être utilisé dans une gamme de domaines liés à la décision séquentielle. fabrication. Inspiré par la technologie de modélisation du langage masqué [Devlin et al., 2018] en PNL, [Carroll et al. 2022] a proposé Uni [MASK], qui unifie divers domaines de recherche couramment utilisés dans des problèmes de raisonnement par masque, notamment le clonage comportemental, le RL hors ligne, le GCRL. , raisonnement passé/futur et prédiction dynamique. Uni [MASK] compare différents schémas de masques, notamment des masques spécifiques à une tâche, des masques aléatoires et des variantes affinées. Les résultats montrent qu'un seul Transformer entraîné avec un masque aléatoire peut résoudre des tâches d'inférence arbitraires.

De plus, [Reid et al. 2022] ont constaté qu'il est bénéfique d'affiner DT à l'aide de Transformers pré-entraînés sur des ensembles de données linguistiques ou des ensembles de données multimodaux contenant des modalités linguistiques. Cela montre que même les connaissances des domaines non RL peuvent être utilisées pour la formation RL via des transformateurs.

Les lecteurs intéressés peuvent lire le texte original de l'article pour en savoir plus sur les détails de la recherche.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Il existe de nombreuses raisons pour lesquelles la startup MySQL échoue, et elle peut être diagnostiquée en vérifiant le journal des erreurs. Les causes courantes incluent les conflits de port (vérifier l'occupation du port et la configuration de modification), les problèmes d'autorisation (vérifier le service exécutant les autorisations des utilisateurs), les erreurs de fichier de configuration (vérifier les paramètres des paramètres), la corruption du répertoire de données (restaurer les données ou reconstruire l'espace de la table), les problèmes d'espace de la table InNODB (vérifier les fichiers IBDATA1), la défaillance du chargement du plug-in (vérification du journal des erreurs). Lors de la résolution de problèmes, vous devez les analyser en fonction du journal d'erreur, trouver la cause profonde du problème et développer l'habitude de sauvegarder régulièrement les données pour prévenir et résoudre des problèmes.

Comprendre les propriétés acides: les piliers d'une base de données fiable

Apr 08, 2025 pm 06:33 PM

Comprendre les propriétés acides: les piliers d'une base de données fiable

Apr 08, 2025 pm 06:33 PM

Une explication détaillée des attributs d'acide de base de données Les attributs acides sont un ensemble de règles pour garantir la fiabilité et la cohérence des transactions de base de données. Ils définissent comment les systèmes de bases de données gérent les transactions et garantissent l'intégrité et la précision des données même en cas de plantages système, d'interruptions d'alimentation ou de plusieurs utilisateurs d'accès simultanément. Présentation de l'attribut acide Atomicité: une transaction est considérée comme une unité indivisible. Toute pièce échoue, la transaction entière est reculée et la base de données ne conserve aucune modification. Par exemple, si un transfert bancaire est déduit d'un compte mais pas augmenté à un autre, toute l'opération est révoquée. BeginTransaction; UpdateAccountSsetBalance = Balance-100Wh

Mysql peut-il renvoyer JSON

Apr 08, 2025 pm 03:09 PM

Mysql peut-il renvoyer JSON

Apr 08, 2025 pm 03:09 PM

MySQL peut renvoyer les données JSON. La fonction JSON_Extract extrait les valeurs de champ. Pour les requêtes complexes, envisagez d'utiliser la clause pour filtrer les données JSON, mais faites attention à son impact sur les performances. Le support de MySQL pour JSON augmente constamment, et il est recommandé de faire attention aux dernières versions et fonctionnalités.

Master SQL Limit Clause: Contrôlez le nombre de lignes dans une requête

Apr 08, 2025 pm 07:00 PM

Master SQL Limit Clause: Contrôlez le nombre de lignes dans une requête

Apr 08, 2025 pm 07:00 PM

Clause SQLLIMIT: Contrôlez le nombre de lignes dans les résultats de la requête. La clause limite dans SQL est utilisée pour limiter le nombre de lignes renvoyées par la requête. Ceci est très utile lors du traitement de grands ensembles de données, des affichages paginés et des données de test, et peut améliorer efficacement l'efficacité de la requête. Syntaxe de base de la syntaxe: selectColumn1, Column2, ... FromTable_NamelimitNumber_Of_Rows; Number_OF_ROWS: Spécifiez le nombre de lignes renvoyées. Syntaxe avec décalage: selectColumn1, Column2, ... FromTable_Namelimitoffset, numéro_of_rows; décalage: sauter

Comment optimiser les performances MySQL pour les applications de haute charge?

Apr 08, 2025 pm 06:03 PM

Comment optimiser les performances MySQL pour les applications de haute charge?

Apr 08, 2025 pm 06:03 PM

Guide d'optimisation des performances de la base de données MySQL dans les applications à forte intensité de ressources, la base de données MySQL joue un rôle crucial et est responsable de la gestion des transactions massives. Cependant, à mesure que l'échelle de l'application se développe, les goulots d'étranglement des performances de la base de données deviennent souvent une contrainte. Cet article explorera une série de stratégies efficaces d'optimisation des performances MySQL pour garantir que votre application reste efficace et réactive dans des charges élevées. Nous combinerons des cas réels pour expliquer les technologies clés approfondies telles que l'indexation, l'optimisation des requêtes, la conception de la base de données et la mise en cache. 1. La conception de l'architecture de la base de données et l'architecture optimisée de la base de données sont la pierre angulaire de l'optimisation des performances MySQL. Voici quelques principes de base: sélectionner le bon type de données et sélectionner le plus petit type de données qui répond aux besoins peut non seulement économiser un espace de stockage, mais également améliorer la vitesse de traitement des données.

Surveillez les gouttelettes MySQL et MariaDB avec Exportateur de Prometheus Mysql

Apr 08, 2025 pm 02:42 PM

Surveillez les gouttelettes MySQL et MariaDB avec Exportateur de Prometheus Mysql

Apr 08, 2025 pm 02:42 PM

Une surveillance efficace des bases de données MySQL et MARIADB est essentielle pour maintenir des performances optimales, identifier les goulots d'étranglement potentiels et assurer la fiabilité globale du système. Prometheus Mysql Exportateur est un outil puissant qui fournit des informations détaillées sur les mesures de base de données qui sont essentielles pour la gestion et le dépannage proactifs.

La clé principale de MySQL peut être nul

Apr 08, 2025 pm 03:03 PM

La clé principale de MySQL peut être nul

Apr 08, 2025 pm 03:03 PM

La clé primaire MySQL ne peut pas être vide car la clé principale est un attribut de clé qui identifie de manière unique chaque ligne dans la base de données. Si la clé primaire peut être vide, l'enregistrement ne peut pas être identifié de manière unique, ce qui entraînera une confusion des données. Lorsque vous utilisez des colonnes entières ou des UUIdes auto-incrémentales comme clés principales, vous devez considérer des facteurs tels que l'efficacité et l'occupation de l'espace et choisir une solution appropriée.

Méthode de Navicat pour afficher le mot de passe de la base de données MongoDB

Apr 08, 2025 pm 09:39 PM

Méthode de Navicat pour afficher le mot de passe de la base de données MongoDB

Apr 08, 2025 pm 09:39 PM

Il est impossible de visualiser le mot de passe MongoDB directement via NAVICAT car il est stocké sous forme de valeurs de hachage. Comment récupérer les mots de passe perdus: 1. Réinitialiser les mots de passe; 2. Vérifiez les fichiers de configuration (peut contenir des valeurs de hachage); 3. Vérifiez les codes (May Code Hardcode).